01Wang veröffentlichte das 100-Milliarden-Parameter-Modell Yi-Large, Kai-fu Lee: Chinas große Modelle haben die Vereinigten Staaten eingeholt und sind entschlossen, mit GPT-5 zu konkurrieren

Nach einem Jahr löste sich Kai-Fu Lee mit „Zero One Thousand Things“ wieder aus dem Kreis.

Im Mai letzten Jahres wurde Zero One Thing gegründet und veröffentlichte sechs Monate später seine erste zweisprachige Modell-Yi-Serie Chinesisch-Englisch. Kai-Fu Lee setzte sich von Anfang an ein ehrgeiziges und schwieriges Ziel: „die Nummer 1 der Welt zu werden.“

Lingyiwuwu, das seit seiner Geburt ein „beliebtes heißes Huhn“ ist, hat sich auch auf ein Team mit einem Hintergrund aus einem großen Unternehmen und hervorragenden Modellleistungen verlassen, um eine Bewertung von 1 Milliarde US-Dollar zu erreichen.

Heute bringen sie ihr zweites Produkt auf den Markt: das Yi-Large Closed-Source-Modell .

Greifen Sie das globale SOTA-Modell an

Im November letzten Jahres rangierte der von Lingyiwuwu veröffentlichte Yi-34B mit seiner „Dessert-Level“-Größe in der Open-Source-Community auf der Hugging Face-Liste und übertraf damit um ein Vielfaches größere Modelle wie Llama2-70B und Falcon-180B und wurde zum Das damals weltweit größte Modell. Eines der stärksten Grundmodelle für internes Open Source.

Ein halbes Jahr später veröffentlichte 01Wang offiziell Yi-Large mit einer Parameterskala von 100 Milliarden. In der unabhängigen maßgeblichen Bewertung schnitt das 01Wanyi Yi-Modell in der zweisprachigen chinesischen und englischen PK der weltweit führenden großen Modelle gut ab.

In der neuesten offiziell zertifizierten Modell-Rangliste von AlpacaEval 2.0, einer Stanford-Bewertungsagentur, liegt der Hauptindikator für die Englischkenntnisse des Yi-Large-Modells, die LC Win Rate (die die Länge der Antwort steuert), weltweit an zweiter Stelle, gleich hinter GPT -4 Turbo, Win Rate steht sogar weltweit an erster Stelle.

Zuvor befanden sich nur Yi und Qwen unter den inländischen Models in den Top 20 dieser Liste.

Eine wichtige Voraussetzung für die intelligente Nutzung eines großen Modells ist, dass es weiß, wovon man spricht.

Ausländische Models haben hervorragende Leistungen, basieren jedoch alle auf dem englischen Kontext. Große inländische Models, die im Land geboren wurden, haben jedoch einzigartige Vorteile beim Verständnis von Chinesisch.

In Bezug auf die chinesischen Sprachkenntnisse belegte Yi-Large in der von SuperCLUE aktualisierten Benchmark-Leistung im April auch den ersten Platz unter den inländischen großen Modellen. Yi-Larges umfassende zweisprachige Fähigkeiten in Chinesisch und Englisch haben eine hervorragende Leistung gezeigt.

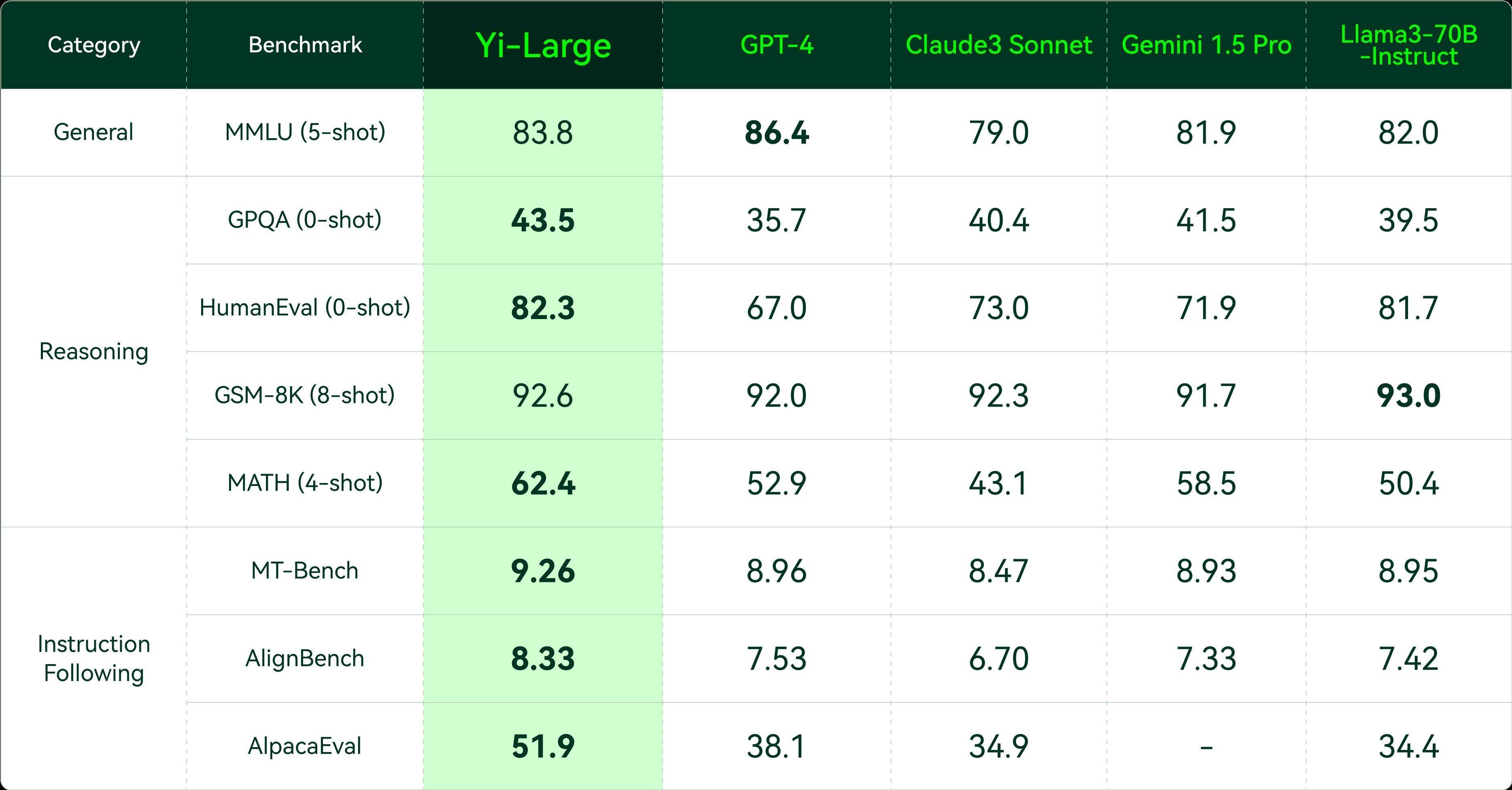

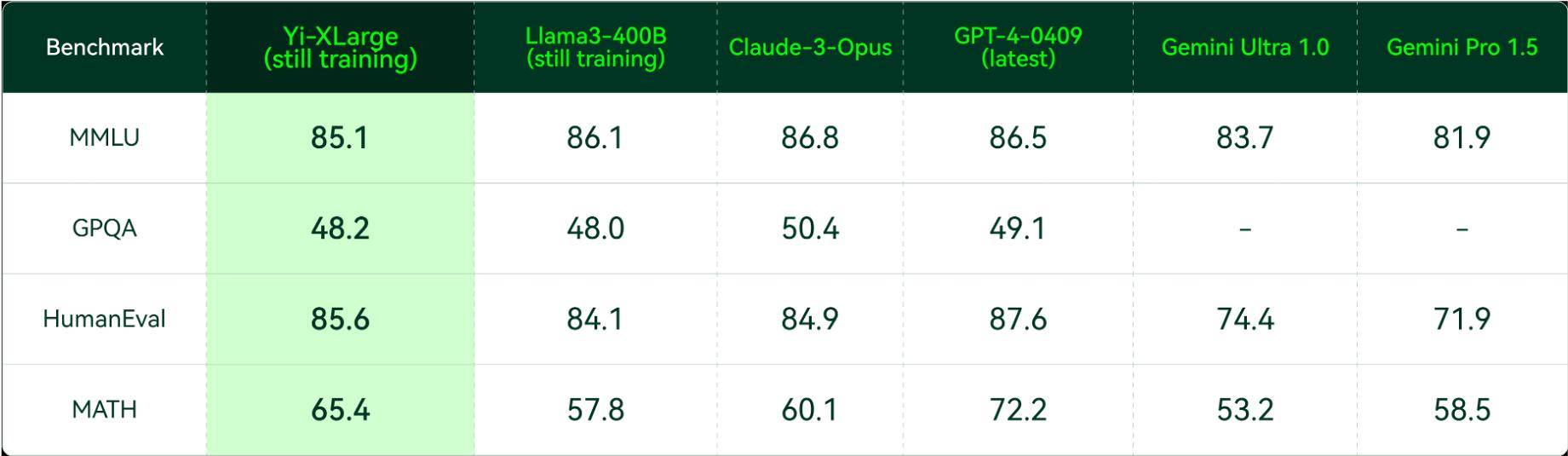

In einer umfassenderen umfassenden Leistungsbewertung großer Modelle übertraf Yi-Large bei den meisten Indikatoren ähnliche Modelle wie GPT4, Claude3 und Google Gemini 1.5 und erreichte den ersten Platz. Es hat in den Bereichen allgemeine Fähigkeiten, Codegenerierung, mathematisches Denken und Befolgen von Anweisungen bessere Ergebnisse erzielt als weltweit führende Unternehmen und gehört zu den Spitzenreitern der Welt.

Da die Fähigkeiten großer Modelle jedes Unternehmens in eine neue Phase des Benchmarkings mit GPT4 eintreten, hat sich auch der Schwerpunkt der Bewertung großer Modelle von einfachen allgemeinen Fähigkeiten hin zu komplexen Argumentationsfähigkeiten wie Mathematik und Codierung verlagert.

Yi-Large hat auch hervorragende Ergebnisse bei Bewertungssätzen wie HumanEval für Codegenerierungsfähigkeiten, GSM-8K und MATH für mathematische Denkfähigkeiten und GPQA für Domänenexpertenfähigkeiten erzielt.

Darüber hinaus sind aus Sicht der Branchenumsetzung das Verstehen menschlicher Anweisungen und das Anpassen menschlicher Präferenzen zu unverzichtbaren Fähigkeiten für große Modelle geworden, und Anweisungsbefolgung (Instruction Following) bezogene Auswertungen werden von globalen großen Modellunternehmen zunehmend geschätzt.

MT-bench wurde vom Open-Source-Evaluierungsprojekt AlpacaEval und Berkeley in Stanford ins Leben gerufen. LM-SYS besteht aus zwei Sätzen zur Bewertung der Einhaltung von Englischanweisungen, und AlignBench ist ein Benchmark zur Bewertung der chinesischen Ausrichtung, der vom Team der Tsinghua University ins Leben gerufen wurde.

Bei der Bewertung maßgeblicher Anweisungen im In- und Ausland schnitt Yi-Large besser ab als die fünf besten internationalen Modelle.

Auf der Pressekonferenz gab Kai-fu Lee außerdem bekannt, dass Zero One Wish das Yi-XLarge MoE-Modelltraining der nächsten Generation gestartet hat, das sich auf die Leistung und Innovation von GPT-5 auswirken wird.

Gleichzeitig befasst sich Zero One Thousand Things auch mit einigen sehr komplexen Themen. Kaifu Lee fasste drei wichtige Punkte zusammen:

- Einerseits müssen wir uns auf den technologischen Fortschritt und die Art von Modellen vorbereiten, die wir produzieren können.

- Zweitens: Wie können wir den Argumentationsaufwand minimieren und den Sinn der Inklusivität entfachen?

- Drittens gibt es das traditionelle PMF, um Benutzerbedürfnisse zu ermitteln.

Kai-Fu Lee sagte, dass solche Überlegungen bei Unternehmen im Silicon Valley im Allgemeinen nicht vorkommen:

Das ist unser einzigartiger Ansatz und eine Chance für chinesische Einhörner.

Yi-1.5 wird vollständig aktualisiert und die API-Plattform wird weltweit eingeführt.

Auf dieser Pressekonferenz wurde auch die Yi-Serie der Open-Source-Modelle umfassend aktualisiert. Yi-1.5 ist in drei Versionen unterteilt: 34B, 9B und 6B, und das Yi-1.5-Chat-Feinabstimmungsmodell wird Entwicklern zur Verfügung gestellt wähle aus.

Den Bewertungsdaten zufolge setzt die Yi-1.5-Serie die herausragende Leistung der Open-Source-Modelle der Yi-Serie fort. Während die mathematische Logik und die Codierungsfähigkeiten umfassend verbessert werden, behalten auch die Sprachfähigkeiten das ursprüngliche hohe Niveau bei.

Nach der Feinabstimmung hat sich Yi-1.5-6B/9B/34B-Chat in Bezug auf mathematisches Denken, Programmierfähigkeit und Befehlsfolge auf ein höheres Niveau verbessert.

Die Leistung von Yi-1.5-6B/9B-Chat bei Bewertungssätzen für mathematische Fähigkeiten wie GSM-8K und MATH und Bewertungssätzen für Codefähigkeiten wie HumanEval und MBPP ist bei weitem nicht die gleiche wie beim Modell auf Parameterebene und ist es auch besser als das kürzlich veröffentlichte Llama-3-8B -Instruct.

Auch die Ergebnisse von MT-Bench, AlignBench und AlpacaEval liegen unter den Modellen mit der gleichen Parametergröße an der Spitze.

Letztes Jahr entschied sich Zero One Wanwan dafür, das Modell der Yi-Serie als Open Source auf den Markt zu bringen, und seine hervorragende Leistung wurde von internationalen Entwicklern hoch gelobt.

Im ersten Monat nach der Veröffentlichung der Yi-Open-Source-Version im November 2023 belegte sie fast 50 % der beliebten Modellrankings in der Open-Source-Community. Einen Monat nach ihrer Veröffentlichung wurde Yi-34B in Nvidias große Modellspielwiese aufgenommen.

Kai-fu Lee hat auch eigene Problemlösungsideen, wenn es um Themen wie die Entwicklung großer Modelle und die Umsetzung von Produkten geht.

In einem Interview mit APPSO sagte Kai-fu Lee:

Wir sind pragmatische AGI-Anhänger. Wir müssen die wenigsten Chips und die niedrigsten Kosten verwenden, um das bestmögliche Modell zu trainieren. Gleichzeitig werden wir weiterhin TC-PMF erforschen und finden. Im Vergleich zu Unternehmen aus dem Silicon Valley besteht der Unterschied zwischen inländischen Start-up-Unternehmen darin, dass wir zu den Sternen aufblicken, aber auch auf dem Boden bleiben können.

Der einzige Gedanke, dass nicht alle Dinge mit reiner Gewalt Wunder bewirken werden, besteht darin, zu prüfen, ob dafür zehn Milliarden US-Dollar oder einhundert Milliarden US-Dollar verwendet werden können. OPEN AI ist qualifiziert, diesen Weg auszuprobieren, aber das ist nicht der Weg, den sie einschlagen wollen. Natürlich werden sie sich nicht die Zeit nehmen, den Zündzeitpunkt von AGI vorherzusagen, aber er kann jedem mit Sicherheit sagen, dass es relevanter ist Sie sind der Punkt von AI Pratt & Whitney.

Heute gab Lingyiwanwu außerdem bekannt, dass es mehrere Modell-API-Schnittstellen, darunter Yi-Large, Yi-Large-Turbo, Yi-Medium, Yi-Medium-200K, Yi-Vision, Yi-Spark usw., gleichzeitig für den heimischen Markt veröffentlicht hat Gleichzeitig steht die englischsprachige Website der Yi API Platform Entwicklern auf der ganzen Welt für gleichzeitige Testanwendungen offen.

Unter anderem verfügt die Yi-Large-API mit einer Parameterskala von 100 Milliarden über eine hervorragende Textgenerierungs- und Argumentationsleistung und eignet sich für komplexe Überlegungen, Vorhersagen, detaillierte Inhaltserstellung und andere Szenarien.

Die Yi-Large-Turbo-API ist ausgewogen und hochpräzise auf Leistung, Inferenzgeschwindigkeit und Kosten abgestimmt und eignet sich für alle Szenarien, hochwertige Inferenz und Textgenerierung.

Der Vorteil der Yi-Medium-API liegt in der Fähigkeit, Anweisungen zu befolgen, die für Chat-, Dialog-, Übersetzungs- und andere Szenarien in regulären Szenarien geeignet ist.

Wenn Sie Anwendungen für Dokumente mit extrem langen Inhalten benötigen, können Sie auch die Yi-Medium-200K-API wählen, die 200.000 Textwörter gleichzeitig interpretieren kann;

Die Yi-Vision-API verfügt über leistungsstarke Bildverständnis- und Analysefunktionen und kann bildbasierte Chats, Analysen und andere Szenarien unterstützen.

Die Yi-Spark-API konzentriert sich auf eine leichte und extrem schnelle Reaktion und eignet sich für einfache mathematische Analysen, Codegenerierung, Text-Chat und andere Szenarien.

Noch wichtiger ist, dass es bereits praktische Anwendungen gibt, und die „Kleine Bauchspeicheldrüse“ für Patienten mit Bauchspeicheldrüsentumoren ist eine davon.

Der KI-Assistent von Xiaoyibao kann Patienten 24 Stunden am Tag, 7 Tage die Woche umfassendes Behandlungswissen vermitteln.

Der technische Support hinter diesem Assistenten ist das Yi-Modell von Zero One Thing. Nachdem Xiaoweibao die Yi-API zum Aufrufen des KI-Großmodells verwendet hat, durchbricht er die Informationsbarriere der Bauchspeicheldrüsentumor-Behandlung und kann Bauchspeicheldrüsentumor-Patienten die Roadmap und den Behandlungsplan für die Behandlung von Bauchspeicheldrüsenkrebs genau und systematisch präsentieren.

Derzeit hat dieses Wohltätigkeitsprojekt mehr als 3.000 Patienten mit Bauchspeicheldrüsentumoren geholfen.

Arbeitsplattform aus einer Hand

Auf der heutigen Pressekonferenz wurde auch „Wanzhi“ vorgestellt, eine One-Stop-KI-Workstation, die kürzlich von Zero One Wagon auf den Markt gebracht wurde.

Laut der offiziellen Einführung ist Wanzhi eine zentrale KI-Arbeitsplattform, die speziell für chinesische Benutzer entwickelt wurde. Sie kann Besprechungsprotokolle erstellen, wöchentliche Berichte schreiben, Finanzberichte interpretieren und PPTs erstellen und ist völlig kostenlos.

Derzeit können sich Benutzer über die offizielle Website und das WeChat-Applet „Wanzhi AI“ anmelden, um es zu erleben.

Auf der Pressekonferenz gaben Wanzhi-Beamte ein sehr praktisches Beispiel:

Sie sind gerade unten im Unternehmen angekommen und werden plötzlich von Ihrem Leiter gebeten, eine Besprechungspräsentation zu halten, aber der Computer ist nicht in der Nähe. Geben Sie nun über Wanzhi das Thema ein, das Sie auf Ihrem Mobiltelefon präsentieren möchten, und warten Sie dann auf die beiden Sie benötigen nur wenige Minuten, um vom Aufzug zu Ihrem Arbeitsplatz zu gelangen. Die PPT-Datei wurde auf der Wanzhi-Webseite erstellt. Danach müssen Sie nur noch einige einfache Texte, Bilder und Änderungen vornehmen, um sie direkt verwenden zu können.

Darüber hinaus verfügt Wanzhi über viele weitere Funktionen.

Die erste Möglichkeit ist die Fähigkeit des Wanzhi AI Assistant, große Mengen an Dokumentinhalten, einschließlich langer Dokumente und komplexer Finanzdaten, schnell zu lesen und zu verstehen. Es kann in wenigen Sekunden wichtige Informationen extrahieren und unterstützt das zweisprachige Lesen in Chinesisch und Englisch.

Zweitens zeigte Wanzhi in allgemeinen Frage- und Antwortszenarien auch eine hervorragende Produktleistung, indem er in der Lage war, schnell passende Antworten zu geben und professionelles und schnelles Feedback zu geben.

Darüber hinaus unterstützt Wanzhi AI Assistant nicht nur die Textausgabe, sondern kann Informationen auch in verschiedenen Formen wie Tabellen, Formeln, Codes usw. anzeigen, wodurch Arbeitsberichte und Lebensplanung übersichtlicher werden.

Schließlich kann Wanzhi AI Assistant in Echtzeit auf Internetinformationen zugreifen und so sicherstellen, dass die von den Benutzern erhaltenen Daten und Erkenntnisse auf dem neuesten Stand und am genauesten sind.

Den Untersuchungen und Beobachtungen des Wanzhi-Teams zufolge hat sich die persönliche Arbeitseffizienz nach der Verwendung von Wanzhi im Durchschnitt um mehr als 50 % gesteigert, insbesondere im Hinblick auf den Wissensabruf, die Konzeption und das Schreiben von Dokumenten usw., was eine erhebliche Zeitersparnis bedeutet.

Derzeit ist Wanzhi AI Assistant völlig kostenlos und steht Benutzern offen.

Beamte von Wanzhi sagten, dass der Einsatz ähnlich großer Modelle in diesem Jahr definitiv ein wichtiger Landepunkt in China werden wird.

Kai-Fu Lee erwähnte auch, dass dieses Jahr das erste Jahr der KI-Produktivitätstools sein wird, da einige Bereiche in diesem Jahr explodieren werden.

Er glaubt, dass der wahre Wert von AI-Frist darin besteht, wer ein AI Douyin, AI WeChat und AI Taobao bauen wird? Zero One hofft, dass sie das Potenzial haben, als solcher Zünder zu dienen.

Der Inklusivpunkt der gesamten KI wird jedoch nicht gleichzeitig erreicht und die Anwendungsanforderungen in einigen Bereichen werden sehr hoch sein.

Bei den Produktivitätstools, die wir derzeit entwickeln, ist beispielsweise der Benutzer letztendlich für den Inhalt verantwortlich, der vom Produktivitätstool erstellt wird. Wenn es also Fehler gibt, die nicht perfekt sind, einer Feinabstimmung bedürfen oder auch nur ein kleines Maß an Illusion vorhanden sind, entscheidet letztendlich der Benutzer, ob es geändert werden kann. Der Indikator des Benutzers ist also, ob ich bessere Inhalte produzieren kann in einer schnelleren Zeit als ohne dieses Tool.

Kai-Fu Lee sagte, dass TC-PMF es tatsächlich erreicht hat, aber es kann noch besser sein, also wird es dieses Jahr definitiv bei Produktivitätstools passieren.

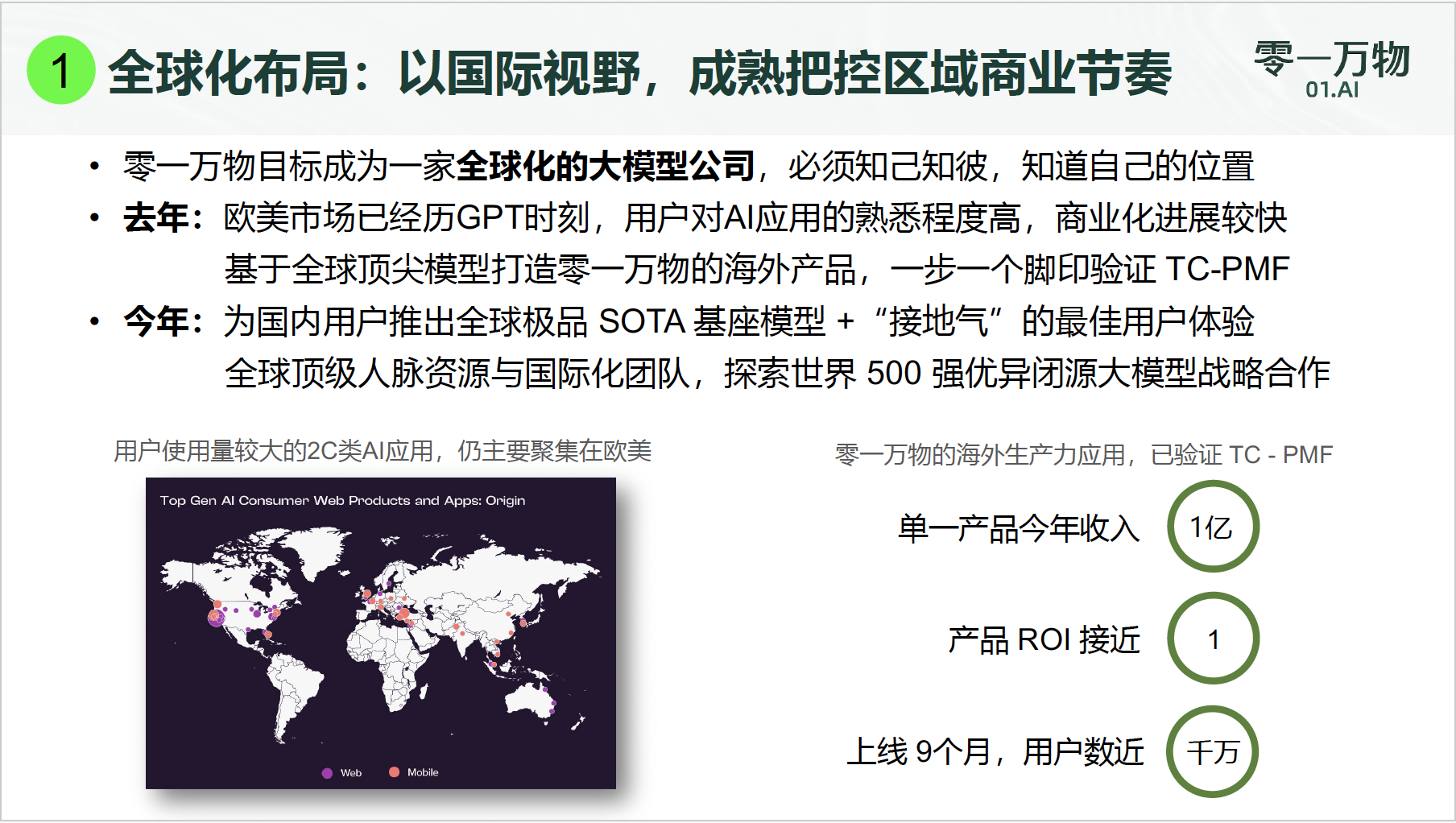

Derzeit beträgt die Gesamtzahl der Produktivitätsanwendungsnutzer von Zero One Thousand Things im Ausland fast 10 Millionen, und der Umsatz eines einzelnen ToC-Produkts erreichte in diesem Jahr 100 Millionen Yuan.

Kai-Fu Lee enthüllte:

Unser ROI liegt immer noch bei etwa 1. Daher sind solche Ergebnisse zumindest aus Sicht großer inländischer Modellunternehmen sehr vorteilhaft.

Zu Beginn des Jahres 2023, wenn das inländische Großmodellfeld im Nahkampf ist, sind verschiedene Bewertungslisten überwältigend und es gibt nicht wenige Modelle, die auf jeder Hauptliste ganz oben stehen.

Im Zeitalter der KI 1.0 hat künstliche Intelligenz noch keine hohen Generalisierungs- und Emergenzfähigkeiten gezeigt, und das privatisierte Bereitstellungsmodell für Hauptkunden ist zum Mainstream geworden. Die Zeit hat jedoch gezeigt, dass die Einnahmen durch das projektorientierte Heavy-Delivery-Modell erzielt werden stellt eine Obergrenze für das Wachstum dar und die Nachhaltigkeitsherausforderungen sind schwerwiegend.

Heute befinden wir uns im Zeitalter der KI 2.0 und die künstliche Intelligenz ist in eine neue Entwicklungsstufe eingetreten. Im Vergleich zu 1.0 markiert KI 2.0 einen Sprung von der regelbasierten automatisierten Verarbeitung hin zu Deep Learning und autonomen Lernfähigkeiten.

Unter diesem Gesichtspunkt wird sich die „Schlacht der Hundert Regimenter“ im Bereich der KI nur noch verschärfen.

Seit letztem Jahr konnten sich immer mehr im Inland produzierte Großmodelle von der harten Konkurrenz abheben und auch in namhaften globalen Listen beeindruckende Ergebnisse erzielen.

In diesem Jahr wird die Branche in eine realistischere kommerzielle Implementierungsphase eintreten, und die Benutzer werden anhand der auf der Anwendungsseite demonstrierten Fähigkeiten mit ihren Füßen abstimmen. Wie der Anwendungseffekt basierend auf den Fähigkeiten des Basismodells so weit wie möglich verbessert werden kann, ist ein wichtiges Thema bei der Aufholjagd mit TC-PMF.

Kai-Fu Lee sagte:

Vor einem Jahr fühlten sich Chinas große Vorbilder (im Vergleich zu den Vereinigten Staaten) zu sehr im Rückstand. Aber heute sind wir sehr stolz, sagen zu können, dass wir seit einem Jahr auf dem Laufenden sind und in Bezug auf die Modelle zumindest die Top-Produkte (große Modelle) eingeholt haben, die in den USA vor einem Jahr auf den Markt kamen Wir werden auch in Zukunft hart arbeiten. Wir brauchen jedoch einen Überblick und eine Zukunftsperspektive und können nicht einfach wie verrückt davonlaufen.

Im KI-Zeitalter, in dem die Wellen hinter dem Jangtsekiang die Wellen vorantreiben, ist es für Benutzer von größter Bedeutung, KI zu kennen, KI zu verstehen, KI zu nutzen und sie im Wettbewerb zwischen Herstellern sogar zum Arbeiten, Lernen und Leben zu bringen.

Und das ist auch die ursprüngliche Absicht und das Ziel der KI-Technologie.

*Fu Liqun hat ebenfalls zu diesem Artikel beigetragen

# Willkommen beim offiziellen öffentlichen WeChat-Konto von aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner |. Ursprünglicher Link · Kommentare anzeigen · Sina Weibo