Microsoft erklärt, wie Tausende von Nvidia-GPUs ChatGPT erstellt haben

ChatGPT wurde in den letzten sechs Monaten viral berühmt, kam aber nicht aus dem Nichts. Laut einem am Montag von Microsoft veröffentlichten Blogbeitrag hat sich OpenAI, das Unternehmen hinter ChatGPT, vor mehr als fünf Jahren an Microsoft gewandt, um eine KI-Infrastruktur auf Tausenden von Nvidia-GPUs aufzubauen.

Die Partnerschaft zwischen OpenAI und Microsoft hat in letzter Zeit viel Aufmerksamkeit erregt, insbesondere nachdem Microsoft 10 Milliarden US-Dollar in die Forschungsgruppe investiert hat, die hinter Tools wie ChatGPT und DALL-E 2 steht. Laut Microsoft hat die Partnerschaft jedoch schon vor langer Zeit begonnen. Seitdem hat Bloomberg berichtet , dass Microsoft „mehrere hundert Millionen Dollar“ in die Entwicklung der Infrastruktur zur Unterstützung von ChatGPT und Projekten wie Bing Chat investiert hat.

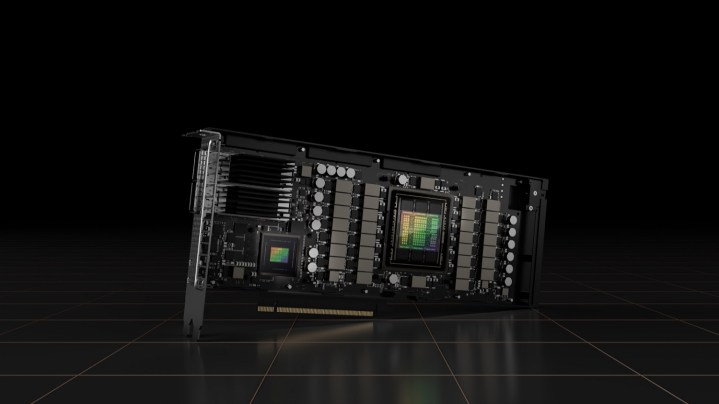

Ein Großteil dieses Geldes ging an Nvidia, das heute an der Spitze der Computerhardware steht, die zum Trainieren von KI-Modellen erforderlich ist. Anstelle von Gaming-GPUs, wie Sie sie auf einer Liste der besten Grafikkarten finden würden, entschied sich Microsoft für Nvidias GPUs der Enterprise-Klasse wie A100 und H100.

Es ist jedoch nicht so einfach, Grafikkarten zusammenzubauen und ein Sprachmodell zu trainieren. Wie Nidhi Chappell, Microsoft-Produktleiter für Azure, erklärt: „Man kauft nicht einfach einen ganzen Haufen GPUs, hängt sie zusammen und sie fangen an, zusammenzuarbeiten. Es gibt viel Optimierung auf Systemebene, um die beste Leistung zu erzielen, und das bringt viel Erfahrung über viele Generationen mit sich.“

Nachdem die Infrastruktur vorhanden ist, öffnet Microsoft nun seine Hardware für andere. Das Unternehmen kündigte am Montag in einem separaten Blogbeitrag an, dass es Nvidia H100-Systeme „on-demand in Größen von acht bis zu Tausenden von Nvidia H100-GPUs“ anbieten werde, die über das Azure-Netzwerk von Microsoft geliefert würden.

Die Popularität von ChatGPT hat Nvidia in die Höhe geschossen , das seit mehreren Jahren durch Hardware und Software in KI investiert. AMD, Nvidias Hauptkonkurrent bei Gaming-Grafikkarten, hat versucht, mit Beschleunigern wie dem Instinct MI300 in den Weltraum vorzudringen.

Laut Greg Brockman, Präsident und Mitbegründer von OpenAI, wäre das Training von ChatGPT ohne die von Microsoft bereitgestellte Pferdestärke nicht möglich gewesen: „Das Co-Design von Supercomputern mit Azure war entscheidend für die Skalierung unserer anspruchsvollen KI-Trainingsanforderungen, unsere Forschung und Anpassungsarbeiten an Systemen wie ChatGPT möglich.“

Nvidia wird voraussichtlich während der GPU Technology Conference (GTC) mehr über zukünftige KI-Produkte verraten. mit der Keynote-Präsentation beginnt am 21. März. Microsoft erweitert seine KI-Roadmap im Laufe dieser Woche mit einer Präsentation, die sich auf die Zukunft der KI am Arbeitsplatz konzentriert und für den 16. März geplant ist.