AIs „iPhone-Moment“, Nvidia gewinnt

Auf der GTC-Konferenz im März sagte Nvidia-CEO Huang Renxun: „Der Moment des KI-iPhones ist gekommen.“

Nach Ablauf von fünf Monaten könnten Huang Renxuns Worte umgeschrieben werden als „Die Zeit für das iPhone von Nvidia AI ist gekommen.“

Nvidia hat heute seinen Finanzbericht für das zweite Quartal des Geschäftsjahres 2024 bekannt gegeben. Der Umsatz im zweiten Quartal belief sich auf 13,51 Milliarden US-Dollar, was einer Steigerung von 101 % gegenüber dem Vorjahr und 88 % gegenüber dem Vorquartal entspricht. Darüber hinaus betrug der Nettogewinn 6,188 Milliarden US-Dollar, was einem starken Anstieg von 843 % gegenüber dem Vorjahr entspricht

Es ist erwähnenswert, dass dies auch das erste Mal ist, dass Nvidia Intel beim Quartalsumsatz überholt hat, was einen historischen Moment einläutet.

Rekordverdächtiges Nvidia, eine neue Ära der Datenverarbeitung

Nach Bekanntgabe des Finanzberichts stieg der Aktienkurs von Nvidia im nachbörslichen Handel um 9,6 %, und der Aktienkurs erreichte einen neuen Höchststand, durchbrach die 500-Dollar-Marke und wurde zum „schönsten Jungen“ auf dem US-Aktienmarkt.

Nvidia machte auch einen ehrgeizigen Ausblick für das nächste Geschäftsquartal und erwartete einen Umsatz von 16 Milliarden US-Dollar, plus oder minus 2 %. Diese Zahl ist fast dreimal so hoch wie vor einem Jahr und 3,7 Milliarden US-Dollar höher als die durchschnittliche Schätzung der Analysten von 12,3 Milliarden US-Dollar.

Im Finanzbericht sagte Huang Renxun: „ Eine neue Ära der Datenverarbeitung hat begonnen und Unternehmen auf der ganzen Welt wandeln sich vom Allzweck-Computing zum beschleunigten Computing und zur generativen KI .“

Chips sind immer noch die Haupteinnahmequelle von Nvidia. Der Geschäftsbereich, der Rechenzentren mit Chips beliefert, ist die größte Einnahmequelle des Unternehmens. Der Umsatz des Geschäftsbereichs erreichte im zweiten Quartal 10,32 Milliarden US-Dollar, ein Anstieg von 171 %, weit über den Markterwartungen von 7,98 US-Dollar Milliarde.

Unter ihnen ist der H100 der begehrteste Chip auf dem Markt und wurde einst auf über 40.000 US-Dollar (ca. 290.000 RMB) gefeuert.

Frühere Quellen enthüllten Raymond James von der Investmentbank, dass die Kosten für die H100-GPU 3.320 US-Dollar (ca. 24.181 Yuan) betrugen und Nvidia sich entschied, sie zu einem Preis von 25.000 bis 30.000 US-Dollar (derzeit etwa 182.000 bis 219.000 Yuan) zu verkaufen. GPU.

Obwohl diese Aussage andere Kosten wie Transport und Logistik möglicherweise nicht berücksichtigt, sondern nur das Verhältnis von Produktionskosten zu Verkaufspreis berücksichtigt, ist die NVIDIA H100-GPU einfach eine „Super-Cash-Cow“.

Laut Tomshardware plant Nvidia in diesem Jahr den Verkauf von mehr als 550.000 H100-GPUs. Wenn dies zutrifft, bedeutet dies, dass Nvidias Einnahmen allein mit der H100-GPU bereits astronomisch sind.

Da der H100-Chip jedoch fortschrittliche Produktionstechnologie und die gleiche komplexe Verpackungstechnologie erfordert, hängt das Angebot direkt von der Verpackungskapazität der Gießerei TSMC ab, was auch ein wichtiger Grund für die Knappheit von H100 ist. Führungskräfte der Branche sagen voraus, dass die Knappheit von H100 wird bis 2024 andauern.

Huang Jensen sagte, dass Nvidia mit seinen Produktionspartnern zusammenarbeiten möchte, um mehr Chips auf den Markt zu bringen, unter anderem durch die Zusammenarbeit mit anderen Unternehmen, um die Verpackungsfähigkeiten von TSMC zu ergänzen, und sagte, dass „das Angebot für den Rest dieses und nächsten Jahres deutlich steigen wird.“ "

Mit der Explosion der generativen KI bemühen sich unzählige Technologiegiganten darum, in den Bereich der generativen KI einzusteigen und versuchen, die Tür zu dieser Technologie voller Möglichkeiten zu öffnen. Nvidia, der Mann, der die „Schaufel“ vor dem Tor der Goldmine bewachte, ging zuerst als Sieger hervor.

Obwohl Giganten wie Microsoft und Google Dutzende Milliarden Dollar in KI investiert haben, haben sie noch keine Gewinne erzielt. Was OpenAI betrifft, das im Rampenlicht steht, berichtete das Analytics India Magazine, dass die tägliche Wartung des ChatGPT-Dienstes 700.000 kostet. Obwohl versucht wurde, durch GPT-3.5 und GPT-4 Rentabilität zu erzielen, sind die aktuellen Vorteile noch nicht eingetreten realisiert. Gleichgewicht unterstützen.

▲ OpenAI-CEO Sam Altman Bild von: CNN

Wenn OpenAI die Situation jedoch nicht ändern kann, da es mit hohen täglichen Kosten konfrontiert ist und nicht in der Lage ist, schnell Rentabilität zu erzielen, geht das Analytics India Magazine davon aus, dass OpenAI in naher Zukunft sogar Insolvenz anmelden könnte.

Im Bereich KI-Chips gibt es kein Technologieunternehmen, das zu Nvidia aufschauen kann.

Laut Daten des Forschungsunternehmens Omdia stellen zwar auch Google, Amazon, Meta, IBM und andere Unternehmen KI-Chips her, Nvidia ist jedoch für mehr als 70 % des KI-Chip-Umsatzes verantwortlich und verfügt über einen größeren Vorteil beim Training generativer KI-Modelle.

Viele Kunden würden lieber 18 Monate warten, um Chips von Nvidia zu beziehen, als serienmäßige Chips von Start-ups oder anderen Wettbewerbern zu kaufen, sagte Daniel Newman, Analyst bei der Futurum Group. Sogar Google, das vor mehr als einem Jahrzehnt mit der Entwicklung von KI-Chips begann, ist bei einigen Arbeiten auf die GPU von Nvidia angewiesen.

Trotz des hohen Preises und der Knappheit an Chips könnten Nvidia-Chips derzeit die kostengünstigste Lösung der Welt sein. Huang Renxun sagte, dass Hochleistungschips den Kunden tatsächlich mehr Geld sparen.

Wenn Sie die Schulungszeit in einem 5-Milliarden-Dollar-Rechenzentrum halbieren könnten, würden die Einsparungen die Kosten für alle Chips übersteigen.

Rechenleistung, Modelle und Daten stellen seit jeher die drei Hauptelemente der KI-Entwicklung dar. Die durch KI-Chips dargestellte Rechenleistung ist nicht nur der Grundpfeiler der künstlichen Intelligenz, sondern auch der Schlüssel, um die Tür zu dieser Technologie zu öffnen.

Dieser Schlüssel zur Zukunft liegt in den Händen von Nvidia und hat einen eigenen Burggraben gebildet.

Nvidias Chipgraben

Vor 58 Jahren stellte Gordon Moore, einer der Gründer von Intel, das berühmte Mooresche Gesetz vor.

Die Anzahl der Transistoren, die auf einem integrierten Schaltkreis untergebracht werden können, verdoppelt sich etwa alle zwei Jahre.

Dann tauchten neue Hochrechnungen auf und der Zweijahreszeitraum wurde auf 18 Monate verkürzt.

Unter dem Einfluss des Mooreschen Gesetzes hat die Verarbeitungsleistung von CPU und GPU ein exponentielles Wachstum erreicht. Nach 2000 ist die CPU von Single-Core auf Multi-Core umgestiegen und die Anzahl der Kerne wurde stark erhöht.

Das Training und die Argumentation von AI Deep Learning basieren stark auf Matrixberechnungen und Gleitkommaberechnungen, was extrem hohe Anforderungen an die Rechenleistung stellt. GPUs sind in der Lage, umfangreiche parallele Berechnungen durchzuführen, übertreffen CPUs bei Matrix- und Vektorberechnungen bei weitem und sind es auch geworden die „High-Performance-Computing-Plattform“. Liebling“.

Darüber hinaus haben die Vorteile der Hochgeschwindigkeitsspeicherbandbreite, des skalierbaren Rechenleistungspools, des speziell optimierten Deep-Learning-Frameworks und der Unterstützung der Cloud-Bereitstellung auch die Kernposition der GPU-Rechenleistung im KI-Zeitalter fest etabliert.

Nvidia wurde im April 1993 gegründet und begann mit GPUs. Durch kontinuierliche Innovation und Entwicklung hat sich das Unternehmen nach und nach zu einem führenden Unternehmen im Bereich Hochleistungsrechnen entwickelt.

Laut dem GPU-Marktstatistikbericht von Jon Peddie Research liegt Nvidia mit einem Marktanteil von 84 % an erster Stelle, gefolgt von AMD mit 12 % und Intel mit 4 %.

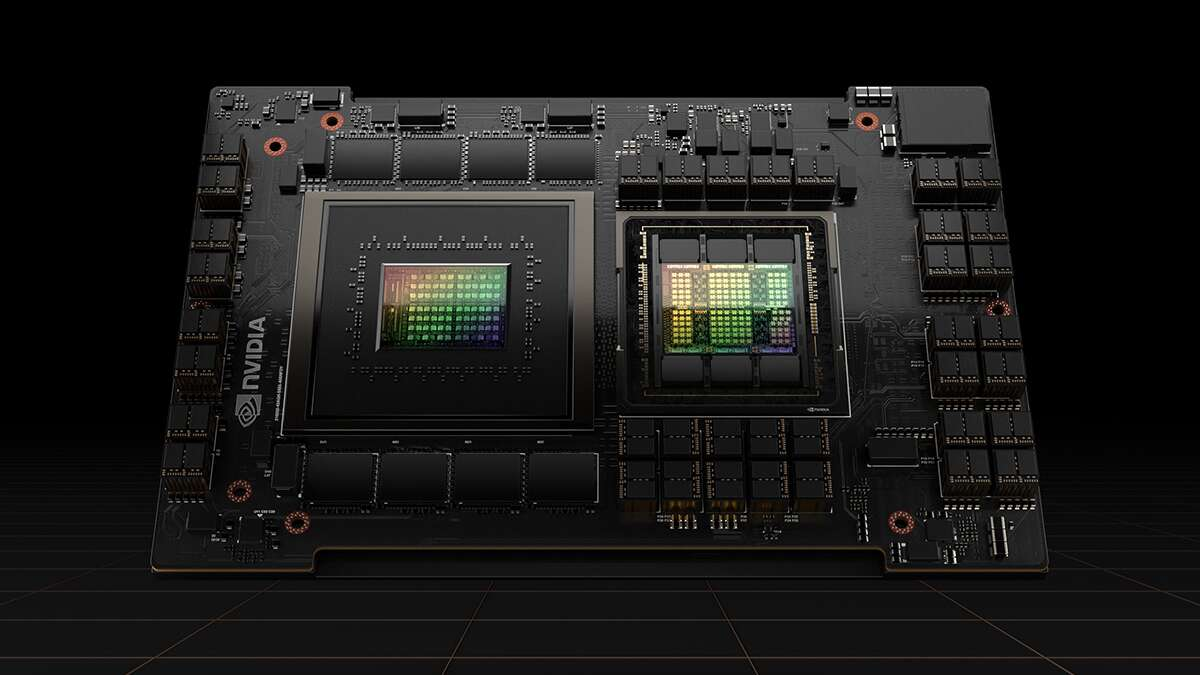

Sowohl A100 als auch H100 sind Nvidias Rechenzentrums-GPUs der Spitzenklasse, die speziell für KI-Computing entwickelt wurden. In Bezug auf das Training und die Argumentation großer neuronaler Netze übertrifft ihre Leistung die der anderen Wettbewerber bei weitem. Die beiden Ass-Chips in Nvidias Händen.

Seit Anfang dieses Jahres konzentriert sich Nvidia auf „Je mehr Sie kaufen, desto mehr sparen Sie“ und hat sehr geschickt und „intim“ verschiedene iterativ aktualisierte GPUs auf den Markt gebracht.

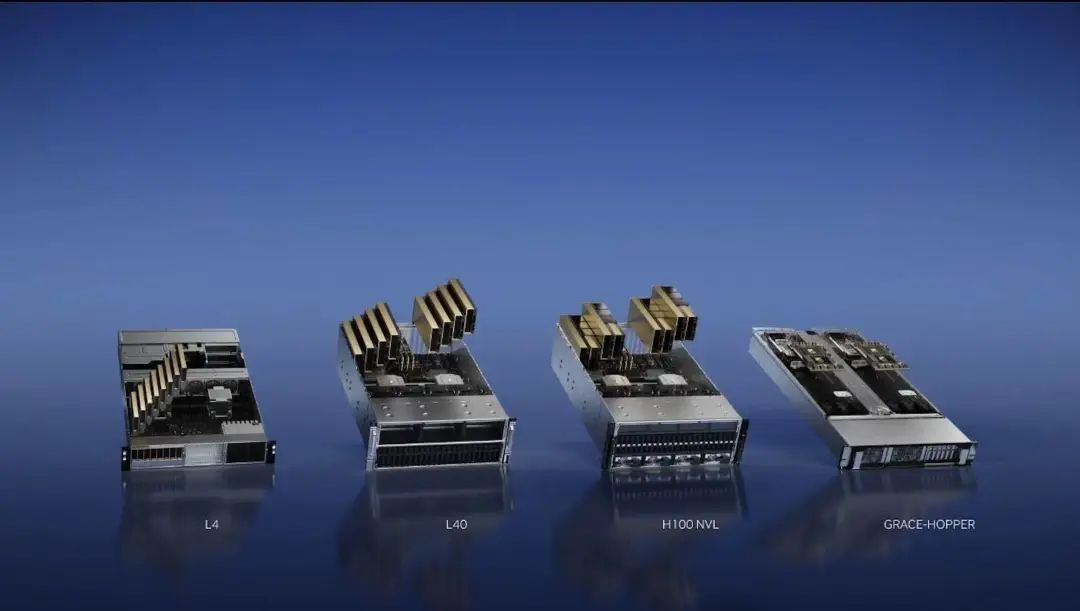

Im März veröffentlichte Nvidia vier KI-Inferenzchips: H100 NVL GPU, L4 Tensor Core GPU, L40 GPU und NVIDIA Grace Hopper.

Zwei Monate später, auf der Taipei Computer Show im Mai, stellte Huang Renxun den Supercomputer DGX GH200 vor, der aus 256 NVIDIA GH200 Grace Hopper-Superchips besteht.

Erst vor zwei Wochen veröffentlichte Huang Renxun eine neue Version des GH200 Grace Hopper mit HBM3e-Speicher, der gleichzeitig der weltweit erste GPU-Chip mit HBM3e-Speicher ist.

HBM3e-Speicher ist eine neue Art von Speichertechnologie mit hoher Bandbreite. In Bezug auf die Rechengeschwindigkeit kann HBM3e 50 % schneller sein als die HBM3-Rechengeschwindigkeit und bietet eine maximale Übertragungsrate von 5 TB/s.

Training und Argumentation sind zwei sehr wichtige Schritte von KI-Großmodellen, und genau darin ist GH200 gut. Nach Ansicht von Huang Renxun ist das typische Anwendungsszenario von GH200 in der Zukunft das große Sprachmodell, und „beschleunigtes Rechnen“ und „KI-Computing“ werden nach und nach das „allgemeine Computing“ traditioneller x86-GPUs ersetzen.

Zahlreiche Fälle in der Vergangenheit haben gezeigt, dass Außenstehende im Wettbewerb die Oberhand gewinnen, wenn erst einmal ein hervorragendes Ökosystem in einen Wassergraben eingebaut ist.

Das starke Ökosystem von Nvidia erfordert natürlich die Siegelzertifizierung der Wettbewerber. Naveen Rao, ein Wissenschaftler für neuronale Netzwerke, war einst Vizepräsident und General Manager der Abteilung für Plattformen für künstliche Intelligenz bei Intel.

Er stellte fest, dass der größte Vorteil von Nvidia nicht nur der Chip selbst ist, sondern dass Nvidia über eine große Community und ein Vertriebszentrum mit einer großen Anzahl hervorragender Programmierer für künstliche Intelligenz verfügt.

Jeder legt Wert darauf, auf Nvidia zu basieren, und wenn man ein neues Stück Hardware auf den Markt bringt, geht es nur darum, es zu verfolgen.

Im Finanzbericht zum zweiten Quartal sagte Huang Renxun außerdem: „Nvidia-GPUs, die über unser Mellanox-Netzwerk und die Switch-Technologie verbunden sind und auf denen unser CUDA AI-Software-Stack läuft, bilden die Recheninfrastruktur für generative KI.“

CUDA ist eine Parallel-Computing-Plattform und ein Programmiermodell, das auf von Nvidia hergestellten GPUs basiert und deren Zweck darin besteht, mehr technischem Personal die Teilnahme an der Entwicklung zu ermöglichen.

Entwickler können CUDA-APIs über Hochsprachen wie C/C++ und Fortan aufrufen, um parallele Programmierung und Hochleistungsrechnen durchzuführen. Durch die Einrichtung dieses Ökosystems verlassen sich viele Entwickler auf CUDA.

Zuvor hatte Huang Renxun der Außenwelt mitgeteilt, dass CUDA weltweit mehr als 4 Millionen Entwickler und mehr als 3.000 Anwendungen hat und dass die kumulierten Downloads von CUDA 40 Millionen Mal erreicht haben. Es gibt 40.000 große Unternehmen auf der Welt, die NVIDIA-Produkte verwenden beschleunigtes Computing. 15.000 Startups basieren auf der NVIDIA-Plattform.

Die große Zahl spiegelt Nvidias erheblichen First-Mover-Vorteil wider. Wenn andere Konkurrenten neue Hardware auf den Markt bringen wollen, müssen sie auch darüber nachdenken, mit diesem bereits gebildeten Innovationsökosystem für künstliche Intelligenz gleichzuziehen.

Die beiden Enden der Transaktion: Ein Ende ist mit dem Verkäufer und das andere Ende mit dem Käufer verbunden.

Im April unterzeichnete der „doppelte Maßstab“ Musk gemeinsam ein Verbot des KI-Trainings, während er heimlich 10.000 GPUs für die Entwicklung großer Modelle fegte, und erhob sogar öffentliche Beschwerden über X: „Es scheint, dass jeder und jeder Hund eine GPU kauft.“ ".

Letzten Monat sagte der Vorstandsvorsitzende von Oracle öffentlich, dass Oracle Milliarden von Dollar für den Kauf von Nvidias GPUs ausgeben würde, um Cloud-Computing-Dienste für eine neue Welle von Unternehmen der künstlichen Intelligenz zu erweitern.

Wer die Rechenleistung bekommt, gewinnt die Welt. Auf der generativen KI-Strecke, auf der man sich gegenseitig jagt, gibt es auch die Angst, im Land nach „Chips“ zu suchen.

Bei der Telefonkonferenz zu den Ergebnissen sagte Colette Kress, CFO von Nvidia: „Wir gehen davon aus, dass das sequenzielle Wachstum hauptsächlich von Rechenzentren getragen wird, wobei die Verkäufe an chinesische Kunden etwa 20 bis 25 % des Rechenzentrumsumsatzes von Nvidia im letzten Quartal ausmachen.“

Dem britischen „Financial Times“-Bericht zufolge bemühen sich chinesische Internetgiganten bereits zuvor darum, Nvidias leistungsstarke KI-Chips zu ergattern, mit Aufträgen im Wert von bis zu 5 Milliarden US-Dollar in diesem und im nächsten Jahr.

Unter ihnen haben Baidu, Tencent, Alibaba und ByteDance in diesem Jahr Zahlungsaufträge für insgesamt 1 Milliarde US-Dollar an Nvidia erteilt, insgesamt 100.000 A800 gekauft, was einem Preis von 10.000 US-Dollar pro A800-Chip entspricht, und die restlichen 400.000 Chips geliefert nächstes Jahr. Einhundert Millionen US-Dollar.

Der A800 ist im Wesentlichen eine „kastrierte Version“ des A100. Aufgrund der Auswirkungen der Richtlinie im August letzten Jahres kann Nvidia nur eine uneingeschränkte Alternativversion für den chinesischen Festlandmarkt auf den Markt bringen.

Viele Leute in der Branche glauben, dass GPUs zu einem anerkannten knappen Gut auf dem Markt geworden sind und dass es auch in den nächsten ein oder zwei Jahren schwierig sein wird, die Situation schwer zu findender Chips zu entschärfen.

Aufgrund der kontinuierlichen Suche nach GPUs, die knapp sind, sind die GPUs von Nvidia für einige KI-Start-ups sogar zu einer harten Währung geworden.

Als Cloud-Computing-Startup war es für CoreWeave nicht einfach, einen Startup-Kredit zu bekommen. Dank Nvidias Investorenstatus kann CoreWeave sogar die H100-GPU als Sicherheit nutzen und problemlos einen Kredit in Höhe von 2,3 Milliarden US-Dollar erhalten.

Aus Sicht des Kreditgebers wird es sich hierbei natürlich nicht um ein verlustbringendes Geschäft handeln.

Einerseits wird dieses Darlehen es CoreWeave ermöglichen, seinen Rechenumfang und seine Rechenleistung schnell zu erweitern und seine Fähigkeit zur Rückzahlung des Darlehens zu verbessern. Andererseits wird Nvidia im nächsten Jahr weitere iterative GPUs auf den Markt bringen. Mit dem Darlehen kann CoreWeave auch die Gelegenheit, die GH200-GPU zu ergattern, die nächstes Jahr verfügbar sein wird.

Wie bereits erwähnt, ist die Situation von KI-Start-ups, die nicht stark sind, natürlich noch besorgniserregender, da die Top-Hersteller keine GPUs auf dem Markt ergattern können.

Einige intelligente KI-Start-ups können sich nur dafür entscheiden, einen anderen Weg zu finden, zusammenzuhalten und in die Arme von Nvidia zu investieren.

Im Juni dieses Jahres gab das Startup für künstliche Intelligenz Inflection AI offiziell bekannt, dass es eine neue Finanzierungsrunde in Höhe von 1,3 Milliarden US-Dollar abgeschlossen hat. Es ist erwähnenswert, dass NVIDIA zum ersten Mal in der brandneuen Investitionsliste auftauchte.

Sobald die Finanzierung gesichert ist, wird Inflection die Kehrtwende machen und 22.000 H100-GPUs von Nvidia kaufen, um einen fortschrittlichen Supercomputer zu bauen, einschließlich eines Rack-Servers mit vier Knoten und fast 700 Intel Xeon-CPUs

Inflection AI gab bekannt, dass es mit den Partnern CoreWeave und NVIDIA den weltweit größten KI-Cluster aufbauen wird.

Die scheinbar glückliche Allianz ähnelt eher einer hilflosen Entscheidung. Mustafa Suleyman, CEO von Inflection AI, sagte in einem Interview mit der New York Times: „Das Unternehmen ist nicht verpflichtet, die Produkte von Nvidia zu verwenden, aber Wettbewerber haben keine brauchbaren Alternativen bereitgestellt.“

Dieses Jahr ist Nvidias „Dreißigjähriges Jahr“. Am letzten Tag im Mai wurde Nvidia das weltweit erste Chipunternehmen mit einem Marktwert von mehr als 1 Billion US-Dollar. Dies ist auch das neunte Technologieunternehmen in der Geschichte, das den Marktwert von einer Billion US-Dollar erreichte Verein.

Im Juni dieses Jahres wurde Huang Renxun, der ein Abschlusskleid trug, eingeladen, an der Abschlussrede der Taiwan University of China teilzunehmen, und nutzte seine früheren Lebenserfahrungen, um eine Botschaft an die Absolventen zu senden.

Was auch immer es ist, gehen Sie ihm mit aller Kraft nach, rennen Sie! Gehen Sie nicht langsam.

Ob es darum geht, nach Nahrung zu rennen oder von anderen nicht als Nahrung behandelt zu werden.

Oft weiß man nicht, in welcher Situation man sich befindet, also rennt weiter, egal was passiert.

Die Chance der Geschichte ist vergänglich, und der GPU-Track könnte ein weiterer Track sein, bei dem der Gewinner alles bekommt.

Huang Renxun, der wild gelaufen ist, nutzte die Chance der KI und sorgte dafür, dass Nvidia, das in einer Restaurantkette am Straßenrand geboren wurde, erfolgreich in den Billionen-Dollar-Club eintrat und der größte Gewinner dieser KI-Welle wurde und vielleicht weitermachen wird um die nächste Ära anzuführen.

#Willkommen beim offiziellen öffentlichen WeChat-Konto von Aifaner: Aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so schnell wie möglich präsentiert.

Ai Faner | Ursprünglicher Link · Kommentare anzeigen · Sina Weibo