Ein neues Modell nahe GPT-4 wird veröffentlicht! „Europäische Version von OpenAI“ hat sich mit Microsoft zusammengetan, wurde jedoch in Frage gestellt, weil es gegen seine ursprüngliche Absicht verstößt

Gestern Abend hat Mistral AI, bekannt als „European OpenAI“, sein neuestes Top-Level-Textgenerierungsmodell Mistral Large veröffentlicht.

Dieses Modell verfügt über Argumentationsfunktionen auf höchstem Niveau und kann zur Bewältigung komplexer mehrsprachiger Argumentationsaufgaben verwendet werden, die das Textverständnis, die Transformation und die Codegenerierung umfassen.

Zeichnen Sie einfach die wichtigsten Punkte auf:

- 32K-Kontextfenster zum genauen Extrahieren großer Dokumentinformationen.

- Präzise Befehlsverfolgungsfunktionen ermöglichen es Entwicklern, Prüfstrategien anzupassen.

- Unterstützt Funktionsaufruf- und Ausgabemodusbeschränkungen, um die Anwendungsentwicklung zu skalieren und Technologie-Stacks zu modernisieren.

- Muttersprachliche Unterstützung für Englisch, Französisch, Spanisch, Deutsch und Italienisch, mit tiefem Verständnis der Grammatik und des kulturellen Hintergrunds.

Im Anhang finden Sie die Erlebnisadresse: https://chat.mistral.ai/chat

Mistral AI erweitert seine Fähigkeiten erneut

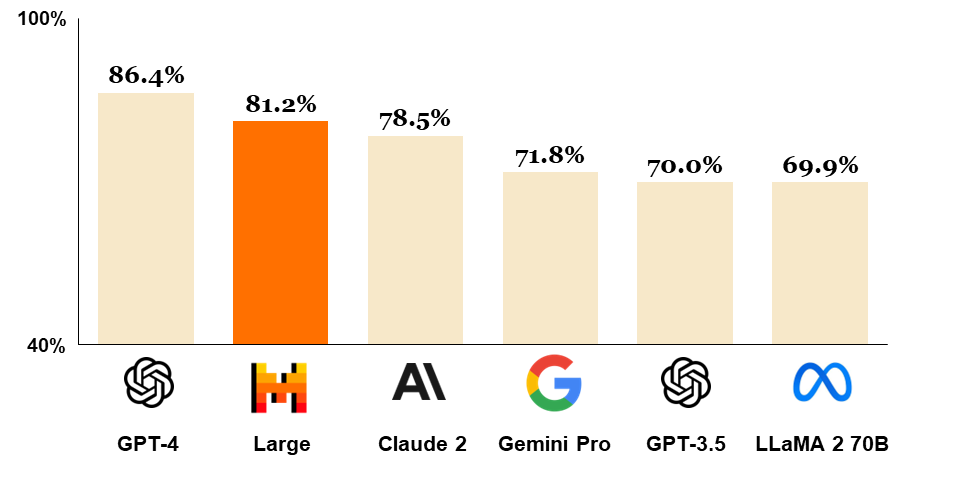

Mistral Large hat in mehreren Benchmark-Tests gut abgeschnitten und ist dank API das am zweithäufigsten verwendete Modell der Welt, direkt hinter GPT-4, und lässt andere Mainstream-Modelle hinter sich.

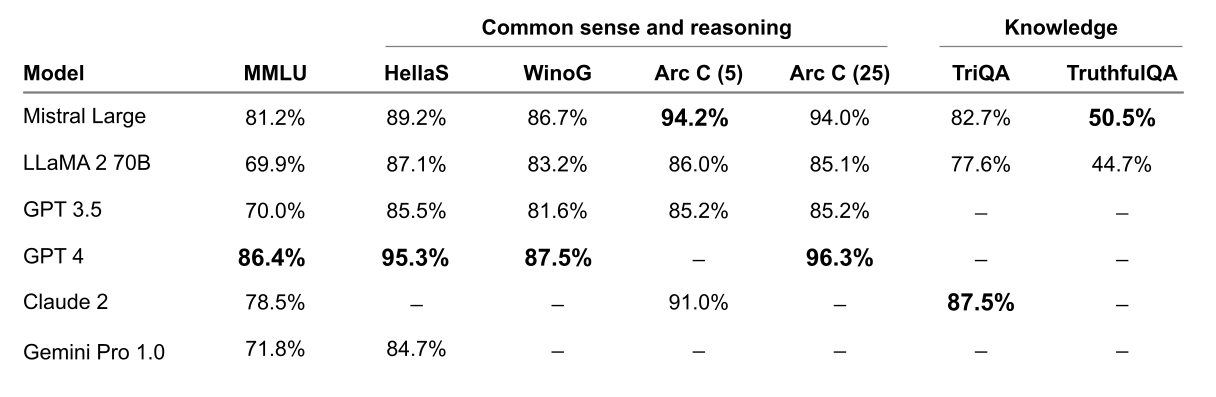

Im Vergleich zu LLaMA 2 70B, GPT-4, Claude 2, Gemini Pro 1.0 und anderen Mainstream-Modellen weist Mistral Large eine starke Denkfähigkeit auf.

In mehreren Common-Sense- und Reasoning-Benchmarks wie MMLU, Hellas und WinoG folgt Mistral Large GPT-4 und übertrifft andere Modelle bei weitem.

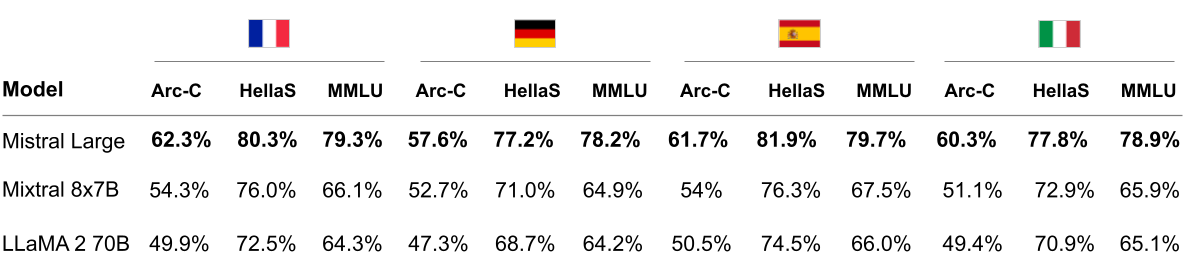

Mistral Large schneidet bei den HellaSwag-, Arc Challenge- und MMLU-Benchmarks in Französisch, Deutsch, Spanisch und Italienisch deutlich besser ab als LLaMA 2 70B.

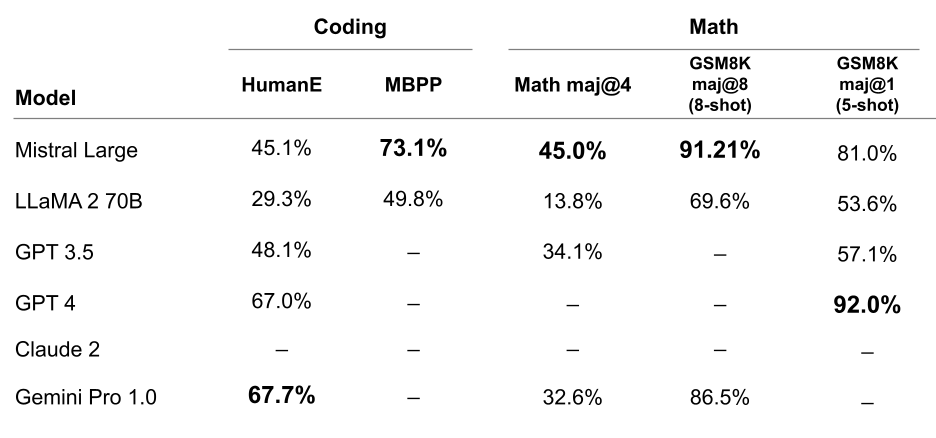

Mistral Large schnitt auch bei Codierungs- und Mathematikaufgaben gut ab. Viele Benchmark-Tests sind noch weit entfernt.

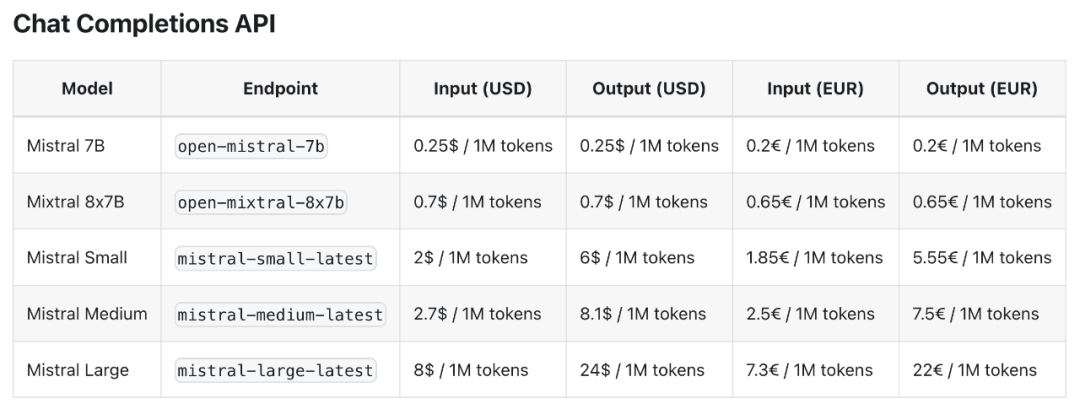

Darüber hinaus hat Mistral AI auch ein neues, auf Latenz und Kosten optimiertes Modell veröffentlicht, Mistral Small, das Mixtral 8x7B in der Leistung übertrifft, aber eine geringere Latenz aufweist.

Nach Ansicht von Mistral AI wird Mistral Small eine ideale Mittelwahl zwischen Open-Source- und Flaggschiff-Modellen sein und die gleichen innovativen Vorteile wie Mistral Large genießen, insbesondere im Hinblick auf die RAG-Aktivierung (Retrieval Augmentation Generation) und Funktionsaufrufe.

Allerdings sind die vom Mistral Small-Modell beanspruchten Eigenschaften einer geringen Latenz im Vergleich zum Mixtral 8x7B begrenzt, aber seine Kosten sind deutlich höher, wobei die Eingabekosten 2,8-mal höher und die Ausgabekosten sogar 8,5-mal höher sind.

Mistral Large ist jetzt auf den Plattformen La Plateforme und Azure verfügbar und in Le Chat integriert. Le Chat (wörtlich übersetzt „Katze“ auf Französisch) ist ein KI-Chatbot ähnlich wie ChatGPT, der mehrsprachige Kommunikation unterstützt.

Benutzer können zwischen drei verschiedenen Modellen wählen: Mistral Small, Mistral Large und Mistral Next. Allerdings unterstützt Le Chat keine Echtzeit-Netzwerkfunktionalität.

Kurz nach der Veröffentlichung stürzte Le Chat ab, weil eine größere Menschenmenge als erwartet zu dem Erlebnis strömte, und bei Redaktionsschluss ist Le Chat wieder in Betrieb.

Auch Le Chat erlebten wir zum ersten Mal. Abhängig von der Komplexität der Sprache selbst und der Menge und Qualität der empfangenen Trainingsdaten ist Le Chat auf Englisch ausdrucksstärker und kann in anderen Sprachen von Sprache zu Sprache variieren.

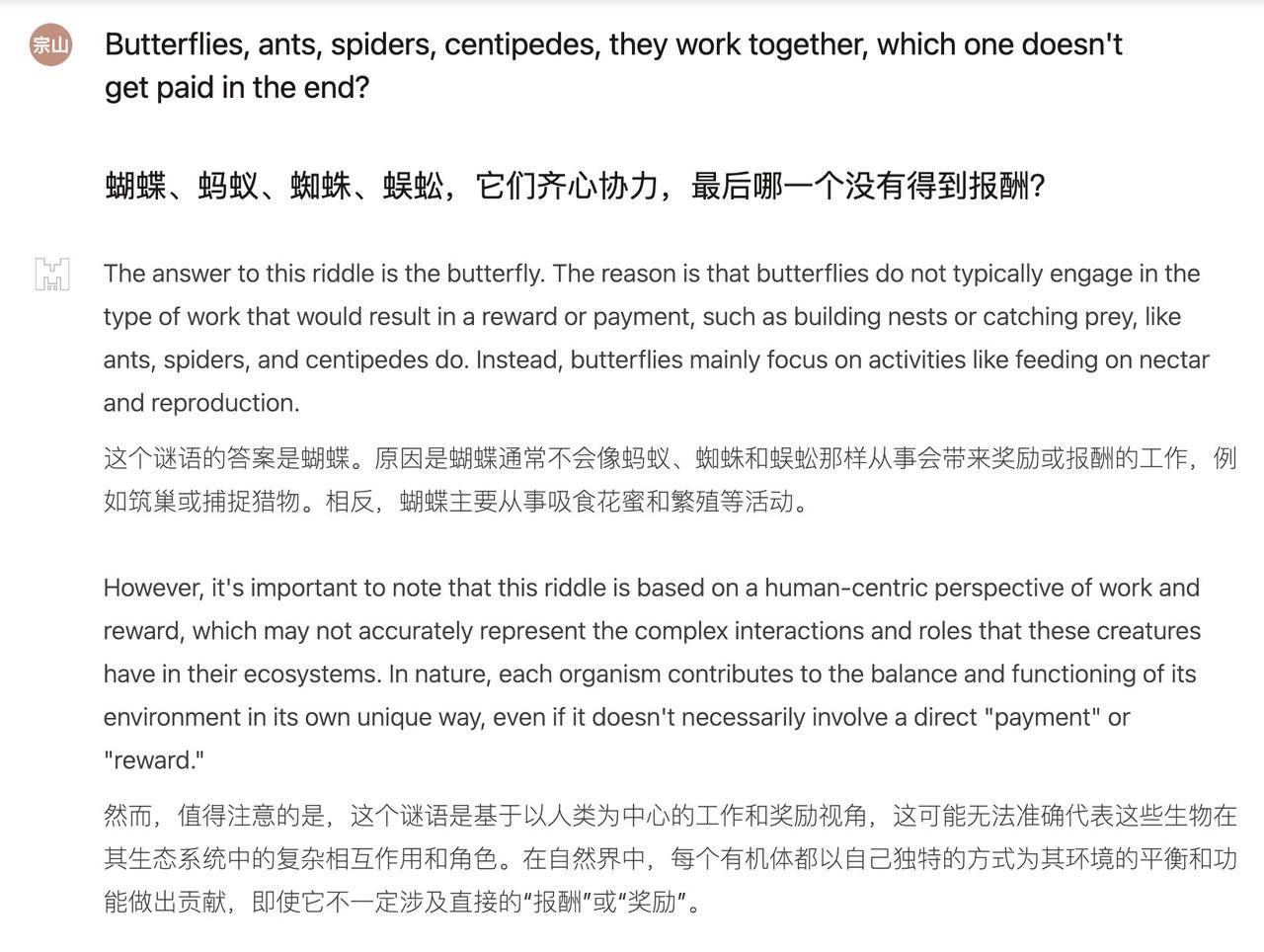

Angesichts der chinesischen Denkaufgabe war Mistral Large offensichtlich etwas verwirrt und gab eine Weile keine Antwort.

Frage: Schmetterling, Ameise, Spinne, Tausendfüßler, sie arbeiten zusammen, wer wird am Ende nicht bezahlt?

Aber wenn man es auf Englisch umstellt, verwandelt es sich sofort in einen Problemlösungsexperten. Die Antworten sind klar und logisch, und es entsteht eine „menschenzentrierte Perspektive von Arbeit und Belohnungen.“ Allerdings sind die Denksportaufgaben im chinesischen Kontext Folgen Sie nicht dem gesunden Menschenverstand. Schließlich wird „Centipede“ nicht belohnt.

Das Problem, dass Hühner und Kaninchen im selben Käfig leben, ist für Mistral Large kein Kinderspiel. Nach dem Aufstellen der linearen Gleichungen kam die Antwort schnell heraus, aber die 16 Hühner und 19 Kaninchen in der Antwort waren falsch.

Frage: Im selben Käfig befinden sich Hühner und Kaninchen mit insgesamt 35 Köpfen und 94 Beinen. Wie viele Hühner und Kaninchen sind es?

Dabei handelt es sich um ein klassisches mathematisches Problem, das mithilfe eines linearen Gleichungssystems gelöst werden kann.

Unter der Annahme, dass die Anzahl der Hühner x und die Anzahl der Kaninchen y beträgt, können die folgenden zwei Gleichungen aufgeführt werden:

1. x + y = 35 (die Gesamtzahl der Hühner und Kaninchen beträgt 35)

2. 2x + 4y = 94 (das Huhn hat 2 Beine und das Kaninchen hat 4 Beine, also insgesamt 94 Beine)

Drücken Sie x in der ersten Gleichung als Funktion von y aus, um x = 35 – y zu erhalten, und setzen Sie es in die zweite Gleichung ein, um Folgendes zu erhalten:

2(35 – J) + 4J = 94

Das Lösen der Gleichung ergibt y = 19. Das Einsetzen von x = 35 – y ergibt x = 16.

Daher gibt es 16 Hühner und 19 Kaninchen.

Die beiden letztgenannten Fragen können auf die gleiche Weise gelöst werden. Die Antworten lauten: 16 Hühner und 19 Kaninchen.

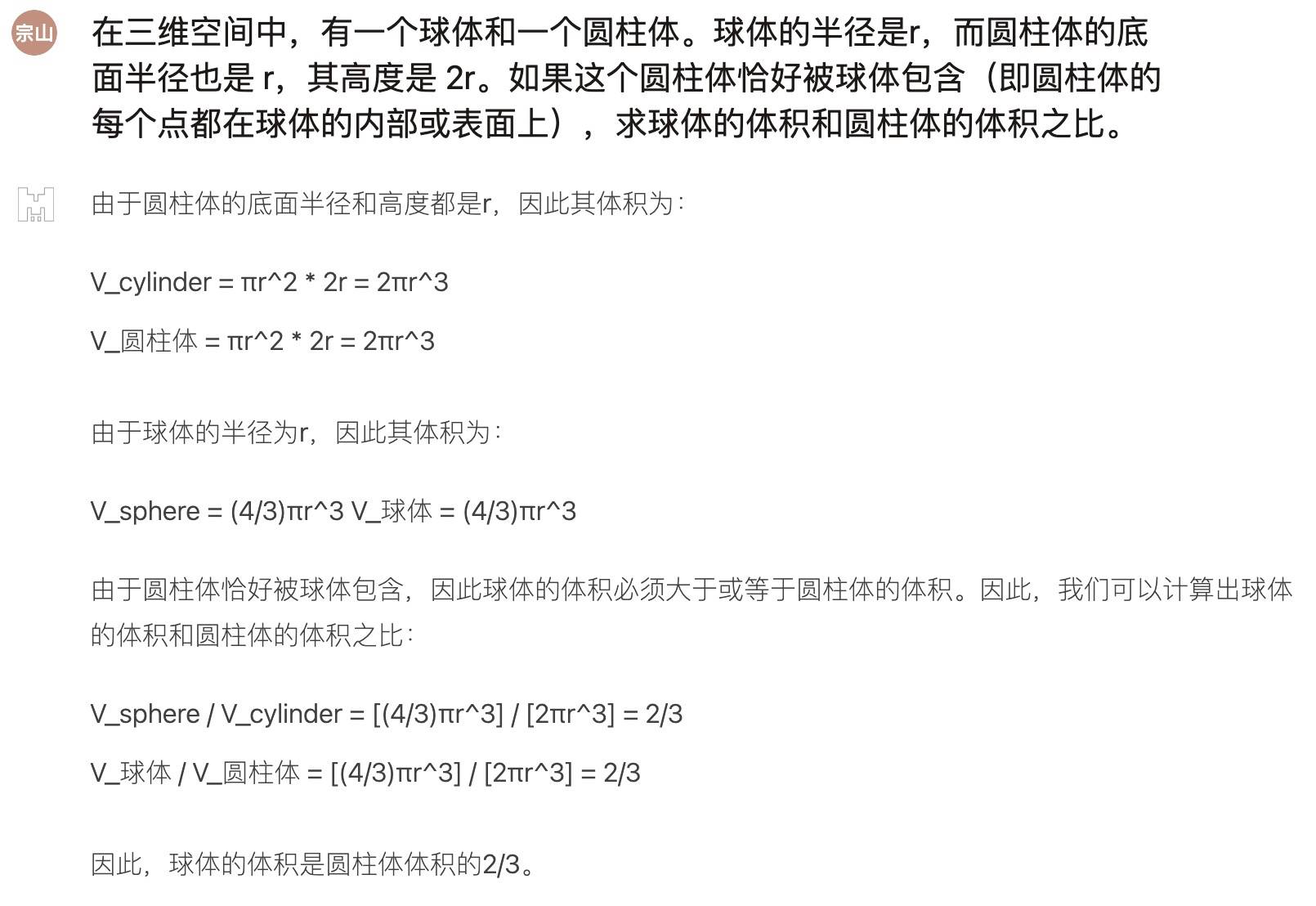

Dann haben wir ChatGPT gebeten, Mistral Large eine Mathe-Testfrage zu stellen, die zwar intensiver war, aber insgesamt eine gute Leistung erbrachte:

Kleines Modell, große Leistung

Mistral AI wurde im Mai letzten Jahres mit nur 25 Mitarbeitern gegründet, sein großes Sprachmodell ist jedoch bereits auf Hugging Face berühmt geworden.

Zuvor berichteten wir über die Veröffentlichung von Mixtral 8x7B. Als dieses Modell auf den Markt kam, begeisterte es sofort die Open-Source-Community und sorgte dafür, dass unzählige Entwickler nachts nicht schlafen konnten.

Obwohl es nur eine Parametergröße von 46,7 B hat, ist die Leistung von Mixtral 8x7B, die sowohl im Kleinen als auch im Großen gut ist, in vielen Benchmark-Tests mit Llama 2 70B und GPT-3.5 vergleichbar und in einigen Tests sogar etwas besser.

Das Erfolgsgeheimnis von Mistral AI liegt in der cleveren Integration der drei Kernelemente im KI-Bereich – Talent, Daten und Rechenleistung.

Der Economist enthüllte, dass die Gründer und technischen Rückgrate von Mistral AI alle von Frankreichs Elite-Technikinstituten kamen und wertvolle Branchenerfahrung in den Forschungslabors von Technologiegiganten wie Google und Meta gesammelt haben. Sie gehören zu den wenigen Experten auf der Welt, die das Training modernster Modelltechnik wirklich beherrschen.

Zweitens sind Daten eine weitere magische Waffe für den Erfolg von Mistral AI. Mistral ist einzigartig im Modelldatentraining. Beispielsweise kann das Modell sich wiederholende oder bedeutungslose Informationen effektiv herausfiltern, wodurch das Modell schlanker und effizienter wird und eine Parameterskala von nur Milliarden beträgt.

Dies bedeutet, dass normale Benutzer Mistral-KI-Modelle sogar problemlos auf ihren eigenen PCs ausführen können.

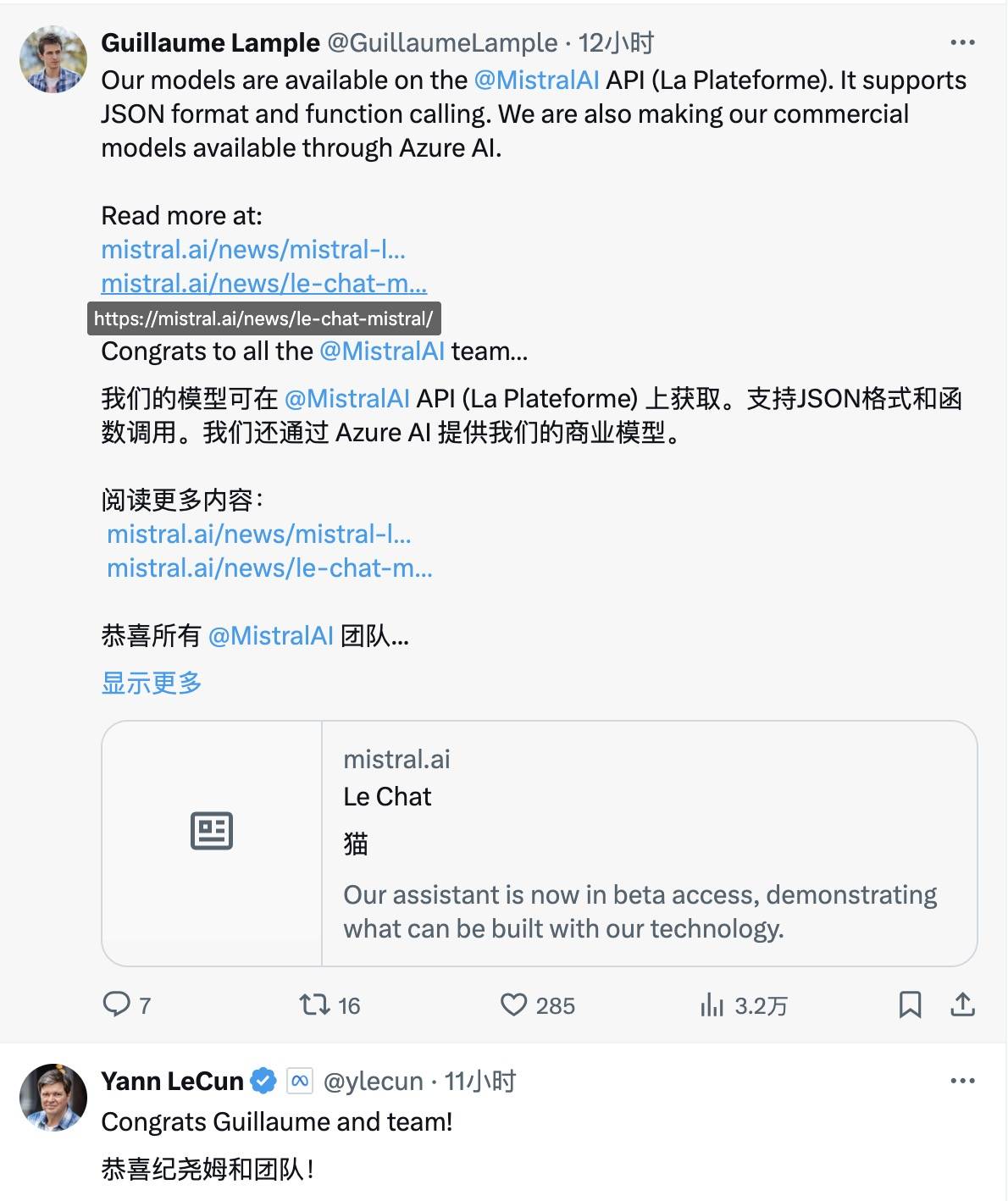

Zur Ankunft von Mistral Large schickten auch der Turing-Award-Gewinner Yann LeCun, der leitende NVIDIA-Wissenschaftler Jim Fan und andere große Namen Glückwünsche zu X.

Derzeit liegt der Wert von Mistral AI bei über 2 Milliarden US-Dollar, und die dahinter stehende Investitionspalette steht der der weltweit führenden Unternehmen in nichts nach.

Von den führenden Risikokapitalgesellschaften in den Vereinigten Staaten wie Lightspeed Venture Capital, Redpoint Venture Capital und Index Venture Capital bis hin zu den Risikokapitalgiganten a16z, NVIDIA, Salesforce, BNP Paribas usw. aus dem Silicon Valley bevorzugen sie alle Mistral AI. Nach mehreren Finanzierungsrunden ist Mistral AI bereits in die Riege der KI-Einhörner aufgestiegen.

Microsoft gab gestern außerdem eine neue Partnerschaft mit Mistral AI bekannt und versprach, dass sich die Zusammenarbeit mit Mistral AI auf die folgenden drei Schlüsselbereiche konzentrieren wird:

Supercomputing-Infrastruktur: Microsoft wird Mistral AI über die Azure AI-Supercomputing-Infrastruktur für KI-Training und Inferenz-Workloads unterstützen.

Erweiterter Marktplatz: Microsoft und Mistral AI werden den Kunden die erweiterten Modelle von Mistral AI über den MaaS- und Azure Machine Learning-Modellkatalog in Azure AI Studio zur Verfügung stellen.

KI-Forschung und -Entwicklung: Microsoft und Mistral AI werden eine Zusammenarbeit prüfen, um proprietäre Modelle für ausgewählte Kunden zu entwickeln, auch für Workloads im europäischen öffentlichen Sektor.

Aber der Schritt von Microsoft wurde von Internetnutzern in Frage gestellt. Der X-Benutzer @osxzxso deutete an, dass Microsoft versuche, eine „komplizierte“ Strategie zu verfolgen, um den Markt zu monopolisieren. Musk drückte seine Zustimmung auch im Kommentarbereich mit einem verblüffenden Emoji aus.

Ich sehe Nutella auf beiden Seiten des Brotes verteilen

Ich sah Erdnussbutter auf beiden Seiten des Brotes verteilen

Es ist erwähnenswert, dass aufmerksame Internetnutzer beobachtet haben, dass nach der Einführung des neuen Modells durch Mistral AI der relevante Inhalt auf seiner offiziellen Website über sein Engagement für die Open-Source-Community stillschweigend verschwunden ist und das neue Modell Open Source nicht unterstützt.

Allerdings sagte Mistral-CEO Mensch in einem Interview mit dem Wall Street Journal, dass Mistral AI nicht gegen die ursprüngliche Absicht von Open Source verstoßen habe, sondern eine Doppelstrategie verfolgt habe, bei der gleichzeitig Kommerzialisierungsstrategien gefördert und Open-Source-Verpflichtungen aufrechterhalten würden.

Natürlich müssen wir ein gutes Gleichgewicht zwischen dem Aufbau eines Geschäftsmodells und der Wahrung unserer Open-Source-Werte finden. Wir wollen neue Dinge und neue Architekturen erfinden, unseren Kunden aber auch verkaufsfähigere Produkte bieten.

# Willkommen beim offiziellen öffentlichen WeChat-Konto von aifaner: aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner | Ursprünglicher Link · Kommentare anzeigen · Sina Weibo