Sobald ChatGPT menschliche Sprache sprechen kann, wird die KI-Verschmutzung des Internets noch gravierender

Was die Menschen am meisten fürchten, ist passiert.

Ich lese zufällig ein paar Nachrichtenartikel im Internet, kann aber nicht sagen, ob sie von KI oder Menschen stammen. Wenn ich in meiner Freizeit Spiele spiele, kann ich nicht sagen, ob meine Teamkollegen KI-Menschen oder echte Menschen sind.

Im Live-Übertragungsraum lutschten die digitalen Prominenten selbst Hühnerfüße und schufen so eine Szene, die von den echten Assistenten getrennt war, die riefen …

Laut Foreign Media 404 Media ist Wordfreq, ein Projekt, das ursprünglich dazu diente, die Beliebtheit und Häufigkeit der Verwendung verschiedener Wörter und Vokabeln in mehreren Sprachen zu verfolgen und zu analysieren, nun das jüngste Opfer.

Wo die Sonne scheint, lauert immer ein Schatten, und es ist klar, dass Wordfreq nicht das erste Opfer ist und auch nicht das letzte sein wird.

Mit anderen Worten: Letztendlich können es die Menschen selbst sein, die dafür bezahlen.

GPT verschmutzt die Sprache und der Mensch muss dafür bezahlen

„Generative KI hat die Daten verunreinigt, und ich glaube nicht, dass irgendjemand verlässliche Informationen über den menschlichen Sprachgebrauch nach 2021 hat.“

Dieser Schrei aus dem Herzen von Robin Spear, dem Gründer des Wordfreq-Projekts, offenbart ein wenig Hilflosigkeit und Groll.

Um den Grund dafür zu erforschen, müssen wir mit dem Ursprung von Wordfreq beginnen.

Durch die Analyse von Inhalten aus Wikipedia, Film- und Fernsehuntertiteln, Nachrichtenberichten und Websites wie Reddit versucht Wordfreq, die Entwicklung von mehr als 40 Sprachen zu verfolgen und anschließend die sich ändernden Sprachgewohnheiten zu untersuchen, wenn sich Slang und Popkultur ändern.

Wordfreq ist eine Fundgrube für Linguisten, Autoren und Übersetzer. Doch nun hat eine große Aussage auf der GitHub-Adresse „Dieses Projekt wird nicht mehr aktualisiert“ leider den Todesstoß für dieses Projekt eingeläutet.

In der Vergangenheit war das Auslesen öffentlicher Daten aus dem Web die Lebensader der Datenquelle des Projekts, aber der Aufstieg der generativen KI hat KI-Text populär gemacht.

Spear gab ein typisches Beispiel: In der Vergangenheit wurde das Wort „Delve“ selten verwendet. Da ChatGPT dieses Wort jedoch eher als Li Kui ausgab, verfälschte dies manchmal die Worthäufigkeitsstatistik genaue Analyse menschlicher Sprachgewohnheiten.

Wenn dies nicht intuitiv genug ist, sind die zunehmenden Klischees wie „zusammenfassend“ und „zusammenfassend“ die auffälligsten Warnungen.

Dieser Trend dringt allmählich in das akademische Schreiben und sogar in das literarische Schaffen ein.

Ein Bericht der Stanford University wies darauf hin, dass ChatGPT für viele Experten und Wissenschaftler in nur fünf Monaten zu einem „Schreibartefakt“ geworden ist. Unter ihnen stammen im Bereich der Informatik fast alle sechs Abstracts und alle siebten Einführungen von ihm.

Was folgt, ist die „massive Invasion“ des menschlichen Schreibstils durch generative KI.

Die Forschungsergebnisse von Geng Mingmeng, einem Doktoranden am Italian Institute for International Advanced Studies, sind wie ein Spiegel, der die Wortpräferenzen von ChatGPT weiter widerspiegelt und seinen Einfluss auf das Verfassen wissenschaftlicher Arbeiten voll und ganz bestätigt.

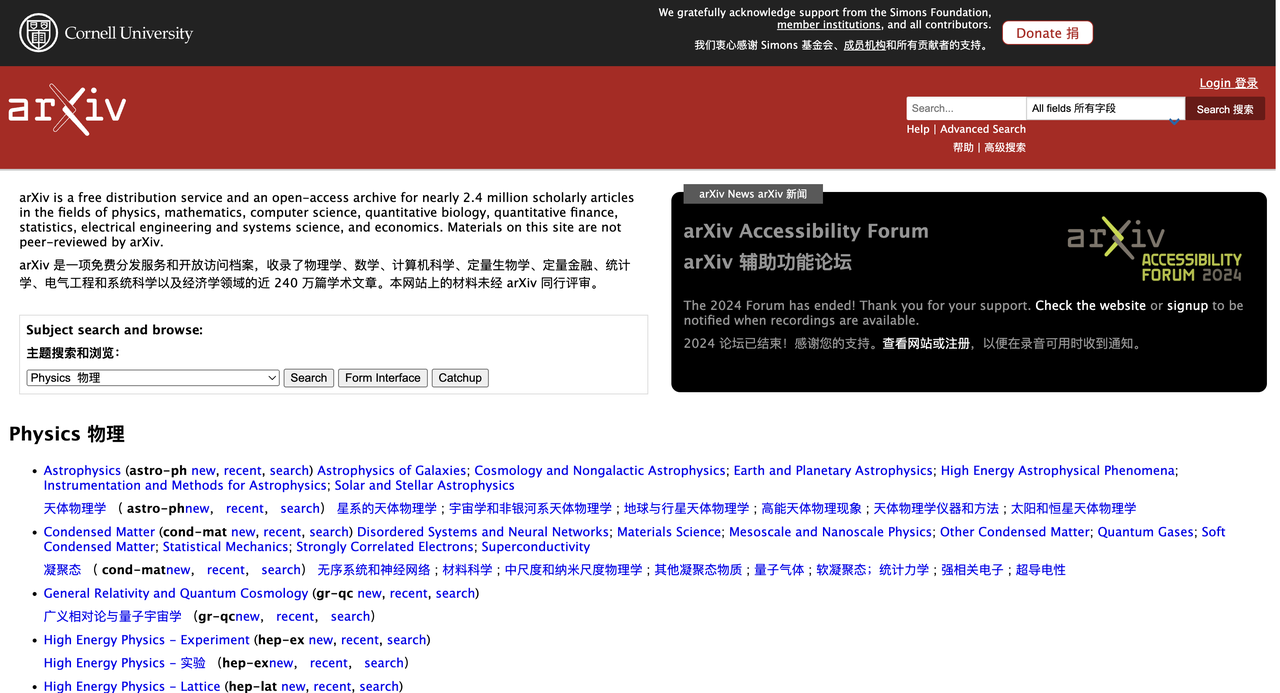

Nach der Analyse der Abstracts von mehr als einer Million Artikeln auf arXiv stellte Geng Mingmeng fest, dass sich die Worthäufigkeit von Artikeln seit der Popularität von ChatGPT erheblich verändert hat. Unter ihnen hat die Häufigkeit der Verwendung von Wörtern wie „signifikant“ deutlich zugenommen, während die Häufigkeit der Verwendung von Wörtern wie „ist“ und „sind“ um etwa 10 % zurückgegangen ist.

In den meisten Fällen kann generative KI eine Person mit einem Kreativitätswert von 60 in einen Wert von 70 oder höher verwandeln. Obwohl sich die persönliche Kreativität und die Schreibqualität verbessert haben, ist die kollektive Kreativität unsichtbar geworden .

Zwei Wissenschaftler der UCL und der University of Exeter veröffentlichten in Science eine Studie, in der 500 Teilnehmer beauftragt wurden, mithilfe von KI etwa acht Zeilen mit Geschichten zu zufälligen Themen zu schreiben und die Zielgruppe zu analysieren.

Die Ergebnisse zeigten, dass die Geschichten mit Hilfe der KI-Inspiration „kreativer“ wurden, aber die von diesen KIs generierten Geschichten waren einander auch überraschend ähnlich.

Wenn daher generative KI-Texte wie ein allgegenwärtiger Schadstoff ins Internet strömen, überwiegen die Vorteile für Wordfreq und den Menschen bei weitem die Nachteile.

Der Anti-Crawler-Krieg beginnt, Wordfreq leidet

Die Beendigung des Wordfreq-Projekts kann als Opfer des gigantischen Crawler-Krieges betrachtet werden.

Die Entwicklung von KI ist untrennbar mit der Unterstützung von Algorithmen, Rechenleistung und Daten verbunden. Obwohl es immer noch eine Lücke zwischen dem von KI generierten Text und der echten menschlichen Sprache gibt, wird er in Bezug auf Grammatik und Logik immer anständiger.

Unter diesem ruhigen Wasser braut sich ein stiller Krieg zwischen KI-Crawling und Anti-Crawling zusammen.

Im aktuellen Umfeld der öffentlichen Meinung scheint das Crawlen von Webseitendaten zu einem Tabu geworden zu sein. Viele Kommentarbereiche von Nachrichtenberichten sind mit der Stimme der Verachtung von Internetnutzern gefüllt, und Wordfreq besteht im Wesentlichen aus dem Crawlen von Texten in verschiedenen Sprachen .

Als generative KI noch nicht populär war, verbrachte auch Wordfreq seine Flitterwochen.

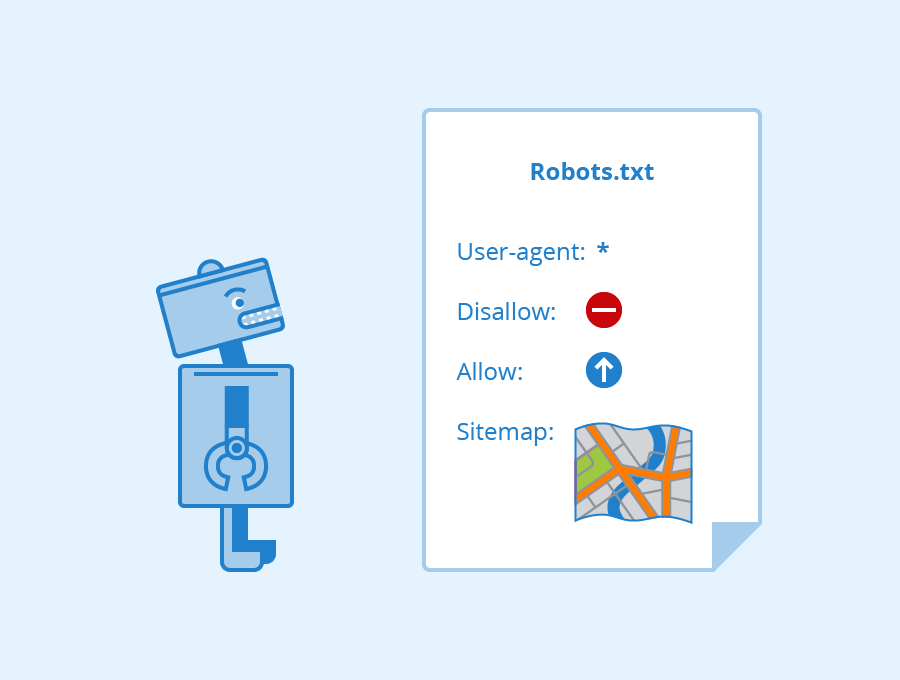

In der Vergangenheit schien es im Allgemeinen sinnvoll, öffentliche Daten zu crawlen, solange die Vorschriften für die robots.txt-Datei der Website eingehalten wurden. Hierbei handelt es sich um eine stillschweigende Vereinbarung zwischen der Website und dem Crawler, die dazu dient, dem Crawler mitzuteilen, welche Inhalte gecrawlt werden können und welche nicht.

Wenn eine Website eine robots.txt-Einschränkungsvereinbarung festlegt, ist das so, als würde man ein Verbotsschild aufstellen. Wenn der Crawler gegen die robots.txt-Vereinbarung verstößt oder eine Methode verwendet, die die Anti-Crawler-Technologie der Website durchbricht, um an Daten zu gelangen, kann dies einen unlauteren Wettbewerb oder eine Urheberrechtsverletzung und andere rechtswidrige Handlungen darstellen.

Da jedoch der Bedarf des Modells an qualitativ hochwertigen Daten steigt, wird der Kampf zwischen Crawling und Anti-Crawling immer härter.

Rückblickend gibt es viele Streitigkeiten über generative KI-Giganten-Crawler- und Anti-Crawler-Daten. Die bekanntesten sind natürlich OpenAI und Google.

Letztes Jahr brachte OpenAI das Webcrawler-Tool GPTBot auf den Markt, das angeblich zum Crawlen von Webseitendaten zum Trainieren von KI-Modellen verwendet wird. Aber offensichtlich möchte kein Medium heimlich von Crawlern erfasst werden.

Medien, die sich der Bedeutung von Daten und Urheberrecht bewusst sind, folgen der Geschäftslogik, Geld in die eine und Daten in die andere Hand zu geben.

Eine vom Reuters-Institut durchgeführte Studie zeigt, dass bis Ende 2023 fast die Hälfte der beliebten Nachrichten-Websites in 10 Ländern weltweit den Crawler (Crawler) von OpenAI blockiert haben, und fast ein Viertel der Websites hat auch Google blockiert Der Crawler führt die gleiche Aktion aus.

Jeder sollte mit der folgenden Geschichte vertraut sein: Alle paar Tage wurde OpenAI von traditionellen Medien verklagt, und es handelte sich ausnahmslos um eine Urheberrechtsklage. Erst in diesem Jahr hat die von Rechtsstreitigkeiten geplagte OpenAI Partnerschaften mit Nachrichtenverlagen geschlossen.

Allerdings machten bisherige Strategien wie hohe Mauern und Datengebühren auch Wordfreq zum Opfer dieser „Datenknappheit“.

Spear weist darauf hin, dass es schwieriger geworden ist, das Web zu durchsuchen, seit Twitter und Reddit (eine in Wordfreq enthaltene Website) Gebühren für ihre APIs erheben.

„Informationen, die früher kostenlos waren, sind teuer geworden“, schrieb Spear. „Ich möchte mich nicht an Arbeiten beteiligen, die mit generativer KI verwechselt werden könnten oder die von generativer KI profitieren könnten.“

Selbst wenn Sie Geld gegen Daten eintauschen können, werden die Daten irgendwann aufgebraucht sein.

Das Forschungsunternehmen Epoch AI prognostiziert, dass die im Internet verfügbaren hochwertigen Textdaten bis 2028 erschöpft sein könnten. Dieses Phänomen wird in der Branche als „Datenwand“ bezeichnet und könnte zum größten Hindernis für die Verlangsamung der Entwicklung von KI werden.

Infolgedessen begannen viele große Modellhersteller, ihre Aufmerksamkeit auf synthetische Daten zu richten und sich auf die Verwendung von KI zum Trainieren von KI zu konzentrieren.

Die Verwendung von KI zum Trainieren von KI kann es „dumm“ machen, je mehr man es übt.

Meine Intuition ist, dass der Text im Internet Blödsinn ist und das Training dieser Daten eine Verschwendung von Rechenleistung darstellt.

Als Llama 3.1-405B mit seiner bahnbrechenden Leistung viele große Open-Source-Modelle eroberte, machte Thomas Scialom, der Meta-KI-Forscher, der die Llama-Reihe leitet, in einem Interview die oben genannten Bemerkungen.

Ihm zufolge basiert der Trainingsprozess von Llama 3 nicht auf von Menschen geschriebenen Antworten, sondern basiert vollständig auf synthetischen Daten, die von Llama 2 generiert wurden.

Scialoms Aussage mag zu grob sein, aber es steckt etwas Wahres darin.

Im Internet entsteht täglich ein stetiger Datenstrom, aber das Training von KI war schon immer eine Multiple-Choice-Frage. Wenn die Daten voller Fehler und Rauschen sind, lernt das Modell diese „Fehler“ und die Genauigkeit der Vorhersage und Klassifizierung kann man sich vorstellen.

Darüber hinaus sind Daten von geringer Qualität oft mit Verzerrungen behaftet und können die gesamte Datenverteilung nicht wirklich darstellen, was dazu führt, dass das Modell verzerrte Antworten liefert. Auch UNESCO-Generaldirektor Azoulay warnte:

„Neue KI-Tools haben die Macht, die Wahrnehmung von Millionen von Menschen unwissentlich zu verändern, sodass selbst minimale geschlechtsspezifische Vorurteile in generierten Inhalten die Ungleichheit in der realen Welt erheblich verschärfen können.“

Allerdings sind synthetische Daten möglicherweise kein Allheilmittel zur Lösung des „Datenwand“-Problems.

Kürzlich haben Forscher aus Oxford und Cambridge herausgefunden, dass, wenn ein Modell von KI generierte Datensätze verwendet, die Qualität der Ausgabe allmählich abnimmt und schließlich bedeutungslose Inhalte entstehen, was allgemein als Modellkollaps bekannt ist.

Der Forschungsleiter Ilia Shumailov nutzte die Analogie zum Aufnehmen eines Fotos, um den Prozess zu beschreiben:

Wenn Sie ein Foto aufnehmen, es scannen, ausdrucken, ein Foto davon machen und den Vorgang dann mit der Zeit wiederholen, wird der gesamte Vorgang praktisch von „Rauschen“ übertönt. Am Ende erhalten Sie ein dunkles Quadrat.

Wenn immer mehr von KI generierte Spam-Webseiten das Internet überschwemmen, werden auch die Rohstoffe für das Training von KI-Modellen verseucht.

Beispielsweise ist Stack Overflow, eine Q&A-Community für Programmierer, stark von KI betroffen.

Als ChatGPT zum ersten Mal populär wurde, kündigte Stack Overflow ein „vorübergehendes Verbot“ an. „Der durchschnittliche Anteil richtiger Antworten von ChatGPT ist zu gering“, beklagte der Beamte in der Stellungnahme.

Schließlich ist die Anzahl professioneller Benutzer begrenzt, es ist unmöglich, alle Antworten einzeln zu überprüfen, und die Fehlerquote von ChatGPT ist offensichtlich. Wenn KI die Umwelt der Gemeinschaft verschmutzt, können Menschen, die zu diesem Zeitpunkt nichts zu tun haben, sie nur verbieten.

Im Bereich der Bilder neigen KI-Modelle dazu, die gängigsten Daten zu reproduzieren, und nach vielen Iterationen vergessen sie möglicherweise sogar das Original.

All dies deutet auf einen Teufelskreis hin: KI generiert minderwertige oder sogar fehlerhafte Informationen, die mit menschlichen Daten vermischt werden. Diese im Allgemeinen minderwertigen Daten werden wiederholt von der KI gespeist, was schließlich dazu führt, dass die grassierende KI nach hinten losgeht.

Und wenn die Menschen erkennen, dass die Datenspuren der Vergangenheit für sie selbst zur Nahrung werden, werden wir vielleicht vorsichtiger mit jedem Wort sein, das wir im Internet hinterlassen.

# Willkommen beim offiziellen öffentlichen WeChat-Konto von Aifaner: Aifaner (WeChat-ID: ifanr) wird Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner |. Ursprünglicher Link · Kommentare anzeigen · Sina Weibo