Ein wichtiges Update des heimischen KI-Videoartefakts, das 4K, 60 Bilder und die Ära der Videogenerierung mit Ton unterstützt, finden Sie hier |

In diesem Jahr ist der Bereich der KI-Videogenerierung in vollem Gange.

Von der ersten Rollengenerierungszeit über die Qualität des Rollenbildes bis hin zur jüngsten Einführung von KI-Spezialeffekten haben Industriehersteller Rollen auf unterschiedliche Weise auf den Markt gebracht, aber alle haben ein gemeinsames Ziel: hart daran zu arbeiten, neue Benutzer zu gewinnen und Alte Benutzer behalten.

Obwohl viele Videomodelle auf dem Markt behaupten, Videos mit einem Klick zu generieren, sind die „Mime“-ähnlichen Fertigprodukte einigermaßen nutzlos. Insbesondere unsere Reizschwelle für KI-Videos wurde immer wieder angehoben und das Fehlen von Soundeffekten dringt wie ein eingeschlagener Nagel immer tiefer in die Herzen der Nutzer ein.

Natürlich ist es nicht so, dass die Hersteller dieses Problem nicht vollständig lösen wollen, sie warten nur auf eine Gelegenheit, mehr Erfahrungen zu sammeln.

Vor drei Monaten wurde Zhipu Qingying als erstes der Öffentlichkeit in China zugängliches Produkt zur Videogenerierung auf der Qingyan-App eingeführt, die mit nur einem Befehl oder einem Bild in 30 Sekunden KI-Videos erzeugen kann.

Heute, drei Monate später, leitete Zhipu Qingying erneut eine Welle großer Modernisierungen ein.

10 Sekunden Dauer, 4K, 60-Frame-Ultra-High-Definition-Bildqualität, jede Größe, bessere Aufgabenaktionen und physische Weltmodelle … Zusätzlich zu den grundlegenden Fähigkeiten zum Öffnen eines Buches, was noch wichtiger ist, wird Zhipu Qingying hier vorgestellt Monat, um die Soundeffekte zu erzeugen und anzupassen.

Im Anhang finden Sie die spezifischen Upgrade-Highlights von New Qingying:

- Tushengs Videoqualität, ästhetische Leistung, Bewegungsrationalität und semantisches Verständnis komplexer Aufforderungswörter wurden erheblich verbessert;

- Stärkere Details der Gesichtsleistung, Bewegungskohärenz und Simulation physikalischer Eigenschaften verbessern die Natürlichkeit und den Realismus des Videos.

- Unterstützt die Generierung von 10-s-, 4K- und 60-Frame-Ultra-High-Definition-Videos sowie die Bildgenerierung in jedem Verhältnis;

- Mit demselben Befehl/Bild können 4 Videos gleichzeitig generiert werden. Die zum Bild passende Soundeffektfunktion wird bald in diesem Monat als öffentliche Betaversion gestartet.

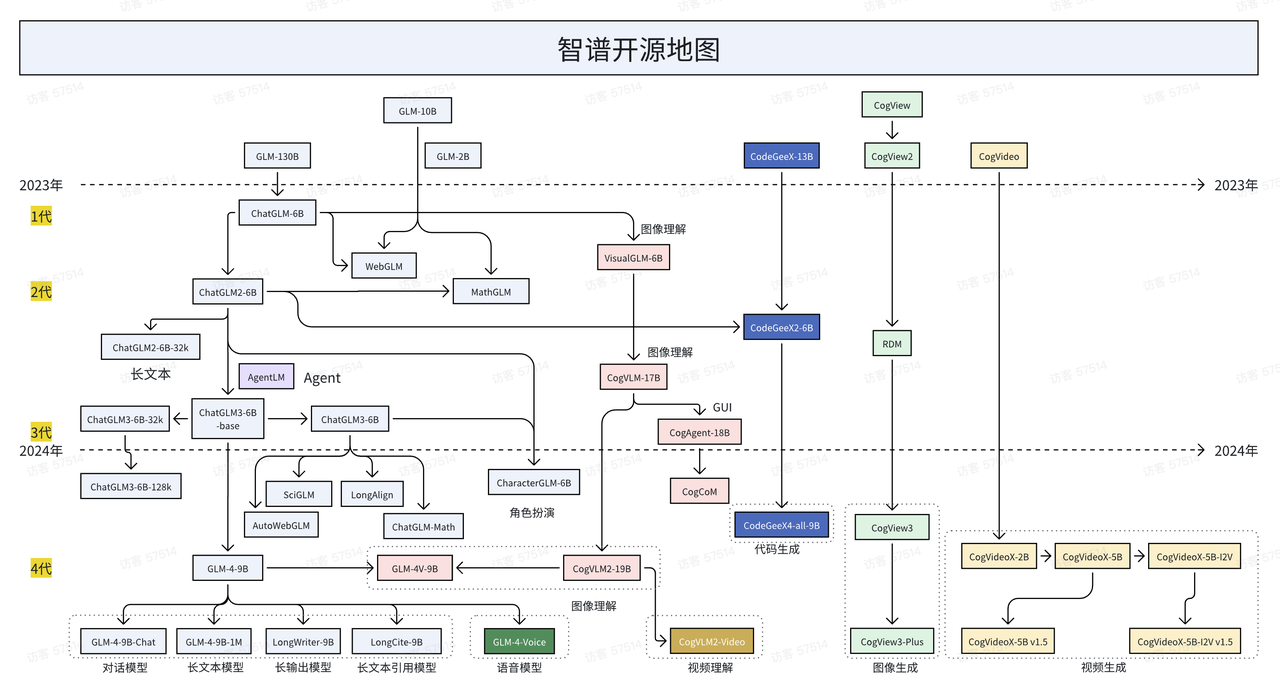

Darüber hinaus ist Zhipu eines der wenigen inländischen Unternehmen, das Open Source konsequent unterstützt, während noch immer über Open Source/Closed Source von KI debattiert wird. Heute hat Zhipu auch die neueste Version des Videomodells CogVideoX v1.5 offiziell veröffentlicht und als Open Source bereitgestellt.

Diese Open Source umfasst zwei Modelle: CogVideoX v1.5-5B und CogVideoX v1.5-5B-I2V. In Zukunft wird CogVideoX v1.5 auch gleichzeitig auf Qingying eingeführt und mit dem neu eingeführten CogSound-Soundeffektmodell kombiniert.

Code: https://github.com/thudm/cogvideo

Modell: https://huggingface.co/THUDM/CogVideoX1.5-5B-SAT

Offiziell angekündigt, dass New Qingying ab sofort in der Zhipu Qingyan-App verfügbar sein wird. Es gibt nicht viel zu sagen, fügen Sie einfach die Erlebnisadresse bei: https://chatglm.cn/video?lang=zh

4K 60 Bilder, neues klares Video hat die nächste Stufe erreicht

Der freundliche alte Mann lächelt und die Details seiner Gesichtsmuskeln sind deutlich sichtbar, ohne dass es zu Pixelbildung oder Unschärfe kommt.

Auch das Bild des Flammentigers ist beeindruckend. Nicht nur sein Gang wirkt realistisch, auch seine Augen offenbaren eine wilde Schönheit, und auch die Flammenfarbe auf seinem Körper zeigt satte Farbstufen und Tiefe.

Das Fahrzeug fährt mit hoher Geschwindigkeit, es gibt keine Verzögerungen oder Verzögerungen bei Szenenübergängen, selbst sich schnell bewegende Objekte können die Kontinuität aufrechterhalten und es ist auch gut darin, ein Gefühl von Geschwindigkeit und Spannung zu erzeugen.

Meows verwandeln sich online in Köche und braten die Gerichte von heute gekonnt an.

Lassen Sie sich nicht von der Rhetorik der Demo täuschen. Der Einstieg ist das einzige Kriterium, um die tatsächliche Wirkung zu testen.

Wir haben auch die Tusheng-Videofunktion verwendet, um ein Video vom Fliegen der Kongming-Laterne zu erstellen. Die Kongming-Laterne wurde losgelassen und stieg langsam in den Nachthimmel. Die Kamera folgte ihr von unten nach oben und der Himmel färbte sich tiefblau.

Oder wir haben die kleinen gelben Blumen, die still waren, „wieder zum Leben erweckt“, und die Brise wehte, und die kleinen gelben Blumen wiegten sich sanft im Gras.

Allerdings erfordert „New Qingying“ immer noch ein gewisses Maß an Kartenzeichnung. Dies ist auch ein häufiges Problem bei der Stabilität inländischer und ausländischer KI-Videomodelle. Bei der täglichen Verwendung solcher Produkte ist mehr Geduld erforderlich.

Für Videos ergänzen sich Soundeffekte und Bilder immer. Aus diesem Grund haben wir auch mehrere „Mime“-Videos verwendet, bei denen der Ton entfernt wurde, und die KI entsprechende Soundeffekte generieren lassen. Es wird empfohlen, die Lautstärketaste einzuschalten .

Zum Beispiel das klassischste Klavierduell in „Der Pianist am Meer“. Bevorzugen Sie diese oder die Originalversion?

Beeindruckt Sie die wunderschöne Feuerwerksshow, sobald sie am Nachthimmel erblüht, gepaart mit KI-Soundeffekten?

Die Geräusche von Regentropfen sind unterschiedlich, manche sind klar, manche tief, manche schnell und manche lang.

Der Ort der Atomexplosion ist riesig, aber das Geräusch ist nahezu verzögerungsfrei. Es eignet sich gut für die Simulation echter Explosionsgeräusche, Umgebungsgeräusche und Nachwirkungen.

Machen Sie sich keine Sorgen, hören Sie gut zu, es gibt auch das Avatar-Unterwasserabenteuer.

Wenn Cog Video

Von Stummfilm zu Ton – KI-Video tritt in die Ära der Tonfilme ein

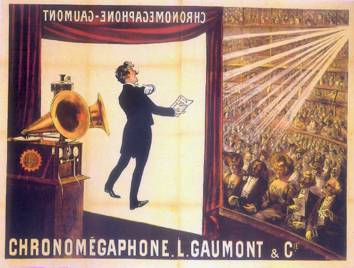

Die ersten Tonfilme wurden 1900 in Paris gezeigt, und erst ein Jahrzehnt später erreichte die Technologie, die Ton mit Bildern synchronisieren konnte, kommerzielle Standards.

Das Aufkommen des Tonfilms beendete nicht nur den Stillstand des Films seit seiner Geburt, sondern, was noch wichtiger ist, es verwandelte den Film von einer einzigen rein visuellen Kunst in eine neue Kunstform, die Audio und Video kombiniert.

Die Schauspieler des Films sprachen und das Publikum jubelte dem Tonfilm zu.

Die beiden Stimmen ihrer Herzenssymphonie und ihre Herztöne schwingen mit.

Heute wiederholt sich der Kreislauf der Geschichte von der „Pantomime“ zu Beginn des Jahres bis zu den heutigen KI-Soundeffekten. Wenn erstere immer noch auf 0-1 beschränkt ist, markiert die Hinzufügung von KI-Soundeffekten einen epischen Sprung 1-N.

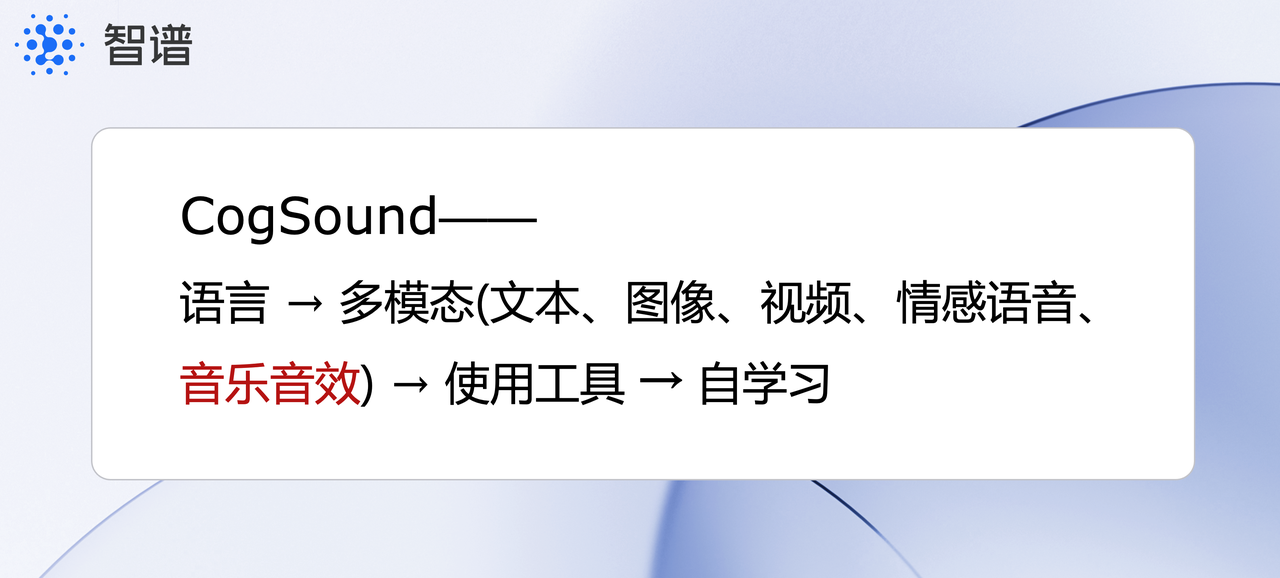

Basierend auf den Videoverständnisfähigkeiten von GLM-4V kann das Soundeffektmodell CogSound, ein neues Mitglied der Intelligent Spectrum-Familie, die Semantik und Emotionen hinter dem Video genau identifizieren und verstehen und auf dieser Grundlage passende Audioinhalte generieren.

Zum Beispiel Explosionen, Wasserströme, Musikinstrumente, Tiergeräusche, Fahrzeuggeräusche usw.

In Bilderzählungen ist der Einzug des Tons ein entscheidender Wendepunkt. Er sorgt nicht nur dafür, dass die Erzählung aus Videos herausbricht, die auf Text basieren, sondern eröffnet auch einen größeren Raum für Vorstellungskraft in Bezug auf Konzepte und Methoden.

Allerdings ist die Einführung von KI in der Film- und Fernsehbranche zweifellos umstritten.

Letzten Monat hat der Streik der Hollywood-Schauspieler nicht nachgelassen, und Regisseur Cameron sagte auf dem Gipfel, dass KI das Geschichtenerzählen in Filmen neu definieren und Drehbuchautoren und Regisseuren dabei helfen wird, neue Handlungsstränge und Erzähltechniken zu erkunden.

Auch in der Videoindustrie gibt es für Soundeffektmodelle vielfältige Anwendungsszenarien. Beispielsweise können sie Sounds für groß angelegte Kampfszenen und Katastrophenszenen in Filmen erzeugen, wodurch der Produktionszyklus erheblich verkürzt und die Produktionskosten gesenkt werden.

Doch wie genau sollte audiovisuelle Kunst im KI-Zeitalter aussehen?

Die technologische Explosion in der Geschichte hat uns auf einige Ideen gebracht. Wenn die Mechanisierung und Fließbandabläufe der industriellen Revolution eine standardisierte Massenproduktion ermöglichten, kann sie mit dem Aufkommen der KI durch das Erlernen einer großen Menge an Daten und Mustern den menschlichen Entscheidungsprozess nachahmen und den Entscheidungsprozess anpassen entsprechend den spezifischen Bedürfnissen jedes Benutzers. Personalisierter Service, der auf seine Bedürfnisse und Vorlieben zugeschnitten ist.

Kurz gesagt: Durch die Senkung der Nutzungsbarrieren ermöglicht KI jedem gewöhnlichen Menschen, die personalisierten Videos zu erstellen, die ihm gefallen.

Jean-Luc Godard, ein Vertreter der französischen Neuen Welle, diskutierte auch die Auswirkungen von Veränderungen in der Filmtechnologie auf Filmsprache und -kunst:

„Filme nutzen beim Drehen nicht nur Ton und Bilder, sondern bauen im Kopf des Publikums eine bestimmte Sprache auf. Stummfilme haben durch das Sehen mehr Möglichkeiten geschaffen, und Tonfilme haben diese Art der Kreation verändert.“

Im Februar dieses Jahres wurden die Erwartungen der Menschen an KI-Videos erstmals von Sora geweckt, das von OpenAI veröffentlicht wurde. Leider schien das Produkt bis zu diesem Zeitpunkt in eine „Tathagata“-Situation geraten zu sein und wurde noch nicht gesehen.

Auch in dieser Zeit freuen wir uns sehr, dass heimische Hersteller auf diesem Weg sogar gute Ergebnisse erzielt haben.

Allerdings ist dies möglicherweise nur ein Vorgeschmack darauf, dass wahre Intelligenz multimodal sein muss, wobei Hören, Sehen, Fühlen usw. gemeinsam an der Bildung der kognitiven Fähigkeiten des menschlichen Gehirns beteiligt sein müssen.

Der Aufbau einer multimodalen intelligenten Spektrum-Großmodellmatrix, die Text, Bilder, Vision und andere Modalitäten umfasst, kann die Anwendungs- und Werkzeugfunktionen großer Modelle weiter verbessern und bewegt sich auch in Richtung des ultimativen Ziels der KI – AGI.

An diesem Punkt kann man sagen, dass wir wirklich in die Ära der KI-Tonfilme eingetreten sind.

# Willkommen beim offiziellen öffentlichen WeChat-Konto von Aifaner: Aifaner (WeChat-ID: ifanr) wird Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner |. Ursprünglicher Link · Kommentare anzeigen · Sina Weibo