Abschrift des 20.000 Wörter umfassenden Interviews von Jen-Hsun Huang: Ich hoffe, dass Nvidia 50.000 Mitarbeiter und 100 Millionen KI-Assistenten haben wird

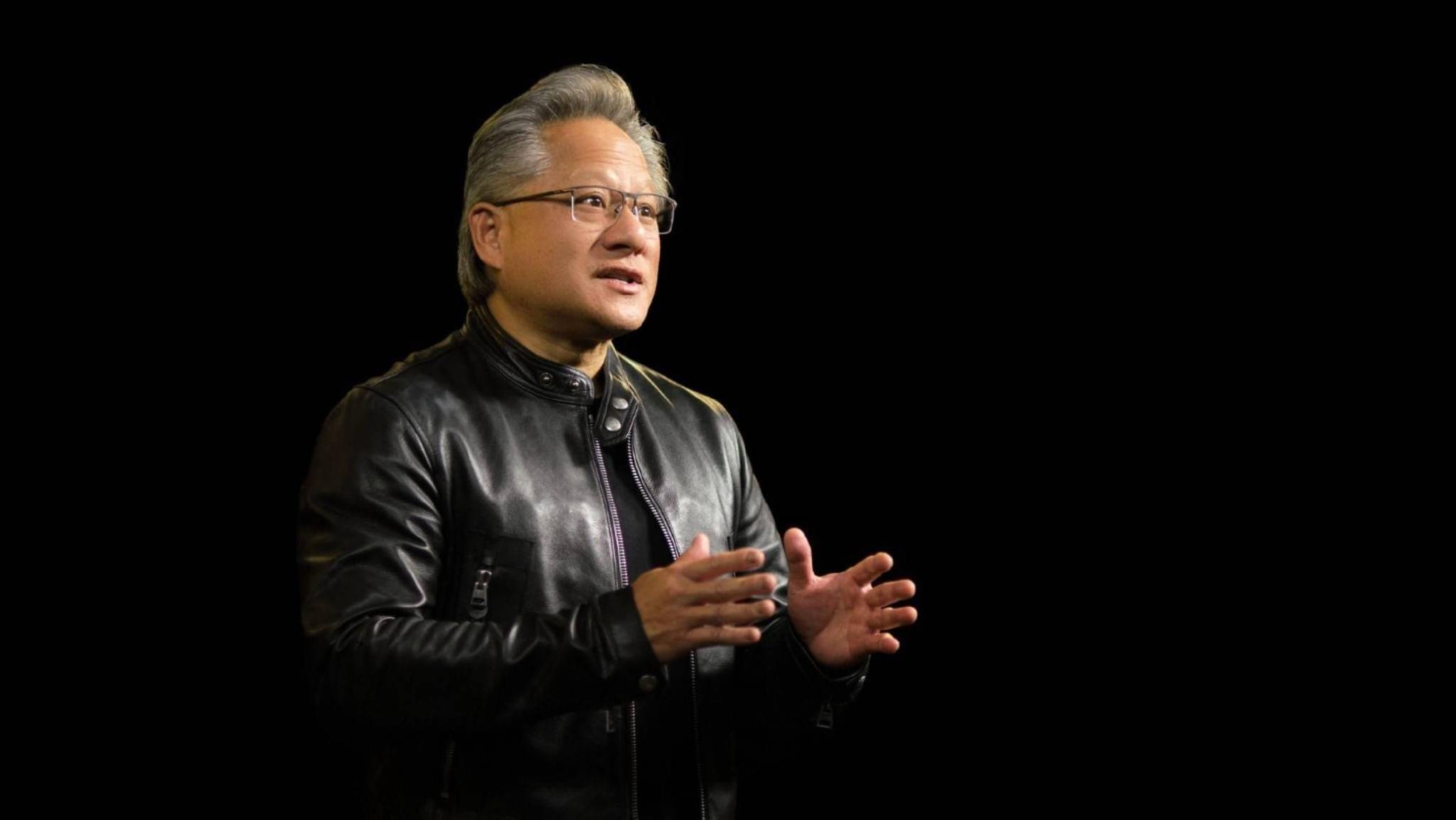

Jen-Hsun Huang, CEO von NVIDIA, besuchte kürzlich den zweiwöchentlichen „Open Source“-Dialog und diskutierte mit Brad Gerstner und Altimeter-Partner Clark Tang über das Thema der Förderung der Entwicklung von Intelligenz hin zu allgemeiner künstlicher Intelligenz (AGI) .

Huang Renxun, der sich seit vielen Jahren intensiv mit dem Bereich KI und maschinelles Lernen beschäftigt, trifft mit seiner Einschätzung des aktuellen Stands und der Aussichten der KI-Entwicklung genau das Richtige: Das ist eine komplette Revolution.

Das Denken erlebt ein explosionsartiges Wachstum, die Nachfrage nach Open-Source-Modellen boomt und eine vollständig kompatible KI-Infrastruktur wird ständig implementiert … In dieser Ära der zunehmenden Beliebtheit von KI hat Huang Renxun eine mutige Idee und hofft, dass NVIDIA 50.000 Mitarbeiter haben wird 100 Millionen KI-Assistenten in der Zukunft.

Wenn es um die Wettbewerbsbarrieren und die Positionierung von NVIDIA in der heutigen KI-Welt geht, ist Huang Jen-Hsun sehr von seinen eigenen Vorteilen überzeugt und hat erhebliche Ambitionen: NVIDIA ist der Beste in Algorithmen und unsere Mission ist es, eine allgegenwärtige KI für die neue Welt zu entwickeln. Computerplattform.

Im Gegensatz zum Wettbewerb um Marktanteile geht es bei diesem Ehrgeiz natürlich nur um „ Ausbeutung “.

In einem fast anderthalbstündigen Interview gab Huang eine scharfe Analyse darüber, wie maschinelles Lernen die Computerwelt umgestaltet, wie KI eine beispiellose technologische Revolution herbeiführt und letztendlich eine riesige Revolutionswelle auslöst. Darüber hinaus werden auch Themen wie KI-Sicherheit und Open-Source-Kontroversen behandelt.

Unter der scheinbar kalten Lederjacke verbirgt sich Huang Renxuns leidenschaftliche ursprüngliche Absicht für den Bereich der KI: Ich werde meine Arbeit, meine Verantwortung, meinen sozialen Beitrag und die Ära, in der wir leben, ernst nehmen.

Die Informationsdichte dieses Interviews ist recht hoch und die Diskussion über die KI-Branche ist beispiellos ausführlich. Lassen Sie sich das nicht entgehen!

Link zum Original-Interview-Video:

Wir fassen Huang Jenxuns Hauptpunkte in diesem Interview kurz wie folgt zusammen:

- Persönliche KI-Assistenten werden bald erscheinen und sich im Laufe der Zeit weiterentwickeln;

- Wir sind von der menschlichen Programmierung zum maschinellen Lernen übergegangen, wobei Innovation und Wachstum im gesamten Technologie-Stack stattfinden;

- Um die beschleunigte Entwicklung der KI voranzutreiben, muss jeder Teil des „Schwungrads“ beschleunigt werden.

- Die Zukunft der Datenverarbeitung (Anwendungsentwicklung) wird in hohem Maße von maschinellem Lernen und KI abhängen, und es wird Agenten geben, die Menschen bei der Nutzung dieser Anwendungen unterstützen;

- KI wird Arbeitsplätze nicht ersetzen, sie wird sie verändern und einen tiefgreifenden Einfluss darauf haben, wie Menschen über Arbeit denken.

- Die Sicherheit der KI ist die Grundlage. Sie erfordert nicht unbedingt eine eigene Gesetzgebung für jede wichtige Technologie und erlaubt auch nicht, dass die Regulierung übermäßig auf unnötige Bereiche ausgeweitet wird.

- Es muss ein Open-Source-Modell geben, um die Entwicklung von KI zu fördern. Open Source ist für die Aktivierung vieler Branchen notwendig.

Im Folgenden finden Sie den vollständigen Text des von APPSO zusammengestellten Interviews:

Übergang von der menschlichen Programmierung zum maschinellen Lernen

Brad Gerstner: Es ist Freitag, der 4. Oktober, und wir sind im Nvidia-Hauptquartier, gleich die Straße runter vom Altimeter. Wir werden am Montag unser jährliches Investorentreffen abhalten, um alle Auswirkungen von KI und unsere Fortschritte bei der Frage zu besprechen, wie schnell wir Intelligenz skalieren können.

Ich kann mir wirklich keinen besseren Menschen vorstellen, mit dem ich dieses Gespräch beginnen könnte, als Sie, sowohl als Aktionär als auch als unser intellektueller Partner, und der Austausch von Ideen mit Ihnen macht uns immer schlauer. Wir sind dankbar für diese Freundschaft und danken Ihnen für Ihren Besuch.

Jen-Hsun Huang : Ich bin froh, hier zu sein.

Brad Gerstner: Das diesjährige Thema ist die Erweiterung der Intelligenz auf künstliche allgemeine Intelligenz (AGI).

Was schockierend ist, ist, dass das Thema, als wir dies vor zwei Jahren machten, die KI-Ära war, und das war zwei Monate vor der Veröffentlichung von ChatGPT. Es ist wirklich überraschend, über all diese Veränderungen nachzudenken. Deshalb dachte ich, wir könnten mit einem Gedankenexperiment beginnen und vielleicht eine Vorhersage treffen.

Wenn ich allgemeine künstliche Intelligenz (AGI) einfach als persönlichen Assistenten in meiner Tasche verstehe, weiß sie, wie ich sie verstehe, alles über mich, hat ein perfektes Gedächtnis über mich, kann mit mir kommunizieren, kann ein Hotel für mich buchen und sogar habe einen Arzttermin für mich vereinbart. Ihrer Meinung nach verändert sich die Welt heute so schnell. Wann glauben Sie, dass wir einen solchen persönlichen Assistenten in der Tasche haben können?

Jensen Huang: Es wird bald in irgendeiner Form erscheinen. Dieser Assistent wird mit der Zeit immer besser. Das ist das Schöne an der Technologie, wie wir sie kennen. Ich denke also, dass es für den Anfang sehr nützlich sein wird, aber es ist nicht perfekt. Und dann wird es mit der Zeit immer besser. Wie jede Technologie.

Brad Gerstner: Wenn wir uns die Änderungsrate ansehen, erinnere ich mich, dass Elon gesagt hat, dass das Einzige, was zählt, die Änderungsrate ist. Wir haben das Gefühl, dass sich das Tempo des Wandels erheblich beschleunigt hat. Es ist das schnellste Tempo, das wir je zu diesen Themen gesehen haben, denn wir arbeiten seit etwa einem Jahrzehnt im Bereich KI und Sie sind sogar noch länger dabei. Ist das der schnellste Wandel, den Sie jemals in Ihrer Karriere erlebt haben?

Jensen Huang: Ja, weil wir die Informatik neu erfunden haben. Diese Veränderungen sind größtenteils darauf zurückzuführen, dass wir die Grenzkosten der Datenverarbeitung in den letzten 10 Jahren um den Faktor 100.000 gesenkt haben. Berechnet nach dem Mooreschen Gesetz stellt dieser Prozess eine etwa 100-fache Verbesserung dar, aber wir haben weit mehr als das erreicht. Dies erreichen wir auf verschiedene Weise.

Zuerst haben wir beschleunigtes Rechnen eingeführt, um Arbeit, die auf der CPU nicht effizient ist, auf die GPU zu übertragen.

Zweitens haben wir neue numerische Präzision erfunden, neue Architekturen entwickelt, Integrationskerne entworfen, die Art und Weise, wie Systeme aufgebaut werden, verbessert, MVLink ultraschnellen Speicher (HBM) hinzugefügt und eine Full-Stack-Erweiterung durch MVLink und InfiniBand implementiert. Im Grunde tragen alle Details, die ich über die Art und Weise beschrieben habe, wie Nvidia vorgeht, zu einer Innovationsrate bei , die über Moores Gesetz hinausgeht .

Was nun wirklich erstaunlich ist, ist, dass wir aus diesem Grund von der menschlichen Programmierung zum maschinellen Lernen übergegangen sind.

Und das Überraschendste am maschinellen Lernen ist, dass es sehr schnell lernt. Wenn wir also neu definieren, wie Berechnungen verteilt werden, stehen uns viele Formen der Parallelverarbeitung zur Verfügung: Tensorparallelität, Pipelineparallelität und alle Arten paralleler Rechenmethoden. Auf dieser Basis haben wir neue Algorithmen erfunden und neue Trainingsmethoden entwickelt. Alle diese Erfindungen wirkten sich gegenseitig verstärkend aus.

Wenn man sich damals anschaut, wie das Mooresche Gesetz funktionierte, war Software statisch. Es ist so konzipiert, dass es statisch wie ein verpacktes Produkt existiert, während sich die Hardware im Tempo des Mooreschen Gesetzes weiterentwickelt. Jetzt wächst unser gesamter Technologie-Stack und der gesamte Stack ist innovativ. Ich denke, das ist der Status quo.

Jetzt erleben wir plötzlich eine erstaunliche Expansion und natürlich eine außergewöhnliche Veränderung. Aber worüber wir zuvor gesprochen haben, waren vorab trainierte Modelle und die Skalierung auf dieser Ebene, etwa durch die Verdoppelung der Modellgröße und entsprechend auch die Verdoppelung der Datenmenge.

Daher vervierfacht sich die benötigte Rechenleistung jedes Jahr. Das war damals eine große Sache. Aber jetzt sehen wir eine Erweiterung in der Post-Training-Phase, wir sehen auch eine Erweiterung in der Inferenzphase, oder? Früher dachte man, dass das Vortraining schwierig und die Schlussfolgerung relativ einfach sei.

Die Vorstellung, dass jetzt alles schwieriger ist, ist eigentlich vernünftig, schließlich wäre es absurd, alles menschliche Denken auf einen einmaligen Prozess zu reduzieren. Daher müssen im Denken Konzepte wie schnelles und langsames Denken, Argumentation, Reflexion, Iteration, Simulation usw. vorhanden sein, und diese Konzepte werden nun schrittweise integriert.

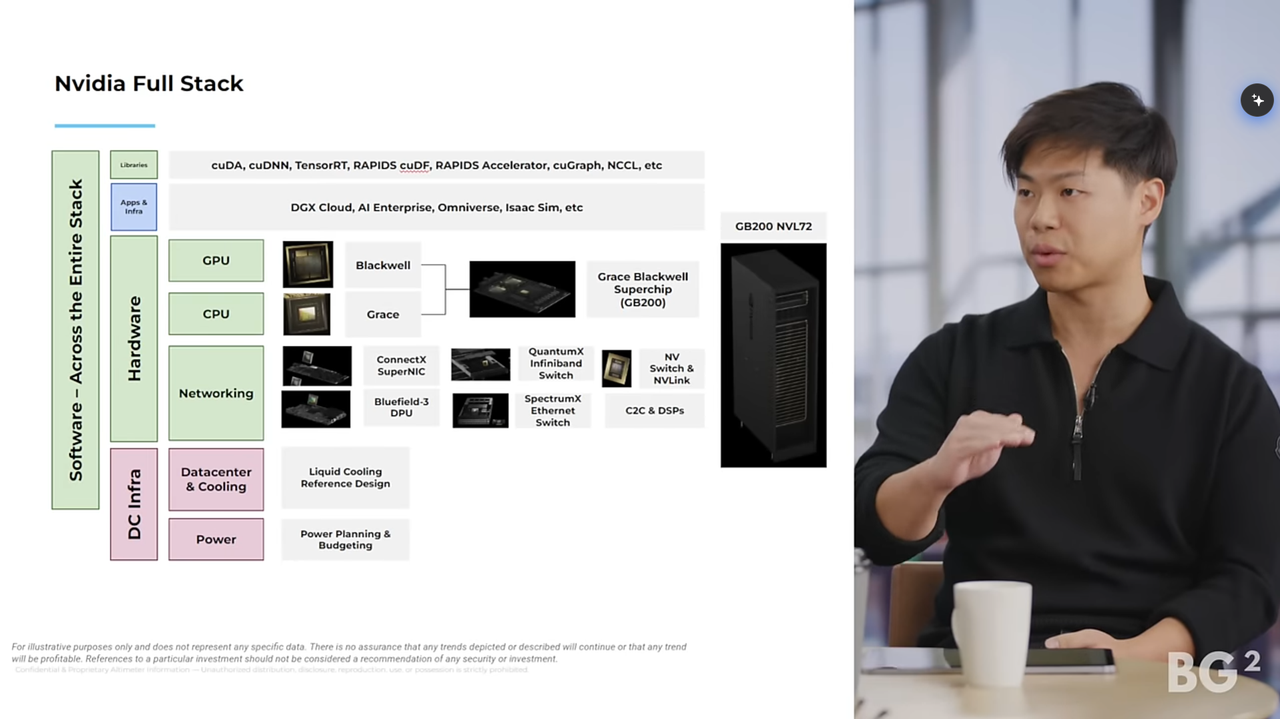

Clark Tang: Ich denke, eines der am meisten missverstandenen Dinge über Nvidia ist derzeit, wie groß der echte technologische Vorsprung von Nvidia ist, oder? Ich glaube, es gibt da draußen die Auffassung, dass jemand, der einen neuen Chip oder einen besseren Chip erfindet, gewonnen hat.

Tatsache ist jedoch, dass Sie im letzten Jahrzehnt den gesamten Technologie-Stack aufgebaut haben, von GPUs über CPUs bis hin zu Netzwerken, insbesondere die Software und Bibliotheken, die die Ausführung von Anwendungen auf NVIDIA-Plattformen ermöglichen. Glauben Sie, dass Nvidias technologischer Vorsprung heute größer oder kleiner ist als vor drei bis vier Jahren?

Jensen Huang: Ich schätze Ihr Bewusstsein dafür, dass sich die Informatik verändert hat. Tatsächlich dachten die Leute (und viele denken immer noch), dass es ausreichen würde, einen besseren Chip zu entwerfen, weil er mehr Floats, mehr Flips, Bytes und Bits hatte. Verstehen Sie, was ich meine? Wenn Sie sich ihre Keynote-Folien ansehen, sind sie voller Flip- und Gleitkommaoperationen sowie verschiedener Balkendiagramme, Diagramme und dergleichen.

Das ist alles gut, ich meine, natürlich kommt es auf die Leistung an, also sind sie im Grunde genommen wichtig. Leider ist dies jedoch eine alte Denkweise. Da Software damals nur eine Anwendung war, die unter Windows ausgeführt wurde, war Software statisch, was bedeutete, dass die beste Möglichkeit, Ihr System zu verbessern, darin bestand, immer schnellere Chips herzustellen.

Aber wir sind uns bewusst, dass maschinelles Lernen keine menschliche Programmierung ist. Beim maschinellen Lernen geht es nicht nur um Software, sondern um den gesamten Datenpfad. Tatsächlich ist das Schwungrad im Herzen des maschinellen Lernens das Wichtigste. Wie denken Sie also darüber, Datenwissenschaftlern und -forschern die Möglichkeit zu geben, in diesem Schwungrad effektiv zu arbeiten und es gleichzeitig voranzutreiben? Und dieses Schwungrad beginnt bereits in den frühesten Stadien.

Vielen Menschen ist nicht einmal bewusst, dass eine KI tatsächlich benötigt wird, um Daten zu organisieren und einer anderen KI beizubringen. Und die KI selbst ist schon ziemlich komplex.

▲Persönliche KI-Assistenten werden bald in irgendeiner Form erscheinen (Quelle: NITCO)

Beschleunigen Sie jeden Schritt des Schwungrads

Brad Gerstner: Verbessert es sich also? Beschleunigt es auch? Wissen Sie, wenn wir wieder an Wettbewerbsvorteile denken, nicht wahr? Es ist wirklich die kombinierte Wirkung all dieser Faktoren.

Jen-Hsun Huang: Absolut richtig, gerade wegen der intelligenteren KI zur Organisation von Daten verfügen wir jetzt sogar über die Generierung synthetischer Daten und verschiedene Arten der Organisation und Präsentation von Daten. Bevor Sie also mit der Schulung beginnen, ist bereits eine Menge Datenverarbeitung erforderlich. Und die Leute denken immer, dass PyTorch der Anfang und das Ende der ganzen Welt ist.

Es ist wirklich wichtig, aber vergessen Sie nicht, dass es vor der Verwendung von PyTorch eine Menge Arbeit gibt und dass es nach der Verwendung von PyTorch eine Menge Arbeit gibt. Und die Idee eines Schwungrads ist eigentlich die Art und Weise, wie man darüber nachdenken sollte. Weißt du, wie soll ich über dieses ganze Schwungrad denken? Wie entwerfe ich ein Computersystem, eine Computerarchitektur, die Ihnen hilft, dieses Schwungrad so effizient wie möglich laufen zu lassen? Das ist kein einzelner Schritt der Bewerbungsschulung, oder? Das ist nur ein Schritt, okay?

Jeder Schritt des Schwungrads ist schwierig, daher sollten Sie nicht als Erstes darüber nachdenken, wie Sie Excel schneller laufen lassen oder wie Sie Doom schneller laufen lassen, das ist doch die alte Vorgehensweise, oder?

Jetzt müssen Sie nur noch darüber nachdenken, wie Sie dieses Schwungrad schneller machen können. Und es gibt viele verschiedene Schritte in diesem Schwungrad, und wie Sie wissen, ist nichts beim maschinellen Lernen einfach, und nichts ist einfach an dem, was OpenAI tut, oder was X tut, oder was das Gemini-Team und DeepMind tun. Es ist einfach.

Deshalb haben wir beschlossen, dass Sie darüber wirklich nachdenken sollten. Dies ist der gesamte Prozess und Sie müssen jeden Teil beschleunigen. Sie müssen das Gesetz von Amdahl respektieren. Wenn dieser Teil 30 % der Zeit in Anspruch nimmt und ich ihn dreimal beschleunige, beschleunige ich den gesamten Prozess nicht allzu sehr, verstehen Sie?

Sie müssen wirklich ein System schaffen, das jeden Schritt beschleunigt, und nur durch die Beschleunigung des gesamten Prozesses können Sie diese Zykluszeit wirklich erheblich verbessern, und dieses Schwungrad der Lernrate führt letztendlich zu exponentiellem Wachstum.

Ich sage also, dass sich die Perspektive eines Unternehmens tatsächlich in seinen Produkten widerspiegelt. Beachten Sie, dass ich immer wieder von diesem Schwungrad spreche.

Clark Tang: Du meinst den gesamten Zyklus.

Jensen Huang: Das stimmt, und wir beschleunigen jetzt alles. Der Schwerpunkt liegt jetzt auf Video. Viele Leute konzentrieren sich auf physikalische KI und Videoverarbeitung. Denken Sie nur an das Frontend: Jede Sekunde gelangen Terabytes an Daten in das System. Geben Sie mir ein Beispiel dafür, wie die Pipeline zur Verarbeitung dieser Daten abläuft, von der Datenaufnahme bis zur Vorbereitung für das Training, und das alles ist CUDA-beschleunigt.

Clark Tang: Jetzt denken die Leute nur an Textmodelle, aber in Zukunft wird es auch Videomodelle umfassen und auch einige Textmodelle wie o1 verwenden, um eine große Datenmenge zu verarbeiten, bevor wir mit der Verarbeitung beginnen.

Jen-Hsun Huang: Sprachmodelle werden alle Bereiche umfassen. Die Branche investiert viel Technologie und Aufwand in die Schulung von Sprachmodellen, um diese großen Sprachmodelle zu trainieren. Jetzt nutzen wir bei jedem Schritt geringere Rechenkosten. Das ist wirklich bemerkenswert.

Brad Gerstner: Ich möchte das nicht zu sehr vereinfachen, aber es ist eine Frage, die wir oft von Investoren hören, oder? Ja, aber was ist mit benutzerdefinierten Chips? Ja, aber werden dadurch ihre Wettbewerbsbarrieren abgebaut?

Ich höre Sie sagen, dass die Vorteile dieses kombinierten Systems mit der Zeit wachsen. Ich höre Sie also sagen: Wir sind heute im Vorteil als vor drei oder vier Jahren, weil wir jede Komponente verbessern. Und dieser Kombinationseffekt bedeutet, dass Intel früher im Technologie-Stack dominant war, und wo stehen Sie heute im Vergleich zu ihnen?

Vielleicht nur eine kurze Zusammenfassung und vergleichen Sie Ihren heutigen Wettbewerbsvorteil mit dem, den er auf seinem Höhepunkt hatte.

Jensen Huang: Intel ist außergewöhnlich. Intel ist außergewöhnlich, weil es wahrscheinlich das erste Unternehmen war, das in der Herstellungsprozesstechnik und -produktion extrem gut war, und der nächste Schritt über den Herstellungsprozess hinaus das Design von Chips ist, oder? Sie haben die Chips entworfen, die x86-Architektur aufgebaut und stellen weiterhin schnellere x86-Chips her. Das ist ihre Klugheit. Sie kombinieren dies mit Herstellungsprozessen.

Unser Unternehmen ist etwas anders, weil wir wissen, dass die Parallelverarbeitung nicht unbedingt erfordert, dass jeder Transistor perfekt ist. Für die serielle Verarbeitung muss jeder Transistor perfekt sein, während für die parallele Verarbeitung eine große Anzahl von Transistoren erforderlich ist, um eine höhere Kosteneffizienz zu erzielen.

Ich hätte lieber zehnmal mehr Transistoren und wäre 20 % langsamer als zehnmal weniger Transistoren und wäre 20 % schneller. Verstehst du? Sie bevorzugen das Gegenteil, daher unterscheiden sich Single-Thread-Leistung und Single-Thread-Verarbeitung stark von der parallelen Verarbeitung. Wir erkennen also, dass es in unserer Welt nicht wirklich darum geht, besser zu werden. Wir wollen so gut wie möglich sein, aber was unserer Welt wirklich am Herzen liegt, ist, besser zu werden.

Paralleles Rechnen und paralleles Verarbeiten ist schwierig, da jeder Algorithmus je nach Architektur auf unterschiedliche Weise umgestaltet und neu gestaltet werden muss. Was die Leute nicht wissen, ist, dass man drei verschiedene CPUs haben kann, jede mit ihrem eigenen C-Compiler, und dass man Software in die entsprechende ISA (Befehlssatzarchitektur) kompilieren kann. Dies ist weder beim beschleunigten Rechnen noch beim parallelen Rechnen möglich.

Das Unternehmen, das die Architektur entwickelte, musste sein eigenes OpenGL entwickeln. Deshalb haben wir Deep Learning revolutioniert , weil wir eine domänenspezifische Bibliothek namens CUDNN hatten. Ohne CUDNN gäbe es heute kein Deep Learning.

Niemand spricht über CUDNN, weil es eine Ebene unter PyTorch und TensorFlow ist. In den frühen Tagen gab es Caffe und Theano, jetzt gibt es Triton und es gibt viele verschiedene Frameworks. Diese domänenspezifische Bibliothek wie CUDNN und Optics, eine domänenspezifische Bibliothek namens CuQuantum, Rapids und viele andere.

Brad Gerstner: Die branchenspezifischen Algorithmen liegen unter der PyTorch-Schicht, auf die sich jeder konzentriert. Ich höre zum Beispiel oft sagen, wenn es diese zugrunde liegenden Bibliotheken nicht gäbe …

Jensen Huang: Wenn wir es nicht erfunden hätten, wäre keine der Top-Level-Anwendungen lauffähig. Verstehen Sie, was ich sage? Mathematisch gesehen ist NVIDIA wirklich gut in Algorithmen, die Wissenschaft auf höherer Ebene mit Architektur auf niedrigerer Ebene kombinieren.

▲Huang Renxun im Interview

Wir sind in das Zeitalter des Denkens eingetreten

Clark Tang: Jetzt liegt die ganze Aufmerksamkeit endlich auf dem Denken. Aber ich erinnere mich, dass Brad und ich vor zwei Jahren mit Ihnen zu Abend gegessen haben und wir Ihnen eine Frage gestellt haben: Glauben Sie, dass der technologische Vorsprung von Nvidia in der Schlussfolgerung ebenso stark sein wird wie im Training?

Jensen Huang: Ich habe definitiv gesagt, dass es stärker sein würde.

Clark Tang: Sie haben gerade viele Faktoren erwähnt, wie zum Beispiel modulare Kombinationen und unterschiedliche Kombinationen von Baugruppen, die wir manchmal nicht vollständig verstehen. Für Kunden ist es wichtig, flexibel zwischen diesen wechseln zu können. Aber können Sie jetzt, da wir in die Ära des Denkens eingetreten sind, etwas näher darauf eingehen?

Jen-Hsun Huang: Argumentation ist ein groß angelegtes Argumentationstraining, oder? Wenn Sie also gut trainieren, ist die Wahrscheinlichkeit groß, dass auch Ihre Argumentation gut ist. Wenn Sie ohne Anpassungen auf dieser Architektur trainieren, kann es auf dieser Architektur ausgeführt werden.

Natürlich können Sie immer noch für andere Architekturen optimieren, aber da es bereits auf der NVIDIA-Architektur aufbaut, läuft es zumindest auf der NVIDIA-Architektur.

Der andere Aspekt ist natürlich der Kapitalinvestitionsaspekt. Wenn Sie ein neues Modell trainieren, möchten Sie für das Training die neueste und beste Ausrüstung verwenden, die zuvor verwendete Geräte zurücklässt. Und diese Geräte eignen sich hervorragend für Schlussfolgerungen. Daher wird es einen freien Gerätepfad geben.

Hinter der neuen Infrastruktur steht eine Kette kostenloser Infrastrukturgeräte, die CUDA-kompatibel sind. Daher legen wir großen Wert darauf, während des gesamten Prozesses die Kompatibilität sicherzustellen, damit die von uns zurückgelassenen Geräte weiterhin eine hervorragende Leistung erbringen können.

Gleichzeitig haben wir auch viel Energie in die ständige Neuerfindung neuer Algorithmen investiert, um sicherzustellen, dass die Leistung der Hopper-Architektur zu gegebener Zeit zwei- bis viermal höher ist als beim ersten Kauf, sodass die Infrastruktur weiterhin effizient bleiben kann.

Die ganze Arbeit, die wir in Bezug auf die Verbesserung neuer Algorithmen und neuer Frameworks leisten, hilft nicht nur jeder unserer installierten Infrastrukturen, sondern auch Hopper ist besser dafür, Ampere ist besser dafür und sogar Volt ist besser dafür.

Ich erinnere mich, dass Sam mir gerade erzählt hat, dass sie ihre Volt-Infrastruktur kürzlich von OpenAI zurückgezogen haben. Ich denke also, dass wir Spuren dieser installierten Infrastrukturen hinterlassen. Wie bei jeder Computerinfrastruktur ist es wichtig, die Infrastruktur zu installieren.

Die Produkte von NVIDIA sind in jeder Cloud, vor Ort und bis hin zu Edge-Geräten verfügbar. Daher kann das in der Cloud erstellte visuelle Sprachmodell von Vela ohne Änderungen perfekt auf dem Edge-Roboter ausgeführt werden. Dem Ganzen liegt CUDA zugrunde. Daher halte ich das Konzept der Architekturkompatibilität für große Projekte für sehr wichtig. Dies unterscheidet sich nicht vom Konzept der Kompatibilität für iPhones oder andere Geräte.

Ich denke, die Installation einer Infrastruktur ist für die Inferenz sehr wichtig, aber was uns wirklich bringt, ist, dass wir, weil wir diese großen Sprachmodelle auf neuen Architekturen trainieren, darüber nachdenken können, wie wir in Zukunft sehr gute Inferenzarchitekturen erstellen können.

Deshalb haben wir über iterative Modelle und Inferenzmodelle nachgedacht, wie Sie Ihrem persönlichen Agenten ein sehr interaktives Inferenzerlebnis bieten können, beispielsweise wie Sie schnell mit Ihnen interagieren können, wenn er eine Weile innehalten und nachdenken muss.

Wie erreichen wir das? Die Antwort ist NVLink. Wissen Sie, mit NVLink können wir diese für das Training geeigneten Systeme verwenden, aber wenn das Training abgeschlossen ist, ist auch die Inferenzleistung sehr gut. Was Sie optimieren möchten, ist die Antwortzeit für den ersten Token. Das Erreichen der Antwortzeit für den ersten Token ist sehr schwierig, da hierfür viel Bandbreite erforderlich ist.

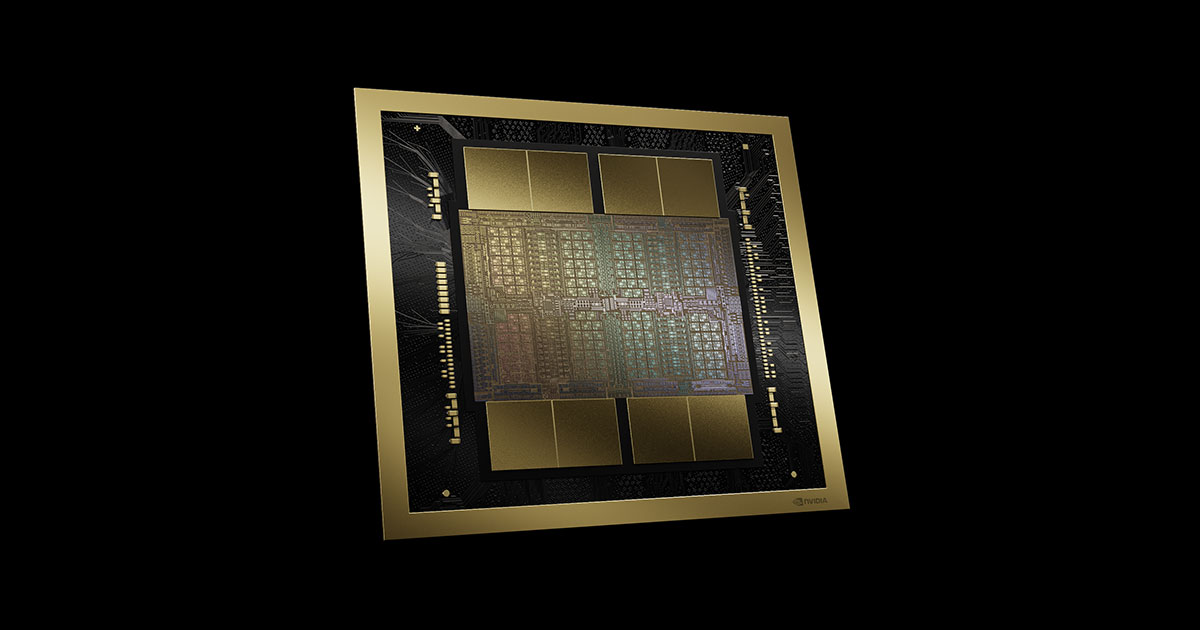

Wenn Ihr Kontext außerdem sehr umfangreich ist, benötigen Sie auch viel Rechenleistung. Sie benötigen also unbegrenzte Bandbreite und Rechenleistung gleichzeitig, um eine Antwortzeit von wenigen Millisekunden zu erreichen. Und diese Art von Architektur ist sehr schwer umzusetzen. Aus diesem Grund haben wir Grace Blackwell NVLink erfunden.

▲NVIDIA Blackwell-Architektur (Quelle: NVIDIA)

NVIDIA baut eine vollständige, konforme KI-Infrastruktur auf

Brad Gerstner: Wissen Sie, ich habe Anfang dieser Woche mit Andy Jassy zu Abend gegessen und Andy sagte: „Wir haben Tranium und wir haben Inferencia als nächstes.“ Ich denke, die meisten Leute denken immer noch, dass dies eine Herausforderung für Nvidia darstellt.

Aber dann sagte er: „Nvidia ist ein sehr wichtiger Partner für uns und wird auch in Zukunft ein sehr wichtiger Partner für uns sein, zumindest in der Zukunft, die ich absehen kann.“

Die Welt läuft auf NVIDIA, oder? Wenn Sie also darüber nachdenken, dass diese benutzerdefinierten ASICs für bestimmte Anwendungen entwickelt werden, wie die Inferenzbeschleuniger von Meta oder Tranium von Amazon oder die TPUs von Google, und die Lieferengpässe, mit denen Sie derzeit konfrontiert sind, verändern diese Faktoren die Dynamik zwischen Ihnen, oder sind sie nur so? Ergänzung zu Ihrem System?

Jensen Huang: Wir machen einfach unterschiedliche Dinge, wir versuchen, unterschiedliche Ziele zu erreichen. NVIDIA versucht, eine Computerplattform für diese neue Welt aufzubauen, diese Welt des maschinellen Lernens, diese Welt der generativen KI, diese Welt der Agenten-KI.

Was wir schaffen wollen, ist, dass wir nach 60 Jahren Informatik den gesamten Computer-Stack neu erfunden haben, von der Art und Weise der Programmierung bis zum maschinellen Lernen, von der Art und Weise, wie Software von CPUs zu GPUs verarbeitet wird, von der Art und Weise, wie Software auf künstliche Intelligenz angewendet wird. Rechts? Softwaretools, künstliche Intelligenz – jeder Aspekt des Computing-Stacks, jeder Aspekt des Technologie-Stacks hat sich verändert.

Unser Ziel ist es, eine allgegenwärtige Computerplattform zu schaffen, und genau darin liegt die Komplexität unserer Arbeit. Wenn Sie darüber nachdenken, was wir tun, bauen wir eine komplette KI-Infrastruktur auf und stellen uns das wie einen Computer vor.

Ich habe bereits gesagt, dass das Rechenzentrum heute die grundlegende Recheneinheit ist. Wenn ich an einen Computer denke, denke ich nicht an den Chip, sondern an das Konzept: Es ist mein mentales Modell davon, mit der ganzen Software, der ganzen Programmierung, allen mechanischen Teilen. Das ist meine Mission, das ist mein Computer, und wir versuchen jedes Jahr, einen brandneuen Computer zu bauen.

Ja, das ist verrückt, das hat noch niemand gemacht. Jedes Jahr versuchen wir, einen komplett neuen Computer zu bauen, und jedes Jahr liefern wir zwei- bis dreifache Leistungssteigerungen. Jedes Jahr senken wir die Kosten um das Zwei- bis Dreifache und jedes Jahr verbessern wir die Energieeffizienz um das Zwei- bis Dreifache.

Deshalb sagen wir unseren Kunden: Kaufen Sie nicht die gesamte Ausrüstung auf einmal, sondern kaufen Sie jedes Jahr ein wenig, okay? Der Grund dafür ist, dass wir wollen, dass sie in die Zukunft übergehen können, in der alle Architekturen kompatibel sind, okay?

Nun ist es sehr schwierig, diese Plattform in diesem Tempo aufzubauen, und was doppelt schwierig ist, ist, dass wir nicht nur Infrastruktur oder Dienste verkaufen, sondern sie auseinander nehmen und in GCP integrieren, sie in AWS integrieren, in Azure integrieren , integriert in andere Plattformen, wissen Sie?

Die Integration ist für jede Plattform unterschiedlich. Wir müssen alle Architekturbibliotheken, alle Algorithmen und alle Frameworks in ihre Systeme integrieren. Wir integrieren unsere Sicherheitssysteme in ihre Systeme, wir integrieren unsere Netzwerke in ihre Systeme, oder? Und dann führen wir etwa zehn dieser Integrationen pro Jahr durch. Und hier liegt die Magie.

Brad Gerstner: Das ist die Magie, warum? Ich meine, es ist verrückt. Es ist wirklich verrückt, dass du das jedes Jahr machst. Denken Sie darüber nach: Was treibt Sie dazu, dies jedes Jahr zu tun?

Und um darauf zurückzukommen: Clark ist gerade aus Taiwan, Korea und Japan zurückgekommen und hat sich mit all Ihren Lieferpartnern getroffen – denjenigen, mit denen Sie seit über zehn Jahren Beziehungen pflegen. Wie wichtig sind diese Partnerschaften für den Gesamteffekt des Aufbaus dieser Wettbewerbsbarriere?

Jen-Hsun Huang: Ja, wenn man es systematisch aufschlüsselt, und je mehr man es aufschlüsselt, ist es überraschend, wie sich das gesamte Ökosystem der Elektronikindustrie heute dafür einsetzt, mit uns zusammenzuarbeiten, um letztendlich diesen Würfel eines Computers zu bauen und ihn zusammenzusetzen all die verschiedenen Ökosysteme? Und die Koordination ist so nahtlos. Offensichtlich haben wir die API, die Methodik, den Geschäftsprozess und die Designregeln rückwärts und die Methodik, Architektur und API vorwärts weitergegeben.

Brad Gerstner: Diese sind seit Jahrzehnten befestigt.

Jen-Hsun Huang : Es wurde über Jahrzehnte gestärkt und entwickelt sich auch ständig weiter. Aber diese APIs müssen bei Bedarf integriert werden – all diese Dinge, die in Taiwan und auf der ganzen Welt hergestellt werden, landen in Azure-Rechenzentren. Sie werden zusammenpassen.

Clark Tang: Jemand ruft einfach die OpenAI-API auf und es funktioniert.

Jen -Hsun Huang: Ja, es ist ein total verrücktes Gefühl. Das haben wir erfunden, wir haben diese riesige Computerinfrastruktur erfunden, und die ganze Welt baut sie mit uns auf.

Es ist in alles integriert, Sie können es über Dell verkaufen, Sie können es über HPE verkaufen, es wird in der Cloud gehostet und erstreckt sich auf Edge-Geräte. Die Leute verwenden es jetzt in Robotersystemen, sie verwenden es in humanoiden Robotern, sie verwenden es in selbstfahrenden Autos, sie sind alle architektonisch kompatibel, was wirklich verrückt ist.

Clark, ich möchte nicht, dass du denkst, dass ich deine Frage nicht beantwortet habe. Ich beziehe mich auf Folgendes bezüglich Ihres ASIC.

Wir als Unternehmen machen einfach verschiedene Dinge. Als Unternehmen möchten wir ein klares Verständnis für die Umwelt haben. Ich bin mir über alles rund um unser Unternehmen und sein Ökosystem sehr bewusst, oder?

Ich kenne alle Menschen, die unterschiedliche Dinge tun, und weiß, was sie tun. Manchmal ist es für uns konfrontativ, manchmal nicht. Ich weiß das sehr gut. An den Zielen unseres Unternehmens ändert sich dadurch jedoch nichts. Das einzige Ziel des Unternehmens ist der Aufbau einer Architekturplattform, die überall genutzt werden kann, und das ist unser Ziel.

Wir versuchen nicht, irgendjemandem Marktanteile wegzunehmen. NVIDIA ist ein Marktpionier und kein Aktienanwärter. Wenn Sie sich unsere Unternehmensberichte ansehen, werden Sie feststellen, dass wir nie über Marktanteile sprechen. Es gibt keinen Tag, an dem wir über Marktanteile innerhalb des Unternehmens sprechen.

Bei all unseren Diskussionen ging es darum, wie wir das nächste Ding erschaffen? Wie lösen wir das nächste Problem im Schwungrad? Wie können wir es besser für die Menschen machen? Wie können wir einen Schwungradzyklus, der früher ein Jahr dauerte, auf nur einen Monat verkürzen? Wissen Sie, das ist die Lichtgeschwindigkeit für ein Schwungrad, oder? Wir denken über all diese verschiedenen Fragen nach, aber eines ist sicher: Wir nehmen alles um uns herum wahr, sind uns aber über unsere Mission sehr im Klaren.

Die Frage ist nur, ob dieser Einsatz notwendig und sinnvoll ist. Alle großen Unternehmen sollten diese Mission haben.

Grundsätzlich stellt sich die Frage: Was machen Sie? Die Frage ist nur: Ist es notwendig, ist es wertvoll, hat es Wirkung und kann es anderen helfen? Ich bin mir ziemlich sicher, dass , wenn Sie ein Entwickler sind, ein generatives KI-Startup, das sich für die Gründung eines Unternehmens entscheidet, die einzige Wahl, die Sie nicht berücksichtigen müssen, darin besteht, welchen ASIC Sie unterstützen möchten.

Wenn Sie nur CUDA unterstützen, können Sie es überall verwenden und später jederzeit Ihre Meinung ändern, aber wir sind der Einstiegspunkt in die KI-Welt, nicht wahr? Sobald Sie sich entscheiden, unserer Plattform beizutreten, können andere Entscheidungen verschoben werden und Sie können später jederzeit Ihren eigenen ASIC entwickeln, und das macht uns nichts aus.

Wenn ich mit GCP, Unternehmen wie GCP und Azure, zusammenarbeite, zeigen wir ihnen unsere Roadmap Jahre im Voraus. Sie werden uns ihre ASIC-Roadmap nicht zeigen und das wird uns nicht beleidigen, okay? Wenn Ihre Ziele klar und sinnvoll sind und Ihre Mission für Sie selbst und andere wichtig ist, können Sie transparent sein.

Beachten Sie, dass meine Roadmap auf GTC öffentlich ist, während meine Roadmap bei Partnern wie Azure, AWS usw. ausführlicher sein wird. Wir haben damit keine Schwierigkeiten, obwohl sie ihre eigenen ASICs entwickeln.

▲NVIDIAs Mission ist es, eine vollständige und kompatible KI-Infrastruktur aufzubauen (Quelle: The Brand Hopper)

KI verändert die Zukunft der Branche

Brad Gerstner: Ich denke, wenn man sich die Branche ansieht, haben Sie kürzlich gesagt, dass die Nachfrage nach Blackwell „verrückt“ sei. Sie sagen auch, dass der schwierigste Teil Ihrer Arbeit darin besteht, die emotionale Belastung zu ertragen, zu Menschen in einer Welt, in der Computerressourcen knapp sind, „Nein“ zu sagen.

Kritiker sagen jedoch, dass dies nur ein Zeitpunkt sei, und sie glauben, dass es ein Boom-and-Bust-Erlebnis sein wird, genau wie Ciscos übermäßiger Glasfaserausbau im Jahr 2000. Wissen Sie, ich denke daran, als wir Anfang 2023 zusammen zu Abend aßen, war die Prognose, dass Nvidias Umsatz im Jahr 2023 26 Milliarden US-Dollar erreichen würde, aber Sie haben tatsächlich 60 Milliarden US-Dollar erzielt, oder?

Jensen Huang: Geben Sie es zu, das ist der größte Prognosefehler, den die Welt je gesehen hat.

Brad Gerstner: Wir waren damals im November 2022 besonders aufgeregt, weil Leute wie Mustafa von Inflection und Noam von Character in unser Büro kamen, um über Investitionen in ihre Unternehmen zu diskutieren. Sie sagten: Wenn Sie nicht direkt in unser Unternehmen investieren können, dann kaufen Sie Nvidia, denn die Welt kämpft darum, Nvidias Chips zu bekommen, um die Anwendungen zu entwickeln, die die Welt verändern werden.

Natürlich ist mit dem Aufkommen von ChatGPT dieser „kambrische Moment“ gekommen. Dennoch sind diese 25 Analysten immer noch vom „Krypto-Winter“ besessen und können sich nicht vorstellen, was auf der Welt passiert, oder? Das Endergebnis übertraf also die Erwartungen bei weitem.

Sie haben deutlich gemacht, dass die Nachfrage nach Blackwell wahnsinnig ist und auch weiterhin so bleiben wird. Natürlich ist die Zukunft unbekannt und nicht absehbar, aber warum liegen die Kritiker so falsch? Es wird keine überbaute Situation wie bei Cisco im Jahr 2000 geben.

Jensen Huang: Der beste Weg, über die Zukunft nachzudenken, besteht darin, von Grund auf zu argumentieren, oder? Die Frage ist also: Was ist der Grund für das, was wir jetzt tun? Erstens: Was machen wir? Was machen wir? Wir erfinden die Datenverarbeitung neu, nicht wahr?

Wir haben gerade gesagt, dass die Zukunft der Informatik in hohem Maße vom maschinellen Lernen abhängen wird, oder? Fast alle unsere Anwendungen, ob Word, Excel, PowerPoint, Photoshop, Premiere, AutoCAD, nennen Sie mir ein Beispiel, alle werden von Hand entworfen. Ich garantiere Ihnen, diese werden in Zukunft stark auf maschinelles Lernen angewiesen sein, oder?

Zusätzlich zu diesen Tools stehen Ihnen Agenten zur Verfügung, die Sie bei der Verwendung unterstützen.

Mittlerweile ist es also eine Tatsache, oder? Wir haben die Informatik neu erfunden und blicken nicht zurück. Der gesamte Computertechnologie-Stack wird neu definiert.

Okay, jetzt, wo wir an diesem Punkt angelangt sind, sagen wir, dass Software anders sein wird, die Art und Weise, wie Software geschrieben wird, wird anders sein, die Art und Weise, wie Software verwendet wird, wird anders sein. Geben wir also zu, dass dies meine grundlegenden Fakten sind. Ja, die Frage ist also, was passiert als nächstes?

Schauen wir uns also an, wie die Berechnungen in der Vergangenheit durchgeführt wurden. Wir haben Computerausrüstung im Wert von einer Billion Dollar. Wenn Sie sich das Rechenzentrum der Vergangenheit ansehen, die Tür öffnen und es betrachten, würden Sie dann sagen, dass dies die Computer sind, mit denen Sie in die Zukunft blicken möchten? Die Antwort ist nein.

Sie sehen diese CPUs, wir wissen, was sie können und was nicht. Wir wissen auch, dass es mittlerweile Rechenzentren im Wert von einer Billion Dollar gibt, die modernisiert werden müssen. Wenn wir also jetzt in den nächsten vier oder fünf Jahren eine Modernisierung vornehmen, ist das völlig vernünftig und sinnvoll.

Brad Gerstner: Wir haben also mit Leuten gesprochen, die modernisieren müssen, und sie modernisieren mit GPUs, ja.

Jensen Huang: Ich meine, lassen Sie uns eine Hypothese aufstellen. Sie haben Investitionen in Höhe von 50 Milliarden US-Dollar. Werden Sie sich für Option A entscheiden: Investitionen für die Zukunft aufbauen, oder Option B: Investitionen nach den Mustern der Vergangenheit aufbauen? Sie haben die Investitionsausgaben hinter sich gelassen, sie sitzen einfach da und werden sowieso nicht besser.

Das Mooresche Gesetz ist im Wesentlichen vorbei, warum also es neu aufbauen? Wir müssen einfach diese 50 Milliarden Dollar in generative KI investieren, oder? So wird es Ihrem Unternehmen besser gehen. Wie viel von den 50 Milliarden werden Sie also investieren? Ich würde 100 % der 50 Milliarden hineinstecken, weil ich über eine vier Jahre alte Infrastruktur verfüge.

Nun denken Sie also grundsätzlich nur aus dieser Perspektive, und genau das tun sie. Kluge Menschen tun kluge Dinge.

Der zweite Teil lautet nun: Wir müssen Kapazitäten in Höhe von einer Billion Dollar aufbauen, oder? Eine Billion Dollar Infrastruktur, vielleicht 150 Milliarden Dollar investiert, oder? Wir werden also in den nächsten 4 bis 5 Jahren eine Infrastruktur im Wert von einer Billion Dollar aufbauen.

Die zweite Sache, die wir beobachtet haben, ist , dass die Art und Weise, wie Software geschrieben wird, anders ist und dass die Art und Weise, wie Software in Zukunft verwendet wird, anders sein wird. Wir werden intelligente Agenten haben, nicht wahr?

Wir werden digitale Mitarbeiter in unserem Unternehmen haben, und sie werden in Ihrem Posteingang sein, und in Zukunft werden diese kleinen Punkte, diese kleinen Avatare zu Ikonen der KI, oder? Ich werde ihnen Aufgaben schicken. Ich programmiere nicht mehr in C++, ich verwende Aufforderungswörter, um KI zu „programmieren“, oder? Das ist nicht anders als damals, als ich heute Morgen eine Menge E-Mails geschrieben habe.

Ich habe meinem Team Anweisungen gegeben, oder? Ich beschrieb den Hintergrund, erläuterte die grundlegenden Grenzen meines Wissens und beschrieb ihre Mission. Ich gebe ihnen genügend Anweisungen, um zu verstehen, was ich brauche, und ich möchte die erwarteten Ergebnisse so klar wie möglich darlegen. Ich lasse aber auch genügend Raum für Kreativität, damit sie mich überraschen können, oder?

Das unterscheidet sich nicht von der Art und Weise, wie ich die KI heute anspreche, genau so befehle ich die KI. Zusätzlich zu unserer modernisierten Infrastruktur wird es eine völlig neue Infrastruktur geben. Diese neue Infrastruktur ist die KI-Fabrik, die diese digitalen Menschen betreiben wird, und sie werden rund um die Uhr laufen.

Wir werden sie in allen Unternehmen auf der ganzen Welt haben, wir werden sie in unseren Fabriken haben, wir werden sie in unseren automatisierten Systemen haben, richtig? Die Welt muss also eine ganze Schicht von Computerstrukturen aufbauen, die ich als KI-Fabrikinfrastruktur bezeichne, die es noch nicht gibt.

Die Frage ist also, wie groß ist das? Wir wissen es noch nicht, aber es könnten Billionen Dollar sein, aber das Schöne ist, dass die modernisierte Rechenzentrumsarchitektur mit der KI-Fabrikarchitektur identisch ist.

Brad Gerstner: Das ist das Schöne. Sie haben sehr deutlich gemacht, dass Sie über eine Billion Dollar an veralteter Infrastruktur verfügen, die modernisiert werden muss, und dass Sie mindestens eine Billion Dollar an neuen KI-Workloads erwarten, was einem Umsatz von etwa 125 Milliarden Dollar in diesem Jahr entspricht.

Wissen Sie, Ihnen wurde gesagt, dass dieses Unternehmen niemals mehr als 1 Milliarde Dollar wert sein würde. Und jetzt sitzen Sie hier, wenn Sie nur 125 Milliarden an Einnahmen aus dem Gesamtmarkt (TAM) von mehreren Billionen ausmachen, welcher Grund lässt Sie dann glauben, dass Ihre zukünftigen Einnahmen nicht doppelt oder dreimal so hoch sein werden wie jetzt? Gibt es einen Grund, warum Ihr Einkommen nicht weiter wächst?

Jensen Huang: Nein, das stimmt. Wissen Sie, es geht nicht um die Gegenwart. Das Unternehmen ist nur durch die Größe des „Teichs“ begrenzt, wissen Sie, Goldfische können nur so groß werden, dass sie der Größe des Teichs entsprechen.

Die Frage ist also: Wie groß ist unser Teich? Das erfordert viel Fantasie, weshalb Marktpioniere an die Zukunft denken und nicht nur im bestehenden Teich konkurrieren.

Es ist schwierig, klar in die Zukunft zu blicken, wenn man nur in die Vergangenheit blickt und versucht, Marktanteile zu gewinnen. Anwärter auf Marktanteile können nur begrenzt groß werden, während Marktpioniere sehr groß werden können. Ich denke, das Glück unseres Unternehmens ist, dass wir vom ersten Tag an einen Marktraum für uns schaffen mussten.

Die Leute wussten es damals noch nicht, aber wir haben den 3D-Gaming-PC-Markt fast von Grund auf neu geschaffen. Wir haben diesen Markt und alle damit verbundenen Ökosysteme im Grunde erfunden, einschließlich des Ökosystems für Grafikkarten. Wir haben alles erfunden. Daher ist es für uns sehr vertraut, einen völlig neuen Markt zu schaffen, um dies zu bedienen.

▲Brad Gerstner (links) und Clark Tang (rechts) im Interview

Unglaubliches OpenAI und X.AI

Brad Gerstner: Ja, das gilt für jemanden, der einen neuen Markt erfunden hat. Lassen Sie uns ein wenig den Gang wechseln und über Modelle und OpenAI sprechen. Wissen Sie, OpenAI hat diese Woche 6,5 Milliarden US-Dollar eingesammelt, was einem Wert von etwa 150 Milliarden US-Dollar entspricht. Wir alle haben uns an dieser Finanzierung beteiligt.

Jen -Hsun Huang: Ich freue mich wirklich für sie, dass alles reibungslos geklappt hat. Ja, sie haben großartige Arbeit geleistet und das Team hat großartige Arbeit geleistet.

Brad Gerstner: Es gibt Berichte, dass ihr Umsatz bzw. ihre Umsatzrendite dieses Jahr etwa 5 Milliarden US-Dollar beträgt und nächstes Jahr 10 Milliarden US-Dollar betragen könnte. Wenn man sich die Größe des Unternehmens heute anschaut, ist sein Umsatz ungefähr doppelt so hoch wie der von Google beim Börsengang.

Sie haben wöchentlich 250 Millionen aktive Nutzer, was unserer Schätzung nach doppelt so viele Nutzer wie beim Börsengang von Google ist. Und wenn Sie sich den Geschäftsmultiplikator ansehen und glauben, dass sie im nächsten Jahr einen Umsatz von 10 Milliarden US-Dollar erzielen können, dann beträgt ihre Marktkapitalisierung etwa das 15-fache des Umsatzes im nächsten Jahr, was ungefähr dem gleichen Multiplikator entspricht, den Google und Meta bei ihren Börsengängen hatten, richtig ? Das ist ziemlich erstaunlich, wenn man bedenkt, dass dieses Unternehmen vor 22 Monaten keinen Umsatz und keine wöchentlichen aktiven Nutzer hatte.

Jensen Huang: Brad hat ein unheimliches Gespür für Geschichte.

Brad Gerstner: Wenn Sie darüber nachdenken, sprechen Sie mit uns über OpenAI als Ihren Partner und wie wichtig es ist, das öffentliche Bewusstsein und den Einsatz von KI zu fördern.

Jensen Huang: Nun, das ist eines der einflussreichsten Unternehmen unserer Zeit. Hierbei handelt es sich um ein reines KI-Unternehmen, das die Vision der künstlichen allgemeinen Intelligenz (AGI) verfolgt.

Wie auch immer die Definition von AGI lautet, ich glaube kaum, dass ihre Definition wirklich wichtig ist, und ich glaube auch nicht an die Bedeutung des Timings. Ich weiß jedoch, dass die KI im Laufe der Zeit weiterhin eine Reihe von Fähigkeiten unter Beweis stellen wird. Der Fahrplan für die Entwicklung dieser Fähigkeiten wird erstaunlich sein. Bevor wir uns mit der Definition von AGI befassen, wenden wir sie allgemein an.

Was Sie jetzt tun müssen, ist, mit Digitalbiologen, Klimatechnikforschern, Materialforschern, Physikern, Astrophysikern und Quantenchemikern zu sprechen. Sie können zu Videospieldesignern, Fertigungsingenieuren und Robotikexperten gehen, eine Branche auswählen, die Ihnen gefällt, sich eingehend damit befassen, mit diesen wichtigen Menschen sprechen und sie fragen: Revolutioniert KI ihre Arbeitsweise? Dann bringen Sie diese Datenpunkte zurück und fragen sich: Wie skeptisch sind Sie?

Denn sie reden nicht über die konzeptionellen Vorteile von KI irgendwann in der Zukunft, sondern über den Einsatz von KI jetzt. Ob Agrartechnologie, Materialtechnologie, Klimatechnologie, wählen Sie Ihren Technologie- oder Wissenschaftsbereich, sie machen Fortschritte und KI hilft ihnen, ihre Arbeit voranzutreiben.

Während wir hier sprechen, nutzt jede Branche, jedes Unternehmen, jede Universität KI. Es ist unglaublich, nicht wahr? Es wird das Geschäft auf jeden Fall in irgendeiner Weise verändern, das wissen wir doch, oder? Ich meine, diese Veränderung ist so real und geschieht. Daher finde ich das durch ChatGPT ausgelöste KI-Erwachen absolut unglaublich. Ich liebe ihre Geschwindigkeit und ihr einzigartiges Ziel, das Feld voranzutreiben, also ist es wirklich wirkungsvoll.

Brad Gerstner: Sie haben einen Motor gebaut, der die nächste Modellgeneration finanzieren kann. Ich denke, im Silicon Valley herrscht ein wachsender Konsens darüber, dass die gesamte Modellebene zur Ware wird und Llama es vielen Menschen ermöglicht, Modelle zu sehr geringen Kosten zu bauen.

Am Anfang hatten wir also viele Modellfirmen wie Character, Inflection, Cohere, Mistral und so weiter. Viele fragen sich, ob diese Unternehmen die „Fluchtgeschwindigkeit“ des Wirtschaftsmotors erreichen und weiterhin die nächste Generation von Modellen finanzieren können. Meiner Meinung nach erleben wir deshalb eine Konsolidierung auf dem Markt, oder?

Offensichtlich hat OpenAI diese „Fluchtgeschwindigkeit“ erreicht, mit der sie ihre Zukunft finanzieren können. Mir ist aber nicht klar, dass viele andere Unternehmen das können. Ist dies ein angemessener Überblick über den aktuellen Zustand der Modellebene? Wie wir in vielen anderen Märkten gesehen haben, werden Marktführer über einen wirtschaftlichen Motor und eine Anwendung verfügen, die es ihnen ermöglichen, weiter zu investieren.

Jensen Huang: Zunächst einmal gibt es einen grundlegenden Unterschied zwischen Modellen und künstlicher Intelligenz, oder? Modelle sind ein notwendiger, aber unzureichender Bestandteil der künstlichen Intelligenz, oder? Künstliche Intelligenz ist eine Fähigkeit, aber wofür? Was ist die Anwendung?

Die künstliche Intelligenz selbstfahrender Autos ist mit der künstlichen Intelligenz humanoider Roboter verwandt, aber sie sind nicht dasselbe. Sie hängen mit der künstlichen Intelligenz von Chatbots zusammen, sind aber nicht dasselbe, oder? Sie müssen also die Klassifizierung dieses Stapels verstehen. Auf jeder Ebene des Stapels gibt es Möglichkeiten, aber nicht jede Ebene bietet unbegrenzte Möglichkeiten.

Ich habe gerade etwas gesagt und Sie müssen nur das Wort „Modell“ durch „GPU“ ersetzen. Tatsächlich war dies die wichtigste Entdeckung unseres Unternehmens vor 32 Jahren – dass es einen grundlegenden Unterschied zwischen GPU-Grafikchips und beschleunigtem Computing gibt. Beschleunigtes Computing unterscheidet sich von dem, was wir in der KI-Infrastruktur tun, und obwohl es verwandt ist, ist es nicht genau dasselbe. Sie bauen aufeinander auf, sind aber nicht identisch. Jede Abstraktionsebene erfordert völlig unterschiedliche Fähigkeiten.

Jemand, der sehr gut darin ist, GPUs zu bauen, hat möglicherweise keine Ahnung, wie er ein Accelerated-Computing-Unternehmen werden kann. Es gibt viele Leute, die GPUs bauen, und wir haben die GPU erfunden, aber wir sind nicht die einzigen, die heute GPUs herstellen, oder? Es gibt viele GPUs auf der Welt, aber nicht alle davon sind Unternehmen für beschleunigtes Rechnen. Und es gibt viele Beschleunigeranwendungen, aber das ist nicht dasselbe wie Accelerated-Computing-Unternehmen. Beispielsweise kann eine sehr spezielle KI-Anwendung sehr erfolgreich sein.

Brad Gerstner: Das ist MTIA.

Jensen Huang: Das stimmt, aber es wird möglicherweise kein Unternehmen mit großer Reichweite und Fähigkeiten. Sie müssen also entscheiden, wo Sie sein möchten. In diesen verschiedenen Bereichen mag es Möglichkeiten geben, aber genau wie beim Aufbau eines Unternehmens muss man auf Veränderungen im Ökosystem und darauf achten, was im Laufe der Zeit zur Ware wird, was ein Feature ist, was ein Produkt ist, was ein Unternehmen ist bestimmt. Nun, ich habe gerade viele verschiedene Threads angesprochen.

Brad Gerstner: Natürlich gibt es einen Neuzugang, der das Geld, die Intelligenz und den Ehrgeiz hat, und das ist X.AI, oder? Von außen gibt es Berichte, dass Sie mit Larry und Elon zu Abend gegessen haben. Sie haben Ihnen 100.000 H100 abgeraten, sind nach Memphis gegangen und haben innerhalb weniger Monate einen riesigen Supercomputing-Cluster aufgebaut.

Jen-Hsun Huang: Erstens liegen die drei Punkte nicht auf derselben Linie. Ich habe mit ihnen zu Abend gegessen. Der kausale Zusammenhang ist einfach so.

Brad Gerstner: Was halten Sie von ihrer Fähigkeit, Supercomputing-Cluster aufzubauen? Es gibt immer noch Diskussionen darüber, dass sie weitere 100.000 H200 hinzufügen wollen, um die Größe dieses Superclusters zu vergrößern.

Erzählen Sie uns zunächst von den Ambitionen von Unternehmen X und was es erreicht hat. Sind wir gleichzeitig in die Ära von 200.000 oder 300.000 GPU-Clustern eingetreten?

Jen-Hsun Huang: Die Antwort ist ja. Beginnen Sie damit, anzuerkennen, dass ihre Leistungen verdient sind. Von der Konzeptphase über den Bau des Rechenzentrums, das für die Bereitstellung von NVIDIA-Geräten bereit ist, bis hin zur Stromversorgung, dem Anschluss der Geräte und der Durchführung der ersten Schulung.

Zunächst einmal der Bau einer so riesigen Fabrik, der Einsatz von Flüssigkeitskühlungstechnologie, die Fertigstellung der Energieversorgung, die Einholung von Genehmigungen und die Fertigstellung in so kurzer Zeit. Ich meine, es ist einfach eine übermenschliche Leistung. Soweit ich weiß, gibt es nur einen Menschen auf der Welt, der das kann. Elon Musks Verständnis von Technik, Architektur, Großsystemen und Ressourcenmobilisierung ist einzigartig und einfach unglaublich.

Natürlich ist auch sein Engineering-Team sehr gut, das Software-Team, das Netzwerk-Team, das Infrastruktur-Team sind alle großartig. Elon versteht das zutiefst. Von dem Moment an, als wir beschlossen, das Projekt zu starten, waren unser Engineering-Team, unser Netzwerkteam, unser Infrastruktur-Computing-Team und unser Software-Team vollständig vorbereitet.

Dann wurde die gesamte Infrastruktur, Logistik und die Menge an Daten und Geräten, die an diesem Tag eintrafen, sowie die Infrastruktur und Computertechnologie von Nvidia in 19 Tagen trainiert.

Wissen Sie, was das bedeutet? Schläft jemand? 24 Stunden am Tag arbeiten, schläft niemand, daran besteht kein Zweifel. Zunächst einmal sind 19 Tage unglaublich, aber wenn man einen Schritt zurücktritt und darüber nachdenkt, ist es nur eine Frage von Wochen. Die Menge an technischem Equipment, die man sehen kann, ist einfach unglaublich.

Die gesamte Verkabelung und Vernetzung. Die Vernetzung mit Nvidia-Geräten unterscheidet sich völlig von der Vernetzung in einem Hyperscale-Rechenzentrum. Die Anzahl der Drähte an einem Knoten. Auf der Rückseite des Computers befinden sich alle Drähte. Es ist einfach unglaublich, diesen Spitzenwert der Technologie und die ganze Software zusammenzubringen.

Daher finde ich es großartig, was Elon und sein Team geleistet haben, und ich bin dankbar, dass er unsere Zusammenarbeit mit ihnen auf der technischen und planerischen Seite gewürdigt hat. Aber was sie erreichten, war einzigartig und beispiellos.

Um Ihnen eine bessere Vorstellung zu geben: Mit 100.000 GPUs ist dies ohne Zweifel der schnellste Supercomputer der Welt. Das ist nur ein Cluster. Wenn man einen Supercomputer baut, dauert die Planung normalerweise drei Jahre, oder? Dann liefern Sie die Ausrüstung und verbringen Sie ein Jahr damit, alles zum Laufen zu bringen. Und wir reden hier von 19 Tagen.

▲Das durch ChatGPT verursachte KI-Erwachen ist unglaublich (Quelle: artnet)

Die Argumentation ist kurz davor, zu explodieren

Clark Tang: Was sind die Vorteile der NVIDIA-Plattform? Der gesamte Prozess wurde gehärtet, oder?

Jensen Huang: Ja, alles läuft bereits. Natürlich gibt es eine Reihe von X-Algorithmen, X-Frameworks und X-Stacks, und wir müssen noch viel Integration leisten. Aber die Vorplanung war so gut, dass sie allein schon beeindruckend war.

Brad Gerstner: Elon ist einzigartig, aber als Sie gerade geantwortet haben, haben Sie erwähnt, dass bereits 200.000 bis 300.000 GPU-Cluster existieren, oder? Kann es auf 500.000 skaliert werden? Kann es auf 1 Million skaliert werden? Hängt die Nachfrage nach Ihrem Produkt davon ab, ob diese Cluster auf Millionen skaliert werden können?

Jensen Huang: Die Antwort auf die letzte Frage lautet nein. Meiner Ansicht nach muss verteiltes Training funktionieren, und ich denke, dass verteiltes Rechnen erfunden wird und eine Form des föderierten Lernens und des verteilten, asynchronen Rechnens entdeckt wird. Ich bin diesbezüglich sehr zuversichtlich und sehr optimistisch.

Natürlich ist es wichtig, sich darüber im Klaren zu sein, dass es bei den Skalierungsgesetzen in der Vergangenheit in erster Linie um das Vortraining ging. Nachdem wir nun in die Multimodalität eingetreten sind, beginnen wir mit der Generierung synthetischer Daten. Die Phase nach dem Training skaliert sehr schnell, wobei sich die Generierung synthetischer Daten, Belohnungssysteme und auf Verstärkungslernen basierendes Training schnell weiterentwickeln. Nun ist auch die Erweiterung der Inferenzstufe an ihre Grenzen gestoßen.

Die Idee ist, dass das Modell, bevor es die Frage beantwortet, 10.000 Mal interne Überlegungen angestellt hat, was wahrscheinlich keine Übertreibung ist. Möglicherweise hat es eine Baumsuche durchgeführt, es hat möglicherweise Verstärkungslernen basierend auf dem Problem durchgeführt, es hat möglicherweise eine Art Simulation durchgeführt, es muss viel nachgedacht haben, es hat sich möglicherweise einige Daten und Informationen angesehen, oder? Der Kontext kann also ziemlich groß sein.

Ich denke, dass es sich bei uns um Intelligenz handelt, nicht wahr? Das ist es, was wir tun. Wenn Sie also diese Skalierung berechnen, skalieren Sie die Modellgröße und den Rechenmaßstab um den Faktor 4 pro Jahr, gepaart mit der wachsenden Nutzungsnachfrage …

Glauben wir, dass wir Millionen von GPUs brauchen? Ohne Zweifel, ja. Dies ist derzeit eine deterministische Frage. Die Frage ist also: Wie gestalten wir dies aus Sicht eines Rechenzentrums? Viel hängt davon ab, ob das Rechenzentrum auf einmal auf Gigawatt oder 250 Megawatt auf einmal umgestellt wird? Meiner Meinung nach treten beide Szenarien auf.

Clark Tang: Ich denke, Analysten konzentrieren sich immer auf aktuelle Architekturentscheidungen, aber ich denke, eine der wichtigsten Erkenntnisse aus diesem Gespräch ist, dass Sie über das gesamte Ökosystem nachdenken und darüber, was viele Jahre in der Zukunft passieren wird.

Nvidia skaliert also, ob vertikal oder horizontal, um sich auf die Zukunft vorzubereiten, anstatt sich nur auf eine Welt von 500.000 oder 1 Million GPU-Clustern zu verlassen. Wenn die verteilte Schulung eintrifft, haben Sie bereits die Software zur Unterstützung geschrieben.

Jen -Hsun Huang: Ja, erinnern Sie sich an den Megatron, den wir und unsere Partner vor etwa sieben Jahren entwickelt haben. Ohne sie wäre die Skalierung dieser groß angelegten Trainingsaufgaben nicht möglich. Wir haben Megatron erfunden, wir haben Nickel, GPU Direct und all die Arbeit, die wir mit RDMA gemacht haben, erfunden, was die Pipeline-Parallelverarbeitung viel einfacher gemacht hat.

Die gesamte Modellparallelverarbeitung, die gesamte verteilte Trainingszerlegung, die Stapelverarbeitung und all diese Technologien sind darauf zurückzuführen, dass wir die frühe Arbeit geleistet haben, und jetzt bereiten wir uns auch auf die nächste Generation von Technologien in der Zukunft vor.

Brad Gerstner: Reden wir also über Strawberry und o1.

Zunächst einmal finde ich es cool, dass sie das O1-Visum genannt haben, oder? Beim o1-Visum geht es darum, die besten und klügsten Talente aus der ganzen Welt in die Vereinigten Staaten zu locken, und ich weiß, dass wir alle eine große Leidenschaft dafür haben.

Mir gefällt die Idee wirklich, ein Modell zu schaffen, das denkt und uns zu neuen Höhen der intelligenten Skalierung treibt, als Hommage an die Genies, die durch Einwanderung nach Amerika kamen und uns zu dem gemacht haben, was wir heute sind.

Jen -Hsun Huang: Es muss eine außerirdische Intelligenz sein.

Brad Gerstner: Natürlich wird dieses Projekt von unserem Freund Noah Brown geleitet, der an Pluribus und Cicero gearbeitet hat, beides Meta-Projekte. Wie wichtig ist es, dass die Inferenz-Zeit-Inferenz eine völlig neue Skalierungsdimension der Intelligenz darstellt, im Gegensatz zur bloßen Erstellung größerer Modelle?

Jen-Hsun Huang: Das ist sehr wichtig, extrem wichtig. Viele Informationen können nicht im Voraus erstellt werden, wissen Sie? Selbst viele Berechnungen können nicht im Voraus nachbestellt werden. Die Ausführung außerhalb der Reihenfolge kann im Voraus erfolgen, viele Dinge können jedoch nur zur Laufzeit erledigt werden.

Ob aus Sicht der Informatik oder der Intelligenz, viele Dinge erfordern Kontext und Kontext, und für die Art der Antworten, nach denen Sie suchen, reicht manchmal eine einfache, schnelle Antwort aus, und die Konsequenzen dieser Antwort hängen davon ab Was Sie verwenden, ist die Art dieser Antwort.

Es kann also einen Abend dauern, über manche Antworten nachzudenken, und über manche Antworten kann es eine Woche dauern, oder? Ich kann mir durchaus vorstellen, dass ich sofort eine Nachricht an meine KI sende und sie erzähle, über Nacht darüber nachdenke und es mir nicht gleich erzähle, oder? Ich möchte, dass Sie die ganze Nacht darüber nachdenken und mir dann morgen früh Ihre beste Antwort sagen und sie für mich begründen.

Ich denke also, dass es aus Produktsicht eine intelligente Schichtung geben wird, es wird einmalige Versionen geben und es wird einige geben, die fünf Minuten dauern.

Brad Gerstner: Diese Intelligenzschicht ist in der Lage, diese Probleme den entsprechenden Modellen und Nutzungsszenarien zuzuordnen. Gestern Abend haben wir den erweiterten Sprachmodus und die o1-Vorschau verwendet, und ich habe meinem Sohn Nachhilfe für seine AP-Geschichtsprüfung gegeben, und es fühlte sich an, als würde der beste AP-Geschichtslehrer der Welt direkt neben Ihnen sitzen und gemeinsam über diese Fragen nachdenken. Es war so ein außergewöhnliches Erlebnis.

Jen-Hsun Huang: Mein Mentor ist jetzt KI.

Brad Gerstner: Natürlich gibt es sie heute. Dies geht auch auf das Thema zurück, dass heute über 40 % Ihres Umsatzes aus Schlussfolgerungen stammt. Aber die Argumentation wird aufgrund von „Argumentationsketten“ explodieren, oder?

Jen-Hsun Huang: Das Wachstum des Denkens wird eine Milliarde Mal betragen.

Brad Gerstner: Verdoppeln Sie es, verdoppeln Sie es eine Milliarde Mal.

Jen-Hsun Huang: Ja. Dies ist der Teil, den die meisten Menschen noch nicht vollständig verstehen. Das ist genau der Branchenwandel, über den wir vorhin gesprochen haben: die industrielle Revolution.

Brad Gerstner: Das ist intelligente Produktion, oder?

Jensen Huang: Es wird eine Milliarde Mal wachsen.

Brad Gerstner: Jeder schenkt NVIDIA große Aufmerksamkeit, da man denkt, dass es hauptsächlich für das Training größerer Modelle verwendet wird. Ist das nicht richtig? Wenn 50 % Ihres Umsatzes heute aus Schulungen stammen, wird der Umfang der Schlussfolgerungen in Zukunft weit über die Schulung hinausgehen. Schulung ist wichtig, aber wir hoffen, dass das Wachstum der Schlussfolgerungen das Wachstum der Schulung bei weitem übertreffen wird, und es ist fast unmöglich, es anders zu machen.

Jensen Huang: Das hoffen wir, ja, zur Schule zu gehen ist eine gute Sache, aber das ultimative Ziel ist, dass man einen Beitrag zur Gesellschaft leisten kann. Das Training dieser Modelle ist also gut, aber das ultimative Ziel besteht darin, sie wirkungsvoll zu machen.

Brad Gerstner: Nutzen Sie bereits Inference Chain und Tools wie o1, um Ihr eigenes Geschäft zu verbessern?

Jen-Hsun Huang: Unsere heutigen Netzwerksicherheitssysteme sind untrennbar mit unserer eigenen Intelligenz verbunden. Wir haben Agenten, die beim Design der Chips helfen, und ohne diese Agenten wäre der Hopper-Chip nicht möglich, ebenso wenig wie Blackwell, geschweige denn Rubin.

Wir haben KI-Chip-Designer, KI-Software-Ingenieure und KI-Verifizierungsingenieure und entwickeln sie alle innerhalb des Unternehmens. Da wir über diese Fähigkeiten verfügen, nutzen wir diese Gelegenheit lieber, um diese Technologie selbst zu erforschen.

▲Das Wachstum der Inferenz wird eine Milliarde Mal betragen (Quelle: NVIDIA)

Wir brauchen eine effizientere und sicherere KI

Brad Gerstner: Wissen Sie, als ich heute das Gebäude betrat, kam jemand auf mich zu und sagte, wissen Sie, fragen Sie Jensen nach Kultur, es geht nur um Kultur. Ich schaue mir Ihr Unternehmen an und wir reden viel über Anpassungsfähigkeit und Effizienz, flache Organisationsstrukturen, die eine schnelle Umsetzung ermöglichen, und kleine Teams.

Wissen Sie, NVIDIA ist in diesem Bereich einzigartig und generiert einen Umsatz von etwa 4 Millionen US-Dollar pro Mitarbeiter und einen Gewinn oder freien Cashflow von etwa 2 Millionen US-Dollar pro Mitarbeiter. Sie haben eine Kultur der Effizienz etabliert, die Kreativität, Innovation, Verantwortung und Eigenverantwortung wirklich freisetzt, und Sie haben das traditionelle funktionale Managementmodell gebrochen. Jeder redet gerne darüber, wie viele direkte Berichte Sie haben.

Ist der Einsatz von KI der Schlüssel dazu, dass Sie äußerst kreativ bleiben und gleichzeitig effizient arbeiten können?

Jen-Hsun Huang: Ohne Zweifel. Ich hoffe, dass Nvidia heute 32.000 Mitarbeiter hat und wir 4.000 Familien in Israel haben. Ich hoffe, dass es ihnen gut geht. Ich hoffe, dass Nvidia eines Tages ein Unternehmen mit 50.000 Mitarbeitern und 100 Millionen KI-Assistenten sein wird.

In jedem Team werden wir ein KI-Verzeichnis mit einer Gruppe von KIs haben, die in verschiedenen Dingen gut sind. Außerdem erhalten wir einen Posteingang mit einem Katalog von KIs, mit denen wir zusammengearbeitet haben und von denen wir wissen, dass sie in unseren Fachgebieten gut sind. Daher rekrutiert die KI andere KI, um Probleme zu lösen. KIs werden auch in Slack-Kanälen miteinander kommunizieren.

Brad Gerstner: Und die Arbeit mit Menschen.

Jen-Hsun Huang: Arbeiten mit Menschen. Wir werden also eine große Gruppe von Mitarbeitern sein, von denen ein Teil digital und KI ist, ein Teil davon sind biologisch-menschliche Mitarbeiter, und ich hoffe, dass es in Zukunft einige mechatronische Mitarbeiter geben wird.

Brad Gerstner: Aus geschäftlicher Sicht wird dies meiner Meinung nach oft missverstanden. Sie haben gerade ein Unternehmen beschrieben, das die Leistung eines Unternehmens mit 150.000 Mitarbeitern hat, aber Sie haben tatsächlich nur 50.000 Mitarbeiter eingesetzt. Sie sagen nicht, dass Sie alle Ihre Mitarbeiter entlassen werden, Sie bauen immer noch neue Mitarbeiter auf, aber die Leistung dieses Unternehmens wird deutlich steigen, oder?

Jen-Hsun Huang: Das wird oft missverstanden. KI wird keine Arbeitsplätze ersetzen, sie wird jeden Arbeitsplatz verändern. KI wird einen tiefgreifenden Einfluss darauf haben, wie Menschen über Arbeit denken, das müssen wir doch zugeben, oder?

KI hat das Potenzial, sowohl großen Nutzen als auch Schaden anzurichten, und wir müssen eine sichere KI aufbauen, ja, das muss die Grundlage sein. Was jedoch übersehen wird, ist, dass der Einsatz von KI zur Steigerung der Produktivität wahrscheinlich zu besseren Erträgen oder einem besseren Wachstum oder beidem führt. Und wenn das passiert, ist es unwahrscheinlich, dass die nächste E-Mail des CEO eine Entlassungsmitteilung sein wird.

Brad Gerstner: Auf jeden Fall, denn das Unternehmen wächst.

Jensen Huang: Ja, der Grund dafür ist, dass wir mehr Ideen haben, als wir erforschen können, und wir brauchen Leute, die uns helfen, darüber nachzudenken und diese Ideen dann zu automatisieren. Was den Automatisierungsteil betrifft, kann uns KI dabei helfen, dies zu erreichen.

Natürlich hilft es uns auch beim Nachdenken, aber wir müssen noch herausfinden, welches Problem wir lösen wollen. Es gibt unzählige Probleme, die wir lösen können, aber Unternehmen müssen diejenigen auswählen, die am dringendsten gelöst werden müssen, und dann einen Weg finden, sie zu automatisieren und zu skalieren.

Wenn wir also effizienter werden, werden wir mehr Leute einstellen. Die Leute vergessen das oft. Wenn man auf die Geschichte zurückblickt, wird deutlich, dass wir heute mehr Ideen haben als vor 200 Jahren. Deshalb wachsen das BIP und die Arbeitsplätze, obwohl wir wie verrückt automatisieren.

Brad Gerstner: Dies ist ein wichtiger Punkt, da wir in eine Zeit eintreten, in der fast die gesamte menschliche Produktivität und der gesamte Wohlstand ein Nebenprodukt der Technologie und Automatisierung der letzten 200 Jahre sind. Wenn Sie auf das Wachstumsdiagramm des Pro-Kopf-BIP der letzten 200 Jahre zurückblicken, von Adam Smith bis zu Schumpeters schöpferischer Zerstörung, zeigt sich, dass es immer schneller wird. Das bringt mich zu einer Frage.

Wenn man sich die 1990er Jahre anschaut, betrug das Produktivitätswachstum in den Vereinigten Staaten etwa 2,5 % bis 3 % pro Jahr. In den 2000er Jahren verlangsamte er sich dann auf etwa 1,8 %. Das letzte Jahrzehnt war das langsamste Produktivitätswachstum seit Beginn der Aufzeichnungen. Dies bezieht sich auf das Wachstum unserer Produktion bei einem festen Einsatz von Arbeit und Kapital und ist unser langsamstes Wachstum seit Beginn der Aufzeichnungen.

Viele Leute haben darüber diskutiert. Aber wenn die Welt so ist, wie Sie sie beschreiben, und wir Intelligenz nutzen und produzieren, stehen wir dann vor einer massiven Steigerung der menschlichen Produktivität?

Jen-Hsun Huang: Das ist unsere Hoffnung. Das ist unsere Hoffnung, und natürlich, wissen Sie, wir leben in dieser Welt, also haben wir direkte Beweise, oder? Wir haben direkte Beweise, etwa einzelne Forscher, die KI nutzen, dass sie die Wissenschaft nun in einem noch nie dagewesenen Ausmaß erforschen können, was ein Ausdruck der Produktivität ist.

Oder wir entwerfen einen so komplexen Chip und machen das so schnell, und die Mitarbeiterzahl des Unternehmens wächst nicht im gleichen Tempo, was auch ein Ausdruck der Produktivität ist, oder? Auch die Software, die wir entwickeln, wird immer besser, weil wir KI und Supercomputer zu unserer Unterstützung nutzen, und die Zahl der Mitarbeiter wächst nahezu linear.

Dies ist ein weiterer Beweis für die Produktivität. Egal in welche Branche ich eintauche, ich kann selbst überprüfen, ob diese Erscheinungen weit verbreitet sind. Es besteht kein Zweifel daran, dass Intelligenz die wertvollste Ressource der Welt ist, und jetzt werden wir sie in großem Maßstab produzieren.

Wir alle müssen lernen, in einer Umgebung zu leben, in der wir von KI umgeben sind, die Dinge sehr gut oder sogar besser kann als wir. Wenn ich darüber nachdenke, erkenne ich, dass dies mein Leben ist.

Ich habe 60 direkt unterstellte Mitarbeiter, oder? Sie sind alle Weltklasseleute auf ihrem Gebiet und schneiden viel besser ab als ich. Ich habe kein Problem damit, mit ihnen zusammenzuarbeiten, und ich habe kein Problem damit, sie zu coachen und mit ihnen zu kommunizieren. Ich denke also, was die Leute lernen werden, ist, dass sie alle CEOs von KI-Agenten sein werden.

Sie müssen über Kreativität, Entschlossenheit und ein gewisses Wissen darüber verfügen, wie man Probleme löst, um diese KIs so programmieren zu können, dass sie ihnen beim Erreichen ihrer Ziele helfen, genau wie ich mein Unternehmen leite.

Brad Gerstner: Sie haben eine Frage angesprochen, nämlich die Diskussion über Ausrichtung und sichere KI. Sie haben auch die Tragödie erwähnt, die sich im Nahen Osten abspielt. Wissen Sie, es gibt derzeit in verschiedenen Teilen der Welt viele Anwendungen von Autonomie und KI.

Sprechen wir also über schlechte Akteure, Sicherheits-KI und die Koordination mit Washington. Wie fühlst du dich jetzt? Sind wir auf dem richtigen Weg? Koordinieren wir uns ausreichend? Ich erinnere mich, dass Mark Zuckerberg einmal sagte, der Weg, schlechte KI zu besiegen, bestehe darin, gute KI besser zu machen. Wie würden Sie beschreiben, wie wir sicherstellen, dass KI einen positiven Nettonutzen für die Menschheit hat, anstatt uns in einer zwecklosen dystopischen Welt gefangen zu halten?

Jen-Hsun Huang: Die Diskussion über Sicherheit ist sehr wichtig und bedeutungsvoll. Die abstrakte Sichtweise, also die Behandlung von KI als großes neuronales Netzwerk, ist keine gute Sichtweise. Und der Grund dafür ist, dass wir wissen, dass künstliche Intelligenz und große Sprachmodelle zwar verwandt, aber nicht dasselbe sind.

Im Moment gibt es eine Menge Arbeit, die ich für brillant halte. Erstens ermöglicht ein Open-Source-Modell jeder Branche, jedem Unternehmen und der gesamten Forschungsgemeinschaft Zugang zu KI und zu lernen, wie sie diese Fähigkeit in ihren Bereichen nutzen können. sehr gut.

Zweitens konzentrieren sich die Kräfte der KI-Entwicklungstechnologie darauf, Wege zu finden, wie KI sicherer gemacht werden kann. KI wird verwendet, um Daten zu sichten, Informationen zu filtern, andere KIs zu trainieren, ausgerichtete KIs zu erstellen, synthetische Daten zu generieren, KI-Wissen zu erweitern, Halluzinationen zu reduzieren und alle KIs werden für Vektorbilder, Grafiken usw. erstellt, um andere KI-Systeme darüber zu informieren und zu überwachen haben noch nicht genügend Anerkennung für die Schaffung sicherer KI erhalten.

Brad Gerstner: Diese Systeme werden bereits gebaut.

Jensen Huang: Ja, wir bauen diese Systeme und jeder in der Branche macht das. Alle diese Sicherheitsmechanismen, darunter Red-Team-Tests, Prozesskontrolle, Modellkarten, Bewertungssysteme, Benchmark-Systeme usw., werden in alarmierendem Tempo aufgebaut. Diese Bemühungen haben nicht die Anerkennung erhalten, die sie verdienen.

Brad Gerstner: Ja, derzeit gibt es keine staatlichen Vorschriften, die Sie dazu verpflichten. Dies ist jetzt eine Zeit, in der die Akteure der Branche diese kritischen Probleme ernst nehmen und sich auf der Grundlage von Best Practices abstimmen.

Jensen Huang: Genau, diese Bemühungen werden nicht ausreichend anerkannt und nicht vollständig verstanden. Die Menschen müssen anfangen, über KI als ein System zu sprechen, das aus mehreren KIs besteht, und über ihre Natur als ausgereiftes System.

Was die Regulierung betrifft, müssen wir bedenken , dass KI eine Fähigkeit ist und in vielen Bereichen eingesetzt werden kann. Es besteht nicht unbedingt die Notwendigkeit einer separaten Gesetzgebung für jede wichtige Technologie, aber die Regulierung sollte sich nicht auf unnötige Bereiche erstrecken.

Die meisten Regulierungen sollten für bestimmte Anwendungen durchgeführt werden. Beispielsweise regulieren Behörden wie die FAA (Federal Aviation Administration), das NIH (National Institutes of Health) und die FDA (U.S. Food and Drug Administration) bereits Technologieanwendungen Es besteht die Notwendigkeit, mit der Verwaltung von Technologieanwendungen zu beginnen, die KI umfassen.

Verstehen Sie das also nicht falsch und ignorieren Sie nicht die große Menge bestehender Regulierungssysteme, die wir aktivieren müssen. Verlassen Sie sich nicht nur auf eine globale KI-Kommission, denn jede Regulierungsbehörde wird aus einem bestimmten Grund gegründet. Der Grund für die Existenz dieser unterschiedlichen Regulierungsbehörden besteht darin, unterschiedliche Herausforderungen anzugehen. Kehren wir noch einmal zu den Grundprinzipien zurück.

▲Clark Tang im Interview

KI-Open-Source treibt die Branchenaktivierung voran

Brad Gerstner: Mein Partner Bill Gurley (Anmerkung des Herausgebers: Bill war in diesem Interview abwesend) würde mir wahrscheinlich die Schuld geben, wenn ich nicht auf das Thema Open Source zurückkommen würde. Sie haben kürzlich ein sehr wichtiges und sehr mächtiges Open -Source -Modell veröffentlicht. META leistet eindeutig auch erhebliche Beiträge zur Open Source.

Als ich Twitter las, bemerkte ich, dass es viele Diskussionen über Open gegen geschlossen gab. Was denkst du über Open Source und insbesondere über die Fähigkeit deines eigenen Open-Source-Modells, mit der modernen Technologie Schritt zu halten? Dies ist die erste Frage.

Die zweite Frage ist, dass Ihre Vision für die Zukunft, ein Open -Source -Modell sowie ein geschlossenes Modell mit kommerziellen Operationen führt? Können diese beiden eine gesunde Spannung für die KI -Sicherheit erzeugen?

Jen-Hsun Huang: Die Diskussion von Open Source und Closed Source bezieht sich auf die Sicherheit, aber es geht nicht nur um Sicherheit. Zum Beispiel ist es völlig in Ordnung, ein geschlossenes Quellmodell als Motor eines Wirtschaftsmodells zur Aufrechterhaltung von Innovationen zu haben, und ich unterstütze dies von ganzem Herzen.

Ich denke, das Problem einfach als geschlossene Quelle gegen Open Source zu definieren ist eine falsche Denkweise. Es sollte geschlossen sein, Quelle und Open Source, oder? Weil Open Source für die Aktivierung vieler Branchen erforderlich ist.

Wenn es jetzt keine Open Source gibt, wie können all diese verschiedenen wissenschaftlichen Bereiche auf KI aktiviert werden? Weil sie ihre eigene domänenspezifische KI entwickeln müssen und Open-Source-Modelle nutzen müssen, um eine domänenspezifische KI zu erstellen. Die beiden sind verwandt, aber nicht dasselbe.

Nur weil Sie ein Open -Source -Modell haben, heißt das nicht, dass Sie KI haben. Daher müssen Sie Open -Source -Modelle haben, um die Erstellung von KI voranzutreiben. Daher werden Finanzdienstleistungen, Gesundheitswesen, Transport und viele andere Bereiche der Wissenschaft und Industrie von Open Source aktiviert.

BRAD GERSTNER: Es ist unglaublich, dass Ihr Open -Source -Modell stark gefragt ist, nicht wahr?

Jensen Huang: Unser Open Source -Modell? Natürlich, Lama -Downloads, oder? Offensichtlich ist die Arbeit, die Mark (Zuckerberg) und sein Team leisten, unglaublich, in enormer Nachfrage und die gesamte Branche und jeden Wissenschaftsbereich voll und ganz anzuferzen.

Der Grund, warum wir Nemotron erstellt haben, war die Erzeugung der synthetischen Daten. Intuitiv klingt es unzuverlässig zu glauben, dass eine KI kontinuierlich Daten in einer Schleife generiert, um sich selbst zu lernen. Es ist fraglich, wie oft Sie in dieser unendlichen Schleife herumgehen können. Ich habe jedoch ein Bild im Kopf, das wie ein super intelligenter Mensch in einem weichen Raum sperrt.

Wenn jedoch zwei oder drei Personen gemeinsam diskutieren, haben wir unterschiedliche KI -Modelle, haben unterschiedliche Wissensverteilungen und können uns gegenseitig in Frage stellen und beantworten und hin und her kommunizieren, dann werden wir alle drei intelligenter. Daher ist die Idee, Diskussionen, Debatten, Verstärkungslernen und synthetische Datenerzeugung zwischen KI-Modellen auszutauschen, zu interagieren, hin und her zu steigern.

Daher sind unser Nemotron 350b, 340b die besten Belohnungssystemmodelle der Welt. Es ist das beste kritische Modell und in der Tat ausgezeichnet. Dies ist also ein fantastisches Werkzeug, um alle anderen Modelle zu verbessern, unabhängig davon, wie gut die anderen Modelle sind, ich empfehle, das Nemotron 340b zu verwenden, um sie zu verbessern und noch besser zu machen. Und wir haben gesehen, wie Lama besser wurde und alle anderen Modelle davon profitiert haben.

▲ Meta leistet erhebliche Beiträge zur Open Source (Quelle: LinkedIn)

KI ist eine vollständige Revolution

Brad Gerstner: Als jemand, der 2016 das erste DGX-1 lieferte, war es eine unglaubliche Reise. Ihre Reise ist sowohl ungewöhnlich als auch erstaunlich. Die Tatsache, dass Sie es geschafft haben, diese anfänglichen schwierigen Zeiten durchzukommen, ist an sich außergewöhnlich.

Sie haben das erste DGX-1 im Jahr 2016 geliefert und wir haben diesen "Kambrischen Moment" im Jahr 2022 eingeliefert. Ich möchte also eine Frage stellen, die mir oft gestellt wird. Wie lange kann Ihr aktueller Jobstatus Ihrer Meinung nach dauern?

Mit 60 direkten Berichten fahren Sie überall diese Revolution. Genießen Sie den Prozess? Gibt es noch etwas, das Sie lieber tun möchten?

Jen-Hsun Huang: Fragen Sie in den letzten anderthalb Stunden nach Ihren Gefühlen? Die Antwort ist: großartig. Ich hatte eine tolle Zeit und konnte mir nicht vorstellen, etwas Lohnenderes zu tun.

Lassen Sie mich darüber nachdenken, ich denke nicht, dass unsere Arbeit immer das Gefühl hat, dass es Spaß macht. Mein Job macht keinen Spaß, und ich erwarte auch nicht, dass es sein würde. Sollte die Arbeit immer Spaß machen? Ich denke, das Wichtigste ist, dass die Arbeit immer wichtig ist. Ich nehme mich nicht zu ernst, aber ich nehme meinen Job sehr ernst. Ich übernehme unsere Verantwortung, unseren Beitrag zur Gesellschaft und die Zeiten, in denen wir sehr ernst leben.

Macht das immer Spaß? Nein, aber liebe ich es immer? Ja, wie alles, ob es sich um Familie, Freunde, Kinder, macht es immer Spaß? Nein, aber lieben wir sie immer tief? Absolut.

Wie lange kann ich das tun? Die eigentliche Frage ist, wie lange kann ich relevant bleiben. Die Antwort auf diese Frage wird nur durch eine andere Frage beantwortet: Wie werde ich weiterhin lernen? Ich bin heute optimistischer und sage das nicht, weil wir heute sprechen. Aufgrund des Aufkommens der KI bin ich optimistischer in Bezug auf meine Fähigkeit, relevant zu bleiben und weiter zu lernen. Ich benutze es jeden Tag. Ich weiß nicht, ob ihr es auch benutzt, aber ich benutze es jeden Tag.

Es gibt keine Studie, die keine KI betrifft, und selbst wenn ich die Antwort kenne, werde ich AI verwenden, um sie zu überprüfen. Überraschenderweise enthüllen die nächsten zwei oder drei Fragen, die ich stelle, oft etwas, das ich nicht kannte.

Sie können das Thema auswählen, das Sie interessiert, ich betrachte AI als Mentor, KI als Assistent, AI als Partner, mit dem ich meine Arbeit überprüfe. Leute, das ist wirklich eine vollständige Revolution. Und ich bin Informationsarbeiter, und meine Ausgabe ist Informationen.

Ich denke also, dass Ais Beitrag zur Gesellschaft außergewöhnlich ist. Wenn ich so relevant bleiben und weiterhin dazu beitragen kann, weiß ich, dass dieser Job für mich wichtig genug ist, um weiter zu verfolgen. Und meine Lebensqualität ist unglaublich.

Brad Gerstner: Ich kann mir nicht vorstellen, diesen Moment zu verpassen. Sie und ich sind seit Jahrzehnten in dieser Branche und dies ist unser größter Moment seit dreißig Jahren. Wir sind zutiefst dankbar für diese Zusammenarbeit.

Jensen Huang: Verpassen Sie nicht die nächsten zehn Jahre.

Brad Gerstner: Vielen Dank für den Austausch von Ideen, Sie machen uns alle klüger. Vielen Dank, ich denke, Sie spielen eine sehr wichtige Rolle als führender Anbieter bei der Navigation der Zukunft mit Optimismus und Sicherheit.

Jensen Huang: Danke, dass Sie bei uns sind. Ich habe es wirklich genossen, ich schätze es sehr, danke Brad, danke Clark.