Gerade hat OpenAI o3 veröffentlicht! Absolventen der Peking-Universität durchbrechen erneut die Grenzen der KI und beteiligen sich an Forschung und Entwicklung

Gerade hat OpenAI das Finale der AI Spring Festival Gala zum Jahresende eingeläutet.

Bei den diesmal veröffentlichten Modellen der o3-Serie handelt es sich um iterative Versionen von o1. Da es möglicherweise Urheberrechts- oder Markenkonflikte mit dem britischen Telekommunikationsbetreiber O2 gibt, hat OpenAI beschlossen, die Benennung „o2“ zu überspringen und direkt „o3“ zu übernehmen.

Aus diesem Grund lachte OpenAI-CEO Sam Altman sogar über die Verwirrung des Unternehmens bei der Modellbenennung. Es stellt sich heraus, dass Sie das auch wissen.

Gastgeber der Konferenz waren Sam Altman, Senior Vice President of Research Mark Chen und der Forschungswissenschaftler Hongyu Ren.

Es ist erwähnenswert, dass Ren Hongyu einen Bachelor-Abschluss an der Peking-Universität hat. Er hat grundlegende Beiträge zu o1 geleistet und ist auch der Hauptentwickler von GPT-4o. Er verfügt über umfangreiche Forschungspraktikumserfahrung bei Apple, Microsoft und Nvidia.

Die o3-Serie umfasst zwei Blockbuster-Modelle:

- OpenAI o3: Flaggschiff-Version mit starker Leistung

- OpenAI o3 mini: leichtes Modell, aber schneller und günstiger, mit Fokus auf Kosteneffizienz

Seien Sie nicht zu voreilig, denn die o3-Serie ist derzeit nicht für normale Benutzer zugänglich. OpenAI plant, Anwendungen zunächst für externe Sicherheitstests zu öffnen, und die offizielle Veröffentlichung wird voraussichtlich im Januar nächsten Jahres erfolgen.

Ab sofort können interessierte Freunde eine Bewerbung einreichen:

https://openai.com/index/early-access-for-safety-testing/

o3 Großer Leistungssprung, Auswendiglernen? existiert nicht

Die „Papierparameter“ des o3-Modells wurden in allen Aspekten verbessert.

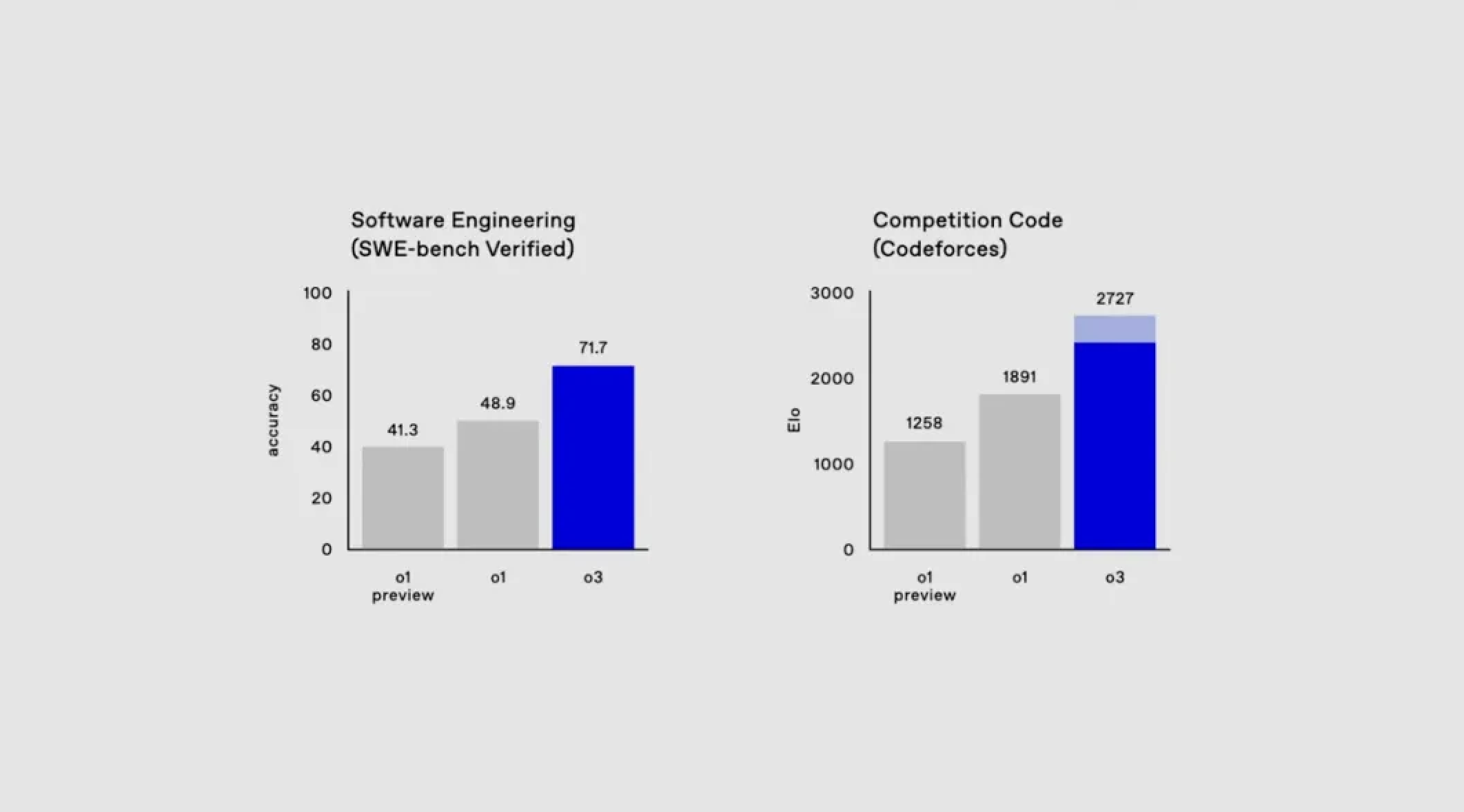

Erstens erreichte o3 im SweepBench Verified-Benchmark-Test eine Genauigkeit von ca. 71,7 % und ließ das o1-Modell direkt um satte 20 % hinter sich.

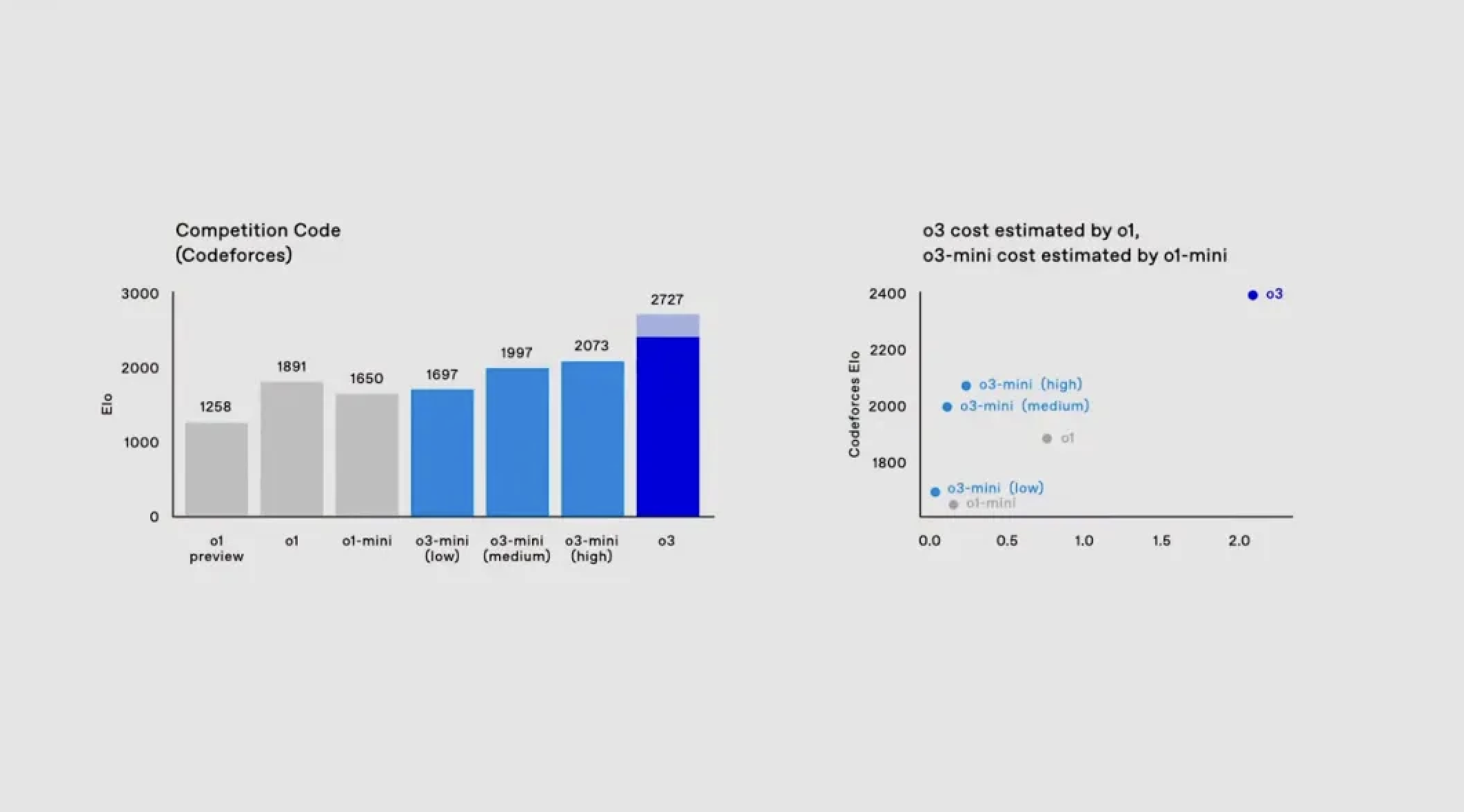

Was den Coding-Bereich betrifft, so hat o1 auf der Coding-Wettbewerbsplattform Codeforces eine Punktzahl von 1891. Und o3 kann bis zu 2727 Punkte erzielen, wenn es mit voller Geschwindigkeit läuft und die Bedenkzeit verlängert.

Als Referenz: Die Punktzahl des Demonstrators Mark Chen beträgt nur 2500, was voll und ganz zeigt, dass das o3-Modell in der Lage ist, menschliche professionelle Programmierer zu erreichen oder sogar zu übertreffen.

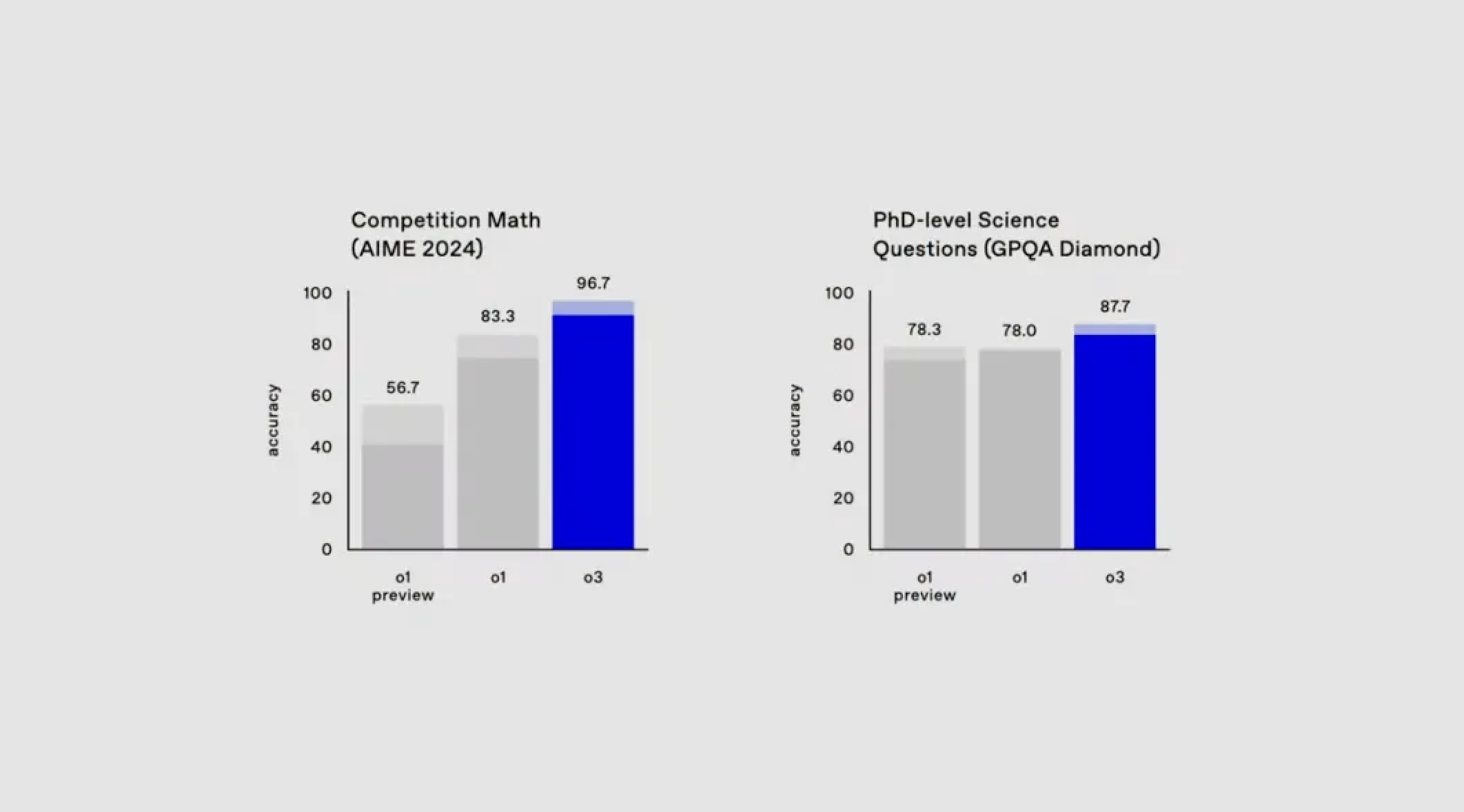

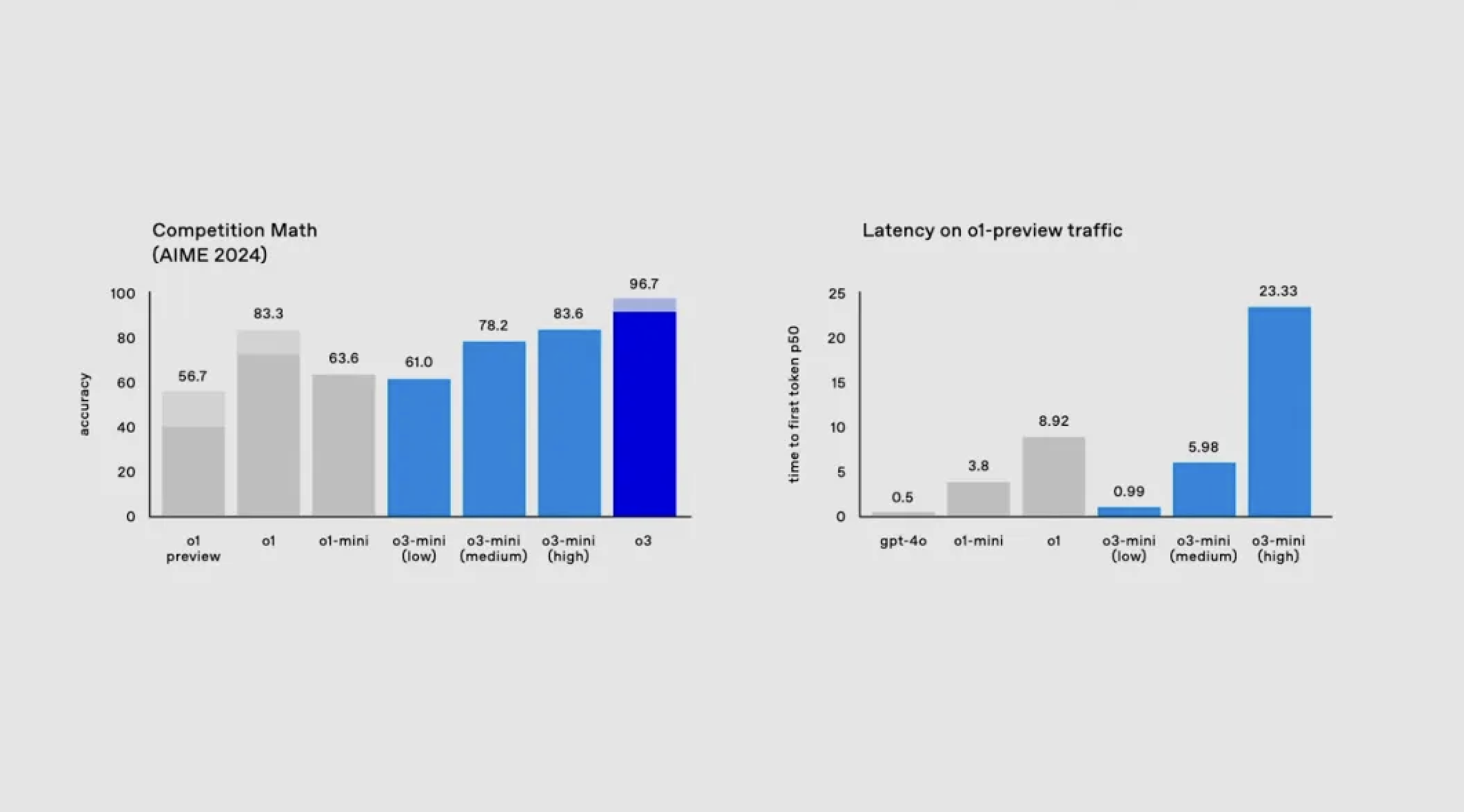

Auch im Bereich Mathematik schneidet o3 gut ab.

Im AIME 2024-Test des American Mathematics Competition übertraf o3 die 83,3 % von o1 mit einer Genauigkeit von 90,67 % vollständig.

Im GPQA Diamond-Test, der die Fähigkeit misst, wissenschaftliche Fragen auf Doktoratsniveau zu beantworten, erreichte o3 eine Punktzahl von 87,7 %, während o1 nur 78 % erreichte.

Welches Konzept? Wissen Sie, selbst promovierte Experten auf diesem Gebiet können im Rahmen ihres eigenen Fachwissens oft nur eine Genauigkeit von etwa 70 % erreichen.

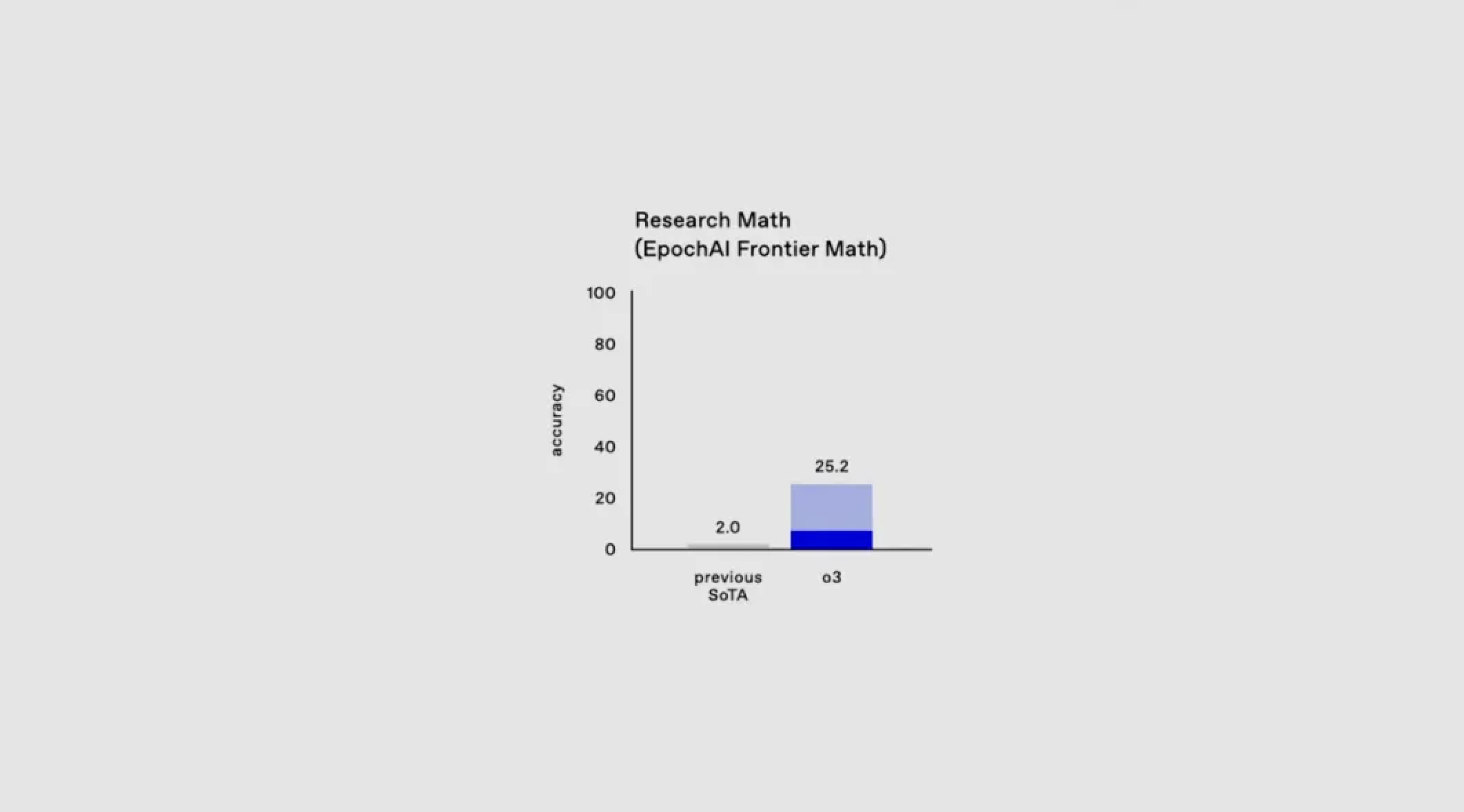

Angesichts der Situation, dass der aktuelle Benchmark-Test nahezu die volle Punktzahl erreicht, hat OpenAI einen neuen Mathematiktest EpochAI Frontier Math eingeführt.

Dies gilt als einer der anspruchsvollsten Mathematiktests, die derzeit verfügbar sind, und enthält äußerst komplexe Fragen. Selbst professionelle Mathematiker können Stunden oder sogar Tage damit verbringen, ein einzelnes Problem zu lösen.

Derzeit beträgt die Genauigkeit aller vorhandenen Modelle bei diesem Test weniger als 2 %, bei einem Langzeittest mit hoher Rechenleistung kann o3 jedoch einen Wert von mehr als 2457 erreichen.

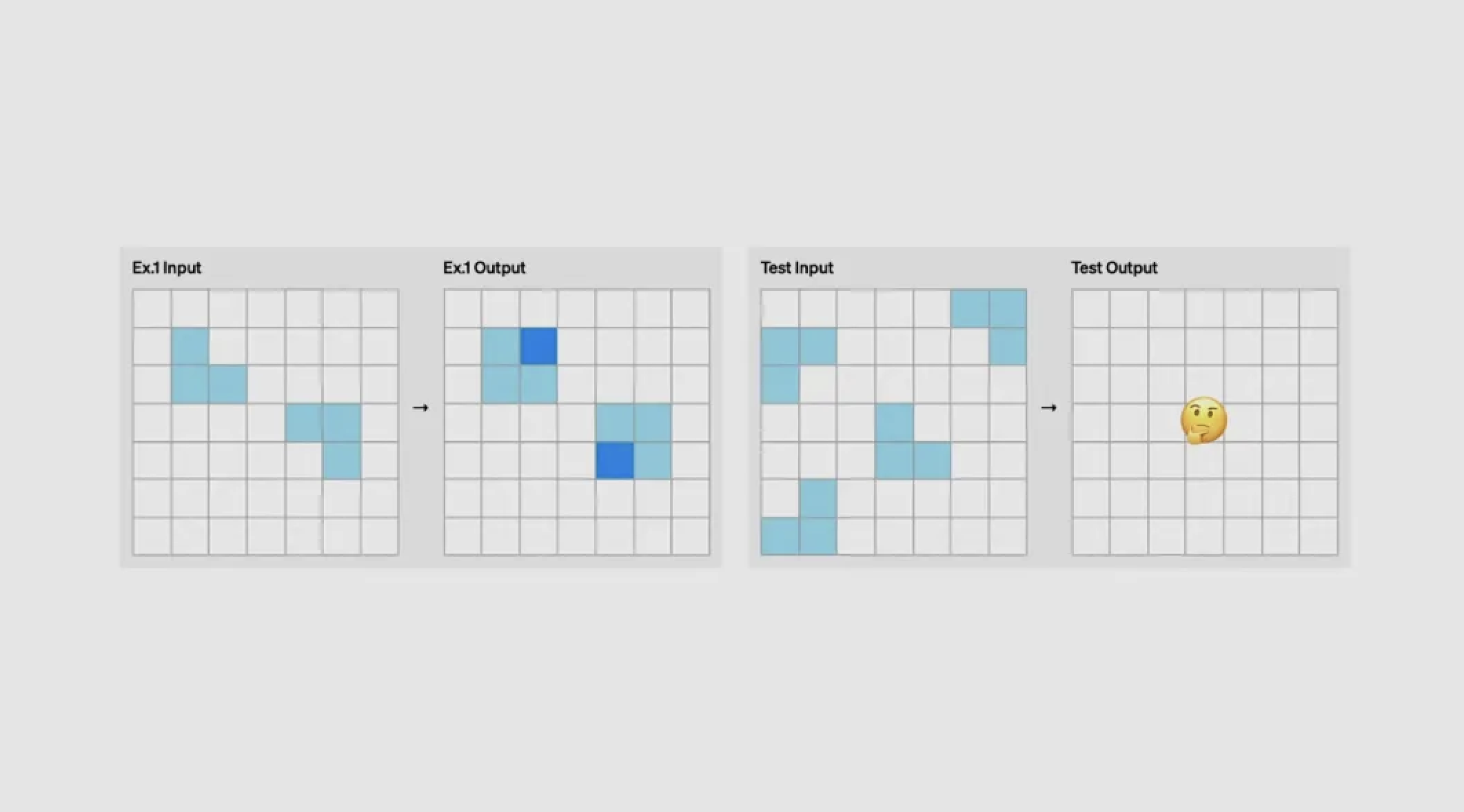

Wenn wir von AGI sprechen, dem Heiligen Gral im Bereich der KI, müssen wir ARC-AGI erwähnen, einen Benchmark-Test, der speziell AGI misst.

ARC-AGI wurde von François Chollet, dem Vater von Keras, entwickelt und testet hauptsächlich die Argumentationsfähigkeit des Modells durch grafisches logisches Denken.

Als der Moderator einem anderen Moderator, Mark Chen, eine spontane Frage stellte, brachte dieser die Anforderungen der Aufgabe genau zum Ausdruck: Zählen Sie die Anzahl der kleinen farbigen Quadrate in jedem gelben Quadrat und erstellen Sie entsprechend den entsprechenden Rand.

Diese für den Menschen einfachen Aufgaben sind für die KI ein schwieriges Problem.

Darüber hinaus erfordert jede Aufgabe von ARC-AGI unterschiedliche Fähigkeiten und vermeidet bewusst Doppelarbeit, wodurch die Möglichkeit, dass das Modell auf „Auswendiglernen“ angewiesen ist, vollständig ausgeschlossen wird und die Fähigkeit des Modells, neue Fähigkeiten in Echtzeit zu erlernen und anzuwenden, wirklich auf die Probe gestellt wird.

Nun erreicht o3 in der Konfiguration mit geringer Rechenleistung 75,7 Punkte. Als o3 gebeten wurde, länger nachzudenken und seine Rechenleistung zu erhöhen, erzielte o3 bei demselben versteckten reservierten Satz eine Punktzahl von 87,5 % und übertraf damit die meisten echten Menschen bei weitem.

Die Implikation von OpenAI ist, dass o3 uns der AGI einen Schritt näher bringen wird.

o3 mini erscheint, schneller und günstiger

Im September dieses Jahres veröffentlichte OpenAI o1 mini, das über starke Mathematik- und Programmierfähigkeiten zu extrem niedrigen Kosten verfügt.

In Fortsetzung dieser Entwicklungsrichtung behält auch der heute vorgestellte o3 mini die oben genannten Eigenschaften bei. Von nun an steht das Modell bis zum 10. Januar nur noch Sicherheitsforschern für Testanwendungen offen.

o3 mini unterstützt drei Inferenzzeitmodi: niedrig, mittel und hoch.

Benutzer können die Denkzeit des Modells flexibel an die Komplexität der Aufgabe anpassen. Beispielsweise erfordern komplexe Probleme möglicherweise eine längere Denkzeit, während einfache Probleme möglicherweise schnell bearbeitet werden.

Den ersten Bewertungsergebnissen nach zu urteilen, steigt der Elo-Score im Codeforces Elo-Score, der die Programmierfähigkeit misst, mit zunehmender Inferenzzeit weiter an und übertrifft den o1 mini bei mittlerer Inferenzzeit.

Der Moderator forderte das Modell auf, mithilfe von Python einen Codegenerator und einen Executor zu erstellen, ein Skript, das den Server startet und eine lokale Benutzeroberfläche erstellt. Benutzer können eine Codeanfrage in das Textfeld eingeben und das System sendet die Anfrage in drei erweiterten Modi an die API, um den entsprechenden Code zu generieren und auszuführen.

Als wir beispielsweise aufgefordert wurden, einen Code mit OpenAI und Zufallszahlen zu generieren, schloss der mittlere Inferenzmodus des o3 mini den Vorgang schnell ab.

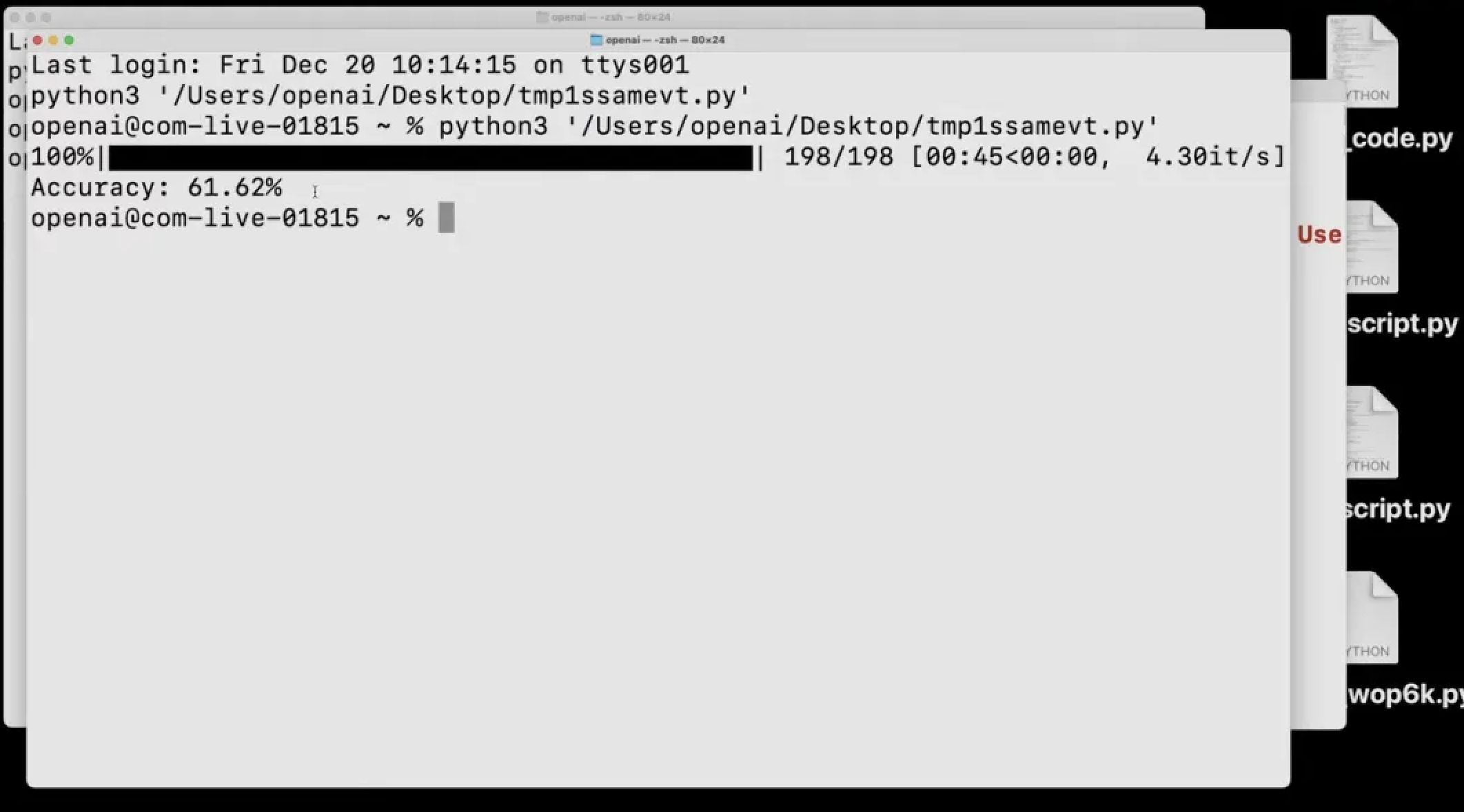

Darüber hinaus kann es sich selbst testen. Im GPQA-Datensatztest hat das Modell beispielsweise die Auswertung komplexer Datensätze im Low-Inference-Modus abgeschlossen.

Es lädt die Originaldatei herunter, identifiziert das CSS, die Antworten und Optionen, organisiert die Fragen und Antworten und führt schließlich eine Bewertung durch, wobei die Selbsteinschätzung in nur einer Minute mit einer Genauigkeit von 61,62 % abgeschlossen wird.

Auch im Bereich Mathematik schneidet o3 mini gut ab.

Im AIME-Mathematik-Benchmark-Test erreichte der niedrige Inferenzmodus eine mit o1 mini vergleichbare Leistung, und sein mittlerer Inferenzmodus übertraf o1 mini mit geringerer Latenz.

Darüber hinaus wird das o3-Mini-Modell als Reaktion auf die Stimme der Entwickler auch API-Funktionen wie Funktionsaufrufe, strukturierte Ausgabe und Entwickleranweisungen vollständig unterstützen.

Nun ist der Bewerbungskanal für o3 mini und o3 geöffnet. Der o3 mini wird voraussichtlich im Januar für alle Benutzer verfügbar sein, die Vollversion des o3 wird später veröffentlicht.

Am Ende des Tages zeigte OpenAI auf dieser 12-tägigen Jahresabschlusskonferenz endlich seinen Trumpf.

Man kann sagen, dass die Veröffentlichung des o3-Modells einen unerwarteten, aber vernünftigen Abschluss dieser Pressekonferenz brachte, die einst im Dilemma „Öffne hoch und geh niedrig“ gefangen war.

In weniger als drei Monaten hat OpenAI das iterative Upgrade des o1-Modells abgeschlossen.

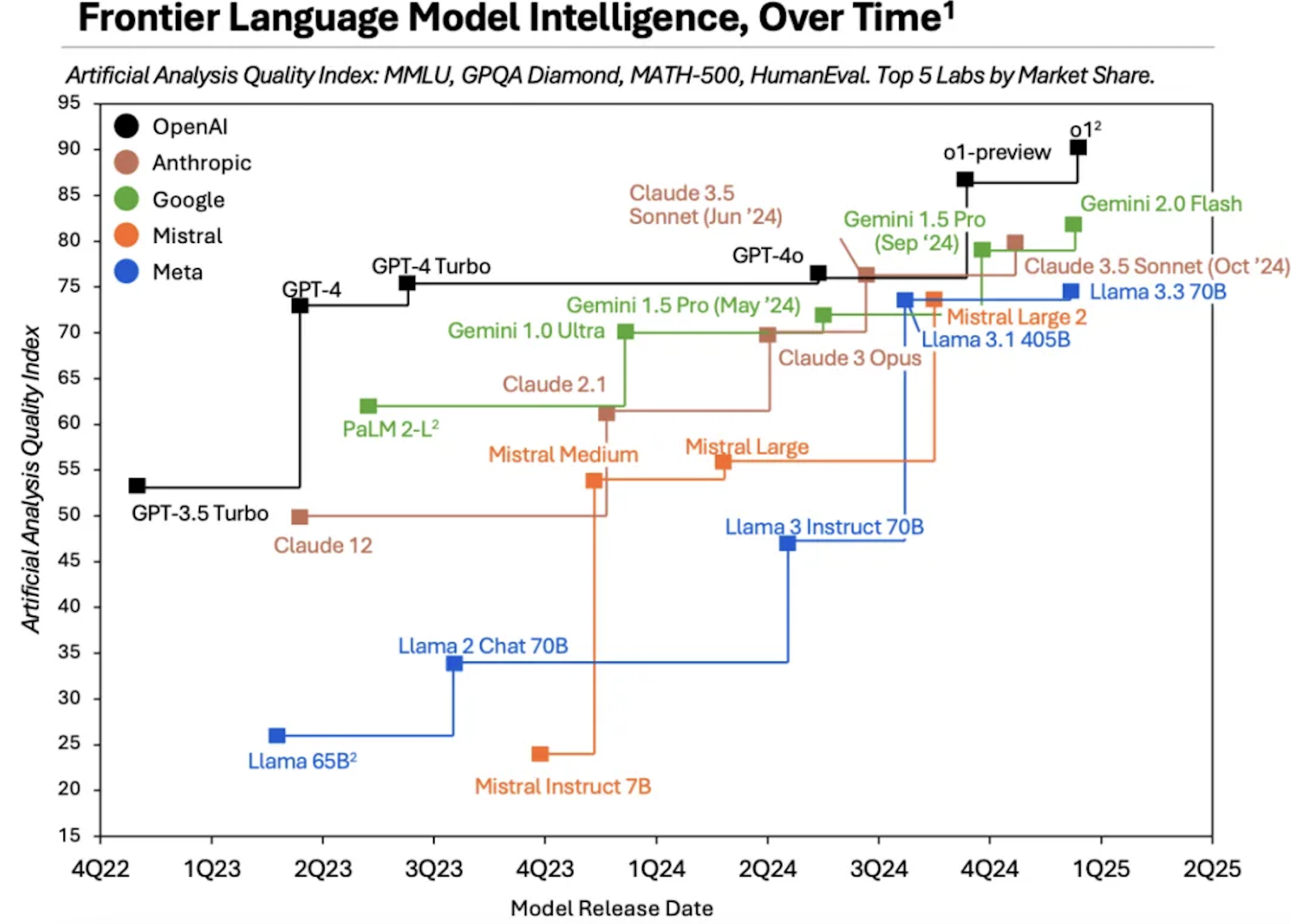

Diese Umstellung von der GPT-Serie auf die o-Serie ist offensichtlich eine sorgfältig überlegte strategische Entscheidung von OpenAI, und auch die nachfolgenden Ergebnisse beweisen, dass diese Entscheidung klug ist.

Es ist jedoch erwähnenswert, dass Microsoft-CEO Satya Nadella kürzlich in einem Podcast erklärte, dass OpenAI seinen Konkurrenten im KI-Bereich etwa zwei Jahre voraus sei.

Es ist dieses relativ entspannte Wettbewerbsumfeld, das es OpenAI ermöglicht, sich auf die Entwicklung von ChatGPT zu konzentrieren.

Allerdings verändert sich die aktuelle Situation sowohl offensiv als auch defensiv.

Der Bericht von Menlo Ventures zeigt, dass der Marktanteil von ChatGPT durch andere Wettbewerber allmählich untergraben wird und von 50 % im Jahr 2023 auf 34 % im Jahr 2024 sinkt.

Von „Standard“ zu „optional“ verblasst der Heiligenschein von ChatGPT.

Der Grund dafür liegt auf der Hand, dass der „Graben“ von OpenAI Stück für Stück von wild um sich greifenden Konkurrenten gefüllt wird.

Forschungsdaten von Artificial Analysis zeigen deutlich, dass Hersteller wie Anthropic und Google sukzessive neue Modelle entwickelt haben, deren Leistung nahe an GPT-4, OpenAI o1 und anderen Modellen liegt.

Darüber hinaus schwinden die Dividenden, die OpenAI in der Vergangenheit dadurch erzielt hat, dass es sich auf ein einziges Grundmodell verlassen hat, immer schneller, da das Skalierungsgesetz seine Obergrenze erreicht und die wichtigsten Führungskräfte nacheinander das Unternehmen verlassen.

In einer Branche, in der alles auf Schritt und Tritt berechnet wird, wird es selbst dem heute veröffentlichten o3-Modell schwer fallen, wieder ein 2-Jahres-Fenster zu schaffen.

Insbesondere wenn neue Modelle wie Grok-3 und Claude an Fahrt gewinnen, bleibt möglicherweise nicht mehr viel Zeit für OpenAI.

Aufwachen, der beste KI-Hersteller in diesem Jahr ist immer noch OpenAI, aber nächstes Jahr kann es aufgrund unterschiedlicher KI-Richtungen unzählige Antworten geben.

Glücklicherweise werden wir als Benutzer die größten Gewinner dieser Änderung sein.

# Willkommen beim offiziellen öffentlichen WeChat-Konto von aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner |. Ursprünglicher Link · Kommentare anzeigen · Sina Weibo