Der zurückhaltendste „AI Six Little Dragons“-Stiefstar hat in der DeepSeek-Welle ein neues Antwortblatt übergeben

Die von DeepSeek ausgelöste Welle ist noch nicht vorbei. Nicht nur OpenAI, sondern auch Chinas „Sechs kleine Drachen der KI“ stehen vor der Frage, ob das Skalierungsgesetz noch aufrechterhalten werden kann, ob es Open Source oder Closed Source ist und ob der Weg der KI-Implementierung noch machbar ist.

Heute übernahm Step Star, der sich unter den AI Six Little Dragons schon immer relativ zurückhaltend verhielt, die Führung bei der Abgabe seines ersten Antwortbogens in diesem Jahr.

Beim ersten Step UP Ecological Open Day kündigte Step UP Star seine eigene Art der Erforschung von AGI an, initiierte technische Forschung zum multimodalen Denken und konzentrierte seine KI-Implementierung auf intelligente Terminals, wobei der Schwerpunkt auf Anwendungsszenarien wie Automobilen, Mobiltelefonen, verkörperter Intelligenz und IoT lag.

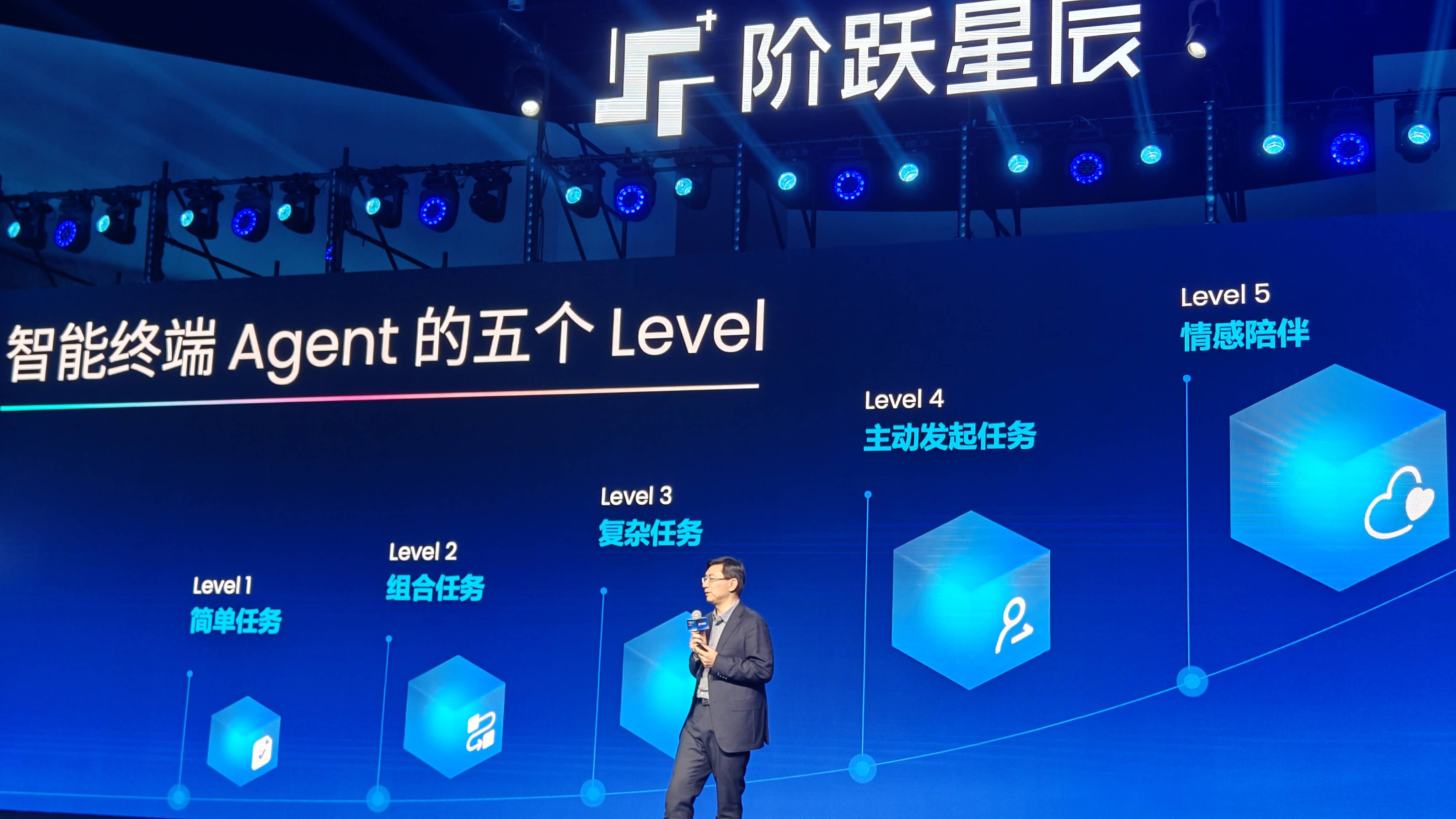

Jiang Daxin, Gründer und CEO von Step Star, glaubt, dass intelligente Terminals zu einem wichtigen Träger für die groß angelegte Anwendung der Agententechnologie werden.

Wir machen stetige Fortschritte in Richtung des Ziels, AGI zu realisieren und sind nun in die Entwicklungsphase des Agenten (intelligenter Körper) eingetreten.

Er wies darauf hin, dass die Entwicklung intelligenter Agenten von zwei Schlüsselelementen abhängt:

Das erste sind multimodale Fähigkeiten, die es intelligenten Agenten ermöglichen, die Welt vollständig wahrzunehmen und zu verstehen;

Die zweite Fähigkeit ist die Argumentationsfähigkeit, die es dem Agenten ermöglicht, in einer langen Denkkette langsam zu denken, proaktiv zu planen, zu versuchen und zu reflektieren und durch kontinuierliche Fehlerkorrektur genaue Antworten zu geben.

Multimodalität ermöglicht es intelligenten Agenten, wie Menschen zu „sehen, zuzuhören und zu verstehen“, was dem „sensorischen System“ eines Menschen entspricht, und die Denkfähigkeit ist die „Großhirnrinde“, die Informationen verarbeitet.

Die Kombination der beiden kann dazu führen, dass KI Wang

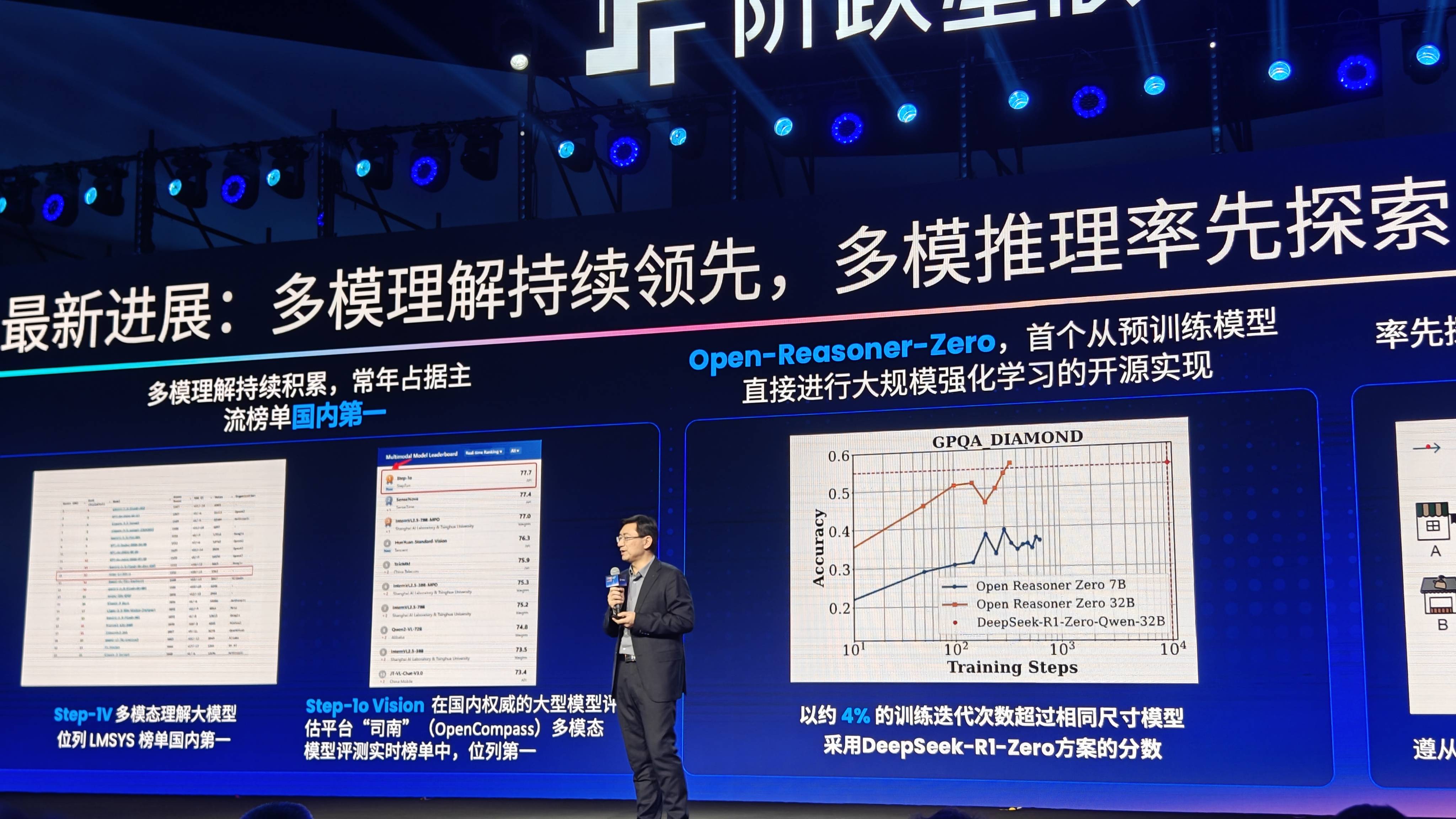

Multimodalität ist auch das größte Merkmal von Step Star unter den Six Little Dragons. Derzeit hat die Modellmatrix der Step-Serie 11 große multimodale Modelle veröffentlicht, die umfassende Funktionen in den Bereichen Spracherkennung, Sprachgenerierung, multimodales Verständnis sowie Bild- und Videogenerierung abdecken.

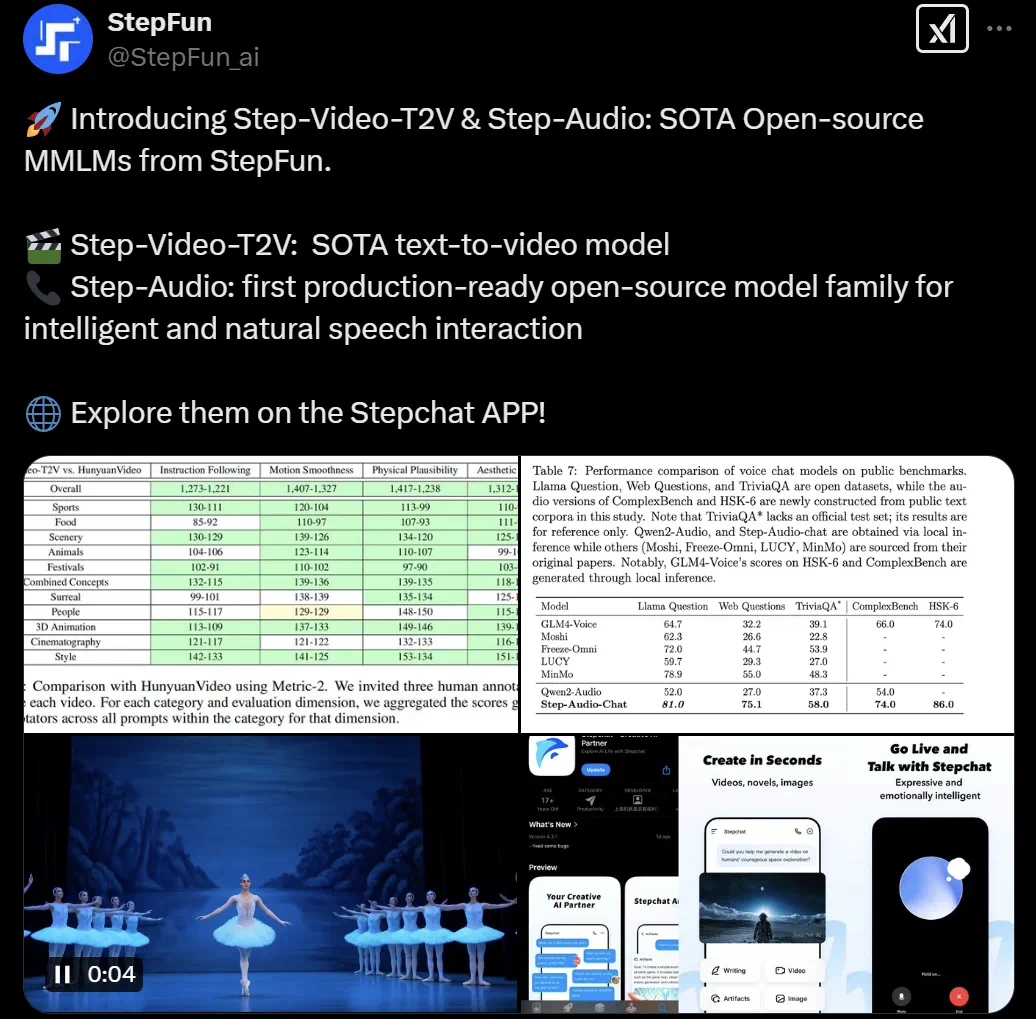

Vor ein paar Tagen hat Step Star auch das Step-Video-T2V-Videogenerierungsmodell und das Step-Audio-Sprachmodell als Open-Source-Modell bereitgestellt und ist damit einer der Six Little Dragons, die Open Source am schnellsten nutzen. Im Gegensatz zu DeepSeek sind die Open-Source-Modelle von Step Star jedoch alle multimodal, und diese Fähigkeit hat DeepSeek noch nicht unter Beweis gestellt.

Letztes Jahr nutzte APPSO die Yuewen-Anwendung unter Step Star, um dem chinesischen iPhone 16, das Apple AI noch nicht unterstützt, eine Funktion zu verleihen, die der offiziellen visuellen Intelligenz ähnelt. Sie können die Kamera einfach durch Drücken der Aufnahmetaste öffnen und im Grunde die Antwort auf alles finden, was Sie benötigen.

Was die Argumentationsfähigkeiten betrifft, kündigte Step Star heute auch das gemeinsam mit der Tsinghua-Universität entwickelte Open-Source-Argumentationsmodell Open-Reasoner-Zero an. Zum ersten Mal beginnt das verstärkte Lernen in großem Maßstab mit dem vorab trainierten Modell, und die Effizienz ist 25-mal höher als die von DeepSeek-R1-Zero.

Jiang Daxin zeigte auch eine Vorschau auf das intern vor Ort entwickelte visuelle Argumentationsmodell. Tatsächlich enthüllte dies die technische Logik von Step Star zur Förderung der Implementierung von KI: die Kombination multimodaler Fähigkeiten und Argumentationsfunktionen, wodurch intelligente Terminals zum Träger des Agenten werden.

Derzeit umfassen die Modellfunktionen von Step Star hauptsächlich die folgenden Szenarien in Smart Terminals.

- Automobilszene: Der in Zusammenarbeit mit Geely entwickelte Smart Cockpit Agent realisiert „Sehen und Sprechen“ durch multimodale Interaktion (Sprache + Vision). Wenn der Benutzer beispielsweise „Navigiere zur nächsten Ladestation“ sagt, ruft der Agent automatisch die Karte auf, fragt den Status der Ladesäule ab und plant die Route.

- Mobiltelefonszenario: Mit der gemeinsam mit OPPO entwickelten Funktion „Bildschirmabfrage mit einem Klick“ kann der Agent, nachdem der Benutzer ein Foto oder einen Screenshot aufgenommen hat, den Bildinhalt (z. B. Produkte, Dokumente) direkt analysieren und die API aufrufen, um die Suche oder Übersetzung abzuschließen, ohne dass die App manuell gewechselt werden muss.

- IoT-Szenario: Arbeiten Sie mit Herstellern wie TCL zusammen, um aktive Dienste durch die Verknüpfung zwischen Geräten zu realisieren und so intelligente Upgrades zwischen Geräten und eine nahtlose Verbindung von Erlebnissen zu erreichen.

- Verkörperte Intelligenz: Fördern Sie die innovative Anwendung von Agent im verkörperten Bereich. Step Star kündigte eine strategische Zusammenarbeit mit Zhiyuan Robot an, um gemeinsam KI+-basierte Roboteranwendungsszenarien zu erkunden.

KI-Smart-Terminals sind ein sexy und umstrittenes Konzept, das es vielen Hardware-Geräten ermöglichen könnte, das Benutzererlebnis durch KI zu verbessern. Vor kurzem haben viele Mobiltelefone den Zugriff auf DeepSek angekündigt. Gleichzeitig wird die KI-Hardware Ai Pin, die letztes Jahr populär wurde, nächsten Monat alle KI-Dienste, Nachrichten-Push und andere Netzwerkfunktionen einstellen.

Derzeit verfügen die meisten mit Mobiltelefonen verbundenen DeepSeek über ein Plug-in zum Sprachassistenten. Da DeepSeek jedoch noch keine multimodalen Funktionen unterstützt, sind die Nutzungsszenarien eingeschränkter. Das kürzlich beliebte Kombinationsspiel „DeepSeek+xx“ soll seinen Mangel an Fähigkeiten eigentlich ausgleichen.

OPPO, das letztes Jahr als erstes Unternehmen ein KI-Telefon auf den Markt brachte, ist bei der Integration von KI-Terminals noch einen Schritt weiter gegangen.

Mithilfe der Xiaobu-Assistenten-App „One-Click Screen Questioning“ interagieren Benutzer beispielsweise mit KI durch multimodales Sehen, um mehrere Funktionen wie Fotofragen und -antworten, Dokumentfragen und -antworten sowie Fragen und Antworten zur Bildschirmerkennung zu realisieren.

Benutzer können Xiaobu sogar Anweisungen geben, verschiedene Anwendungen einzugeben, um Aufgaben zu erledigen, z. B. die Suche nach demselben Produkt auf Taobao und JD.com, die Suche nach Informationen und Diensten auf Plattformen wie Xiaohongshu, Tonghuashun und Ctrip und die Suche nach Chat-Datensätzen in sozialer Software wie Feishu, DingTalk und WeChat Enterprise usw., wodurch eine Rundumsuche mit einem Klick realisiert wird.

Diese Funktionen werden von OPPO gemeinsam auf der Grundlage der Step-Reihe multimodaler Modelle entwickelt. Wan Yulong, Leiter der Abteilung für intelligente Assistenten von OPPO und Leiter von Xiaobu Assistant, sagte uns, dass sich Mobiltelefone mit der umfassenden Integration der KI-Technologie der neuen Generation und mobilen Endgeräten nach und nach zu intelligenten Assistenten entwickelt haben, die Benutzerabsichten verstehen, proaktive Dienste bereitstellen und sogar Benutzerbedürfnisse vorhersagen können.

Intelligente Terminals treten in die Agenten-Ära ein. Der größte Unterschied zur Vergangenheit besteht darin, dass lokalisierte KI-Folgefähigkeiten das Terminal von einem Werkzeug, das passiv auf Anweisungen reagiert, zu einem „intelligenten Partner“ machen, der aktiv Bedürfnisse versteht und anwendungsübergreifend zusammenarbeitet.

Was diesen Entwurf Wirklichkeit werden lässt, ist der multimodale KI-Agent, der als neue interaktive Schnittstelle ohne die Notwendigkeit einer physischen Schnittstelle dienen wird, ähnlich dem Seelenbaum in „Avatar“, der alle Cyber-Agenten verbindet und durch Denken sogar direkt mit der KI interagieren kann, um die Ausführung aller realen Aufgaben abzuschließen.

![]()

Jiang Daxin schlug vor, dass die Entwicklung von AGI drei Phasen durchlaufen muss: Simulation der Welt, Erkundung der Welt und Zusammenfassung der Welt:

- Simulierte Welt: Trainieren Sie multimodale Modelle durch Nachahmungslernen, um Ton, Text, Bilder, Videos und die physische Welt einheitlich darzustellen.

- Entdecken Sie die Welt: Führen Sie verstärkendes Lernen (wie AlphaGo, DeepSeek) ein, um dem Modell logische Argumentation und Problemlösungsfähigkeiten zu verleihen.

- Fassen Sie die Welt zusammen: Erforschen Sie die Fähigkeit von Maschinen, unabhängig physikalische Gesetze zu entdecken, wie zum Beispiel Newtons Ableitung des Schwerkraftgesetzes aus dem Fall eines Apfels. Ziel ist die Zusammenarbeit von KI und Wissenschaftlern.

Es mag mehr als einen Weg zu AGI geben, aber jemand muss immer einen anderen Weg einschlagen. Step Star hat den Weg des intelligenten Terminalagenten gewählt. Vielleicht hat die nächste Innovation der Mensch-Computer-Interaktion bereits den Grundstein für die nächste Innovation gelegt.

# Willkommen beim offiziellen öffentlichen WeChat-Konto von Aifaner: Aifaner (WeChat-ID: ifanr) wird Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner |. Ursprünglicher Link · Kommentare anzeigen · Sina Weibo