Apple arbeitet mit Nvidia zusammen, um die KI reaktionsfähiger zu machen

Kürzlich gaben Apple und NVIDIA eine Zusammenarbeit bekannt, um die Inferenzleistung großer Sprachmodelle (LLM) zu beschleunigen und zu optimieren.

Um die geringe Effizienz und die geringe Speicherbandbreite des herkömmlichen autoregressiven LLM-Denkens zu verbessern, haben Apple-Forscher für maschinelles Lernen Anfang dieses Jahres eine spekulative Dekodierungstechnologie namens „ ReDrafter “ (Recurrent Drafter, zyklisches Entwurfsmodell) veröffentlicht und als Open Source bereitgestellt.

▲Quelle: GitHub

Derzeit ist ReDrafter in NVIDIAs skalierbare Inferenzlösung „ TensorRT-LLM “ integriert. Letztere ist eine Open-Source-Bibliothek, die auf dem Deep-Learning-Kompilierungsframework „TensorRT“ basiert und die spekulative Dekodierung einschließlich der „Medusa-Methode“ unterstützt.

Da die in ReDrafter enthaltenen Algorithmen jedoch noch nie zuvor verwendete Operatoren verwenden, hat NVIDIA neue Operatoren hinzugefügt oder vorhandene Operatoren verfügbar gemacht, was die Anpassungsfähigkeit von TensorRT-LLM an komplexe Modelle und Decodierungsfähigkeiten erheblich verbessert.

▲Quelle: GitHub

Es wird berichtet, dass die spekulative Dekodierung von ReDrafter den LLM-Schlussfolgerungsprozess durch drei Schlüsseltechnologien beschleunigt:

- RNN-Entwurfsmodell

- Dynamischer Baum-Aufmerksamkeitsalgorithmus

- Schulung zur Wissensdestillation

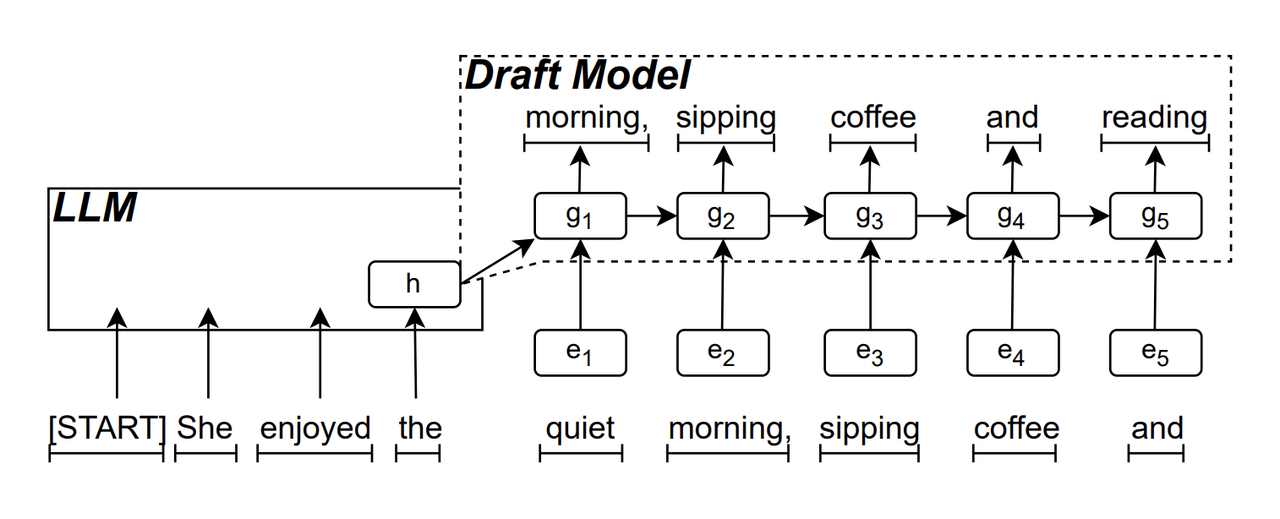

Das RNN-Entwurfsmodell ist die „Kern“-Komponente von ReDrafter. Es verwendet ein wiederkehrendes neuronales Netzwerk, um die Reihenfolge der Token vorherzusagen, die als nächstes erscheinen könnten, basierend auf dem „versteckten Zustand“ von LLM. Es kann lokale Zeitabhängigkeiten erfassen und dadurch die Vorhersagegenauigkeit verbessern.

Das Arbeitsprinzip dieses Modells ist: LLM generiert während des Textgenerierungsprozesses zunächst ein anfängliches Token, und dann verwendet das RNN-Entwurfsmodell das Token und den letzten verborgenen Zustand von LLM als Eingabe, um eine Strahlsuche (Beam Search) durchzuführen, und generiert dann Sequenz mit mehreren Kandidaten-Tokens.

Im Gegensatz zum herkömmlichen autoregressiven LLM, das jeweils nur ein Token generiert, kann ReDrafter durch die Vorhersageausgabe des RNN-Entwurfsmodells bei jedem Decodierungsschritt mehrere Token generieren, wodurch die Anzahl der Aufrufe der LLM-Verifizierung erheblich reduziert und dadurch verbessert wird die allgemeine Denkgeschwindigkeit.

▲Bildquelle: arXiv

Dynamic Tree Attention ist ein Algorithmus, der Beam-Suchergebnisse optimiert.

Wir wissen bereits, dass während des Strahlsuchprozesses mehrere Kandidatensequenzen generiert werden und diese Sequenzen häufig gemeinsame Präfixe haben. Der dynamische Baum-Aufmerksamkeitsalgorithmus identifiziert diese gemeinsamen Präfixe und entfernt sie von Token, die eine Verifizierung erfordern, wodurch die Datenmenge reduziert wird, die LLM verarbeiten muss.

In einigen Fällen kann dieser Algorithmus die Anzahl der zu verifizierenden Token um 30 bis 60 % reduzieren. Dies bedeutet, dass ReDrafter nach Verwendung des dynamischen Baumaufmerksamkeitsalgorithmus die Rechenressourcen effizienter nutzen und die Inferenzgeschwindigkeit weiter verbessern kann.

▲Bildquelle: NVIDIA

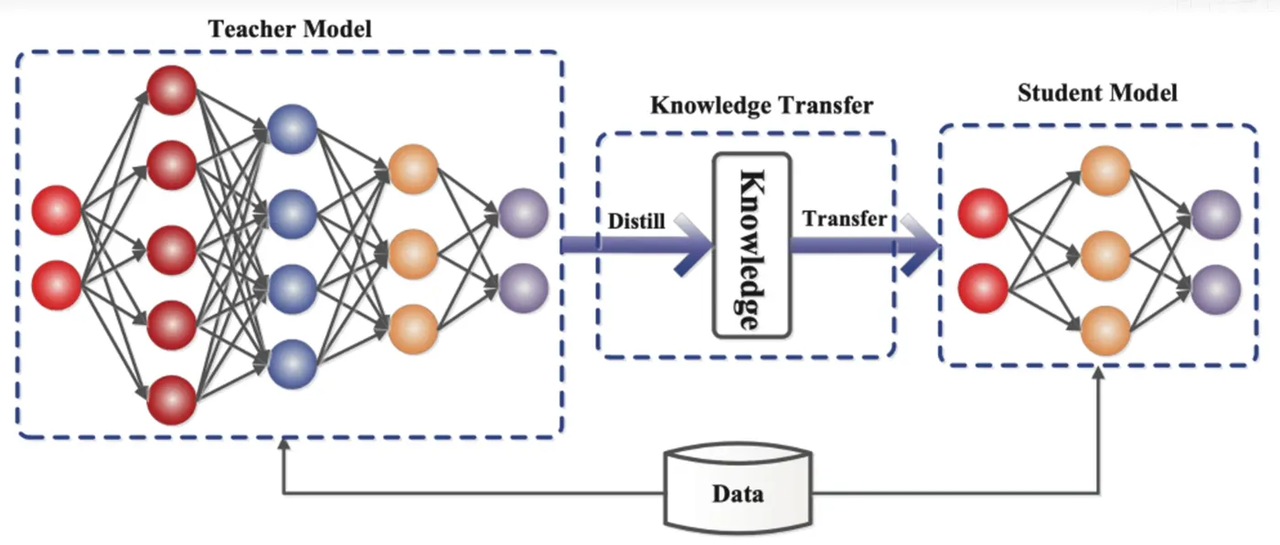

Wissensdestillation ist eine Modellkomprimierungstechnologie, die das Wissen eines großen, komplexen Modells (Lehrermodell) in ein kleineres, einfacheres Modell (Schülermodell) „destillieren“ kann. In ReDrafter dient das RNN-Entwurfsmodell als Schülermodell und lernt durch Wissensdestillation vom LLM (Lehrermodell).

Konkret gibt LLM während des Destillationstrainingsprozesses eine Reihe von „Wahrscheinlichkeitsverteilungen“ der nächsten möglichen Wörter an. Die Entwickler trainieren das RNN-Entwurfsmodell auf der Grundlage dieser Wahrscheinlichkeitsverteilungsdaten und berechnen dann die Differenz zwischen den Wahrscheinlichkeitsverteilungen der beiden Modelle. Und minimieren Sie diesen Unterschied durch Optimierungsalgorithmen.

In diesem Prozess lernt das RNN-Entwurfsmodell kontinuierlich den probabilistischen Vorhersagemodus von LLM, sodass in praktischen Anwendungen LLM-ähnlicher Text generiert werden kann.

Durch Wissensdestillationstraining erfasst das RNN-Entwurfsmodell die Gesetze und Muster der Sprache besser, wodurch die Ausgabe von LLM genauer vorhergesagt wird, und verbessert die Leistung von ReDrafter auf begrenzter Hardware aufgrund seiner geringeren Größe und geringeren Gesamtleistung unter Bedingungen.

▲Bildquelle: Alibaba Cloud Developer Community

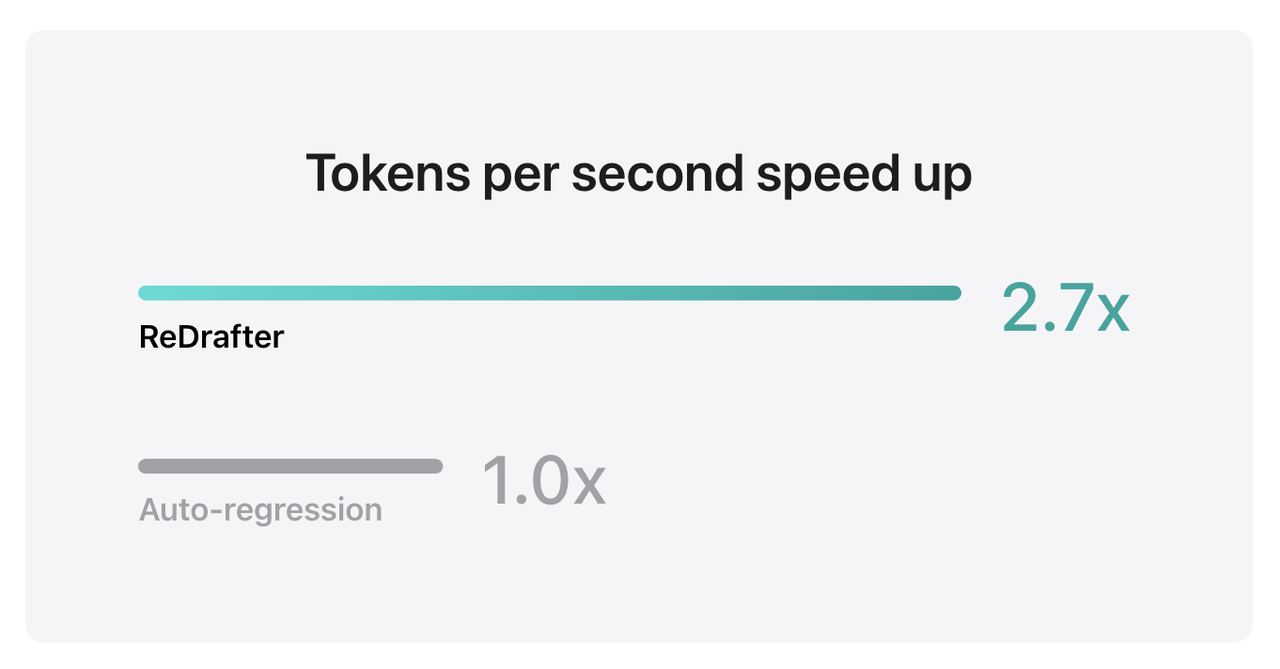

Die Benchmark-Ergebnisse von Apple zeigen, dass bei der Verwendung von TensorRT-LLM in ReDrafter in einem Produktionsmodell mit Milliarden von Parametern auf der NVIDIA H100-GPU die Anzahl der pro Sekunde durch Greedy Decoding generierten Token um das 2,7-fache stieg.

Darüber hinaus kann ReDrafter auch auf Apples eigener M2 Ultra Metal GPU eine 2,3-fache Steigerung der Inferenzgeschwindigkeit erreichen. Apple-Forscher erklärten: „LLM wird zunehmend zur Steuerung von Produktionsanwendungen eingesetzt und eine Verbesserung der Inferenzeffizienz kann sich sowohl auf die Rechenkosten auswirken als auch die Latenz auf Benutzerseite verringern.“

▲Quelle: Apple

Erwähnenswert ist, dass ReDrafter unter Beibehaltung der Ausgabequalität den Bedarf an GPU-Ressourcen reduziert, wodurch LLM in ressourcenbeschränkten Umgebungen effizient ausgeführt werden kann und LLM auf verschiedenen Hardwareplattformen eingesetzt werden kann.

Apple hat diese Technologie nun als Open Source auf GitHub bereitgestellt und Nvidia dürfte in Zukunft das einzige Unternehmen sein, das davon profitieren wird.

# Willkommen beim offiziellen öffentlichen WeChat-Konto von aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner |. Ursprünglicher Link · Kommentare anzeigen · Sina Weibo