Auf welchen Chip der Zukunft setzen Apple, Qualcomm und Google? Harte Philosophie

Während meiner Erfahrung mit dem Pixel 6 Pro hatte ich, abgesehen vom Fotografieren, selten das Gefühl, dass etwas mit dem, was Google als „das intelligenteste Pixel-Telefon“ bezeichnete, nicht in Ordnung war, bis mich eines Morgens der Wecker meines Telefons weckte.

Anders als beim Schieben zum Schließen des Alarms auf einem normalen Mobiltelefon fordert mich das Pixel 6 Pro auf, „Snooze (one more break)“ oder „Stop (stop)“ zu sagen, um den Alarm zu steuern, und wenn ich „Stop "Vorsichtig, der Wecker. Das Handy, das weiterging, war stumm.

Es ist ein triviales kleines Feature, aber es hält mich jeden Morgen bei guter Laune, wenn ich von meinem Wecker geweckt werde.

Endlich brauche ich keine Schläfrigkeit mehr, um mein Handy zu suchen, sondern brauche nur noch einen Satz, um das lebensbedrohliche Handy zum Schweigen zu bringen, und ich habe das erste Mal das Gefühl, dass das Handy mich „verstehen“ kann.

Das Geheimnis, „die Worte der Menschen zu verstehen“, ist im bescheidenen TPU verborgen.

Allgegenwärtiges KI-Computing

Auf dem SoC des Handys ist die Präsenz der NPU immer schwächer als die von CPU und GPU.

Dieser Prozessor, der sich auf den Betrieb neuronaler Netze konzentriert, hat nicht einmal einen einheitlichen Namen: Er heißt NPU auf dem Kirin-Chip und Neural Engine auf dem bionischen Chip der A-Serie; Google nennt ihn TPU, und MediaTek glaubt, dass er dafür verwendet wird sollte APU für KI-Berechnung heißen …

Obwohl diese Chips verschiedene Namen und unterschiedliche Architekturen und Prinzipien haben, sind ihre Zwecke weitgehend ähnlich – das maschinelle Lernen zu beschleunigen und die Rechenleistung von Mobiltelefonen mit künstlicher Intelligenz zu verbessern.

Wer auf die Leistung des Handy-Prozessors achtet, wird feststellen, dass die Rechenleistung der CPU, egal ob A-Series-Chip des iPhone oder Snapdragon-Flaggschiff von Android, in der Vergangenheit nur sehr begrenzt verbessert wurde zwei Jahre, und das Phänomen des "Zahnpastaquetschens" in der Leistung wird immer ernster.

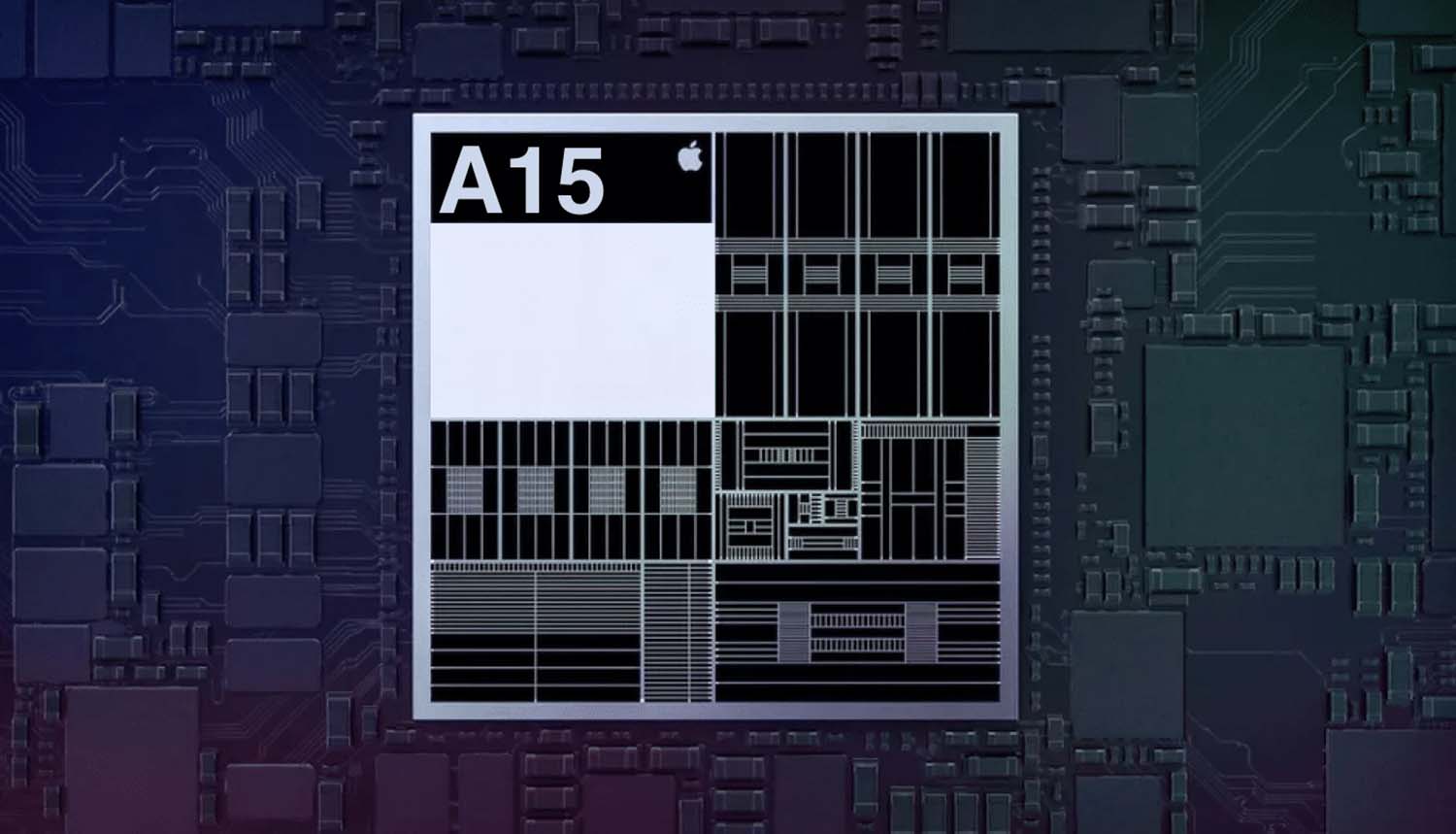

Im Gegensatz dazu ist die KI-Rechenleistung zu einem Parameterindikator geworden, den immer mehr Hersteller zu nennen bereit sind. Am Beispiel des Chips der A-Serie hat der bionische Chip A14 von Apple seine Spitzenrechenleistung im Vergleich zur vorherigen Generation fast verdoppelt und kann 11 Billionen Operationen pro Sekunde ausführen.

Ein Jahr später kann der Bionic-Chip A15 auf dieser Basis immer noch eine deutliche Verbesserung von mehr als 40 % bringen und bis zu 15,8 Billionen Operationen pro Sekunde ausführen.

Auch der KI-Rechenleistungsfortschritt des Android-Lagers kann sich sehen lassen: Auf der von der Technischen Universität Zürich lancierten KI-Leistungstestliste punktete der erstmals mit NPU eingeführte KI-Performance-Score Kirin 970 23.600 Punkte Vier Jahre später erreichte der Google Tensor-Chip mit einem Highscore von 214.700 die Spitze, Kirin 9000 und Snapdragon 888 erreichten ebenfalls rund 160.000 Punkte.

Da die KI-Rechenleistung fast exponentiell wächst, warum ist es für uns schwierig, Veränderungen zu spüren? Ist das etwas fortgeschritten klingende Wort KI-Funktion zu weit von uns entfernt?

▲ Bild von: Gadgetmatch

Tatsächlich ist es jedes Mal, wenn Sie das Telefon entsperren, den Sprachassistenten aktivieren oder sogar den Auslöser drücken, ein enger Kontakt mit KI-Computing.

Die NPU ist wie eine Black Box, sie macht den KI-Berechnungsprozess fast nicht existent und macht Sie für die Technologie unsichtbar, aber umgeben von einer natürlicheren Mensch-Computer-Interaktion. Die Evolution des Sprachassistenten von Google ist ein gutes Beispiel.

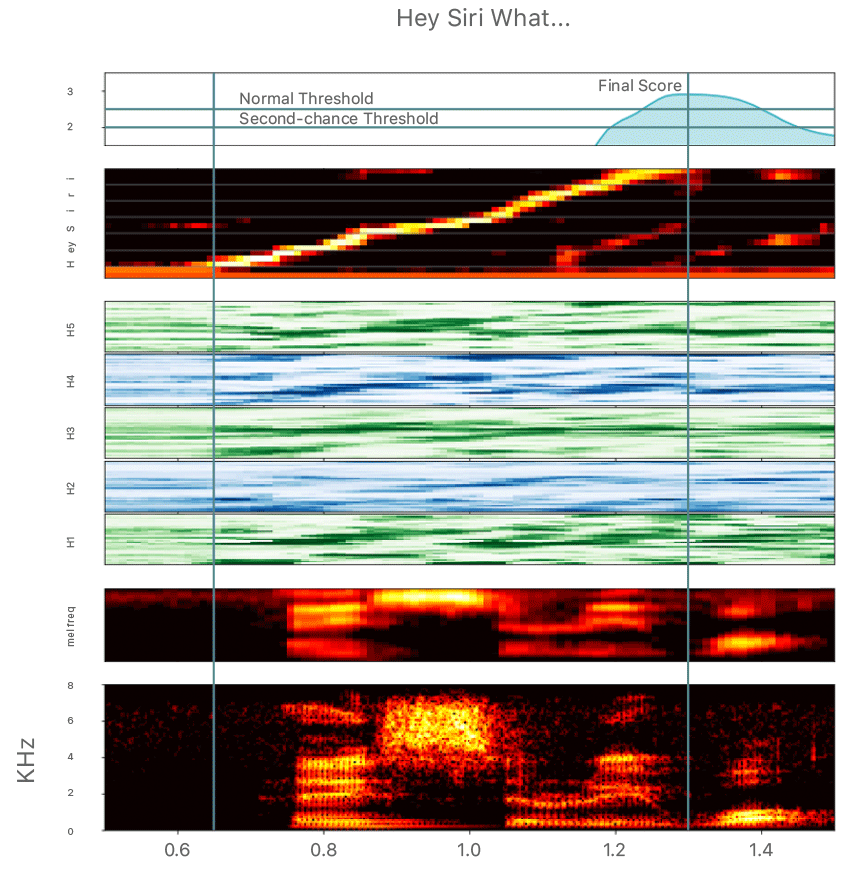

Seit Siri 2014 in die Sprachweckfunktion von „Hey, Siri“ eingestiegen ist, sind die Weckworte quasi an den Sprachassistenten gebunden – jedes Mal, wenn wir mit dem Sprachassistenten sprechen, müssen wir uns die Mühe machen, seinen Namen zu rufen : Siri, Xiao Ai, Xiao Bu , Xiaoyi… Wenn die Sprachumgebung sehr laut ist, kann dieser peinliche Vorgang viele Male wiederholt werden.

▲ Das Stimmabdruckbild zur Erkennung des Weckwortes stammt von: Apple

Denn aus Stromverbrauchsgründen kann der Prozessor des Mobiltelefons keine Rechenleistung verschwenden, um lange Zeit im Hintergrund jeden Satz des Benutzers zu parsen, was derzeit ein Sprachempfänger mit geringem Stromverbrauch ist, der nur Weckwörter erkennt dauerhaft arbeiten müssen.

Wenn das Weckwortsignal empfangen wird, wird der Hauptprozessor mobilisiert, um auf die nächste Anweisung des Benutzers zu hören.

Obwohl dies eine energiesparende Sprachaufweckung erreichen kann, ist es immer noch ein wenig weit von der idealen Form von KI-Assistenten in Science-Fiction-Filmen entfernt. Es ist, als würde Iron Man vor dem Kampf „Hey, Jarvis“ sagen. Die Computerinteraktion ist etwas umständlich.

Googles „Shortcut Commands“-Funktion der Pixel 6-Serie bringt diese natürliche Interaktion, die in Science-Fiction-Filmen existiert, in die Realität.

Wie am Anfang des Artikels erwähnt, können Nutzer den Google Assistant auch aufwecken, um bestimmte Aufgaben wie das Ausschalten des Weckers und das Annehmen von Anrufen auszuführen, ohne Weckwörter wie „OK Google“ durch die „Shortcut-Anweisungen“ zu rufen.

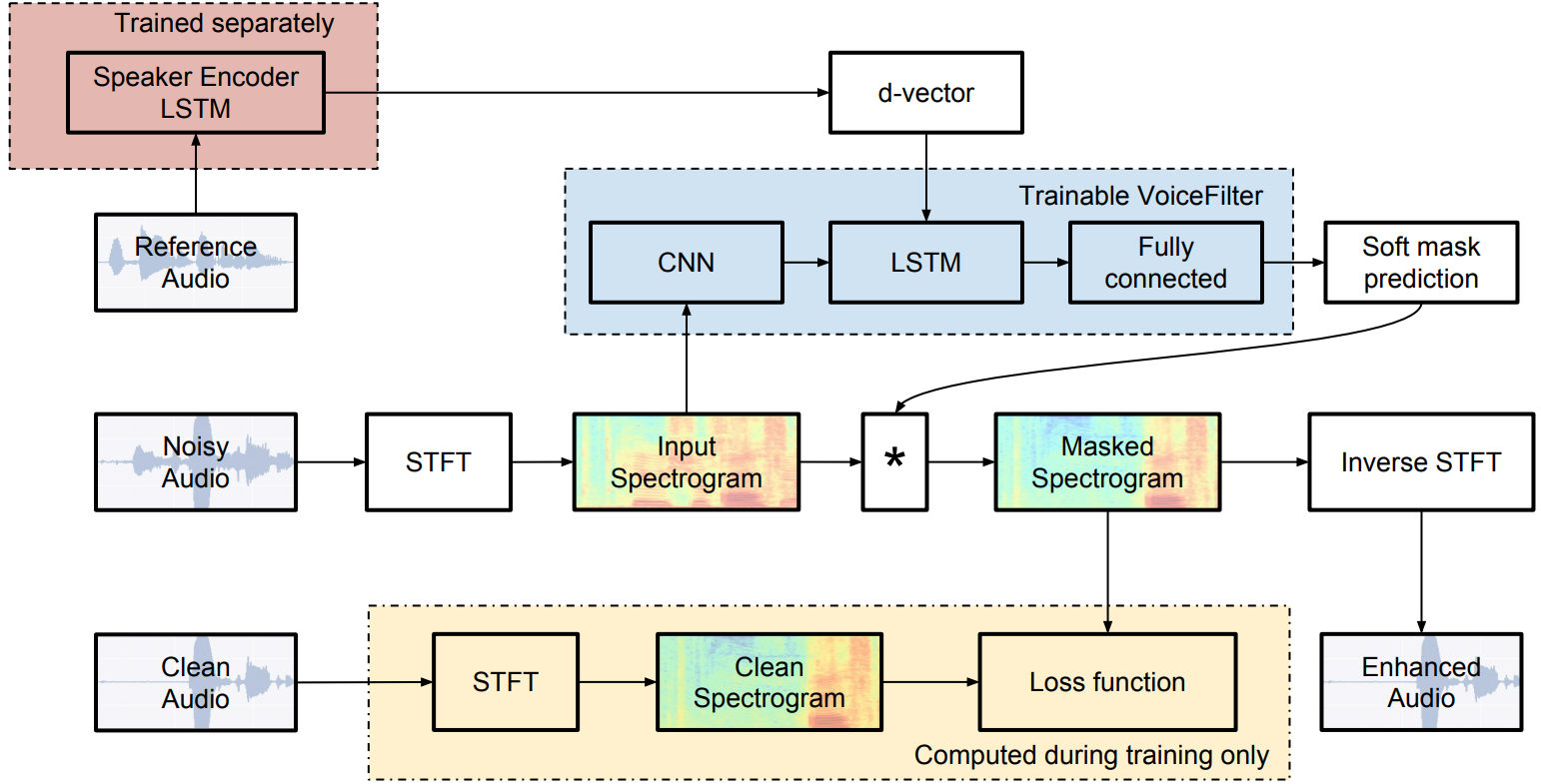

▲ Von Google vorgeschlagener VoiceFilter-Algorithmus Bild von: Google

Um menschliche Stimmen in einer lauten Umgebung richtungsmäßig zu trennen, müssen Mobiltelefone über hochpräzise Stimmabdruck-Erkennungsfunktionen verfügen und komplexere Faltungs-Neuronalnetzalgorithmen verwenden, um das Passwort des Benutzers genau zu erfassen und zu erkennen.

Und Googles TPU-Chip, der speziell für KI-Computing entwickelt wurde, erfüllt gerade diesen KI-Rechenleistungsbedarf, und diese natürliche Sprachinteraktion wird endlich auf der Pixel 6-Serie realisiert.

Die auf der neuronalen Verarbeitungseinheit basierende NPU ist bei der Bild- und Spracherkennung und -verarbeitung viel effizienter als die traditionelle CPU.Mobiltelefonhersteller können daher viele Funktionen wie computergestützte Fotografie und Texterkennung entwickeln, um die Softwarefunktionen des Systems zu bereichern.

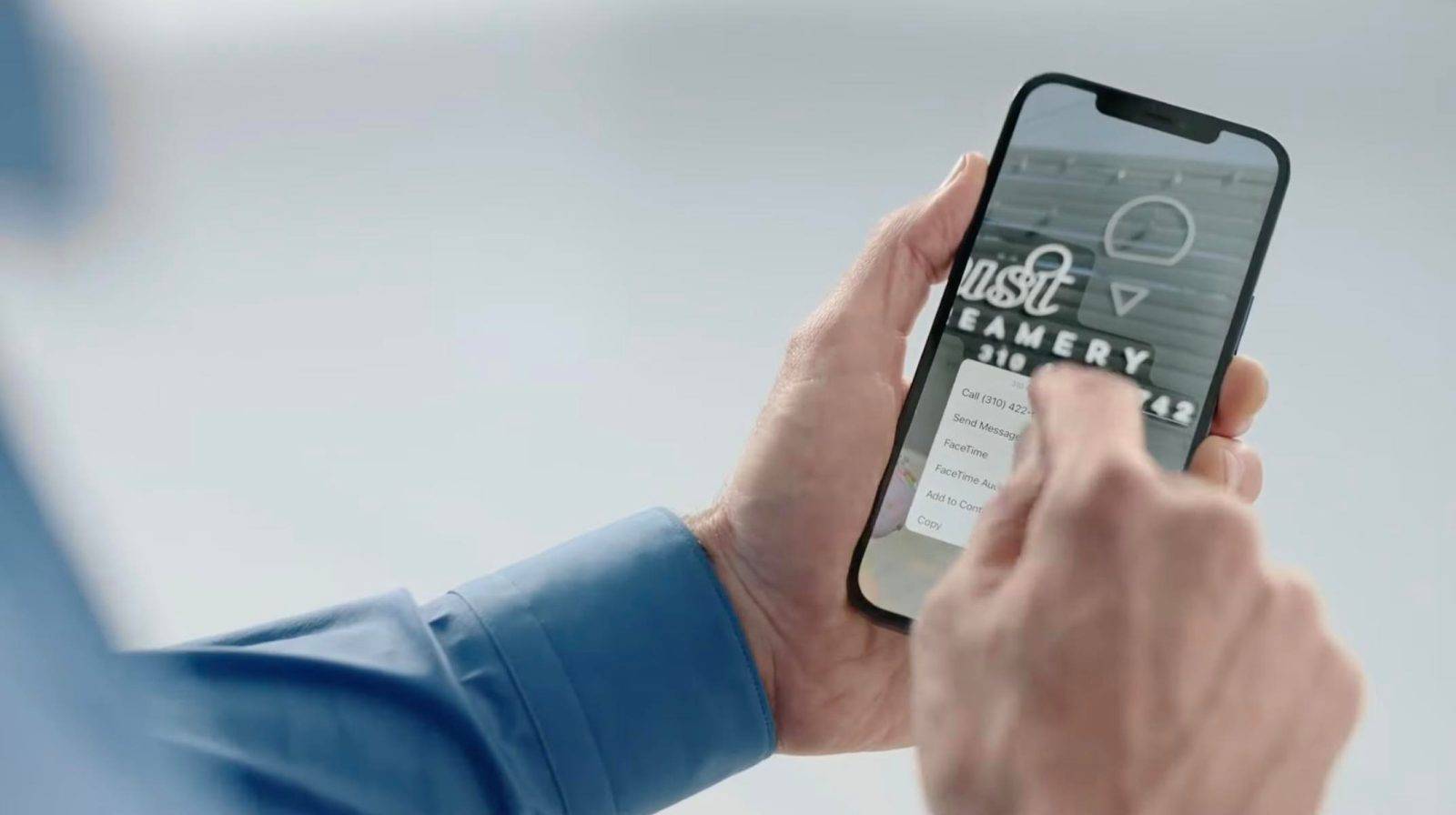

Auf Apples neuestem iOS15 wurden viele neue Funktionen auf der Grundlage von neuronalen Computing-Engines entwickelt, wie z. B. räumliches Audio und Porträtmodus zu FaceTime hinzugefügt, Textextraktion und -übersetzung in Echtzeit, Fotoalben zur direkten Suche nach Text in Fotos, Siri-Offline-Betrieb usw .

Da diese Funktionen gewisse Anforderungen an die KI-Rechenleistung haben, betont Apple auch, dass wenn der SoC-Chip kein späteres Modell des A12 Bionic ist, diese Funktionen selbst bei einem Upgrade auf iOS15 nicht erlebbar sind.

Ein weiteres Beispiel ist die intelligente Identifizierung von ID-Fotos auf MIUI13, das Hinzufügen von Wasserzeichen, der Schutz der Privatsphäre durch Gesichtsverifizierung und andere Funktionen.Die Raumgesten und die Kopfdrehung von HarmonyOS werden ebenfalls mit Technologien wie KI-Bilderkennung und Text-OCR entwickelt.

KI-Funktionen sind zu einem wichtigen Bestandteil unserer täglichen Mobiltelefonerfahrung geworden, und die NPU, die ursprünglich als unbedeutend angesehen wurde, ist zu einem integralen Bestandteil der Systemsoftwareerfahrung geworden.

Warum braucht man KI-Rechenchips?

Verglichen mit anderen Teilen von Mobiltelefonen erschien NPU viel später.

Im September 2017 stellte Huawei auf der IFA in Berlin mit dem Kirin 970 das erste SoC mit integrierter NPU vor, Apple veröffentlichte im gleichen Zeitraum den ersten A11-Bionic-Chip mit Neural-Computing-Engine, beide Lager achteten darauf überraschend synchron zum Bereich des KI-Computing.

Das Aufkommen von KI-Funktionen mag abrupt erscheinen, ist aber tatsächlich das Ergebnis der natürlichen Evolution während der Entwicklung von Smartphone-Formen.

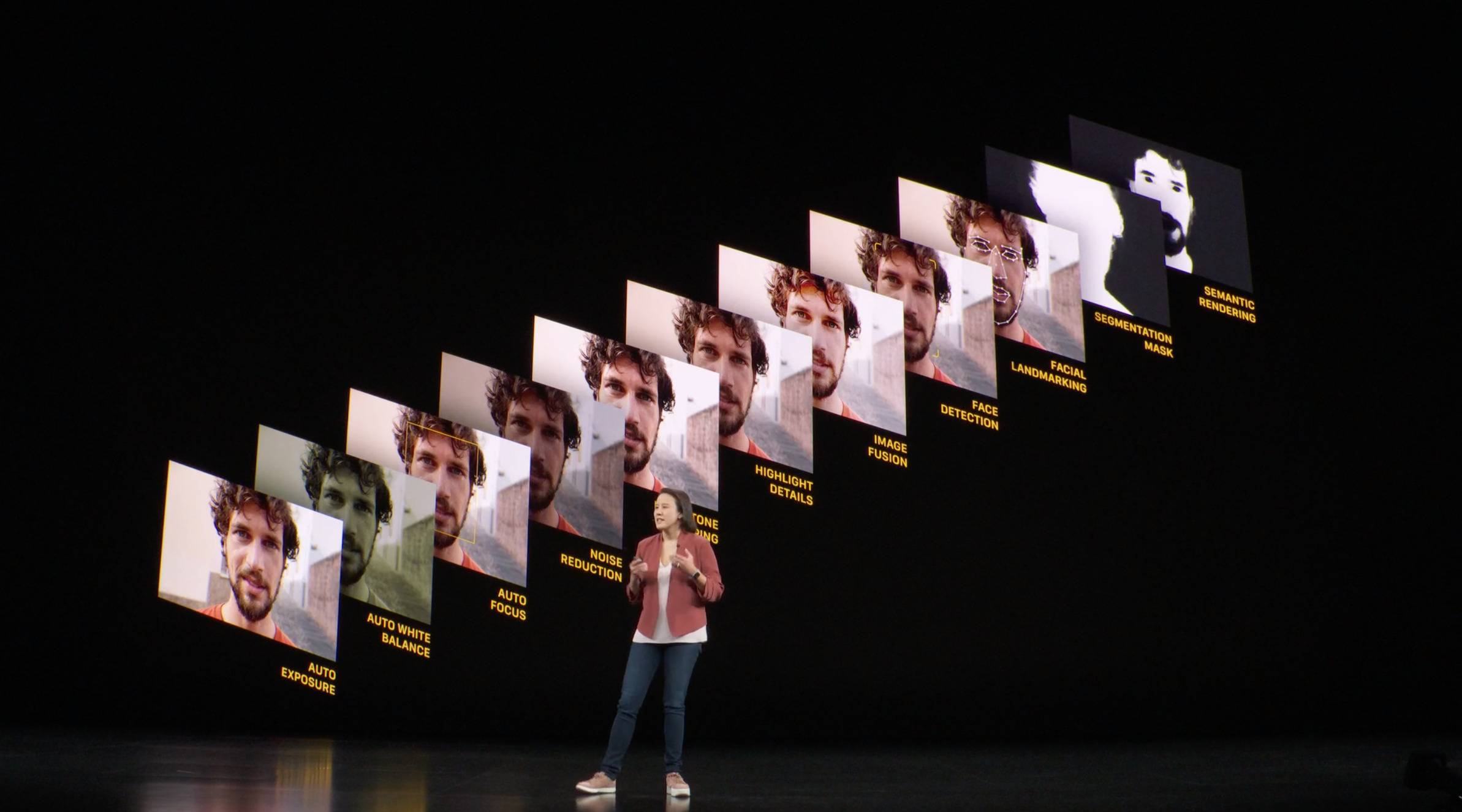

In einem Interview mit Apple VP Tim Millet über die Chips der A-Serie erwähnte das Magazin Wired, dass einige Apple-Ingenieure einige Jahre vor der Veröffentlichung des iPhone X vorschlugen, maschinelle Lernalgorithmen zu verwenden, um die Kamera des iPhone intelligenter zu machen.

Es ist diese Idee, die das iPhone X, das die Form des iPhones im nächsten Jahrzehnt definiert, möglich macht. Der Umstieg auf das Vollbild-iPhone X erfordert einen neuen Sicherheitsmechanismus, der die Touch-ID ersetzt, die ursprünglich das Kinn belegt, und der in Bezug auf Genauigkeit und Entsperrgeschwindigkeit nicht hinter ersterem zurückstehen kann.Um diese Punkte zu erreichen, wandte sich Apple dem 3D-strukturierten Lichtgesicht zu Erkennung.

Jedes Mal, wenn das iPhone zum Entsperren eingeschaltet wird, erstellt die Tiefensensorkamera im Pony eine Tiefenkarte durch Tausende von Punkten, die mit den gespeicherten Gesichtsdaten verglichen werden, um das Entsperren und diesen Prozess der Erfassung und Erstellung abzuschließen und das Korrekturlesen müssen kontrolliert werden, und vor allem muss der Stromverbrauch im Handumdrehen auf einem ausreichend niedrigen Niveau gehalten werden.

Laut von Apple veröffentlichten Daten entsperren iPhone-Nutzer durchschnittlich 80 Mal am Tag.Wenn die CPU oder GPU bei jedem Entsperren mobilisiert werden muss, um leistungsstarke Grafikoperationen auszuführen, stellt dies eine erhebliche Herausforderung für die Akkulaufzeit dar das Telefon.

▲ Der Prozess des maschinellen Lernens

Die neuronale Computing-Engine mit Multi-Core-Architektur kann eine große Anzahl von Operationen gleichzeitig ausführen und durch tiefes maschinelles Lernen menschliche Gesichtsinformationen wie das menschliche Gehirn erkennen und beurteilen.Die Verwendung zur Realisierung der Gesichtserkennung hat einen unterschiedlichen Stromverbrauch und Leistung als herkömmliche CPUs kleiner Vorteil.

„Ohne eine neuronale Computer-Engine hätten wir das nicht geschafft“, sagte Tim Millet in dem Interview.

Mit der Erhöhung der Anzahl der Kerne wird auch die Rechenleistung der Neural Computing Engine stark verbessert und ihre Anwendungen werden immer umfangreicher.

Beispielsweise bringt die 8-Kern-Neural-Computing-Engine des A13-Bionic-Chips Deep Fusion- und Nachtszenenmodus-Funktionen in die iPhone11-Serie, die die Klarheit und Details von Fotos durch mehrere Fusionen verbessern; Rufen Sie mehrere Kameras gleichzeitig auf, um eine reibungsloses Zoom-Erlebnis.

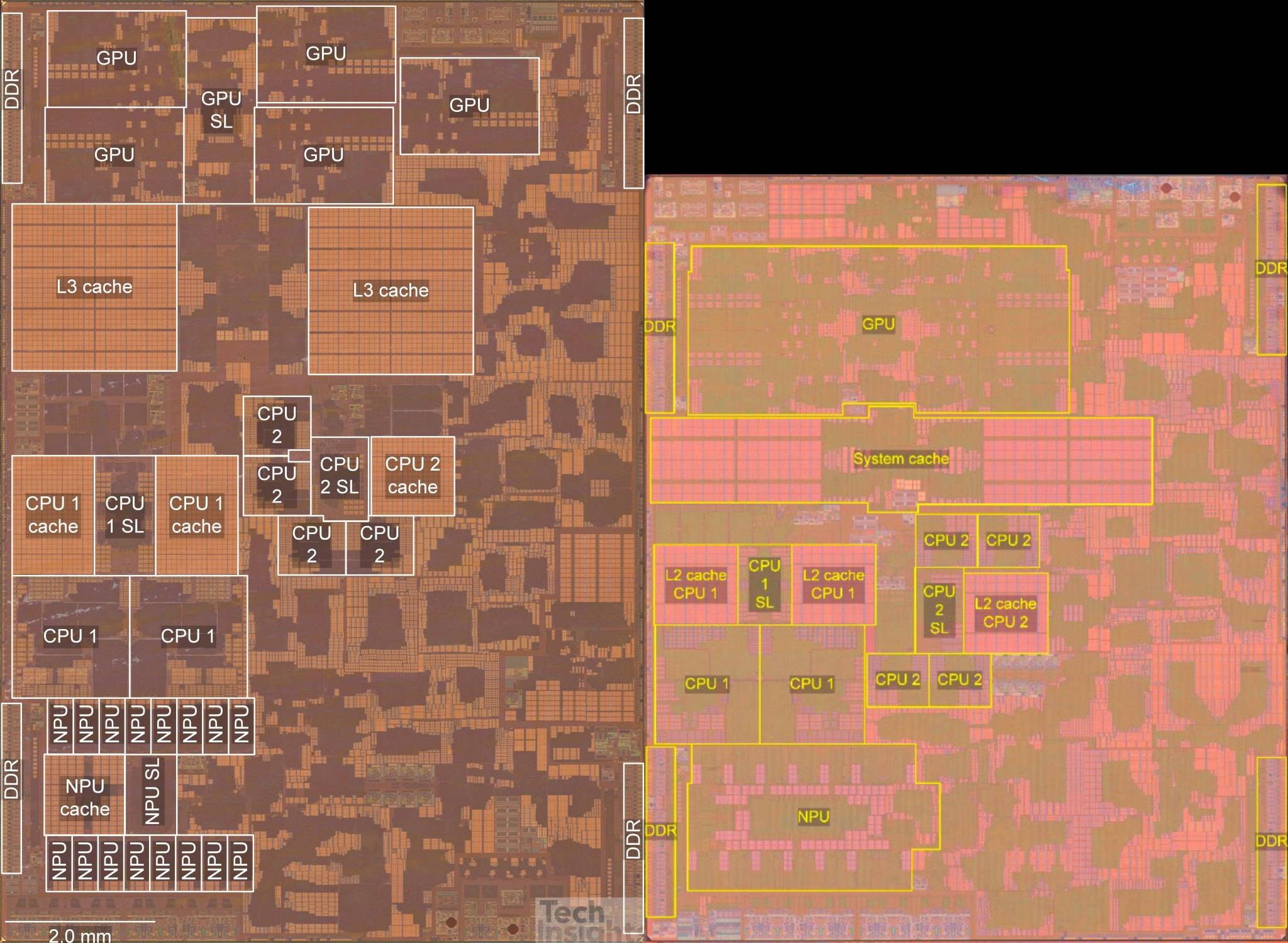

▲ Anatomie des bionischen A15-Chips und des bionischen A14-Chips, die neuronale Rechenmaschine ist in der unteren linken Ecke konzentriert

Im Allgemeinen kann das Aufkommen von NPUs wie Neural Computing Engines den Rechendruck von CPU oder GPU gut teilen. Durch effiziente parallele Analyse und Berechnung von Big Data können aussagekräftige Ergebnisse extrahiert und eine natürlichere Verarbeitung verwendet werden. Fähigkeit zur Verbesserung unsere Erfahrung.

KI wird Smartphones neu definieren

John Giannandrea, Senior Vice President of Machine Learning and Artificial Intelligence Strategy bei Apple, erwähnte in einem Interview, dass er glaubt, dass in den nächsten Jahren alle Funktionen von iOS oder Apples Software-Ökosystem durch maschinelles Lernen verändert werden.

Ich denke, Apple hat schon immer die Schnittstelle zwischen Kreativität und Technologie repräsentiert. Wenn Sie darüber nachdenken, intelligente Erfahrungen zu erstellen, ist es wirklich wichtig, Apps, Frameworks, Chips vertikal zu integrieren … Ich denke, es ist eine Reise, dies ist die Zukunft der Computergeräte, die wir haben, sie werden intelligent, und dann wird diese Intelligenz unsichtbar sein .

Das ursprüngliche iPhone hat das Mobiltelefon mit Touchscreen-Interaktion und der Verbindung zum Internet immer und überall neu definiert.Seitdem hat sich das Mobiltelefon zu einem Zweig von „Feature Phone“ und „Smart Phone“ entwickelt.

Wenn die Funktionen von Smartphones zusammenlaufen, kehren die sogenannten „Smart“-Funktionen – WeChat senden, Musik abspielen, Fotos machen, Nachrichten ansehen usw. – in gewissem Sinne zurück.

▲ Bild von: Gadgetmatch

Smartphones müssen neu definiert werden, und neue Intelligenz sollte als Mobiltelefon interpretiert werden, das „Menschen versteht". Es kann die Welt, die Sie sehen, verstehen, jeden Ihrer Befehle verstehen und sich dynamisch an die Umgebung anpassen. All dies erfordert KI-Chips. Erhalten stark involviert.

Da die Hardware-Lieferkette von Mobiltelefonen immer transparenter wird, werden die Unterschiede in den Kernkomponenten von Mid- bis High-End-Mobiltelefonen immer kleiner und Softwarefunktionen erhalten immer mehr Aufmerksamkeit von den Herstellern Die Hardware-Lieferkette bietet eine gute Möglichkeit, die „Grundzutaten“ von Gerichten zuzubereiten, und wenn Sie einen einzigartigen Geschmack zubereiten möchten, ist eine hervorragende Software-Erfahrung der Schlüssel zum „Würzen“.

Heute haben wir bereits einen ausreichend klaren Bildschirm und eine Kamera, die Landschaften aus 100 Metern Entfernung aufnehmen kann, aber die Erfahrung von Smartphones beschränkt sich nicht auf herkömmliche Anzeige und Fotografie.

![]()

Es sollte Ihnen ermöglichen, Fotos mit mehreren Brennweiten gleichzeitig aufzunehmen, damit Sie die Landschaft nicht verpassen, indem Sie zum Fokussieren eilen; es sollte in der Lage sein, eine Vorschau der Nachtszene oder des HDR-Effekts in Echtzeit im Sucher anzuzeigen, und nein länger auf die Bildgebung warten; es sollte sogar ein Übersetzer werden, der Sie auf Reisen begleiten kann, selbst wenn das Netzwerk schlecht ist, kann er Offline-Übersetzungsarbeiten in Echtzeit erledigen.

KI ist die beste Wahl, um uns bei der Realisierung dieser Funktionen zu helfen.Um Softwarefunktionen stärker anzupassen, haben mehr Mobiltelefonhersteller wie Google und OPPO damit begonnen, sich am Design von NPU-Chips zu beteiligen, um zu den Vorreitern wie Apple und aufzuschließen Huawei.

Gleichzeitig ist starke KI-Rechenleistung nicht mehr das Patent von selbst entwickelten Chipplayern: Qualcomm Snapdragon 8 und Dimensity 9000 sehen beide die KI-Rechenleistung im Fokus der Verbesserung und haben Googles Tensor in der KI-Leistung in Laufpunkten übertroffen Der kürzlich veröffentlichte Exynos 2200 konzentriert sich auch auf die Verbesserung der NPU-Leistung und bringt die doppelte Verbesserung.

Die konzentrierten Anstrengungen der Chipgiganten in Sachen KI-Leistung lassen mobile KI-Chips so aussehen, als würden sie das „neue Moore’sche Gesetz“ erleben.

Neben der Geschwindigkeit des Leistungswachstums ist auch die Popularität von KI-Chips sehr beeindruckend: Laut der Statistik der Statistikagentur Counterpoint machte die Zahl der Mobiltelefone mit eingebauten KI-Chips im Jahr 2017 nur 3 % des Marktes aus Anteil, und im Jahr 2020 hat diese Zahl 35 % erreicht.

In Zukunft werden mehr Mobiltelefone KI-beschleunigtes Computing unterstützen, was bedeutet, dass der Einsatz von maschinellem Lernen zur Entwicklung mobiler Anwendungen zur neuen Normalität werden wird – in Apps auf nationaler Ebene wie Douyin und WeChat sogar der Einsatz von Maschinen Das Lernen ist bereits erschienen. Realisieren Sie KI-Funktionen wie Hintergrundunschärfe und Ein-Klick-Clipping.

Mit der Beteiligung von Mobiltelefonherstellern und der Entwicklung von Drittanbietern werden sich KI-Anwendungen weiter vertiefen, und auch die Form von Smartphones kann sich entsprechend ändern und zu einer Software-Hardware-Symbiose für ein angenehmes Erlebnis werden.

Dann verlagert sich der Kampf um das Mitspracherecht in Form von Smartphones sukzessive von der Steuerung der Lieferkette hin zur Kontrolle von User Big Data.

#Willkommen beim offiziellen WeChat-Konto von Aifaner: Aifaner (WeChat: ifanr), weitere aufregende Inhalte werden Ihnen so bald wie möglich zur Verfügung gestellt.

Liebe Faner | Ursprünglicher Link · Kommentare anzeigen · Sina Weibo