Die besten Online-Web-Scraping-Tools

Web Scraping ist für verschiedene Analysezwecke nützlich. Dies kann nützlich sein, wenn Sie Online-Umfragen für Ihr Unternehmen durchführen müssen, um Markttrends zu überwachen. Web Scraping erfordert jedoch einige technische Kenntnisse, sodass einige Leute versuchen, dies zu vermeiden.

Mit einigen Web-Scraping-Tools können Sie jetzt die gewünschten Daten in die Hände bekommen, ohne eine einzige Codezeile schreiben oder hochtechnische Prozesse durchlaufen zu müssen.

Schauen wir uns einige Online-Web-Scraper an, mit denen Sie Daten für Ihre Analyseanforderungen erfassen können.

1. Scrapingbot

Scrapingbot ist einer der benutzerfreundlichsten Web-Scraper auf dem Markt. Es enthält auch eine leicht verständliche Dokumentation , die Sie durch die Verwendung des Tools führt.

Scrapingbot bietet eine API (Application Programming Interface) und vorgefertigte Tools zum Scraping von Webseiten. Es ist vielseitig einsetzbar und funktioniert perfekt mit Geschäftsdatenquellen wie Einzelhandels- und Immobilienwebsites.

Das Daten-Scraping-Tool erfordert keine Codierung, da es einen Großteil der Arbeit für Sie erledigt, und gibt das JSON-Format jeder Webseite zurück, die Sie als Roh-HTML scrapen. Die Preise von Scrapingbot sind ebenfalls flexibel. Sie können mit dem kostenlosen Tarif beginnen, bevor Sie ein Upgrade auf ein kostenpflichtiges Abonnement durchführen.

Obwohl der kostenlose Plan nur begrenzte Funktionen und Ressourcen bietet, lohnt es sich dennoch, ihn auszuprobieren, wenn Ihr Budget niedrig ist oder Sie sich die kostenpflichtigen Optionen nicht leisten können. Denken Sie daran, dass die Anzahl der gleichzeitigen Anfragen, die Sie pro Kratzer mit anderen technischen Supportleistungen stellen müssen, mit sinkendem Preis abnimmt.

Um eine Website mit Scrapingbot zu kratzen, müssen Sie lediglich die URL der Zielwebsite angeben. Wenn Sie die Codeversion Ihrer Anfrage erhalten möchten, unterstützt Scrapingbot auch verschiedene Programmiersprachen. Es hat auch eine Schnittstelle, die die Codeversion Ihrer Anfrage in verschiedenen Sprachformaten zurückgibt.

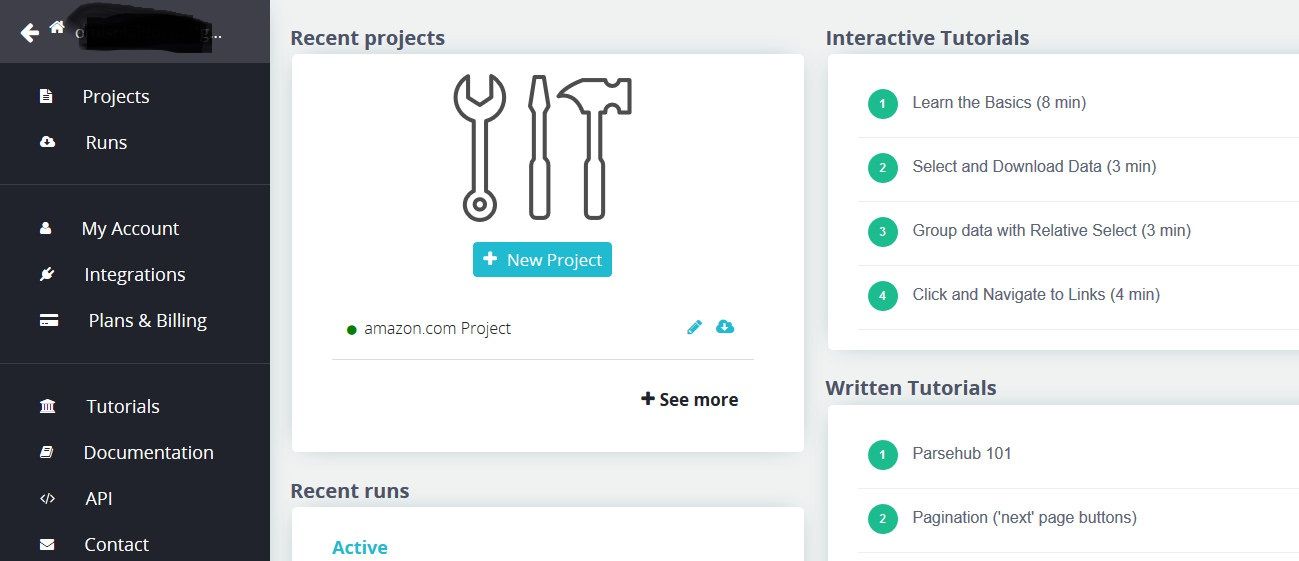

2. Parsehub

Im Gegensatz zu Scrapingbot ist Parsehub eine Desktop-App, mit der Sie jedoch eine Verbindung zu jeder Website herstellen können, von der Sie Daten extrahieren möchten.

Mit einer schlanken Oberfläche können Sie entweder eine Verbindung zur Parsehub REST-API herstellen oder die extrahierten Daten als JSON-, CSV-, Excel-Dateien oder Google Sheets exportieren. Sie können den Datenexport auch planen, wenn Sie möchten.

Der Einstieg in Parsehub ist ganz einfach. Das Extrahieren von Daten erfordert nur geringe oder keine technischen Kenntnisse. Das Tool verfügt außerdem über detaillierte Tutorials und Dokumente , die die Verwendung vereinfachen. Wenn Sie jemals die REST-API verwenden möchten, verfügt sie auch über eine detaillierte API-Dokumentation .

Wenn Sie die Ausgabedaten nicht direkt auf Ihrem PC speichern möchten, können Sie mit den dynamischen Cloud-basierten Funktionen von Parsehub Ihre Ausgabedaten auf dem Server speichern und jederzeit abrufen. Das Tool extrahiert auch Daten von Websites, die asynchron mit AJAX und JavaScript geladen werden.

Obwohl es eine kostenlose Option bietet, bietet Parsehub andere kostenpflichtige Optionen, mit denen Sie das Beste daraus machen können. Die kostenlose Option eignet sich zunächst hervorragend, aber wenn Sie bezahlen, können Sie Daten mit weniger Anforderungen pro Extraktion schneller kratzen.

3. Dexi.io

Dexi verfügt über eine einfache Oberfläche, mit der Sie mithilfe der integrierten Technologie für maschinelles Lernen, den so genannten digitalen Erfassungsrobotern, Echtzeitdaten von jeder Webseite extrahieren können.

Mit Dexi können Sie sowohl Text- als auch Bilddaten extrahieren. Mit seinen Cloud-basierten Lösungen können Sie Scraped-Daten auf Plattformen wie Google Sheets, Amazon S3 und mehr exportieren.

Dexi extrahiert nicht nur Daten, sondern bietet auch Echtzeit-Überwachungstools, mit denen Sie über Änderungen der Aktivitäten der Wettbewerber auf dem Laufenden gehalten werden.

Obwohl Dexi eine kostenlose Version hat, mit der Sie kleinere Projekte ausführen können, erhalten Sie nicht Zugriff auf alle Funktionen. Die kostenpflichtige Version von 105 bis 699 US-Dollar pro Monat bietet Ihnen Zugriff auf viele Premium-Supportleistungen.

Wie bei anderen Online-Web-Scrapern müssen Sie Dexi lediglich die Ziel-URL bereitstellen und gleichzeitig einen sogenannten Extraktionsroboter erstellen.

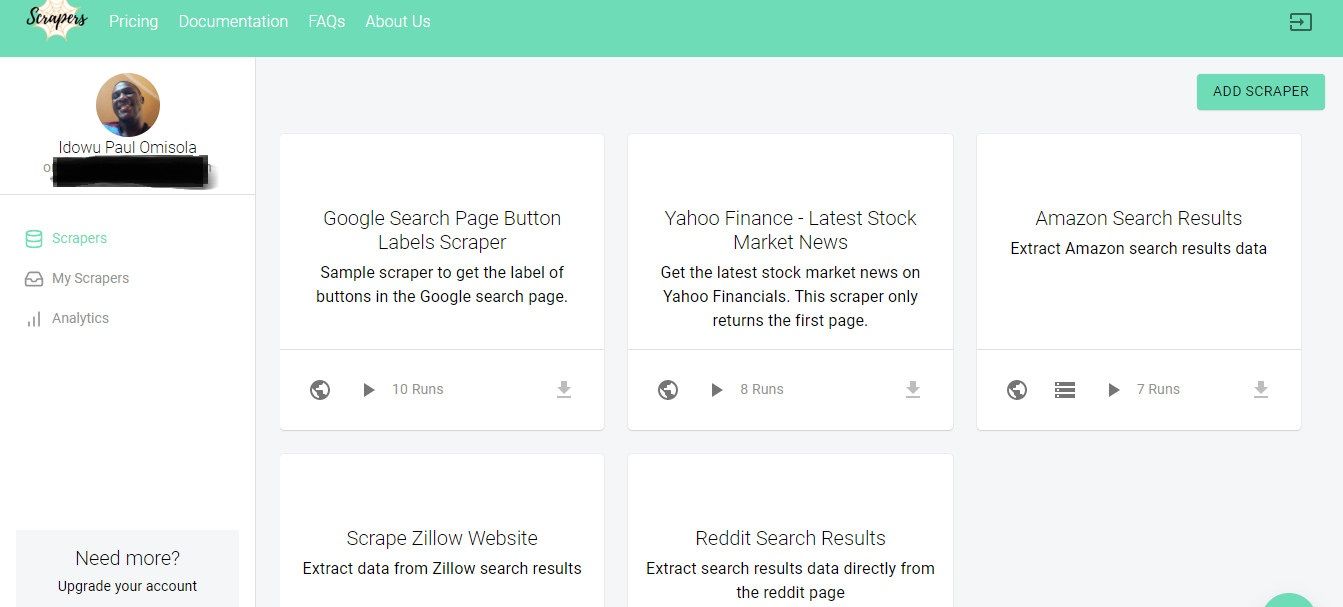

4. Schaber

Scrapers ist ein webbasiertes Tool zum Extrahieren von Webseiteninhalten. Die Verwendung von Schabern ist einfach und erfordert keine Codierung. Die Dokumentation ist auch kurz und leicht verständlich.

Das Tool bietet jedoch eine kostenlose API, mit der Programmierer wiederverwendbare und Open-Source-Web-Scraper erstellen können. Während diese Option erfordert, dass Sie einige Felder ausfüllen oder den integrierten Texteditor verwenden, um einen vorgenerierten Codeblock zu vervollständigen, ist die Verwendung dennoch recht einfach und unkompliziert.

Die Daten, die Sie mit Scrapers extrahieren, sind als JSON-, HTML- oder CSV-Dateien verfügbar. Obwohl die kostenlose Option nur begrenzte Web-Scraper bietet, können Sie dies dennoch umgehen, indem Sie Ihren Scraper mit seiner API erstellen.

Die bezahlten Optionen kosten nur 30 US-Dollar pro Monat. Im Gegensatz zum kostenlosen Plan beschränkt jedoch keine der kostenpflichtigen Optionen die Anzahl der Websites, die Sie durchsuchen können. Sie können sogar die von anderen Personen erstellten Schaber verwenden, wenn Sie ein Mitgliedschaftsabonnement haben.

Das Tool bietet eine schnelle Benutzererfahrung und eine erstklassige Benutzeroberfläche. Außerdem werden Ihre Ausgabedaten asynchron geladen und im Format Ihrer Wahl auf Ihren PC heruntergeladen.

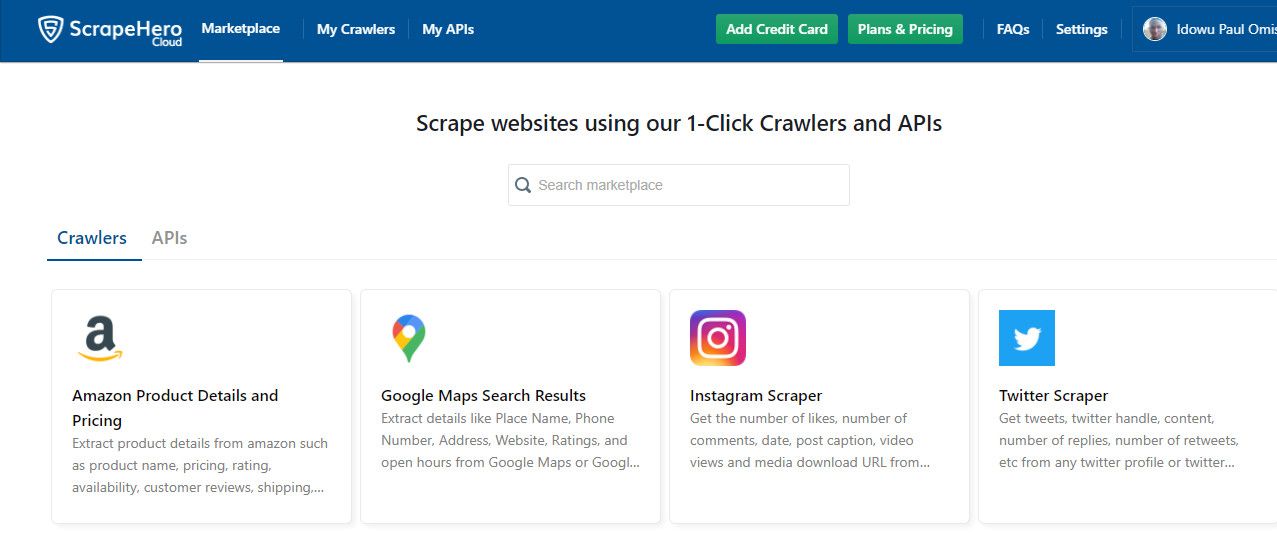

5. ScrapeHero

Wenn Sie Daten von sozialen Plattformen und Online-Einzelhandelsgeschäften erhalten möchten, ist ScrapeHero eine ausgezeichnete Wahl.

Es verfügt über spezielle Tools zum Scraping von Daten, um Daten von Social-Media-Plattformen wie Instagram und Twitter sowie von Einzelhandels- und Geschäftsstellen wie Amazon und Google Reviews abzurufen.

Das Tool verfügt über einen eigenen Marktplatz, auf dem Sie eine Plattform auswählen können, die Sie kratzen möchten. Wie bei anderen erwähnten Web-Scrapern benötigen Sie keine Codierungskenntnisse, um ScraperHero verwenden zu können.

Im Gegensatz zu Paserhub ist ScraperHero zu 100 Prozent webbasiert, sodass Sie keine dedizierten Apps auf Ihrem PC installieren müssen, um es zu verwenden. ScraperHero reagiert sehr schnell und gibt Datenelemente mit wenigen Klicks schnell zurück.

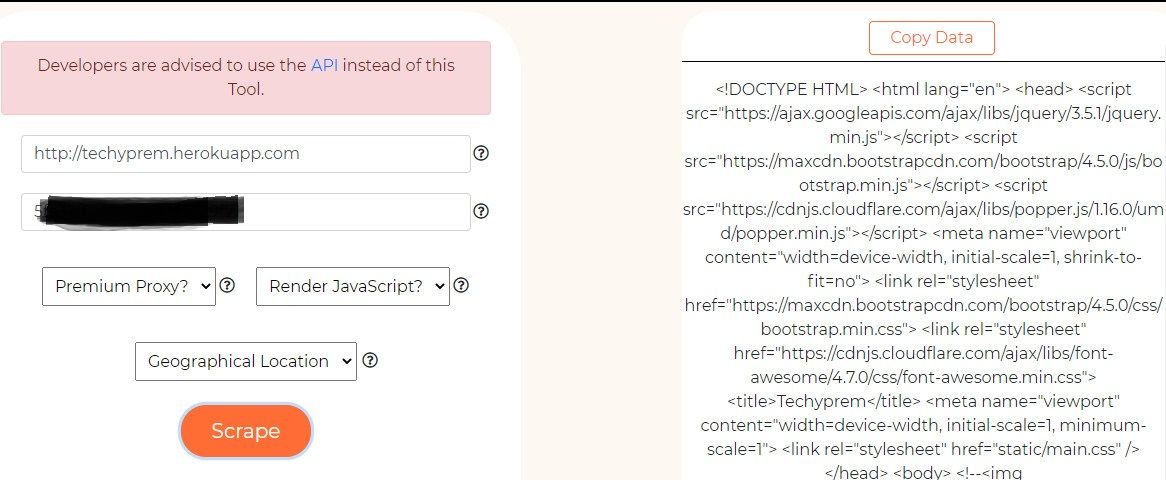

6. Scrapingdog

Scrapingdog ist ein webbasiertes Tool zum Scraping der Elemente einer Website zusammen mit ihrem Inhalt. Der integrierte Scraper gibt die Daten einer Webseite als Roh-HTML zurück.

Das Tool bietet eine API, die eine strukturiertere Ausgabe Ihrer Daten ermöglicht. Die Verwendung der API-Option erfordert jedoch einige Programmierkenntnisse. Mit dem integrierten Scraper können Sie jedoch die Verwendung der API-Option vermeiden.

Scrapingdog unterstützt auch das asynchrone Laden beim Crawlen und Scraping des Inhalts einer Website. Um den Web-Scraper zu verwenden, müssen Sie lediglich die URL der Website angeben, die Sie scrapen möchten, um deren Inhalt zu erhalten.

Scrapingdog bietet auch einen Premium-Proxy, mit dem Sie auf Websites zugreifen können, die schwieriger zu kratzen sind, ohne blockiert zu werden. Die Preise für Scrapingdog liegen nach einer 30-tägigen kostenlosen Testversion zwischen 20 und 200 US-Dollar pro Monat.

Kombinieren Sie diese Web Scraping Tools mit anderen Techniken

Die Verwendung von Online-Web-Scrapern erleichtert das Leben, wenn Sie keine Codes schreiben möchten. Wenn Sie Daten für geschäftliche Zwecke verwenden, kann die Verwendung dieser Tools eine intelligente Möglichkeit sein, einen Wettbewerbsvorteil gegenüber anderen Unternehmen zu erzielen, wenn Sie sich mit diesen auskennen.

Diese Online-Web-Scraper können Ihnen die wesentlichen Informationen liefern, die Sie benötigen. Wenn Sie sie jedoch mit anderen Tools kombinieren, haben Sie mehr Kontrolle über die Art der Daten, die Sie scrappen möchten.