Bombenanschlag bis spät in die Nacht! Nvidia bringt den leistungsstärksten KI-Chip der Welt auf den Markt, dessen Leistung um das 30-fache steigt. Lao Huang ist der Steve Jobs dieser Ära

Gerade hat NVIDIA den weltweit leistungsstärksten KI-Chip herausgebracht.

Die generative KI hat einen Wendepunkt erreicht.

Die zweistündige GTC 2024-Konferenz glich eher einem großen Konzert. Jim Fan, ein leitender Wissenschaftler bei NVIDIA, scherzte: „Jensen Huang ist der neue Taylor Swift.“

Dies ist wahrscheinlich die aktuelle Position von Nvidias Jen-Hsun Huang in der KI-Branche.

Letztes Jahr verkündete Huang Renxun, dass der „iPhone-Moment“ der KI gekommen sei und es uns ermögliche, zu sehen, wie das tägliche Leben durch die KI neu geschrieben werde, und heute zeigt sich, dass die Geschwindigkeit dieser Veränderung wahnsinnig zunimmt.

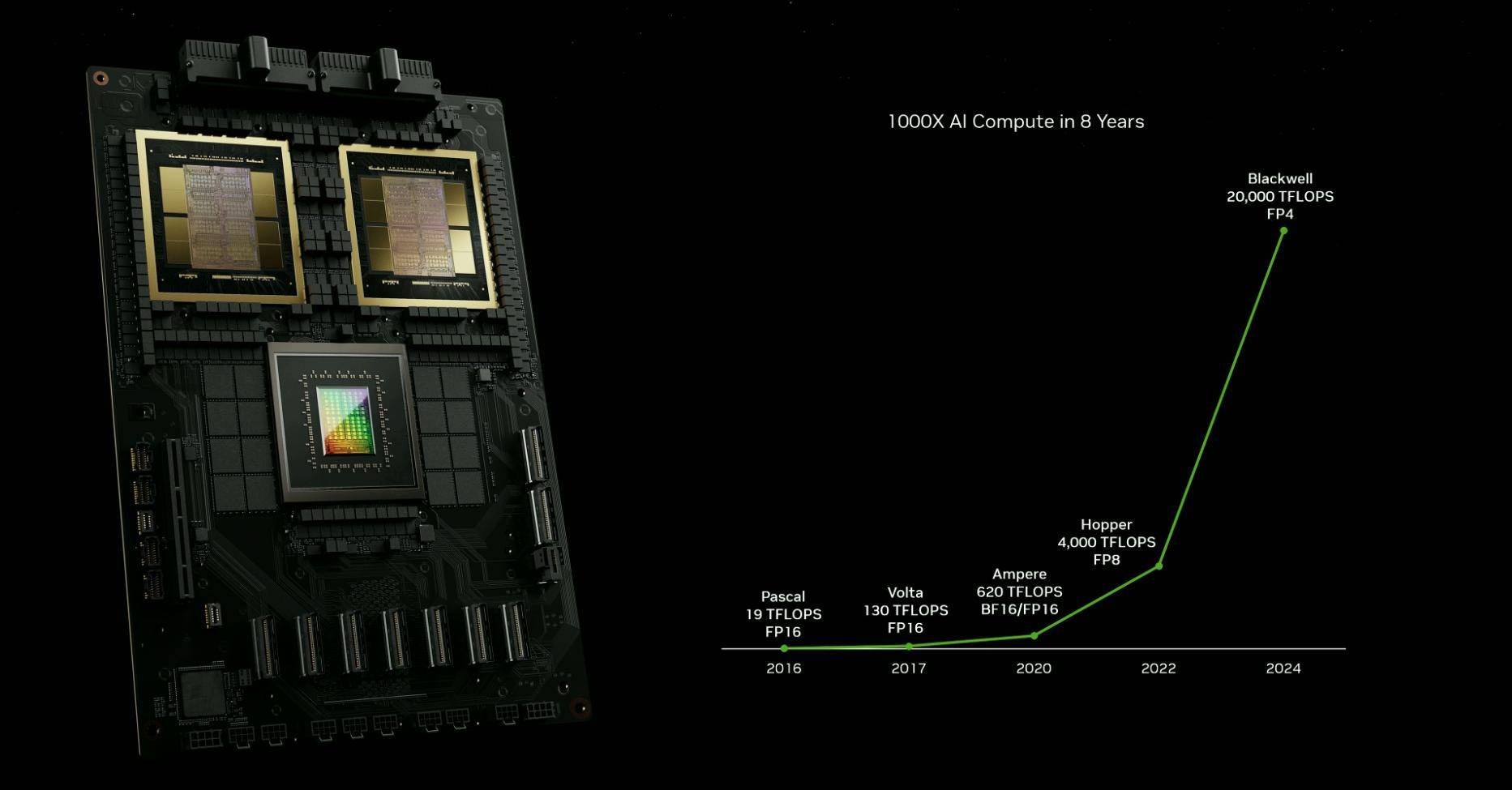

In den letzten 10 Jahren hat NVIDIA die KI etwa eine Million Mal weiterentwickelt und damit das Mooresche Gesetz weit übertroffen. Mit anderen Worten: NVIDIA schreibt sein eigenes Iterationsgesetz. Von der Chip-Rechenleistung bis zur KI-Implementierung, vom Automobilbau bis zur medizinischen Logistik hat NVIDIA die Entwicklung verschiedener Branchen vorangetrieben und gleichzeitig eigene Fortschritte gemacht.

Das Mooresche Gesetz ist tot, aber NVIDIA hat ein neues Mooresches Gesetz hervorgebracht.

Mit Ausnahme von Computergrafikkarten wird NVIDIA in normalen Zeiten von uns selten wahrgenommen, aber der technologische Fortschritt vieler Produkte um uns herum ist immer untrennbar mit ihnen verbunden. Nachdem Sie diese erste Zusammenfassung der GTC 2024 gelesen haben, können Sie vielleicht eine klarere Wahrnehmung davon bekommen Welle von AIGC.

Ein Tweet, den OpenAI-CEO Sam Altman gestern Abend auf X gesendet hat, könnte eine Fußnote der Zeit sein:

Dies ist das interessanteste Jahr in der Geschichte der Menschheit, abgesehen von allen kommenden Jahren

Dies war das interessanteste Jahr in der Geschichte der Menschheit, aber es wird das langweiligste Jahr in der Zukunft sein.

Der leistungsstärkste KI-Chip der Welt ist geboren und seine Leistung schießt in die Höhe

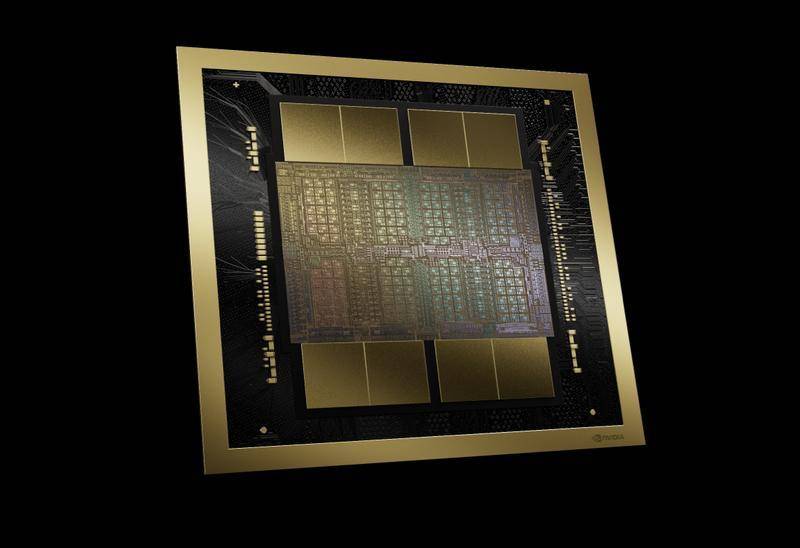

Dies ist die fortschrittlichste GPU, die derzeit weltweit produziert wird.

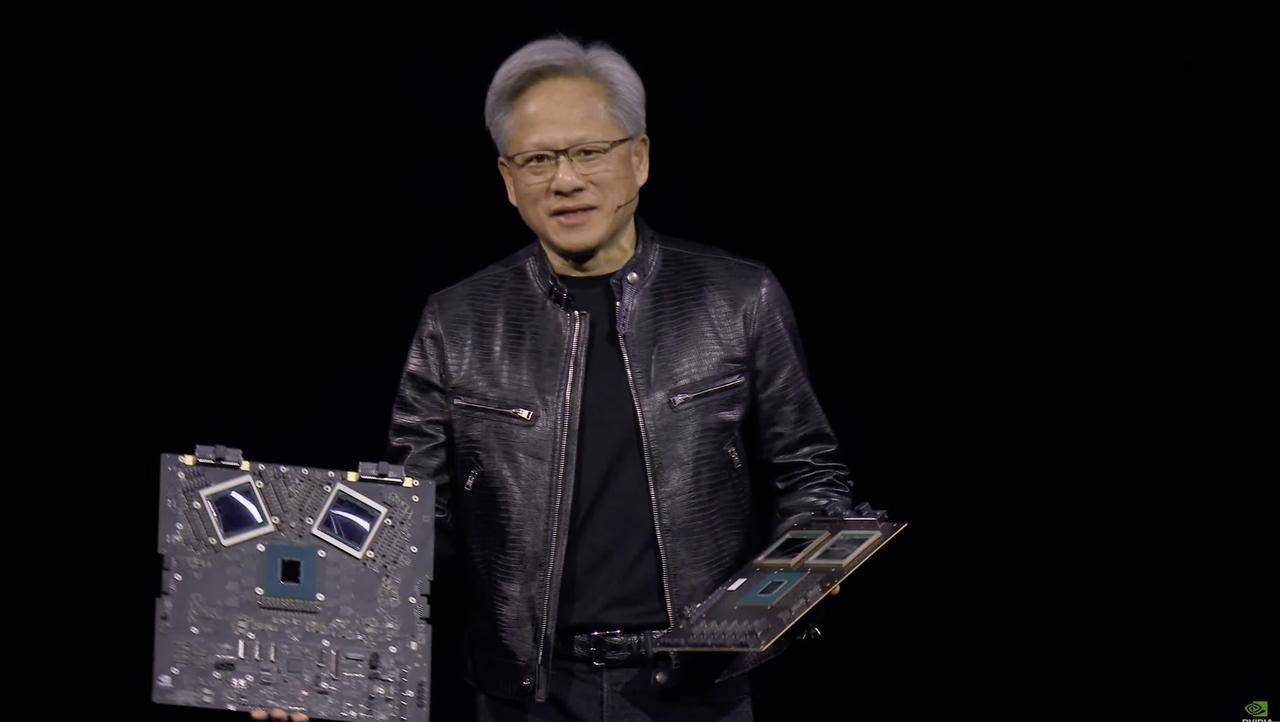

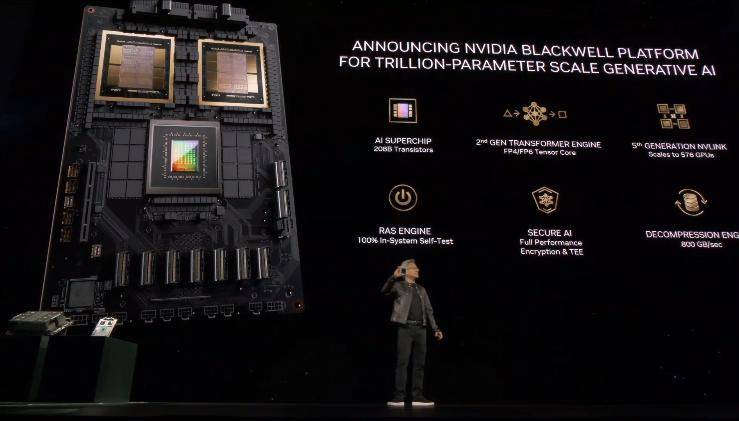

Der Protagonist der Konferenz ist der KI-Chip „Blackwell B200“. Huang Renxun sagte, dass der Name dieses Chips vom Mathematiker, Spieltheoretiker und Wahrscheinlichkeitstheoretiker David Blackwell stammt.

Basierend auf dem 4NP-Prozess von TSMC verfügt der Rechenchip der Blackwell-Architektur über 104 Milliarden Transistoren, was einen weiteren Durchbruch im Vergleich zu den 80 Milliarden Transistoren der GH100-GPU der vorherigen Generation darstellt.

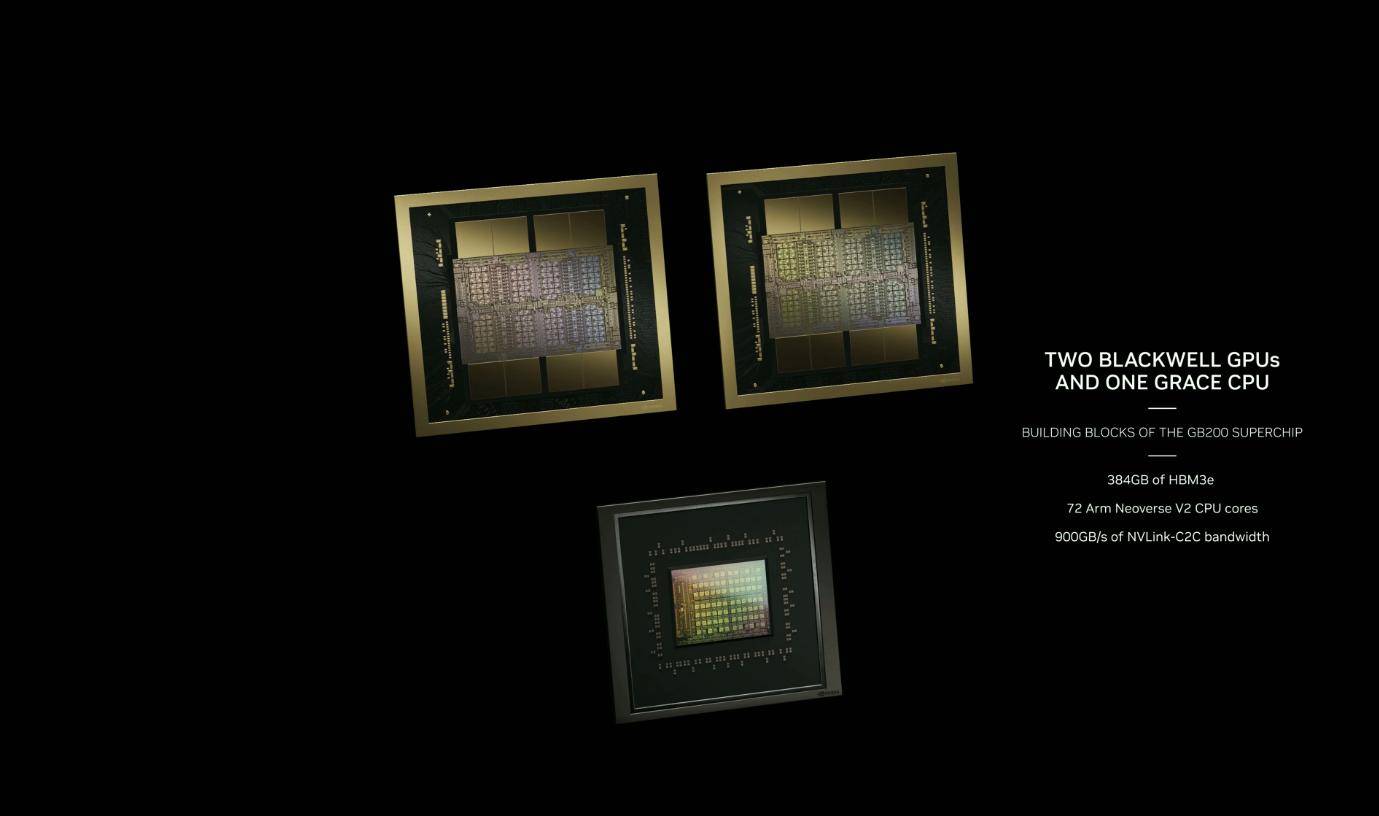

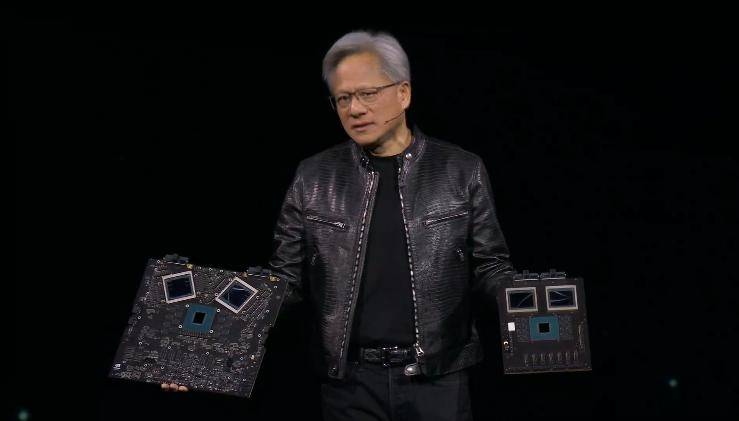

Der Blackwell B200 ist keine einzelne GPU im herkömmlichen Sinne. Er besteht aus zwei Blackwell-GPUs + einem Grace-CPU-Chip und ist über 10 TB/s NV-HBI (Nvidia High Bandwidth Interface) verbunden, um sicherzustellen, dass jeder Chip alleine laufen kann .

Daher verfügt der B200 tatsächlich über 208 Milliarden Transistoren und kann bis zu 20 Petaflops FP4-Rechenleistung bereitstellen. Die beiden GPUs in Kombination mit einer einzigen Grace-CPU können die Arbeit der LLM-Inferenz (Large Language Model) um das 30-fache steigern. Effizienz.

Auch die Leistung von GB200 wird erheblich verbessert. Im GPT-3 LLM-Benchmark mit 175 Milliarden Parametern ist die Leistung von GB200 siebenmal so hoch wie die von H100 und seine Trainingsgeschwindigkeit viermal so hoch wie die von H100.

Darüber hinaus werden Kosten und Energieverbrauch im Vergleich zum H100 um das 25-fache gesenkt.

Obwohl der KI-Prozessor H100 von NVIDIA sehr beliebt war, lag der Spitzenstromverbrauch jedes H100 früher bei bis zu 700 Watt und übertraf damit den durchschnittlichen Stromverbrauch normaler amerikanischer Haushalte. Experten gehen davon aus, dass die Gesamtleistung bei einer großen Anzahl von H100-Prozessoren sinkt Der Verbrauch wird so hoch sein wie eine große amerikanische Stadt, die mit einigen kleinen europäischen Ländern vergleichbar oder sogar größer ist.

Huang Renxun sagte, dass das Training eines Modells mit 1,8 Billionen Parametern früher 8.000 Hopper-GPUs und 15 Megawatt Leistung erforderte. Jetzt können dies 2.000 Blackwell-GPUs mit nur 4 Megawatt Stromverbrauch leisten.

Die starke Leistung der Blackwell B200 GPU spiegelt sich auch perfekt im Energieverbrauch wider. Der B200, der die neueste NVLink-Verbindungstechnologie nutzt, unterstützt die gleiche 8GPU-Architektur und 400-GbE-Netzwerk-Switches. Während seine Leistung erheblich verbessert wurde, kann er den gleichen Spitzenenergieverbrauch (700 W) wie die Vorgängergeneration H100/H200 erreichen.

Ein weiterer erwähnenswerter Punkt ist die Rechenleistung von FP4. Huang Renxun sagte, dass sich die KI-Rechenleistung in den letzten acht Jahren um das Tausendfache erhöht habe. Die wichtigste Verbesserung sei die Transformer-Engine der zweiten Generation, die durch die FP4-Rechenleistung die Rechenleistung, die Bandbreite und die Modellgröße erheblich verbessert habe.

Verglichen mit der FP8-Rechenleistung, die üblicherweise in der KI verwendet wird, ist die Leistung der beiden Rechenchips des B200 2,5-mal höher als die des H100. Die Rechenleistung jedes Chips unter der Blackwell-Architektur ist 25 % höher als die des Hopper-Chips der vorherigen Generation.

Der leitende NVIDIA-Wissenschaftler Jim Fan bezeichnet die neue Blackwell B200-GPU als „ein neues Leistungsbiest“.

Die Rechenleistung von B200 übersteigt 1 Exaflop innerhalb einer einzelnen Architektur. Die Leistung des ersten von Jen-Hsun Huang an OpenAI gelieferten DGX beträgt 0,17 Petaflops. Die GPT-4-1.8T-Parameter können innerhalb von 90 Tagen auf 2.000 Blackwell-Einheiten trainiert werden.

Man kann ohne Übertreibung sagen, dass ein neues Mooresches Gesetz geboren wurde.

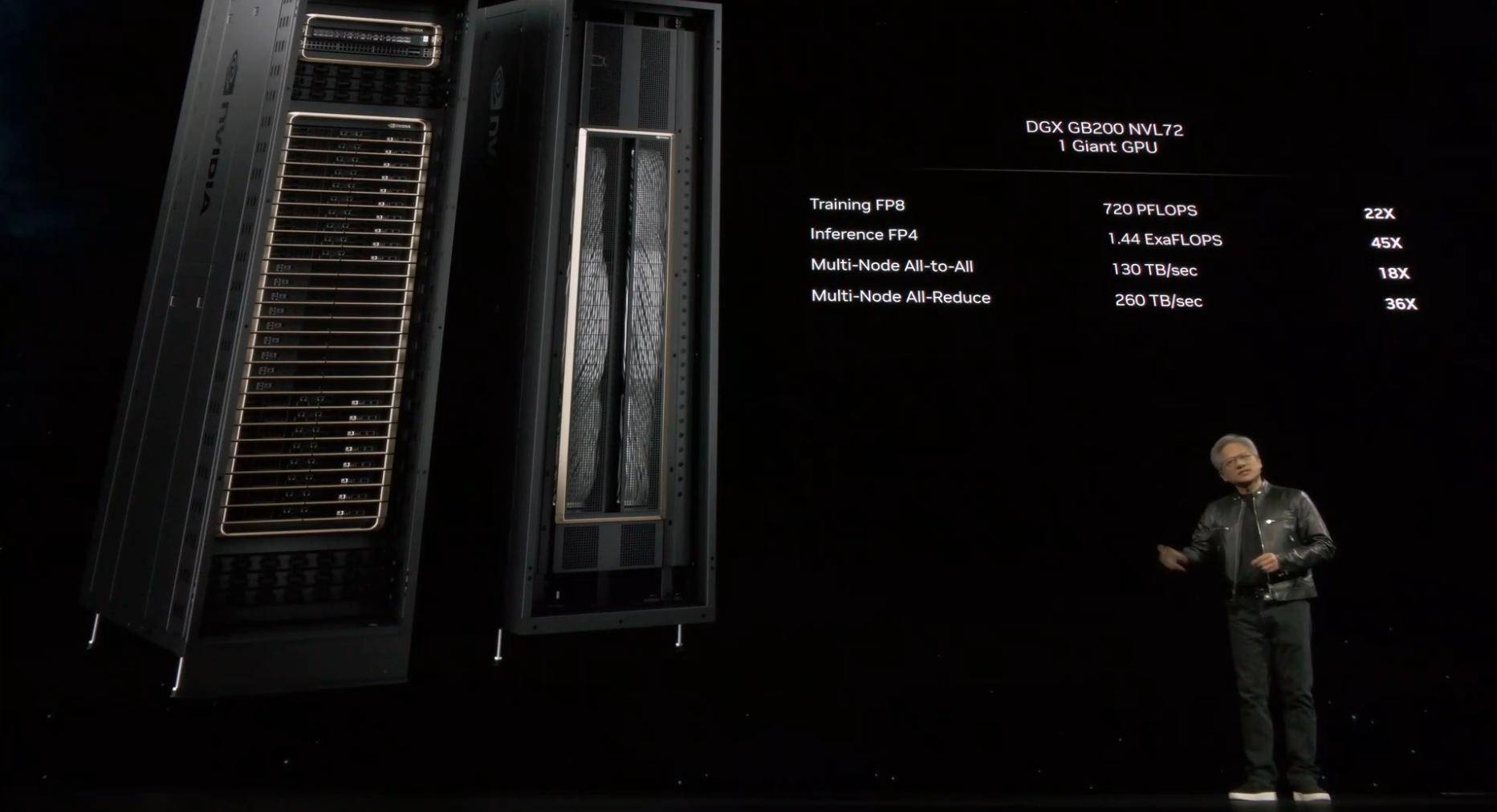

Da Blackwell in mehreren verschiedenen Varianten erhältlich ist, stellt Nvidia auch Spezifikationen für den vollständigen Serverknoten mit drei Hauptoptionen bereit.

Das erste ist das größte und leistungsstärkste GB200 NVL72-System, das mit 18 1U-Servern konfiguriert ist, wobei jeder Server mit zwei GB200-Superchips ausgestattet ist. Das System bietet 72 B200-GPUs mit 1440 Peta FLOPS FP4-KI-Inferenzleistung und 720 Peta FLOPS FP8-KI-Trainingsleistung. Es wird eine Flüssigkeitskühlungslösung übernehmen. Ein NVL72 kann 27 Billionen Parametermodelle (GPT-4) verarbeiten. Der maximale Parameter funktioniert nicht (mehr als 1,7 Billionen Parameter).

Eine weitere Spezifikation ist der HGX B200, der auf der Verwendung von acht B200-GPUs und einer x86-CPU in einem einzelnen Serverknoten basiert. Jede B200-GPU kann mit bis zu 1000 W konfiguriert werden, und die GPU bietet bis zu 18 Petaflops FP4-Durchsatz, was langsamer ist als die GPU im GB200 10 %.

Schließlich wird NVIDIA auch den HGX B100 auf den Markt bringen, der die gleichen allgemeinen Spezifikationen wie der HGX B200 aufweist, mit einer x86-CPU und 8 B100-GPUs ausgestattet ist, aber direkt mit der bestehenden HGX H100-Infrastruktur kompatibel ist und den schnellsten Einsatz von Blackwell-GPUs ermöglicht , jeweils Die TDP der GPU ist auf 700W begrenzt.

Zuvor hat sich Nvidia durch KI-Chips wie H100 und H200 zu einem Multi-Billionen-Dollar-Unternehmen entwickelt und führende Unternehmen wie Amazon überholt. Die heute veröffentlichten neuen Blackwell B200-GPUs und GB200-„Superchips“ sind sehr vielversprechend. Es könnte sich verlängern sein Vorsprung und übertreffen sogar Apple.

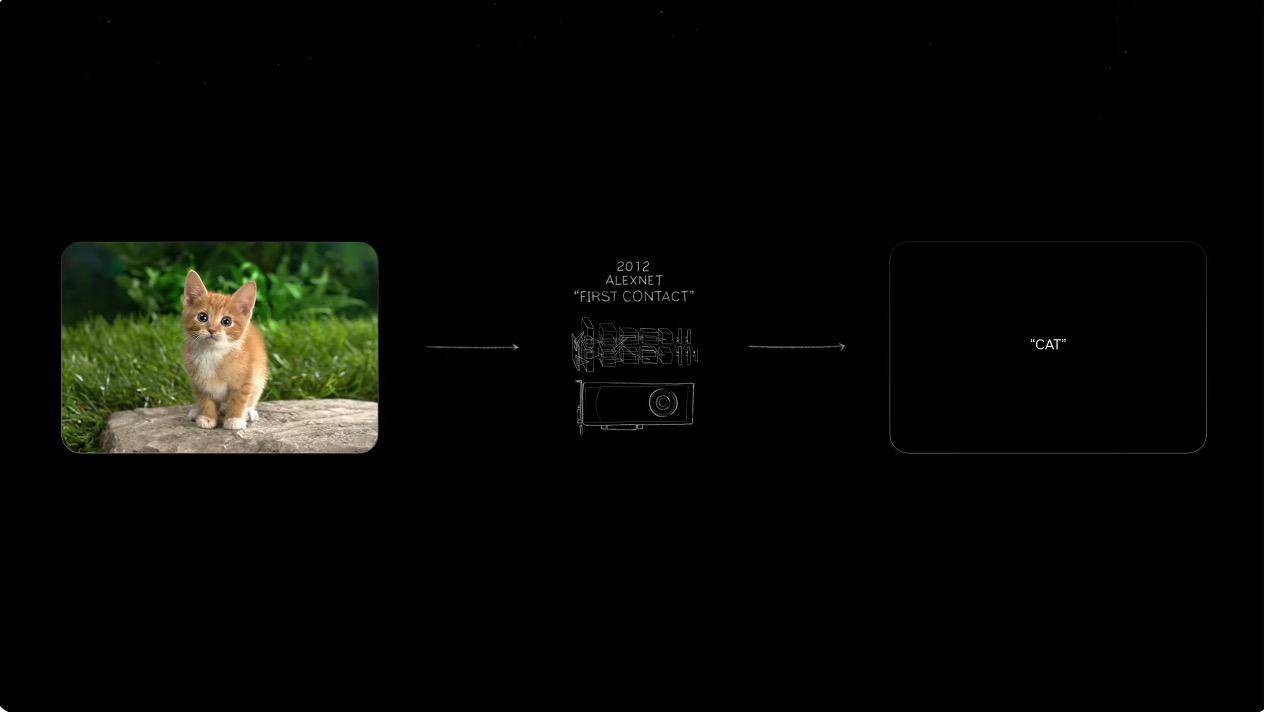

Die Ära der Software, die alles definiert, naht

Im Jahr 2012 veröffentlichte eine kleine Gruppe von Forschern ein bahnbrechendes Bilderkennungssystem namens AlexNet, das damals frühere Methoden zur Klassifizierung von Hunden und Katzen weit übertraf und es zu einem Spitzenreiter im Bereich Deep Learning und Faltungs-Neuronale Netze machte. Eine ikonische Demonstration von das Potenzial von (CNN) in der Bilderkennung.

Gerade nachdem Huang Renxun die Möglichkeiten der KI erkannte, beschloss er, ganz auf KI zu setzen. Interessant ist, dass es in der Vergangenheit dazu diente, generierte Bilder zu erkennen und Text zu generieren, jetzt aber Bilder durch Text generieren soll.

Was können wir also damit machen, wenn die Welle der generativen KI kommt? Jen-Hsun Huang gab einige Standardantworten.

Herkömmliche Wettermodelle können in Kombination mit dem Wettermodell Cordiff von NVIDIA Vorhersagen erstellen, die Gebiete von Hunderten oder sogar Tausenden von Kilometern abdecken und die Reichweite von Auswirkungen wie Taifunen angeben, wodurch Sachschäden minimiert werden. Cordiff wird in Zukunft auch für weitere Länder und Regionen offen sein.

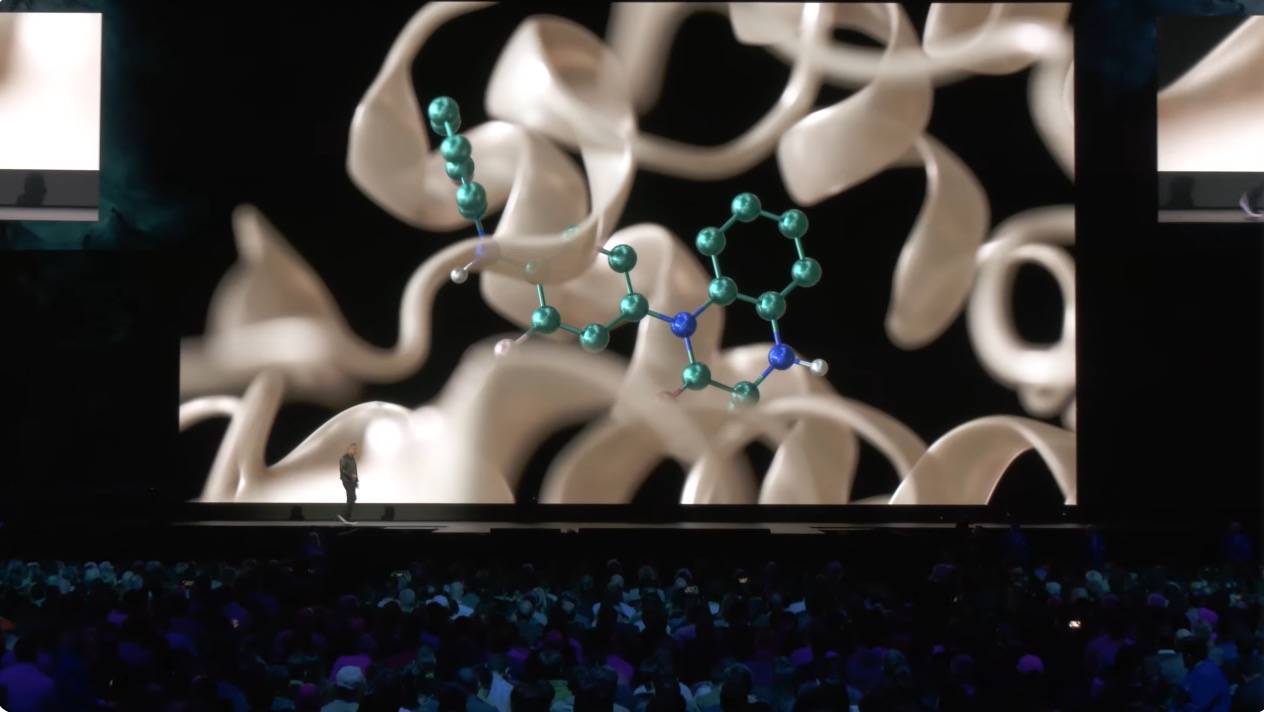

Generative KI kann nicht nur Bilder und Audio durch digitale Fähigkeiten verstehen, sondern kann ihre enorme Rechenleistung auch nutzen, um Milliarden von Verbindungen zu scannen, um neue Medikamente auszusortieren.

Als KI-Waffenhändler führte Huang Renxun auch das NiMS-System ein, das auf die Unterstützung bei der Entwicklung von KI-Chips spezialisiert ist. In Zukunft haben Sie möglicherweise sogar die Möglichkeit, ein KI-Superteam zu bilden. Nachdem Sie die Aufgabe in eine Reihe von Unteraufgaben unterteilt haben, können Sie verschiedene KIs Aufgaben wie das Abrufen und die Softwareoptimierung erledigen lassen.

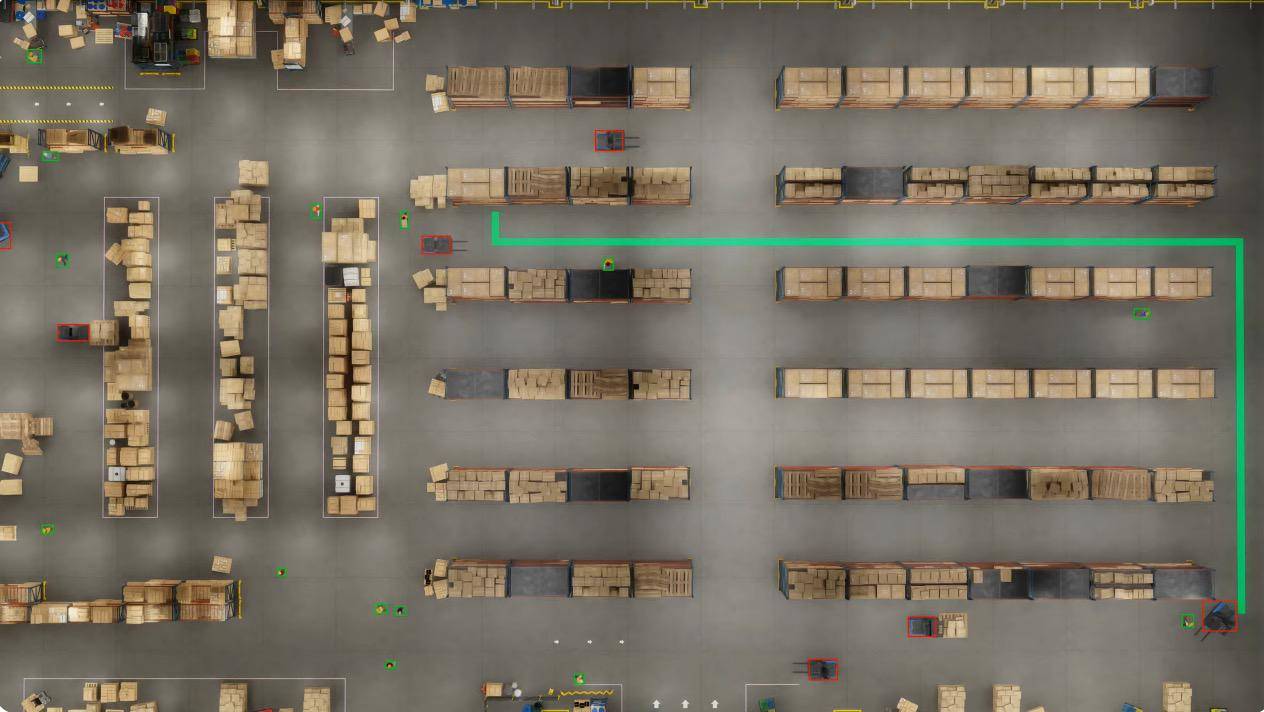

Die Anlagen, Lager und Fabrikgebäude der Zukunft werden softwaredefiniert sein.

Ob humanoide Roboter, selbstfahrende Autos oder manipulierende Arme – diese autonomen Roboter erfordern Betriebssysteme auf Softwareebene. Durch die Kombination von KI und Omniverse baute NVIDIA beispielsweise ein Roboterlager mit einer Fläche von 100.000 Quadratmetern.

In dieser physikalisch genau simulierten Umgebung zeichnen 100 an der Decke montierte Kameras mithilfe der NVIDIA Metropolis-Software und den Routenplanungsfunktionen autonomer mobiler Roboter (AMRs) alle Aktivitäten im Lager in Echtzeit auf.

Diese Simulationen umfassen auch Software-Loop-Tests des KI-Agenten, um die Fähigkeit des Systems zu bewerten und zu optimieren, sich an die Unvorhersehbarkeit der realen Welt anzupassen.

In einem simulierten Szenario war der AMR unterwegs, um eine Palette abzuholen, als er auf einen Zwischenfall stieß, der ihm die geplante Route versperrte. Anschließend aktualisierte Nvidia Metropolis eine Echtzeit-Belegungskarte und sendete sie an das Steuerungssystem, das den neuen optimalen Pfad berechnete.

Lagerbetreiber können dem visuellen Modell auch in natürlicher Sprache Fragen stellen, und das Modell kann Details und Aktivitäten verstehen und sofortiges Feedback geben, um die betriebliche Effizienz zu verbessern.

Erwähnenswert ist, dass auch Apple Vision Pro auf dieser Konferenz vorgestellt wurde. Unternehmen können über Omniverse Cloud problemlos interaktive universelle Szenenbeschreibungen (OpenUSD) von 3D-Anwendungen in Echtzeit an Vision Pro streamen und so Benutzern dabei helfen, virtuelle Welten wie nie zuvor zu erkunden.

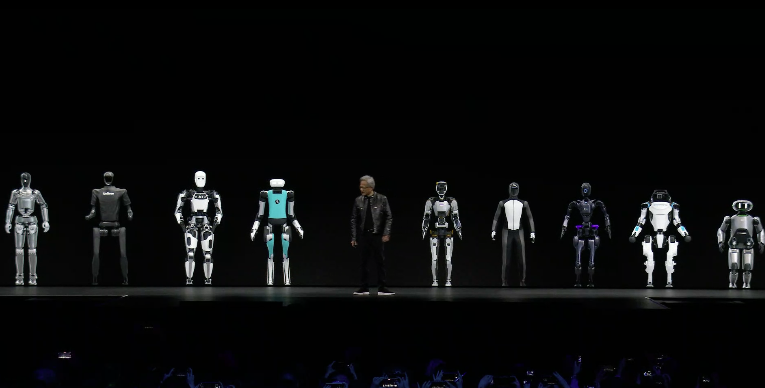

Den Abschluss der Pressekonferenz bildete das vertraute Robotersegment. Wie Huang Renxun sagte, war der Moment, in dem er seine Hände öffnete und zusammen mit anderen humanoiden Robotern stand, zu dieser Zeit „die Schnittstelle zwischen Computergrafik, Physik und künstlicher Intelligenz.“ .. Alles beginnt in diesem Moment.“

▲ Kleines Osterei

Vor zehn Jahren betonte Jen-Hsun Huang bei GTC erstmals die Bedeutung des maschinellen Lernens. Während viele Menschen Nvidia noch als Hersteller von „Spielegrafikkarten“ betrachteten, standen sie bereits an der Spitze der KI-Revolution.

Im Jahr 2024, dem ersten Jahr der KI-Anwendungen, hat NVIDIA bereits KI-Software und -Hardware eingesetzt, um verschiedene Branchen in vielen Bereichen zu stärken: große Sprachmodelle, Konversations-KI, Edge Computing, Big Data, autonomes Fahren, bionische Roboter …

Die Entdeckung von Arzneimitteln ist nicht unser Fachwissen, sondern die Informatik; der Bau von Autos ist nicht unser Fachwissen, sondern die KI-Computer, die zum Bau von Autos benötigt werden. Ehrlich gesagt ist es für ein Unternehmen schwer, in all diesen Dingen gut zu sein, aber wir sind sehr gut im KI-Computing-Teil davon.

Verglichen mit dem Marktführer in einer einzelnen Branche ist NVIDIA eher ein „großer Mann hinter den Kulissen“. Solange KI erwähnt wird, muss NVIDIA ein unvermeidbares Thema sein.

Wie Huang sagte, ist Nvidia bereits ein Plattformunternehmen.

Es war der Vormarsch und der allgemeine Trend der historischen Entwicklung, der es Nvidia zu Beginn der KI-Ära ermöglichte, mehr als 70 % des Umsatzes des KI-Chipmarktes zu erwirtschaften. Auch die Unternehmensbewertung überstieg 2 Billionen US-Dollar nicht vor langer Zeit.

Vielleicht ist dies auch der Grund, warum Apple nach vielen Jahren des Kampfes den Bau von Autos aufgegeben und stark in generative KI investiert hat. Ob es um wirtschaftliche Vorteile oder technologische Trends geht, es ist ein zu hohes Risiko wert.

In einer Zeit, in der wir immer noch den Nutzen von „KI“ in Frage stellen, hat NVIDIA mit Taten bewiesen, dass KI zu einem unverzichtbaren Bestandteil der neuen Ära geworden ist.

Autor: Li Chaofan, Xiao Fanbo, Mo Chongyu

# Willkommen beim offiziellen öffentlichen WeChat-Konto von aifaner: aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner | Ursprünglicher Link · Kommentare anzeigen · Sina Weibo