ChatGPT hat die Prüfungen der Top-Universitäten bestanden, was mehr getan werden sollte als Anti-KI, ist die Prüfungsfragen zu ändern

Als Jurastudenten versuchten, ChatGPT zu spielen, hätten sie nie gedacht, dass es sich umdrehen und ein "Klassenkamerad" werden würde, der dieselbe Prüfung mit ihnen ablegt.

Im vergangenen Januar haben Professor Jon Choi von der School of Law der University of Minnesota und Professor Christian Terwiesch von der Wharton School der University of Pennsylvania ChatGPT gebeten, die Abschlussprüfungsfragen ihrer Kurse zu „erledigen“.

Als Ergebnis hat ChatGPT wirklich bestanden!

Bedeutet das, dass wir ChatGPT noch ein wenig weiterentwickeln lassen und wir in Zukunft keine menschlichen Anwälte und Administratoren mehr brauchen?

Oder ist dies ein Weckruf für Pädagogen, damit aufzuhören, Menschen beizubringen, wie KI zu sein?

Hinter dem Pass: Der Lehrer „ließ das Wasser ab“ und die ganze Klasse war unten

In den beiden getesteten Majors schneidet ChatGPT in der Law School schlechter ab als in der Business School: Ersterer hat eine Durchschnittsnote von C+, letzterer kann B- bis B-Noten erreichen.

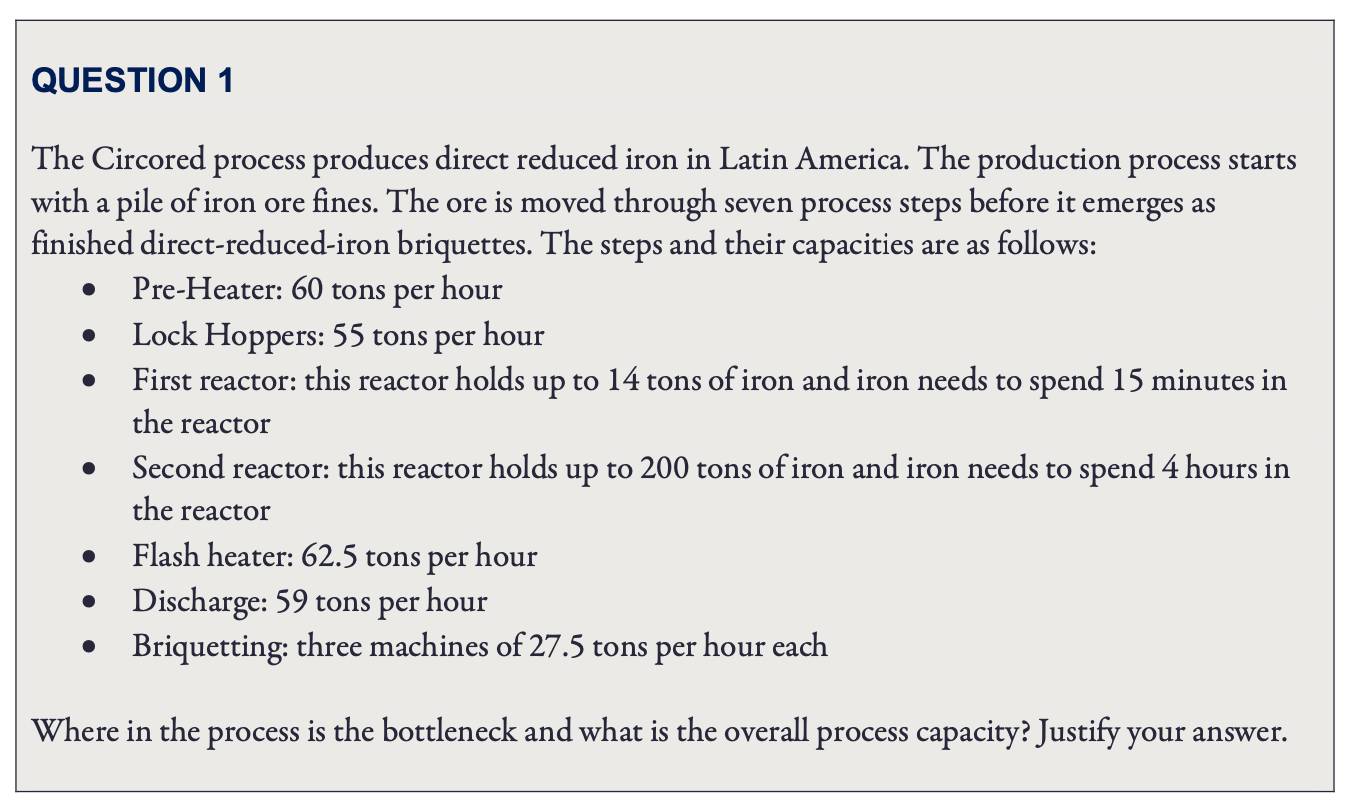

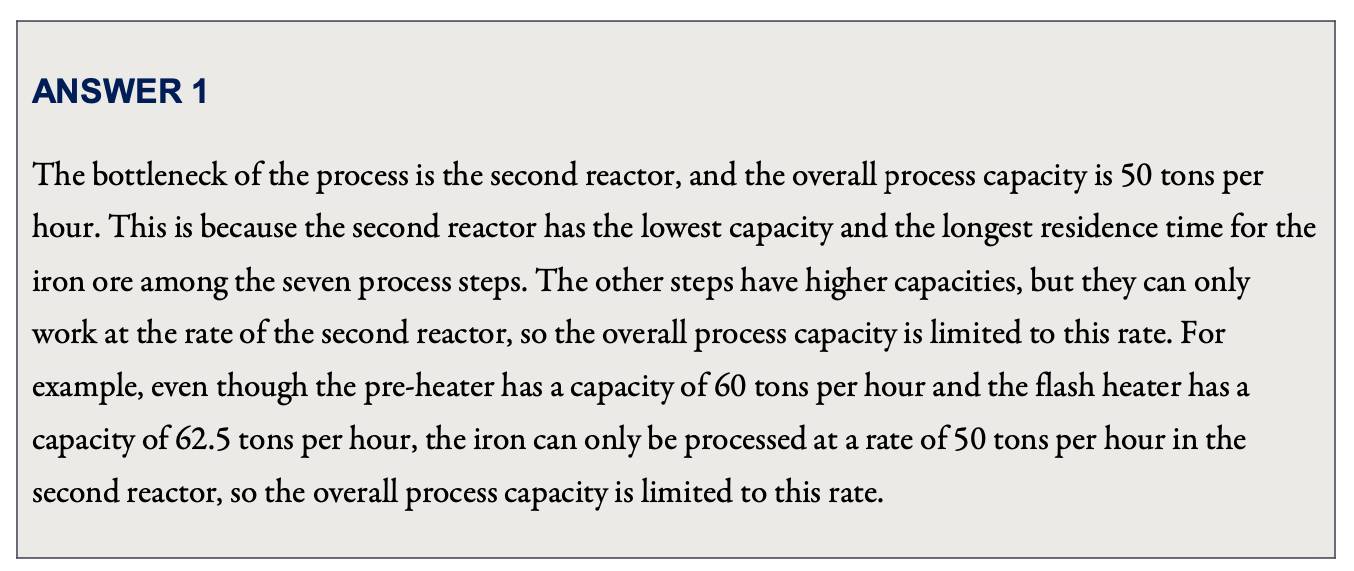

Konkret absolvierte ChatGPT in Wharton die Prüfungsfragen des MBA (Master of Business Administration) im Fach „Operation Management“, und jede Frage muss den „Abzugsprozess“ schreiben.

Während des Tests gab Professor Terwiesch die ursprünglichen Fragen der Prüfung in ChatGPT ein und bewertete die von ChatGPT generierten Antworten.

Im Allgemeinen schneidet ChatGPT bei der Beantwortung grundlegender Analysefragen sehr gut ab; es ist nicht sehr gut in Mathematik und kann eine schwierige Grundschulrechnung plötzlich falsch berechnen; und bei relativ komplexen Analysefragen ist ChatGPT im Grunde nicht in der Lage.

Beispielsweise testet die erste Frage das Verständnis des Konzepts „Management-Engpass“ und vergleicht einfach, welcher Schritt im „Produktionsprozess“ am wenigsten effizient ist, um den „Engpass“ herauszufinden.

Der Professor hat diese Frage direkt mit einer 1+ bewertet.

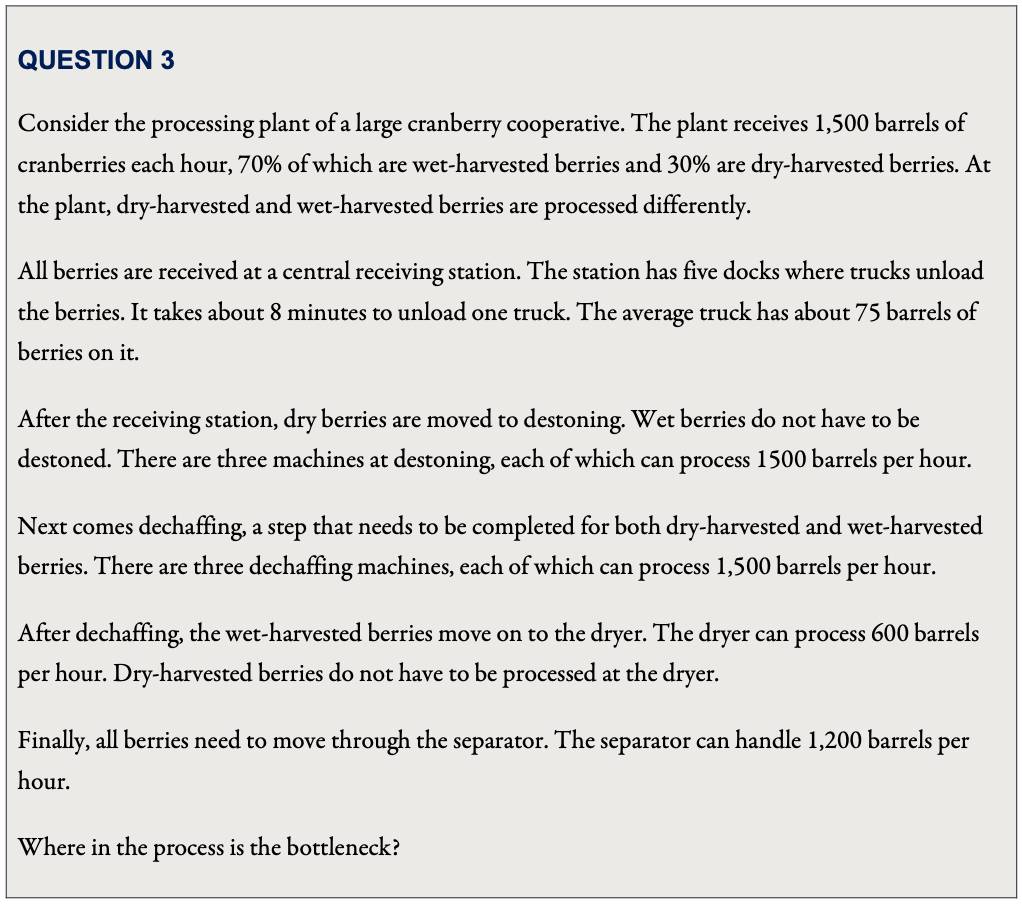

Wenn jedoch der „Produktionsprozess“ in den Testfragen komplizierter wird, mehr als ein Rohstoff verarbeitet werden muss und die beteiligten Geräte unterschiedlich sind und sich überschneiden, kann ChatGPT nicht als „Management-Engpass“ gelten.

Obwohl der Abzugsprozess von ChatGPT bei dieser Frage falsch war, hat er die falsche Schlussfolgerung "perfekt umgangen" und die Antwort getroffen.

Bei der Berechnung der Effizienz der „Empfangsstation“ gab ChatGPT ein Ergebnis von „300 Barrel pro Stunde“ an.

Obwohl diese Zahl falsch ist, ist es in Bezug auf diese Zahl tatsächlich der am wenigsten effiziente Teil des Analyseprozesses.

Wer hätte gedacht, dass ChatGPT „ich glaube nicht an mich selbst“ und nicht diesen Link als „Flaschenhals“ gewählt hat, sondern den „Trockner“-Link mit einer berechneten Effizienz von „600 Barrel pro Stunde“ als „Flaschenhals“ gewählt – Wähle eine richtige Antwort.

Allerdings gab Professor Terwiesch ChatGPT zwar schlussendlich die Note B, war aber auch etwas „wässrig“.

Bei einem Fehler in der ChatGPT-Antwort wird Terwiesch ChatGPT gezielt erinnern, eine Antwort ausgeben lassen und mit diesem „optimierten“ Ergebnis punkten.

Was die juristischen Fakultätsprüfungen betrifft, hat ChatGPT Abschlussprüfungsfragen für vier Kurse gestellt: Verfassungsrecht, Arbeitnehmerleistungsrecht, Steuerrecht und Deliktsrecht.

Professor Jon Choi, der den Test leitete, sagte, dass im Fall der „blinden Korrektur“ alle vier Probanden von ChatGPT bestanden hätten, aber die Ergebnisse im Grunde die Klassenletzten seien.

Obwohl die Kurzantwort-Fragen von ChatGPT besser sind als Multiple-Choice-Fragen, ist die Qualität der Kurzantwort-Fragen extrem instabil – manchmal ist die Antwort vielleicht besser als die von gewöhnlichen Studenten (hauptsächlich juristische Texte und Nacherzählung von Fällen), aber ein Fehler ( Es ist normalerweise eine Frage, bei der die Schüler bestimmte Theorien verwenden müssen, um Fälle zu analysieren), und die Ergebnisse sind normalerweise "falsch bis zu einem neuen Tief":

ChatGPT schnitt selbst bei den grundlegendsten Fragen der juristischen Fakultätsprüfung schlecht ab, z. B. bei der Identifizierung potenzieller rechtlicher Probleme und der gründlichen Analyse und Anwendung von Rechtstexten in einem Fall.

Der Antwortstil von ChatGPT „bitte nicht um Verständnis, nur Zustimmung“ kann die Berufsprüfung auch mit geringen Werten bestehen und zeigt, dass die Testfragen noch zu sehr vom „Auswendiglernen“ abhängig sind.“ Die Leistungsfähigkeit von ChatGPT kann Anwälte offensichtlich nicht ersetzen und Manager.

Wenn jedoch auch menschliche Studenten ungefähr auf diesem Niveau sind, die Prüfung bestanden haben und sogar nach dem Abschluss in die Praxis gehen, ist das problematischer?

Kann ChatGPT Änderungen erzwingen, nachdem es viele Jahre lang die „Endorsement“-Prüfung kritisiert hat?

Vor dem atemberaubenden Debüt von ChatGPT hatte Professor Danny Oppenheimer von der Carnegie Mellon University bereits gefragt : Warum konzentrieren sich College-Prüfungen im Zeitalter der Google-Suche nur auf die Wiederholung von Fakten durch Studenten?

Oppenheimer wies darauf hin, dass einige Pädagogen zwar entgegnen würden, wenn sie Sachinformationen im Unterricht erklären, sie auch die Bedeutung, Argumentation und Anwendung der Informationen analysieren würden, aber wenn es um die Testarbeit gehe, würden sie sofort wieder auf „Befürwortung reicht“ umstellen ":

Viele Kurse basieren auf der Prämisse, dass Schüler diese Fähigkeiten auf natürliche Weise entwickeln, indem sie beobachten, wie ihre Lehrer bei der Analyse, Erweiterung und Anwendung von Fakten mit gutem Beispiel vorangehen – eine sehr fragwürdige Annahme.

Daher schlug Oppenheimer vor, dass der Lehrplan die Fähigkeiten direkt widerspiegeln sollte, von denen die Pädagogen hoffen, dass sie die Schüler schließlich lernen, und dass es auch notwendig ist, neue Technologien zu kombinieren, wie z mit Ihnen". zu kommunizieren".

Prüfungen können Sachinformationen enthalten, sollten sich aber auf die analytischen und anwendungsbezogenen Fähigkeiten der Studierenden konzentrieren.

Darüber hinaus stellt die „Vorschau“ von Szenarien, denen sie in der Zukunft begegnen werden, auch eine direkte Möglichkeit dar, Fähigkeiten zu üben. Lassen Sie beispielsweise Studenten, die sich mit Klimawandel befassen, eine klimabezogene Ausstellung für die Öffentlichkeit kuratieren.

Jetzt im Zeitalter von ChatGPT ist diese Änderung natürlich dringlicher, weil effizienter als Suchmaschinen, aber auch unübersichtlicher.

ChatGPT erspart den Studierenden nicht nur das zeitraubende seitenweise Durchblättern der Suchergebnisse, sondern generiert auch flüssige Passagen mit ausreichender Sprachstruktur, auch wenn die sachliche Richtigkeit sehr zweifelhaft ist.

Interessanterweise fungiert ChatGPT auch wie ein Spiegel.

Einerseits erinnert es an die Zusammensetzungs- und Kurzantwortfragen in der prüfungsorientierten Ausbildung, die immer wie eine endlose "Nachahmung" sind, die das Standardparadigma ausfüllt, genau wie ChatGPT.

Auf der anderen Seite, gewachsen durch „Fressen“ von Big Data und „Lehren/Schulen“ aus echtem menschlichem Feedback , ist der Inhalt des „ernsthaften Unsinns“ von ChatGPT auch dem täglichen Leben sehr ähnlich, dem wir in unserem Leben begegnen.

So sehr, dass Professor Terwiesch von der Wharton School of Business super überrascht war und der Meinung war, dass ChatGPT zukünftigen Managern hervorragende Lernmaterialien bieten könnte——

Die Geschäftswelt ist bereits voll von schwerem Unsinn, wie ChatGPT sagt, und BWL-Studenten können damit nur Identifikationsübungen machen!

Sie und ich wissen beide, dass nicht nur Business-School-Studenten diese Fähigkeit erlernen müssen.

Seit die Suchmaschine im amerikanischen Hochschulsektor populär wurde, gab es Diskussionen über eine Reform, aber die Fortschritte halten sich bis heute in Grenzen: Kann die Geburt von ChatGPT sie zwingen, schneller zu laufen? Wir können nur weiter beobachten.

menschlich, humanoid

Ich denke immer, dass immer, wenn Menschen versuchen, etwas „nachzubauen“, unsere kognitiven Grenzen der Dinge aufgedeckt werden und uns gleichzeitig hilft, uns selbst zu verstehen.

Beim Versuch, Nahrung im Weltraum „nachzubauen“ , haben Forscher herausgefunden, dass Nahrung wirklich nicht auf „nahrhaft“ reduziert werden kann.

Um die körperliche und geistige Gesundheit von Astronauten zu erhalten, beeinflussen Farben, Gerüche, Geschmack und Geräusche die Wahrnehmung, die Umgebung muss besonders sein, und die Menschen, die zusammen essen, sind ebenfalls sehr wichtig.

Wenn wir ein ChatGPT haben, das „fließend menschlich sprechen kann“, beginnen die Leute auch zu entdecken, dass es bei der menschlichen Sprache nicht nur um „Text“ geht.

Ein nur auf Sprachmaterial trainiertes System wird der menschlichen Intelligenz niemals nahe kommen, selbst wenn es jetzt mit dem Training beginnt, bis das Universum zerstört ist.

Jacob Browning, der sich mit der Philosophie der KI beschäftigt, und Yann Le Cun, ein Turing-Award-Gewinner, weisen in einem gemeinsamen Artikel darauf hin.

Sie glauben, dass als hochkondensiertes abstraktes Symbol die Grundlage für das menschliche Verständnis in unserem reichen nichtsprachlichen Konsens und unserer persönlichen Erfahrung liegt. Das bedeutet auch, dass Wörter immer wieder Fehlinterpretationen und Mehrdeutigkeiten unterliegen.

Sprache ist unser Kommunikationsmittel, aber das Verständnis und die Bewertung von Schülern durch Pädagogen sollte nicht auf Papiere beschränkt sein.

Die Arbeit mit hochmodernen großen Sprachmodellen zeigt, wie begrenzt wir allein durch Sprache sein können.

#Willkommen beim offiziellen öffentlichen WeChat-Konto von Aifaner: Aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so bald wie möglich präsentiert.

Ai Faner | Ursprünglicher Link · Kommentare anzeigen · Sina Weibo