Zurückschlagen! Die Google-Version von ChatGPT debütierte mit einer Funktion zum “Rollen” von ChatGPT

Google kann als eines der KI-versiertesten Unternehmen der Welt bezeichnet werden. Es hat den Weltmeister von Go mit KI besiegt, 133 Sprachen übersetzt und Smartphones auf Computerfotografie umgestellt. Fast alle Google-Produkte werden von KI angetrieben.

Aber in den letzten zwei Monaten wurde Google von OpenAIs Chatbot ChatGPT in den Schatten gestellt.

ChatGPT, das wie ein Mensch sprechen kann, hat das Wort KI komplett aus dem Kreis genommen.Die Diskussion der Leute über KI hat sich allmählich von „was KI kann“ zu „was KI sonst nicht kann“ gewandelt.

Erst gestern gab Microsoft bekannt, dass es mit OpenAI zusammenarbeiten wird, um eine neue Version der Bing-Suche und des Edge-Browsers mit integrierten Chatbots herauszubringen, die KI verwenden, um ein neues Sucherlebnis zu bieten.

Die Absicht von Microsoft ist klar: Es will Googles Status als „Suchführer“ herausfordern und mit den besten Schachzügen der anderen Partei konkurrieren.

Google, das über LaMDA, PaLM, Imagen und andere KI-Technologien verfügt, wird Microsoft die Chance von KI-Anwendungen natürlich nicht so einfach nutzen lassen.

Auf der gerade zu Ende gegangenen Google-Konferenz demonstrierte Google die neue KI-Technologie, die in Zukunft auf Google Lens, Karten, Übersetzung und vor allem die Suche angewendet wird, und versucht, das KI-Hochland wieder zu besetzen.

Unter ihnen ist der gemeinsam gezeigte Chat-Roboter Bard der mächtigste Gegenangriff auf ChatGPT, der auch erklärt, dass die Suchmaschine kurz davor steht, in die Ära der Chat-Roboter-Kriege einzutreten. Nun, niemand wird sanft in diese gute Nacht gehen.

Barden nicht zu unterschätzen

Bevor wir Bard vorstellen, können wir auch kurz das verwendete LaMDA-Modell verstehen.

Das vor zwei Jahren von Google veröffentlichte LaMDA-Modell hat in der Branche große Aufmerksamkeit erregt, und sein Einfluss ist nicht geringer als der von ChatGPT heute.

LaMDA ist eine neue KI-Architektur, die maschinelles Lernen einfacher, effizienter und skalierbarer macht. Es kann auf Tausende von Knoten skaliert werden und unterstützt viele Arten von maschinellen Lernaufgaben wie Bilderkennung, Verarbeitung natürlicher Sprache und mehr.

Durch Training kann LaMDA mit Menschen mit fast menschlichem Ausdruck und Verständnis sprechen. Weil sich LaMDA beim Chatten so sehr wie ein Mensch verhielt, dachte ein Ingenieur bei Google sogar, es habe "Selbstbewusstsein", und das sorgte für Aufsehen.

Das ist auch einer der Gründe, warum Google in dieser Zeit die Chance von Chatbots nicht genutzt hat: Nicht dass es dazu unfähig ist, sondern dass LaMDA „verrückt“ ist und sogar Google selbst Angst haben wird.

Allerdings unterschätzte Google die Akzeptanz von AIGC immer noch.Die plötzliche Popularität von ChatGPT schlug bei Google Alarm, sodass Bard ins Leben gerufen wurde.

Bereits vor dem Start hatte Google-CEO Sundar Pichai (Sundar Pichai) in seinem Blog die Existenz von Bard angekündigt.

Bard läuft auf einer leichtgewichtigen Version des LaMDA-Modells, das laut Google die von Bard benötigte Rechenleistung reduziert, so dass es für mehr Benutzer skaliert werden kann und mehr Feedback erhält.

Im Gegensatz zu ChatGPT, das im Jahr 2021 feststeckt, akzeptiert Bard Informationen aus dem neuesten Internet, sodass Bard Antworten auf das geben kann, was jetzt passiert.Wenn man die Menge an Informationen vergleicht, die von den beiden abgerufen werden kann, ist Bard eine Menge größer als die ChatGPT-Klasse.

Mit anderen Worten, Ai Faner sollte in Zukunft nicht lange aufbleiben müssen, um Entwürfe für Pressekonferenzen zu programmieren, und Bard einfach bitten, eine Zusammenfassung der Konferenz auszugeben.

Laut Googles Präsentation auf der Pressekonferenz können Nutzer Bard-Fragen direkt in natürlicher Sprache stellen, anstatt wie bisher mit Schlüsselwörtern zu suchen.

Wenn Sie ein neues Auto kaufen möchten, können Sie Bard direkt fragen, welche Art von Auto für Ihre Familie geeignet ist, und Bard wird Ihnen verschiedene Autokaufvorschläge unter den Gesichtspunkten Budget und Sicherheit geben.

Wenn Sie neue Energiefahrzeuge bevorzugen, wird Bard im Kontext auch Vorschläge für neue Energietypen machen.

Dies ist auch das Merkmal von Bard: Beantwortung von Fragen aus mehreren Blickwinkeln und starkes Kontextverständnis.

Zukünftig wird Bard auch in die Google-Suche integriert, um Ihnen schneller Antworten zu liefern.

Wenn Sie beispielsweise nach der Frage „Was ist das beste Sternbild, das Sie beim Sternengucken sehen können?“ in der Demo-Anzeige von Google suchen, zeigt Bart die Eigenschaften mehrerer Sternbilder und die Beobachtungsmethode.

Google glaubt, dass künstliche Intelligenz bei der Beantwortung von Fragen keine eindeutig richtige Antwort (No One Right Answer) hat. Daher beantwortet Bard die Fragen der Benutzer aus mehreren Blickwinkeln und hilft den Benutzern, die Gesamtsituation schnell zu verstehen, anstatt nur eine eindeutige Antwort wie ChatGPT zu geben Es ist besser, eine richtige, scheinbar richtige Antwort zu haben.

Der von Google veröffentlichten Demo nach zu urteilen, ist Bard weniger ein Chat-Roboter als vielmehr ein Suchassistent.

Ob Bard über die leistungsstarke Fähigkeit zur Textgenerierung wie ChatGPT verfügt, ist aufgrund der begrenzten Anzeige immer noch schwer zu beurteilen.

Hier kommt die Frage, die die Benutzer am meisten beschäftigt: Wann wird Bard verfügbar sein? Laut Google befindet sich Bard noch in der internen Beta-Phase und wird in den nächsten Wochen für die Öffentlichkeit zugänglich sein, dann wird auch Ai Faner es zum ersten Mal erleben.

Google Translate wird von 1 Milliarde Menschen verwendet

Google Translate ist neben der Suche möglicherweise eines der am häufigsten verwendeten Produkte von Google. Laut von Google veröffentlichten Daten verwenden mehr als 1 Milliarde Menschen auf der ganzen Welt Google Translate, um diese vielfältige Welt zu verstehen.

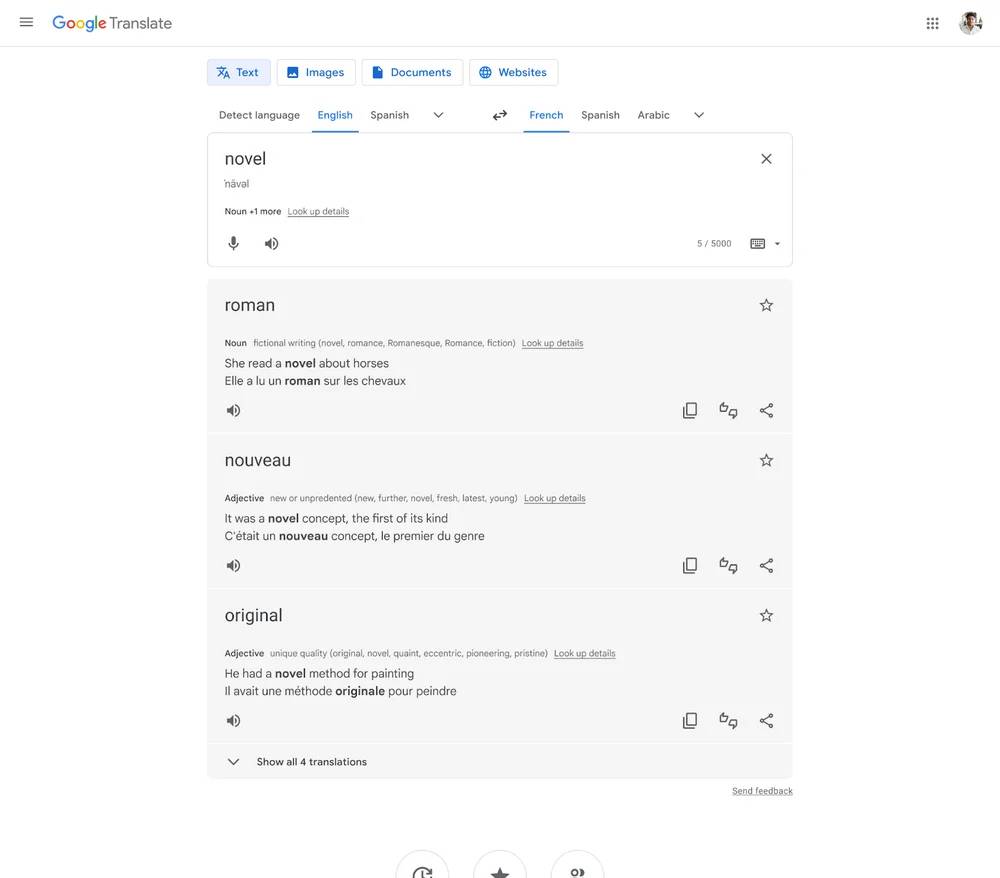

Um Menschen dabei zu helfen, unbekannte Fremdsprachen besser zu verstehen und zu verwenden, bietet Google Translate jetzt nicht nur die Übersetzung von Wörtern, sondern auch mehr Hintergrundinformationen und relevante Informationen, wie z. B. die gleichzeitige Anzeige mehrerer Synonyme, Beispielsätze usw.

Die Funktion wird in fünf Sprachen verfügbar sein: Englisch, Französisch, Deutsch, Japanisch und Spanisch und wird voraussichtlich in den nächsten Wochen verfügbar sein.

Auch Google Translate auf der Android-Seite erhält ein neues Design, das besser lesbar und benutzerfreundlicher ist: Durch die einfachere Bedienlogik wird das Übersetzen immer einfacher und Sie können gelassen damit umgehen, wenn Sie unterwegs auf Sprachbarrieren stoßen. Google sagte, es werde Google Translate in Zukunft auch auf der iOS-Seite neu gestalten.

Eine weitere wichtige Funktion des Google Translate-Updates besteht darin, die KI-Lernfähigkeit zu verwenden, um fremdsprachigen Text auf Bildern genauer zu übersetzen und den übersetzten Text und Bildhintergrund in ein neues Bild zu remixen, was besser ist als die Live-Text-Funktion von iOS.Um noch einen Schritt weiter zu gehen , betont Google, dass mehr als 6 GB RAM erforderlich sind, um diese Funktion zu implementieren.

bewege die erde in die wolke

Die bereits 2021 angekündigte Immersive-View-Funktion verfügt nun über ein detaillierteres Architekturmodell, und der Rendering-Bereich ist groß, wodurch wirklich die gesamte Erde in die Cloud versetzt wird. Gleichzeitig kombiniert Immersive View auch das Wettersystem, das die Umgebung gemäß der Wettervorhersage voller Immersion rendert.

Ab heute wird die Funktion in London, Los Angeles, New York, San Francisco und Tokio verfügbar sein, weitere Städte sollen in den kommenden Monaten folgen.

Angesichts dieser Demonstration kündige ich einseitig an, dass "Earth OL" heute offiziell gestartet wird. Obwohl dies nur ein Witz ist, ist es in der Tat eine große Verbesserung für den Metaverse-Track.

Ein weiteres metaverses „Infrastrukturprojekt“ ist die organische Kombination aus realer Welt und virtuellen Elementen, die oft als „erweiterte Realität“ bezeichnet wird. Google Map wird ebenfalls berücksichtigt, wird aber derzeit nur auf Mobiltelefonen verwendet.

Auf der Straße hält man sein Handy hoch und schaut sich um, der Name des Ladens wird auf dem Bildschirm angezeigt, man klickt auf einen der Läden und kann den Inhalt inklusive Öffnungszeiten, Kundenbewertungen und Rezensionen einsehen.

Dies gilt nicht als innovativ, aber die Städte, die diese Funktion unterstützen, expandieren allmählich, und schließlich wird die Brücke zwischen Virtualität und Realität offiziell vollendet. Bis dahin wird es nicht schwer sein, eine ähnliche Erfahrung mit AR-Brillen zu machen.

Vielleicht wird Google Glass zu diesem Zeitpunkt wiederbelebt, um sein unvollendetes Geschäft abzuschließen.

Google kündigte auf der Pressekonferenz außerdem an, dass die Navigationsfunktion von Google Map AR mehr als 1.000 Flughäfen auf der ganzen Welt unterstützen wird, um es Reisenden zu erleichtern, ihre Ziele genauer zu finden.

Darüber hinaus hat Google endlich begonnen, Besitzer von New Energy Cars zu beachten und wird für New Energy Vehicles mit integrierter Google Map-Funktion künftig die Empfehlungsfunktion von Ladestationen einführen, was eine gute Nachricht für Elektroauto-Nutzer ist. Allerdings haben heimische Autokonzerne und Kartendienstanbieter bereits ähnliche Funktionen auf den Markt gebracht, und die Funktionen sind ziemlich vollständig, Google muss in dieser Hinsicht noch nachziehen.

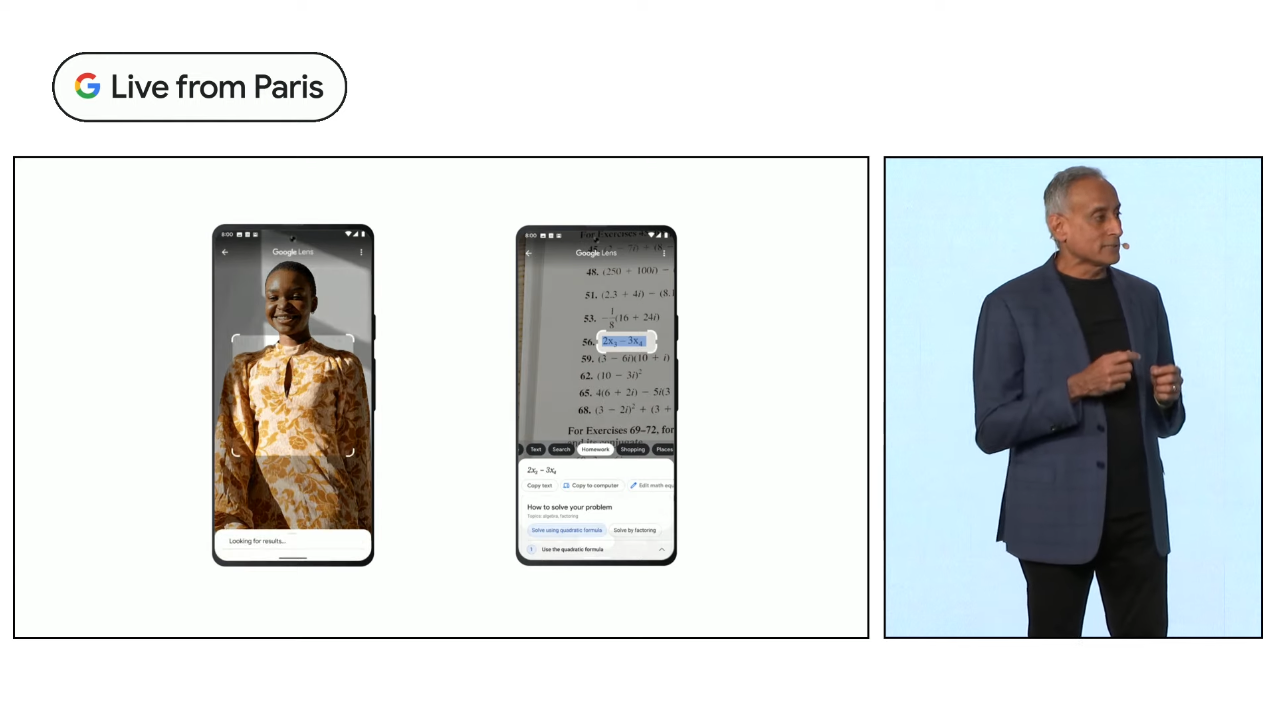

Google Lens, so gut wie es nur geht

Vor der Kombination von künstlicher Intelligenz und Kameras konnten Mobiltelefonobjektive nur zum Fotografieren verwendet werden, aber im Zeitalter der künstlichen Intelligenz haben die Kameras von Mobiltelefonen nach und nach das menschliche Auge ersetzt und die Fähigkeit, die Welt zu erkennen.

Auf dieser Grundlage entstand Google Lens, einschließlich Produktidentifikation, Realszenenübersetzung, Pflanzenidentifikation, Texterkennungssuche usw., die in den Aufgabenbereich von Google Lens fallen.

Mit Hilfe eines neuen KI-Modells hat auch Google Lens eine rasante Entwicklung eingeläutet.

Die erste ist die Search your Screen-Funktion, die ich als Neuinterpretation von „what you see is what you get“ bezeichnen möchte.

Wenn Sie beispielsweise einen sehr leckeren Kuchen auf Xiaohongshu sehen, müssen Sie nicht aus der aktuellen App springen, lange auf die Ein-/Aus-Taste drücken, um Google Assistant zu aktivieren, auf den Suchbildschirm klicken, Sie können die Informationen zu diesem Kuchen finden. und dann mit der neu eingeführten Funktion "Gemischte Suche (Multisuche)" abgleichen, können Sie nach Orten in der Nähe suchen, an denen Sie diese Art von Kuchen kaufen können, und Ihren Appetit rechtzeitig stillen.

Diese „Hybrid-Suche“-Funktion kann die zu durchsuchenden Inhalte mit Text auf Basis der Bilderkennung weiter verfeinern, um genauere und vielfältigere Ergebnisse zu erhalten.

Es ist ein bisschen wie die Bildversion von ChatGPT, aber es fehlt ihm die Fähigkeit zum kontinuierlichen Dialog, und das Endergebnis ist möglicherweise nicht jedes Mal zufriedenstellend.

In diesem kleinen Update sehen wir jedoch auch das Potenzial von Google im natürlichen Sprachmodell, das möglicherweise früher als ChatGPT ein Allround-AIGC-Tool vorschlagen kann, aber nicht heute.

Die Suche ist immer noch ein Moonshot

Prabhakar Raghavan, Senior Vice President von Google, begann die Einführung des Updates mit einem Punkt, der Sie vielleicht überraschen wird: Die Suche ist immer noch ein „Moonshot-Projekt“.

Die Suchmaschine ist mittlerweile sehr ausgereift und stellt das grundlegende Werkzeug dar, das von den meisten Internetbenutzern täglich verwendet wird. Sie ist so einfach, benutzerfreundlich und intuitiv – es gibt nur eine Suchleiste, und Sie können direkt eingeben, was Sie möchten wissen möchten und klicken Sie, um zu suchen.

Aber es ist auch sehr einfach, das Suchverfahren zu verwenden, was es sehr schwierig macht, die Genauigkeit der Suche zu erhöhen, ohne die Belastung des Benutzers auf dieser Basis zu erhöhen. Es erfordert viel unsichtbaren Aufwand für Suchmaschinen, Sie durch Schichten nutzloser Informationen zu führen, um die Antwort zu finden, wenn Sie suchen.

Google ist seit 25 Jahren auf dem Gebiet der Suche tätig, kann aber immer noch nicht garantieren, dass Nutzer bei jeder Suche die gewünschten Informationen finden. Daher ist die Einführung einer KI-gestützten Suche besonders wichtig, um die Benutzererfahrung zu verbessern und unnötige Wiederholungen zu vermeiden sucht.

Prabhakar Raghavan glaubt, dass Google den Menschen dabei hilft, die Beschränkungen einer einzelnen Suchmethode und Sprache zu überwinden, aus dem Suchfeld herauszuspringen, um eine größere Welt zu erkunden, und die Bedeutung der Suche neu zu gestalten, und dies ist erst der Anfang.

Wie zufrieden sind die Nutzer mit dem KI-basierten Antwortbogen von Google? Aus Aktiensicht fiel der Aktienkurs von Google bei Redaktionsschluss um 7,68 %. Wenn Google seine Position als „Search Leader“ weiter festigen will, muss Bard die Suchmaschine einen Schritt vor ChatGPT verändern.

Hinweis: Dieser Artikel wurde gemeinsam von Huang Zhijian, Wang Zhishao und ChatGPT erstellt

#Willkommen beim offiziellen öffentlichen WeChat-Konto von Aifaner: Aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so bald wie möglich präsentiert.

Ai Faner | Ursprünglicher Link · Kommentare anzeigen · Sina Weibo