Wie Nvidias DLSS 3 funktioniert (und warum AMD FSR vorerst nicht aufholen kann)

Die Grafikkarten der RTX 40-Serie von Nvidia kommen in wenigen Wochen auf den Markt, aber unter all den Hardware-Verbesserungen liegt das, was Nvidias goldenes Ei sein könnte: DLSS 3 . Es ist viel mehr als nur ein Update für Nvidias beliebte DLSS-Funktion (Deep Learning Super Sampling) und könnte am Ende die nächste Generation von Nvidia viel mehr definieren als die Grafikkarten selbst.

AMD hat hart daran gearbeitet, FidelityFX Super Resolution (FSR) auf Augenhöhe mit DLSS zu bringen, und in den letzten Monaten war es erfolgreich. DLSS 3 sieht so aus, als würde es diese Dynamik ändern – und dieses Mal kann FSR möglicherweise nicht in absehbarer Zeit aufholen.

Wie DLSS 3 funktioniert (und wie nicht)

Es sei Ihnen verziehen zu denken, dass DLSS 3 eine völlig neue Version von DLSS ist, aber das ist es nicht. Oder zumindest ist es nicht ganz neu. Das Rückgrat von DLSS 3 ist die gleiche Super-Resolution-Technologie, die heute in DLSS-Titeln verfügbar ist, und Nvidia wird sie vermutlich mit neuen Versionen weiter verbessern. Nvidia sagt, dass Sie den Super-Resolution-Teil von DLSS 3 jetzt als separate Option in den Grafikeinstellungen sehen werden.

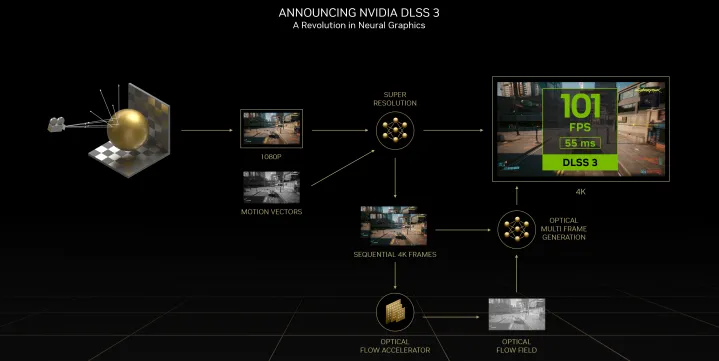

Der neue Teil ist die Frame-Generation. DLSS 3 generiert bei jedem zweiten Frame ein völlig einzigartiges Bild und generiert im Wesentlichen sieben von jeweils acht Pixeln, die Sie sehen. Eine Veranschaulichung dazu finden Sie im folgenden Flussdiagramm. Im Fall von 4K rendert Ihre GPU nur die Pixel für 1080p und verwendet diese Informationen nicht nur für das aktuelle Bild, sondern auch für das nächste Bild.

Die Frame-Generierung wird laut Nvidia ein separater Schalter von der Superauflösung sein. Das liegt daran, dass die Frame-Generierung vorerst nur auf GPUs der RTX 40-Serie funktioniert, während die Superauflösung weiterhin auf allen RTX-Grafikkarten funktioniert, auch in Spielen, die auf DLSS 3 aktualisiert wurden. Es sollte selbstverständlich sein, aber wenn die Hälfte Ihrer Frames vollständig generiert werden, wird dies Ihre Leistung erheblich steigern .

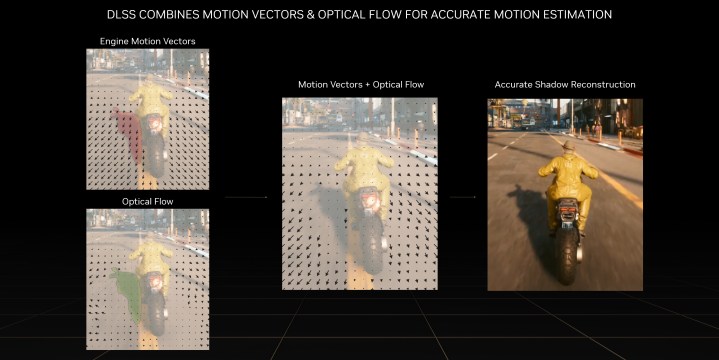

Die Frame-Generierung ist jedoch nicht nur eine geheime KI-Sauce. In DLSS 2 und Tools wie FSR sind Bewegungsvektoren eine wichtige Eingabe für die Hochskalierung. Sie beschreiben, wo sich Objekte von einem Frame zum nächsten bewegen, aber Bewegungsvektoren gelten nur für die Geometrie in einer Szene. Elemente ohne 3D-Geometrie, wie Schatten, Reflexionen und Partikel, wurden traditionell aus dem Hochskalierungsprozess ausgeblendet, um visuelle Artefakte zu vermeiden.

Maskierung ist keine Option, wenn eine KI einen völlig einzigartigen Frame generiert, und hier kommt der Optical Flow Accelerator in den GPUs der RTX 40-Serie ins Spiel. Es ist wie ein Bewegungsvektor, außer dass die Grafikkarte die Bewegung einzelner Pixel von einem Frame zum nächsten verfolgt. Dieses optische Flussfeld trägt zusammen mit Bewegungsvektoren, Tiefe und Farbe zum KI-generierten Frame bei.

Es hört sich alles nach Vorteilen an, aber es gibt ein großes Problem mit Frames, die von der KI generiert werden: Sie erhöhen die Latenz. Der von der KI generierte Frame durchläuft niemals Ihren PC – es ist ein „gefälschter“ Frame, sodass Sie ihn nicht auf herkömmlichen FPS-Anzeigen in Spielen oder Tools wie FRAPS sehen werden. Die Latenz sinkt also nicht, obwohl so viele zusätzliche Frames vorhanden sind, und aufgrund des Rechenaufwands des optischen Flusses steigt die Latenz tatsächlich an. Aus diesem Grund erfordert DLSS 3 Nvidia Reflex , um die höhere Latenz auszugleichen.

Normalerweise speichert Ihre CPU eine Render-Warteschlange für Ihre Grafikkarte, um sicherzustellen, dass Ihre GPU nie auf Arbeit wartet (das würde zu Stottern und Framerate-Einbrüchen führen). Reflex entfernt die Render-Warteschlange und synchronisiert Ihre GPU und CPU, sodass die GPU mit der Verarbeitung beginnt, sobald Ihre CPU Anweisungen senden kann. Wenn es über DLSS 3 angewendet wird, kann Reflex laut Nvidia manchmal sogar zu einer Reduzierung der Latenz führen.

Wo KI einen Unterschied macht

AMDs FSR 2.0 verwendet keine KI, und wie ich vor einiger Zeit geschrieben habe, beweist es, dass Sie mit Algorithmen anstelle von maschinellem Lernen die gleiche Qualität wie DLSS erreichen können. DLSS 3 ändert dies mit seinen einzigartigen Frame-Generierungsfunktionen sowie der Einführung von Optical Flow.

Der optische Fluss ist keine neue Idee – er gibt es schon seit Jahrzehnten und findet Anwendung in allen Bereichen, von Videobearbeitungsanwendungen bis hin zu selbstfahrenden Autos. Die Berechnung des optischen Flusses mit maschinellem Lernen ist jedoch relativ neu, da immer mehr Datensätze zum Trainieren von KI-Modellen verwendet werden. Der Grund, warum Sie KI verwenden möchten, ist einfach: Sie erzeugt bei ausreichendem Training weniger visuelle Fehler und verursacht zur Laufzeit nicht so viel Overhead.

DLSS wird zur Laufzeit ausgeführt. Es ist möglich, einen Algorithmus ohne maschinelles Lernen zu entwickeln, um abzuschätzen, wie sich jedes Pixel von einem Frame zum nächsten bewegt, aber es ist rechenintensiv, was dem eigentlichen Sinn des Supersamplings zuwiderläuft. Mit einem KI-Modell, das nicht viel Leistung und genügend Trainingsdaten erfordert – und seien Sie versichert, Nvidia verfügt über zahlreiche Trainingsdaten, mit denen Sie arbeiten können – können Sie einen optischen Fluss erzielen, der von hoher Qualität ist und zur Laufzeit ausgeführt werden kann.

Das führt zu einer Verbesserung der Framerate auch bei CPU-limitierten Spielen. Supersampling gilt nur für Ihre Auflösung, die fast ausschließlich von Ihrer GPU abhängt. Mit einem neuen Frame, der die CPU-Verarbeitung umgeht, kann DLSS 3 die Frameraten in Spielen verdoppeln, selbst wenn Sie einen vollständigen CPU-Engpass haben. Das ist beeindruckend und derzeit nur mit KI möglich.

Warum FSR 2.0 (vorerst) nicht aufholen kann

AMD hat mit FSR 2.0 wirklich das Unmögliche geschafft. Es sieht fantastisch aus und die Tatsache, dass es markenunabhängig ist, ist noch besser. Ich war bereit, DLSS für FSR 2.0 aufzugeben, seit ich es zum ersten Mal in Deathloop gesehen habe. Aber so sehr ich FSR 2.0 genieße und denke, dass es ein großartiges Teil des Kits von AMD ist, es wird DLSS 3 in absehbarer Zeit nicht einholen.

Für den Anfang ist die Entwicklung eines Algorithmus, der jedes Pixel zwischen Frames frei von Artefakten verfolgen kann, schwierig genug, insbesondere in einer 3D-Umgebung mit dichten, feinen Details ( Cyberpunk 2077 ist ein Paradebeispiel). Es ist möglich, aber hart. Das größere Problem ist jedoch, wie aufgebläht dieser Algorithmus sein müsste. Die Verfolgung jedes Pixels durch den 3D-Raum, die Berechnung des optischen Flusses, die Generierung eines Frames und die Bereinigung aller Pannen, die auf dem Weg passieren – das ist viel verlangt.

Das zum Laufen zu bringen, während ein Spiel ausgeführt wird, und dennoch eine Verbesserung der Framerate auf dem Niveau von FSR 2.0 oder DLSS zu bieten, das ist noch mehr verlangt. Nvidia muss selbst mit dedizierten Prozessoren und einem trainierten Modell immer noch Reflex verwenden, um die durch den optischen Fluss verursachte höhere Latenz auszugleichen. Ohne diese Hardware oder Software würde FSR wahrscheinlich zu viel Latenz opfern, um Frames zu generieren.

Ich habe keinen Zweifel, dass AMD und andere Entwickler irgendwann dorthin kommen werden – oder einen anderen Weg finden werden, um das Problem zu umgehen – aber das könnte ein paar Jahre dauern. Das ist jetzt schwer zu sagen.

Was man leicht sagen kann ist, dass DLSS 3 sehr spannend aussieht. Natürlich müssen wir warten, bis es hier ist, um die Leistungsansprüche von Nvidia zu validieren und zu sehen, wie sich die Bildqualität hält. Bisher haben wir nur ein kurzes Video von Digital Foundry, das DLSS 3-Material zeigt (oben), das ich sehr empfehlen würde, es sich anzusehen, bis wir weitere Tests von Drittanbietern sehen. Aus heutiger Sicht sieht DLSS 3 jedoch durchaus vielversprechend aus.

Dieser Artikel ist Teil von ReSpec – einer fortlaufenden zweiwöchentlichen Kolumne, die Diskussionen, Ratschläge und ausführliche Berichte über die Technologie hinter PC-Spielen enthält.