Nvidia hat eine massive Dual-GPU gebaut, um Modelle wie ChatGPT mit Strom zu versorgen

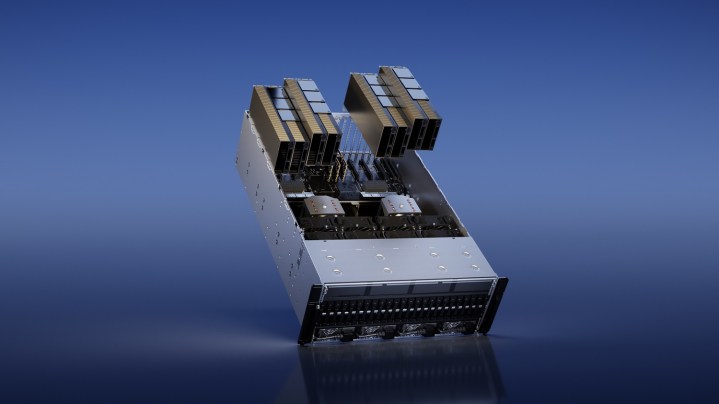

Nvidias halbjährliche GPU Technology Conference (GTC) konzentriert sich normalerweise auf Fortschritte in der KI, aber dieses Jahr reagiert Nvidia auf den massiven Aufstieg von ChatGPT mit einer Reihe neuer GPUs. Der wichtigste unter ihnen ist der H100 NVL, der zwei von Nvidias H100-GPUs zusammenfügt, um Large Language Models (LLM) wie ChatGPT bereitzustellen.

Die H100 ist keine neue GPU. Nvidia hat es vor einem Jahr auf der GTC angekündigt , mit seiner Hopper-Architektur und dem Versprechen, die KI-Inferenz bei einer Vielzahl von Aufgaben zu beschleunigen. Das neue NVL-Modell mit seinen massiven 94 GB Speicher soll am besten funktionieren, wenn LLMs in großem Maßstab bereitgestellt werden, und bietet im Vergleich zum A100 der letzten Generation eine bis zu 12-mal schnellere Inferenz.

Diese GPUs sind das Herzstück von Modellen wie ChatGPT. Nvidia und Microsoft haben kürzlich enthüllt, dass Tausende von A100-GPUs verwendet wurden, um ChatGPT zu trainieren , ein Projekt, das mehr als fünf Jahre in der Mache war.

Das H100 NVL funktioniert durch die Kombination von zwei H100-GPUs über eine NVLink-Verbindung mit hoher Bandbreite von Nvidia. Dies ist bereits mit aktuellen H100-GPUs möglich – tatsächlich können Sie bis zu 256 H100 über NVLink miteinander verbinden – aber diese dedizierte Einheit wurde für kleinere Bereitstellungen entwickelt.

Dies ist ein Produkt, das mehr als alles andere für Unternehmen entwickelt wurde. Erwarten Sie also nicht, dass der H100 NVL in Ihrem örtlichen Micro Center im Regal auftaucht. Laut Nvidia können Unternehmenskunden jedoch damit rechnen, es in der zweiten Jahreshälfte zu sehen.

Neben dem H100 NVL kündigte Nvidia auch die L4-GPU an, die speziell für KI-generierte Videos entwickelt wurde. Laut Nvidia ist es für KI-generierte Videos 120-mal leistungsfähiger als eine CPU und bietet eine um 99 % bessere Energieeffizienz. Zusätzlich zu generativem KI-Video bietet Nvidia laut Nvidia die Video-Decodierungs- und Transcodierungsfunktionen der GPU und kann für Augmented Reality genutzt werden.

Laut Nvidia gehört Google Cloud zu den ersten, die L4 integrieren. Google plant, Kunden noch heute L4-Instanzen über seine Vertex-KI-Plattform anzubieten. Nvidia sagte, dass die GPU später bei Partnern erhältlich sein wird, darunter unter anderem Lenovo, Dell, Asus, HP, Gigabyte und HP.