Sugar Factory veröffentlicht Humming Board Open-Source-Hardware und -Software und eröffnet damit eine unendliche Zukunft des Personal Computing und Ladens

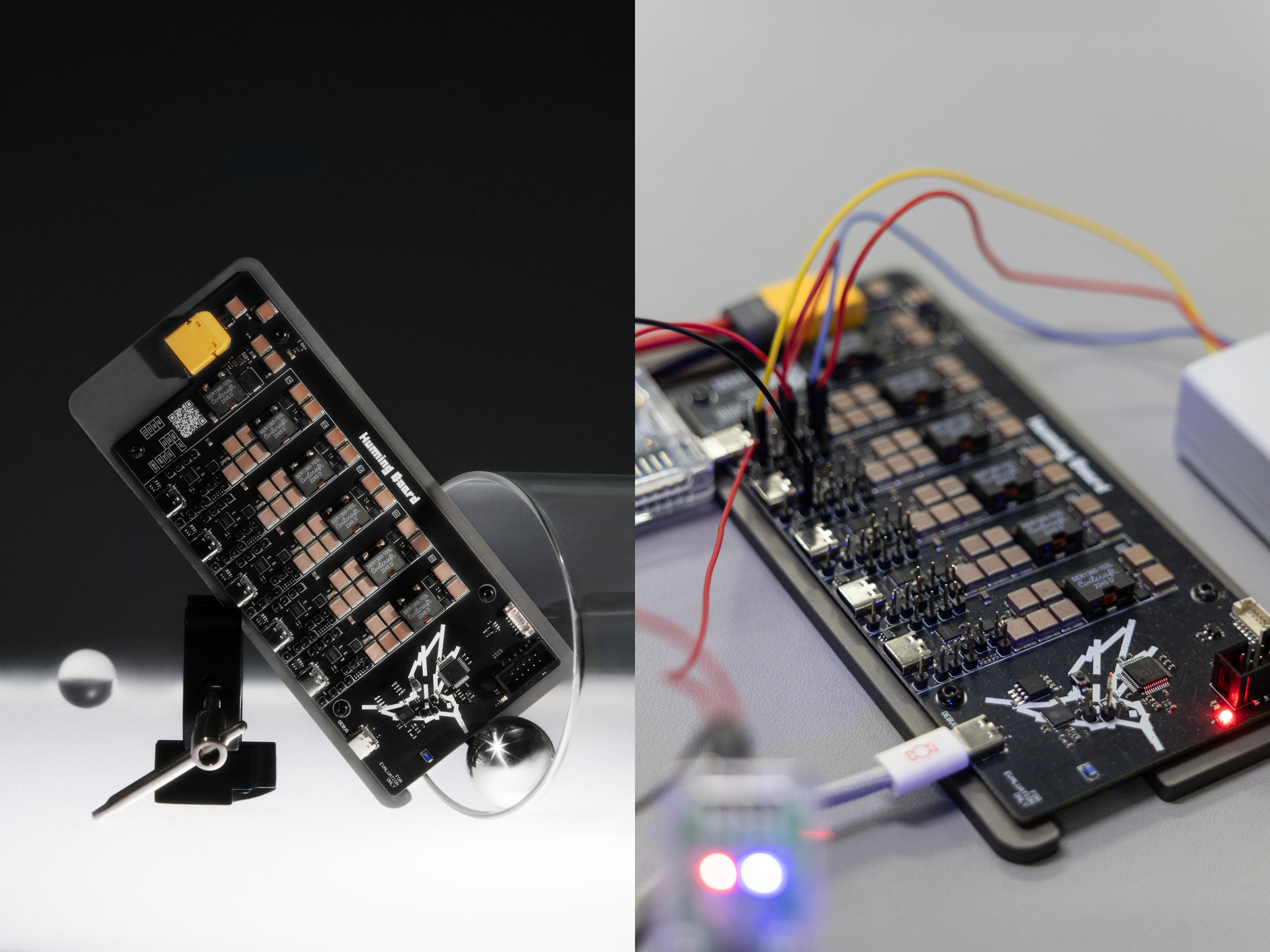

Der Forschungs- und Entwicklungsprototyp von AI Xiaodianpin: ein leistungsstarkes Open-Source-Entwicklungsboard mit sowohl Technologie als auch Ästhetik

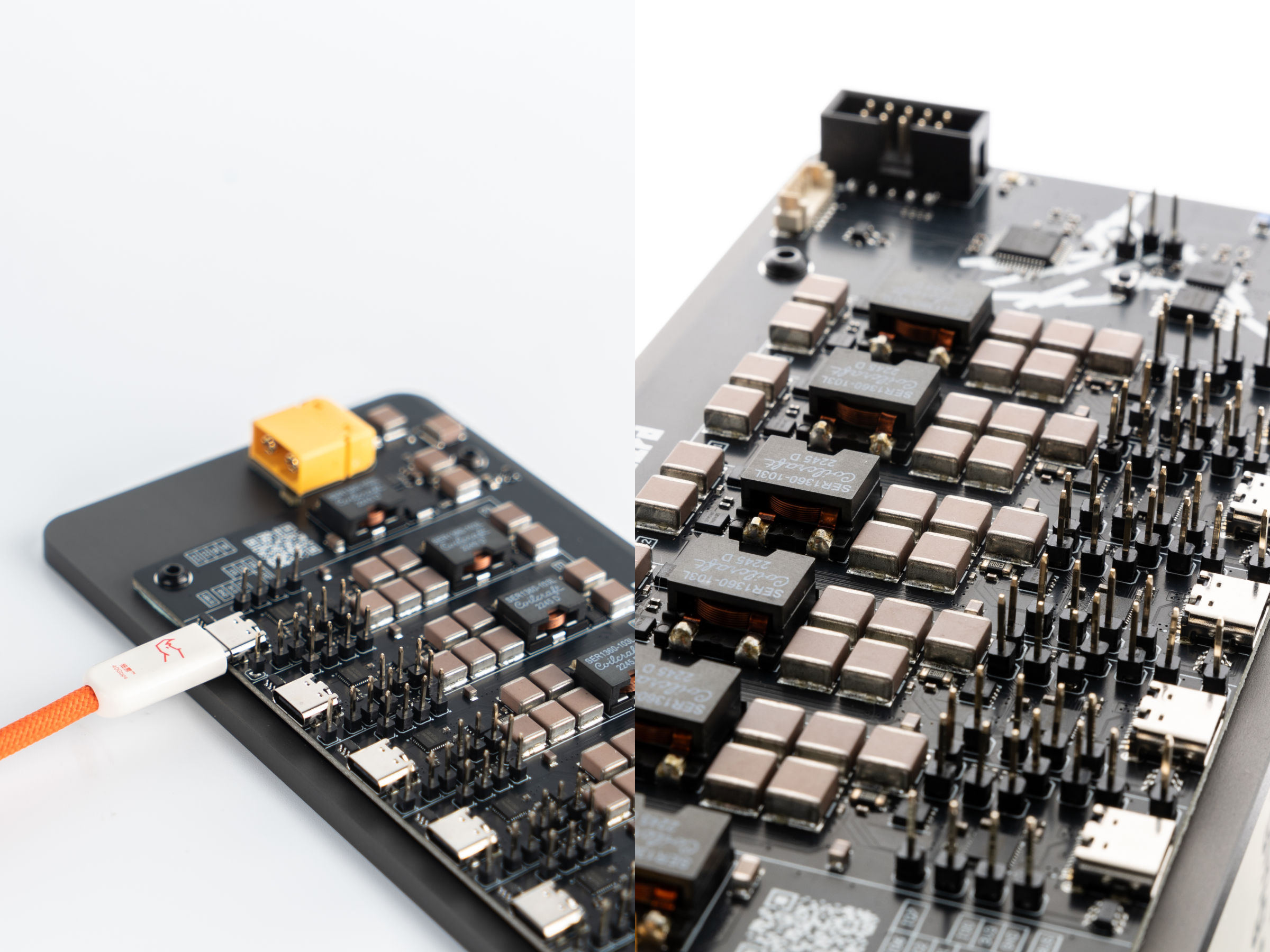

Das Humming Board ist mit 5 PD 140W USB-C-Schnittstellen, 1 Debug-Schnittstelle und einer OLED-Schnittstelle ausgestattet. Es verfügt über einen integrierten FPGA-Chip, einen Protokoll-Chip und einen Wi-Fi-Chip. Es kann Hochgeschwindigkeits-Kommunikationsprotokolle in Echtzeit verarbeiten und reservieren Sie Platz für zukünftige Updates.

Das Humming Board entspricht vollständig dem DCDC-Prinzip der kommerziellen Kleinelektronik Pro/Ultra und verwendet hochwertige Komponenten wie Samsung, Murata-Kondensatoren, CoilCraft, TDK-Chip-Induktivitäten usw., um seine hohe Leistung und Stabilität zu gewährleisten.

Der modernste Standard für Open-Source-Hardware

Humming Board hat den höchsten Standard der Open-Source-Hardware erreicht – Sugar Factory hat nicht nur sein detailliertes Schaltplandiagramm, seinen Software-Quellcode, sein Steuerprotokoll, sein Bluetooth-Kommunikationsprotokoll und sein MQTT-Kommunikationsprotokoll offengelegt, sondern Benutzern auch die Möglichkeit gegeben, den MQTT-Broker zu modifizieren. Dies bedeutet, dass Entwickler frei erstellen können, von Ladegeräten über Internet-of-Things-Systeme bis hin zur Verwendung reservierter Schnittstellen zum Anschluss von Sensoren usw., um komplexe Systeme zu bilden, was den Weg für das Design intelligenter Geräte ebnet.

Die Sugar Factory wird in Zukunft das 3D-gedruckte Gehäusemodell von Humming Board und weitere Informationen veröffentlichen. Mit einem Gleichstromnetzteil mit einer 29-32-V-XT60-Schnittstelle können Benutzer ein fertiges Ladegerät mit einer Gesamtleistung von bis zu 700 W zusammenstellen und zusammenbauen. (*Die maximale Leistung muss selbst zusammengestellt werden, um sie zu erreichen.)

Das Humming Board ist ab sofort in begrenzter Stückzahl zum Preis von 1.499 Yuan erhältlich.

Entwickeln Sie sich für den Schöpfer

Das Konzept des Open-Source-Sharings ist seit jeher Bestandteil der Entwicklungsstrategie der Zuckerfabrik. Die Zuckerfabrik weiß, dass der technologische Fortschritt die gemeinsamen Anstrengungen und die Weisheit der gesamten Branche erfordert.

Als Forschungs- und Entwicklungsprototyp von Xiaodianpin Pro/Ultra bietet Humming Board eine modulare und offene Hardwareplattform, die nicht nur für Entwickler/Ingenieure zum Debuggen und Verifizieren von Ladeprotokollen, Energieverwaltung und intelligenten Algorithmen geeignet ist, sondern auch für die Anfangsphase Der Hardware-Entwickler bietet ein intuitives Tool zum Erlernen der USB-PD-, IoT- und Ladegerätetechnologie.

Die Mission von Humming Board besteht nicht nur darin, Entwicklern eine praktische experimentelle Plattform zur Verfügung zu stellen, sondern Sugar Factory schafft durch Open Source und Offenheit auch ein freieres, kollaborativeres und innovativeres Lade- und Computer-Ökosystem.

Über Zuckerfabrik

# Willkommen beim offiziellen öffentlichen WeChat-Konto von aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner |. Ursprünglicher Link · Kommentare anzeigen · Sina Weibo