Der beliebteste Abend von Domestic AI! Die großen Vorbilder DeepSeek und Kimi konkurrieren mit OpenAI o1. Wie stark ist das tatsächliche Testerlebnis?

Pünktlich zu den Feiertagen haben beliebte inländische Hersteller von großen KI-Modellen eine große Anzahl von Geschenken zum Frühlingsfest herausgebracht.

Der DeepSeek-R1 mit Vorderfuß wird offiziell veröffentlicht und behauptet, dass seine Leistung mit der offiziellen Version von OpenAI o1 verglichen wird, und das neue Modell k1.5 mit Hinterfuß wird ebenfalls offiziell eingeführt, was darauf hinweist, dass die Leistung das Niveau des Vollmodells erreicht. Blutversion des multimodalen o1.

Wenn wir den GLM-Zero, das Step-Star-Inferenzmodell Step R-mini und das Xinghuo-Deep-Inferenzmodell X1 hinzufügen, die zuvor ein starkes Debüt gegeben haben, haben die im Inland produzierten großen Modelle in Oita Ende des Jahres eröffnet Vorhang auf für echte Schwerter und Waffen, und auch die von OpenAI repräsentierten Overseas-Modelle sind stark unter Druck geraten.

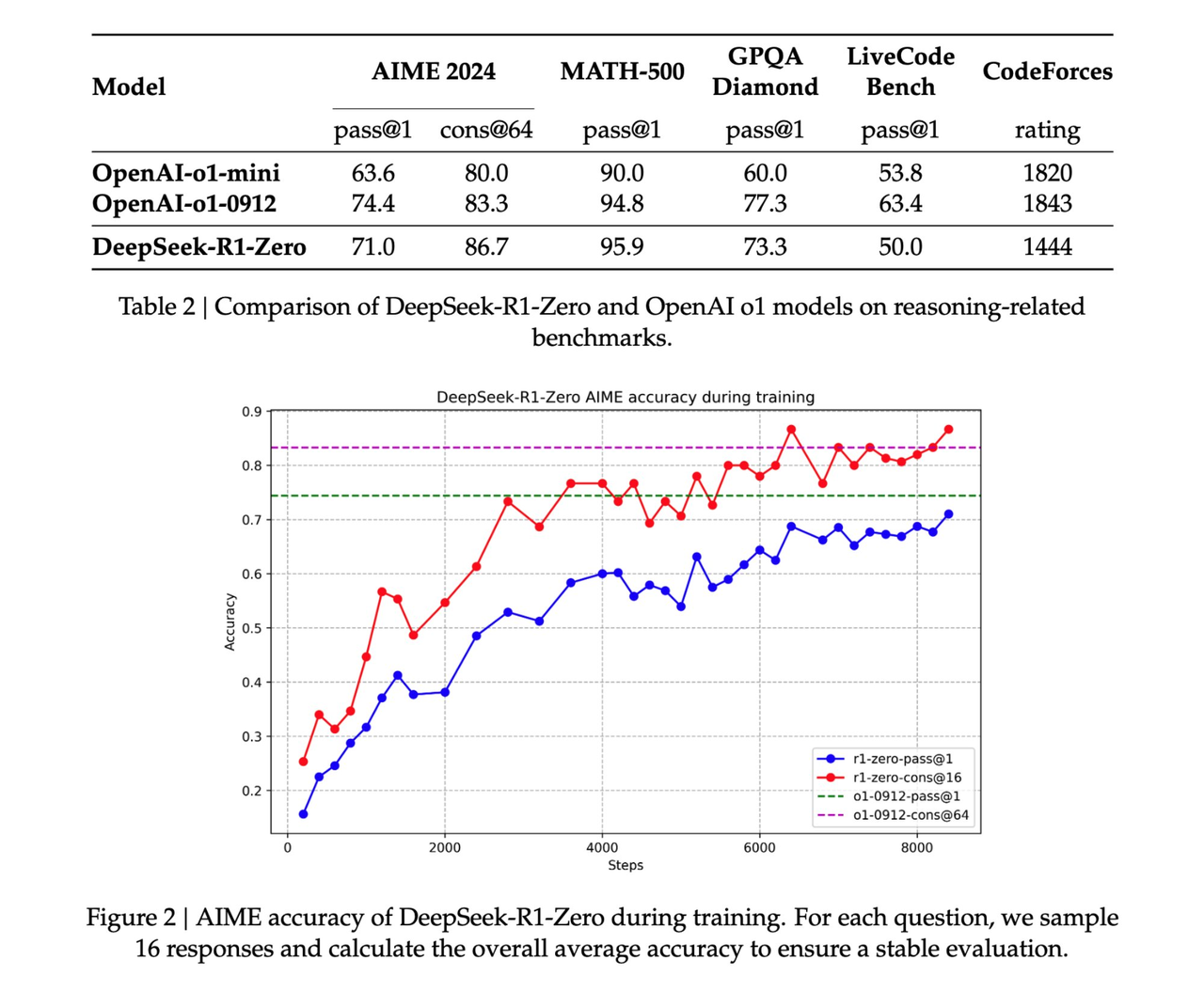

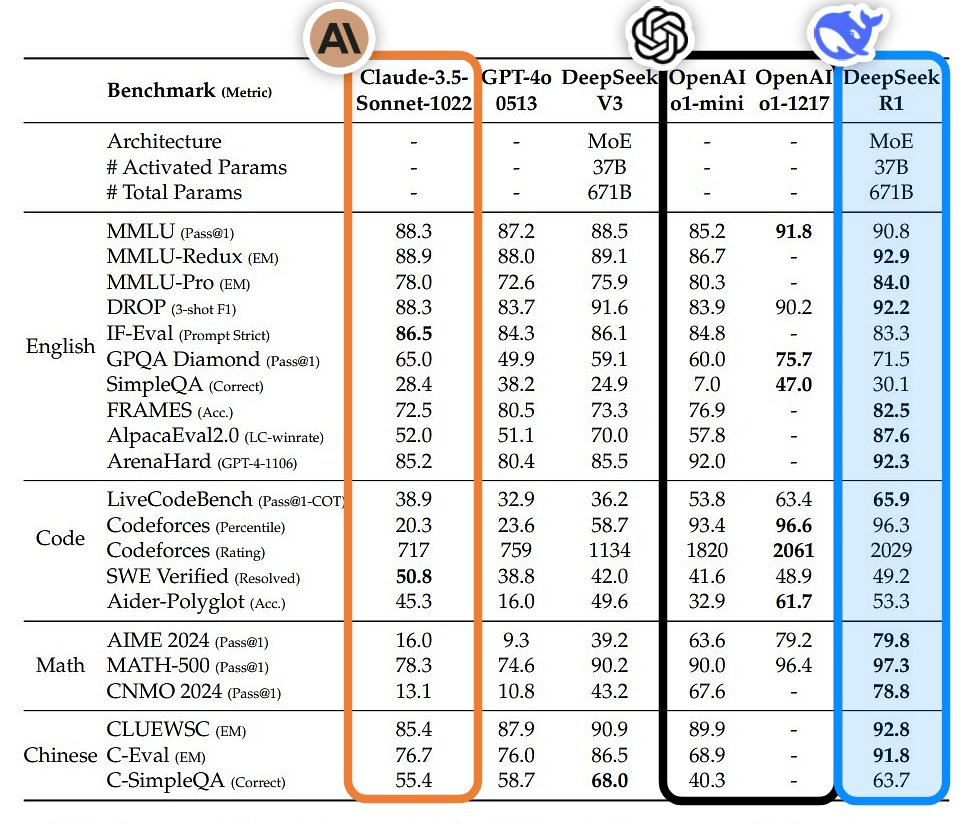

- DeepSeek-R1: Bei Aufgaben wie Mathematik, Codierung und logischem Denken ist seine Leistung mit der offiziellen Version von OpenAI o1 vergleichbar

- Dark Side of the Moon k1.5: Mathematik, Codierung, visuelle multimodale und allgemeine Fähigkeiten übertreffen GPT-4o und Claude 3.5 Sonnet bei weitem.

- GLM-Zero: Gut im Umgang mit mathematischer Logik, Code und komplexen Problemen, die tiefgreifendes Denken erfordern

- Step-2 mini: extrem schnelle Reaktion, die durchschnittliche Verzögerung beim ersten Wort beträgt nur 0,17 Sekunden, außerdem gibt es die Step-2 Literary Master Edition

- Xinghuo

Der Ausbruch ist kein zufälliger Ausbruch, sondern eine seit langem angesammelte Kraft. Man kann sagen, dass der Durchbruch inländischer KI-Modelle am Vorabend des Frühlingsfestes die Weltkoordinaten der KI-Entwicklung neu definieren wird.

Die chinesische Version von „Yuanshen“ ist im Ausland beliebt, das ist die echte OpenAI

DeepSeek-R1, das gestern Abend erstmals veröffentlicht wurde, ist jetzt auf der offiziellen Website und App von DeepSeek verfügbar. Sie können es öffnen und verwenden.

Ich habe die schwierigen Fragen, welches größer ist, 9,8 und 9,11, und wie viele Rs es in Strawberry gibt, im ersten Test erfolgreich bestanden. Auch wenn die Denkkette etwas lang ist, ist die richtige Antwort, dass Fakten mehr sagen als Worte.

Angesichts der Qual des geistig zurückgebliebenen Balkenproblems „Wie hoch können Sie springen, um die Werbung auf Ihrem Mobiltelefon zu überspringen?“ kann die extrem schnelle Reaktion von DeepSeek-R1 nicht nur Sprachfallen vermeiden, sondern auch viele Vorschläge machen, die es zu vermeiden gilt Anzeigen, was sehr benutzerfreundlich ist.

Vor ein paar Jahren wurde im Internet eine logische Frage mit dem Titel „Wenn gestern morgen war, ist heute Freitag, welcher Wochentag ist heute?“ populär. Nachdem OpenAI o1 mit derselben Frage konfrontiert wurde, lautete die Antwort: Sonntag. DeepSeek -R1 ist Mittwoch.

Aber im Moment ist zumindest DeepSeek-R1 der Antwort näher.

Berichten zufolge ist die Leistung von DeepSeek-R1 bei Aufgaben wie Mathematik, Codierung und natürlichem Sprachdenken mit der offiziellen Version von OpenAI o1 vergleichbar. Theoretisch ist es eher für Studenten der Naturwissenschaften geeignet.

Pünktlich zum freundschaftlichen Austausch von Mathe-Hausaufgaben zwischen chinesischen und amerikanischen Internetnutzern auf Xiaohongshu haben wir auch DeepSeek-R1 gebeten, bei der Beantwortung von Fragen zu helfen.

Interessanterweise entdeckten einige Internetnutzer, als DeepSeek das letzte Mal im Ausland populär wurde, dass DeepSeek tatsächlich auch die Bilderkennung unterstützt. Wir können das Modell direkt von amerikanischen Internetnutzern hochgeladene Testpapierbilder analysieren lassen.

Es gibt insgesamt zwei Fragen. Die erste Frage ist C und die zweite Frage ist A. Darüber hinaus vermutet DeepSeek-R1, dass es in der ursprünglichen Frage der zweiten Frage keine Option 18 gibt Es wird spekuliert, dass die ursprüngliche Frage lauten könnte. Es liegen Schreibfehler vor (z. B. sollte die Gleichung lauten: r2=9cos(2θ)r2=9cos(2θ)).

In den nachfolgenden Beweisfragen zur linearen Algebra sind die von DeepSeek-R1 bereitgestellten Beweisschritte logisch streng, und dieselbe Frage bietet auch eine Vielzahl von Verifizierungsmethoden, die fundierte mathematische Fähigkeiten demonstrieren.

Beginnen Sie mit der Leistung, bleiben Sie bei den Kosten stehen und bleiben Sie Open Source treu. Nach der offiziellen Veröffentlichung von DeepSeek-R1 werden auch die Gewichte des Open-Source-Modells synchronisiert. Ich erkläre, dass DeepSeek von China Orient die echte OpenAI ist.

Es wird berichtet, dass DeepSeek-R1 der MIT-Lizenz folgt und es Benutzern ermöglicht, andere Modelle mit R1 durch Destillationstechnologie zu trainieren. DeepSeek-R1 startet die API und öffnet die Ausgabe der Denkkette für Benutzer, die durch Festlegen von model='deepseek-reasoner' aufgerufen werden kann.

Darüber hinaus wird die DeepSeek-R1-Trainingstechnologie vollständig veröffentlicht und der Link zum Papier bietet Orientierungshilfen.  https://github.com/deepseek-ai/DeepSeek-R1/blob/main/DeepSeek_R1.pdf

https://github.com/deepseek-ai/DeepSeek-R1/blob/main/DeepSeek_R1.pdf

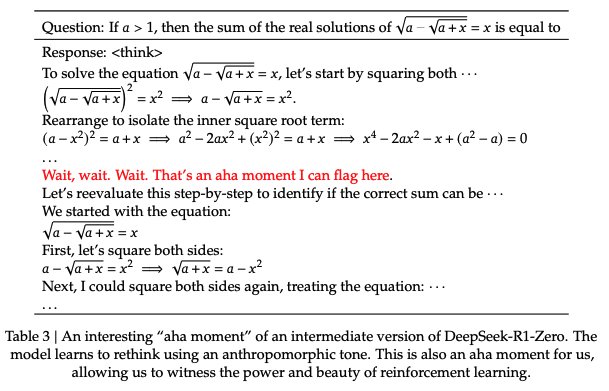

Im technischen Bericht von DeepSeek-R1 wurde eine bemerkenswerte Entdeckung erwähnt, nämlich der „Aha-Moment“, der während des R1-Null-Trainingsprozesses auftrat.

In der mittleren Trainingsphase des Modells beginnt DeepSeek-R1-Zero damit, die anfänglichen Problemlösungsideen aktiv neu zu bewerten und mehr Zeit für die Optimierung der Strategie einzuplanen (z. B. durch mehrmaliges Ausprobieren verschiedener Lösungen). Mit anderen Worten: Durch das RL-Framework kann KI spontan menschenähnliche Denkfähigkeiten entwickeln und sogar die Grenzen voreingestellter Regeln überschreiten.

Und dies wird hoffentlich auch eine Richtung für die Entwicklung autonomerer und adaptiverer KI-Modelle vorgeben, etwa zur dynamischen Anpassung von Strategien bei komplexen Entscheidungen (medizinische Diagnose, Algorithmendesign). In dem Bericht heißt es: „Dieser Moment war ein ‚Aha-Moment‘, nicht nur für das Modell, sondern auch für die Forscher, die sein Verhalten beobachteten.“

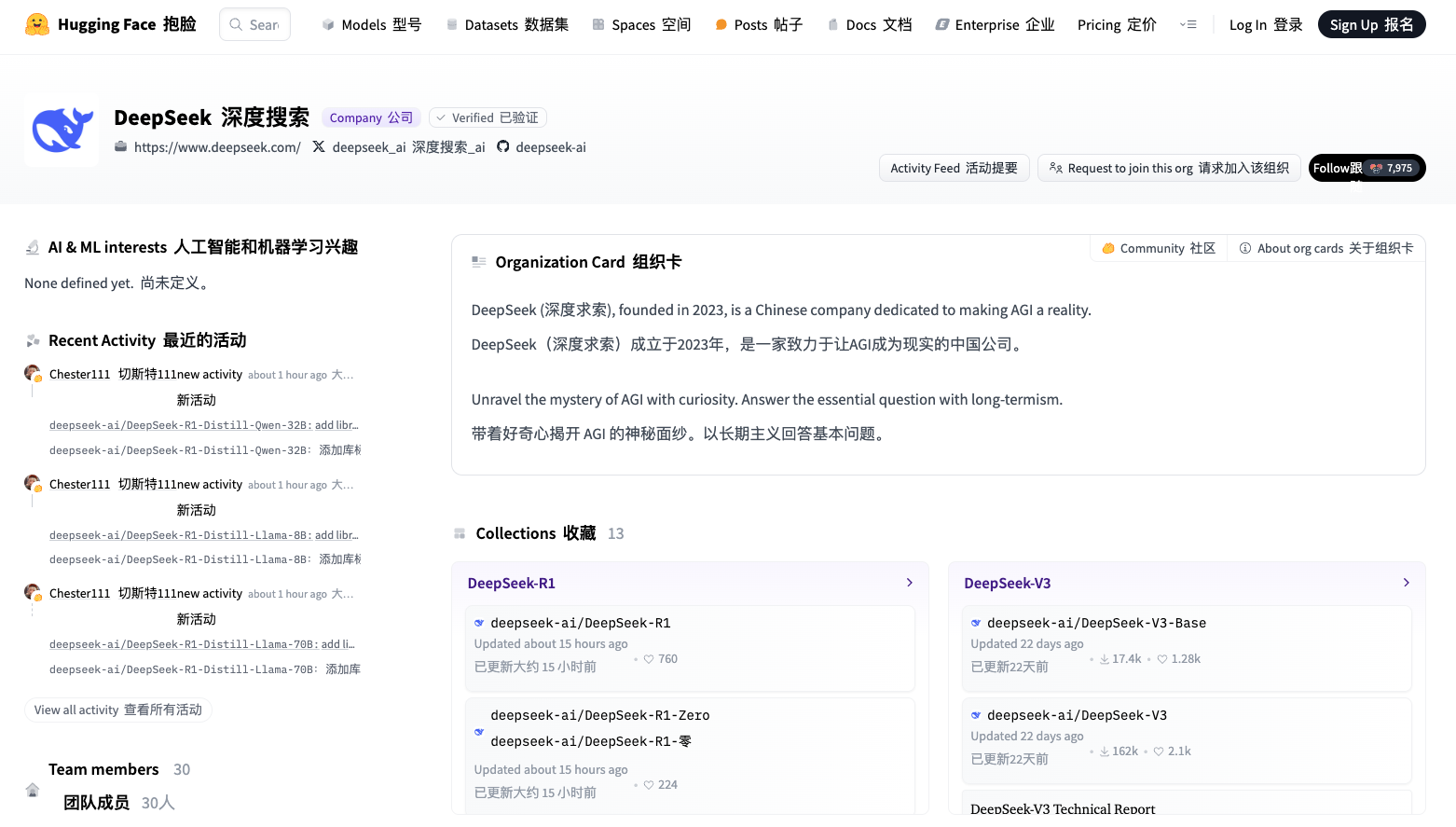

Zusätzlich zu den großen Hauptmodellen sind auch die kleinen Modelle von DeepSeek sehr leistungsstark.

DeepSeek hat durch die Destillation von zwei 660B-Modellen, DeepSeek-R1-Zero und DeepSeek-R1, sechs kleine Modelle als Open-Source-Lösung bereitgestellt. Unter ihnen haben die Modelle 32B und 70B in vielen Bereichen das Niveau von OpenAI o1-mini erreicht.

Darüber hinaus übertraf DeepSeek-R1-Distill-Qwen-1.5B mit einer Parametergröße von nur 1,5 B GPT-4o und Claude-3.5-Sonnet im Mathematik-Benchmark-Test mit einem AIME-Score von 28,9 % und einem MATH-Score von 83,9 %.

HuggingFace-Link: https://huggingface.co/deepseek-ai

In Bezug auf die API-Service-Preise verwendet DeepSeek, das als KI-Äquivalent von Pinduoduo bekannt ist, auch flexible Staffelpreise: 1–4 Yuan pro Million Eingabe-Tokens, abhängig von den Cache-Bedingungen, und einmalig 16 Yuan für Ausgabe-Tokens Dadurch werden die Entwicklungs- und Nutzungskosten nochmals deutlich gesenkt.

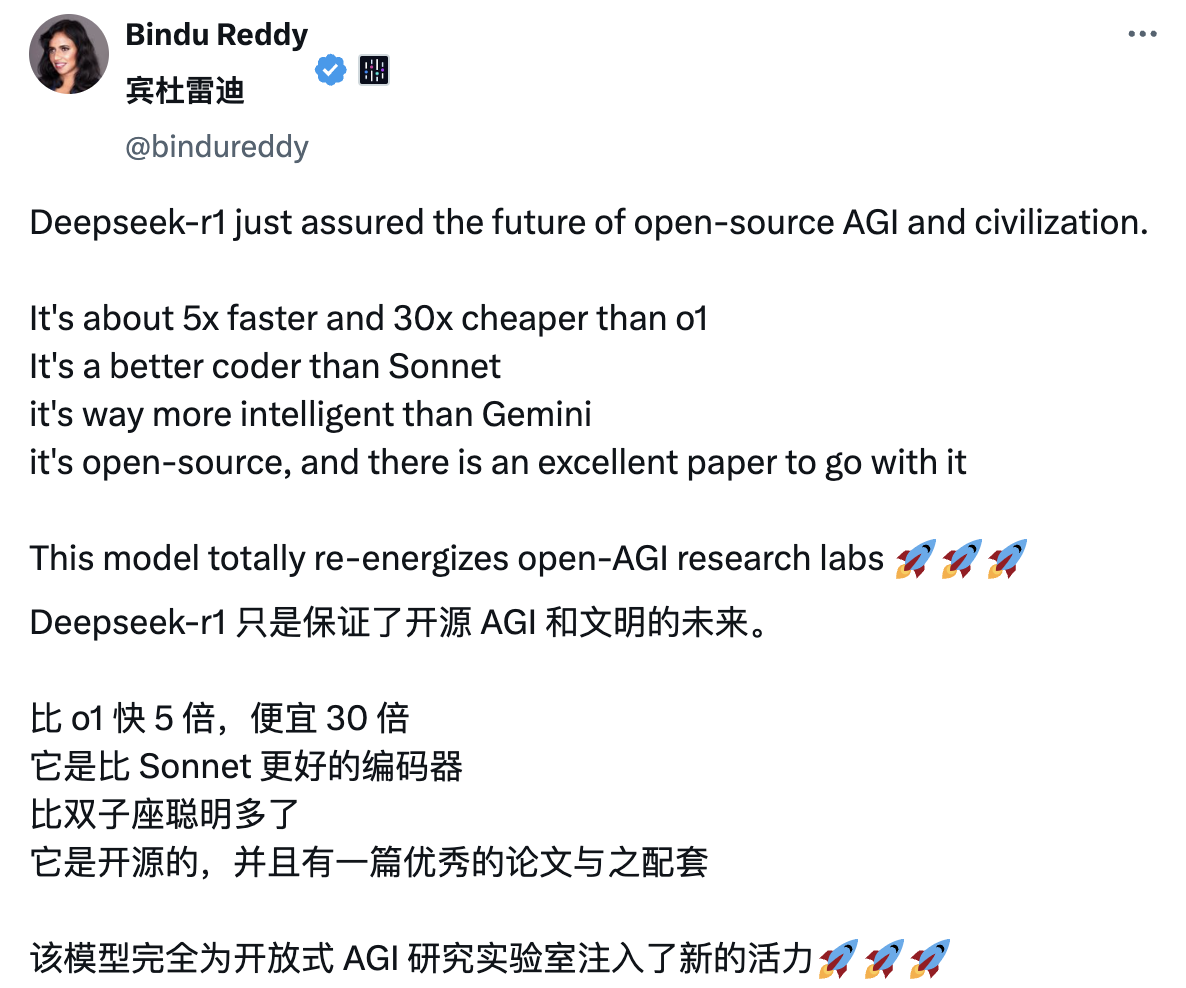

Nach der Veröffentlichung von DeepSeek-R1 sorgte es in ausländischen KI-Kreisen erneut für Aufsehen und sorgte für viel „Leitungswasser“. Unter ihnen bezeichnete der Blogger Bindu Reddy Deepseek sogar als die Zukunft der Open-Source-AGI und der Zivilisation.

Die hervorragende Bewertung ergibt sich aus der hervorragenden Leistung des Modells bei der tatsächlichen Anwendung durch Internetnutzer. Von einer detaillierten Erklärung des Satzes des Pythagoras in 30 Sekunden bis hin zu einer 9-minütigen Erklärung der Prinzipien der Quantenelektrodynamik auf einfache Weise und mit visueller Präsentation. An DeepSeek-R1 ist nichts auszusetzen.

Es gibt sogar Internetnutzer, die die Gedankenkette von DeepSeek-R1 besonders schätzen und sagen, dass es „sehr dem inneren Monolog eines Menschen gleicht, sowohl professionell als auch niedlich.“

Jim Fan, leitender Forschungswissenschaftler bei NVIDIA, lobte DeepSeek-R1. Er wies darauf hin, dass dies bedeutet, dass Nicht-US-Unternehmen die ursprüngliche offene Mission von OpenAI erfüllen und durch die Offenlegung ursprünglicher Algorithmen und Lernkurven Einfluss gewinnen. Dies beinhaltet übrigens auch eine Welle von OpenAI.

DeepSeek-R1 stellte nicht nur eine Reihe von Modellen als Open Source zur Verfügung, sondern enthüllte auch alle Trainingsgeheimnisse. Sie könnten die ersten Open-Source-Projekte sein, die das signifikante und kontinuierliche Wachstum des RL-Schwungrads demonstrieren.

Einfluss kann durch legendäre Projekte wie „ASI Internal Implementation“ oder „Strawberry Project“ oder einfach durch die Offenlegung des ursprünglichen Algorithmus und der Matplotlib-Lernkurve erreicht werden.

Nachdem er sich mit dem Papier befasst hatte, hob Jim Fan mehrere wichtige Erkenntnisse hervor:

Vollständig angetrieben durch Reinforcement Learning ohne SFT (überwachte Feinabstimmung). Erinnert an AlphaZero – man beherrscht Go, Shogi und Schach von Grund auf, anstatt zunächst die Bewegungen eines menschlichen Meisters zu imitieren. Dies ist die kritischste Feststellung in der Arbeit. Echte Belohnungen, die anhand hartcodierter Regeln berechnet werden.

Vermeiden Sie die Verwendung leicht zu knackender Lernbelohnungsmodelle für das verstärkende Lernen. Mit fortschreitendem Training nimmt die Denkzeit des Modells allmählich zu – es handelt sich hierbei nicht um ein vorab geschriebenes Programm, sondern um eine entstehende Eigenschaft! Die Entstehung von Selbstreflexion und explorativem Verhalten.

GRPO ersetzt PPO: Es entfernt das Kommentarnetzwerk von PPO und verwendet stattdessen die durchschnittliche Belohnung mehrerer Proben. Dies ist eine einfache Möglichkeit, die Speichernutzung zu reduzieren. Es ist zu beachten, dass GRPO eine vom Autorenteam vorgeschlagene innovative Methode ist.

Insgesamt zeigt diese Arbeit das bahnbrechende Potenzial des Reinforcement Learning für die praktische Anwendung in groß angelegten Szenarien und zeigt, dass bestimmte komplexe Verhaltensweisen mit einfacheren algorithmischen Strukturen erreicht werden können, ohne dass umständliche Abstimmungen oder menschliches Eingreifen erforderlich sind.

Ein Bild sagt mehr als tausend Worte. Ein offensichtlicherer Vergleich ist wie folgt:

Auf diese Weise erreichte DeepSeek im In- und Ausland erneut eine Popularitätsexplosion. Es war nicht nur ein technologischer Durchbruch, sondern auch ein Sieg für den Open-Source-Geist in China und auf der ganzen Welt Fans.

Das neue Modell ist mit OpenAI o1 vergleichbar und hat innerhalb von drei Monaten dreimal den Durchbruch geschafft, was Kimi im Ausland für Begeisterung sorgt

Am selben Tag wurde auch das multimodale Denkmodell Kimi v1.5 eingeführt.

Seit Kimi im November letzten Jahres das mathematische Modell k0-math und im Dezember das visuelle Denkmodell k1 herausgebracht hat, ist dies das dritte wichtige Update der K-Serie.

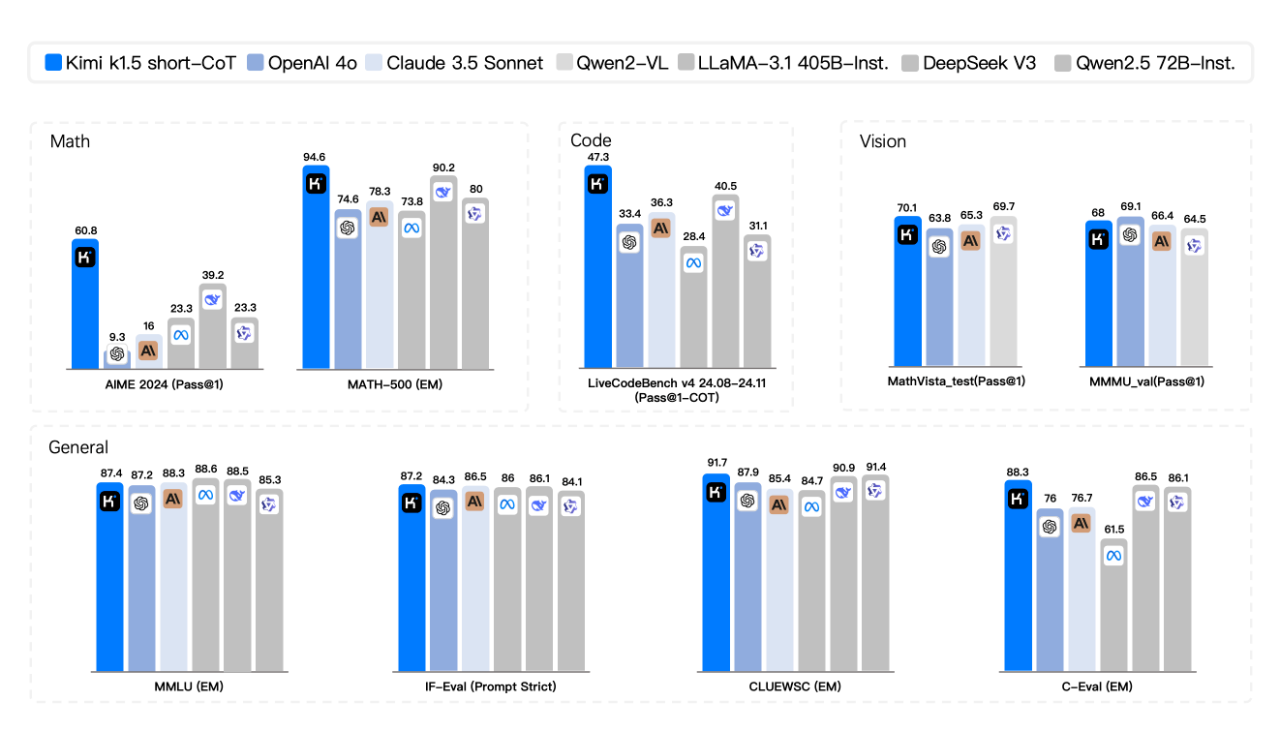

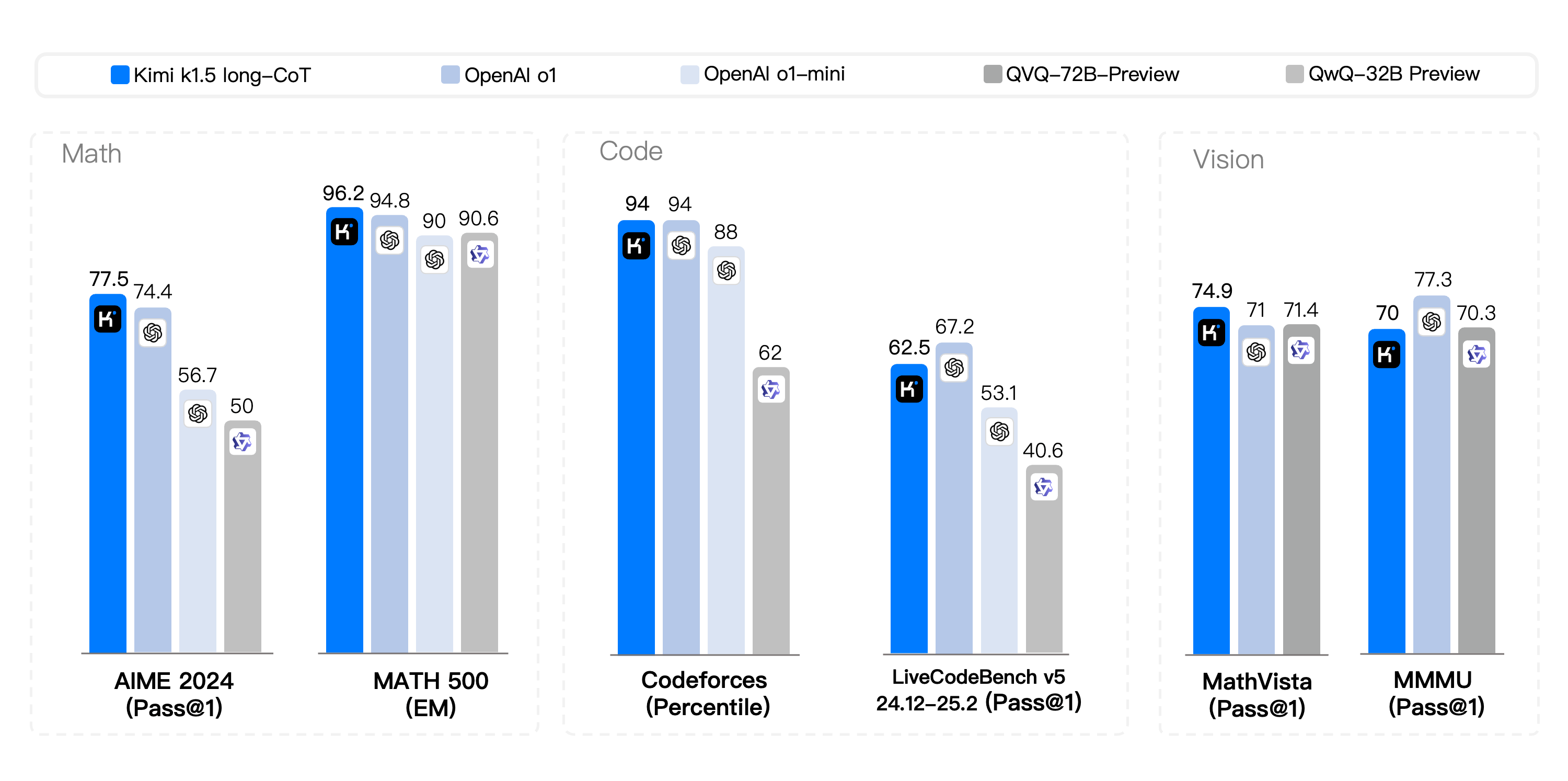

Im Short-CoT-Wettbewerb zeigte Kimi k1.5 einen überwältigenden Vorteil und übertraf die Branchenführer GPT-4o und Claude 3.5 Sonnet in seinen Mathematik-, Codierungs-, visuellen multimodalen und allgemeinen Fähigkeiten.

Im langjährigen CoT-Wettbewerb sind die Code- und multimodalen Argumentationsfunktionen von Kimi k1.5 mit der offiziellen Version von OpenAI o1 vergleichbar und damit die erste weltweit, die eine multimodale Argumentationsleistung auf o1-Ebene außerhalb des OpenAI-Modells erreicht .

Zusammen mit der großen Veröffentlichung des Modells veröffentlichte Kimi zum ersten Mal auch einen vollständigen Technologiebericht zum Modelltraining.

GitHub-Link: https://github.com/MoonshotAI/kimi-k1.5

Laut der offiziellen Einführung spiegeln sich die wichtigsten technologischen Durchbrüche des k1.5-Modells hauptsächlich in vier Schlüsseldimensionen wider:

- Lange Kontexterweiterung. Wir erweitern das Kontextfenster von RL auf 128 KB und beobachten mit zunehmender Kontextlänge weitere Leistungsverbesserungen. Eine Schlüsselidee unseres Ansatzes besteht darin, Teil-Rollouts zu verwenden, um die Trainingseffizienz zu verbessern – das heißt, indem eine große Anzahl früherer Trajektorien wiederverwendet wird, um neue Trajektorien abzutasten, wodurch die Kosten für die Neugenerierung neuer Trajektorien von Grund auf vermieden werden. Unsere Beobachtungen zeigen, dass die Kontextlänge eine entscheidende Dimension für die konsistente Skalierung von RL über LLMs ist.

- Verbesserte Strategieoptimierung. Wir leiten die RL-Formulierung von Long-CoT ab und verwenden eine Variante des Online-Spiegelabstiegs für eine robuste Richtlinienoptimierung. Der Algorithmus wird durch die Optimierung unserer effizienten Stichprobenstrategie, der Längenstrafe und des Datenrezepts weiter verbessert.

- Einfaches Framework. Eine lange Kontexterweiterung in Kombination mit verbesserten Richtlinienoptimierungsmethoden schafft einen prägnanten RL-Rahmen für das Lernen durch LLMs. Da wir in der Lage sind, die Kontextlänge zu erweitern, weisen erlernte CoTs Planungs-, Reflexions- und Revisionsmerkmale auf. Durch die Vergrößerung der Kontextlänge erhöht sich die Anzahl der Suchschritte. Daher zeigen wir, dass eine starke Leistung erzielt werden kann, ohne auf komplexere Techniken wie die Monte-Carlo-Baumsuche, Wertfunktionen und Prozessbelohnungsmodelle angewiesen zu sein.

- Multimodale Fähigkeiten. Unser Modell wird gemeinsam auf Text- und visuelle Daten trainiert und verfügt über die Fähigkeit, gemeinsam über beide Modalitäten nachzudenken. Dieses Modell verfügt über hervorragende mathematische Fähigkeiten. Da es jedoch hauptsächlich die Texteingabe in Formaten wie LaTeX unterstützt, ist es schwierig, einige geometrische Grafikfragen zu beantworten, die auf Grafikverständnis beruhen.

Die Vorschauversion des multimodalen Denkmodells k1.5 wird in Graustufen auf der offiziellen Website und der offiziellen App veröffentlicht. Es ist erwähnenswert, dass die Veröffentlichung von k1.5 auch im Ausland eine große Resonanz hervorrief. Einige Internetnutzer lobten dieses Modell ohne zu zögern und ermöglichten es den überseeischen Ländern, Zeuge des Aufstiegs von Chinas KI-Stärke zu werden.

Tatsächlich ist die intensive Veröffentlichung inländischer Inferenzmodelle am Ende des Jahres kein Zufall. Dies ist ein bedeutendes Zeichen dafür, dass die Wellen, die das im Oktober letzten Jahres veröffentlichte o1-Modell von OpenAI im globalen KI-Bereich verursacht hat, endlich China erreicht haben. In nur wenigen Monaten haben im Inland produzierte große Modelle vom Aufholen bis zum Gleichstand Chinas Schnelligkeit unter Beweis gestellt.

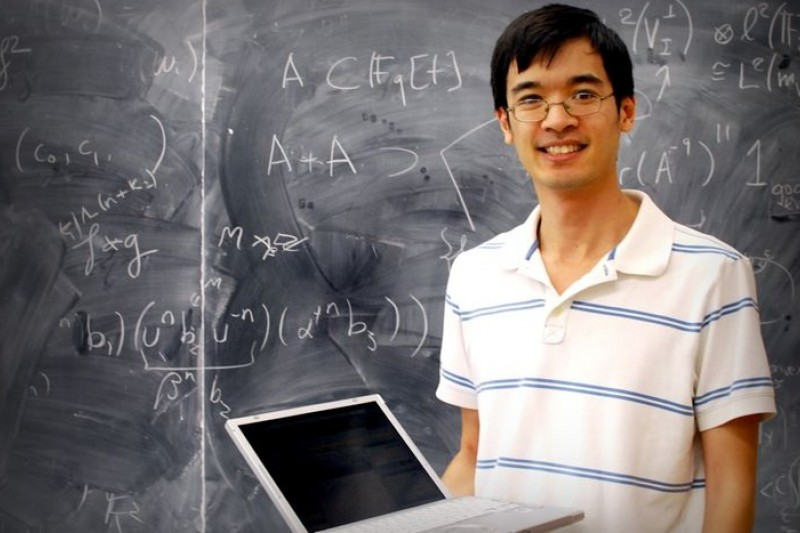

Der Fields-Medaillengewinner und Mathematikgenie Terence Tao glaubte einst, dass diese Art von Argumentationsmodell möglicherweise nur ein oder zwei weitere Iterationsrunden und Leistungsverbesserungen benötige, bevor es das Niveau eines „qualifizierten Doktoranden“ erreichen könne. Die Vision der KI-Entwicklung geht weit darüber hinaus.

Derzeit erleben wir einen entscheidenden Transformationsmoment für KI-Agenten. Von der reinen „Wissenserweiterung“ bis zur „Ausführungsverbesserung“ beginnen Sie, sich aktiv am Prozess der Entscheidungsfindung und Aufgabenausführung zu beteiligen. Gleichzeitig durchbricht die KI auch die Beschränkungen einer einzelnen Modalität und entwickelt sich schnell in Richtung einer multimodalen Fusion. Wenn Umsetzung auf Denken trifft, kann KI wirklich die Macht haben, die Welt zu verändern.

Darauf aufbauend eröffnen Modelle, die wie Menschen denken, mehr Möglichkeiten für die tatsächliche Umsetzung von KI.

Oberflächlich betrachtet mag das intensive Aufkommen inländischer Inferenzmodelle am Ende des Jahres den Schatten einer „chinesischen Follower-Innovation“ haben, aber wenn man genauer hinschaut, wird man feststellen, dass sowohl die Tiefe der Open-Source-Strategie als auch die technischen Details Was die Genauigkeit angeht, haben chinesische Hersteller immer noch einen einzigartigen Entwicklungspfad gefunden.

# Willkommen beim offiziellen öffentlichen WeChat-Konto von Aifaner: Aifaner (WeChat-ID: ifanr) wird Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner |. Ursprünglicher Link · Kommentare anzeigen · Sina Weibo