Der Grund, warum ChatGPTs schwer zu replizieren ist, liegt darin, dass neben dem Verbrauch von Grafikkarten auch die Wasser- und Stromrechnung zu teuer ist?

Als ich aufwachte, veränderte sich die Welt erneut.

Nachdem ChatGPT in die Öffentlichkeit gerückt war, hat die AIGC-Industrie vor allem im letzten Monat eine Explosion eingeläutet, als ob jeder Tag ein „historischer“ Tag sein könnte.

Die durch ChatGPT repräsentierte generative KI scheint fortgeschritten zu sein, erscheint der Öffentlichkeit jedoch in einer äußerst „klassischen“ interaktiven Form.

Es hat weder ausgefallene Symbole noch ein tief verwurzeltes UI-Design, sondern verwendet das einfachste Dialogfeld, um die Welt zu "schockieren".

![]()

Eine so einfache Form ist jedoch zum heißesten Thema im Internet und in der Realität geworden: Wie erwartet, "gut aussehende Skins sind gleich, aber interessante Seelen gibt es unter einer Million."

Es besteht nur aus einer Webseite und einer einfachen Frage und Antwort, was uns oft dazu bringt, viele Probleme zu ignorieren.

Eine nach der anderen "Antworten", die scheinbar ohne Last sind, aber dahinter steht eine Handvoll Cloud-Computing-Power der Welt.

Als ChatGPT zur Norm wurde, wurden diese hinter ChatGPT versteckten Ecken nach und nach gemeldet.

Geld und Strom verbrennen, aber auch gerne Trinkwasser

Dass die generative KI Grafikkarten verbraucht, hat etwas mit „Mining“ zu tun.

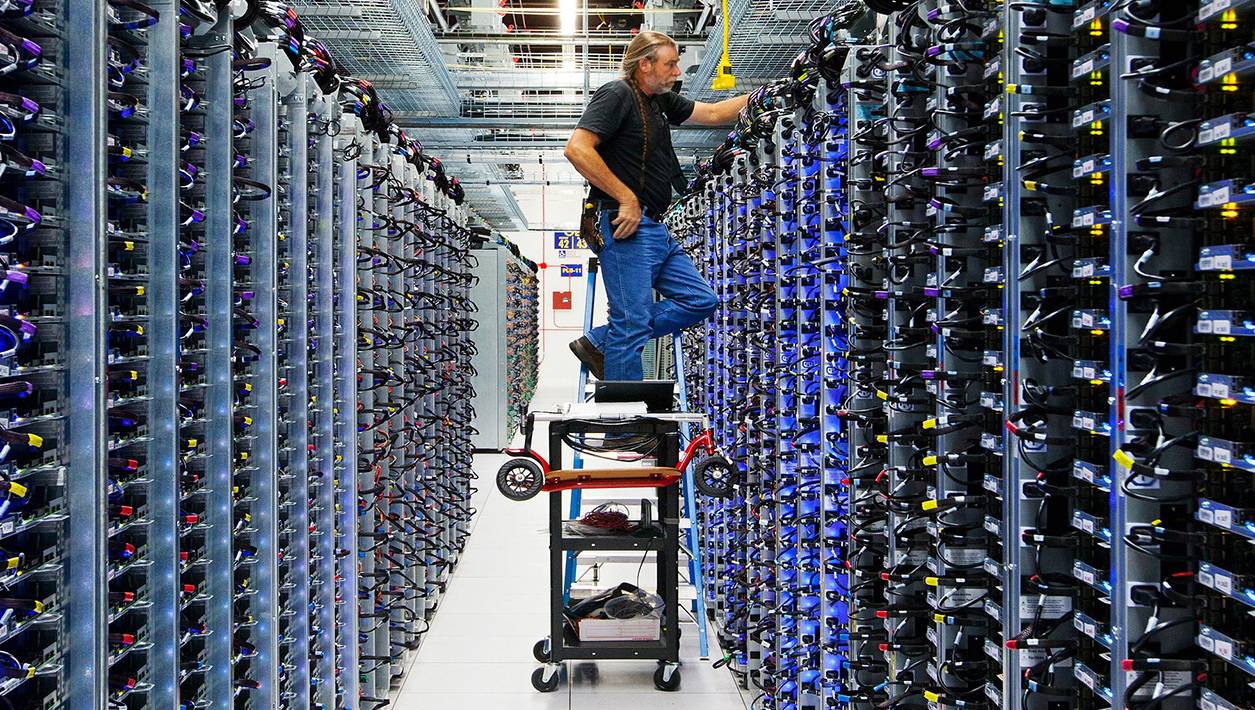

▲ Bild des Google Machine Learning Center bestehend aus TPU v4 von: Google

Beim Trainieren großer Sprachmodelle (LLMs) gilt: Je mehr Parameter, desto besser die Leistung. Das LLM hat 2018 etwa 100 Millionen Parameter und muss jetzt etwa 200 Milliarden Parameter trainieren.

Deren Betrieb erfordert GPUs mit stärkerer Rechenleistung, Nvidia brachte 2020 auch die entsprechende A100-Hochleistungs-GPU auf den Markt und kann auch acht A100 zu einem DGX A100-Server packen.

▲ Die spirituelle Nahrung der KI

Diese Rechenserver oder Grafikkarten werden schließlich in sogenannten Cloud-Rechenzentren wie dem Cloud-Dienst Azure von Microsoft platziert.

Das Trainieren eines großen Sprachmodells erfordert nicht nur viel Rechenleistung, sondern wenn jeder Benutzer eine Anfrage stellt und ChatGPTs einmal darauf antworten, muss ein Teil der Rechenleistung abgerufen werden.

Traffic ist Geld, ich denke, OpenAI und Microsoft sollten ein unvergessliches Erlebnis haben.

Laut Similarweb verzeichnete ChatGPT im vergangenen Monat weltweit 1,6 Milliarden Besuche, fast dreimal so viele wie im Januar.

Obwohl Microsoft in diesem Fall bereit war, mehr als 10.000 A100 für ChatGPT vorzubereiten, konnte OpenAI angesichts eines solchen Datenverkehrs immer noch nicht durchhalten, und es gab Ausfallzeiten, Kontosperrungen und die Aussetzung der Aktivierung der Plus-Mitgliedschaft.

Einige Leute haben geschätzt, dass Microsoft, um den aktuellen Datenverkehr zu verbrauchen, Zehntausende von A100- und H100-Grafikkarten kaufen muss, und die aktuelle Rechenleistung von Azure ist bei weitem nicht genug.

Aber der Kauf von mehr Grafikkarten wird neben der Geldverbrennung auch viele Probleme verursachen.

Der aus acht A100 bestehende DGX A100-Server kostet etwa 199.000 US-Dollar und hat eine maximale Leistung von 6,5 kW.

Auf 10.000 Stück gerechnet, wird Microsoft allein für die Hardware 250 Millionen US-Dollar ausgeben, die für einen Monat Betrieb 5,85 Millionen Kilowattstunden Strom verbraucht und die Stromrechnung bezahlt werden muss.

Nach den vom National Bureau of Statistics veröffentlichten Daten beträgt der monatliche Stromverbrauch der chinesischen Einwohner etwa 69,3 kWh. ChatGPT läuft einen Monat, was in etwa dem Stromverbrauch unserer 80.000 Mitarbeiter entspricht.

Schaffen Sie neben dem Wert der Grafikkarte selbst und der für ihre Wartung erforderlichen Energie eine kühle Umgebung für sie und konfigurieren Sie ein Verdunstungskühlgerät.

Das Prinzip ist auch relativ einfach, nämlich die Verwendung von verdunstetem Wasser zur Wärmeableitung, aber für den Betrieb muss viel sauberes Wasser verbraucht werden, und während des Zirkulationsprozesses werden etwa 1% bis 2% des Wassers weggeblasen vom Wind als feiner Wassernebel.

Wasser behält zwar makroskopisch ein dynamisches Gleichgewicht, ist aber in der kleinen Umgebung des Kühlturms ein unsichtbarer Verbrauch.

In Kombination mit dem Rechenzentrum von AIGC, das eine enorme Rechenleistung erfordert, schätzten Forscher der University of Colorado und der University of Texas in dem Papier den Wasserverbrauch während des Trainingsprozesses.

Im Fall von GPT-3 entspricht die Menge an sauberem Frischwasser, die für das Training benötigt wird, der Menge, die zum Füllen der Kühltürme eines Kernreaktors benötigt wird. Sicher genug, KI wird irgendwann mit Atomkraft verbunden sein.

Wenn es genauer ist, verbraucht es etwa 700.000 Liter, und sie haben auch berechnet, dass das Gespräch eines Benutzers mit ChatGPT für 25 bis 50 Fragen ungefähr gleichbedeutend damit ist, ChatGPT zu bitten, 500 ml Wasser zu trinken.

Gleichzeitig fanden sie heraus, dass bei Betrieb des Verdunstungskühlturms im Durchschnitt eine Gallone Wasser (3,78 l) für jede verbrauchte Kilowattstunde Strom verloren geht.

Tatsächlich ist es nicht nur Microsoft, Google verbrauchte 2019 mehr als 2,3 Milliarden Gallonen sauberes Wasser für seine drei Rechenzentren.

▲ Bild des Rechenzentrums von Google von: Google

In den kontinentalen Vereinigten Staaten hat Google 14 Rechenzentren, die Rechenleistung für seine Suche und jetzt LaMDA und Bard bereitstellen. Und der Prozess des Trainierens des LaMDA-Sprachmodells ist energie- und wasserintensiver als GPT-3.

Es stellt sich heraus, dass KI nicht nur für Grafikkarten Geld ausgibt, sondern in einem großen Haus mit konstanter Temperatur lebt und einen überraschend guten Appetit hat, Strom isst und Wasser trinkt.

Der KI-Abgrund überall

In der AIGC-Branche demonstriert ein einfaches Dialogfeld, das genau antworten kann, nicht nur technische Stärke, sondern auch starke finanzielle Stärke.

Dr. Sasha Luccioni sagte, dass nur wenige Unternehmen und Organisationen auf der Welt die Ressourcen haben, um große und komplexe Sprachmodelle zu schulen.

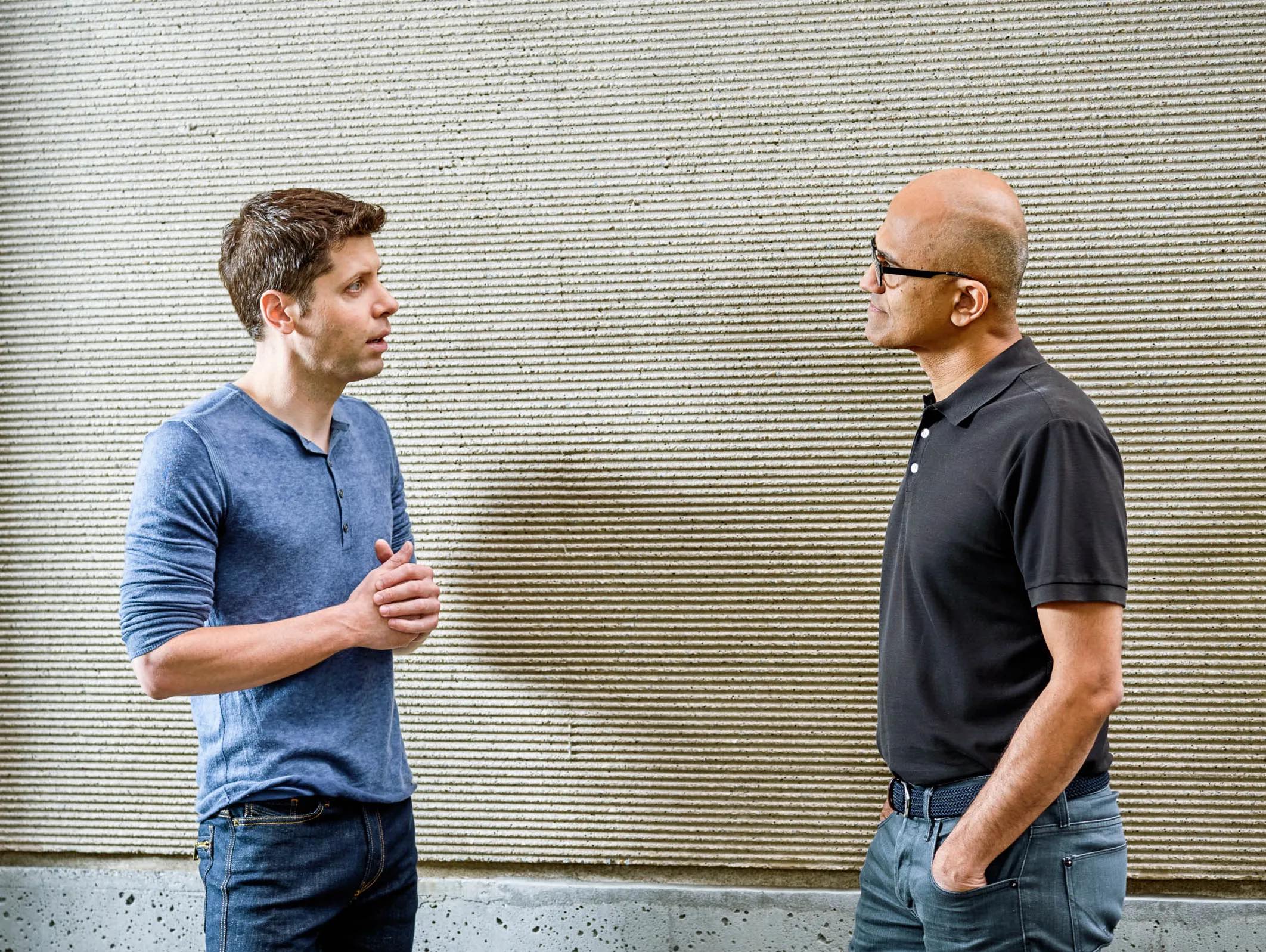

▲ Sam Altman (links) und Microsoft-CEO Satya Nadella (rechts) Bild aus: Wired

Am Beispiel von GPT-3 liegen die Kosten für das Training von 180 Milliarden Parametern bei etwa 4,6 Millionen US-Dollar, ohne den späteren Betrieb und die iterative Wartung usw.

Diese materiellen und immateriellen Kosten, die während des Betriebs entstehen, sind für viele Unternehmen schwer zu tragen.

Infolgedessen gibt es in der AIGC-Welle unsichtbar eine solche KI-Lücke, und sie ist wahrscheinlich in zwei Arten von Unternehmen unterteilt.

Das eine ist ein großes Technologieunternehmen, das es sich leisten kann, Geld auszugeben, und das fortschrittliche und komplexe große Vorhersagemodelle trainieren kann. Die anderen sind gemeinnützige Organisationen und kleine Unternehmen, die sich die Kosten nicht leisten können.

In vielen Forschungsberichten darüber, wie viel Strom und Ressourcen AIGC verbraucht, verwenden die meisten von ihnen GPT-3 oder verwenden Wörter wie „geschätzt“.

Genau wie bei der Forschung, wie viel Wasser zum Trainieren von GPT-3 verwendet wurde, da OpenAI die für das GPT-3-Training benötigte Zeit nicht offenlegte, können die Forscher anhand der veröffentlichten Daten des Kühlturms des Azure-Rechenzentrums nur schätzen von Microsoft.

Eine Reihe von Referenzdaten wie die CO2-Emissionen werden hauptsächlich aus dem Bert-Trainingsmodell im Jahr 2019 vorhergesagt.

Neben Hard Power wie Funds, GPUs, Rechenzentren, Netzwerkbandbreite etc. haben Google und Microsoft auch den Trainingsalgorithmus, Ablauf, Zeit, Parameter etc. des großen Sprachmodells als Top Secrets gelistet.

Wir möchten es nur über die bereitgestellte API verwenden und verstehen oder direkt ChatGPT oder Bard selbst fragen.

Unsichtbar ist daraus auch eine „KI-Lücke“ geworden.

AIGC entwickelt sich so schnell und seine Fähigkeiten erweitern sich auch unendlich, viele Länder, Regionen und Organisationen überlegen, wie sie einige Normen für AIGC aufstellen können, damit es nicht rücksichtslos handelt (Selbstbewusstsein erzeugt, zu erwachen beginnt …).

Aber genau wie verwandte Forscher hat AIGC (wie GPT-4) derzeit fast keine öffentlichen Informationen und ist eher wie eine Black Box.

Es ist wahr, dass AIGC für große Unternehmen der Beginn der nächsten neuen Ära sein kann, und es ist verständlich, technologische Barrieren zu gestalten.

Aber beim Ressourcenverbrauch, sei es für den Gesetzgeber oder für die Allgemeinheit, sollte eine gewisse Transparenz gewahrt werden,

Aus diesem Grund graben Forscher weiter und TD bezahlt dafür, während KI Komfort bietet.

Die Entwicklung der KI ist eigentlich eine Mondlandung für die Menschheit

Die Forschung zum KI-Energieverbrauch, den CO2-Emissionen und dem neuesten Wasserverbrauch verurteilt oder widersetzt sich nicht der Entwicklung der AIGC, die Ressourcen im Austausch für technologische Verbesserungen verwendet.

Diese Daten stellen tatsächlich eine andere Perspektive der AIGC-Branche dar. Hinter den menschenähnlichen Antworten, was haben wir oder große Technologieunternehmen dafür bezahlt?

Es geht nicht darum, Google und Microsoft aufzufordern, sofort CO2-Neutralität zu betreiben und für den Verbrauch von Wasserressourcen, Strom und einige indirekte Umweltprobleme zu bezahlen, damit sie Google Green oder Green Soft werden können.

Der Ausbruch von AIGC ist weder ein Cluster noch eine einfache technologische Explosion, sondern deckt eine ganze Reihe von Industrieketten dahinter ab und ist eher ein „Erfolg“.

Die Steigerung der Rechenleistung des Cloud-Rechenzentrums großer Unternehmen, die effiziente Berechnung komplexer Algorithmen durch die GPU und die Komplexität der Parameter des großen Sprachmodells, gekoppelt mit dem AIGC-Unternehmen selbst, hat unabhängig von den Kosten investiert.

▲ Große Rechenzentren sind nur ein Teil der AIGC-Industrie

Vor dem Aufkommen von GPT-3 waren die Fähigkeiten von KIs relativ unausgereift, und die Öffentlichkeit erkannte nicht, dass KI die Welt verändern könnte.

Aber mit dem Aufkommen von GPT-4, Midjourey V5 usw. ist AIGC endgültig zum Liebling des Silicon Valley geworden.

In diesem Moment haben auch große Unternehmen wie OpenAI, Microsoft und Google vorläufige Ergebnisse beim Ressourcenverbrauch und der Nutzung großer Rechenleistung erzielt.

▲ Stills von „Für alle Menschen“

In ähnlicher Weise ähnelt der aktuelle AIGC-Knoten dem Moment, als Armstrong zum ersten Mal den Mond betrat.

Die Mondlandung verbrauchte damals erhebliche finanzielle und finanzielle Ressourcen, aber so genanntes Wasser und verfügbare Ressourcen gab es auf dem Mond (vorübergehend) nicht.

Aber es lässt sich nicht leugnen, dass es bedeutungslos ist, zum Mond zu gehen, genauso wie viele Ressourcen und finanzielle Ressourcen aufzuwenden, um KI zu füttern und AIGC zu entwickeln.

Allerdings kann niemand sagen, wie sich AIGC entwickeln wird, vielleicht wie Skynet in „Terminator“ oder CP30 in „Star Wars“, mit unendlichen Möglichkeiten.

#Willkommen beim offiziellen öffentlichen WeChat-Konto von Aifaner: Aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so bald wie möglich präsentiert.

Ai Faner | Ursprünglicher Link · Kommentare anzeigen · Sina Weibo