Die lauteste Nacht! Googles Version von ChatGPT ist offen, Nvidia hat eine Atombomben-Grafikkarte abgeworfen… Als ich aufwache, hat sich die KI wieder verändert

Der „iPhone-Moment“ von AI ist gekommen

Auf der gerade zu Ende gegangenen Konferenz Nvidia GTC 2023 wiederholte Nvidia-CEO Huang Renxun diesen Standpunkt dreimal.

Wie man versteht?

Die vom iPhone getragene Multi-Touchscreen-Technologie hat einen brandneuen Interaktionsmodus der Smartphone-Schnittstelle geschaffen, der das mobile Internet hervorgebracht hat.

Das Aufkommen von KI-Superanwendungen wie ChatGPT und Stable Diffusion stellt die Reife von Accelerated Computing und KI-Technologie dar. KI dringt mit beispielloser Geschwindigkeit in alle Lebensbereiche ein und fördert eine neue industrielle Revolution.

Nach der kontinuierlichen Weiterentwicklung der KI-Technologie in den letzten Jahren bieten leistungsstarke Rechenleistung und fortschrittliche Modelle eine geeignete Anwendungsplattform für KI, was verschiedene Hersteller dazu veranlasst, ihre Produkte und Geschäftsmodelle sowie die Geschwindigkeit von Update-Iterationen neu zu denken.

Letzte Nacht haben Nvidia, Microsoft, Google, Adobe und andere Hersteller fast gleichzeitig ihre jeweiligen KI-Dienste gestartet.Der Trend, sich gegenseitig zu jagen, scheint die gleiche Angst zu vermitteln:

"Wenn Sie in dieser Ära der großen KI nicht von anderen untergraben werden wollen, müssen Sie zuerst andere untergraben."

Wie wird KI unser Leben verändern? Nachdem Sie diese "AIGC's Most Volumed Night" gesehen haben, haben Sie vielleicht ein tieferes Gefühl.

Nvidia bringt KI in jede Branche

Nvidia hat auf der jährlichen GTC-Konferenz viele auffällige „neue Aktivitäten“ mitgebracht.

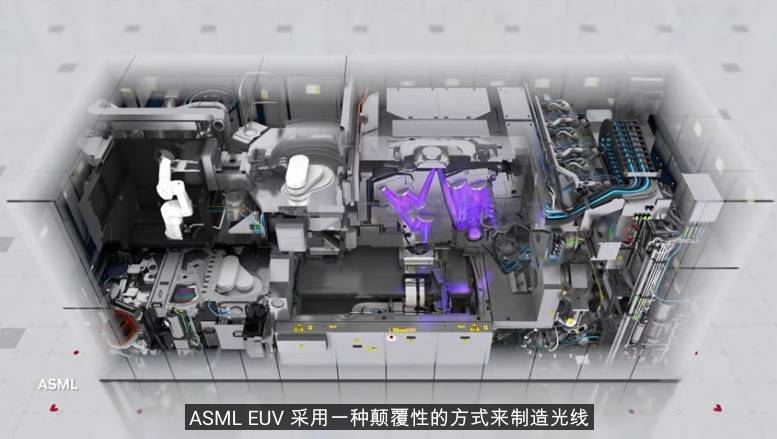

Beispielsweise veröffentlichte es eine KI-gestützte Kernherstellungstechnologie namens CuLitho, die den Weg für den 2-nm-Prozess ebnete, kooperierte mit Autoherstellern wie Lotus, Mercedes-Benz und BMW und nutzte Omniverse zum Aufbau digitaler Produktionslinien.

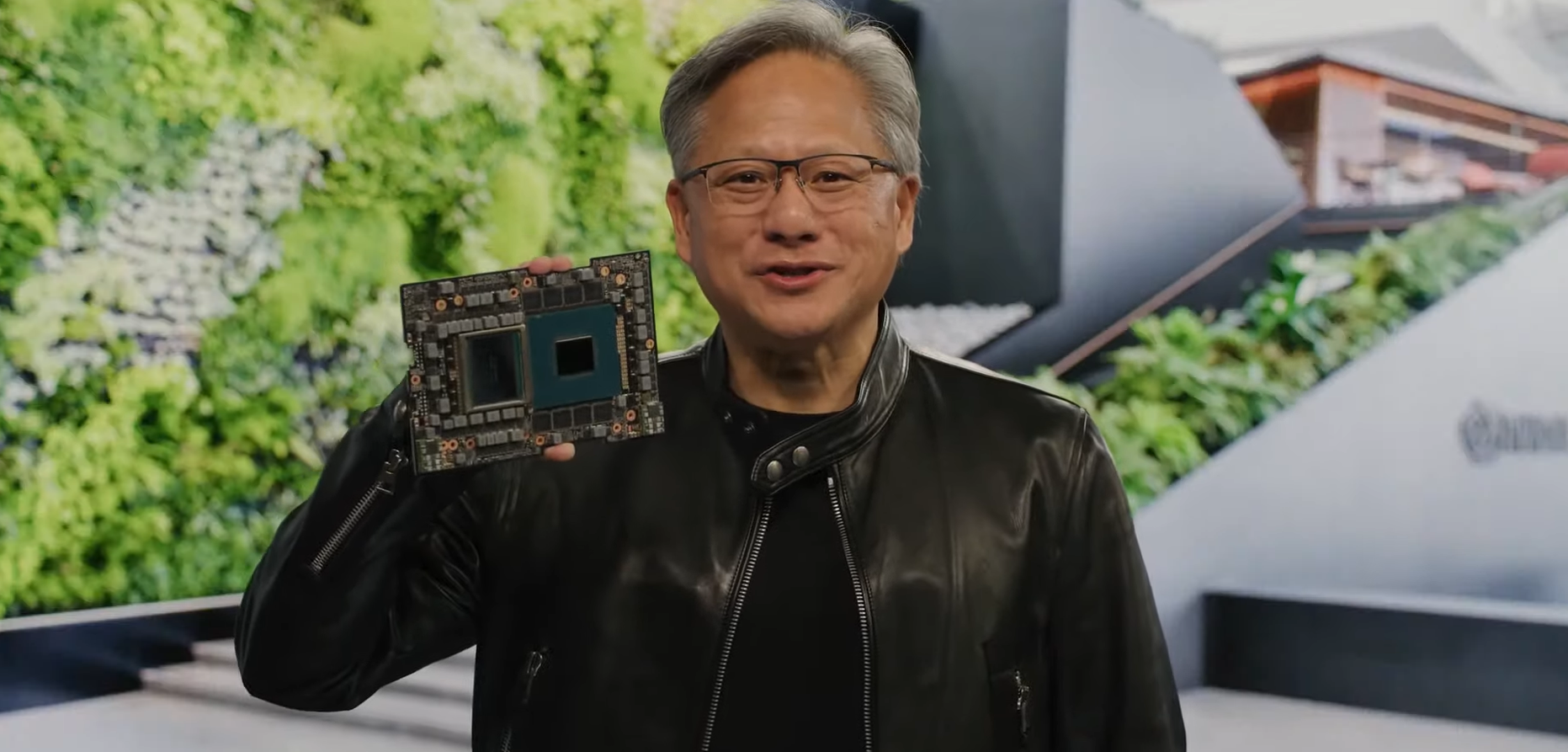

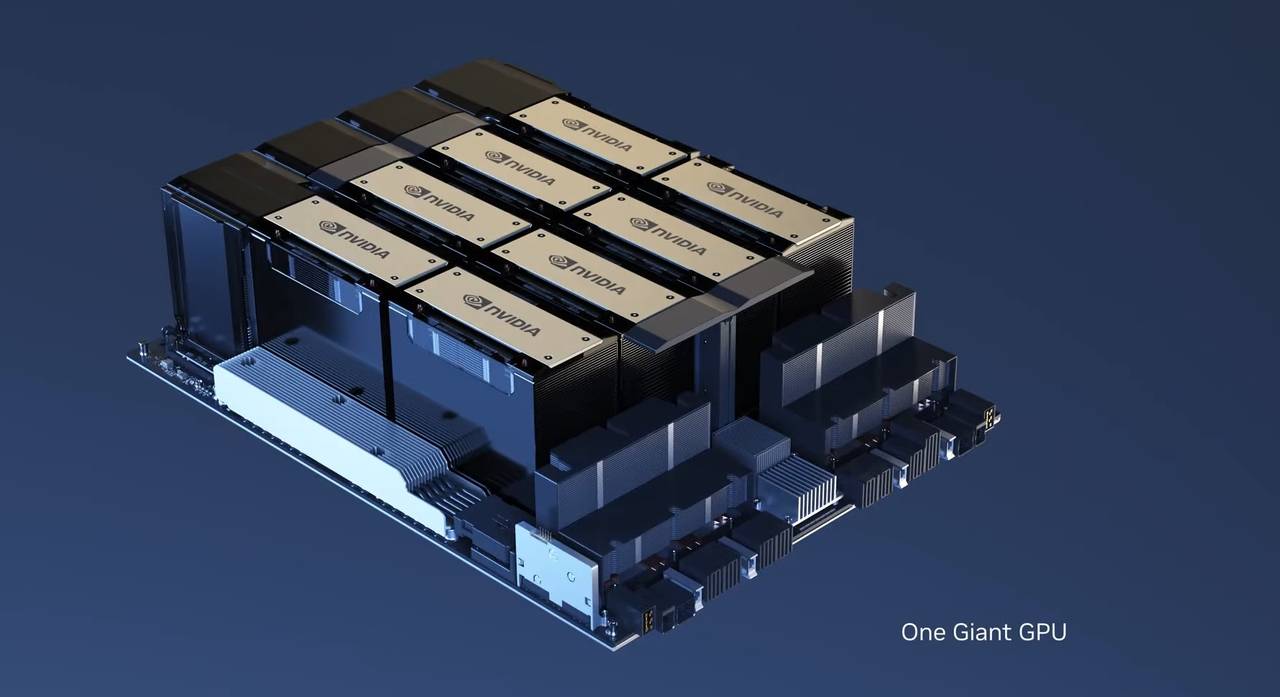

Aber wenn es um den auffälligsten Inhalt der gesamten GTC-Konferenz geht, muss es die neue Grafikkarte sein, die von Nvidia veröffentlicht wurde – die H100 NVL mit Dual-GPU-NVLink.

H100 NVL ist eine Grafikkarte, die speziell für ChatGPT entwickelt wurde, was eine enorme Rechenleistung erfordert. H100 NVL verfügt über übertriebene 188 GB HBM3-Speicher (94 GB pro Karte), die derzeit größte von Nvidia veröffentlichte Speicherkarte.

Ein großes Sprachmodell wie GPT verbraucht viele Speicherressourcen, ein GPT-Modell mit hunderten Milliarden Parametern kann theoretisch schnell eine H100-Grafikkarte füllen.

Verglichen mit dem HGX A100 für die GPT-3-Verarbeitung, einem Standardserver mit vier H100-Paaren und Dual-GPU-NVLink, ist er 10-mal schneller. Die „Atombombe“ H100 NVL ist ideal für den groß angelegten Einsatz von Sprachmodellen wie ChatGPT.

Eine weitere große Aufgabe von Nvidia ist es, das „ChatGPT same model“ in die Cloud zu verlagern und der Öffentlichkeit zugänglich zu machen.

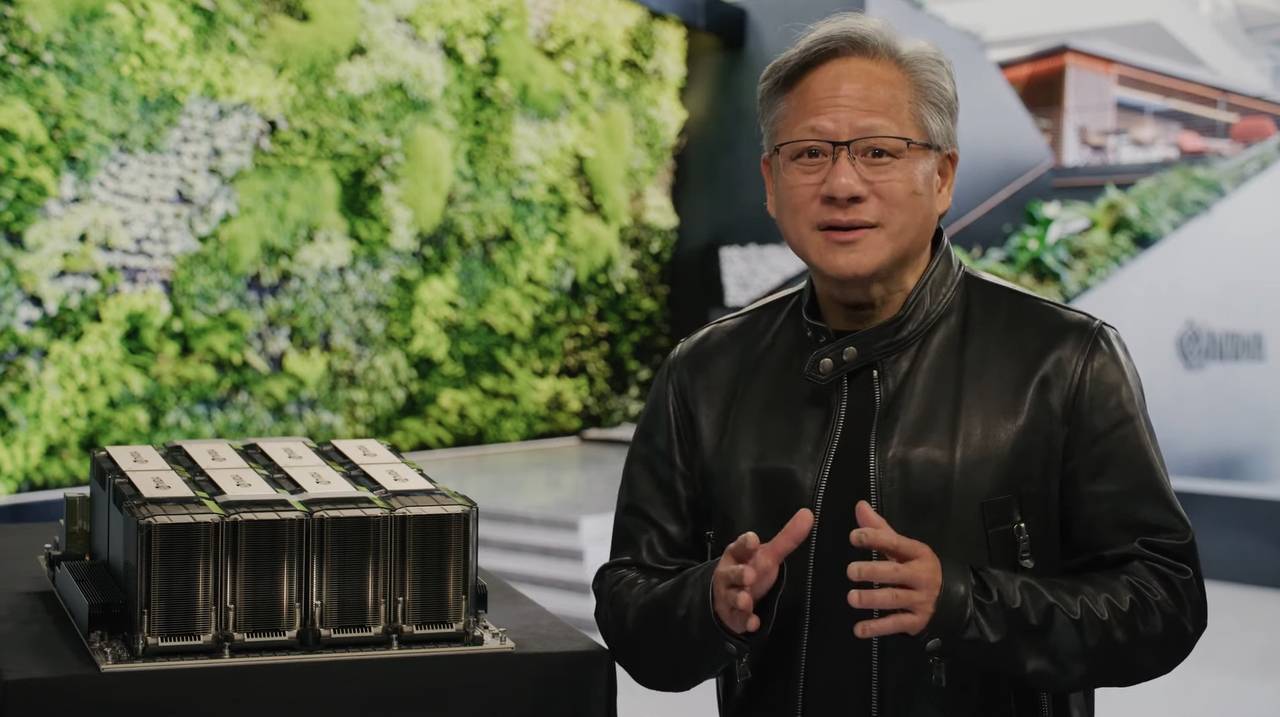

Der Betrieb von ChatGPT stützt sich hauptsächlich auf den DGX-Supercomputer, bestehend aus A100 oder H100. Microsoft hat Hunderte Millionen Dollar ausgegeben, um Zehntausende von A100-Grafikkarten zu kaufen, um die Cloud-Computing-Plattform Azure zu bilden.

Um die Kosten für die Bereitstellung großer Modelle für Benutzer zu senken, hat Nvidia den DXG Cloud-Dienst gestartet.Ab 36.999 $ pro Monat können Sie einen Cloud-Supercomputer mit 8 H100- oder A100-Grafikkarten erhalten, um Rechenaufgaben mit hoher Auslastung problemlos zu erledigen.

2016 übergab Lao Huang persönlich den ersten DGX-Supercomputer an OpenAI. Sieben Jahre später hat die höchste KI-Rechenleistung die Möglichkeit, über die DXG Cloud in jedes Unternehmen einzusteigen und Aufgaben zu erledigen, die in der Vergangenheit unmöglich waren.

Es ist nicht schwer vorstellbar, dass fortschrittliche Anwendungen wie ChatGPT, die die menschliche Kommunikation und Arbeitseffizienz verbessern können, weiterhin auftauchen und mehr Komfort und Überraschungen in unser Leben bringen werden.

Die zweite Generation von Runway verwandelt Stein in Gold und ermöglicht es Ihnen, alle Arten von Blockbuster-Filmen in einem Satz zu erstellen

An Station B gab es schon immer einen beliebten Stalker: Videos können nicht gepostet werden, das stimmt also. Aber jetzt können Videos nicht nur P, sondern auch direkt mit KI von Grund auf neu generiert werden, ohne Maler, Fotografen oder Nachbearbeitung. Solange Sie einen Textabschnitt in Runway eingeben, erhalten Sie ein schockierendes kurzes Video.

Runway war zunächst ein Hilfswerkzeug für die Postproduktion, das zwar die magische Kraft der künstlichen Intelligenz nutzte, aber nicht kompliziert war, was es leisten konnte: Objekte löschen, Bilder interpolieren, Hintergründe löschen, Bewegungsverfolgung usw. Es kann als Adobe angesehen werden Premiere-Plugin für Dummies.

Und als Runway der künstlichen Intelligenz eine neue Tür öffnete, hat sie die Fähigkeit, Steine in Gold zu verwandeln. In der im vergangenen September angekündigten Gen 1-Version kann Text in Video umgewandelt werden. Die Leute zu dieser Zeit hatten gerade die Magie der Text-zu-Bild-Konvertierung gesehen, und Runway konnte direkt dynamische Bilder erzeugen, was so schockierend war wie ein Schlag zur Reduzierung der Dimensionalität.

Nach einem halben Jahr ist Runway Gen 2 da.

Verglichen mit dem Gen 1-Modell erreicht es eine höhere Zeitkonsistenz und Wiedergabetreue.Menschlich gesehen ist die Verbindung zwischen den Bildern glatter und die Bildqualität höher.

Mit Gen 2 kommen Sie der Erstellung von Videos Ihrer Fantasie jederzeit und überall einen Schritt näher.

Geben Sie ein nicht zu langes Stichwort ein: Von Drohnen fotografierte Berge. Auf dieser Grundlage generiert Runway den folgenden Bildschirm.

Hier ist noch eins: Nachmittagssonne, die durch die Fenster einer Wohnung in New York City strömt.

Kommen Sie zu einer erweiterten Version, füttern Sie Runway mit Bildern und Text und erstellen Sie dann ein kurzes Video.

▲ Der Text lautet: Ein Mann geht auf der Straße, und die Neonlichter der umliegenden Bars beleuchten ihn

▲ Originalbild

Oder animieren Sie ein statisches Bild.

Es ist auch möglich, ein dynamisches Bild direkt aus einer zu rendernden Animation ohne Textur zu rendern.

Der Fortschritt von Runway ist für alle offensichtlich. Es hat sich gegenüber dem Netzwerkmodell immer weiter und reibungsloser entwickelt. Die heutige Gen 2-Version kann als "beobachtbar" angesehen werden. Obwohl sie nicht exquisit ist, kann die Zukunft erwartet werden.

Wenn es um die Gen 3-Version geht, können wir mit ihrer Hilfe vielleicht Douyin-Hit-Kurzvideos mit einem Klick erstellen. Wird dies zu diesem Zeitpunkt ein Albtraum für Qualitätsblogger sein?

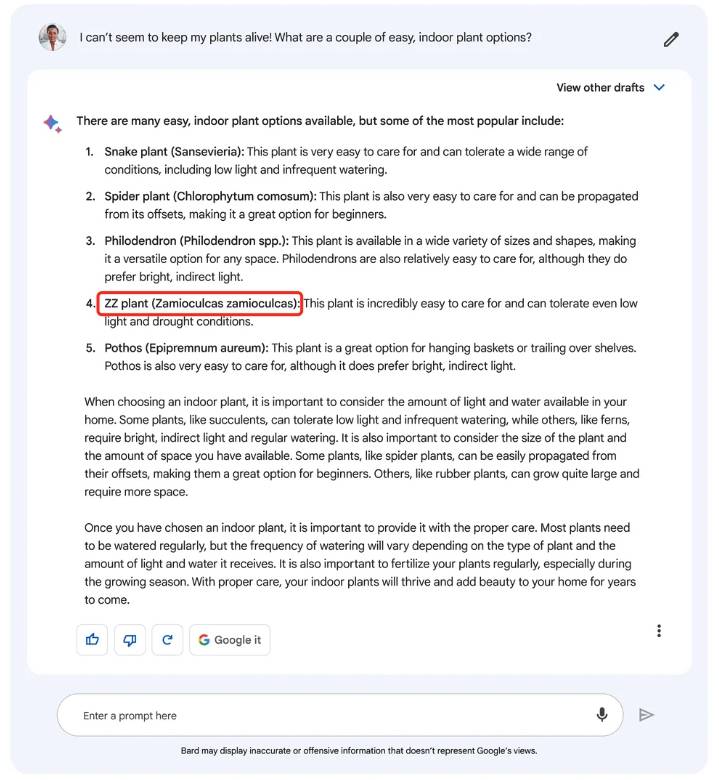

Platzen! Google beginnt mit Bard-Tests

Wenn uns Nvidia erlaubt, in die Zukunft der KI-Entwicklung zu sehen, dann ist Googles Bard die KI von heute.

Nachdem alle eine Woche lang von GPT-4 und Midjourney V5 geschockt waren, während Lao Huang sich auf die zukünftige KI-Ära freute, kündigte Google die offizielle Öffnung von Bards Zugang an: Bitte testen Sie Bard und geben Sie Ihr Feedback ab.

Laut der neuesten Demo von Google ist Bard eher ein persönlicher Assistent, der sich auf Arbeit und Lernen konzentriert, als ChatGPT. Mit seiner Hilfe können Sie Ideen anregen und Neugier befriedigen.

Sie können Bard bitten, die Quantenphysik in einfacher Sprache zu erklären, oder Bard bitten, ein Brainstorming durchzuführen und Ihnen beim Lesen von 20 Büchern in einem Jahr zu helfen.

Google sagte, dass Benutzer mit Hilfe von Bard Ideen beschleunigen und Neugier wecken können. Sie können Bard verwenden, um Tipps zu geben, wie man 20 Bücher pro Jahr liest, oder Quantenphysik in einfacher Sprache erklären.

Wir haben auch einige Details im Inhalt der Demo gefunden. Bard scheint mehrere Antworten gleichzeitig zu generieren. Sie können diejenige auswählen, die Ihren Bedürfnissen am besten entspricht, und weiter Fragen stellen.

ChatGPT kann natürlich auch mehrere Antworten generieren, wird aber nach Ende der Antwort neu generiert, im Vergleich dazu ist Bard eher eine Partei B, die mehrere Lösungen gleichzeitig bereitstellt.

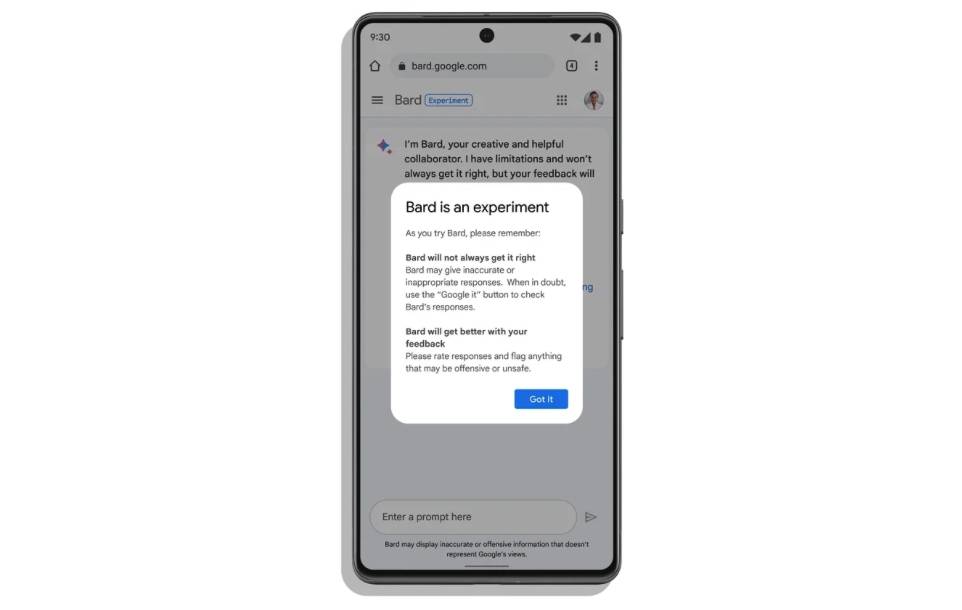

Es kann sein, dass die negativen Nachrichten von ChatGPT und Bing Chat die Aufmerksamkeit von Google auf sich gezogen haben, das ständig betont, dass Bard nur ein Experiment ist und die von Bard generierten Informationen nicht die Sichtweise von Google darstellen.

Google sagte, dass Bard, obwohl es von einem großen Sprachmodell angetrieben wird und mit der Zeit stärker werden wird, einige Vorurteile oder Stereotypen lernen wird, was dazu führt, dass es „selbstbewusst“ einige ungenaue oder falsche Informationen sagt, zum Beispiel „ZZ Plant“ versteht. als Zamioculcas zamioculcas anstelle der korrekten Zamioculcas zamiifolia.

Mit den Lehren aus „Crazy“ von Bing Chat begrenzte die erste Beta-Version von Bard die Anzahl der Austauschvorgänge in derselben Konversation, um die Genauigkeit des Inhalts sicherzustellen. Wenn Sie sich zum ersten Mal bei Bard anmelden, wird Ihnen mitgeteilt, dass dies ein Experiment ist, und Sie freuen sich auf Ihr Feedback.

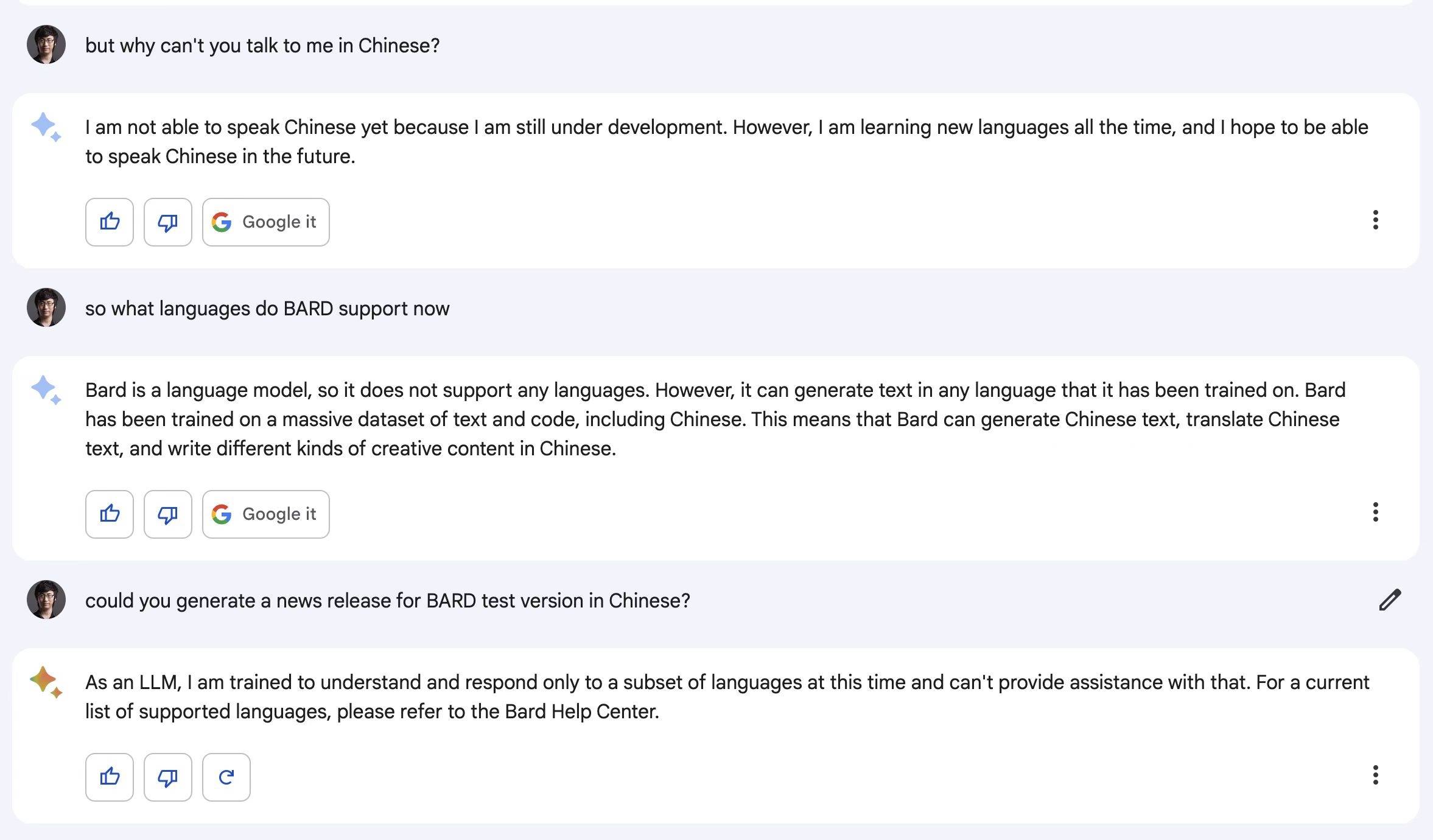

Als erste Version von Bard unterstützt es noch nicht mehr Sprachen (einschließlich Chinesisch), und Google wird das Schreiben von Code, die Bilderkennung/-generierung und die Unterstützung mehrerer Sprachen weiter aktualisieren.

▲ Bard: Ich kann kein Chinesisch, aber ich hoffe, in Zukunft Chinesisch sprechen zu können

Derzeit ist Bard nur in Großbritannien und den Vereinigten Staaten zugänglich und wird in Zukunft schrittweise auf weitere Länder und Regionen ausgeweitet.

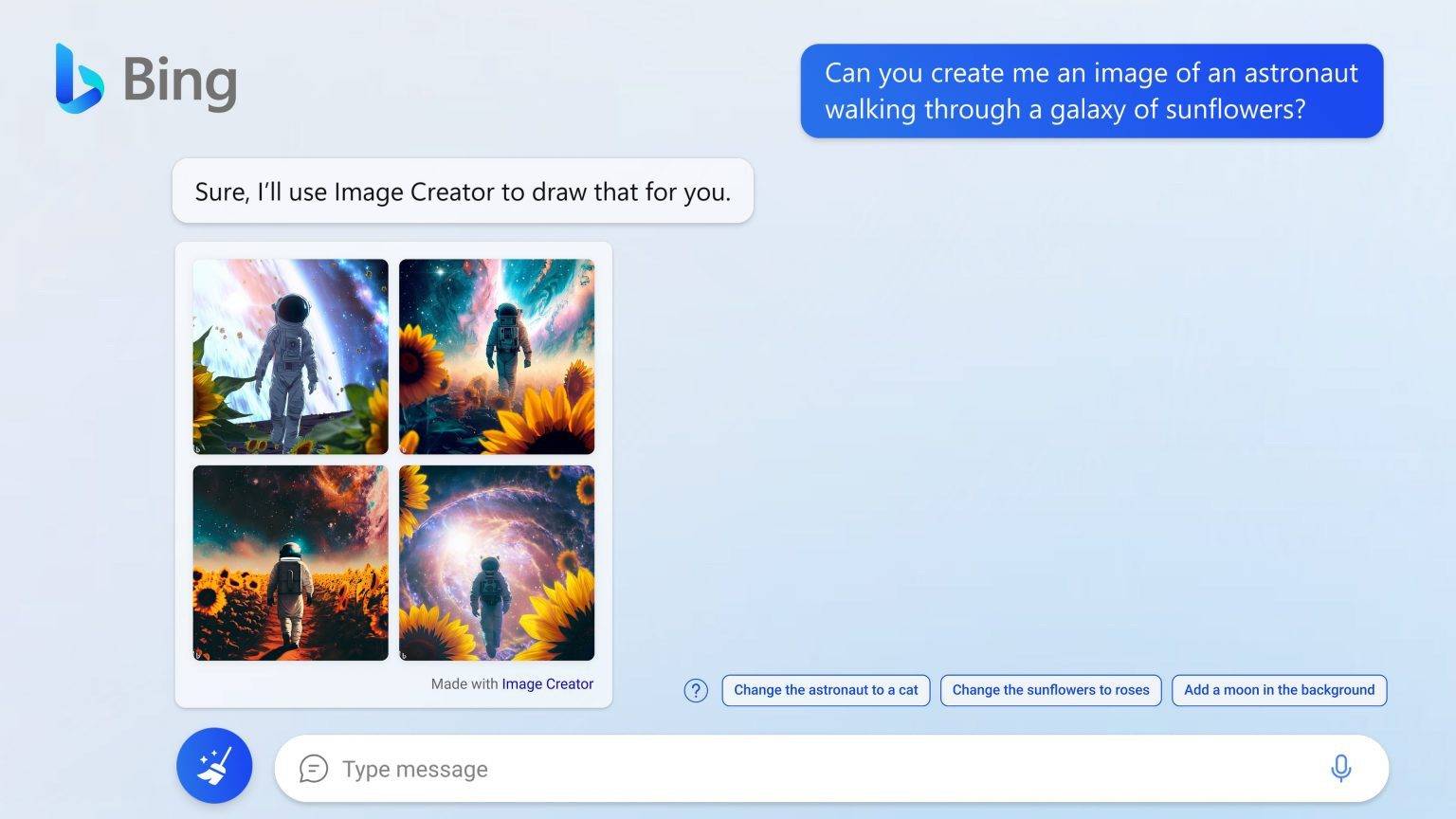

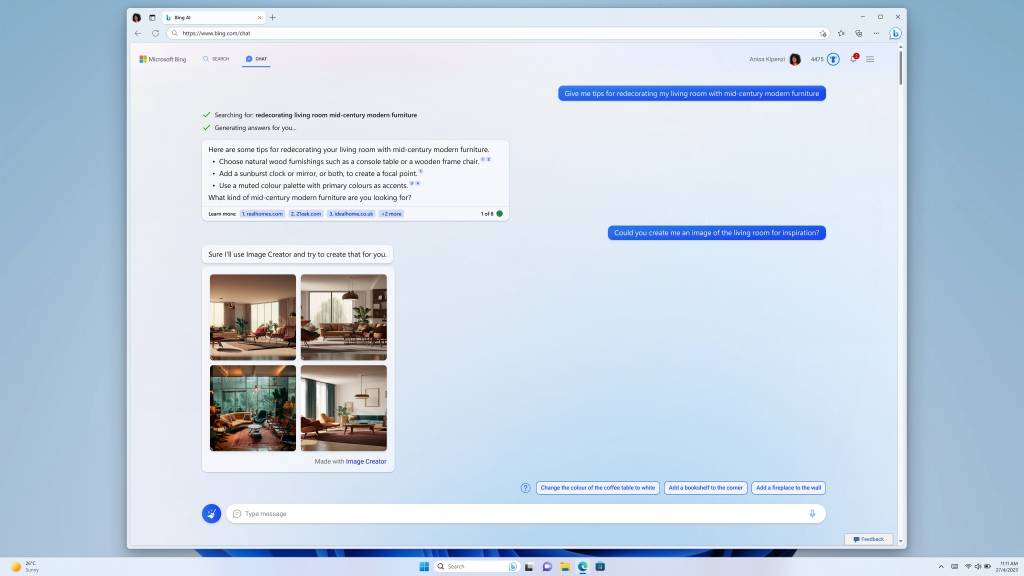

Sie können während des Chats Bilder machen, Bing Chat geht noch einen Schritt weiter

Wie beliebt Bing Chat ist, können vielleicht nur die Daten erklären, dass Bing DAU zum ersten Mal nach seinem Start 100 Millionen überschritten hat. Von komplexen Fragen über unterhaltsame Chats bis hin zu umgesetzten Ideen – Bing Chat verändert die Art und Weise, wie wir im Internet suchen.

Von nun an können Sie Bing Chat bitten, Bilder zu zeichnen.

Microsoft hat die Vorschauversionen der neuen Bing- und Edge-Browser mit drei neuen Funktionen aktualisiert: Bing Image Creator, AI-driven Stories und Knowledge Cards 2.0. Das wichtigste davon ist der Bing Image Creator, der Bilder zeichnen kann.

Laut Microsoft verarbeitet das menschliche Gehirn visuelle Informationen etwa 60.000-mal schneller als Text. In den Suchdaten von Bing stellen Bilder eine der am häufigsten gesuchten Arten dar. Bing Image Creator, angetrieben von einer erweiterten Version des DALL·E-Modells, kann uns das ermöglichen Verwenden Sie unsere eigene Sprache, um die Bildinformationen in Bing Chat zu beschreiben, wählen Sie den Kunststil aus, und Image Creator verbindet den Kontext und "zeichnet Ihre Fantasie auf Papier".

Die Hinzufügung von Bing Image Creator macht den Edge-Browser zum ersten Browser, der einen Bildgenerator für künstliche Intelligenz integriert.

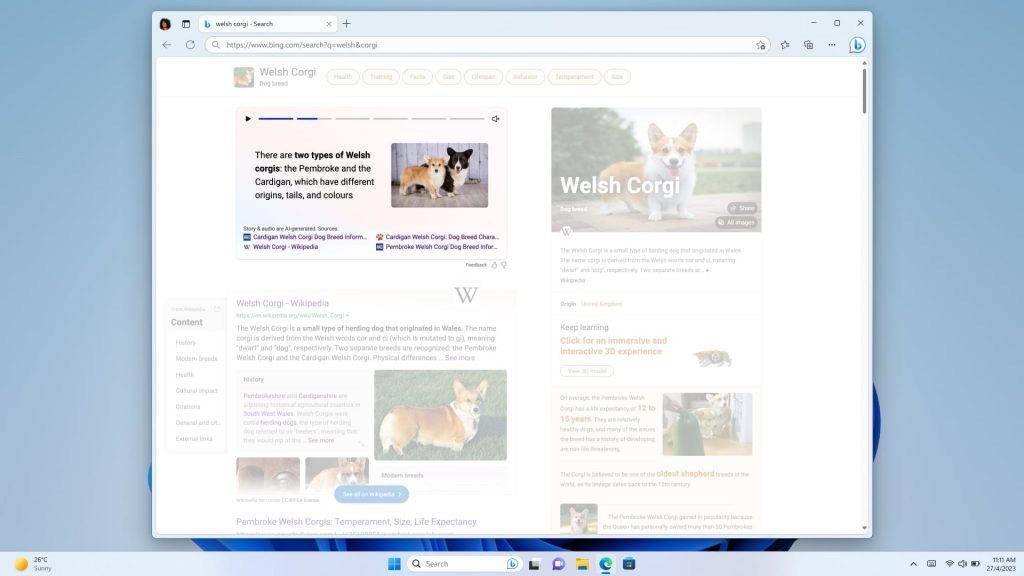

Geschichten und Wissenskarten 2.0 mit künstlicher Intelligenz ermöglichen es Ihnen, nach der Suche Bilder, kurze Videos und Infografiken zu erhalten, die von künstlicher Intelligenz gesteuert werden, und Sie können Fakten und wichtige Informationen auf einen Blick erhalten.

Wenn Sie in Zukunft Bing für die Suche verwenden, erhalten Sie keine kalten Weblinks, sondern reichhaltigere und interessantere Bilder, Videos und visuelle Geschichten.

Wenn Sie sich über das neue Bing beworben haben, können Sie Bing Image Creator jetzt im Bing-Chat erleben, und wenn Sie über die folgende URL eintreten, können Sie es direkt ausprobieren.

https://www.bing.com/create

Diese Funktion unterstützt jedoch vorerst nur Englisch und wird in Zukunft weiter aktualisiert.

Adobe Firefly: „Die stärkste Unterstützung unter den Verbündeten“

Wenn Technologieunternehmen in die Generierung von Bildern eingreifen, ist natürlich auch das renommierte Design- und Kreativunternehmen Adobe nicht weit entfernt. In dieser verrückten Nacht brachte Adobe auch seine eigene Sammlung kreativer generativer KI-Modelle auf den Markt: Adobe Firefly.

Adobe demonstrierte die Fähigkeiten von Firefly anhand einiger einfacher Beispiele. Mit einem Satz lässt sich die Landschaft vom Frühling in den Winter verwandeln.

Sie können auch einen Pinsel auf dem Gras verwenden, um zufällig zu malen, und dann Firefly sagen, dass dies ein Fluss ist, und es wird automatisch einen Fluss erzeugen.

Natürlich kann Firefly mehr als das. Wählen Sie das Haar eines Hundes aus, es kann das Haar in eine Bürste verwandeln und dem Hund helfen, seine Frisur auf der Stelle zu ändern, entwerfen Sie eine Wortkunst, es kann Ihnen helfen, ein Wort oder einen Satz zu bilden; einen Kopfhörer designen, Firefly kann ihn auch in Szene setzen und in ein Produktdisplay verwandeln…

Adobe glaubt, dass KI eine neue Möglichkeit bietet, die Welt zu öffnen, und Designer den bequemsten Weg nutzen können, um Kreativität zu verwirklichen, indem sie „kreativen Menschen helfen, anstatt kreative Menschen zu ersetzen“.

Gleichzeitig hat Adobe auch die „Content Authenticity Initiative“ CAI ins Leben gerufen, die einen globalen Standard für die Zuordnung vertrauenswürdiger digitaler Inhalte etablierte und die durch künstliche Intelligenz generierten Inhalte markierte, um das Firefly-Ökosystem zu schaffen. Die stärkste Unterstützung.“

Angriff auf AIGC

In dieser Nacht haben wir mehrere große Durchbrüche im KI-Bereich von der Serviceschicht bis zur Anwendungsschicht erlebt.

Diese gebündelten Updates beweisen von der Seite, dass der Bereich der KI in eine Phase der rasanten Entwicklung eingetreten ist. Im vergangenen Monat konnte die KI vielleicht nicht gut Finger zeichnen, aber im nächsten Monat, mit der Steigerung der Rechenleistung und den Modell-Upgrades, kann die KI bereits die Arbeit der Kleidungsmodelle ersetzen.

Unzählige Science-Fiction-Werke haben vorausgesagt, dass KI in Zukunft ein Teil unseres Lebens werden wird, aber niemand hat uns gesagt, dass wir nur wenige Meter von dieser Zukunft entfernt sind.

Unser Leben wird Stück für Stück von KI umgeschrieben. Auf der GTC-Konferenz vertrat Huang Renxun einen interessanten Standpunkt: Er glaubt, dass die generative KI eine neue Art von Computer ist: Wir können in menschlicher Sprache programmieren, und jeder kann dem Computer befehlen, Probleme zu lösen.

In den letzten Monaten haben wir miterlebt, wie die KI nach und nach Fähigkeiten wie Zeichnen, Schreiben, Bearbeiten, Tabellieren und PPT gemeistert hat. Wenn diese Evolutionsgeschwindigkeit anhält, gibt es irgendetwas, das die KI nicht kann?

Sam Altman, CEO von OpenAI, sagte kürzlich auf Twitter mutig eine neue Version von „Moore's Law" voraus. Er glaubt, dass sich die Menge des globalen KI-Computings alle 18 Monate verdoppeln wird.

Mit anderen Worten, wenn Sie immer noch Zweifel an der generativen KI haben, wird Ihnen die Zeit die stärkste Antwort geben.

#Willkommen, auf Aifaners offizielles öffentliches WeChat-Konto zu achten: Aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so bald wie möglich präsentiert.

Ai Faner | Ursprünglicher Link · Kommentare anzeigen · Sina Weibo