Diese neuen Technologien der Meta-KI ermöglichen Robotern „Berührung“

Mit der heutigen Entwicklung von Robotern mit künstlicher Intelligenz ist es nicht mehr ungewöhnlich, dass sie über „Sehen“ oder „Hören“ verfügen. Schließlich sind diese beiden Sinne fast die wichtigsten Kanäle, über die der Mensch die physische Welt wahrnimmt.

Die kürzlich vom Basic Artificial Intelligence Research Team (FAIR) von Meta AI angekündigte neue Technologie verleiht Robotern einen „ Touch “. In diesem Zusammenhang besteht die Vision von Meta darin, der KI zu ermöglichen, „die Welt besser zu verstehen“ und „die physische Welt besser zu verstehen und zu simulieren“.

Es besteht kein Zweifel, dass diese neuen Technologien Robotern eine neue Möglichkeit bieten, mit der Welt zu interagieren, und ihnen auch ermöglichen, einen weiteren Schritt auf dem Weg zur „ Menschenähnlichkeit “ zu machen.

▲Bild von: NewsBytes

Meta arbeitet mit dem amerikanischen Sensorunternehmen GelSight und dem koreanischen Robotikunternehmen Wonik Robotics an der Entwicklung einer Reihe neuer Technologien und engagiert sich für die Kommerzialisierung taktiler Sensoren und deren Einsatz in der künstlichen Intelligenz.

Zu diesen neuen Technologien gehören drei Forschungstools – „ Sparsh “, „ Digit 360 “ und „ Digit Plexus “, die sich auf taktile Wahrnehmung, Robotergeschicklichkeit und Mensch-Computer-Interaktion konzentrieren. Darüber hinaus stellt Meta auch „ PARTNR “ vor, einen neuen Maßstab zur Bewertung von Planung und Argumentation in der Mensch-Maschine-Zusammenarbeit.

Es ist wichtig zu beachten, dass diese neuen Technologien derzeit nicht für Verbraucher eingeführt werden, sondern sich stattdessen an Wissenschaftler und Forscher richten.

▲Bild aus: Techopedia

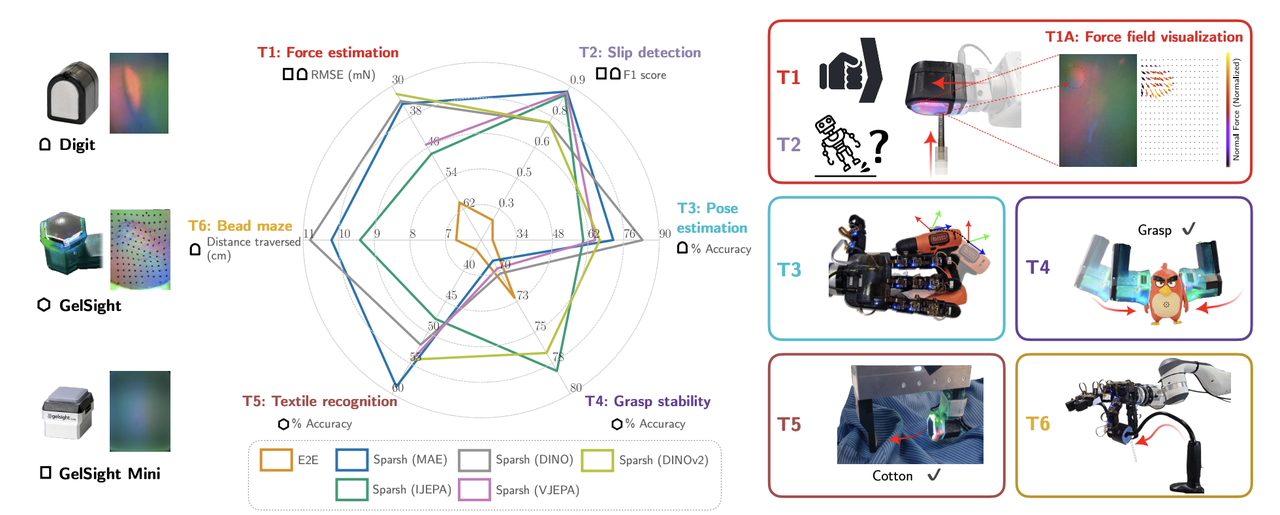

Sparsh ist das erste universelle Encodermodell für die visionsbasierte taktile Wahrnehmung , das in Zusammenarbeit zwischen der University of Washington und der Carnegie Mellon University entwickelt wurde.

Es klingt etwas abstrakt, da es „taktil“ ist. Warum basiert es dann „auf dem Sehen“?

Tatsächlich basieren herkömmliche Methoden auf manuellen Modellen spezifischer Aufgaben und Sensoren, die erfordern, dass die „ Berührungsparameter “ von Objekten (wie Kraft, Reibung usw.) in „ Gefühls-Tags “ verpackt und dem Roboter zugeführt werden Äquivalent dazu, dem Roboter zu sagen, was „Leichtigkeit“ bedeutet: „Nimm es sanft“ oder „Drücke es fest“.

Diese Methode ist jedoch umständlich, da viele solcher Tag-Daten für jede unterschiedliche Aufgabe und unterschiedliche Sensoren erfasst werden müssen.

Sparsh lernt autonom aus Erfahrung durch selbstüberwachtes Lernen (SSL) , ohne ihm die Bezeichnung zu sagen, die jeder Aktion entspricht. Es wird anhand eines großen Datensatzes mit mehr als 460.000 taktilen Bildern vorab trainiert. Das ist so, als würde man den Roboter viele verschiedene Objekte und Szenen sehen lassen und dann lernen, diese Objekte selbst zu erkennen und zu verarbeiten.

Einfach ausgedrückt ist Sparsh so, als würde man den Roboter lernen lassen, Objekte zu „fühlen“, indem er sich eine große Anzahl von Bildern und Videos ansieht , anstatt sein „Gefühl“ manuell zu benennen. Auf diese Weise kann der Roboter leichter lernen, verschiedene taktile Sensoren für verschiedene Aufgaben zu verwenden.

Interessanterweise kommt der Name „Sparsh“ aus dem Sanskrit und bedeutet „ Berührung oder Kontakt-Sinneserfahrung “, was für seine Funktion, digitale taktile Signale zu verarbeiten und eine Berührungswahrnehmung zu erreichen, sehr passend ist.

▲Bild von: Meta

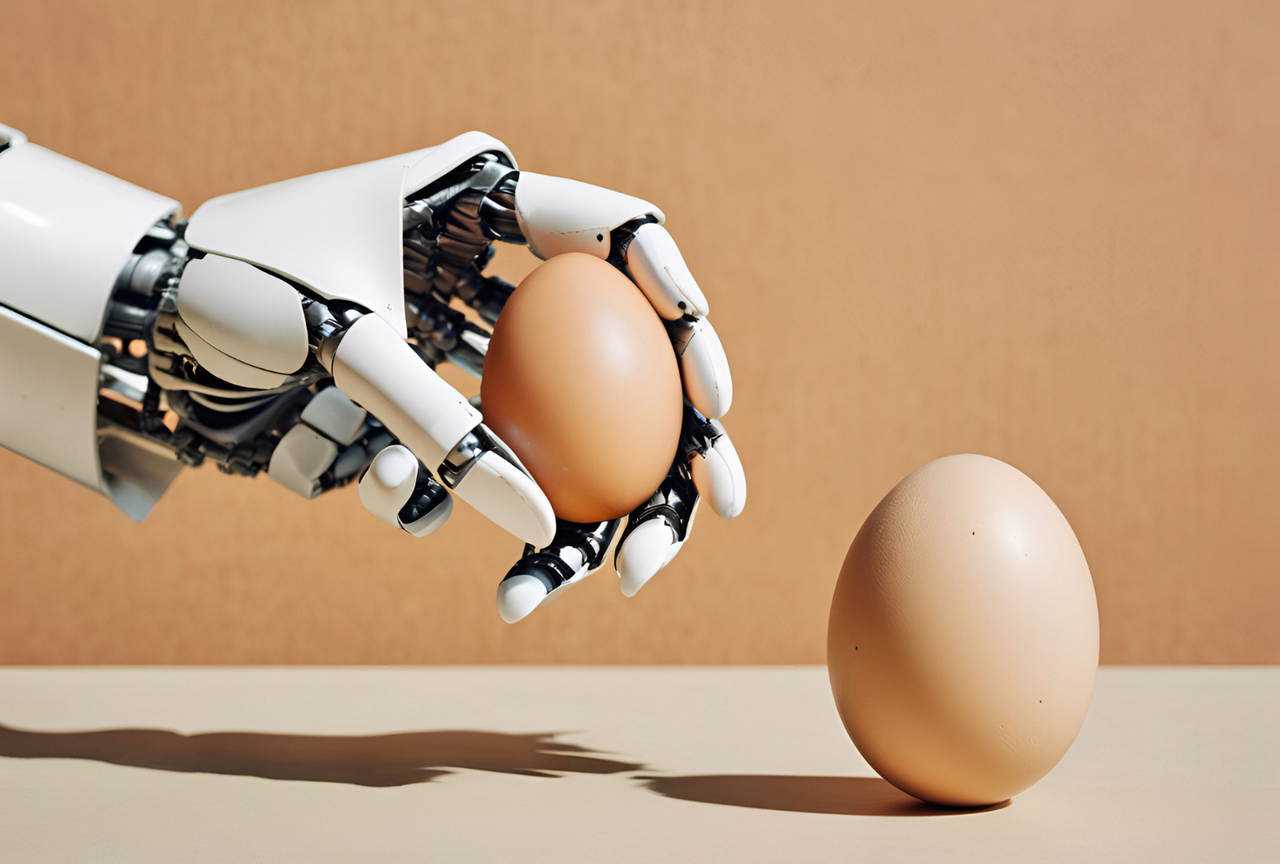

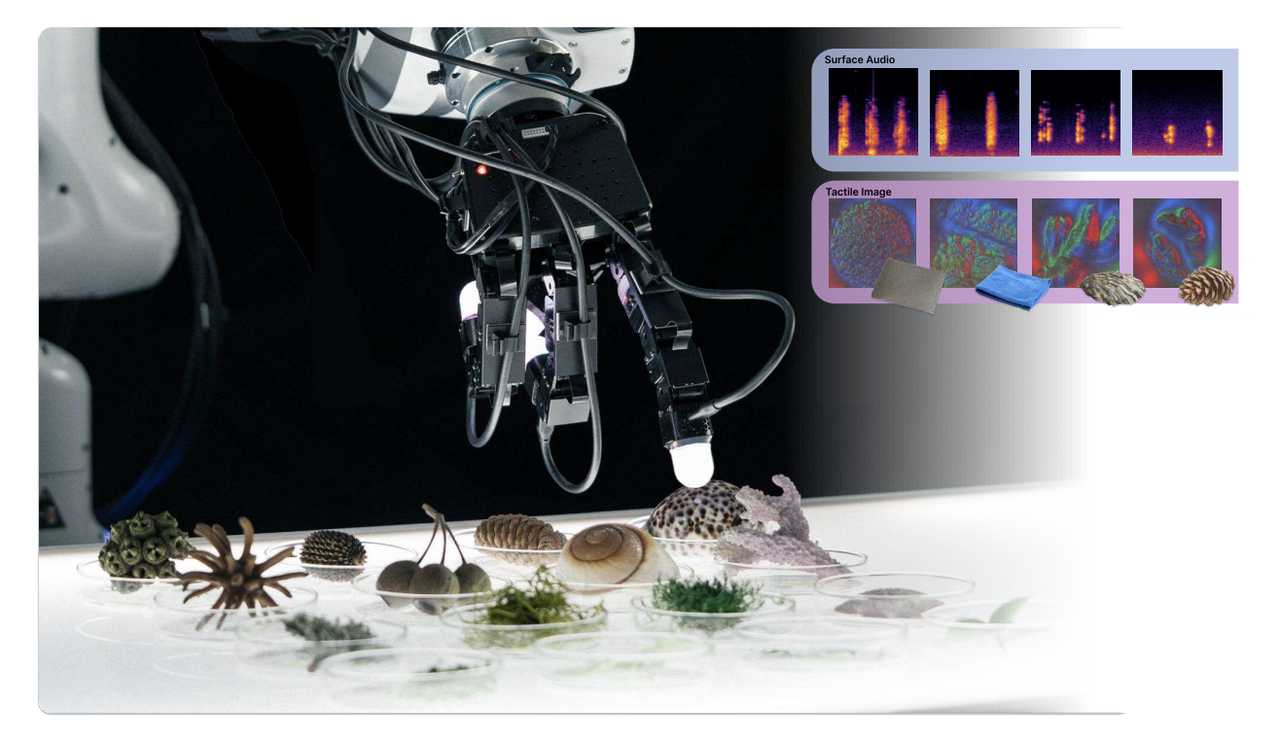

Digit 360 , ein künstlicher fingerförmiger Tastsensor, der von Meta in Zusammenarbeit mit GelSight entwickelt wurde, liefert umfangreiche und detaillierte taktile Daten, indem er Berührungen mit menschlicher Genauigkeit digitalisiert.

Ausgestattet mit mehr als 18 Sensorfunktionen ermöglicht Digit 360 Forschern die Kombination verschiedener Sensortechnologien oder die Isolierung einzelner Signale für eine detaillierte Analyse jedes Modus.

Es kann kleinste Änderungen in räumlichen Details erkennen, Kräfte von nur 1 Millinewton erfassen und verfügt über mehrere Erfassungsmodi, die Vibrationen, Hitze und sogar Gerüche erfassen können und damit frühere Sensoren deutlich übertreffen.

▲Digit 360 Tastsensor (rechts).

Das Meta AI-Team entwickelte außerdem ein dediziertes optisches Weitfeld-Berührungssensorsystem, das aus mehr als 8 Millionen Sensoreinheiten (Taxeln) besteht, um die omnidirektionale Verformung der Fingerspitzenoberfläche zu erfassen.

Darüber hinaus ist Digit 360 mithilfe von KI-Beschleunigern auf dem Gerät in der Lage, Informationen schnell zu verarbeiten, auf Berührungsreize zu reagieren und als peripheres Nervensystem des Roboters zu fungieren. Das Design ist von den Reflexbögen von Menschen und Tieren inspiriert.

Offensichtlich bietet dieser Sensor neben der Verbesserung der Flexibilität von Robotern auch breite Anwendungsaussichten in Bereichen wie Medizin, Prothetik, virtuelle Realität und Ferninteraktion.

▲Bild von: Meta

Meta sagte in einem Blog:

Die menschliche Hand ist sehr gut darin, Hautberührungsinformationen von den Fingerspitzen bis zur Handfläche an das Gehirn zu senden und so die Handmuskulatur zu aktivieren, wenn Entscheidungen getroffen werden, etwa wie man auf einer Tastatur tippt oder mit einem überhitzten Objekt interagiert. Um eingebettete KI zu erreichen, ist eine ähnliche Koordination zwischen taktiler Wahrnehmung und motorischer Betätigung in Roboterhänden erforderlich.

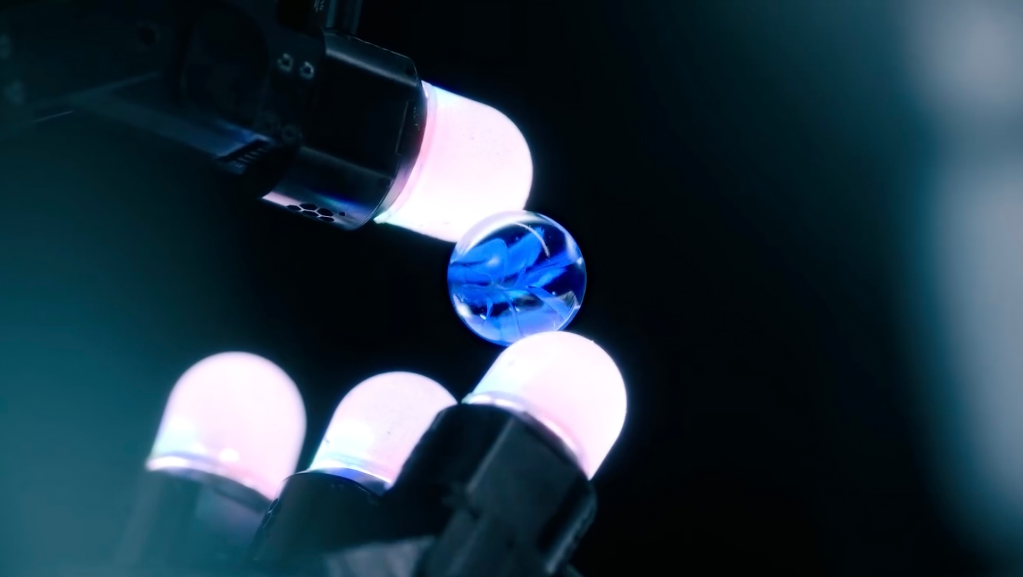

Basierend auf diesem Konzept arbeitete Meta AI mit Wonik Robotics zusammen, um eine standardisierte Software- und Hardwareplattform Digit Plexus vorzuschlagen und zu etablieren.

Es ermöglicht die Integration einer Vielzahl von taktilen Fingerspitzen- und Hautsensoren (wie Digit, Digit 360 und ReSkin) in eine Roboterhand, wobei taktile Daten kodiert und über ein einziges Kabel an einen Host-Computer übertragen werden, um eine nahtlose Datenerfassung, Steuerung und Analyse zu ermöglichen .

Das Plexus-System soll die Entwicklung von Robotikanwendungen vereinfachen, insbesondere von solchen, die anspruchsvolles taktiles Feedback erfordern. Durch den Einsatz von Plexus können Entwickler taktile Sensortechnologie einfacher in ihre Robotikprojekte integrieren und so die Geschicklichkeit und Wahrnehmung der Roboterwelt verbessern.

▲Bild von: Techcrunch

Erwähnenswert ist, dass der nächste Schritt der Zusammenarbeit zwischen Meta und Wonik darin besteht, sich auf die Entwicklung von Woniks Allegro Hand der neuen Generation zu konzentrieren , einer Roboterhand , die mit taktilen Sensoren wie Digit 360 ausgestattet ist und auf der Digit Plexus-Plattform laufen wird.

▲Bild von: XELA

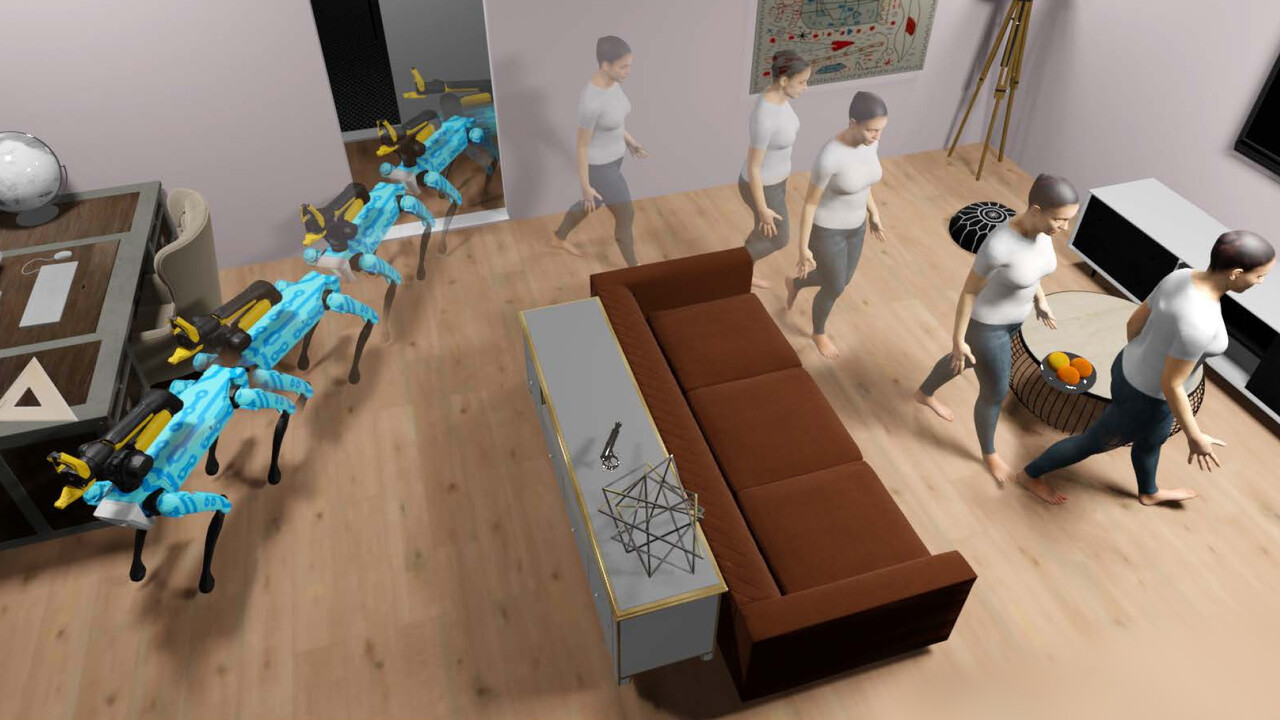

Um die Zusammenarbeit zwischen Mensch und Maschine bei häuslichen Aktivitäten zu untersuchen, veröffentlichte Meta PARTNR, einen Benchmark für Planungs- und Argumentationsaufgaben für die Zusammenarbeit zwischen Mensch und Maschine , basierend auf Habitat 3.0, einer Simulationsplattform zur Untersuchung von Aufgaben der Zusammenarbeit zwischen Mensch und Maschine in häuslichen Umgebungen.

PARTNR ist der größte Benchmark seiner Art und besteht aus 100.000 Aufgaben in natürlicher Sprache, die 60 Häuser und mehr als 5.800 einzigartige Objekte abdecken. Das Ziel dieses Benchmarks besteht darin, die Leistung großer Sprach- und Bildmodelle (LLMs/VLMs) in Zusammenarbeit mit Menschen mithilfe von Mensch-Computer-Interaktionstools zu bewerten.

Durch die Bereitstellung standardisierter Benchmarks und Datensätze hofft Meta, dass es „die Forschung an Robotern ermöglichen wird, nicht nur unabhängig, sondern auch in der Nähe von Menschen zu operieren, wodurch sie effizienter, zuverlässiger und an die Vorlieben jedes Einzelnen angepasst werden können.“

▲Bild von: LinkedIn

Robotern „Berührungen“ zu geben, ist kein „Luftschloss“.

Diese Roboter reagieren weitaus empfindlicher auf äußere Veränderungen als Menschen. Mit effizienten Software- und Hardware-Kollaborationssystemen werden sie bei chirurgischen Eingriffen oder bei der Herstellung von Präzisionsinstrumenten von großem Nutzen sein.

Tatsächlich haben Forscher der Pennsylvania State University nicht nur „Sehen“, „Hören“ und „Berühren“ simuliert, sondern auch „ Geschmack “ in einem Modell der künstlichen Intelligenz. Gleichzeitig hat ein Unternehmen namens Osmo dem Modell der künstlichen Intelligenz beigebracht, wie das geht Imitieren Sie Yuanyou.

Vielleicht können zukünftige Roboter den Menschen in Bezug auf die Sinne vollständig „nachbilden“. Es ist nur so, dass sie besser keine realistischen „Humanoiden“ mehr haben sollten, sonst tritt der Uncanny-Valley-Effekt ein.

# Willkommen beim offiziellen öffentlichen WeChat-Konto von Aifaner: Aifaner (WeChat-ID: ifanr) wird Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner |. Ursprünglicher Link · Kommentare anzeigen · Sina Weibo