Gegenangriff Korea N Room 2.0! Wenn gewöhnliche Menschen durch KI-Gesichtsveränderungen völlig besiegt werden, nutzen sie Magie, um Magie zu besiegen

Der jüngste „Room N 2.0“-Vorfall in Südkorea hat das alltägliche Thema Deepfake erneut in den Vordergrund gerückt.

Die Täter versammelten sich auf Telegram und synthetisierten mithilfe von KI Frauenfotos in Nacktfotos, was zeigt, dass sich der Kreis der Deepfakes bereits von Unterhaltungsstars und Politikern auf ganz normale Menschen wie Du und ich ausgeweitet hat.

In einer Zeit, in der KI zu einer herausragenden Wissenschaft geworden ist, möchten wir verstehen, wie sich diese Technologie, die nicht neu erscheint, aber in den letzten Jahren immer beliebter geworden ist, auf das tägliche Leben auswirkt.

Inwieweit haben sich Deepfakes weiterentwickelt und welchen Schaden werden sie anrichten? Wie kann man Deepfake mithilfe von Technologie bekämpfen? Wie verhindern normale Menschen Deepfakes?

Wir haben über diese Probleme mit Dr. Chen Peng gesprochen, einem Wissenschaftler bei Ruilai Intelligent Algorithm. Ruilai Wisdom wurde 2018 vom Forschungsinstitut für künstliche Intelligenz der Tsinghua-Universität gegründet und beschäftigt sich seit vielen Jahren intensiv mit der KI-Fälschungserkennung.

Chen Peng erzählte uns, dass normale Menschen bei der Identifizierung von Deepfakes kläglich versagt haben und dass Anti-Deepfake immer noch auf KI angewiesen ist.

Ein Bild, ein paar Sekunden, Deepfake wird immer einfacher

Deepfake tauchte erstmals 2017 auf Reddit auf, der „amerikanischen Version von Tieba“. Die Hauptform besteht darin, die Gesichter von Prominenten durch die Protagonisten pornografischer Videos zu ersetzen oder politische Persönlichkeiten zu fälschen.

Heutzutage gehören die Verbreitung von Gerüchten und die Beschäftigung mit Pornografie immer noch zu den gängigen Einsatzmöglichkeiten von Deepfakes, aber sie sind jetzt einfacher geworden.

Chen Peng erklärte, dass das Sammeln eines Fotos ausreicht, um das Gesicht zu verändern. Je mehr Daten gesammelt werden, desto besser werden natürlich die Details des Gesichts wie Muttermale und Gesichtszüge modelliert und der Effekt der Gesichtsveränderung ist umso realistischer .

Im April dieses Jahres ist das Performance-Kunstprojekt zweier deutscher Künstler ein lebendiges Beispiel.

Sie haben eine KI-Kamera NUCA entworfen. Das Kameragehäuse ist 3D-gedruckt und verfügt über ein eingebautes 37-mm-Weitwinkelobjektiv. Die aufgenommenen Fotos werden in die Cloud übertragen, wo die KI „die Kleidung auszieht“ und das Foto erstellt in weniger als 10 Sekunden „herausgenommen“ werden.

NUCA weiß eigentlich nicht, wie Ihr nackter Körper aussieht. Es analysiert nur Ihr Geschlecht, Ihr Gesicht, Ihr Alter, Ihre Körperform usw., um Ihren nackten Körper in den Augen der KI darzustellen.

Rauh? Vielleicht spielt es keine Rolle. In wenigen Sekunden sind Sie der KI ausgesetzt und andere glauben möglicherweise, dass Sie es sind.

Auch Südkoreas „Room N 2.0“ wurde mit ähnlichen Details entlarvt: ein Telegram-Chatroom mit 227.000 Menschen, ein eingebauter Roboter, der Frauenfotos in Nacktfotos synthetisiert, Brüste anpassen kann und Deepfake-Inhalte in 5 bis 7 Sekunden generiert.

▲Screenshot des Chatrooms, der die Verwendung von Deepfake erklärt

Das Ändern von Gesichtern und das Ausziehen von Kleidung sind nur eine Anwendung von Deepfake.

Die Verwendung generativer KI-Modelle (GAN, VAE, Diffusionsmodell usw.) zur Synthese oder Fälschung realistischer Inhalte, einschließlich Text, Bildern, Audio und Video, kann als Deepfake bezeichnet werden.

Unter ihnen ist auch Audio-Deepfake weit verbreitet.

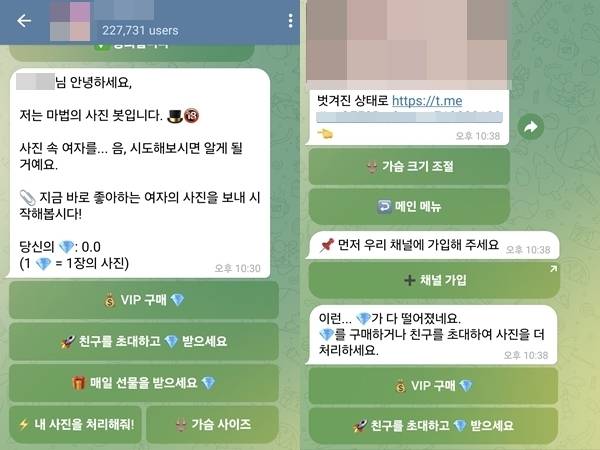

Anfang 2023 rief der Technologiereporter Joseph Cox die automatisierte Service-Hotline der Bank an, spielte die von ihm mit ElevenLabs geklonte KI-Stimme „Meine Stimme ist mein Passwort“ ab und bat darum, den Kontostand zu überprüfen. Unerwarteterweise war die Sprachüberprüfung erfolgreich.

Chen Peng sagte, dass dies in der Vergangenheit mehrere Minuten oder Dutzende von Minuten dauerte, um unsere Stimmabdruckinformationen zu erfassen, aber jetzt kann es ungefähr in einer halben Minute oder Dutzenden von Sekunden erfasst werden. Wenn wir noch ein paar belästigende Anrufe erhalten, kann es sein, dass unsere Stimmen durchsickern.

Wenn Sie den Ton und andere Sprechstile genauer klonen und kopieren möchten, z. B. Guo Degang Englisch sprechen lassen oder Swift Chinesisch sprechen lassen möchten, benötigen Sie natürlich immer noch mehr Korpus.

Sogar Text ist ein Bereich, der zutiefst gefälscht ist. KI-generierte Texte sind schon lange überall zu sehen und bereiten Lehrern Kopfzerbrechen, wenn Schüler damit schummeln und Hausaufgaben erledigen, aber wir sind uns der Risiken, die dahinter stecken, möglicherweise nicht bewusst.

Falsche Nachrichten und Gerüchte seien die am stärksten betroffenen Bereiche von Text-Deepfakes, sagte Chen Peng, dass in der Vergangenheit noch Menschen den Text selbst schreiben müssten, aber jetzt könne KI verschiedene Kommentare zu einem bestimmten Ereignis generieren und diese dann automatisch in den sozialen Medien veröffentlichen .

Laut Chen Peng gibt es drei Hauptgründe, warum Deepfake schneller und einfacher ist.

Erstens gab es Durchbrüche bei generativen KI-Technologien wie Vincent Pictures und Vincent Videos. Zweitens erfreut sich die Rechenleistung immer größerer Beliebtheit, und auf Grafikkarten für Endverbraucher können bereits generative KI-Modelle ausgeführt werden.

Ein weiterer sehr wichtiger Punkt ist, dass die Deepfake-Technologie in verschiedene Tools mit niedrigeren Schwellenwerten optimiert wurde.

Nehmen wir als Beispiel Face-Change. Es gibt viele Open-Source-Projekte für DeepFaceLive und Deep-Live-Cam auf Github. Benutzer können den Code von der Website herunterladen und die laufende Umgebung lokal konfigurieren.

▲AI Musk Live-Übertragung mit Deep-Live-Cam

Wenn es für Anfänger, die die Technologie nicht verstehen, immer noch schwierig ist, gibt es auch Profis, die den Reis direkt in den Mund nehmen, das Modell kapseln und es in eine einfache und benutzerfreundliche Software schreiben, die Spieler kostenlos herunterladen können Verdienen Sie selbst einige Werbegebühren, darunter viele Ein-Klick-Apps zum Strippen.

Was Audio-Deepfake betrifft, gibt es bereits ausgereifte kommerzielle Unternehmen, die Benutzern die einfache Nutzung von Diensten in Form von SDK (Entwicklungskit) oder API (Anwendungsprogrammierschnittstelle) ermöglichen.

Benutzer benötigen nicht einmal ein Gerät mit Grafikkarte, um das Programm bereitzustellen, sondern laden stattdessen Inhalte wie Audio auf die Website hoch, warten, bis die Ergebnisse generiert werden, und laden sie dann herunter.

Daher verbergen sich hinter den Kulissen komplexe technische Prinzipien, und vor den Augen der Benutzer stehen „out-of-the-box“-Schnittstellen. Selbst Teenager können nach Belieben falsche Informationen erstellen.

Zusammenfassend lautet Chen Pengs Schlussfolgerung:

Deepfake hat einen Punkt erreicht, an dem normale Menschen es leicht bekommen können.

Menschen haben es möglicherweise völlig versäumt, Deepfake mit bloßem Auge zu identifizieren

Wenn eine Technologie „in die Häuser gewöhnlicher Menschen eindringt“, sind gewöhnliche Menschen am wahrscheinlichsten betroffen.

Betrug ist eine der häufigsten Methoden, mit denen Deepfakes Böses anrichten.

Anfang dieses Jahres wurde die Niederlassung eines multinationalen Unternehmens in Hongkong aufgrund von KI um 25 Millionen US-Dollar betrogen. Das Opfer nahm an einer Videokonferenz teil, die anderen waren Betrüger, die sich einer „KI-Gesichtsveränderung“ und einer „KI-Stimmveränderung“ unterzogen hatten.

▲Die Polizei demonstrierte, wie man mit Deepfake eine Videokonferenz mit mehreren Personen vortäuscht

Was können wir tun, um uns zu schützen, nachdem es so weit gekommen ist?

Wenn jemand Deepfake verwendet, um Sie zu täuschen, ist das Ausnutzen von KI-Lücken eine Möglichkeit, aber es hat eine Haltbarkeitsdauer.

Wenn wir beispielsweise während eines Videoanrufs den Verdacht haben, dass das Gesicht des anderen Teilnehmers durch KI ersetzt wurde, können wir den anderen Teilnehmer zu bestimmten Aktionen anleiten, wie zum Beispiel seine Hand vor sein Gesicht zu legen und ein paar Mal schnell zu wischen, oder seinen Kopf deutlich drehen.

Wenn das Modell hinter der KI-Gesichtsersetzung nicht speziell für die Handokklusion optimiert ist, wird es freigelegt und das Gesicht erscheint möglicherweise auf dem Handrücken oder es kann plötzlich verzerrt werden.

Das Prinzip der Kopfdrehung ist dasselbe. Wenn die Gegenpartei während der Datenerfassung nicht absichtlich Material mit einer Kopfdrehung von mehr als 45 Grad sammelt, ist die Gesichtsanpassung unnatürlich.

Aber in Zukunft werden solche mit bloßem Auge sichtbaren Mängel sicherlich allmählich abnehmen.

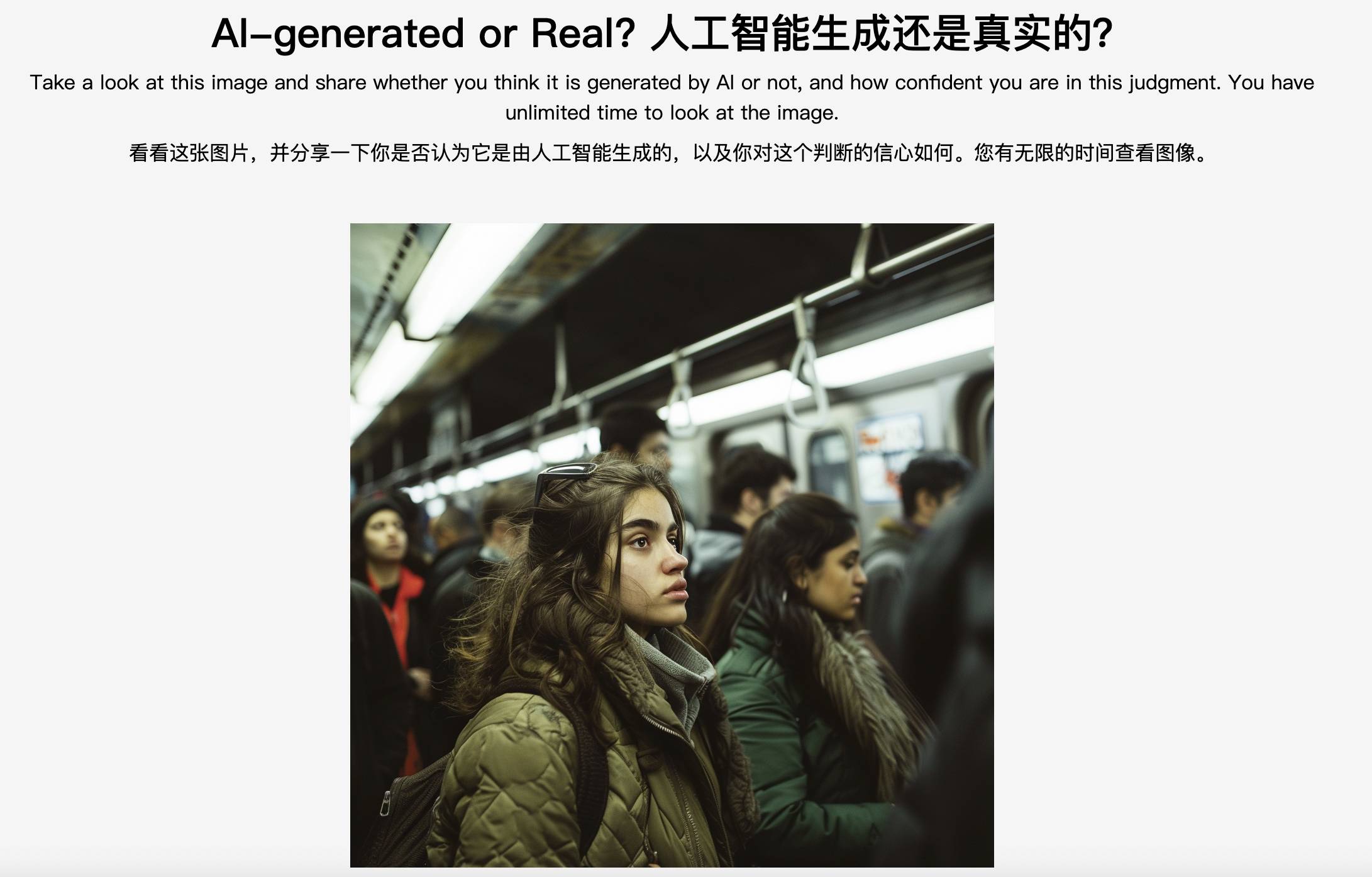

▲Der „Fehlerbehebungs“-Test der Northwestern University: KI-generiert oder real?

Chen Peng scherzte: Wenn Betrüger Sie für ein fettes Schaf halten, das darauf wartet, geschlachtet zu werden, und Sie absichtlich täuschen, Ihre Social-Media-Informationen entfernen und mehrere Tage damit verbringen möchten, Ihr Modell zu optimieren, dann ist die Wirksamkeit dieser Methoden nicht garantiert.

Wenn ein Video diese Mängel nicht aufweist, bedeutet das, dass es sich um ein echtes Video handelt? Das ist nicht wahr.

Ob es wirksam ist oder nicht: Es kann sicherlich nicht vollständig oder zu 100 % wirksam sein, aber es ist bis zu einem gewissen Grad wirksam.

Um es professioneller auszudrücken: Die visuelle Wahrnehmung des Menschen schneidet auf der semantischen Ebene sehr gut ab, etwa wenn es darum geht, die Bedeutung von Objekten oder Szenen leicht zu unterscheiden, bei der Verarbeitung niedriger Nuancen hingegen auf der Pixelebene, der Wahrnehmung Die Fähigkeit ist nicht so gut wie die des KI-Modells.

Aus dieser Perspektive glaubt Chen Peng, dass normale Menschen bei der Unterscheidung von Deepfakes kläglich versagt haben. Experten können sich möglicherweise immer noch wehren, weil sie zu viel gesehen haben und über relativ umfassende Analysefähigkeiten verfügen und erkennen können, dass etwas nicht den Regeln entspricht.

Keiner von uns ist Leeuwenhoek, wir haben auch keine scharfen Augen, aber die menschliche Natur bleibt unverändert. Daher können wir auch die traditionelle psychologische Verteidigungslinie hochziehen, die nichts mit Technologie zu tun hat – seien Sie vorsichtig beim Segeln.

Betrügereien folgen oft dem gleichen Muster: Privatsphäre stehlen, Angst, Gier und emotionale Werte nutzen, um Geschichten zu erfinden, sich als Bekannte ausgeben oder sich verstecken, um Vertrauen zu gewinnen, und das ultimative Ziel ist Geld.

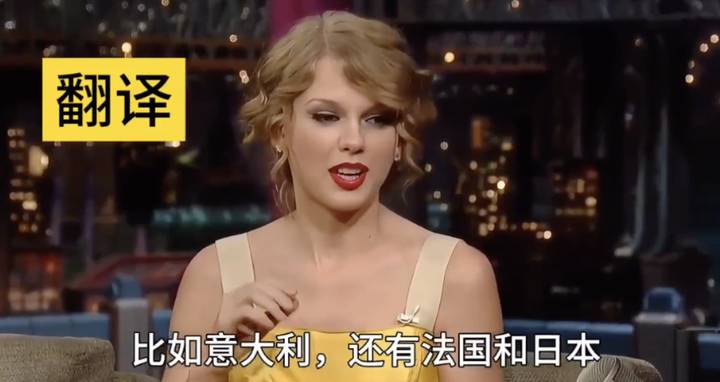

▲Das Produkt RealBelieve von Realai Smart gibt bei Videoanrufen Frühwarnungen aus.

Denken Sie daran und seien Sie dann wachsamer. Klicken Sie nicht auf unbekannte Links, geben Sie keine Bestätigungscodes weiter, versuchen Sie nicht, Ihr Gesicht, Ihre Stimme, Fingerabdrücke und andere persönliche biometrische Informationen im Internet übermäßig preiszugeben, und nehmen Sie keine verdächtigen Anrufe entgegen. und haben mehrere Köpfe, wenn es um Geld geht, Möglichkeiten, die Identität des anderen zu überprüfen, beispielsweise Dinge zu fragen, die nur der andere weiß.

Wie das alte Sprichwort sagt: Das Beste, was man tun kann, ist, das Herz anzugreifen. Wenn wir erst einmal erkennen, dass wir getäuscht werden können, dürfen wir nicht getäuscht werden.

Magie gegen Magie, KI besiegt KI

Es reicht nicht aus, das Bewusstsein für Betrugsbekämpfung zu schärfen. Der „Room N 2.0“-Vorfall in Südkorea zeigt eine weitere Form des Deepfake-Bösens. Die Leute sitzen zu Hause und Töpfe kommen vom Himmel.

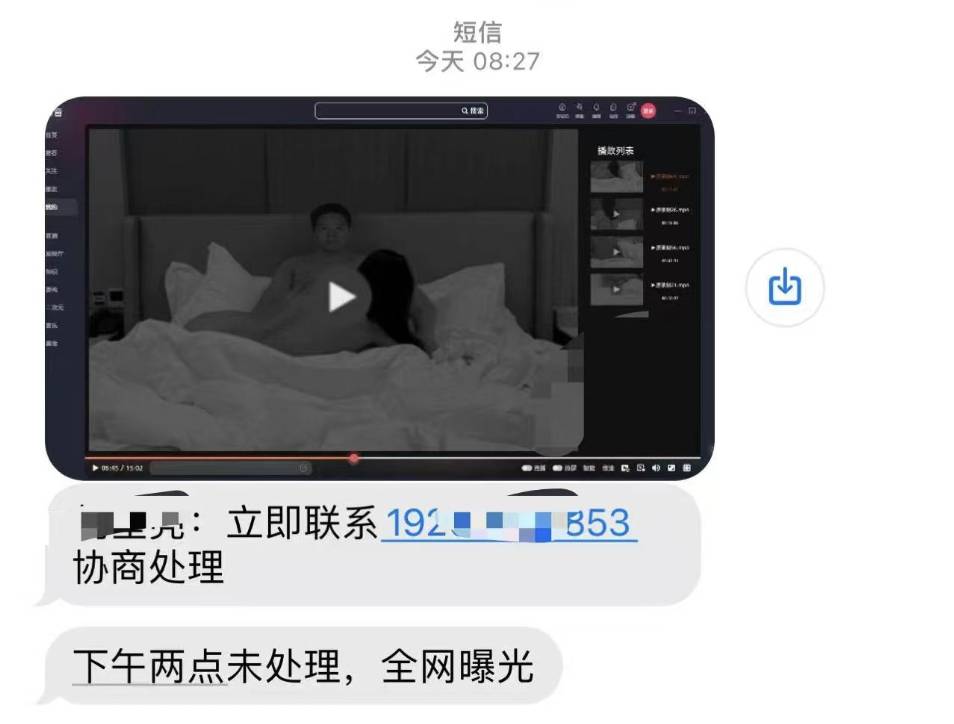

Opfer gefälschter Nacktfotos können mit „Rachepornos“ konfrontiert werden – die Täter drohen damit, Fake-Materialien zu verbreiten, um die Opfer zu erpressen und zu belästigen, was zu noch schwerwiegenderen Folgeschäden führt.

Aber diese Sichel kann auch über unseren Köpfen erhoben werden: Stellen Sie sich vor, die Betrügerbande hätte Ihre Fotos aus dem Nichts bekommen, sie zu vulgären Videos kombiniert, Ihnen SMS-Nachrichten geschickt, um Sie zu bedrohen, und wenn Sie das Geld nicht überweisen, wird es offengelegt Überall im Internet. Wie kann man sich beweisen?

Ruilai Wisdom, wo Chen Peng arbeitet, ist tatsächlich auf eine solche persönliche Angelegenheit gestoßen. Die andere Partei sagte, dass sein Gesicht in einem Video verändert wurde und er freigesprochen werden könnte.

Natürlich gibt es Möglichkeiten: Magie gegen Magie, KI besiegt KI.

Chen Peng stellte vor, dass es zwei technische Hauptwege für KI-Fälschungen gibt: aktive Verteidigung und passive Erkennung.

Lassen Sie uns zunächst über die aktive Verteidigung sprechen. Wenn wir Fotos in sozialen Medien veröffentlichen und nicht möchten, dass sie von anderen verwendet werden, können wir ihnen optisch nicht wahrnehmbare Geräusche hinzufügen.

Wenn jemand anderes unsere Fotos zum Trainieren des Modells verwendet, kann die KI aufgrund dieser unsichtbaren Störung die visuelle Darstellung nicht gut extrahieren und das Endergebnis kann verzerrt oder unscharf sein. Dies wird als „gegnerischer Probenangriff“ bezeichnet. "

„Semi-vulnerable Watermark“ ist eine weitere aktive Verteidigungsmethode. Wenn nach dem Hinzufügen eines Wasserzeichens jemand anderes unser Foto bearbeitet, wird das Wasserzeichen zerstört und wir wissen, dass das Bild verarbeitet wurde und nicht vertrauenswürdig ist.

Wasserzeichen können nicht direkt verhindern, dass es sich bei Bildern um Deepfakes handelt, sie können jedoch die Echtheit von Bildern erkennen und zertifizieren.

▲In Übersee gibt es ähnliche Untersuchungen. Adobe hat den C2PA-Standard ins Leben gerufen, bei dem Metadatenparameter zur Bestimmung der Bildquelle verwendet werden.

Natürlich ist die Schwelle für eine aktive Verteidigung höher, daher müssen wir Vorkehrungen treffen, bevor sie passieren, und die Bilder im Voraus bearbeiten.

Eine häufigere Situation ist, dass wir es nicht vorhersehen können. Wir erhalten „Nacktfotos“ von uns selbst, aber es ist auch das erste Mal, dass wir „offen“ mit uns selbst sind. Zu diesem Zeitpunkt muss die passive Erkennung verwendet werden.

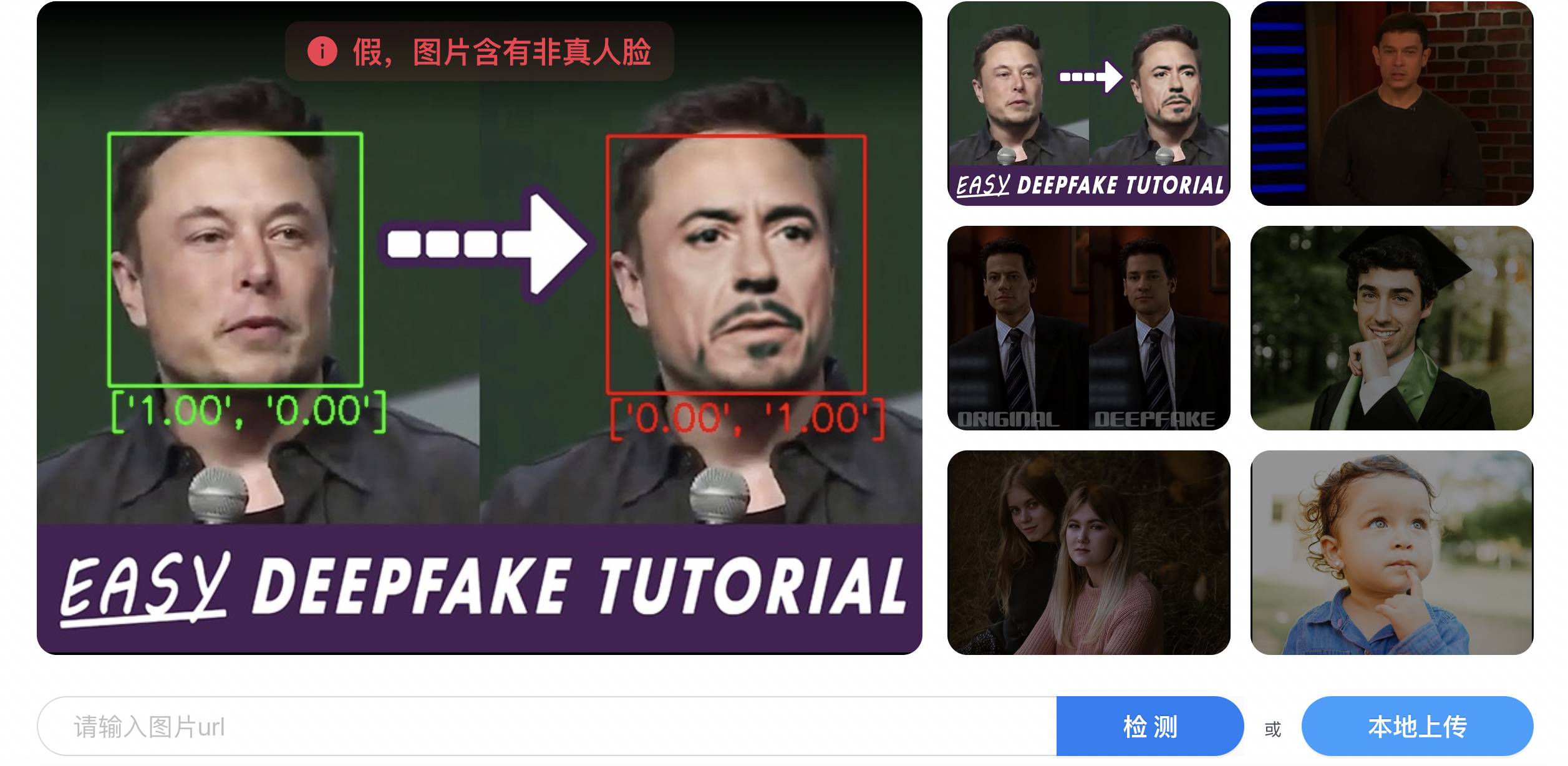

Realai Intelligence verfügt über eine Reihe von KI-Produkten, die für die Erkennung von Fälschungen verantwortlich sind, darunter die generative KI-Plattform zur Erkennung von Inhalten DeepReal, die Gesichts-KI-Sicherheitsfirewall RealGuard und so weiter.

▲DeapReal

Vereinfacht ausgedrückt ist die Verwendung von KI zur Identifizierung von KI in zwei Schritte unterteilt: Zuerst wird eine große Anzahl von Fälschungsmerkmalen extrahiert und dann basierend auf diesen Beispielen modelliert, damit die KI die Regeln zur Fälschungserkennung erlernen kann.

Verzerrte Farben, unangemessene Texturen, unnatürliche Ausdrücke, nicht synchrones Audio und Video, unregelmäßige Irisformen und inkonsistente Glanzlichter der beiden Schüler sind alles Lernmaterialien für KI.

Unter diesen kann die Genauigkeit von Videofälschungen höher sein als die von Bildern, da Videos aus einer Reihe fortlaufender Bilder bestehen, die mehr Informationen liefern, die für Fälschungen verwendet werden können als ein einzelnes Bild, beispielsweise das Aussehen eines Zeichens zwischen verschiedenen Rahmen. Kontinuität der Aktion.

Im Wesentlichen ähnelt KI-Fälschung der Verwendung menschlicher Augen zur Fehlersuche und nutzt dabei auch die Mängel des KI-Modells selbst aus.

▲ Forscher der Chinesischen Akademie der Wissenschaften stellten der Welt das KI-Modell zur Erkennung von Deepfakes als Open Source zur Verfügung

Aber die Mängel werden sich sicherlich nach und nach bessern, sodass sich eine sehr kritische Frage stellt: Liegt zuerst die Fälschung und dann die Echtheit vor? Wenn ja, wäre die Fälschung nicht immer einen halben Schritt hinter der Fälschung?

Chen Peng antwortete, dass die erzeugte Technologie der Fälschungstechnologie möglicherweise etwas voraus sei, sie jedoch über ein internes rot-blaues Angriffs- und Verteidigungslabor verfügen, um Deepfake zu simulieren und sich gleichzeitig gegen Deepfake zu verteidigen, und die Erkennungsfähigkeiten von Deepfake ständig zu verbessern.

Wenn eine neue Deepfake-Technologie auf den Markt kommt, können sie diese schnell reproduzieren und dann auf dem Erkennungsprodukt überprüfen. „Wenn eine neue Technologie auf den Markt kommt, kann ich sie bis zu einem gewissen Grad trotzdem erkennen.“

Darüber hinaus verfügt das Modell selbst über eine gewisse Verallgemeinerungsfähigkeit. Es hat viele Deepfake-Inhalte gesehen und kann diese bis zu einem gewissen Grad genau identifizieren und erkennen, wenn es auf unsichtbare Inhalte stößt.

▲ Plattformen wie Bilibili werden KI-Unterhaltungsinhalte kennzeichnen, die das Gesicht verändern

Kurz gesagt ist KI-Fälschung und Fälschungserkennung ein „Katz-und-Maus-Spiel“ mit langfristiger Konfrontation und gegenseitigem Wettbewerb.

Aus diesem Grund hat Chen Peng KI-Fälschungsalgorithmen untersucht:

Anti-Deepfake ist zu konfrontativ und erfordert langfristige Investitionen. Im Gegensatz zu vielen KI-Produkten können Sie es nach der Fertigstellung vergessen.

Trotzdem ist er immer noch relativ optimistisch: „Überwachen Sie mit Gesetzen und Vorschriften, verwalten Sie Inhalte auf Plattformen, stellen Sie Technologien und Tools zur Verfügung und machen Sie durch die Medien mehr Menschen auf Risiken aufmerksam.“ Wenn die vielschichtige Governance ein bestimmtes Niveau erreicht, wird dies der Fall sein wird auf jeden Fall eine Erleichterung sein.

In Zukunft könnten wir beim Surfen im Internet in ein so etwas absurdes Szenario geraten: Mit dem Verifizierungscode können wir beweisen, dass ich ein Mensch bin, und mit Deepfake können wir beweisen, dass ich nicht ich bin.

Die Technologie kann nicht alle böswilligen Absichten vollständig erkennen, aber der Mensch muss sich keine allzu großen Sorgen machen. Der Erfolg von Deepfake ist nur das Endergebnis, aber die Verhinderung von Deepfake kann jederzeit beginnen.

Wie Chen Peng sagte, ist selbst ein sehr einfaches KI-Produkt ein sehr systematisches Projekt.

Wir sind Teil eines größeren Systems. Lassen Sie die Verletzten zu Wort kommen, lassen Sie die Täter bestrafen, lassen Sie die Technologie eingreifen, die böse Taten verhindert, und lassen Sie das Konzept der Gesellschaft einen Zentimeter besser werden gerechte Nutzung der Zukunft.

# Willkommen beim offiziellen öffentlichen WeChat-Konto von aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner |. Ursprünglicher Link · Kommentare anzeigen · Sina Weibo