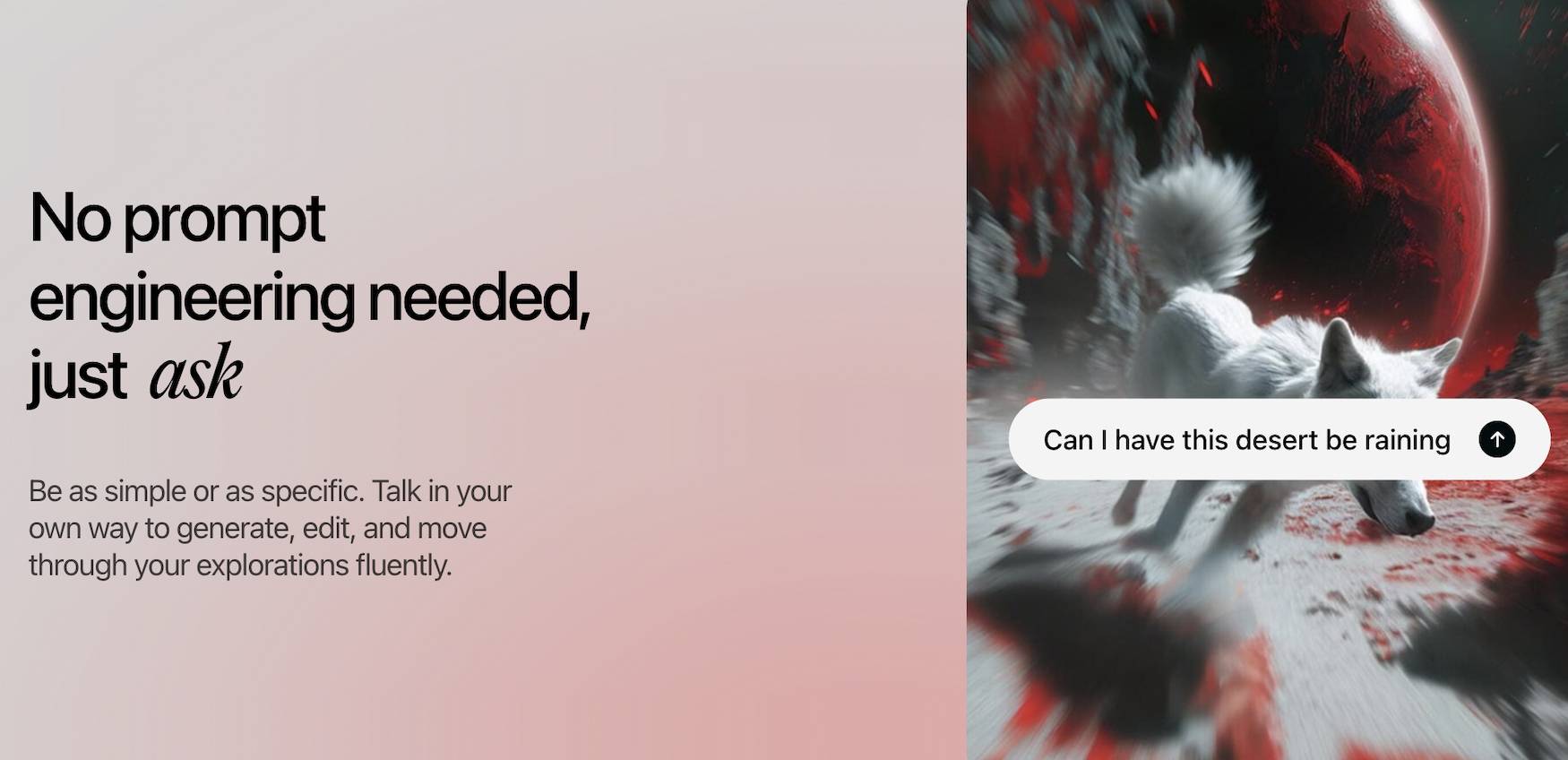

Großes Update für den KI-Videoriesen! Sie müssen sich nicht anstrengen, um die Aufforderungsworte zu schreiben. Es gab noch nie eine solche Möglichkeit, Videos zu erstellen.

In welche Richtung können KI-Videos gedreht werden? Die Antwort von Luma AI ist etwas anders. Der Gegner übt immer noch einen Zug nach dem anderen, aber es ist so, als würde Feng Qingyang Dugu Neun Schwerter beibringen. Er achtet auf Flexibilität und kann tun, was er will, wie fließende Wolken und fließendes Wasser.

Luma AI ist vielleicht nicht so bekannt wie Keling und Runway, aber auch sein Videomodell heißt Dream Machine und wurde kürzlich einem großen Upgrade unterzogen , was die größte Dynamik seit der Einführung des Produkts darstellt.

Es umfasst zwei Updates. Das eine ist die Veröffentlichung des eigenen Bildmodells Luma Photon, das Text, Bilder und Videos an einem Ort vereint. Das andere ist die Schaffung eines neuen Workflows zur Generierung von KI-Videos Chatten Sie gerne mit ChatGPT, ohne sorgfältig über die richtigen Worte nachdenken zu müssen.

Dream Machine hat eine völlig neue Methode zur Erstellung von Videos entwickelt.

den Weg weisen  https://dream-machine.lumalabs.ai/

https://dream-machine.lumalabs.ai/

Während des Chats wurde das Video generiert.

Wenn wir Dream Machine öffnen, sehen wir als Erstes das „Board“, das als unendliche kreative Leinwand verstanden werden kann. Hier verwenden wir natürliche Sprache, um Bilder oder Videos frei zu generieren.

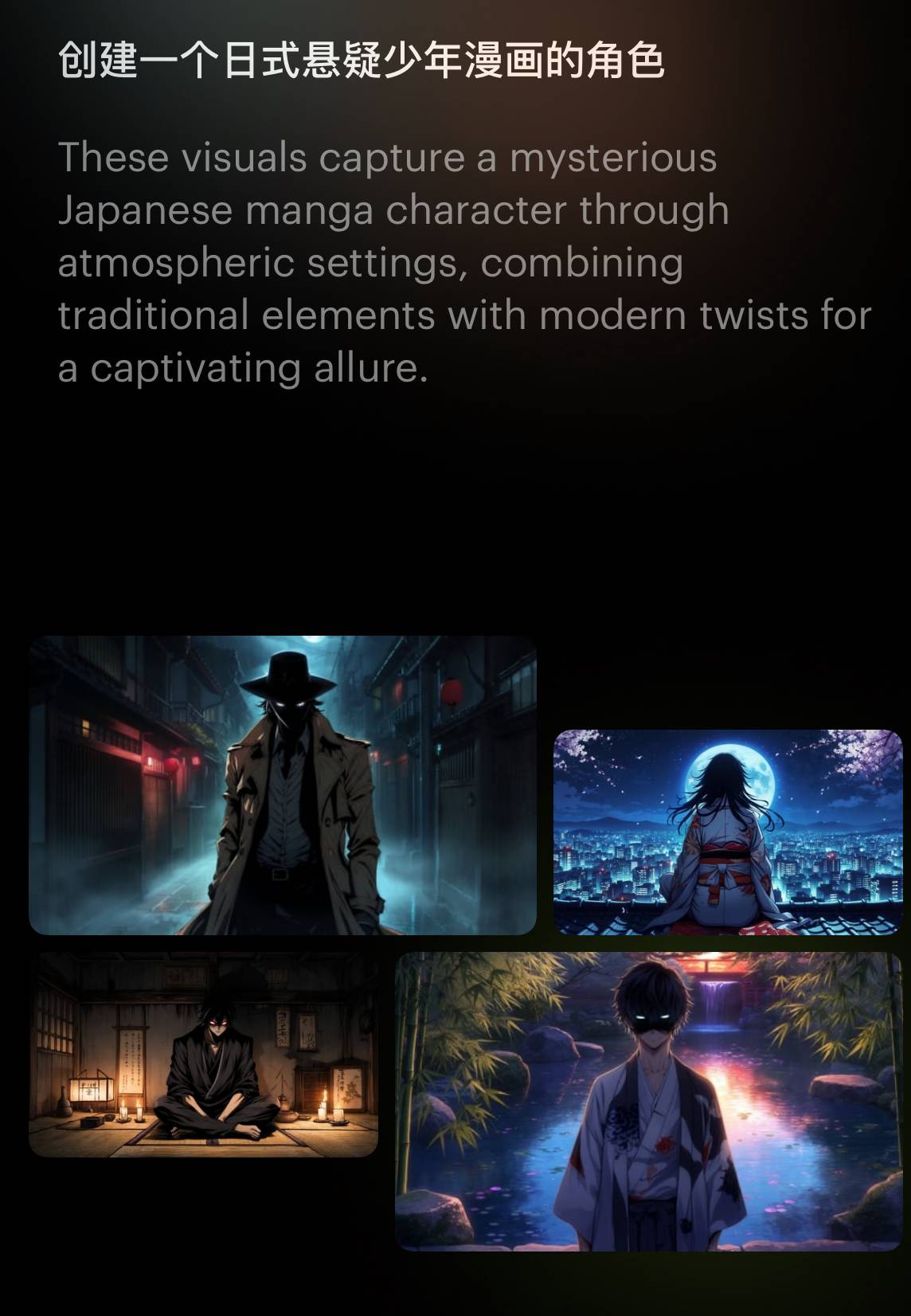

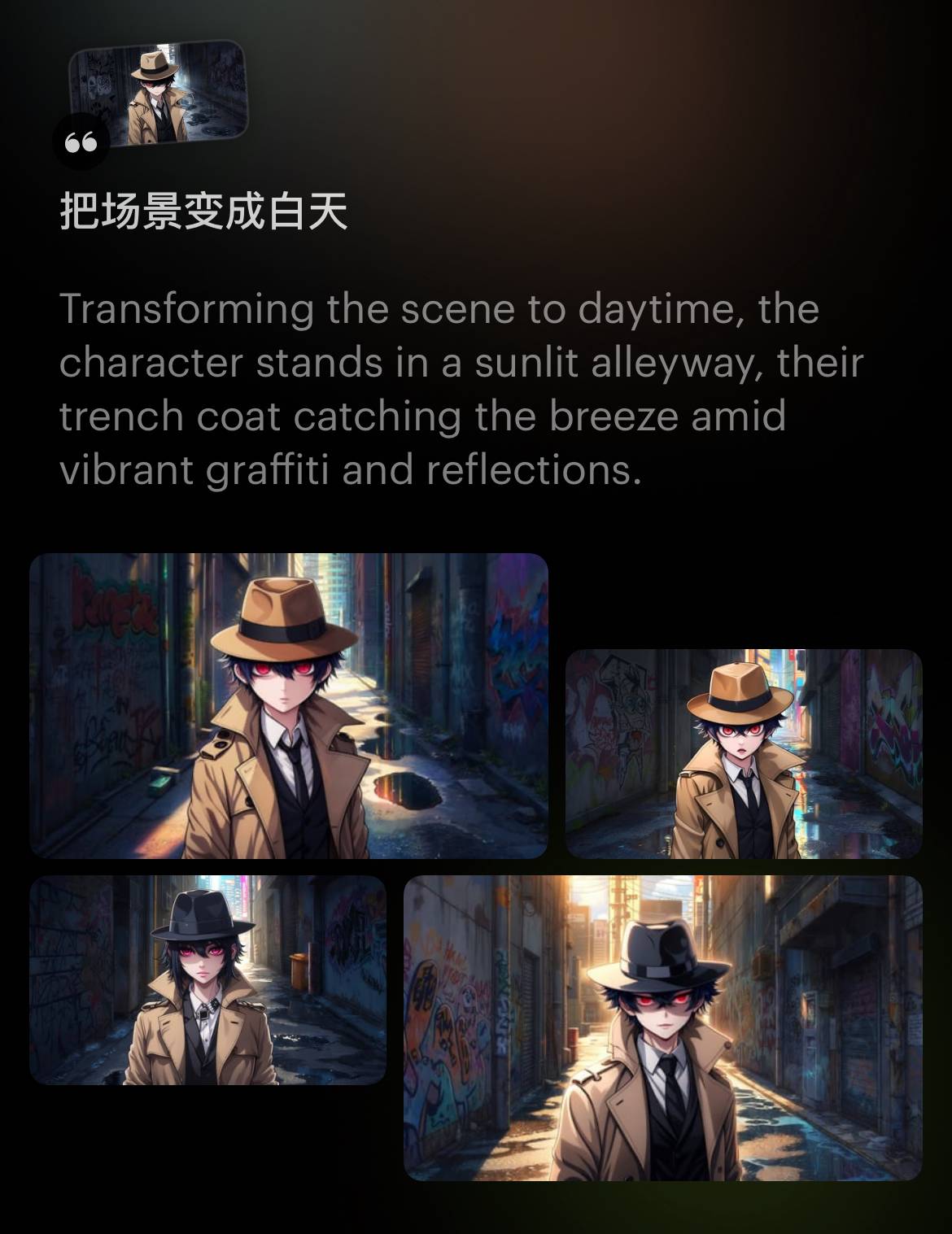

Als ich ein Forum startete, war meine Aufforderung ganz einfach: „Erstelle eine japanische Suspense-Boy-Comicfigur.“

Die KI hat meine Aufforderungsworte erweitert und 4 Bilder auf einmal generiert, aber es hat nicht funktioniert, die Zeit stimmte nicht.

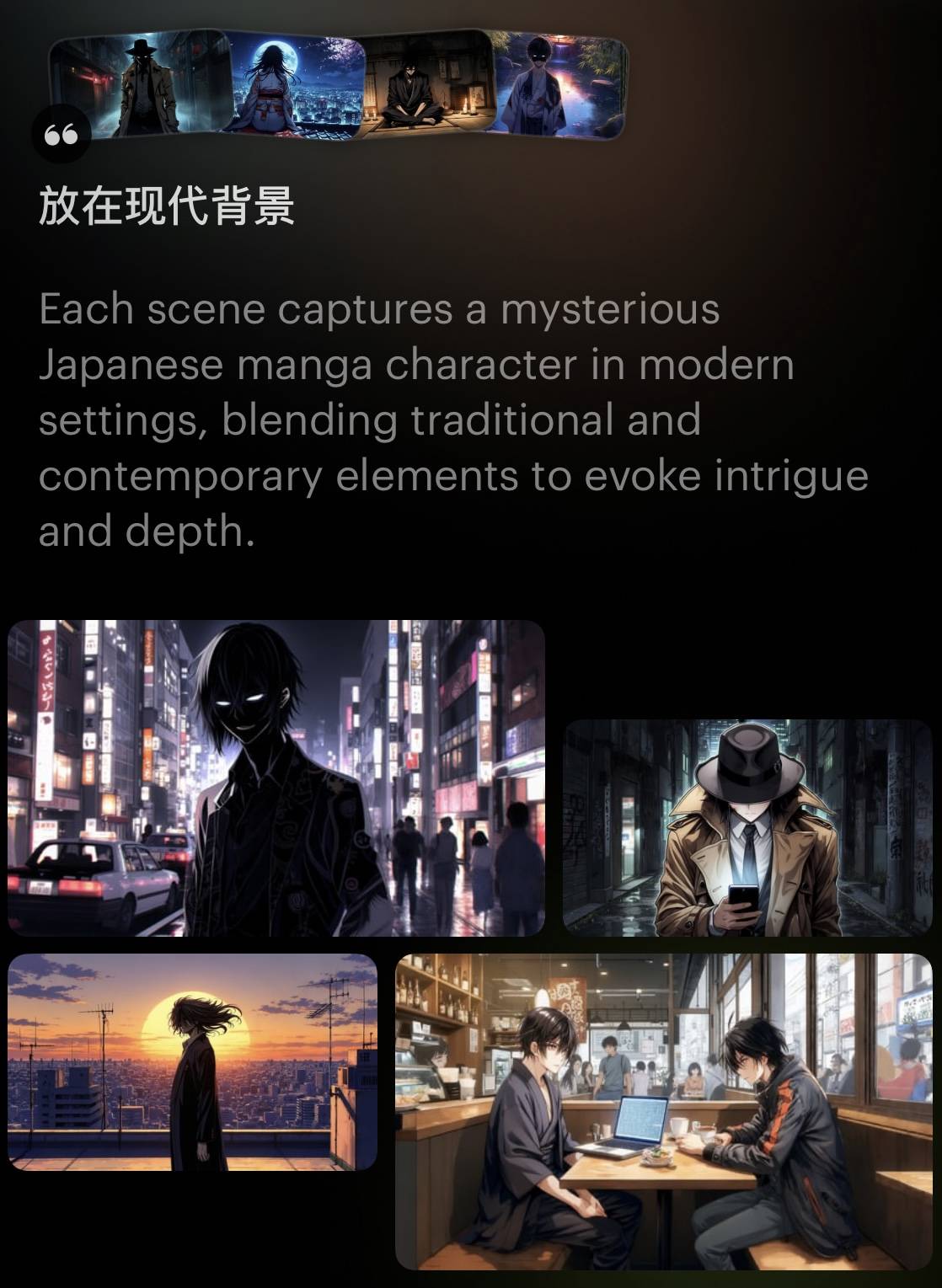

Es spielt keine Rolle, geben Sie einfach einen weiteren Satz in das Dialogfeld ein: „Platzieren Sie es auf einem modernen Hintergrund.“

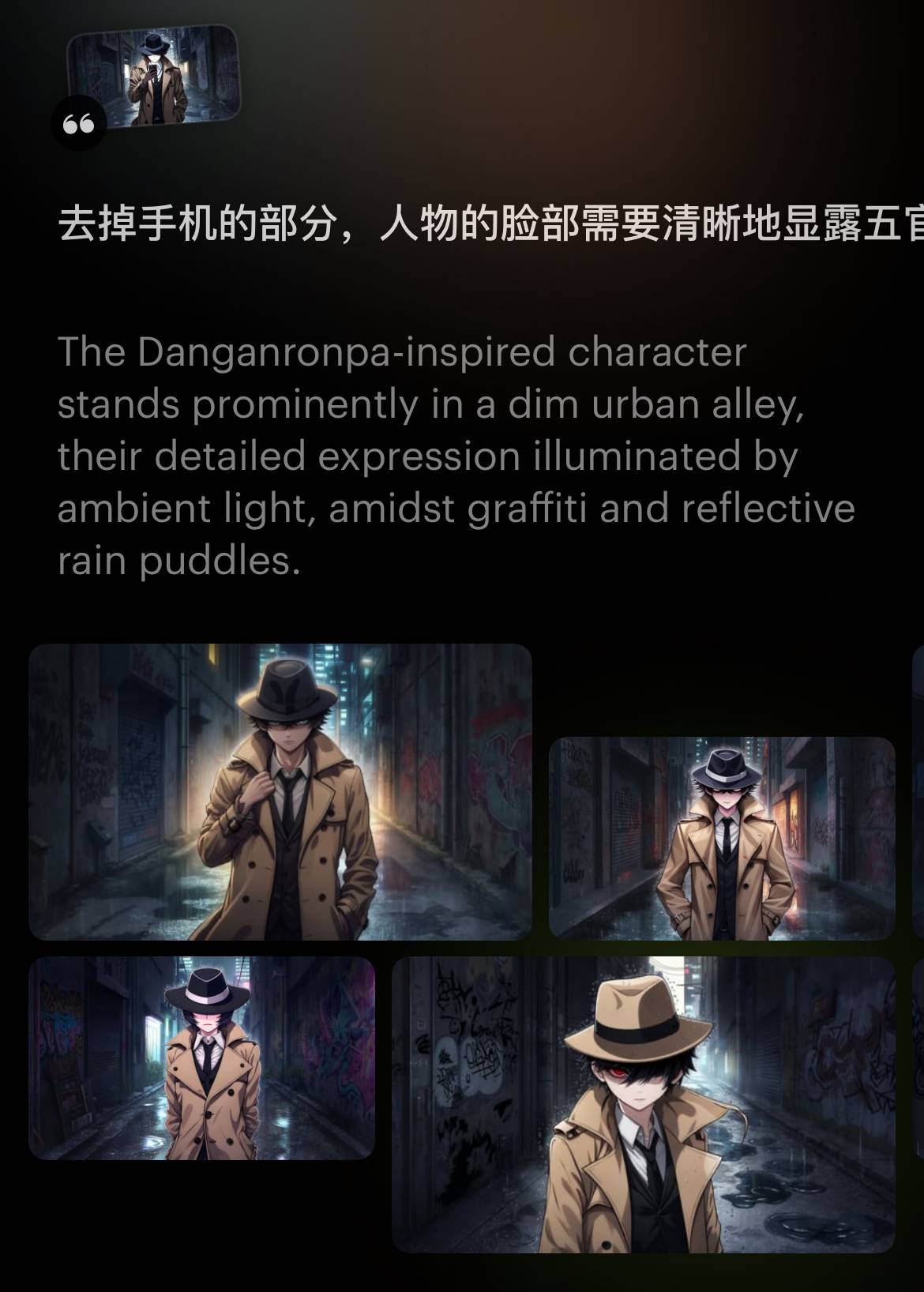

AI sagte, es hätte verstanden und 4 weitere Bilder erzeugt. Das Bild oben rechts, wie er alleine durch eine dunkle Gasse geht, kommt dem Gefühl nahe, das ich möchte, aber es reicht immer noch nicht aus, dass er seinen Kopf hebt und seinen zeigt Gesichtszüge.

Es ist nicht schwer, optimieren Sie einfach weiter, vergessen Sie komplizierte Aufforderungswörter und spielen Sie einfach direkt mit der KI.

Das Bild unten rechts ist gut, auch wenn das Bild etwas kindisch wirkt. Als nächstes möchte ich, dass die KI ein Video des Protagonisten generiert, der von Tag zu Nacht durch dieselbe Gasse geht.

Die Funktion von Dream Machine, das erste und letzte Bild des Videos zu generieren, ist auf diesen Bedarf vorbereitet – wir wählen das erste und letzte Bild aus und überlassen der KI den mittleren Prozess.

Dann müssen wir die KI nur noch ein paar Tagesszenen generieren lassen, basierend auf den Bildern, mit denen wir zufrieden sind, und die Kommunikationsmethode ist immer noch dieselbe einfach und grob. Die beiden schließlich ausgewählten Bilder weisen leicht unterschiedliche Details auf, befinden sich jedoch im selben Rahmen.

Alles ist bereit und wartet nur darauf, das Video zu generieren, und der KI-Übergang erfolgt ganz natürlich.

An dieser Stelle sollten Sie den Unterschied zwischen Dream Machine und anderen Videotools verstehen.

Bei anderen Videotools erhalten Sie in der Regel ein Textfeld zum Ausfüllen eines Aufforderungsworts und können dann Parameter wie Kamerabewegung und -dauer festlegen. Einmal setzen, einmal generieren.

Die Benutzeroberfläche von Dream Machine ähnelt jedoch stark der Interaktion mit einem Chatbot. Unten befindet sich ein Eingabefeld, in das Vincent-Bilder, Tush-Bilder, Tush-Videos und Vincent-Videos eingegeben werden können.

Professionelle Schöpfer können weiterhin traditionelle schnelle Wörter schreiben, aber wir haben auch das Recht, „menschliche Wörter“ zu sagen. Die KI kann den Kontext verstehen und uns dabei helfen, die schnellen Wörter zu verbessern grobe Idee, mit ihm chatten, während man Änderungen vornimmt und optimiert.

Und da Dream Machine die Form einer unendlichen Leinwand hat, können wir sie in einer Sitzung wiederholt generieren, und die Materialien bleiben erhalten und überdecken sich nicht gegenseitig.

Unser Denken wird nicht auf ein kurzes Wort oder ein Video beschränkt sein, sondern in diesem Prozess können weitere Ideen entstehen.

Kontrollierbarere Bilder, besser kontrollierbare Videos

Der neue Workflow von Dream Machine ist wie der Stamm eines großen Baumes, und einige seiner unterhaltsamen und praktischen Funktionen sind wie Zweige, die sich gegenseitig ergänzen und gedeihen.

Eine Schlüsselrolle spielt Luma Photon, das neueste von Dream Machine veröffentlichte Bildmodell.

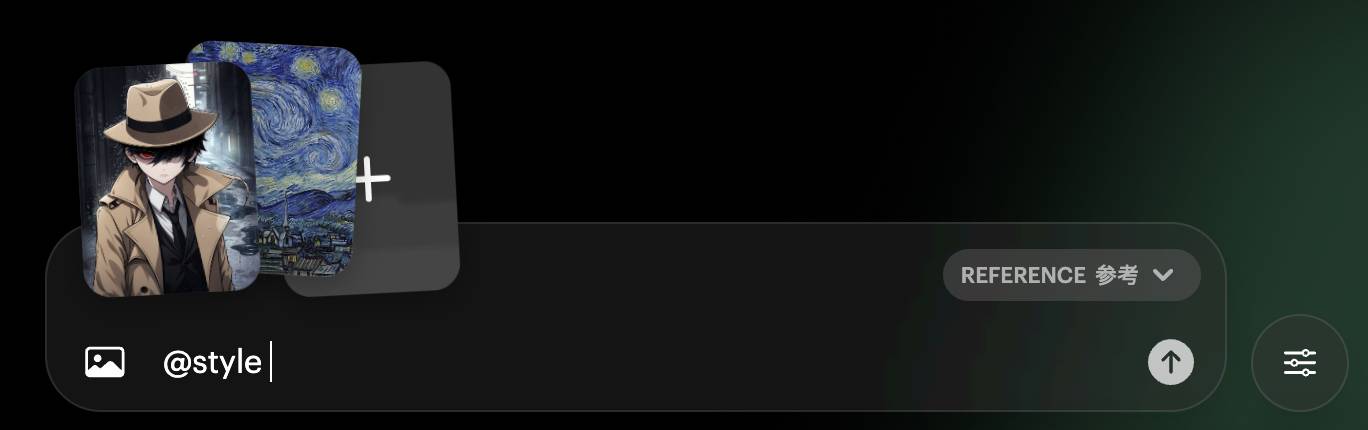

Wie erzeugt man Bilder, die unserer Ästhetik besser entsprechen? Dream Machine unterstützt Stilreferenz- und Zeichenreferenzfunktionen.

Lassen Sie uns zunächst über die Stilreferenz sprechen. Wir können unsere eigenen Bilder importieren und die KI wird den Stil in die Kreation integrieren. Der Beamte nannte ein Beispiel: die Erstellung einer Vogelversion von „Das Mädchen mit dem Perlenohrring“ im Stil von Mondrian.

Folgen Sie dieser Idee und erschaffen Sie eine Detektivin basierend auf dem Bild eines männlichen Detektivs und dem Stil von Van Goghs „Sternennacht“.

Wenn die zweite Dimension auf Postimpressionismus trifft, ist die chemische Reaktion wunderbar.

Die Charakterreferenzfunktion kann die Konsistenz des Charakters durch ein Bild erreichen, sodass der Charakter in mehr Bildern und Videos erscheinen kann.

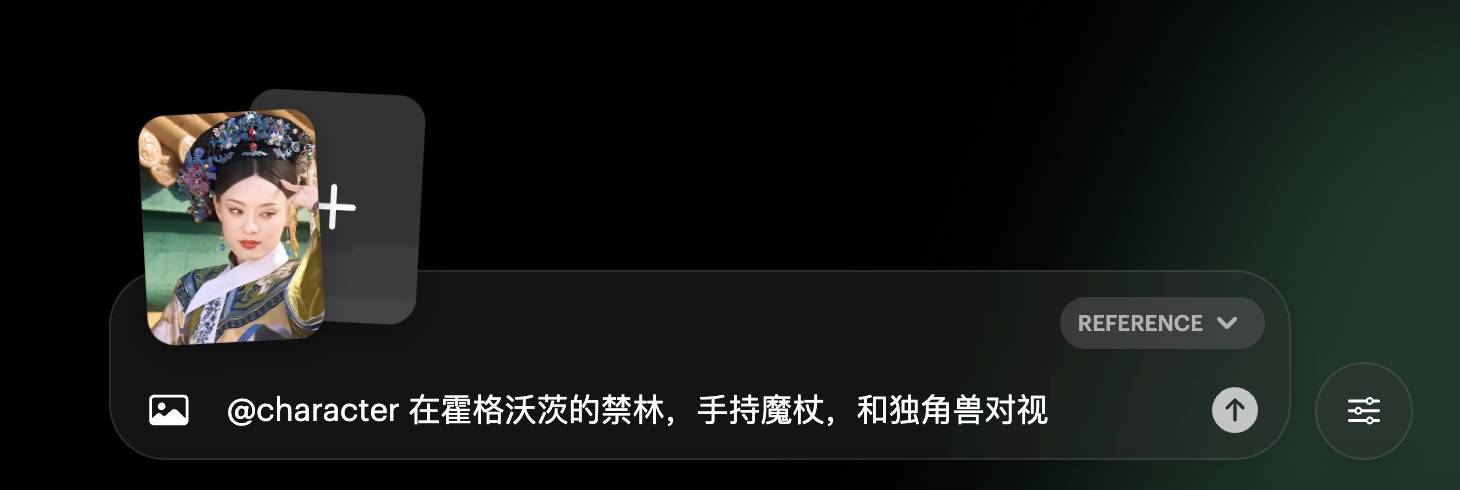

Musk ist eine wandelnde Materialbibliothek. Ich beschloss, Zhen Huan in die Welt von Harry Potter teleportieren zu lassen, um zu sehen, ob sie nach dem Szenenwechsel noch 2,8 Meter groß sein könnte.

Das Ergebnis ist etwas schwer zu kommentieren. Es ist zu erkennen, dass es Zhen Huans Gesicht ist, aber das Aussehen der Kaiserin folgt den lokalen Gepflogenheiten und ihre Gesichtszüge, insbesondere ihre Augen, sind europäischer und amerikanischer geworden.

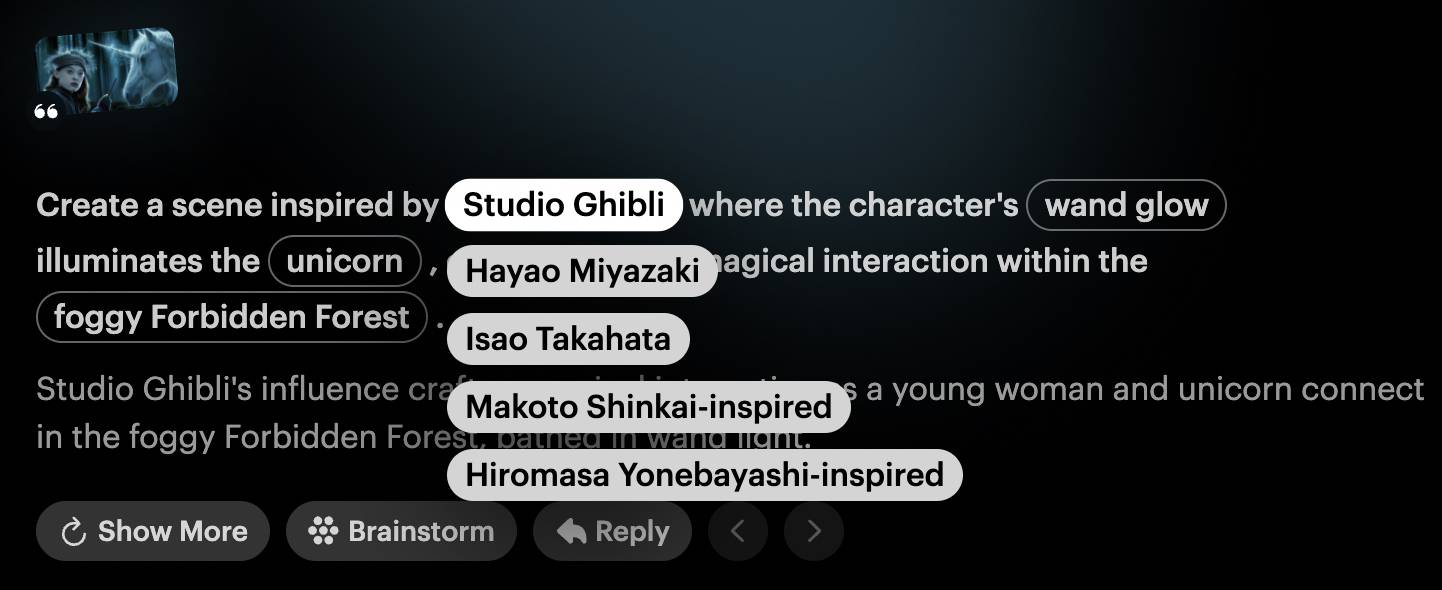

Tatsächlich kann Dream Machine auch verhindern, dass Bilder und Videos für alle verloren gehen, ohne nach zusätzlichen Bildreferenzen zu suchen. Zu diesem Zeitpunkt müssen Sie die „Brainstorming“-Funktion verwenden. Es empfiehlt Ihnen die Stile einiger Künstler Du erzeugst.

Genau wie die Szene, in der Zhen Huan Hogwarts betritt, können wir sie im Studio-Ghibli-Stil nachbilden.

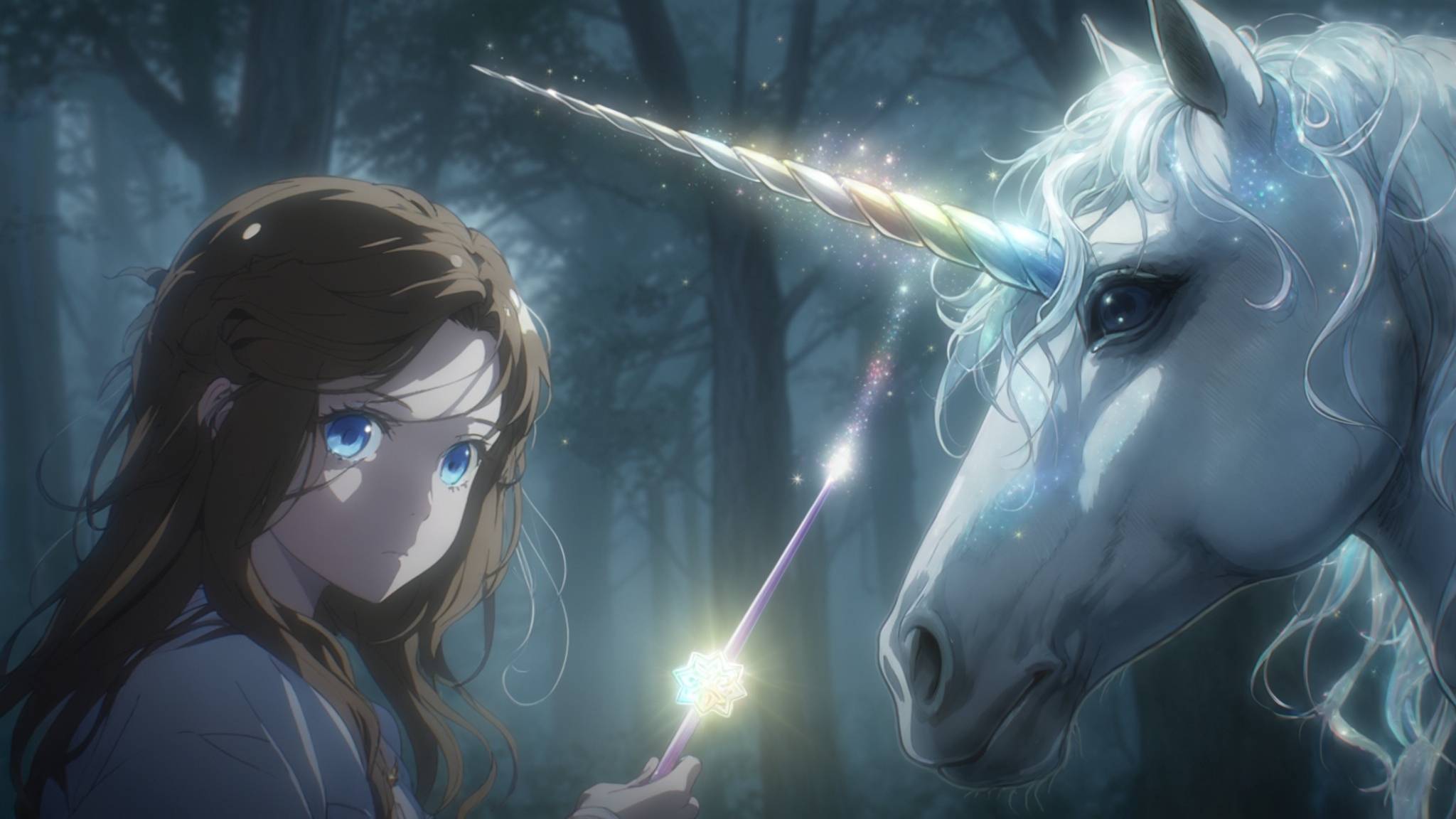

Darüber hinaus sind einige Schlüsselwörter in den Aufforderungswörtern eingerahmt und können durch Dropdown-Optionen ersetzt werden. Dream Machine nennt sie „Konzeptpillen“ und kann den künstlerischen Stil ändern oder Bildelemente mit einem Klick.

Mit nur wenigen Klicks können Sie „Ghibli“ durch „Shinkai Makoto“ und „Unicorn“ durch „Dragon“ ersetzen.

Das Luma Photon-Modell basiert auf der universellen Transformer-Architektur von Luma. Durch die Entwicklung eines eigenen Bildmodells kann Luma AI seine Abhängigkeit von externen Bildmodellen wie Midjourney verringern und gleichzeitig das Problem der Instabilität in Vincent-Videos lösen.

Natürlich ist Video die Spezialität, aber auch für steuerbare Funktionen wie Kamerabewegungen ist Dream Machine unverzichtbar.

Können Zhen Huan in der Verbotenen Stadt und Zhen Huan in Hogwarts einen reibungslosen Übergang schaffen? Bei Verwendung des Zoomobjektivs ist das Bild dynamisch und die Zeichen werden nicht gravierend verformt. Es können 80 Punkte erzielt werden.

Visuelles Denken, Geschichtenerzählen

Zufälligerweise hat Runway vor zwei Tagen, am selben Abend wie das Luma-Update, auch offiziell sein Bilderzeugungsmodell Frame angekündigt. Wenn man sich die Demonstration ansieht, kann man sehen, dass es großen Wert auf Ästhetik legt und derzeit schrittweise Qualifikationen für Gen- öffnet. 3 Alpha.

▲ Laufstegrahmen

Die Qualität der Bilderzeugung, die ästhetische Höhe sowie die Konsistenz und Kontrollierbarkeit des visuellen Stils werden von visuellen Modellen zunehmend geschätzt.

Das ist eine gute Sache für Schöpfer. Wenn wir KI für Grafikdesign und Charaktereinstellungen verwenden, erschaffen wir tatsächlich eine einzigartige Welt und erzählen eine einzigartige Geschichte.

Cristóbal Valenzuela, CEO von Runway, glaubt, dass Runway kein KI-Unternehmen, sondern ein Medien- und Unterhaltungsunternehmen ist und dass die Ära der KI-Unternehmen vorbei ist.

Er verunglimpft KI nicht, im Gegenteil, er glaubt, dass KI eine Art Infrastruktur ist. Die wahre Revolution liegt nicht in der Technologie selbst, sondern in dem, was sie erreicht: neue Ausdrucksformen, neue Arten, Geschichten zu erzählen, und Verbindungen, die sie ermöglicht Neue Methoden verbinden. Dies deckt sich mit der Evolutionsrichtung von Luma.

Nach diesem Update gab Amit Jain, CEO und Mitbegründer von Luma AI, Dream Machine eine interessante Definition – einen Partner für visuelles Denken.

Das Konzept ist etwas abstrakt, aber was er eigentlich meint, ist, visuelle Kreationen wie Bilder und Videos so einfach und intuitiv zu gestalten wie das Chatten.

Die Art und Weise, wie wir interagieren, beeinflusst die Art und Weise, wie wir denken. Der Workflow im Canvas-Stil kann Ideen visualisieren, alle kreativen Prozesse und Ergebnisse aufzeichnen und vollständige Ideen für die Erstellung von Videos präsentieren.

Infinite Canvas ist in Bildmodellen wie Recraft und Ideogram's Canvas normalerweise häufiger anzutreffen. Die Leinwand von Dream Machine ist regelmäßiger, mit Materialien und Variationen, die durch dieselben Aufforderungswörter erzeugt werden, die horizontal angeordnet sind, und verschiedenen, die vertikal angeordnet sind.

Der Prozess des Chattens, Generierens und Optimierens wird den Menschen das Gefühl geben, als sei eine unabhängige kleine Welt auf der Leinwand geboren worden.

Lassen Sie Dream Machine zunächst einen hyperrealistischen Film-CG-Stil verwenden, um den Protagonisten eines Spiels mit einem industriellen Ödland-Hintergrund zu erschaffen.

Verwenden Sie dann eine Surround-Aufnahme, um den Protagonisten zu animieren und ein Gefühl von Räumlichkeit in der Umgebung zu erzeugen.

Dann können wir mit der KI chatten und die KI weiterhin verschiedene Innen- und Außenszenen in der Ödlandwelt generieren lassen und die KI vorschlagen lassen, wie wir sie apokalyptischer machen können.

In gewisser Weise ist diese Leinwand der Rahmen für unsere persönlichen Geschichten.

Natürlich hat Luma AI auch viele Fehler, unter anderem ist die Verwendung eines Bildes zur Erreichung der Zeichenkonsistenz nicht ideal; Bilder und Videos müssen immer noch genau generiert werden Englisch, aber ich kann kein Chinesisch…

Aber die Bedeutung wird gut vermittelt: Sprechen Sie weniger über Parameter, nutzen Sie die Interaktion als Ausgangspunkt und entwickeln Sie ein KI-Erstellungstool.

Ein besseres Videomodell verfügt nicht nur über eine schnellere Generierungsgeschwindigkeit, eine besser kontrollierbare Kamerabewegung und eine einzigartigere Ästhetik, es sollte auch eine bessere Möglichkeit bieten, Geschichten zu erzählen und Texte, Bilder und Videos als Ausdrucksmittel für Ideen zu verwenden.

Traummaschine, Traummaschine.

Erstellen Sie einfach, wie Luma AI sagte: „Es ist nicht nötig, komplizierte Aufforderungsworte zu schreiben, sondern stellen Sie einfach.“ Bei den Fragen, die uns die KI in Zukunft stellt, geht es nicht mehr um Technologie, sondern darum, was wir damit bauen.

# Willkommen beim offiziellen öffentlichen WeChat-Konto von aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner |. Ursprünglicher Link · Kommentare anzeigen · Sina Weibo