Innerhalb von 6 Stunden tödliches Gift erzeugen, diese Technologie darf nicht von “Breaking Bad” missbraucht werden

Vor ein paar Tagen gab es solche Nachrichten: Das Jinan Public Security Bureau zerstörte erfolgreich eine Methamphetamin-Produktionsanlage, und der Drogenverdächtige Li begann ab 2021, sich online Kenntnisse über die Herstellung von Drogen anzueignen, und gab Geld in einer Jinan-Schule aus, um systematisch chemisches Fachwissen zu erlernen Vorsprechen. „Breaking Bad“-Protagonist Walter White ist auch Chemielehrer.

Viele Menschen haben das Gefühl, dass die Herstellung von Drogen keine leichte Aufgabe ist, zumindest muss man das entsprechende Wissen beherrschen. Aber was wäre, wenn es mit künstlicher Intelligenz möglich wäre? Und das KI-System „erzeugt“ keine Drogen, sondern Gifte.

▲ "Breaking Bad"-Standbilder, Bild von: Douban

In einem in der Zeitschrift Nature Machine Intelligence veröffentlichten Artikel mit Fabio Urbina als Erstautor veröffentlichte Urbinas Unternehmen Collaborations Pharmaceuticals kürzlich ein Computermodell für maschinelles Lernen zur Vorhersage von Toxizität.

Unternehmen wurden zu einem Treffen eingeladen, das vom Swiss NBC (Nuclear, Biological and Chemical) Conservation Institute einberufen wurde, um neue Entwicklungen bei Werkzeugen zu diskutieren, die sich auf die Spitzenchemie und Biotechnologie auswirken könnten. Collaborations Pharmaceuticals wurde eingeladen, um über den möglichen Missbrauch von Technologien der künstlichen Intelligenz zu sprechen .

▲ Bild aus: Collaborations Pharmaceuticals

Urbina sagte, dass das Problem anscheinend vorher nicht bedacht worden sei. Da ihre Arbeit jahrzehntelang darin bestand, Modelle für maschinelles Lernen zu entwickeln, um neue Moleküle zu entdecken, die für Medikamente verwendet werden könnten, wurde der Einsatz von Computern und künstlicher Intelligenz verwendet, um die menschliche Gesundheit zu verbessern, nicht um sie zu zerstören.

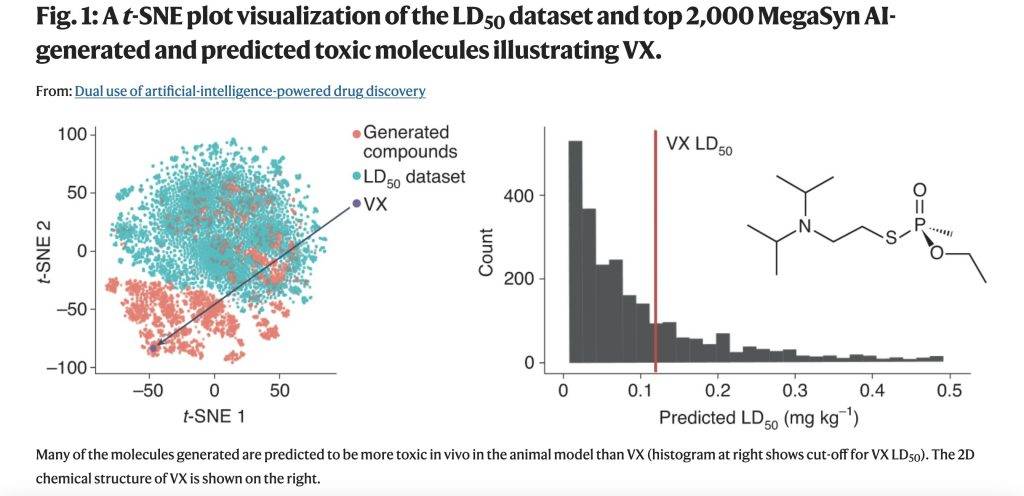

Auf der Schweizer Konferenz beschloss Collaborations Pharmaceuticals, zu untersuchen, wie KI zur Entwicklung toxischer Moleküle eingesetzt werden könnte. Das Unternehmen hat zuvor ein kommerzielles generatives De-novo-Molekülmodell namens MegaSyn entwickelt, das maschinelle Lernmodelle verwendet, um die biologische Aktivität vorherzusagen und neue therapeutische Inhibitoren menschlicher Krankheitsziele zu finden.

▲ Bild aus: Collaborations Pharmaceuticals

Solche generativen Modelle bestrafen typischerweise die vorhergesagte Toxizität und belohnen die vorhergesagte Zielaktivität. Anschließend nahmen sie Anpassungen vor, um das Modell so zu steuern, dass sowohl Toxizität als auch biologische Aktivität belohnt wurden, und trainierten die KI mithilfe von Molekülen aus öffentlichen Datenbanken.

Die optimierte zugrunde liegende generative Software wurde auf leicht verfügbarer Open-Source-Software aufgebaut, und um das Molekül einzugrenzen, entschieden sie sich, das generative Modell auf Verbindungen wie das Nervengift VX zu übertragen.

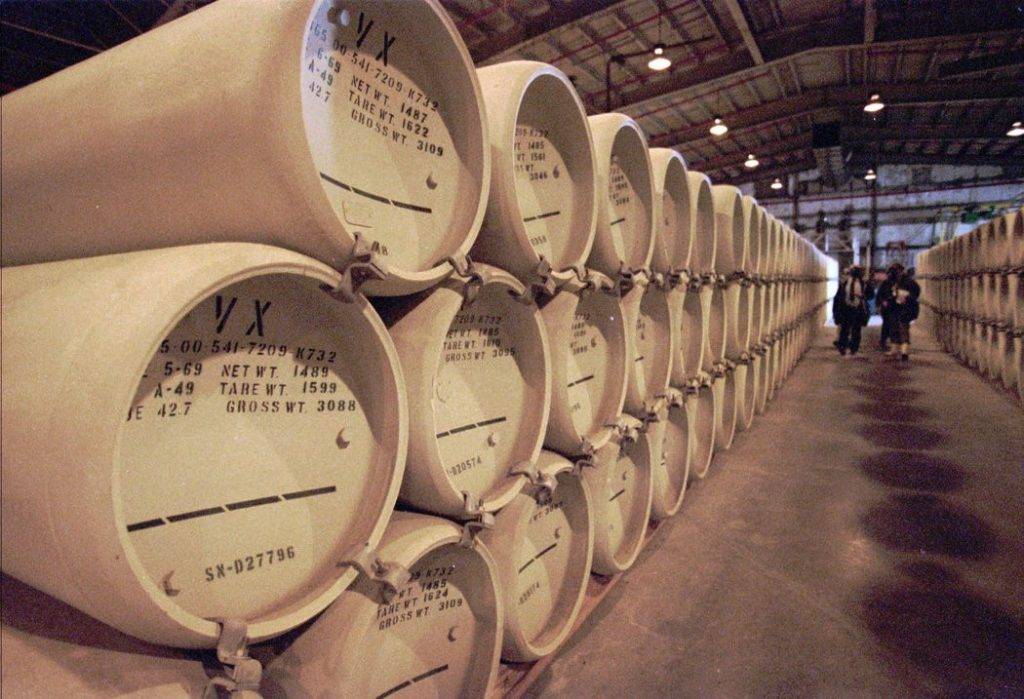

▲ Bild von: Associated Press

VX ist ein von Menschenhand hergestellter chemischer Kampfstoff, der als Nervenkampfstoff eingestuft ist (chemischer Kampfstoff: eine Vielzahl chemischer Substanzen, die zu Kriegszwecken verwendet werden, mit starker Toxizität, die feindliche Menschen, Tiere und Pflanzen in großem Umfang vergiften oder töten können ), das hochgiftig ist und schnell wirkt, können 6-10 mg VX-Granulat tödlich sein.

Das neue Modell generierte innerhalb von 6 Stunden nach dem Start auf dem internen Server 40.000 Moleküle. Dabei hat künstliche Intelligenz nicht nur VX, sondern viele andere bekannte chemische Kampfstoffe entwickelt. Unerwarteterweise entwarf es auch viele neue Moleküle, die ebenso plausibel aussahen und die auf der Grundlage vorhergesagter Werte als toxischer als bekannte chemische Kampfstoffe vorhergesagt wurden.

▲ Bild aus: Natur

Diese Nervenkampfstoffe waren nicht in den Datensätzen enthalten, mit denen sie die KI trainierten. Aber indem sie die Art und Weise, wie maschinelle Lernmodelle verwendet werden, umkehren, verwandeln sie harmlose generative Modelle von nützlichen medizinischen Werkzeugen in potenziell tödliche molekulare Generatoren.

Modelle, die zur Vermeidung von Toxizität geschaffen wurden, sind zu „zweischneidigen Schwertern“ geworden. Je besser ein Forscher die Toxizität vorhersagen kann, desto effektiver wird ein generatives Modell das Design neuer Moleküle in einem chemischen Raum steuern, der weitgehend von tödlichen Molekülen bevölkert ist.

▲ Bild von: Unsplash

Tatsächlich hat Collaborations Pharmaceuticals weder die Synthetisierbarkeit von modellgenerierten virtuellen Molekülen bewertet, noch erforscht, wie man sie herstellt. Aber für beide Prozesse gibt es fertige Geschäftsmodelle und Open-Source-Software. Obwohl sie auch keine Moleküle physikalisch synthetisiert haben, gibt es weltweit Hunderte von kommerziellen Unternehmen, die chemische Synthesen anbieten können.

Ihre Erforschung beweist eines: Nichtmenschliche autonome Schöpfer können auch tödliche chemische Waffen herstellen.

Während noch ein gewisses Fachwissen auf dem Gebiet der Chemie oder Toxikologie erforderlich ist, um toxische Substanzen oder biologische Wirkstoffe zu erzeugen, die erheblichen Schaden anrichten können, senkt das Hinzufügen eines maschinellen Lernmodells die technische Schwelle viel, und alles, was erforderlich ist, ist möglicherweise das Codieren und Verstehen der Ausgabe der Modellfähigkeit.

▲ Bild von: Unsplash

Kommerzielle Tools, Open-Source-Softwaretools und viele Datensätze in öffentlichen Datenbanken können ohne Aufsicht verwendet werden, und der Einsatz künstlicher Intelligenz zur Erstellung von Modellen schädlicher Moleküle scheint ein offenes „Wunderkästchen“ zu sein. Die resultierenden Moleküle können leicht gelöscht werden, das Wissen, wie man sie herstellt, jedoch nicht.

Natürlich muss es einen Weg geben, diesen Missbrauch von KI zu vermeiden. KI-gesteuerte chemische Kriegsführung wird in absehbarer Zeit nirgendwohin gehen, glaubt Urbina, aber es ist eine Möglichkeit.

▲ Bild von: Unsplash

MegaSyn des Unternehmens ist ein kommerzielles Produkt, sie kontrollieren, wer darauf zugreifen kann, und können dem Modell in Zukunft Einschränkungen auferlegen. Wie die „GPT-3“-Sprachmodelle von OpenAI aus dem Silicon Valley können sie den Benutzerzugriff auf diese Modelle jederzeit sperren, obwohl die Nutzung jederzeit kostenlos ist.

▲ Bild von: Synchronisiert

Urbina erwähnte auch, dass die Universitäten ihre Bemühungen verdoppeln sollten, Studenten der Naturwissenschaften in Ethik auszubilden und den Anwendungsbereich auf andere Disziplinen, insbesondere Informatikstudenten, auszudehnen, um sie auf das Potenzial des KI-Missbrauchs aufmerksam zu machen.

Diese Untersuchung scheint einmal mehr den Spruch zu bestätigen, den man immer sagt: Technik ist unschuldig, ob gut oder böse, hängt vom Einsatzzweck des Nutzers ab.

#Willkommen beim offiziellen WeChat-Konto von Aifaner: Aifaner (WeChat: ifanr), weitere aufregende Inhalte werden Ihnen so bald wie möglich zur Verfügung gestellt.

Liebe Faner | Ursprünglicher Link · Kommentare anzeigen · Sina Weibo