KI-Tasten „besetzen“ Mobiltelefone und Computer. Ist das Erlebnis wirklich besser?

Ich habe mir vor einiger Zeit das brandneue Samsung Galaxy S25 zugelegt. Die Redaktion bat mich, mich darauf zu konzentrieren, die berühmte KI-Funktion dieses Telefons zu erleben, also nutzte ich es als mein Hauptgerät und ersetzte das iPhone 15 in meiner Hand, was nichts mit KI zu tun hatte.

Abgesehen davon, ob Galaxy AI einfach zu bedienen ist oder nicht, nahm während dieser Erfahrung nach und nach eine andere Idee in meinem Kopf Gestalt an: Derzeit scheint es für die Interaktion zwischen Benutzern und Mobiltelefonen kein Paradigma zu geben, das KI gut berücksichtigen kann.

Dies wirft auch die Frage auf: Ist es notwendig, eine spezielle Schaltfläche für KI hinzuzufügen?

Ich möchte einen KI-Knopf

Diese Idee stammt aus meiner Erfahrung, als ich gerade das Samsung Galaxy S25 bekam.

Da wir „KI“ erleben wollen, wo ist die KI? Die erste Reaktion war definitiv das lange Drücken und Halten der langen Taste, die früher „Power-Taste“ genannt wurde. Tatsächlich wurde Samsungs KI-Sprachassistent Bixby aufgerufen. Das Bixby-Erlebnis mit integrierten großen Modellen ähnelt dem der meisten heimischen Mobiltelefone. Es ist eloquent und kann Ihnen dabei helfen, in einem Satz auf Moments zu posten.

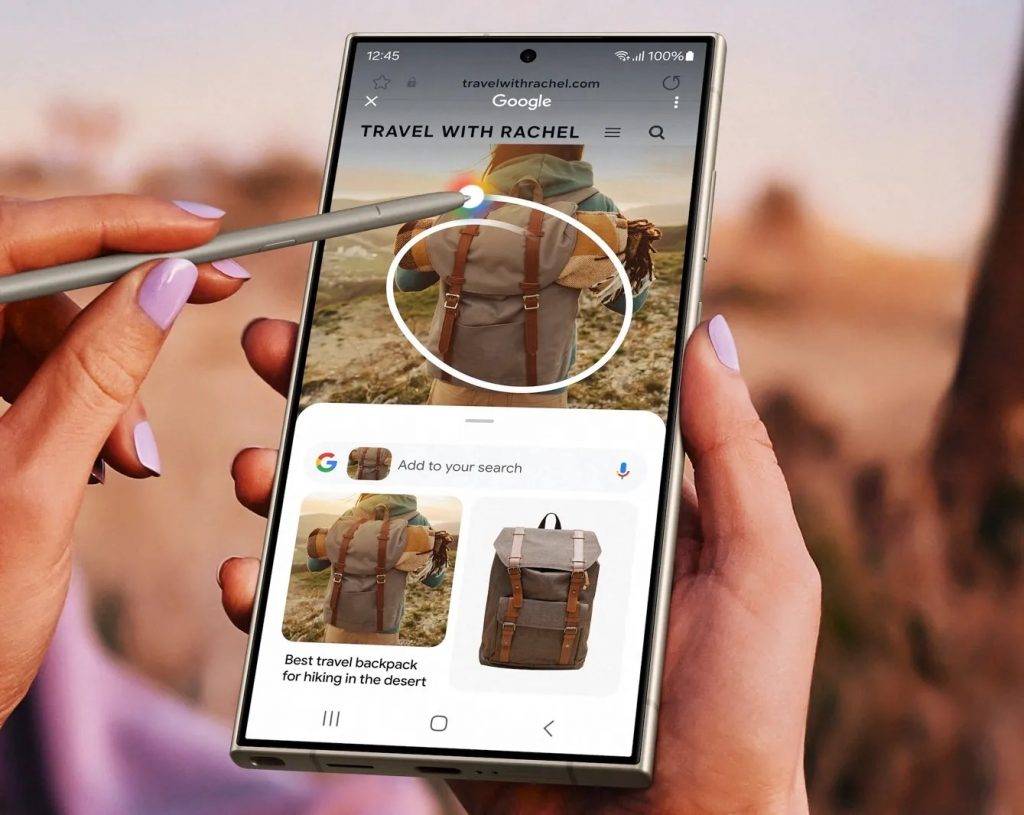

Aber wenn ich multimodale Funktionen wie Kreisklicksuche und KI-Objekterkennung nutzen möchte, bin ich etwas verwirrt. Wo sind diese Funktionen versteckt?

Es gibt keine Tutorials und keine Anleitung. Mit anderen Worten: Wenn es sich um unerfahrene Benutzer handelt, die nicht viel über die KI von Mobiltelefonen wissen, wissen sie wahrscheinlich nicht, dass das neue Telefon, das sie für Tausende von Dollar gekauft haben, auch die neuen Funktionen enthält, über die auf der Pressekonferenz gesprochen wurde.

Dieses Phänomen ist nicht nur auf Samsung beschränkt. Auch heimische Hersteller legen großen Wert auf Mobilfunk-KI. Die richtige Art und Weise, KI einzuschalten, ist immer verwirrend: Langes Drücken der Navigationsleiste, langes Drücken des Netzschalters, „KI-Insel“ … Jedes Unternehmen ist nicht genau gleich und verschiedene KI-Funktionen sind in verschiedene, etwas abstrakte Interaktionen gestopft.

Doch inzwischen hat die KI eine strategische Position mit sehr hoher Priorität erlangt. Unabhängig vom Gerät oder der Plattform muss „KI“ erwähnt werden, und jeder Vorgang kann durch KI unterstützt werden.

Ich kann also nicht anders, als darüber nachzudenken. Wenn es eine physische Taste gibt, die speziell mit KI-Funktionen interagiert, drücken Sie sie einfach, egal um welche Szene es sich handelt, und Sie können KI-Unterstützung erhalten.

Darüber hinaus kann die Erstellung einer speziellen Schaltfläche Verbrauchern und Benutzern einen tieferen Eindruck von „KI-Mobiltelefonen“ vermitteln.

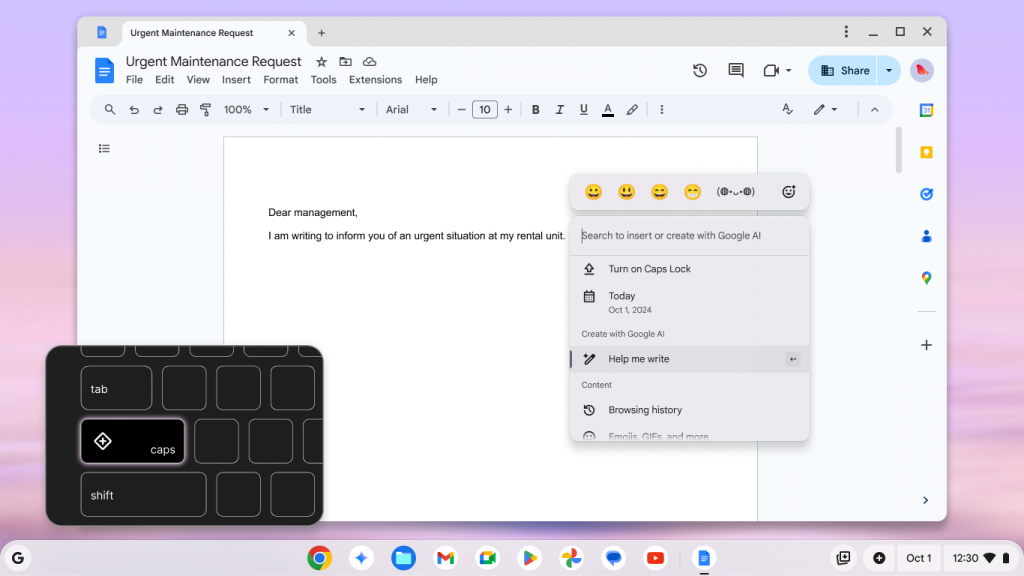

Das Konzept der KI-Buttons ist eigentlich nicht besonders neu. Wenn Sie jetzt einen neuen Windows-Laptop kaufen, werden Sie höchstwahrscheinlich feststellen, dass sich links neben den Pfeiltasten eine brandneue Schaltfläche befindet.

Seit letztem Jahr hat Microsoft eine neue Spezifikation eingeführt: Alle „AI PC“-Notebooks müssen vor Verlassen des Werks mit einer „Copilot“-Taste ausgestattet sein, wodurch die KI-Funktionen auf ein höheres Niveau gehoben werden.

Obwohl ein Jahr später diese Copilot-Schaltfläche im Grunde nur zum Aufrufen der Windows Copilot-Chatbot-Webanwendung verwendet werden kann, und wenn Sie sich in einer Region befinden, in der Copilot sie nicht unterstützt, handelt es sich lediglich um eine gewöhnliche Suchschaltfläche.

Die „KI-Tasten“ eines anderen Desktop-Camps sind viel nützlicher. Google hat im vergangenen Jahr auch damit begonnen, die Schaltfläche „Quick Insert“ auf der ChromeBook-Tastatur zu bewerben. Drücken Sie darauf, um schnell auf das AI-Generierungstool-Menü von ChromeOS zuzugreifen, schnell den erforderlichen Text- und Bildinhalt zu generieren oder Suchvorgänge durchzuführen.

Auf Apples Seite ist das iPhone früher als der Mac mit der Einführung des „AI-Buttons“ ausgestattet: Über den neuen „Foto-Button“ des iPhone 16 lassen sich nicht nur Fotos aufnehmen, sondern auch die Funktion „Visuelle Intelligenz“ aktivieren; Die iPhone 15 Pro- und iPhone 16e-Serien, die über keine Fototaste verfügen, legen diese Interaktion auf die Bedientaste, sodass Benutzer mit Apple-Smartphones einfacher die Hand heben können, um die Welt zu sehen.

Die aktuelle Form der KI gibt sich nicht mehr mit Chatbots zufrieden, die Fragen stellen und beantworten. Verschiedene multimodale und intelligente Agenten sind in unsere Arbeitsabläufe und Geräte eingedrungen. Dies ist auch die von den Herstellern mittlerweile befürwortete „KI auf Systemebene“.

Zukünftig werden die KI-Funktionen auf Geräten auf jeden Fall vielfältiger sein als bisher. Derzeit ist eine spezielle KI-Taste erforderlich, um diese Funktionen auszuführen.

▲ Jetzt können die Seitentasten den Sprachassistenten aufrufen, aber das reicht möglicherweise nicht aus

Wenn ein Benutzer beispielsweise den Beitrag eines Restaurants auf Xiaohongshu liest, kann er durch Drücken der KI-Taste automatisch relevante Adressinformationen extrahieren, detaillierte Bewertungen aus Dianping pushen und automatisch einen geeigneten Zeitplan vereinbaren.

Unerwarteterweise tauchten tatsächlich einige Geräte mit unterschiedlichen „KI“-Tasten vor mir auf.

Wie ist die Erfahrung mit verschiedenen KI-Tasten?

Als neue Marke verfügt Nothing über keine große Technologieakkumulation und es ist schwierig, wie bei anderen großen Marken Lösungen für „KI auf Systemebene“ zu entwickeln. Daher kann die Integration von Sprachassistenten nur auf Google Gemini und ChatGPT zurückgreifen.

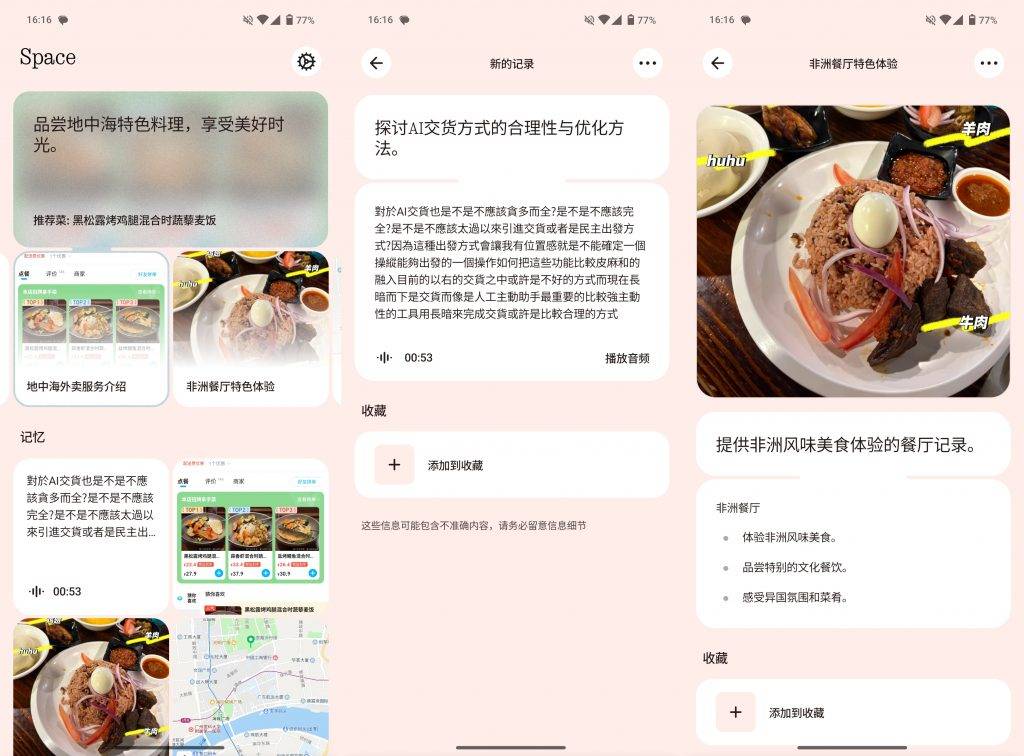

Noch einzigartiger ist jedoch die KI-Funktion des neuen Nothing Phone 3a: Sie heißt „Essential Space“ und ähnelt in gewisser Weise der „Snap Nian Capsule“ von Lao Luo.

Benutzer können jederzeit die Essential-Taste unter der Schaltfläche zum Sperren des Bildschirms drücken, um einen Screenshot zu erstellen und eine kleine Textbeschreibung hinzuzufügen, oder lange auf die Aufnahme drücken, um Text zu senden. Die KI erkennt im Hintergrund auch den Inhalt des Screenshots und der Aufnahme und erstellt eine Zusammenfassung.

▲ Unterhalb des Power-Buttons befindet sich der AI-Button. Quelle: The Wired

Das Konzept ist schön, aber der Nutzen bleibt etwas hinter meinen Erwartungen zurück. Ein Problem ist, dass ich mich oft kaum daran erinnern kann, dass es eine solche Funktion gibt, und die Anzahl der versehentlichen Berührungen ist viel höher als die des aktiven Erwachens.

Schließlich ist es nicht einfach, Benutzer dazu zu bringen, neue Nutzungsgewohnheiten zu entwickeln, es sei denn, es handelt sich um eine erstklassige Funktion, zu der Benutzer nicht mehr zurückkehren können, sobald sie sie berührt haben. Und dieser grobe und unzuverlässige Essential Key ist nützlich, aber nicht besonders einfach zu verwenden. Die Zusammenfassung und die Spracherkennung sind nicht besonders genau. Es handelt sich eher um eine Screenshot-Taste und eine Aufnahmetaste, um wichtige Informationen an einem anderen Ort zu speichern.

Aber gleichzeitig hat ein weiterer „KI-Knopf“ bei vielen Freunden in der Redaktion großes Lob erhalten.

Diese „KI-Tastatur“, die auf den ersten Blick sehr beeindruckend aussieht, ist eigentlich eine gewöhnliche Tastatur für 50 Yuan, plus viele Tasten, die mit einem Klick direkt auf die entsprechenden KI-Funktionen zugreifen können: Dokumentkorrekturlesen, Leseverständnis, KI-Frage und -Antwort, KI-Schreiben … Sie ist in das DeepSeek R1-Modell integriert und der Preis liegt bei bis zu 399 Yuan.

Zuerst erschien diese Tastatur in unserer Diskussion als eine Art „IQ-Steuer“, aber als ich anfing, war ich von dieser einfachen und groben Interaktionsmethode beeindruckt und sagte zu jedem, den ich traf, Ja.

Der Grund ist ganz einfach. Für viele dieser Ein-Klick-KI-Funktionen muss ich zuerst auf die Browserseite klicken, dann auf das DeepSeek-Lesezeichen klicken und dort die entsprechende Eingabeaufforderung eingeben, bevor ich diese Funktionen tatsächlich nutzen kann.

Obwohl ich weiß, dass DeepSeek und ChatGPT über bessere Übersetzungs- und Korrekturlesefunktionen verfügen, entscheide ich mich dennoch oft für die Verwendung älterer Tools, weil ich zu faul bin, die entsprechende Seite zu öffnen und Eingabeaufforderungen einzugeben.

All dies wurde durch diese praktische KI-Tastatur zunichte gemacht, die es der KI tatsächlich ermöglichte, direkt in meinen Arbeitsablauf einzudringen.

▲Tastaturgebundene KI-Software hat wirklich alles

Antworten zur KI-Interaktion

Ob KI-Tasten hinzugefügt werden sollen oder nicht, ist immer noch eine Frage des „Zugangs“. Der Wunsch nach einer KI-Schaltfläche bedeutet tatsächlich, sich nach einem einheitlichen KI-Zugang zu sehnen, damit die KI alle Vorgänge und Interaktionen steuern kann.

Die KI-Tastatur schiebt die Eingabe verschiedener KI-Funktionen auf einfache und grobe Weise direkt in meine Hände, und der Weg zur Realisierung der Funktionen wird auf die kürzestmögliche Zeit verkürzt.

Das liegt natürlich auch daran, dass die Funktionen der KI-Tastatur allesamt produktivitätsrelevant sind und sich perfekt in meinen Computer-Workflow integrieren lassen, was die Arbeitseffizienz enorm steigert.

Mobiltelefone und Computer unterscheiden sich hinsichtlich Interaktion und Szenen erheblich. Am Computer können wir DeepSeek zehn verschiedene Manuskripte generieren lassen und das beste für die Zulassung auswählen; Auf dem Mobiltelefon hoffen wir, dass die KI die Aufgabe mit einem einzigen Befehl erledigen kann, aber der aktuelle technische Stand ist nicht 100 % zuverlässig und es ist schwierig, Benutzer davon zu überzeugen, sie aktiv zu nutzen.

Die Einrichtung einer separaten Schaltfläche für KI ist möglicherweise nicht die endgültige Lösung, unabhängig von der Perspektive der Entwicklung intelligenter Geräte oder dem Entwicklungspfad der KI. Es ist bestenfalls nur ein Übergang.

Nicht nur, dass Smartphones selbst auf dem Weg zum „Entknöpfen“ voranschreiten, sondern die übermäßige Abhängigkeit von einem physischen Zugang wird auch die Wahrnehmung von „KI = unabhängiges Werkzeug“ festigen. Die derzeit anerkannten KI-Lösungen ermöglichen es der KI tatsächlich, tief in die unterste Schicht des Systems einzudringen, um „echte Intelligenz“ zu erreichen.

Schließlich ist KI kein Zweck, sondern ein Mittel zu einer besseren Benutzererfahrung.

Genau wie Nothing's Essential Space: Wenn es vollständig automatisiert werden kann und ich bei Bedarf schnell Informationen suchen und abrufen kann, die ich zuvor gesehen habe, beispielsweise Informationen zu einem Restaurant oder einem Flugzeug, die in einer riesigen Menge an Chat-Aufzeichnungen untergehen, wäre das eine fortschrittlichere Intelligenz.

▲ Apple Huabings „AI Siri“ möchte diese Vision tatsächlich verwirklichen

Auch Vivos „Atomic Island“ vermittelt dieses Gefühl: Kopieren Sie eine Adressinformation und Atomic Island schlägt eine Kartennavigation vor; Kopieren Sie ein Taobao-Passwort und Taobao auf Atomic Island wartet darauf, dass Sie es öffnen.

Eine wirklich intelligente und einfache Interaktion sollte nicht erfordern, dass Benutzer ihre Aufmerksamkeit häufig verlagern müssen, um sie abzuschließen. Stattdessen können Benutzer bei Bedarf auf einfachste Weise die Hilfe erhalten, die sie benötigen, und in den meisten Fällen ergreifen sie sogar die Initiative, Hilfe zu leisten.

Ich glaube, dass in den nächsten Jahren mehr Geräte versuchen werden, KI-Tasten zu verwenden, aber diese werden irgendwann verschwinden und noch mehr bestehende Interaktionen werden nicht mehr existieren, weil die KI bereits alles erledigt hat.

# Willkommen beim offiziellen öffentlichen WeChat-Konto von aifaner: aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner | Ursprünglicher Link · Kommentare anzeigen · Sina Weibo