Lassen Sie GPT-4 sich nicht noch einmal weiterentwickeln! Musk übernahm die Führung bei der Unterzeichnung eines gemeinsamen Briefes von Tausenden von Menschen, in dem KI-Labore dringend aufgefordert wurden, die Forschung sofort einzustellen

Bisher haben wir viele digitale Revolutionen erlebt, darunter das Aufkommen grafischer Schnittstellen, die Geburt des Internets und die Popularisierung des mobilen Internets, aber keine technologische Veränderung hat eine so weit verbreitete Panik ausgelöst wie die durch die GPT ausgelöste KI-Welle Modell.

Einerseits hat KI die Art und Weise, wie Menschen arbeiten und leben, verändert und die Effizienz stark verbessert; andererseits sind der Betrieb und die Entwicklung von KI voller Unsicherheiten, die den natürlichen Schutzmechanismus des Menschen gegen Unbekanntes auslösen – Angst.

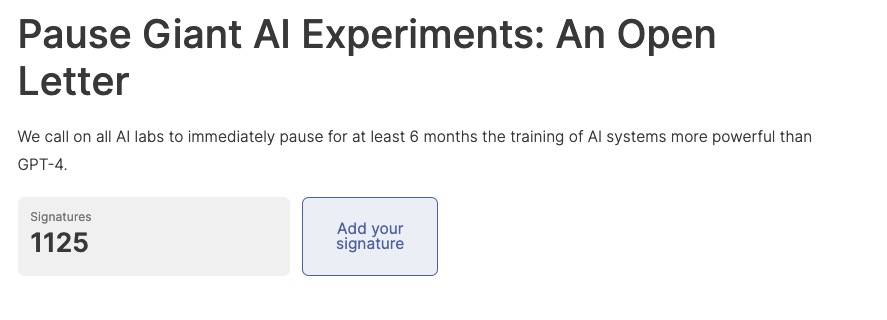

Heute explodierte ein öffentlicher gemeinsamer Brief im Internet, in dem alle KI-Experimente aufgefordert wurden, die Forschung an KI-Modellen, die weiter fortgeschritten sind als GPT-4, unverzüglich für mindestens 6 Monate auszusetzen, um diese schrecklichen Fantasien in Zukunft zu töten.

Die Geschwindigkeit des KI-Fortschritts ist erstaunlich, aber relevante Überwachungs- und Prüfungsmethoden haben nicht Schritt gehalten, was bedeutet, dass niemand die Sicherheit von KI-Tools und den Prozess der Verwendung von KI-Tools garantieren kann.

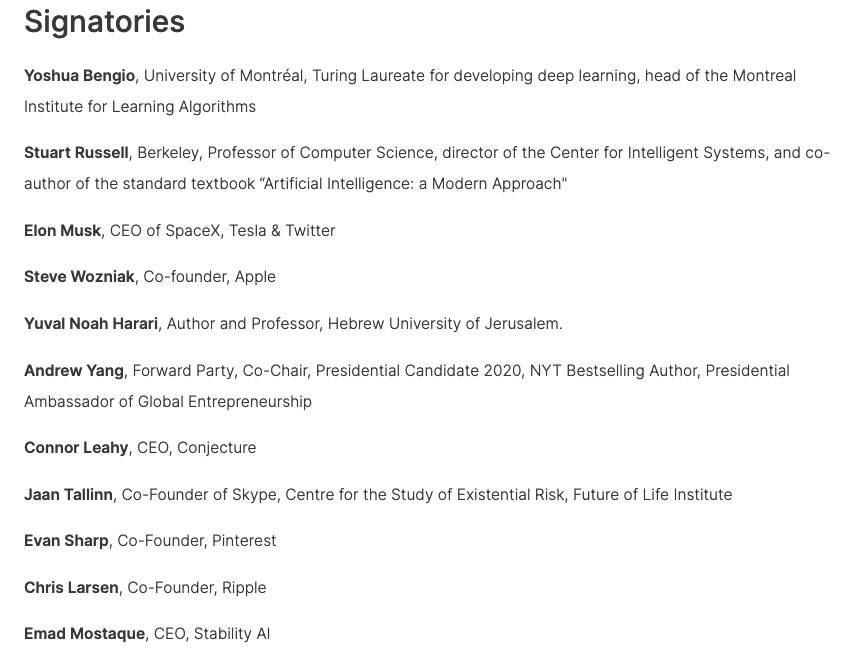

Der gemeinsame Brief wurde von vielen bekannten Persönlichkeiten unterschrieben, darunter der Gewinner des Turing-Preises 2018, Yoshua Bengio, Musk, Steve Wozniak, Mitbegründer von Skype, Mitbegründer von Pinterest, CEO von Stability AI usw., die Anzahl der Mitunterzeichner 1125 vor Ablauf der Frist erreicht hat.

Der Originaltext des offenen Briefes lautet wie folgt:

Künstliche Intelligenz hat Intelligenz, um mit Menschen zu konkurrieren, was tiefgreifende Risiken für die Gesellschaft und die Menschen mit sich bringen kann, was durch eine große Anzahl von Studien bestätigt wurde [1] und von führenden KI-Labors anerkannt wurde [2]. Wie die weithin anerkannten KI-Prinzipien von Asilomar besagen, könnte fortschrittliche KI eine große Transformation in der Geschichte des Lebens auf der Erde darstellen und sollte daher mit entsprechender Aufmerksamkeit und Ressourcen geplant und verwaltet werden.

Leider waren KI-Labore selbst in den letzten Monaten in einem außer Kontrolle geratenen Wettlauf um die Entwicklung und den Einsatz immer leistungsfähigerer digitaler Köpfe, die niemand verstehen, vorhersagen oder zuverlässig kontrollieren kann, selbst wenn sie das auch nicht könnten.

Da moderne KI-Systeme jetzt bei gemeinsamen Aufgaben mit Menschen konkurrieren [3], müssen wir uns fragen:

- Sollten wir zulassen, dass Maschinen unsere Informationskanäle überschwemmen und Propaganda und Lügen verbreiten?

- Sollten wir alle Jobs automatisieren, auch die befriedigenden?

- Sollten wir einen nichtmenschlichen Verstand entwickeln, der uns schließlich übertreffen und ersetzen kann?

- Sollten wir riskieren, die Zivilisation außer Kontrolle zu bringen?

Diese Entscheidungen sollten nicht von nicht gewählten Technologieführern getroffen werden. Erst wenn wir überzeugt sind, dass die Wirkung des KI-Systems positiv und die Risiken überschaubar sind, sollten wir leistungsfähige KI-Systeme entwickeln. Dieses Vertrauen muss begründet sein und wächst mit der potenziellen Wirkung des Systems. In der jüngsten Erklärung von OpenAI zur künstlichen Intelligenz heißt es: „Irgendwann kann es erforderlich sein, eine unabhängige Überprüfung einzuholen, bevor mit dem Training zukünftiger Systeme begonnen wird, und für hochmoderne Bemühungen, sich darauf zu einigen, die Wachstumsrate der zur Erstellung verwendeten Berechnungen zu begrenzen neue Modelle." Dem stimmen wir zu. Jetzt ist dieser Moment.

Daher fordern wir ein sofortiges Moratorium für alle KI-Labore für mindestens 6 Monate vom Training von KI-Systemen, die leistungsfähiger als GPT-4 sind. Diese Suspendierung sollte öffentlich und überprüfbar sein und alle wichtigen Akteure umfassen. Wenn ein solches Moratorium nicht schnell umgesetzt werden kann, sollte die Regierung eingreifen und ein Moratorium verhängen.

KI-Labore und unabhängige Experten sollten diese Pause nutzen, um gemeinsam an der Entwicklung und Implementierung eines gemeinsamen Satzes fortschrittlicher KI-Design- und Entwicklungssicherheitsprotokolle zu arbeiten, die von unabhängigen externen Experten streng überprüft und überwacht werden sollten.

Diese Protokolle sollen sicherstellen, dass Systeme, die sich an sie halten, zweifelsfrei sicher sind [4]. Dies bedeutet nicht, die KI-Entwicklung zu unterbrechen, sondern einfach einen Schritt zurückzutreten aus dem immer gefährlicheren Wettlauf zu größeren, unvorhersehbaren Black-Box-Modellen und ihren aufkommenden Fähigkeiten.

KI-Forschung und -Entwicklung sollte sich auf die Verbesserung der Genauigkeit, Sicherheit, Erklärbarkeit, Transparenz, Robustheit, Ausrichtung, Vertrauenswürdigkeit und Loyalität bestehender robuster, fortschrittlicher Systeme konzentrieren.

Gleichzeitig müssen KI-Entwickler mit politischen Entscheidungsträgern zusammenarbeiten, um die Entwicklung von KI-Governance-Systemen dramatisch zu beschleunigen. Diese sollten mindestens enthalten:

- Eine neue, kompetente Regulierungsbehörde für KI;

- Überwachung und Verfolgung von KI-Systemen mit hoher Kapazität und großen Rechenleistungspools;

- Herkunfts- und Wasserzeichensysteme zur Unterscheidung echter von synthetischen Inhalten, Verfolgung von Modelllecks;

- Robustes Audit- und Zertifizierungs-Ökosystem, Verantwortlichkeit für durch KI verursachte Schäden;

- Angemessene öffentliche Finanzierung der technischen KI-Sicherheitsforschung;

- Eine erfahrene Institution, die sich mit den massiven wirtschaftlichen und politischen Veränderungen befasst, die KI verursachen wird, insbesondere mit den Auswirkungen auf Demokratien.

Die Menschheit kann mit Hilfe von KI eine erfolgreiche Zukunft genießen. Nachdem es uns gelungen ist, leistungsstarke KI-Systeme zu schaffen, können wir jetzt einen „KI-Sommer“ genießen, in dem wir die Früchte der Nutzung dieser Systeme ernten, die ausdrücklich allen zugute kommen und der Gesellschaft die Möglichkeit geben, sich anzupassen.

Die Gesellschaft hat angesichts anderer Technologien, die katastrophale Auswirkungen auf die Gesellschaft haben könnten, die Pause-Taste gedrückt [5]. Hier können wir dasselbe tun. Lasst uns einen langen KI-Sommer genießen, anstatt unvorbereitet in den Herbst zu stürzen.

Referenzinformationen:

[1]

Bender, EM, Gebru, T., McMillan-Major, A., & Shmitchell, S. (2021, März): Über die Gefahren stochastischer Papageien: Können Sprachmodelle zu groß sein?In Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency (S. 610-623).

Bostrom, N. (2016), Superintelligenz, Oxford University Press.

Bucknall, BS, & Dori-Hacohen, S. (2022, Juli), Current and Near-term AI as a potential existential risk factor, in Proceedings of the 2022 AAAI/ACM Conference on AI, Ethics, and Society (S. 119). -129).

Carlsmith, J. (2022).Is Power-Seeking AI an Existential Risk?.arXiv preprint arXiv:2206.13353.

Christian, B. (2020), The Alignment Problem: Machine Learning and human values, Norton & Company.

Cohen, M. ua (2022), Advanced Artificial Agents Intervene in the Provision of Reward, AI Magazine, 43(3) (S. 282-293).

Eloundou, T., ua (2023): GPTs sind GPTs: An Early Look at the Labour Market Impact Potential of Large Language Models.

Hendrycks, D., & Mazeika, M. (2022), X-risk Analysis for AI Research, arXiv preprint arXiv:2206.05862.

Ngo, R. (2022), The Alignment Problem from a Deep Learning Perspective, arXiv Preprint arXiv:2209.00626.

Russell, S. (2019): Human Compatible: Artificial Intelligence and the Problem of Control. Viking.

Tegmark, M. (2017), Leben 3.0: Menschsein im Zeitalter der künstlichen Intelligenz, Knopf.

Weidinger, L. et al (2021), Ethische und soziale Schadensrisiken durch Sprachmodelle, arXiv-Preprint arXiv:2112.04359.

[2]

Ordonez, V. ua (2023, 16. März) Sam Altman, CEO von OpenAI, sagt, KI werde die Gesellschaft umgestalten, erkennt Risiken an: „Ein bisschen Angst davor.“ ABC News.

Perrigo, B. (2023, 12. Januar): Demis Hassabis, CEO von DeepMind, fordert Vorsicht bei der KI-Zeit.

[3]

Bubeck, S. ua (2023), Sparks of Artificial General Intelligence: Early Experiments with GPT-4, arXiv:2303.12712.

OpenAI (2023), GPT-4 Technical Report, arXiv:2303.08774.

[4]

Es gibt zahlreiche rechtliche Präzedenzfälle – zum Beispiel verlangen die weit verbreiteten OECD-KI-Grundsätze, dass KI-Systeme „angemessen funktionieren und kein unangemessenes Sicherheitsrisiko darstellen“.

[5]

Beispiele hierfür sind das Klonen von Menschen, die Modifikation der menschlichen Keimbahn, die Funktionsgewinnforschung und die Eugenik.

Spannender als der Inhalt des Briefes ist bei diesem offenen Brief vielleicht das angehängte Unterschriftsformular selbst. Hier finden sich viele bekannte Namen, und jede Unterschrift drückt die starke Skepsis des Unterzeichners gegenüber KI aus.

Einige Internetnutzer stellten jedoch fest, dass diese Signaturen möglicherweise nicht vollständig glaubwürdig sind, da die Namen von OpenAI-CEO Sam Altman (ich habe mich versiegelt?) und des Schauspielers John Wick aus dem Film „Quick Chase“ in der Liste auftauchten studiert werden.

Die Adresse dieses gemeinsamen Briefes ist unten beigefügt, und interessierte Freunde können auch mit ihrem Namen unterschreiben.

#Willkommen, dem offiziellen öffentlichen WeChat-Konto von Aifaner zu folgen: Aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so bald wie möglich präsentiert.

Ai Faner | Ursprünglicher Link · Kommentare anzeigen · Sina Weibo

In Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency (S. 610-623).

In Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency (S. 610-623).