Meine iPhone 14 Pro Kamera ist ruiniert und es ist alles Apples Schuld

Jedes Jahr wirbt Apple für das iPhone mit einem unglaublichen Kamerasystem – und ja, die Hardware ist sicherlich beeindruckend. Das iPhone 14 Pro verfügt über die neuesten Fortschritte, die Apple in Bezug auf Kamera-Upgrades anbietet, einschließlich eines großen Sprungs zu einer 48-Megapixel-Hauptkamera mit Pixel-Binning-Technologie (vier Su-Pixel, um ein größeres Pixel zu bilden), einem Teleobjektiv mit 3x optisch Zoom, schnellerer Nachtmodus und mehr. Auch auf der Hardwareseite sieht die Kamera des iPhone 14 Pro beeindruckend aus. Und es ist!

Aber was nützt großartige Kamerahardware, wenn die Software weiterhin die Bilder ruiniert, die Sie aufnehmen? Seit der iPhone 13 -Reihe scheint es, dass alle Bilder, die von einem iPhone aufgenommen wurden, im Vergleich zu denen, die auf älteren iPhones und den konkurrierenden besten Android-Handys aufgenommen wurden, einfach schlecht aussehen, es sei denn, es wurde im ProRaw-Format aufgenommen. Das liegt daran, dass Apple jedes Mal, wenn Sie ein Foto aufnehmen, die Computerfotografie und die Nachbearbeitung weit nach oben gedreht hat. Es ruiniert meine Bilder und Apple muss eine Chill-Pille nehmen und es eine Stufe runterschrauben.

Diese "intelligenten" Funktionen sind nicht so intelligent, wie sie behaupten

Um Fotos zu machen, brauchen wir Sensoren, die helfen, Licht und Details einzufangen, um diese Bilder zu erstellen. Da Smartphones jedoch viel kompakter sind als eine vollwertige DSLR , sind die Sensoren in ihren Möglichkeiten ziemlich eingeschränkt. Aus diesem Grund verlassen sich Apple und andere Smartphone-Hersteller möglicherweise auf Software, um die Bildqualität von Bildern zu verbessern, die Sie mit einem Telefon aufnehmen.

Apple hat Smart HDR im Jahr 2018 auf dem iPhone eingeführt, und diese Softwarefunktion befindet sich jetzt in der vierten Iteration mit der iPhone 14 -Reihe. Mit Smart HDR 4 nimmt das Gerät mehrere Fotos mit unterschiedlichen Einstellungen auf und kombiniert dann die „besten“ Elemente jedes Bildes zu einem einzigen Foto. Bei diesem Prozess wird viel computergestützte Fotografie durchgeführt, und obwohl die Absicht darin besteht, die Bilder gut aussehen zu lassen, bewirkt sie tatsächlich das Gegenteil.

Sie haben dies vielleicht bemerkt, als Sie ein Foto auf Ihrem iPhone 14 (oder iPhone 13) aufgenommen und sofort auf die Miniaturansicht in der Ecke getippt haben, um die gerade aufgenommenen Bilder anzuzeigen. Das Bild sieht für eine kurze Sekunde so aus, wie Sie es aufgenommen haben, aber dann sieht es übermäßig scharf aus – mit Farben, die künstlicher erscheinen, in bestimmten Bereichen möglicherweise ausgewaschen und in anderen übermäßig gesättigt sind. Sogar der Hautton kann ein wenig anders aussehen als das, was Sie im wirklichen Leben sehen. Während ich den Nachtmodus liebte, als er zum ersten Mal auf der iPhone 11 -Serie debütierte, lässt der Nachtmodus im Vergleich zur Konkurrenz jetzt Fotos durch Überverarbeitung zu „hell“ erscheinen, und viele Nachtfotos sehen nicht einmal so aus, als wären sie aufgenommen worden Nacht.

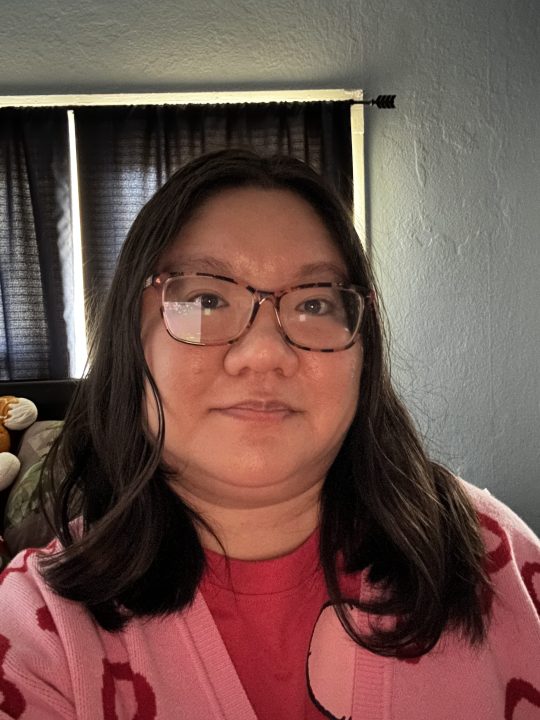

Und haben Sie jemals versucht, ein Selfie bei schlechten Lichtverhältnissen zu machen? Sicher, das iPhone hat auch einen Nachtmodus für die Frontkamera, aber ich fand es nicht sehr hilfreich. Lowlight-Selfies sehen schrecklich aus, egal was Sie tun, weil iOS dem Bild viele digitale Artefakte hinzufügt, um es zu „speichern“. Aber anstatt das Foto zu speichern, sieht es am Ende aus wie ein schlechtes und unordentliches Aquarellbild. Tatsächlich versuche ich, keine Selfies auf meinem iPhone 14 Pro zu machen, wenn ich mich in einer dunklen Umgebung befinde, weil sie fast immer schlecht aussehen.

Ich bin mir nicht sicher, wann Fotos, die mit einem iPhone aufgenommen wurden, so aussahen, aber ich habe definitiv das Gefühl, dass es ab der iPhone 13-Serie prominenter wurde. Ich könnte mich irren, aber ich erinnere mich nicht besonders, dass meine iPhone 12 Pro -Bilder so übertrieben aussahen, und besonders nicht meine iPhone 11 Pro-Fotos. Früher hat das iPhone Bilder aufgenommen, die realistisch und natürlich aussahen, aber all diese intelligente HDR- und rechnergestützte Nachbearbeitung der Fotografie ist außer Kontrolle geraten, wodurch die Bilder schlechter aussehen, als sie sein sollten.

Apple, lass uns dieses Zeug ausschalten

Vor einigen Jahren war es möglich, Smart HDR überhaupt nicht zu verwenden. Dies war eine optionale Einstellung, die Sie nach Belieben ein- oder ausschalten konnten. Diese Einstellung war nur auf den Modellen iPhone XS, iPhone XR, iPhone 11-Serie, iPhone SE 2 und iPhone 12 verfügbar. Seit dem iPhone 13 und höher wurde die Option zum Einschalten von Smart HDR entfernt.

Diese Option wegzunehmen war ein kurzsichtiger Schritt, und ich hoffe, Apple bringt sie irgendwann zurück. Obwohl mein iPhone 14 Pro mein persönliches und primäres Gerät ist, insbesondere für die Fotografie, muss ich manchmal ein Bild bearbeiten, bevor ich es für geeignet halte, es mit anderen zu teilen. Ich verstehe, was Apple mit Smart HDR zu tun versucht, aber das resultierende Bild sieht normalerweise einfach viel zu künstlich aus, verglichen mit dem, was Sie in der Realität sehen.

Wenn ich zum Beispiel draußen bei sonnigem Wetter fotografiere, kann das Foto einen übermäßig gesättigten blauen Himmel haben, wodurch es unecht aussieht. Ich denke auch, dass die Farbveränderung meinen Hautton manchmal ein bisschen falsch aussehen lässt – etwas, worüber YouTuber Marques Brownlee (MKBHD) sogar in einem kürzlich erschienenen Video spricht .

Die Android-Konkurrenz macht es besser

Auch hier hat Apple einige großartige Kamerahardware in die iPhone 14 Pro-Reihe aufgenommen, die jedoch durch die Überverarbeitung der Software beeinträchtigt wird. Da ich mir in meiner Zeit hier bei Digital Trends ein paar verschiedene Android-Geräte zugelegt habe, genieße ich es, wie einige konkurrierende Android-Telefone mit der Fotografie über das iPhone umgehen.

Das Google Pixel 7 beispielsweise macht mit der Hauptkamera tolle Fotos ohne Mehraufwand. Einfach zielen und schießen, und die Ergebnisse entsprechen genau dem, was Ihre Augen sehen – wenn nicht sogar besser. Google verwendet immer noch viel eigene Bildverarbeitung, lässt Fotos jedoch nicht so unnatürlich aussehen wie Apple. Das einzige Problem damit, soweit ich es bemerkt habe, sind Selfies. Der Hautton wird nicht ganz genau wiedergegeben, aber ansonsten ist die Hauptkamera großartig. Die Farben sind ausgewogen, nicht verwaschen, und die Software bemüht sich nicht zu sehr, es „gut aussehen“ zu lassen, weil es das bereits ist. Und mit lustigen Tools wie Magic Eraser verwende ich lieber mein Google Pixel 7 zum Bearbeiten von Aufnahmen.

Ich habe auch das ältere Samsung Galaxy S21 für einige dieser Fotovergleiche getestet, und obwohl ich nicht glaube, dass es Hautton und -farbe so gut handhabt, scheint es gut für Lowlight-Selfies zu sein, was mich überrascht. Es hat auch Bilder im Nachtmodus recht gut gehandhabt, sodass sie natürlich und realistisch erscheinen, anstatt wie beim iPhone 14 Pro mit ausgeschalteten Farben ausgeblasen zu werden.

Während Apple sagen kann, dass es die „beste“ Kamerahardware hat, ruinieren iOS und die übermäßige Abhängigkeit von Computerfotografie das Aussehen von Bildern. Sicher, einige Leute mögen diese Ästhetik, aber ich persönlich kann es nicht ertragen, wie unnatürlich viele meiner Bilder aussehen. Apple muss das Smart HDR-Zeug abschwächen oder zumindest die Option zurückbringen, es auszuschalten, wenn es uns gefällt. Denn im Moment sieht es nicht gut aus.