Musk kündigte die Gründung eines ChatGPT-Konkurrenten an! Der CEO von OpenAI hat ihn mit kaltem Wasser übergossen, GPT-5 könnte sich drastisch ändern

Wenn Sie eine Frage in ChatGPT oder New Bing eingeben, ruft die KI ihr Cloud-Gehirn an, denkt darüber nach und generiert eine vernünftigere Antwort.

Als OpenAI GPT entwickelte, wurde immer wieder erwähnt, dass die Parameter riesig werden und der Maßstab des Modells von Generation zu Generation immer komplexer wird.

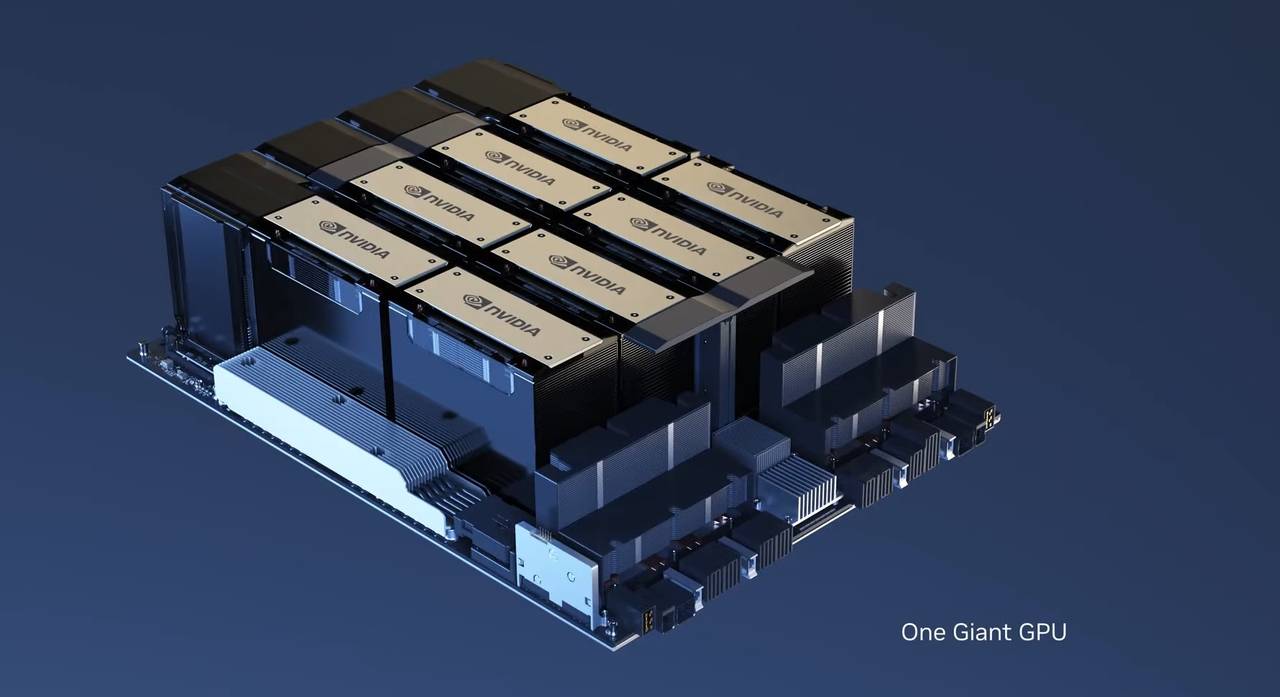

Das Training umfangreicher Sprachmodelle erfordert GPU-Cluster mit enormer Rechenleistung, und da die Anzahl der Benutzer exponentiell wächst, wird deren Ausführung auch eine beträchtliche Rechenleistung in Anspruch nehmen.

Jedes Unternehmen, das am AIGC teilnehmen möchte, überlegt zunächst, wie es ein groß angelegtes Cloud-Rechenzentrum einrichten kann, als ob die Konkurrenz des AIGC zu einem Kampf um Hardwareressourcen geworden wäre.

▲ OpenAI CEO Sam Altman Bild von: wired

Mit einem Rechenzentrum mit stärkerer Rechenleistung wird es in der Lage sein, Sprachmodelle und Algorithmen in größerem Maßstab auszuführen, und das endgültige KI-Produkt kann auch „intelligenter“ werden.

In einer kürzlich gehaltenen Rede von OpenAI-CEO Sam Altman am Massachusetts Institute of Technology goss er jedoch kaltes Wasser auf jene Nachzügler, die „Wunder mit großer Kraft vollbringen“ wollten.

Altman: Modellskalierung ist veraltet

„Die Ära der Großmodelle ist zu Ende. Wir müssen mit neuen Ideen und Methoden neue Fortschritte in der AIGC erzielen.“

Die Erweiterung der Größe des Modells, die Verwendung komplexerer Parameter und die Forderung nach mehr Rechenleistung sind im Wesentlichen die iterativen Methoden, die OpenAI in den letzten Jahren auf GPT angewendet hat.

GPT-2 hat ungefähr 1,5 Milliarden Parameter, während GPT-3 175 Milliarden Parameter hat.Obwohl GPT-4 keine offizielle digitale Verifizierung hat, haben viele Institutionen spekuliert, dass es Billionen von Textwörtern und Zehntausende von Einheiten verwendet.Cloud Computing Server , die Ausbildungskosten haben 100 Millionen Dollar überschritten.

Als der Einfluss von ChatGPT zunahm, nutzte Microsoft auch die zugrunde liegende Technologie, um ein neues Bing zu starten.

Anschließend brachte Google Bard und Adobe Firefly auf den Markt.Neben diesen großen Unternehmen investieren auch viele gut finanzierte Start-ups im Silicon Valley wie Anthropic, AI21, Cohere und Character.AI fieberhaft, um größere Unternehmen aufzubauen Algorithmen, um mit ChatGPT und OpenAI Schritt zu halten.

▲ Der Runway der zweiten Generation ist ein Blockbuster, der in einem Satz generiert wird

Die enorme Nachfrage nach Hardware-Ressourcen hat auch zu einem Ansturm auf den Kauf von NVIDIA A100- und H100-GPUs geführt.

Bei eBay hat sich Nvidias H100 zu einer heißen Ware entwickelt, der Preis wurde auf 40.000 US-Dollar hochgeschossen, während sein offizieller Verkaufspreis nur 33.000 US-Dollar beträgt. Darüber hinaus wird H100 im Allgemeinen mit 8 Blättern verpackt, um einen Server zum Verkauf zu bilden.

Derzeit gibt es keine andere GPU von Drittanbietern, die mit Nvidia konkurriert.Wer mehr Nvidia-GPUs hat, scheint unter der KI-Welle den Schlüssel zum Sieg in der AIGC-Industrie zu haben.

Ähnlich wie das Kapitalmonopol und das Monopol großer Unternehmen in traditionellen Industrien hat das Streben nach Rechenleistung auch das „Rechenleistungsmonopol“ hervorgebracht.

Und Sam Altman sagte auch, dass OpenAI keine Pläne habe, GPT-5 zu entwickeln. Die Implikation ist, dass die hirnlose Erweiterung der Modellskala GPT nicht erlauben wird, unendliche Iterationen aufrechtzuerhalten.

Derzeit sind sowohl ChatGPT als auch das neue Bing von Microsoft aufgrund unzureichender Rechenleistung mit vielen Ausfallzeiten und instabilen Diensten konfrontiert.

Gleichzeitig steht das neue Bing nicht allen Nutzern offen, und die Situation des „Anstehens“ besteht weiterhin.

Und das ist einer der Gründe, warum Google eine ähnliche generative KI nicht vollständig in seine Suche integrieren konnte.

Nick Frosst, der bei Google an KI arbeitete und jetzt der Gründer von Cohere ist, sagte auch, Altman sei vorausschauend und sagte auch, dass neue Modelldesigns oder -architekturen für künstliche Intelligenz basierend auf menschlichem Feedback angepasst werden könnten.

Nach dieser Vorstellung könnte OpenAI GPT-5 bereits mit neuen Ideen konzipieren.

Musk: Leute abwerben, Grafikkarten kaufen und ein Team bilden

Auch wenn Sam Altman öffentlich erklärt hat, dass er in dieser Phase den alten Weg von OpenAI weitergehen und sich durch die Erweiterung der Modellgröße verbessern wird, wird es schwierig sein, zu ChatGPT aufzuschließen.

Aber Musk, der ein alter Freund von Altman war, widmete sich entschlossen der AIGC-Industrie.

Laut dem Wall Street Journal hat Musk klammheimlich eine Firma namens X.AI Crop registriert, mehrere Forscher von Google abgeworben und tausende Grafikkarten von Nvidia gekauft.

Musks Ziel ist ganz klar, mit OpenAI und Google zu konkurrieren.

Kurz nachdem die entsprechenden Berichte veröffentlicht wurden, gab Musk in einem Interview mit Fox News zu, dass er ein ChatGPT-ähnliches Produkt namens TruthGPT auf den Markt bringen wollte.

Musks Absichten sind klar, TruthGPT wird „die wahrheitssuchende KI maximieren“ und versuchen, die Natur des Universums zu verstehen, was hoffentlich mehr Gutes als Schlechtes bringt.

Musks Interview und Antwort sind eigentlich ein bisschen unsinnig, schließlich ist X.AI Crop nach dem Maßstab des aktuellen großen Sprachmodells vielleicht nicht so gut wie manche Start-up-Teams im Silicon Valley.

Und der Name TruthGPT scheint gegen ChatGPT zu protestieren.

Musk war immer der Meinung, dass generative KI wie GPT-4 erhebliche Risiken bergen wird, forderte ein sechsmonatiges Entwicklungsmoratorium und forderte die Einführung entsprechender Vorschriften.

Es hieß sogar, dass „ta das Potenzial hat, die Zivilisation zu zerstören“.

Es ist nur so, dass ich, während ich über die Einstellung der Forschung sprach, X.AI Crop gründete und begann, AIGC zu betreten. Es ist schwer nicht zu glauben, dass dies ein Hype ist.

Darüber hinaus ist das Aussetzen von sechs Monaten Forschung und Entwicklung eher so, als würde man OpenAI besiegeln und sich sechs Monate Zeit geben, um mit den Fortschritten Schritt zu halten.

Es ist unbestreitbar, dass sowohl SpaceX als auch Tesla von Musk eine Branche untergraben haben und zu den derzeit bekanntesten Unternehmen geworden sind.

▲ Moschus und Raumschiff

Aber als er OpenAI verließ, die aktuellen Errungenschaften sah und einige kontroverse Bemerkungen machte, zeigte sich Musks Widerwille, die Gelegenheit schon vor langer Zeit zu verpassen.

Ob TruthGPT das tun kann, was er sagte, können wir nur sechs Monate abwarten.

Jensen Huang: Wir brauchen eine App

Generative KI existiert derzeit nur in Dialogfeldern und erscheint in ganz klassischer Form in allen Smart Devices.

Egal, ob es sich um ein Plug-in oder eine Drittanbieter-App handelt, die Öffentlichkeit interagiert letztendlich mit einem Dialogfeld.

![]()

Dies war auch die grundlegendste Art der Mensch-Computer-Interaktion, als Computer zum ersten Mal auftauchten.

In einem Podcast von Nicolai Tangen sprach er mit Nvidia-CEO Huang Renxun darüber, wie KI die Art und Weise verändern wird, wie Menschen leben und arbeiten.

Die aktuelle rasante Entwicklung der KI ist untrennbar mit der Hilfe von Nvidias GPU verbunden, und Nvidia hat den Cloud-Computing-Power-Markt fast monopolisiert.

Wie aus Sicht von Altman kann die aktuelle KI die ultrahohe Rechenleistung immer noch nicht loswerden, und das supergroße Modell wird bereits von riesigen Algorithmen unterstützt.

Es ist eine Herausforderung für Startups, aber es gilt auch für Nvidia.

Nvidia muss kontinuierlich leistungsfähigere GPUs entwickeln und herstellen, um sich an die Entwicklung der KI anzupassen. Und derzeit existiert KI noch in riesigen Rechenzentren und benötigt mehrere Supercomputer, um Rechenleistung bereitzustellen.

Es ist nicht wie jede frühere Anwendung oder Software. GPT-3 hat 175 Milliarden Parameter, angesichts einer solchen Berechnung wurde Nvidias KI-GPU von Grund auf neu gestaltet.

Aber derzeit dauert es noch Wochen, um große Datenmengen zu verarbeiten und große Modelle zu lernen. Es kann noch nicht zu einer App oder einem persönlichen PC verdichtet werden.

Tatsächlich erklärt dies auch die bisherige Förderung von KI zu Software, die eigentlich in Form von Cloud und Plug-Ins existiert.

Nvidia erklärte auch, dass KI begonnen habe, in das Design der eigenen Chips einzudringen: „Wenn der Chiparchitekt schläft, iteriert und optimiert und verbessert die KI immer noch die entsprechende Architektur.“

"Es kann uns helfen, Chips besser zu entwerfen und herzustellen."

Mit anderen Worten, KI greift in die Produktion von Chips ein, und die produzierten Chips werden in Cloud-Computing-Leistungen verwendet, um KI zu betreiben – das ist KI-Selbstversorgung.

Darüber hinaus glaubt Huang Renxun, dass die KI auch die nächste industrielle Revolution auslösen wird und vorerst nicht selbst erwachen wird, um den Menschen zu ersetzen.

Im Gegenteil, es wird Arbeitskräfte erheblich freisetzen und die Produktivität aller steigern. Menschen können natürliche Sprache verwenden, um direkt zu programmieren, ohne komplizierte Python-, Java- und C-Sprachen lernen zu müssen.

Außerdem nahm er sich Nvidias Software-Ingenieure zum Vorbild: Mit Hilfe von KI werden etwa 40-50 % des Codes und der Software durch generative KI ergänzt, und Ingenieure müssen nur noch Vorschläge und Ideen liefern.

Huang Renxun schätzte auch, dass die Hinzufügung von KI die Produktivität der aktuellen Nvidia-Softwareingenieure um das Zehnfache steigern wird.

▲ Copilot-Funktion von Github

Das Eingreifen der KI kann es Menschen ermöglichen, viele mühsame Aufgaben mit einer Geschwindigkeit von 10.000 Mal zu erledigen, was indirekt die Produktivität verbessert.

Vor dem Aufkommen von GPT-4 konnte sich die KI-Industrie einfach darauf verlassen, die Modellgröße zu erweitern und den Hardwareeinsatz zu erhöhen, um Iterationen mit hoher Geschwindigkeit aufrechtzuerhalten.

Mit dem Aufkommen von Rechenleistungsengpässen musste OpenAI überdenken, wie man KI optimieren und die nächste Entwicklungsrichtung finden kann.

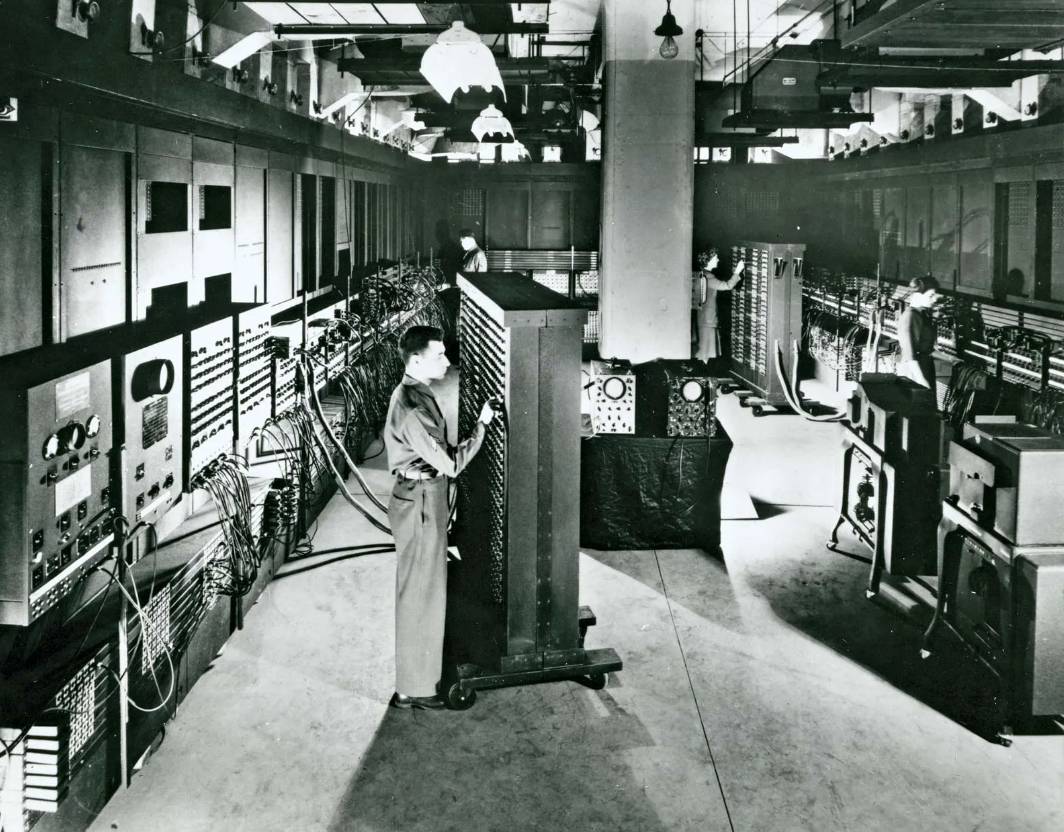

In ähnlicher Weise erkannte Huang Renxun auch deutlich, dass der aktuelle KI-Bedarf an Rechenleistung zu groß ist und an einem Ort mit riesigem Platz und vielen Chips existieren muss.Die aktuelle KI scheint wie der ENIAC-Computer der ersten Generation der Welt zu sein.

Der nächste Schritt der KI muss bei gleichzeitiger Verringerung des Ressourcenbedarfs auch abgespeckt werden und kann unabhängig in einer App oder Software existieren.

Aus heutiger Sicht ist das nicht realistisch, aber die gute Nachricht ist, dass OpenAI damit begonnen hat, Android- und iOS-Ingenieure zu rekrutieren, und die entsprechende App sollte bald kommen.

#Willkommen beim offiziellen öffentlichen WeChat-Konto von Aifaner: Aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so bald wie möglich präsentiert.

Ai Faner | Ursprünglicher Link · Kommentare anzeigen · Sina Weibo