NPUs sind offiziell nutzlos – vorerst

Es tut mir leid, das sagen zu müssen, aber ich würde lügen, wenn ich etwas anderes sagen würde. NPUs sind nutzlos. Das kommt vielleicht hart rüber, aber es entspringt nicht dem Zynismus. Nachdem ich sie selbst getestet habe, bin ich wirklich davon überzeugt, dass es derzeit keinen überzeugenden Einsatz für NPUs gibt.

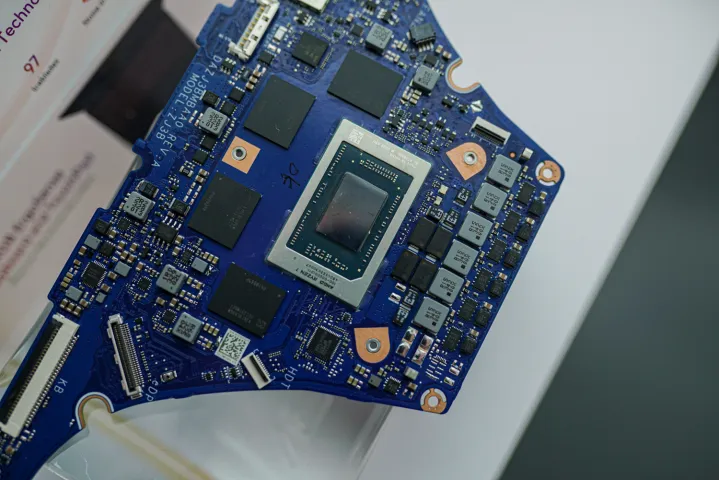

Wenn Sie Ihren nächsten Laptop kaufen, besteht eine gute Chance, dass er über eine Neural Processing Unit (NPU) verfügt, und AMD und Intel haben großen Aufruhr darüber gemacht, wie diese NPUs die Zukunft des KI-PCs vorantreiben werden. Ich bezweifle nicht, dass wir dieses Ziel irgendwann erreichen werden, aber im Hinblick auf einen modernen Anwendungsfall ist eine NPU wirklich nicht so effektiv, wie Sie vielleicht denken.

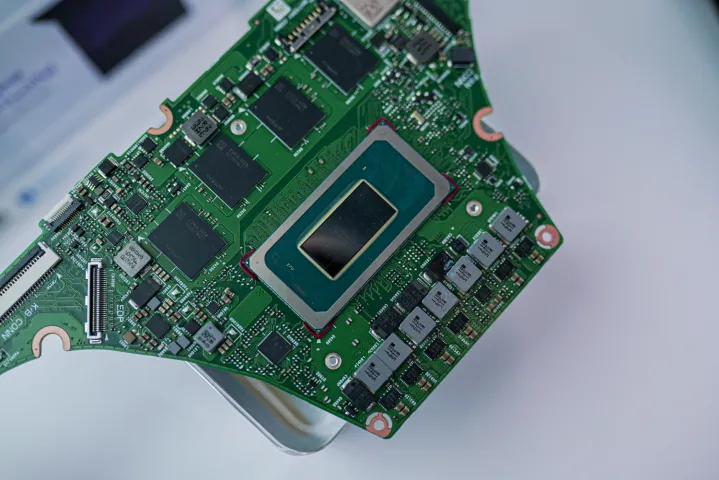

Als Intel auf der CES 2024 über Meteor Lake sprach, erklärte Intel, dass es die verschiedenen Prozessoren auf Meteor-Lake-Chips für KI-Arbeiten nutzt. Es fällt nicht alles der NPU zu. Tatsächlich werden die anspruchsvollsten KI-Arbeitslasten auf die integrierte Arc-GPU verlagert. Die NPU dient hauptsächlich als stromsparende Option für stetige KI-Arbeitslasten mit geringer Intensität wie Hintergrundunschärfe .

Für alles, was intensiver ist, springt Ihre GPU ein. Intel zeigte beispielsweise eine Demo in Audacity, bei der KI die Audiospuren aus einer einzelnen Stereodatei trennen und sogar die Liedtexte transkribieren konnte. Es zeigte auch die Arbeit der KI mit Metahuman von der Unreal Engine, die eine Videoaufzeichnung in eine Animation einer realistischen Spielfigur verwandelte. Beide liefen auf der GPU.

Dies sind einige großartige Anwendungsfälle für KI. Sie brauchen die NPU einfach nicht. Der dedizierte KI-Prozessor ist bei diesen stoßartigen KI-Arbeitslasten bei weitem nicht so leistungsstark wie die GPU.

Laut Intel besteht der Hauptanwendungsfall darin, dass die NPU effizient ist, sodass sie die Akkulaufzeit verlängern sollte, wenn Sie stetige KI-Arbeitslasten mit geringer Intensität wie Hintergrundunschärfe auf ihr statt auf der GPU ausführen. Ich habe das auf einem MSI Studio 16 getestet, auf dem eine der neuen Meteor-Lake-CPUs von Intel läuft, und die Energieeinsparung ist nicht so groß, wie man erwarten würde.

Über 30 Minuten hatte die GPU eine durchschnittliche Leistungsaufnahme von 18,9 W, während die NPU durchschnittlich 17,6 W verbrauchte. Interessant ist, dass die GPU anfangs einen Spitzenwert erreichte und etwa 38 W Gesamtleistung für das System auf einem Chip erreichte, sich aber langsam wieder verringerte. Der NPU hingegen begann niedrig und stieg im Laufe der Zeit langsam an, um sich schließlich zwischen 16 W und 17 W einzupendeln.

Ich muss darauf hinweisen, dass es sich hierbei um die Gesamtleistung des Pakets handelt – mit anderen Worten, um die Leistung des gesamten Chips, nicht nur der GPU oder NPU. Die NPU ist effizienter, aber ich weiß nicht, wie wichtig diese Effizienz bei diesen KI-Arbeitslasten mit geringer Intensität ist. Im realen Einsatz wird es Ihnen wahrscheinlich nicht viel Akkulaufzeit sparen.

Ich muss warten, um die Akkulaufzeit zu testen, sobald ich mehr Zeit mit einem dieser Meteor-Lake- Laptops habe, aber ich glaube nicht, dass es einen großen Unterschied machen wird. Selbst die besten Windows-Laptops haben im Vergleich zur Konkurrenz von Apple eine recht mittelmäßige Akkulaufzeit, und ich bezweifle, dass eine NPU ausreicht, um diese Dynamik zu ändern.

Das sollte nicht von den aufregenden KI-Apps ablenken, die wir auf PCs sehen. Von Audacity über die Adobe-Suite bis hin zu Stable Diffusion in GIMP gibt es jetzt unzählige Möglichkeiten, KI zu nutzen. Die meisten dieser Anwendungen werden jedoch entweder in der Cloud oder von Ihrer GPU verwaltet, und die dedizierte NPU leistet außer der Hintergrundunschärfe nicht viel.

Da NPUs immer leistungsfähiger und diese KI-Apps effizienter werden, habe ich keinen Zweifel daran, dass NPUs ihren Platz finden werden. Und es macht Sinn, dass AMD und Intel den Grundstein dafür legen, dass dies in der Zukunft geschehen kann. Derzeit liegt der Schwerpunkt der KI-Leistung jedoch größtenteils auf Ihrer GPU und nicht auf dem effizienten KI-Prozessor, der Ihre Videoanrufe verarbeitet.