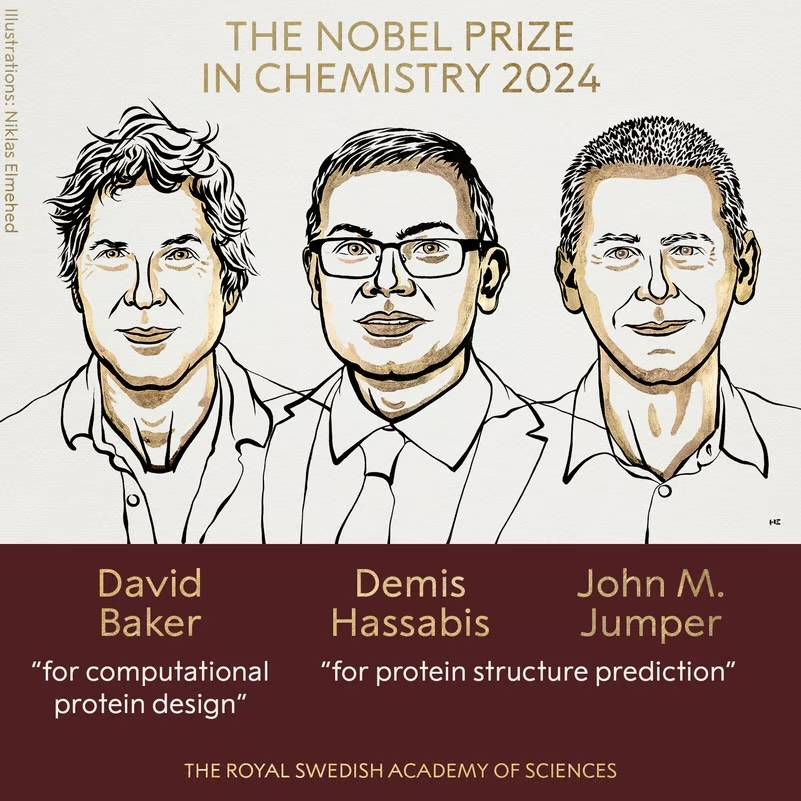

Nur! Der CEO von Deepmind gewinnt den Nobelpreis für Chemie 2024. Als er über KI sprach, sagte er: „Es wird überbewertet, aber sie wird immer noch unterbewertet.“

Der diesjährige Nobelpreis geht an KI.

Der gerade verliehene Nobelpreis für Chemie wurde gemeinsam von David Baker, John M. Jumper und Demis Hassabis gewonnen. Der Nachname dürfte jedem bekannt sein, es handelt sich um den Gründer von Deepmind.

Vor nicht allzu langer Zeit war Demis Hassabis zu Gast auf dem Podcast-Kanal von DeepMind. Im Gespräch mit Hannah Fry (der neuen Direktorin des Instituts für Angewandte Mathematik der British Mathematical Society) erläuterte er nicht nur die Forschung des Teams zur Proteinstruktur, sondern ging auch darauf ein Erfahren Sie mehr über die Arbeit von DeepMind, Gemini und die Zukunft von AGI und, was noch wichtiger ist, wie Sie ausgeglichener werden, wenn die Technologie immer leistungsfähiger wird.

Im Folgenden finden Sie einen Auszug aus dem Gespräch, der inhaltlich bearbeitet wurde.

Hannah Fry: Willkommen bei Google DeepMind, meine Gastgeberin ist Professorin Hannah Fry. Als wir 2017 zum ersten Mal über die Produktion dieses Podcasts nachdachten, war DeepMind ein relativ kleines, auf KI fokussiertes Forschungslabor. Als sie zum ersten Mal von Google übernommen wurden, arbeiteten sie etwas entfernt in London an ihrem eigenen Projekt. Im letzten Quartal hat Google seine gesamte Struktur neu konfiguriert, um sein KI-Team in den Mittelpunkt seiner Strategie zu stellen.

Demis Hassabis: Nein, absolut nicht (lacht).

Hannah Fry: Vielen Dank für Ihr Kommen. Ich frage mich: Ist Ihre Arbeit jetzt, da das öffentliche Interesse an KI explodiert, einfacher oder schwieriger?

Demis Hassabis: Ich denke, es ist ein zweischneidiges Schwert, richtig. Es ist definitiv schwieriger, weil es auf dem gesamten Gebiet so viel Kontrolle, Aufmerksamkeit und ziemlich viel Lärm gibt. Tatsächlich bevorzuge ich es, wenn weniger Leute da sind und ich mich mehr auf die Wissenschaft konzentrieren kann. Aber es ist jetzt auch gut, weil es zeigt, dass die Technologie bereit ist, die Welt auf vielfältige Weise zu beeinflussen und das tägliche Leben der Menschen positiv zu beeinflussen. Ich finde das auch spannend.

Hannah Fry: Sind Sie überrascht, wie schnell KI die Aufmerksamkeit der Öffentlichkeit auf sich gezogen hat? Obwohl ich vermute, dass Sie das auch erwartet haben.

Demis Hassabis: Ja, genau, irgendwann (bereits erwartet). Wir alle arbeiten seit Jahren, sogar Jahrzehnten daran. Ich denke also, dass irgendwann jeder die Bedeutung der KI erkennen wird. Aber es ist immer noch ziemlich surreal zu sehen, wie alles tatsächlich zum Tragen kommt. Ich schätze, das ist das Aufkommen von Chatbots und Sprachmodellen, schließlich benutzt jeder Sprache und jeder kann Sprache verstehen. Dies ist also eine einfache Möglichkeit für die Öffentlichkeit, den Stand der KI zu verstehen und möglicherweise zu beurteilen.

Hannah Fry: Ich habe gehört, dass Sie diese Chatbots als „unangemessen nützlich“ beschrieben haben, und das gefällt mir wirklich. Wir werden gleich über die Transformatortechnologie sprechen, und ich denke, es war dieser große Durchbruch, der uns diese Werkzeuge bescherte. Aber jetzt möchte ich zuerst fragen: Was meinst du mit „unangemessen nützlich“?

Demis Hassabis: Ich meine, ich denke, wenn jemand fünf, zehn Jahre zurückblickt und sagt, wir werden etwas tun, dann wird es so aussehen, als würden wir eine erstaunliche Architektur bauen und dann von dort aus skalieren, anstatt von dort aus zu bauen Irgendein Konzept oder eine Abstraktion – das ist eine Debatte, die wir vor 5, 10 Jahren geführt hätten. Brauchen wir eine bestimmte Art der Abstraktion? Denn genau das scheint das Gehirn zu tun.

Aber wenn man Systemen, sagen wir dem gesamten Internet, genügend Daten zur Verfügung stellt, scheinen sie irgendwie daraus zu lernen und zu verallgemeinern, nicht nur auswendig, sondern bis zu einem gewissen Grad wirklich zu verstehen, womit sie es zu tun haben. Und es funktioniert auf eine Art und Weise, die wahrnehmungsmäßig und irgendwie irrational ist. Ich glaube nicht, dass sich vor fünf Jahren irgendjemand vorgestellt hätte, dass es funktioniert.

Hannah Fry: Ja, Dinge wie konzeptionelles Verständnis und Abstraktion passieren einfach auf natürliche Weise und nicht (entworfen).

Demis Hassabis: Ja, wir haben zuvor über Dinge wie Konzepte und Erdung gesprochen, die Verankerung der Sprache in realen Erfahrungen, vielleicht in einer simulierten Umgebung, vielleicht in einem verkörperten intelligenten Roboter, was wirklich wichtig ist, um die Welt um uns herum wirklich zu verstehen. Die Welt ist notwendig. Natürlich sind diese Systeme noch nicht implementiert. Sie machten viele Fehler und hatten kein wirkliches Modell der Welt, kein gutes Modell der Welt. Aber sie haben allein durch das Erlernen der Sprache mehr gelernt, als die Menschen erwartet hatten.

Hannah Fry: Möglicherweise müssen wir Zuschauern, die es nicht wissen, noch erklären, was Erdung ist. Denn das ist ein sehr wichtiges Konzept.

Demis Hassabis: Das ist natürlich der Grund, warum das klassische Al-Forschungssystem in den 1980er und 1990er Jahren an Orten wie dem MIT etabliert wurde. Sie können sie sich als riesige Datenbanken vorstellen, die mit anderen Wörtern verbunden sind. Das Problem besteht darin, dass man zwar sagen kann, dass „ein Hund hat Beine“ in der Datenbank existiert, aber wenn man ihm ein Bild eines Hundes zeigt, weiß er nicht, dass die Pixelsammlung auf diesen Satz verweist. Dies ist das Problem, dem sich Erdungsarbeiten stellen müssen. Sie haben diese abstrakte Darstellung von Symbolen, aber was bedeutet das in der realen Welt – der chaotischen realen Welt – wirklich? Wir versuchen es herauszufinden, aber es gelingt nie ganz.

Bei heutigen Systemen, die direkt aus den Daten lernen, ist dies natürlich nicht der Fall. In gewisser Weise stellten sie diese Verbindung also von Anfang an her. Aber das Interessante ist, dass Ihnen, wenn Sie nur aus der Sprache lernen, theoretisch ein Großteil der Grundlagen fehlen sollte, die Sie brauchen. Es stellt sich heraus, dass vieles davon abgeleitet werden kann.

Hannah Fry: Warum theoretisch?

Demis Hassabis: Woher kommt diese Erdung? Diese Systeme, zumindest die ersten großen Sprachmodelle, existierten in der realen Welt vorher nicht wirklich. Sie sind nicht mit dem Emulator verbunden, sie sind nicht mit dem Bot verbunden, sie haben nicht einmal Zugang zum Internet. Sie sind auch nicht von vornherein multimodal, sie haben keine visuellen Fähigkeiten oder ähnliches, sie leben lediglich im Sprachraum, einem abstrakten Bereich, daher ist es ziemlich überraschend, dass sie daraus etwas über die reale Welt ableiten können.

Hannah Fry: Wenn Menschen sich engagieren, mit dem System interagieren und klar sagen: „Das ist eine Quatsch-Antwort“, „Das ist eine gute Antwort“, kann das zu einer Wahrnehmung führen.

Demis Hassabis: Genau. Wenn sie also schief gehen, liegt das sicherlich zum Teil an der fehlenden Begründung in den frühen Versionen. Wenn Sie beispielsweise einen Hund fragen, wie er bellen soll, und er falsch antwortet, korrigieren Sie die Antwort, indem Sie ihm Feedback geben. Ein Teil des Feedbacks stammt aus unserem eigenen Wissen, das langsam in das Modell eindringt.

Hannah Fry: Ich erinnere mich, dass ich ein wirklich gutes Beispiel dafür gesehen habe, nämlich „Überqueren des Ärmelkanals“ im Gegensatz zu „Überqueren des Ärmelkanals“.

Demis Hassabis: Ja, es ist so etwas. Wenn es falsch antwortet, gibst du ihm Rückmeldung, dass es falsch ist, und dann muss es es herausfinden, du kannst den Kanal nicht zu Fuß überqueren.

Hannah Fry: Ich möchte irgendwie fragen: Glauben Sie, dass in der Phase, in der wir uns gerade befinden, die Dinge über- oder unterbewertet sind? Oder wird es in die falsche Richtung gehypt?

Demis Hassabis: Ich denke, es ist eher Letzteres. Ich würde sagen, dass es kurzfristig überbewertet war. Es wird behauptet, dass man alles Mögliche tun kann, was nicht möglich ist; es gibt jede Menge Startups und Risikokapitalgeber, die ihnen nachjagen, aber sie sind noch nicht so weit. Andererseits denke ich, dass es immer noch unterbewertet ist, und ich habe immer noch nicht das Gefühl, dass die Leute vollständig verstehen, was passieren wird, wenn wir zu AGI und Post-AGI kommen. Das wäre eine so große Sache, also verstehen Sie auch diese Verantwortung. Beides ist also etwas übertrieben und ich denke, wir durchlaufen einen solchen Zyklus.

Hannah Fry: Im Vergleich zu all diesen potenziellen Start-ups und Risikokapitalgebern leben Sie (das Team) seit Jahrzehnten in der KI-Forschung und sind in einer guten Position, um zu erkennen, welche davon realistische Ziele sind und welche nicht. Aber wie unterscheiden andere zwischen dem, was real ist, und dem, was nicht?

Demis Hassabis: Ich denke, man muss natürlich auf technischer Ebene sorgfältig vorgehen und ein gewisses Verständnis für die Technologie und die neuesten Trends haben. Ich denke, es hängt auch von der Person ab, die spricht, von ihrem Hintergrund und davon, wie technisch sie ist. Haben sie erst letztes Jahr begonnen, sich mit KI zu beschäftigen? Vor letztem Jahr haben sie sich mit Kryptowährungen beschäftigt? Das könnten einige Hinweise sein.

Wenn ein Ort plötzlich Aufmerksamkeit erregt und Geld damit einhergeht, haben alle Angst, etwas zu verpassen. Das schafft ein opportunistisches Umfeld, das im Gegensatz zu denen von uns steht, die seit Jahrzehnten zutiefst technisch und zutiefst wissenschaftlich arbeiten.

Hannah Fry: Ja, eines unserer großen Themen sind Zwillinge, und es basiert auf diesem sehr tiefgreifenden wissenschaftlichen Ansatz. Inwiefern unterscheidet sich Gemini von anderen großen Sprachmodellen, die von anderen Labors veröffentlicht wurden?

Demis Hassabis: Von Anfang an wollten wir, dass Gemini multimodal ist. Es kann nicht nur Sprache, sondern auch Audio, Video, Bilder, Code und alles verarbeiten. Der Grund, warum wir dies tun wollen, ist zunächst einmal, dass wir glauben, dass diese Systeme auf diese Weise die Welt um sie herum wirklich verstehen und bessere Modelle der Welt erstellen können. Das geht also tatsächlich auf das Thema zurück, über das wir gerade gesprochen haben. Wir bauen immer noch die Grundlage, aber dieses Mal geht es um die Sprache.

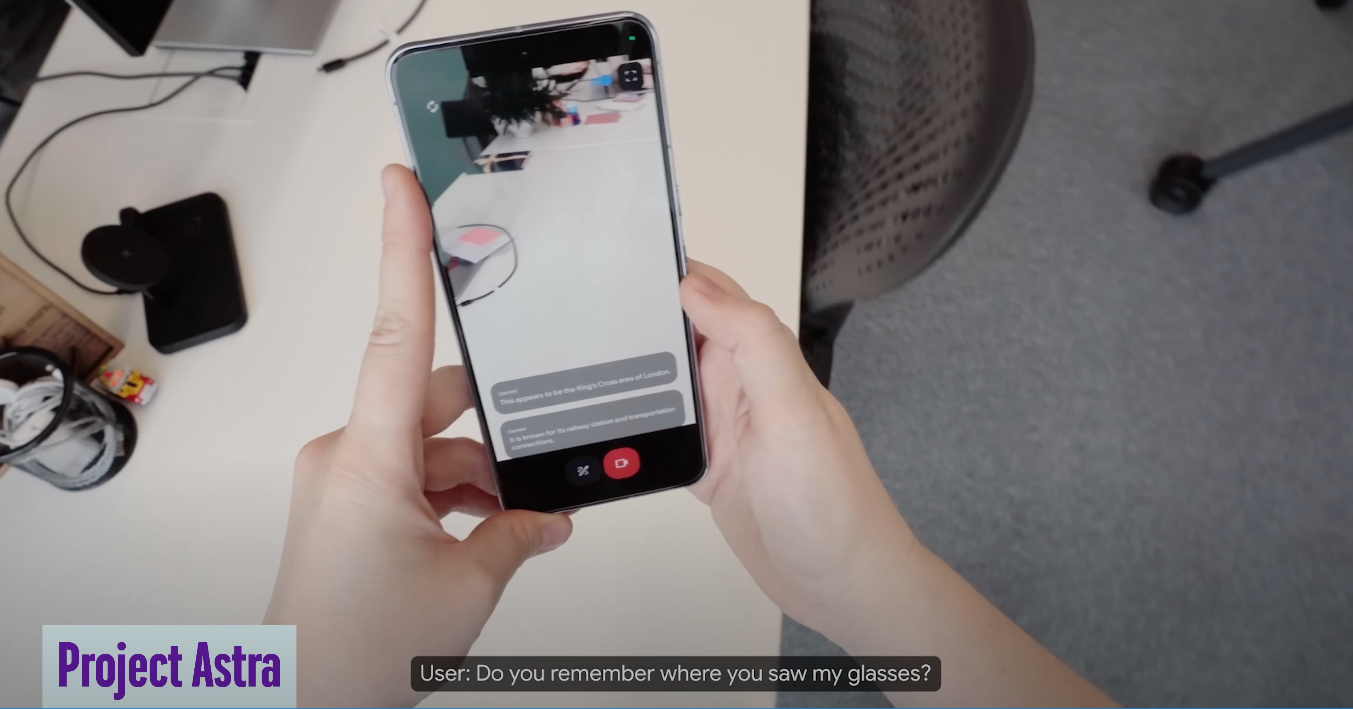

Und dann hatten wir auch die Vision eines universellen Assistenten und entwickelten einen Prototypen namens Astra, über den wir meiner Meinung nach noch sprechen werden und der nicht nur versteht, was Sie eingeben, sondern auch die Umgebung, in der Sie sich befinden.

Wenn Sie sich einen persönlichen Assistenten oder digitalen Assistenten vorstellen, ist die Hilfe, die er leisten kann, umso nützlicher, je mehr Kontext er versteht. Wir dachten immer, dass ein solches System nützlicher wäre. Deshalb haben wir von Anfang an Multimodalität eingebaut. Das ist ein Aspekt davon – dass es von Natur aus multimodal ist. Und es war damals das einzige Modell, das das konnte. Jetzt versuchen andere Modelle aufzuholen

Und dann haben wir auch einige große Neuerungen im Speicher, wie zum Beispiel den langen Kontext, der sich jetzt eine Million oder zwei Millionen Token merken kann, und man kann sie sich ungefähr so vorstellen, als würde man sich eine Million oder zweihunderttausend Wörter merken. Sie können ihm ein Werk wie „Krieg und Frieden“ geben oder aufgrund der Multimodalität jetzt sogar ein ganzes Video, einen ganzen Film oder einen Vortrag geben und Fragen beantworten lassen oder im Videostream den benötigten Inhalt finden.

Hannah Fry: Ich erinnere mich, dass Sie ein Beispiel von Astra gegeben haben, das Ihnen hilft, sich daran zu erinnern, wo Sie Ihre Brille abgelegt haben. Aber ich bin neugierig auf die Entwicklung dieser Technologien. Handelt es sich nur um eine Weiterentwicklung dieser alten Google-Brille?

Demis Hassabis: Natürlich hat Google eine lange Geschichte in der Entwicklung glasähnlicher Geräte, die eigentlich bis etwa 2012 zurückreicht. Sie sind also in diesem Bereich weit vorne, aber was wahrscheinlich fehlt, ist diese Art von Technologie, die Astra repräsentiert. Mit dieser Technologie können Sie einen intelligenten Agenten oder intelligenten Assistenten wirklich verstehen, der versteht, was er sieht. Wir sind begeistert von digitalen Assistenten, die Sie begleiten und die Welt um Sie herum verstehen können. Wenn Sie es verwenden, fühlt es sich wie eine sehr natürliche Verwendung an.

Hannah Fry: Okay, ich möchte ein wenig auf die Ursprünge von Gemini zurückkommen. Es kam aus zwei verschiedenen Abteilungen, richtig.

Demis Hassabis: Ja, wir haben letztes Jahr tatsächlich die beiden Forschungsabteilungen von Alphabet zusammengelegt. Mit anderen Worten: Wir vereinen das ursprüngliche DeepMind und Google Brain zu einer Superabteilung, vereinen alle Top-Talente in unserem Unternehmen und bei Google und vereinen das beste Wissen in der gesamten Forschung, insbesondere im Bereich der Sprachmodelle. Wir haben Projekte wie Chinchilla und Gopher, die frühe Sprachmodelle wie Palm und Lambda erstellt haben, von denen jedes seine eigenen Stärken und Schwächen hat. Wir haben sie alle zusammengebracht, um Gemini zu gründen, das erste Leuchtturmprojekt, das vom gemeinsamen Team gestartet wurde. Ein weiterer wichtiger Punkt ist, dass wir auch alle Computerressourcen zusammenbringen, um wirklich umfangreiche Schulungen durchzuführen und die Computerressourcen zu zentralisieren. Also ich finde das wirklich cool.

Hannah Fry: Ich denke, der Fokus von Google Brain und DeepMind unterscheidet sich in vielerlei Hinsicht, stimmt das?

Demis Hassabis: In der Tat. Ich denke, beide konzentrieren sich auf den neuesten Stand der KI, und obwohl es auf der Ebene der einzelnen Forscher bereits viel Zusammenarbeit gibt, ist dies auf strategischer Ebene möglicherweise nicht so sehr der Fall. Jetzt, nach der Fusion, bezeichne ich Google DeepMind als den „Maschinenraum“ von Google. Tatsächlich haben wir in unserer Arbeitsweise mehr Gemeinsamkeiten als Unterschiede. Wir behalten unsere Stärken in der Grundlagenforschung bei und bauen sie weiter aus. Woher kommt beispielsweise die Transformer-Architektur der nächsten Generation? Wir wollen es erfinden. Offensichtlich hat Google Brain die Architektur der vorherigen Generation erfunden, und wir haben sie mit dem von uns entwickelten Deep Reinforcement Learning kombiniert. Ich glaube immer noch, dass es in Zukunft noch mehr Innovationen braucht, und ich glaube, dass wir das schaffen können, wie wir es in den letzten zehn Jahren getan haben, was aufregend ist.

Hannah Fry: Zurück zum Gemini selbst: Wie gut ist es im Vergleich zu anderen Modellen?

Demis Hassabis: Ich denke, es gibt einige Benchmarks [die Aufschluss über seine Fähigkeiten geben], aber das ist nicht das Problem, das Problem ist, dass der gesamte Bereich bessere Benchmarks braucht. Es gibt einige bekannte akademische Benchmarks, aber diese sind mittlerweile etwas gesättigt und können die subtilen Unterschiede zwischen verschiedenen Topmodellen nicht wirklich unterscheiden. Ich würde sagen, dass derzeit drei Modelle im Vordergrund stehen: unser Gemini, GPT von OpenAI und Claude von Anthropic. Natürlich gibt es auch andere gute Modelle, etwa die von Meta und Mistral und anderen Unternehmen, die in unterschiedlichen Bereichen ihre eigenen Stärken haben. Abhängig von Ihren Anforderungen ist Claude möglicherweise stärker für die Kodierung, GPT möglicherweise besser für die Argumentation und in Bezug auf Speicherverarbeitung, langen Kontext und multimodales Verständnis ist es Gemini. Natürlich verbessern wir alle unsere Modelle ständig. Wenn man bedenkt, dass Gemini erst ein Jahr alt ist, denke ich, dass wir auf einem sehr guten Weg sind. Wenn wir das nächste Mal über dieses Thema sprechen, werden wir hoffentlich ganz vorne mit dabei sein, denn das sind wir.

Hannah Fry: Es scheint, als ob noch ein langer Weg vor uns liegt. Ich meine, es gibt immer noch einige Dinge, in denen diese Modelle nicht sehr gut sind.

Demis Hassabis: Ja, auf jeden Fall. Tatsächlich ist das derzeit die große Debatte. Diese letzten Dinge scheinen also aus einer Technologie hervorgegangen zu sein, die vor fünf oder sechs Jahren erfunden wurde. Das Problem ist, dass ihnen immer noch jede Menge Zeug fehlt. Sie erzeugen also tatsächlich das, was wir als Halluzinationen kennen. Sie sind auch nicht sehr gut im Planen.

Hannah Fry: Welchen Sinn planen sie? Ich meine.

Demis Hassabis: Ja, dort findet derzeit die Debatte statt. Diese jüngste Reihe von Entwicklungen basiert tatsächlich auf einer Technologie, die vor 5 oder 6 Jahren erfunden wurde. Das Problem ist jedoch, dass ihnen immer noch viel fehlt. Es gibt zum Beispiel Probleme mit ihrer sachlichen Richtigkeit und wir wissen, dass sie halluzinieren können. Darüber hinaus sind sie nicht gut genug im Planen.

Hannah Fry: Was genau bedeutet „Planung“?

Demis Hassabis: Was die langfristige Planung angeht, geben Sie beispielsweise ein Ziel vor, und in der realen Welt können sie noch keine Operationen für Sie durchführen. Es handelt sich also immer noch um sehr passive Frage- und Antwortsysteme. Sie müssen sie aktivieren, indem Sie Fragen stellen, und dann geben sie eine Antwort, aber sie können das Problem nicht wirklich für Sie lösen.

Wenn Sie möchten, dass es sich um einen digitalen Assistenten handelt, möchten Sie vielleicht sagen: „Buchen Sie mir einen Urlaub in Italien und organisieren Sie alle Restaurants, Museen usw.“ Selbst wenn es Ihre Vorlieben wüsste, wäre es nicht in der Lage, diese tatsächlich zu buchen . Tickets und Abwicklung dieser Angelegenheiten. Das ist derzeit also nicht möglich.

Aber ich denke, dies ist die nächste Ära – jene Systeme, die ein eher agentisches Verhalten aufweisen, was wir Agentensysteme oder Systeme nennen würden, die die Fähigkeit haben, als Agenten zu agieren. Darin zeichnen wir uns aus. Das haben wir mit all unseren Spieleagenten, AlphaGo und anderen Projekten gemacht, über die wir in der Vergangenheit gesprochen haben. Wir kombinieren diese prestigeträchtigen Werke mit neuen großformatigen multimodalen Modellen. Ich denke, hier wird die nächste Generation von Systemen ansetzen. Man kann es sich als eine Kombination von AlphaGo und Gemini vorstellen.

Hannah Fry: Ja, ich finde AlphaGo schon sehr gut.

Demis Hassabis: Ja, es ist sehr gut im Planen, natürlich nur in der Gaming-Welt. Deshalb müssen wir es in gemeinsame Bereiche wie die tägliche Arbeit und die Sprache integrieren.

Hannah Fry: Sie haben gerade erwähnt, dass Google DeepMind jetzt der Maschinenraum von Google ist. Ich habe vor ein paar Jahren auch gefragt, ob Google ein ziemlich großes Risiko eingeht.

Demis Hassabis: Ja, das denke ich. Ich denke, Google hat die Bedeutung von KI immer verstanden. Als er das Amt des CEO übernahm, sagte er, dass Google dieses Thema zu Beginn seiner Amtszeit als nächsten großen Paradigmenwechsel ansah, sogar noch größer. Aber ich denke, in den letzten ein oder zwei Jahren haben wir wirklich begonnen, dieser Philosophie gerecht zu werden, nicht nur aus Forschungsperspektive, sondern auch aus Produkt- und anderen Aspekten. Es ist sehr aufregend und ich denke, es ist die richtige Entscheidung für uns, alle Talente zu koordinieren und unser Bestes zu geben, um voranzukommen.

Hannah Fry: Wie wäre es umgekehrt? Denn ich denke, bedeutet das aus der Sicht von DeepMind mit seinen starken Forschungskapazitäten, dass man sich jetzt, da es zum „Maschinenraum“ von Google geworden ist, mehr auf kommerzielle Interessen als auf rein wissenschaftliche Forschung konzentrieren muss?

Demis Hassabis: Wir müssen den Geschäftsinteressen mehr Aufmerksamkeit schenken, was jetzt eine unserer Aufgaben ist. Allerdings gibt es ein paar Dinge zu besprechen.

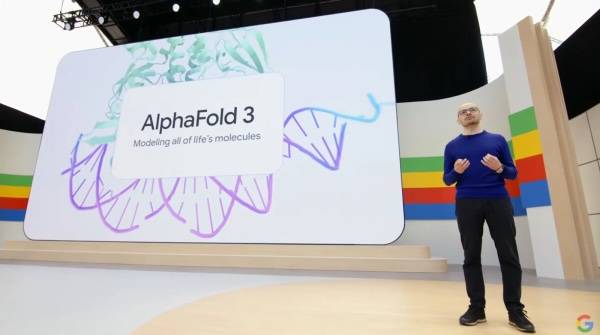

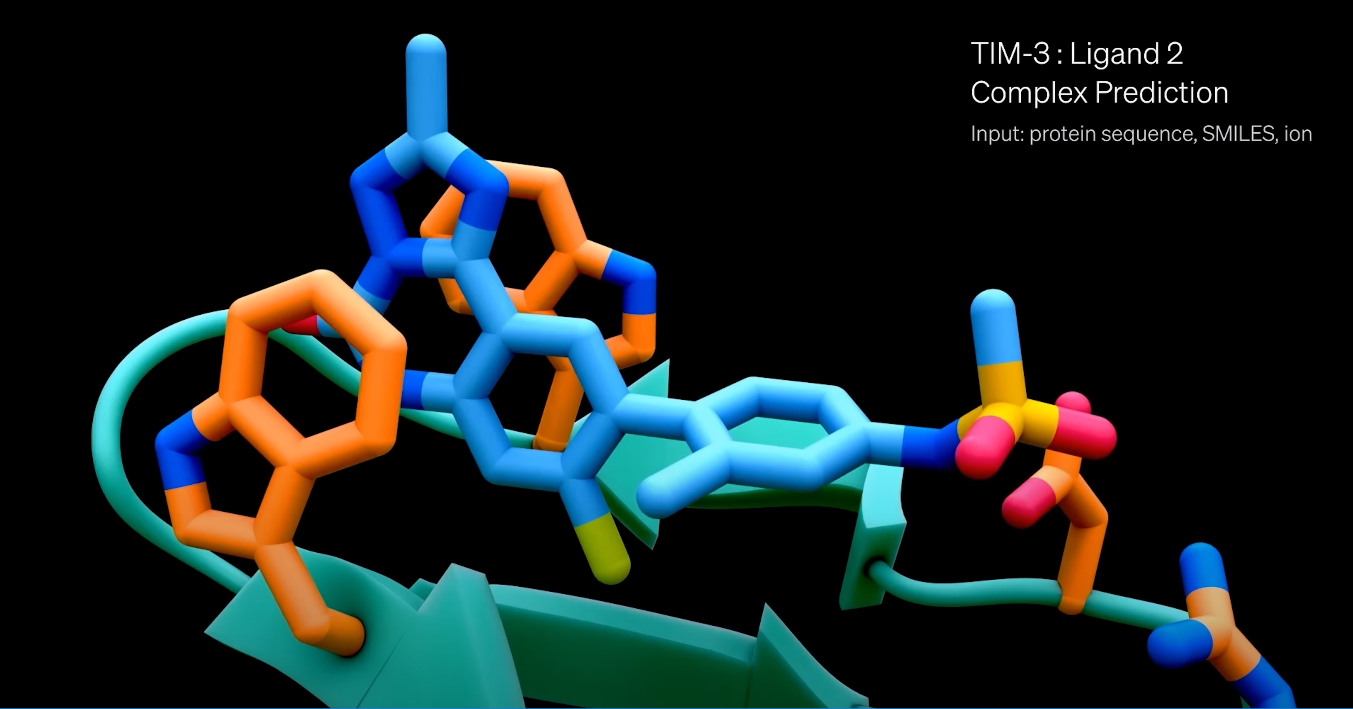

Erstens setzen wir unsere wissenschaftliche Forschung fort, wie zum Beispiel AlphaFold 3, das kürzlich veröffentlicht wurde, und wir verdoppeln unsere Investitionen in diesem Bereich. Ich denke, dass dies eine einzigartige Funktion von Google DeepMind ist. Selbst unsere Konkurrenten betrachten diese als den „universellen Reichtum“, den die KI mit sich bringt. Die Fortschritte an diesen Fronten sind sehr gut. Wir haben Isomorphic auch für die Arzneimittelforschung erweitert, was alles sehr spannend ist. Wir werden diese Bemühungen weiter vorantreiben.

Neben der Entwicklung großer Modelle, Gemini usw. bauen wir auch ein Produktteam auf, um all diese erstaunlichen Technologien auf die verschiedenen Plattformen von Google zu bringen. Es ist in gewisser Weise ein unglaubliches Privileg, dass das, was wir erfinden, eine unmittelbare Wirkung auf eine Milliarde Menschen haben kann, und das ist wirklich motivierend.

Tatsächlich gibt es mittlerweile eine größere Konvergenz zwischen der Entwicklung von KI-Technologien für den Einsatz in Produkten und solchen, die für die reine AGI-Forschung erforderlich sind. Vor fünf Jahren mussten Sie möglicherweise eine spezielle KI für ein Produkt entwickeln. Es gibt noch einige produktspezifische Arbeiten, die erledigt werden müssen, aber vielleicht sind das nur 10 % des Aufwands. Da nun also die Spannung zwischen der Entwicklung von KI-Produkten und dem Aufbau von AGI weg ist, würde ich sagen, dass 90 % des Forschungsplans derselbe sind.

Wenn Sie schließlich ein Produkt auf den Markt bringen und es in die Praxis umsetzen, werden Sie natürlich viel daraus lernen. Durch die Nutzung durch den Benutzer kann vieles aufgedeckt werden, was nicht genau mit Ihrer internen Einschätzung übereinstimmt, sodass Sie die Studie aktualisieren und verbessern können, was sehr hilfreich ist.

Hannah Fry: Stimme voll und ganz zu. In diesem Podcast sprechen wir mehr über die Durchbrüche, die durch die Anwendung von KI in der Wissenschaft erzielt wurden. Aber ich möchte eine Frage stellen, wann die Ergebnisse der Öffentlichkeit zugänglich gemacht werden. Innerhalb von DeepMind werden diese Tools, wie auch große Sprachmodelle, eher für Forschungszwecke verwendet als als potenzielle kommerzielle Produkte betrachtet, richtig.

Demis Hassabis: Ja, genau. Seit unseren Anfängen im Jahr 2010 haben wir Verantwortung und Sicherheit immer sehr ernst genommen und Google hat einige unserer Ethik-Charta in seine KI-Grundsätze übernommen. Daher sind wir eng mit Google als einem der führenden Unternehmen in diesem Bereich verbunden und haben uns dem verantwortungsvollen Einsatz von Technologie verschrieben.

Es ist jetzt wirklich interessant, Produkte mit generativer KI auf den Markt zu bringen. Wir lernen schnell, was gut ist, denn die Technologie befindet sich noch in einem relativ risikoarmen Stadium. Da die Technologie immer leistungsfähiger wird, müssen wir vorsichtiger sein. Für Produktteams ist es wichtig zu lernen, wie man generative KI-Technologie testet. Dies unterscheidet sich vom Testen normaler Technologie, da die generative KI nicht unbedingt immer das Gleiche tut. Es ist fast so, als würde man ein Open-World-Spiel ausprobieren, und die Dinge, die man ausprobieren kann, sind nahezu grenzenlos. Es wird also sehr interessant, wie man Red Teaming durchführt.

Hannah Fry: Konkurriert das rote Team in diesem Fall gegen Sie selbst?

Demis Hassabis: Ja, Red Teaming bedeutet, ein vom Entwicklungsteam unabhängiges Team zusammenzustellen, das Stresstests durchführt und versucht, die Technologie auf jede erdenkliche Weise zu zerstören. Realistisch gesehen benötigen Sie Tools, um diese Tests zu automatisieren, denn selbst wenn Zehntausende von Personen teilnehmen, ist dies immer noch nicht mit der tatsächlichen Nutzung durch Milliarden von Benutzern vergleichbar. Wenn die Technologie veröffentlicht wird, werden Benutzer eine Vielzahl von Dingen ausprobieren. Es hat also Spaß gemacht, diese Erkenntnisse zur Verbesserung unserer Prozesse anzuwenden, um sicherzustellen, dass zukünftige Releases so reibungslos wie möglich ablaufen. Wir müssen es schrittweise tun, beginnend mit einer experimentellen Phase, dann einer geschlossenen Beta und schließlich einer schrittweisen Veröffentlichung, genau wie wir es bei früheren Spielveröffentlichungen getan haben. Lernen Sie jeden Schritt des Weges.

Darüber hinaus sollten wir die KI selbst stärker nutzen, um Red-Team-Tests durchzuführen, einige Fehler automatisch zu entdecken oder vorläufige Klassifizierungen durchzuführen, damit sich unsere Entwickler und menschlichen Tester auf die Bewältigung dieser komplexen Situationen konzentrieren können.

Hannah Fry: Was wirklich interessant ist, ist, dass Sie sich jetzt in einer unsichereren Situation befinden. Wenn die Wahrscheinlichkeit, dass etwas passiert, sehr gering ist, man es aber oft genug versucht, wird irgendwann etwas schiefgehen. Ich denke, dass es möglicherweise ein paar veröffentlichte Fehler gegeben hat.

Demis Hassabis: Ja, deshalb habe ich erwähnt, dass sich Produktteams an diesen Testansatz anpassen. Obwohl sie diese Systeme testeten, waren sie von Natur aus zufällig und unsicher. Wenn es sich also um gewöhnliche Software handelt, kann man in vielen Fällen sagen, dass ich 99,99 % der Fälle getestet habe, und daraus schließen, dass dies ausreicht. Aber das ist bei diesen generativen Systemen nicht der Fall, die auf alle möglichen unerwarteten, unerwarteten und noch nie dagewesenen Arten reagieren können.

Dies kann schwierig sein, wenn jemand, der schlau oder gegnerisch ist, wie etwa ein Hacker, beschließt, seine Grenzen zu testen und auszureizen. Aufgrund der Zufälligkeit des Generierungssystems befinden sie sich möglicherweise in einem besonderen Zustand oder ihr Speicher ist mit bestimmten Informationen gefüllt, sodass die Ausgabe abnormal ist, selbst wenn sie alles enthält, was Sie zuvor gesagt haben. Das ist zwar sehr komplex, aber nicht unendlich. Es gibt zwar Möglichkeiten, mit diesen Situationen umzugehen, diese sind jedoch viel komplexer und differenzierter als herkömmliche Technologieversionen.

Hannah Fry: Ich erinnere mich, dass Sie gesagt haben, dass wir uns dies als eine völlig andere Art des Rechnens vorstellen müssen, vom deterministischen Rechnen, das wir vollständig verstehen, hin zu dieser chaotischeren, probabilistischeren und fehlerbehafteteren Art des Rechnens. Glauben Sie, dass die Öffentlichkeit ihre Meinung über die Art der von uns betriebenen Datenverarbeitung ein wenig ändern muss?

Demis Hassabis: Ich denke schon. Bevor wir etwas veröffentlichen, können wir vielleicht darüber nachdenken, ein Grundsatzdokument oder etwas Ähnliches zu veröffentlichen, um zu klären, was die Erwartungen an das System sind, was der Entwurfszweck ist, welche anwendbaren Szenarien es gibt und welche Aufgaben dadurch nicht erledigt werden können viel Sinn. Wir müssen die Benutzer darüber aufklären, dass man es in manchen Fällen auf diese Weise verwenden kann, aber diese anderen Dinge nicht ausprobieren, da es sonst möglicherweise nicht funktioniert. Ich denke, das ist ein Bereich, in dem wir besser werden müssen und die Benutzer erfahrener sein müssen. Es ist eigentlich ziemlich interessant.

Dies mag der Grund dafür sein, dass Chatbots etwas aus heiterem Himmel entstanden sind. Sogar ChatGPT überraschte OpenAI. Wir haben unseren eigenen Chatbot, Google auch. Als ich sie mir ansah, fiel mir auch auf, dass sie immer noch viele Mängel aufweisen und immer noch unter Irrtümern, Illusionen und vielen anderen Problemen leiden. Was uns jedoch nicht bewusst war, ist, dass es trotzdem immer noch viele sehr gute Anwendungsfälle für Chatbots gibt, die für die Menschen sehr wertvoll sind, wie zum Beispiel das Zusammenfassen von Dokumenten, das Schreiben von E-Mails, das Ausfüllen von Formularen usw. In diesen Nutzungsszenarien stört es die Leute nicht, auch wenn es kleinere Fehler gibt, da diese leicht behoben werden können und viel Zeit sparen. Das ist die Überraschung, die Menschen erleben, wenn sie diese Technologien in die Hände der breiten Masse legen. Trotz der vielen bekannten Mängel dieser Systeme gibt es immer noch wertvolle Anwendungsfälle.

Hannah Fry: Die nächste Frage, die ich stellen möchte, betrifft Open Source. Denn wenn Technologie in den Händen der Massen ist, passieren, wie Sie erwähnt haben, einige wirklich erstaunliche Dinge. Ich weiß, dass DeepMind in der Vergangenheit viele Forschungsprojekte als Open Source bereitgestellt hat, aber es scheint, als hätte sich dies im Laufe der Zeit geändert.

Demis Hassabis: Wir haben Open Source und Open Science immer sehr unterstützt. Wie Sie wissen, veröffentlichen wir fast jedes Forschungsprojekt, das wir durchführen, als Open Source, einschließlich Projekten wie Transformer und AlphaGo, die wir in den Zeitschriften Nature und Science veröffentlichen. AlphaFold ist ebenfalls Open Source, wie wir letztes Mal besprochen haben.

Tatsächlich ist es so, dass Technologie und Wissenschaft durch den Austausch von Informationen rasant voranschreiten, weshalb wir fast immer davon ausgehen, dass dies von Vorteil ist. Dies ist die allgemeine Art und Weise, wie die Wissenschaft voranschreitet. Die einzige Ausnahme ist, wenn es um leistungsstarke KI oder AGI geht, wo wir mit dem Problem der Dual-Use-Technologie konfrontiert sind.

Die Frage ist also, dass Sie alle guten Anwendungsfälle und diese gut gemeinten Wissenschaftler und Technologen unterstützen und sie ermutigen möchten, auf diesen Ideen aufzubauen, sie zu kritisieren usw. Dies ist der schnellste Weg für die Gesellschaft, voranzukommen. Das Problem besteht jedoch darin, gleichzeitig den Zugriff auf böswillige Akteure zu beschränken, die diese Systeme möglicherweise für unerwünschte Zwecke nutzen, missbrauchen oder in Waffensysteme umwandeln usw.

Diese allgemeinen Systeme können tatsächlich auf diese Weise und auf andere Weise ausgenutzt werden. Es würde nicht schaden, das heute zu tun, weil ich glaube, dass das aktuelle System nicht robust genug ist. Aber nach zwei oder drei Jahren, insbesondere wenn man sich mit automatisierten Agentensystemen oder dem Agentenverhalten vertraut macht, kann es ernsthaften Schaden anrichten, wenn diese Systeme von einigen Leuten oder sogar einigen Schurken missbraucht werden. Daher denke ich, dass wir als Kollektiv darüber nachdenken müssen, was das für Open Source bedeutet.

Möglicherweise müssen hochmoderne Modelle genauer untersucht werden, vielleicht ein oder zwei Jahre nach ihrer Veröffentlichung, bevor sie als Open Source verfügbar sind. Dies ist das Modell, dem wir derzeit folgen, da wir über unsere eigenen Open-Source-Modelle wie Gemma verfügen, die kleiner sind und daher keine hochmodernen Modelle sind. Obwohl ihre Fähigkeiten zum jetzigen Zeitpunkt gut verstanden sind, sind sie für Entwickler immer noch sehr nützlich, da sie auch problemlos auf Laptops ausgeführt werden können. Zusammenfassend lässt sich sagen, dass die Fähigkeiten dieser Modelle immer noch wertvoll sind, aber nicht so leistungsstark wie die neuesten Spitzenmodelle (wie das Modell Gemini 1.5). Daher denke ich, dass wir am Ende wahrscheinlich diesen Ansatz verfolgen werden, bei dem wir Open-Source-Modelle haben werden, diese aber den hochmodernen Modellen um etwa ein Jahr hinterherhinken, sodass wir die Leistung dieser Modelle wirklich bewerten können in einer offenen Umgebung.

Hannah Fry: Die neuesten und modernsten Modellfunktionen können tatsächlich die Grenzen verschieben.

Demis Hassabis: Wir können uns die Fähigkeiten und Grenzen dieser Modelle ansehen. Das Problem bei Open Source ist, dass man es nicht rückgängig machen kann, wenn etwas schiefgeht. Mit einem proprietären Modell können Sie den Zugriff sperren, wenn böswillige Akteure damit beginnen, ihn auf schädliche Weise zu nutzen. Im Extremfall können Sie es komplett ausschalten. Aber sobald Sie etwas als Open-Source-Quelle freigegeben haben, können Sie es nicht mehr zurücknehmen. Dies ist eine Einbahnstraße, daher sollten Sie bei Open Source sehr vorsichtig sein.

Hannah Fry: Ist es also möglich, AGI innerhalb der Grenzen einer Organisation zu kontrollieren?

Demis Hassabis: Noch keine Ahnung, wie das geht. Vor allem, wenn es um leistungsstarke künstliche Intelligenz auf der AGI-Ebene geht, also einer KI, die der menschlichen Ebene ähnelt.

Hannah Fry: Wo passen Institutionen in das von Ihnen beschriebene ideale Ökosystem? Wenn wir das Stadium erreichen, in dem AGI die gesamte wissenschaftliche Forschung unterstützt, werden traditionelle Institutionen dann noch einen Wert haben?

Demis Hassabis: Ich denke, Institutionen sind immer noch wichtig. Bevor AGI erreicht wird, muss eine Zusammenarbeit zwischen Zivilgesellschaft, Wissenschaft, Regierung und Industrielabors erfolgen. Ich bin fest davon überzeugt, dass dies der einzige Weg ist, wie wir dieses Stadium erreichen können.

Hannah Fry: Der Informatiker Stuart Russell sagte mir einmal, dass er ein wenig besorgt sei, dass es, sobald wir AGI erreichen, zu einer Situation kommen könnte, in der wir alle wie die Prinzen von früher sind – Leute, die sich nicht anmelden müssen, Leute, die sitzen Auf dem Thron sitzen und keine Arbeit verrichten, sondern ein Leben in hemmungslosem Luxus und ohne Ziele führen.

Demis Hassabis: Ja, das ist eine interessante Frage. Vielleicht handelt es sich hier nicht nur um AGI, sondern eher um künstliche Superintelligenz (Artificial Superintelligence) oder ein anderes Konzept, manchmal nennen es die Leute ASI (Artificial Superintelligence). In diesem Fall erleben wir möglicherweise einen grundlegenden Zustand des Überflusses, in dem wir mehr Freiheit bei unseren Entscheidungen haben, solange wir dafür sorgen, dass die Ressourcen gerecht und rational verteilt werden.

Die Bedeutung wird dann zu einer großen philosophischen Frage. Ich denke, wir brauchen Philosophen, sogar Theologen und Sozialwissenschaftler, die anfangen, darüber nachzudenken. Was bringt Sinn? Ich halte Selbstverwirklichung immer noch für wichtig. Ich glaube nicht, dass wir alle einfach da sitzen und meditieren, vielleicht Computerspiele spielen, wer weiß? Aber ist es wirklich schlimm? Vielleicht müssen wir auch neu definieren, was ein „gutes“ Leben ist.

Hannah Fry: Ich denke, die Prinzen von früher hätten nichts Schlimmes empfunden.

Demis Hassabis: Wenn man sich diejenigen ansieht, die Extremsportarten betreiben, wie zum Beispiel die Besteigung des Mount Everest, sind das alles Herausforderungen an menschliche Grenzen. Die Motivationen hinter diesen Aktivitäten können mit dem Streben nach Sinn und Selbstverwirklichung zusammenhängen. Wie Sie bereits erwähnt haben, werden diese Themen unsere Welt erheblich verändern, auch wenn sie noch nicht ausführlich diskutiert werden.

Auch wenn die fortschrittlichsten Technologien große Veränderungen mit sich gebracht haben, etwa die Behandlung von Krankheiten, die Lösung von Energieproblemen, die Reaktion auf den Klimawandel usw., stehen wir immer noch vor dem tief verwurzelten Problem des „Sinnes“. Diese Sinnsuche findet nicht nur auf technischer Ebene statt, sondern umfasst auch philosophische, psychologische und sogar kulturelle Ebenen. Wir müssen darüber nachdenken, wie die menschliche Existenz und das menschliche Verhalten im Zuge des künftigen Technologiebooms neu definiert werden.

# Willkommen beim offiziellen öffentlichen WeChat-Konto von aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner |. Ursprünglicher Link · Kommentare anzeigen · Sina Weibo