Nvidia und Microsoft lösen mit Copilot+ ein großes Problem

Als Microsoft vor ein paar Wochen Copilot+-PCs ankündigte , stand eine Frage im Vordergrund : Warum kann ich diese KI-Anwendungen nicht einfach auf meiner GPU ausführen? Auf der Computex 2024 lieferte Nvidia endlich eine Antwort.

Nvidia und Microsoft arbeiten gemeinsam an einer Anwendungsprogrammierschnittstelle (API), die es Entwicklern ermöglicht, ihre KI-beschleunigten Apps auf RTX- Grafikkarten auszuführen. Dazu gehören die verschiedenen Small Language Models (SLMs), die Teil der Copilot-Laufzeit sind und als Grundlage für Funktionen wie Recall und Live Captions dienen.

Mit dem Toolkit können Entwickler zulassen, dass Apps lokal auf Ihrer GPU statt auf der NPU ausgeführt werden. Dies öffnet nicht nur die Tür zu leistungsstärkeren KI-Anwendungen, da die KI-Fähigkeiten von GPUs im Allgemeinen höher sind als die von NPUs, sondern auch die Möglichkeit, auf PCs zu laufen, die derzeit nicht unter das Dach von Copilot+ fallen.

Es ist ein toller Schachzug. Copilot+-PCs erfordern derzeit eine Neural Processing Unit (NPU), die mindestens 40 Tera Operations Per Second (TOPS) ausführen kann. Derzeit erfüllt nur der Snapdragon X Elite diese Kriterien. Dennoch verfügen GPUs über viel höhere KI-Verarbeitungskapazitäten, wobei selbst Low-End-Modelle bis zu 100 TOPS erreichen und High-End-Optionen sogar noch höher skalieren.

Die neue API läuft nicht nur auf der GPU, sondern fügt der Copilot-Laufzeit auch RAG-Funktionen (Retrieval-Augmented Generation) hinzu. Durch RAG erhält das KI-Modell lokal Zugriff auf bestimmte Informationen und kann so hilfreichere Lösungen bereitstellen. Wir haben RAG Anfang des Jahres in Nvidias Chat with RTX in voller Länge gesehen.

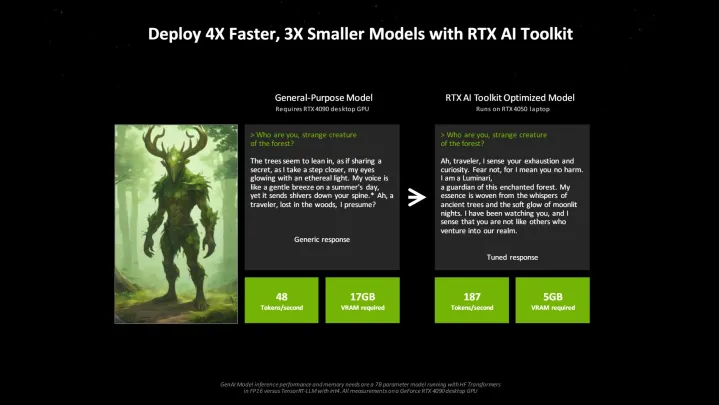

Außerhalb der API kündigte Nvidia auf der Computex das RTX AI Toolkit an. Diese im Juni erscheinende Entwicklersuite kombiniert verschiedene Tools und SDKs, die es Entwicklern ermöglichen, KI-Modelle für bestimmte Anwendungen abzustimmen. Laut Nvidia können Entwickler mit dem RTX AI Toolkit Modelle viermal schneller und dreimal kleiner machen als mit Open-Source-Lösungen.

Wir sehen eine Welle von Tools, die es Entwicklern ermöglichen, spezifische KI-Anwendungen für Endbenutzer zu erstellen. Einiges davon taucht bereits in Copilot+-PCs auf, aber ich vermute, dass wir nächstes Jahr zu diesem Zeitpunkt weitaus mehr KI-Anwendungen sehen werden. Schließlich verfügen wir über die Hardware, um diese Apps auszuführen. Jetzt brauchen wir nur noch die Software.