OpenAI veröffentlicht das stärkste Modell o1! GPT-5 wird den KI-Engpass überwinden und eine neue Ära einläuten – vielleicht kommt es nie

Sam Altman, CEO von OpenAI, sagte: „OpenAI o1 ist der Beginn eines neuen Paradigmas: KI, die komplexe Schlussfolgerungen für allgemeine Zwecke durchführen kann.“

Dieses neue Modell ist ein wichtiger Durchbruch bei komplexen Denkaufgaben und stellt eine neue Ebene der KI-Fähigkeiten dar. Auf dieser Grundlage hat OpenAI beschlossen, diese Serie in OpenAI o1 umzubenennen und von vorne zu beginnen.

Ich weiß nicht, ob das bedeutet, dass der Name GPT-5 nicht mehr erscheint.

Eine kurze Zusammenfassung der Features des neuen Modells:

- OpenAI o1: leistungsstarke Leistung, geeignet für die Bewältigung komplexer Argumentationsaufgaben in verschiedenen Bereichen.

- OpenAI o1 mini: Kostengünstig und geeignet für Anwendungen, die Argumentation erfordern, aber kein umfassendes Weltwissen erfordern.

Jetzt wurde das Modell vollständig gepusht und Sie können über den ChatGPT-Webclient oder die API darauf zugreifen.

Unter diesen ist o1-preview immer noch eine Vorschauversion, und OpenAI wird die nächste Version weiterhin aktualisieren und weiterentwickeln. Derzeit gibt es bestimmte Nutzungsbeschränkungen, o1-preview hat 30 Nachrichten pro Woche und o1-mini hat 50 Nachrichten pro Woche.

Wie das gemunkelte „Strawberry“ sind diese neuen KI-Modelle in der Lage, über komplexe Aufgaben nachzudenken und schwierigere Probleme als je zuvor in Naturwissenschaften, Programmierung und Mathematik zu lösen. Beamte sagen, dass diese verbesserten Denkfähigkeiten besonders nützlich sein werden, wenn Sie komplexe Probleme in Naturwissenschaften, Codierung, Mathematik und mehr lösen müssen.

Beispielsweise können medizinische Forscher damit Zellsequenzierungsdaten annotieren, Physiker können damit komplexe quantenoptische Formeln generieren und Entwickler können damit mehrstufige Arbeitsabläufe erstellen und ausführen.

Darüber hinaus zeichnet sich die OpenAI o1-Serie durch die Generierung und Fehlerbehebung komplexer Codes aus.

Um Entwicklern effizientere Lösungen zu bieten, hat OpenAI auch ein schnelleres und kostengünstigeres Inferenzmodell OpenAI o1-mini veröffentlicht, das besonders gut im Codieren ist.

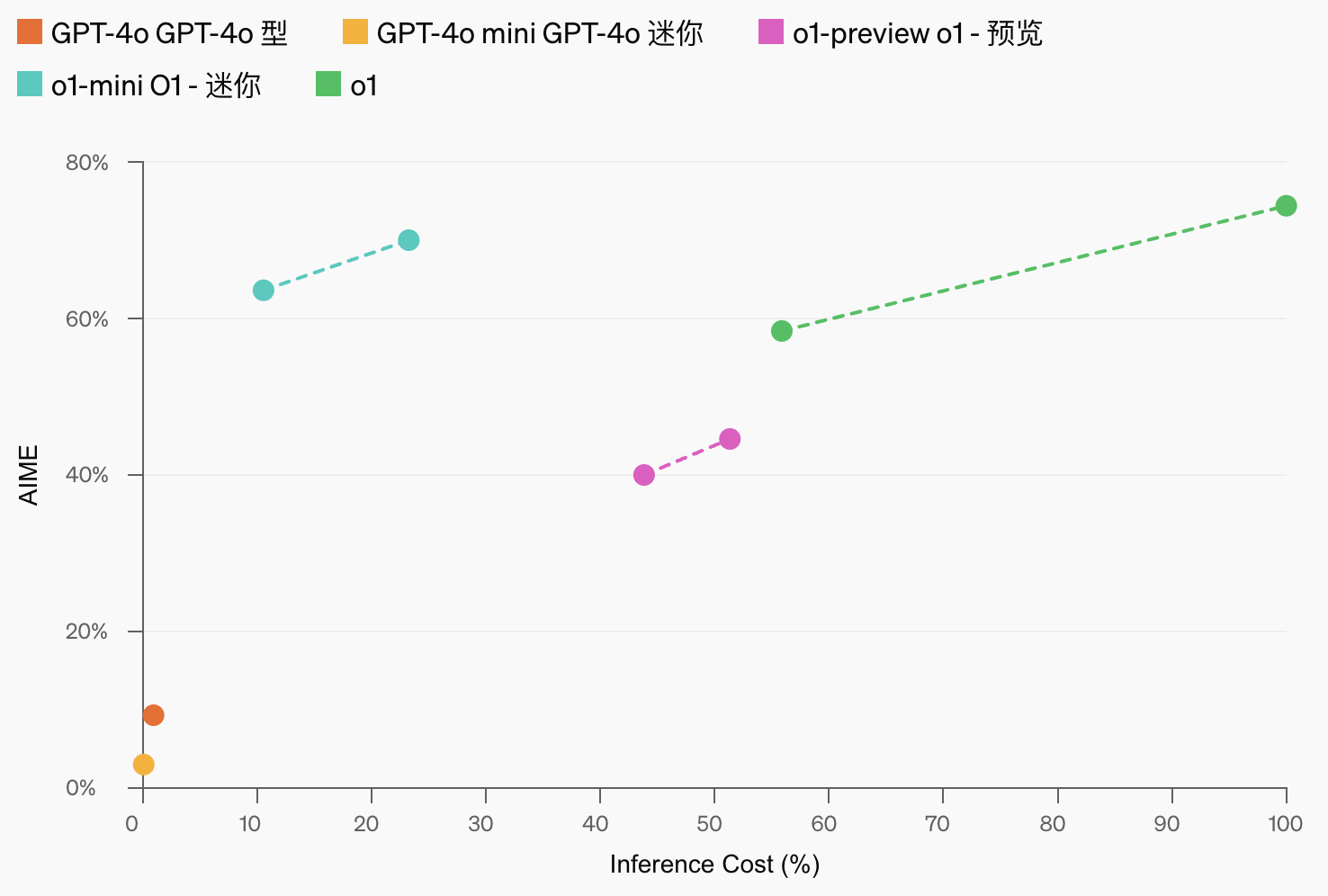

Als kleinere Version kostet o1-mini 80 % weniger als o1-preview und ist ein leistungsstarkes und effizientes Modell, das für Anwendungsszenarien geeignet ist, die Argumentation erfordern, aber kein umfassendes Weltwissen erfordern.

Während des Trainings trainiert OpenAI diese Modelle, gründlich nachzudenken, bevor sie eine Frage beantworten. o1 generiert vor der Beantwortung einer Frage eine interne Gedankenkette, die es ihm ermöglicht, tiefergehende Überlegungen anzustellen.

Durch Training lernt das OpenAI o1-Modell, seine Denkweise zu perfektionieren, und verbessert sich weiterhin durch mehr verstärkendes Lernen (in der Trainingszeit gezählt) und mehr Zeit zum Nachdenken (in der Testzeit gezählt).

Der OpenAI-Forscher @yubai01 wies auch auf den Trainingsweg von 01 hin:

Wir verwenden RL, um ein leistungsfähigeres Inferenzmodell zu trainieren. Ich freue mich sehr, Teil dieser Reise zu sein, und es geht weit!

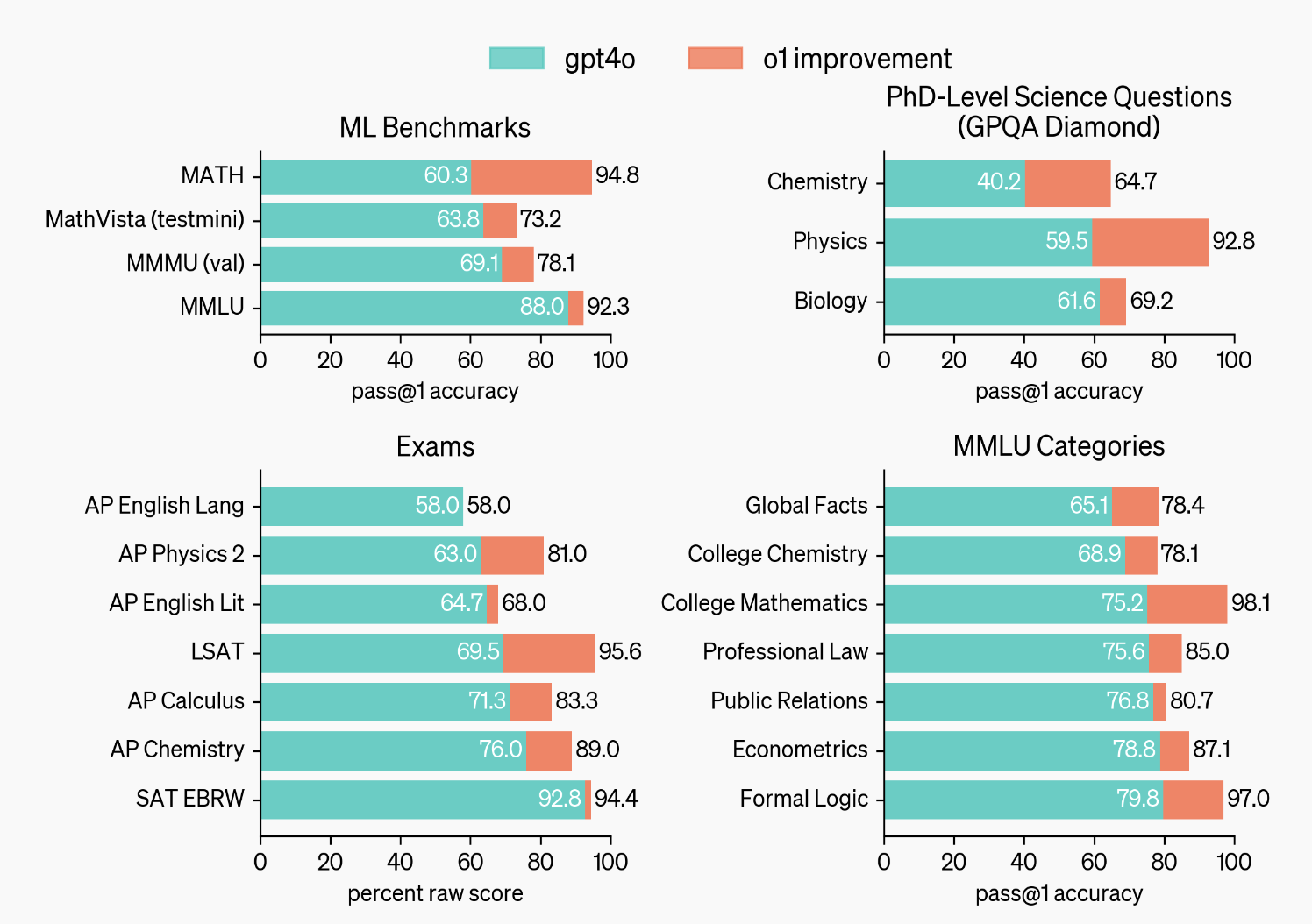

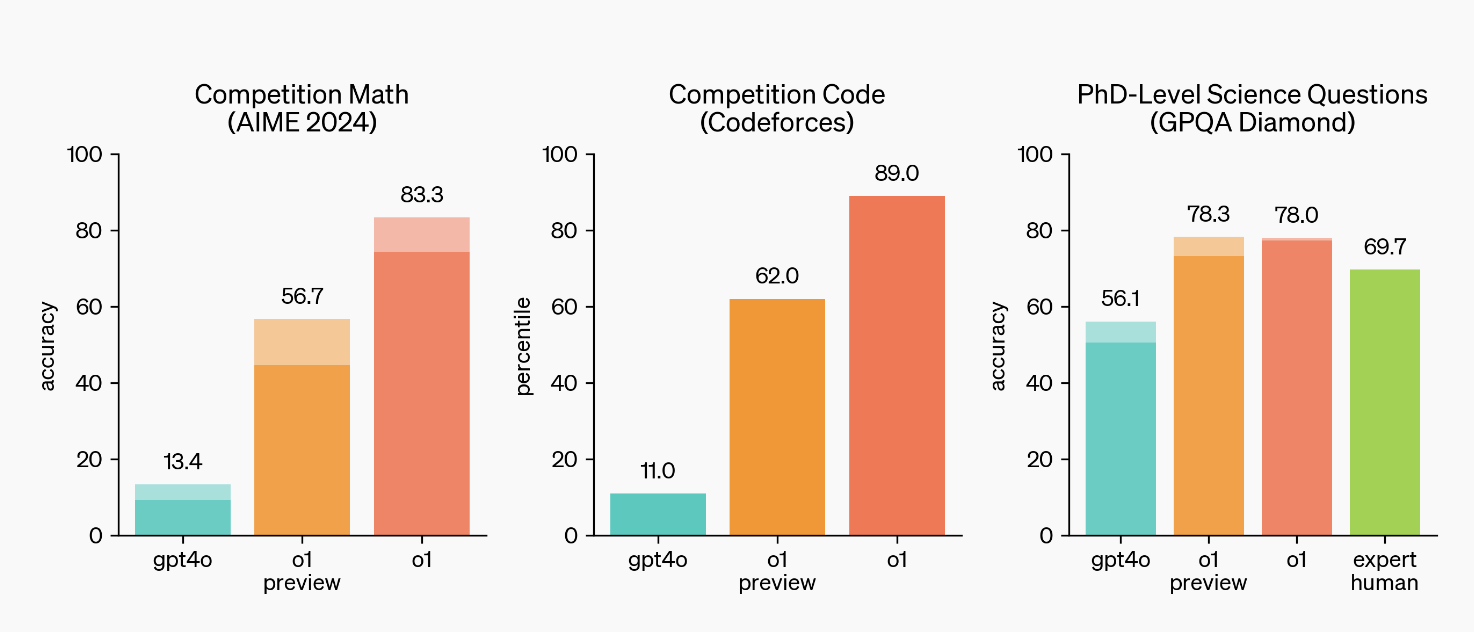

Berichten zufolge schnitt dieses Modell in Tests bei Aufgaben wie Physik, Chemie und Biologie wie ein Doktorand ab, insbesondere in den Bereichen Mathematik und Codierung.

Bei der Qualifikationsprüfung zur Internationalen Mathematischen Olympiade (IMO) löste GPT-4o nur 13 % der Probleme, während das Inferenzmodell sogar 83 % erreichte. Im Codeforces-Programmierwettbewerb lag seine Leistung unter den besten 89 % der Kohorte.

Allerdings verfügt dieses Modell, wie die gemunkelten Enthüllungen auch zeigen, als frühe Version noch nicht über einige gemeinsame Funktionen von ChatGPT, wie etwa multimodale Funktionen wie das Surfen im Internet und das Hochladen von Dateien oder Bildern.

Im Gegensatz dazu ist GPT-4o für viele gängige Anwendungsszenarien besser geeignet.

Um die Sicherheit neuer Modelle zu gewährleisten, schlägt OpenAI eine neue sichere Trainingsmethode vor.

Im strengsten „Jailbreak“-Test erreichte GPT-4o 22 (von 100), während das o1-Preview-Modell 84 Punkte erzielte, was in puncto Sicherheit weit vorn liegt.

ChatGPT Enterprise- und Edu-Benutzer haben ab nächster Woche auch Zugriff auf beide Modelle. Berechtigte Entwickler können nun beide Modelle über die API nutzen, mit Tarifbegrenzungen pro Minute.

Um hier einen wichtigen Punkt hervorzuheben: OpenAI erklärte, dass es in Zukunft allen kostenlosen ChatGPT-Benutzern Zugriff auf o1-mini gewähren wird. Es besteht jedoch eine hohe Wahrscheinlichkeit, dass die Anzahl begrenzt sein wird.

Weitere Details zum neuen Modell o1 werden Ihnen bald nach einem ausführlicheren Erlebnis mitgeteilt. Wenn Sie Fragen haben, die Sie interessieren, teilen Sie uns dies bitte im Nachrichtenbereich mit.

Mein Denkvermögen ist weit voraus, aber ich kann immer noch nicht sagen, welches besser ist, 9,11 oder 9,8.

Der Beamte veröffentlichte außerdem weitere Demovideos von OpenAI o1.

Verwenden Sie beispielsweise OpenAI o1, um ein Webspiel zum Finden von Eichhörnchen zu schreiben. Das Ziel dieses Spiels ist es, einen Koala zu kontrollieren, um der zunehmenden Anzahl von Erdbeeren auszuweichen und das Eichhörnchen zu finden, das nach 3 Sekunden erscheint.

Anders als bei traditionellen klassischen Spielen wie Snake ist die Logik dieser Art von Spielen relativ komplex und stellt die logische Denkfähigkeit von OpenAI o1 auf die Probe.

Oder OpenAI o1 hat begonnen, einige einfache physikalische Probleme durch logisches Denken zu lösen.

Bei der Demonstration wurde ein Beispiel gezeigt, bei dem eine kleine Erdbeere in einen gewöhnlichen Becher gegeben wurde, der Becher umgedreht auf den Tisch gestellt wurde und dann der Becher hochgehoben und gefragt wurde, wo die Erdbeere sein würde, und gebeten wurde, den Argumentationsprozess zu erklären. Dies zeigt, dass das Modell in der Lage ist, die Positionsänderungen von Objekten in verschiedenen physikalischen Zuständen zu verstehen.

Bei der Implementierung in bestimmte Anwendungen kann OpenAI o1 auch zum rechten Assistenten eines Arztes werden, indem es Ärzten beispielsweise dabei hilft, Fallinformationen zu organisieren und zusammenzufassen, und sogar bei der Diagnose einiger schwieriger und komplizierter Krankheiten behilflich ist.

Mario Krenn, ein Quantenphysiker, der daran interessiert ist, KI und Wissenschaft zu verbinden, stellte dem o1-Modell von OpenAI auch eine Frage zur Anwendung eines bestimmten Quantenoperators. Infolgedessen hat OpenAI o1 es auch leicht herausgefunden.

Wie viele „r“ gibt es in „Strawberry“? GPT-4o wird falsche Antworten geben, aber es kann OpenAI o1 nicht stören

Allerdings kann OpenAI o1 nach tatsächlichen Tests das klassische Problem „Was ist größer, 9.11 oder 9.8?“ immer noch nicht lösen, was zu einem gravierenden Punktabzug führt.

Zur Einführung von OpenAI o1 sagte Jim Fan, Leiter der Abteilung Embodied Intelligence bei NVIDIA:

Endlich erleben wir, wie das Paradigma der Inferenzzeitskalierung verallgemeinert und in die Produktion überführt wird. Wie Sutton (der Pate des Reinforcement Learning) in „The Bitter Lessons“ sagte, gibt es nur zwei Techniken, die sich unbegrenzt mit Berechnungen skalieren lassen:

Lernen und suchen. Es ist an der Zeit, unseren Fokus auf Letzteres zu richten.

Seiner Ansicht nach werden viele Parameter in großen Modellen verwendet, um sich Fakten zu merken, was in der Tat hilfreich ist, um die Punktzahl im Frage-Antwort-Test zu steigern klein Der „Inferenzkern“ wird zum Aufrufen von Tools wie Browsern und Code-Verifizierern verwendet, wodurch der Umfang der Berechnungen vor dem Training reduziert werden kann.

Jim Fan wies auch auf den größten Vorteil von OpenAI o1 hin, nämlich dass das o1-Modell problemlos Teil des Datenschwungrads werden kann.

Einfach ausgedrückt: Wenn das Modell die richtige Antwort gibt, kann der gesamte Suchprozess in einen Trainingsdatensatz umgewandelt werden, der positive und negative Belohnungen enthält. Solche Datensätze können zum Trainieren zukünftiger Versionen des Modells verwendet werden. Mit zunehmender Verfeinerung der generierten Trainingsdaten wird sich die Leistung des Modells weiter verbessern. Es ist eine gute Idee, den inneren Kreislauf des Selbsttrainings durch Ihr eigenes Spiel zu erkennen.

Allerdings stellten die Internetnutzer auch einige Probleme beim eigentlichen Testen fest, zum Beispiel war die Antwortzeit viel länger. Obwohl das Nachdenken länger dauerte, gab es auch Probleme wie unvollständige Antworten auf die Fragen und unvollständige Ausgabe bei einigen Fragen.

Cyber Zen Heart vermutet, dass o1 dieses Mal nach einigen Feinabstimmungen/Anpassungen der Agent von GPT-4o sein könnte und die Gesamtleistung weitaus geringer ausfällt als erwartet.

Sam Altman gibt auch zu, dass das o1 immer noch Mängel aufweist, Einschränkungen aufweist und bei der ersten Verwendung beeindruckender ist und nach längerer Verwendung weniger beeindruckend ist.

Dennoch ist die Gesamtleistung des OpenAI o1-Modells bemerkenswert.

Nun kann die Veröffentlichung des OpenAI o1-Modells als Auslöser für den KI-Modellkrieg in der zweiten Jahreshälfte angesehen werden. Wenn nichts Unerwartetes passiert, werden andere KI-Unternehmen es nicht verbergen.

Das ist richtig, ich ziele auf alte Konkurrenten wie Anthropic, Meta AI und xAI sowie auf einige potenziell tiefgreifende KI-Dark Horses.

Darüber hinaus liegt die tiefste Bedeutung jeder OpenAI-Modellversion seit der Veröffentlichung von GPT-4 bis heute nicht in der leistungsstarken Leistung, sondern darin, einen Maßstab für eine technische Route bereitzustellen und so Menschen dazu zu bringen, in unbekannte tiefe Gewässer vorzudringen.

GPT-4 ist so und OpenAI o1 hofft, so zu sein.

# Willkommen beim offiziellen öffentlichen WeChat-Konto von aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner |. Ursprünglicher Link · Kommentare anzeigen · Sina Weibo