Sprachungleichheit großer KI-Modelle: Englisch-Training kostet am günstigsten, Chinesisch-Training kostet doppelt so viel wie Englisch

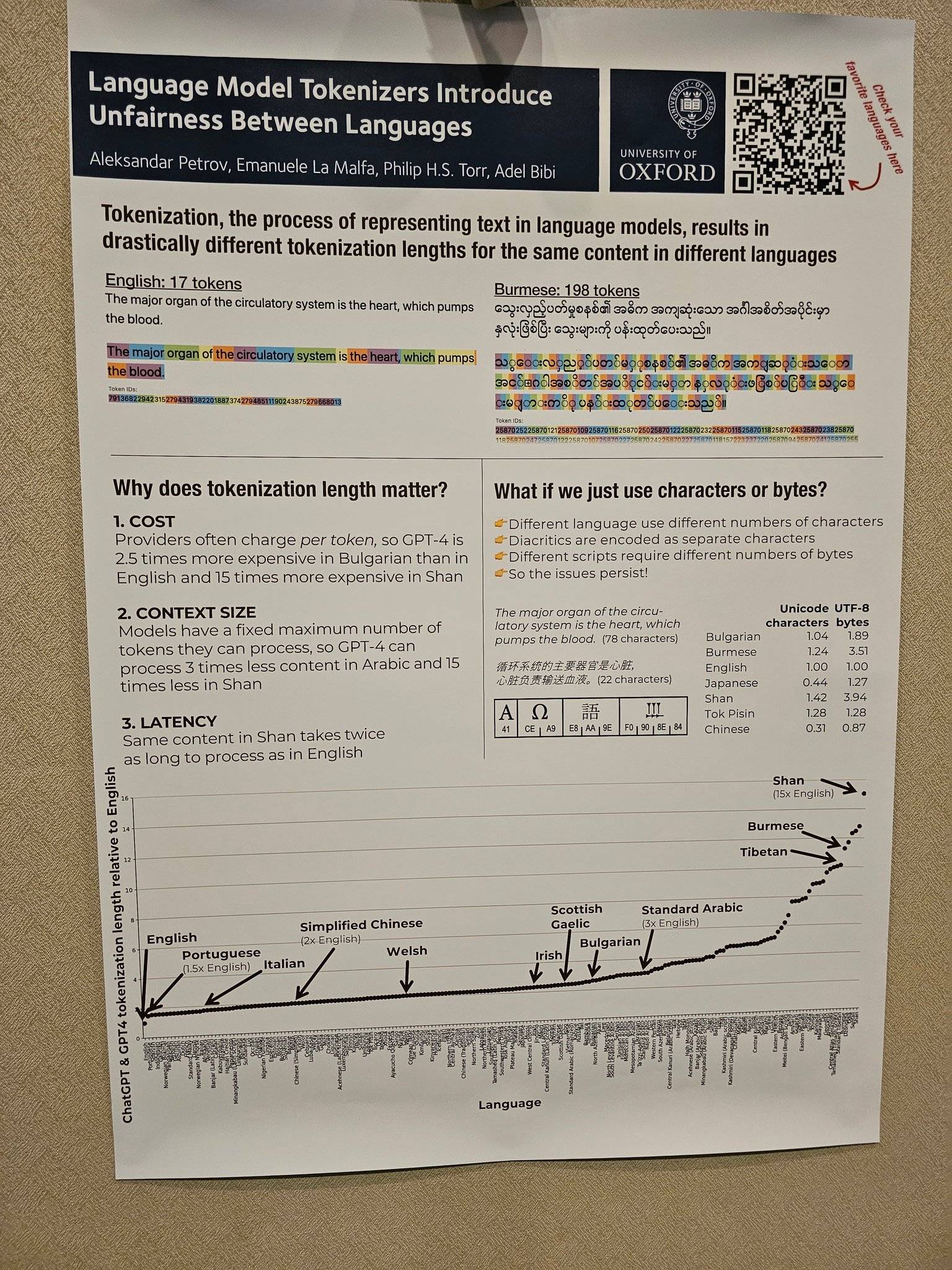

Kürzlich zeigte der X-Benutzer (ehemals Twitter) @Dylan Patel eine Studie der Universität Oxford: Bei der Untersuchung der Sprache von GPT-4 und den meisten anderen gängigen LLMs stellte die Studie fest, dass die Kosten für LLM-Inferenzen (Large Language Model) sehr unterschiedlich sind. groß.

Unter diesen ist die Ein- und Ausgabe in Englisch viel günstiger als in anderen Sprachen: Die Kosten für vereinfachtes Chinesisch sind etwa doppelt so hoch wie für Englisch, die Kosten für Spanisch sind 1,5-mal so hoch wie für Englisch und die Kosten für Burmesisch Shan sind 15-mal so hoch wie für Englisch .

Das Prinzip lässt sich auf einen Artikel zurückführen, der im Mai dieses Jahres von der Universität Oxford auf arXiv veröffentlicht wurde.

Lexikalisch ist der Prozess der Konvertierung von Text in natürlicher Sprache in eine Folge von Token. Dies ist der erste Schritt bei der Textverarbeitung im Sprachmodell. Bei der Berechnung der LLM-Rechenleistungskosten gilt: Je mehr Token vorhanden sind, desto höher sind die Kosten für die Rechenleistung.

Zweifellos werden im Zuge der Kommerzialisierung der generativen KI auch die Kosten für die Rechenleistung auf die Nutzer abgewälzt. Viele aktuelle KI-Dienste werden nach der Anzahl der zu verarbeitenden Wörter abgerechnet.

Die Arbeit zeigt, dass die Forscher nach der Analyse von 17 Lemmatisierungsmethoden herausgefunden haben, dass die Länge desselben Textes in Lemmasequenzen in verschiedenen Sprachen umgewandelt wird. Die Länge ist völlig fair.

Wenn Sie beispielsweise laut dem GPT3-Tokenizer von OpenAI „Ihre Liebe“ tokenisieren, sind auf Englisch nur zwei Token erforderlich, während auf vereinfachtem Chinesisch acht Token erforderlich sind. Obwohl vereinfachter chinesischer Text nur 4 Zeichen und englischer Text 14 Zeichen hat.

Aus den vom selbe Bedeutung. Das bedeutet, dass die Verarbeitung von Burmesisch 11-mal teurer sein wird als die von Englisch.

Es gibt viele ähnliche Situationen. Die Website von Aleksandar Petrov bietet viele verwandte Symbole und Daten. Interessierte Freunde möchten möglicherweise auf „https://aleksandarpetrov.github.io/tokenization-fairness/“ klicken, um die Unterschiede zwischen den Sprachen anzuzeigen.

Es gibt auch eine ähnliche Seite auf der offiziellen Website von OpenAI, auf der erklärt wird, wie die API einen Textabschnitt lemmatisiert und die Gesamtzahl der Token im Text anzeigt. Auf der offiziellen Website wird außerdem erwähnt, dass ein Lemma normalerweise etwa 4 Zeichen in einem englischen Text entspricht und 100 Lemmata etwa 75 Wörtern entsprechen.

Dank der kurzen Länge der englischen lexikalischen Sequenzen ist Englisch der größte Gewinner in der Kosteneffizienz des Vortrainings für generative künstliche Intelligenz und lässt andere Sprachbenutzer weit zurück, was indirekt zu einer unfairen Situation führt.

Dieser Unterschied in der Länge der Token-Sequenz kann unter anderem zu einer unfairen Verarbeitungslatenz (einige Sprachen benötigen mehr Zeit, um denselben Inhalt zu verarbeiten) und einer unfairen Modellierung langer Sequenzabhängigkeiten (einige Sprachen können nur kürzeren Text verarbeiten) führen.

Vereinfacht ausgedrückt müssen Benutzer bestimmter Sprachen höhere Kosten zahlen, größere Verzögerungen erleiden und eine schlechtere Leistung erzielen, wodurch ihr fairer Zugang zu Möglichkeiten der Sprachtechnologie eingeschränkt wird, was indirekt dazu führt, dass englischsprachige Benutzer und KI-Kluftformen zwischen ihnen entstehen den übrigen Sprachgebrauch der Welt.

Allein aufgrund der Produktionskosten sind die Kosten für vereinfachtes Chinesisch doppelt so hoch wie für Englisch. Mit der tiefgreifenden Entwicklung des KI-Bereichs ist vereinfachtes Chinesisch, das immer „einen Schritt entfernt“ ist, offensichtlich nicht freundlich. Unter dem Einfluss überlagernder Faktoren wie Kosten versuchen auch nicht englischsprachige Länder, ihre eigenen Muttersprachenmodelle zu entwickeln.

Am Beispiel Chinas hat Baidu als einer der ersten inländischen Giganten, der KI erforschte, am 20. März 2023 offiziell die generative KI Wenxin Yiyan eingeführt.

Anschließend entstanden nacheinander Chargen hervorragender Großmodelle, wie das Großmodell Tongyi Qianwen von Alibaba und das Großmodell Pangu von Huawei.

Unter ihnen ist das NLP-Großmodell im Pangu-Großmodell von Huawei das erste chinesische Großmodell der Branche mit 100 Milliarden Parametern, das über 110 Milliarden dichte Parameter verfügt und mit 40 TB massiven Daten trainiert wird.

Wie die stellvertretende Generalsekretärin der Vereinten Nationen, Amina Mohamed, einst auf der UN-Generalversammlung warnte, werde die digitale Kluft „zum neuen Gesicht der Ungleichheit“ werden, wenn die internationale Gemeinschaft nicht entschlossen handle.

Ebenso dürfte die KI-Lücke mit der rasanten Entwicklung der generativen KI zu einer neuen Runde „neuer Gesichter der Ungleichheit“ werden, die Aufmerksamkeit verdient.

Glücklicherweise haben die heimischen Technologieriesen, die normalerweise „ekelhaft“ sind, bereits Maßnahmen ergriffen.

#Willkommen, dem offiziellen öffentlichen WeChat-Konto von Aifaner zu folgen: Aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so schnell wie möglich präsentiert.

Ai Faner | Ursprünglicher Link · Kommentare anzeigen · Sina Weibo