Gerade wurde das stärkste Inferenzmodell o3 von OpenAI veröffentlicht! Zum ersten Mal kann ich mit Bildern denken, Ultraman: Genius Level Mit tatsächlichen Messdetails

„o3 erreicht oder nähert sich dem Niveau des Genies.“

Gerade wurde das OpenAI o3/o4 Mini-Modell endlich offiziell eingeführt. Die Live-Übertragung dauerte fast 30 Minuten, war schnell und voller Informationen.

Der Veröffentlichungsprozess von o3 selbst ist ebenfalls sehr umkehrend. Im Februar dieses Jahres kündigte OpenAI an, den unabhängigen Release-Plan von o3 auf Eis zu legen und die Technologie in GPT-5 zu packen und zu stopfen. Anfang April gab Altman, der sich gut mit „Hungermarketing“ auskennt, bekannt, dass sich sein Plan geändert habe:

o3 muss zuerst veröffentlicht werden, aber GPT-5 muss warten, vielleicht frühestens ein paar Monate.

Um die wichtigsten Punkte hervorzuheben, sind die Highlights von OpenAI o3/o4 mini wie folgt:

- o Das bisher intelligenteste Modell der Serie, dessen Denkfähigkeit erheblich verbessert wurde. Je länger man darüber nachdenkt, desto besser ist die Wirkung.

- Erstmals werden Bilder direkt in die Denkkette integriert, mit Bildern „gedacht“ und Werkzeuge können direkt aufgerufen werden, um Bilder zu verarbeiten.

- Zum ersten Mal werden Websuche, Dateianalyse, Python-Codeausführung, Deep Reasoning für visuelle Eingaben und Bildgenerierung vollständig unterstützt.

- O3 ist der Vorgängergeneration kosteneffektiv überlegen und bietet eine höhere Leistung bei gleicher Latenz und gleichen Kosten.

Als Ersatz für Modelle wie o1 in der Modellauswahl stehen ab heute ChatGPT Plus-, Pro- und Team-Benutzern o3, o4-mini und o4-mini-high zur Verfügung. Unternehmens- und Bildungsbenutzer erhalten in einer Woche Zugriff. o3-pro wird voraussichtlich in einigen Wochen erscheinen.

Free-Nutzer können o4-mini im „Think“-Modus nutzen, die Ratenbegrenzung bleibt unverändert.

Entwickler greifen darauf über die Chat Completions API und Responses API zu, die die Zusammenfassung von Inferenzen und die Optimierung von Funktionsaufrufen unterstützen. Es wird bald integrierte Tools wie die Websuche unterstützen.

OpenAIs stärkstes Inferenzmodell o3 wird veröffentlicht. Kann GPT-5 weit zurückliegen?

Die neu erschienenen Modelle o3 und o4-mini sind die bislang intelligentesten Modelle der o-Serie.

Diese beiden Modelle weisen eine gute Leistung in Bezug auf Argumentationsfähigkeiten, Werkzeugnutzung und multimodale Verarbeitung auf und ermöglichen es ihnen, über längere Zeiträume über komplexe Probleme nachzudenken. Zum ersten Mal unterstützen sie vollständig die Websuche, die Dateianalyse, die Ausführung von Python-Code, das Deep Reasoning visueller Eingaben und die Bildgenerierung.

Von erfahrenen Forschern bis hin zu normalen Benutzern ist das neue Modell auf ein breiteres Spektrum von Szenarien anwendbar.

OpenAI o3 und o4-mini können Tools in ChatGPT aufrufen und über Funktionsaufrufe in der API auf benutzerdefinierte Tools zugreifen.

OpenAI veröffentlicht o3 und o4-mini und sagt, dass o3 „neuartige Hypothesen generieren“ kann | Beebom

Durch Reinforcement Learning trainierte OpenAI auch beide Modelle in der Verwendung des Tools – sie wussten nicht nur, wie und wann sie es verwenden sollten, sondern waren auch in der Lage, schnell zuverlässige Antworten im richtigen Format zu generieren, oft in weniger als einer Minute.

Wenn ich beispielsweise gefragt werde, wie der Energieverbrauch in Kalifornien im Sommer im Vergleich zum letzten Jahr ausfällt, kann ich die öffentlichen Energieverbrauchsdaten online überprüfen, Python-Code zur Vorhersage schreiben, Diagramme oder Bilder erstellen, die Grundlage für die Vorhersage erläutern und mehrere Tools fließend verbinden.

Der gesamte Prozess der Inferenzsuche ist außerdem flexibler: Das Modell kann die Suchmaschine mehrmals aufrufen, um die Ergebnisse gegenseitig zu validieren. Wenn das eigene Wissen nicht ausreicht, kann es Informationen weiter auswerten und typübergreifende Ergebnisse integrieren.

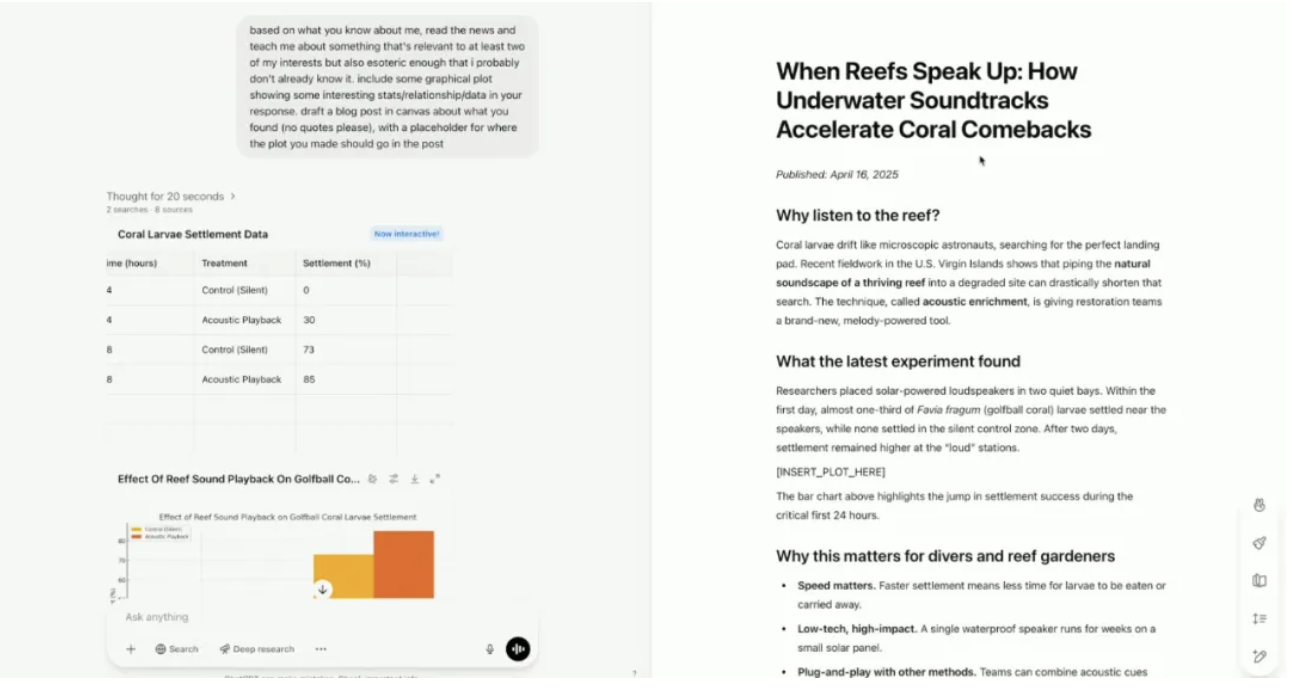

Während der Live-Übertragung heute früh hatte auch OpenAI-Präsident Greg Brockman einen seltenen Auftritt. OpenAI-Referenten zeigten, wie neue Modelle Benutzerinteressen kombinieren können, um Inhalte zu entdecken, die Benutzer möglicherweise interessieren, aber noch nicht kennen.

Bei aktivierter „Memory“-Funktion kann das neue Modell die Interessen und Hobbys des Demonstranten – Fallschirmspringen und Musik – kennenlernen.

Anstatt die beiden Hobbys einfach getrennt zu diskutieren, hat das neue Modell einen Forschungsbereich gefunden, der beide verbindet: Wissenschaftler zeichnen die Geräusche gesunder Korallenriffe auf und geben diese Aufnahmen dann über Unterwasserlautsprecher wieder. Diese Klangwiedergabe beschleunigt die Besiedlung neuer Korallen und Fische und hilft den Riffen, schneller zu heilen und zu regenerieren.

Während des Inhaltserstellungsprozesses erstellte das Modell auch automatisch einen vollständigen Blog-Beitrag, indem es zunächst Datenanalysetools zur Generierung von Visualisierungen und Canvas zum Erstellen des Blog-Beitrags mit angehängten Zitaten und Quellen verwendete.

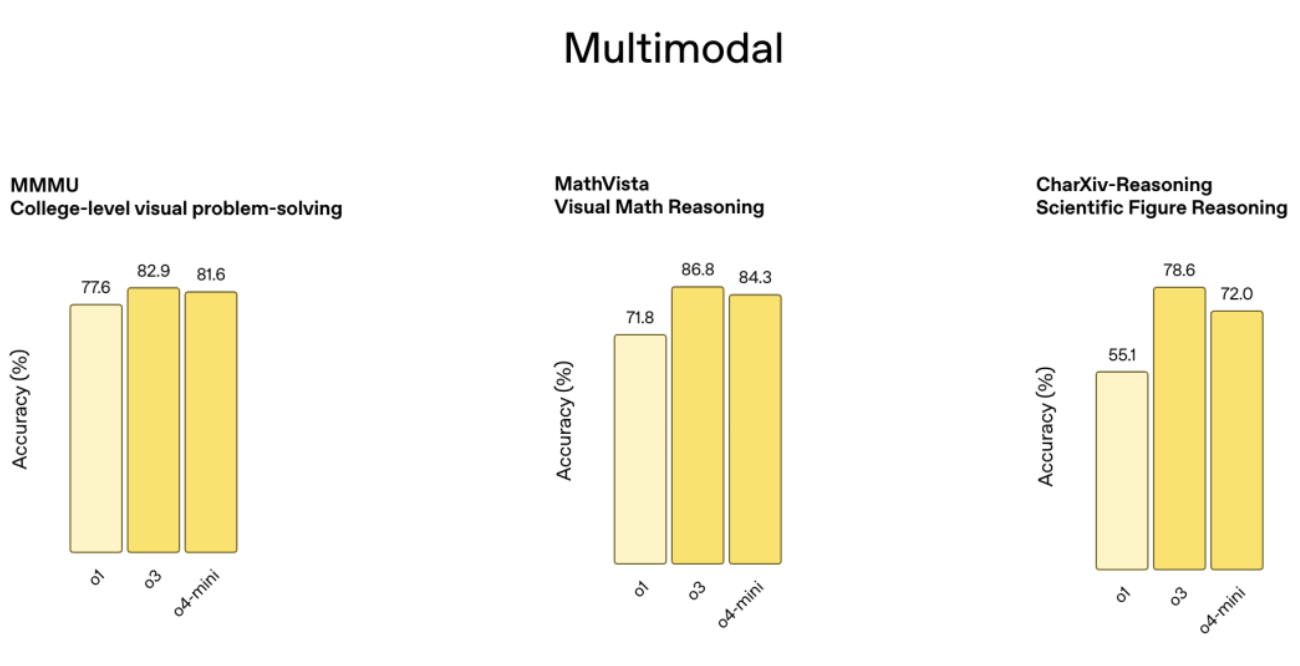

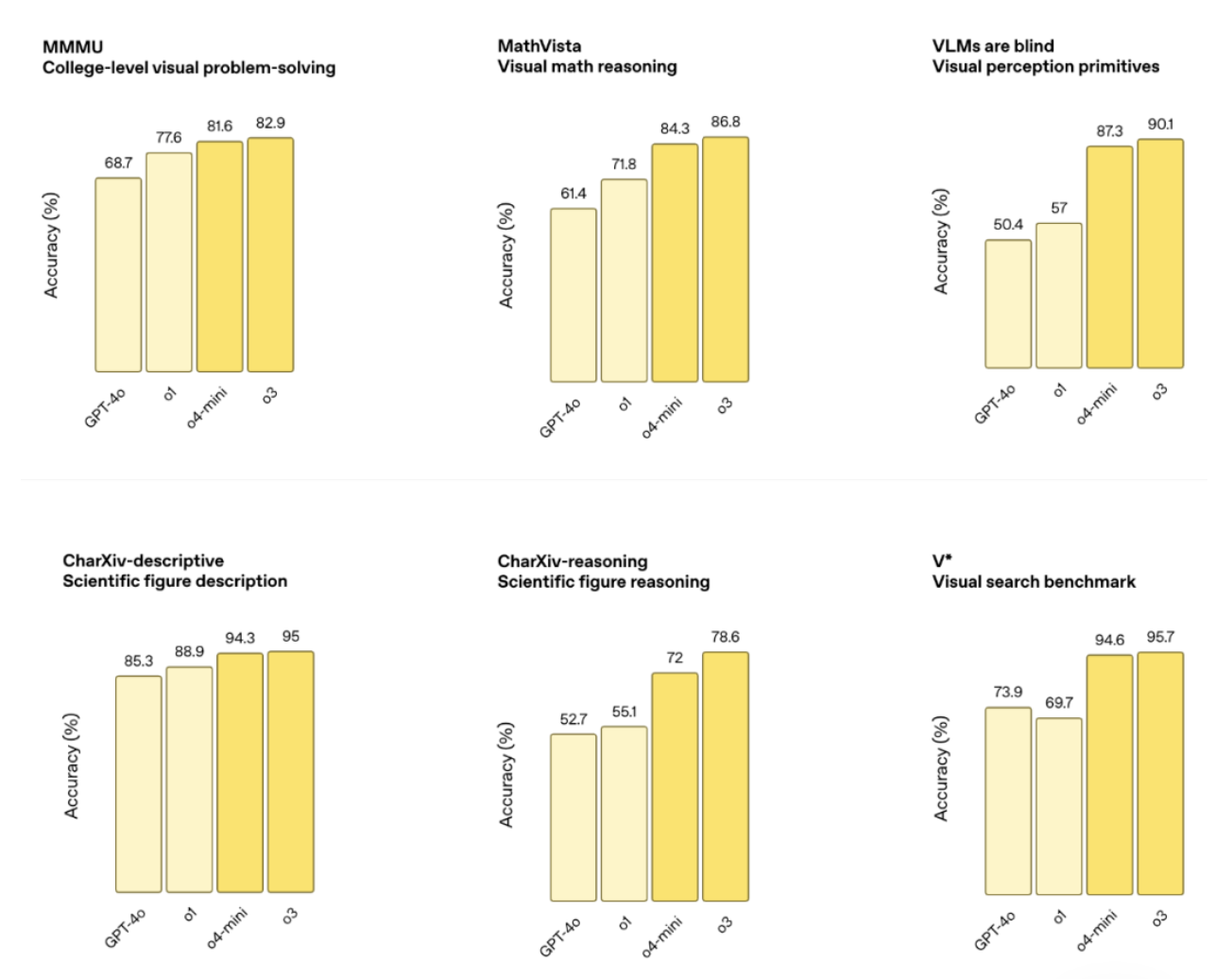

Als neuestes Flaggschiff-Inferenzmodell hat o3 neue Rekorde in den Bereichen Programmierung, Mathematik, Naturwissenschaften und visuelle Wahrnehmung aufgestellt, wie z. B. Codeforces, SWE-Bench und MMMU-Benchmarks, mit einer visuellen Aufgabengenauigkeit von 87,5 % und MathVista 75,4 %.

Eine externe Expertenbewertung zeigt, dass o3 auch in den Bereichen Programmierung, Unternehmensberatung und kreative Ideenfindung eine um 20 % geringere kritische Fehlerquote aufweist als o1. Es kann neuartige Hypothesen in den Bereichen Biologie, Mathematik und Ingenieurwissenschaften generieren und kritisch bewerten und eignet sich für komplexe Fragestellungen.

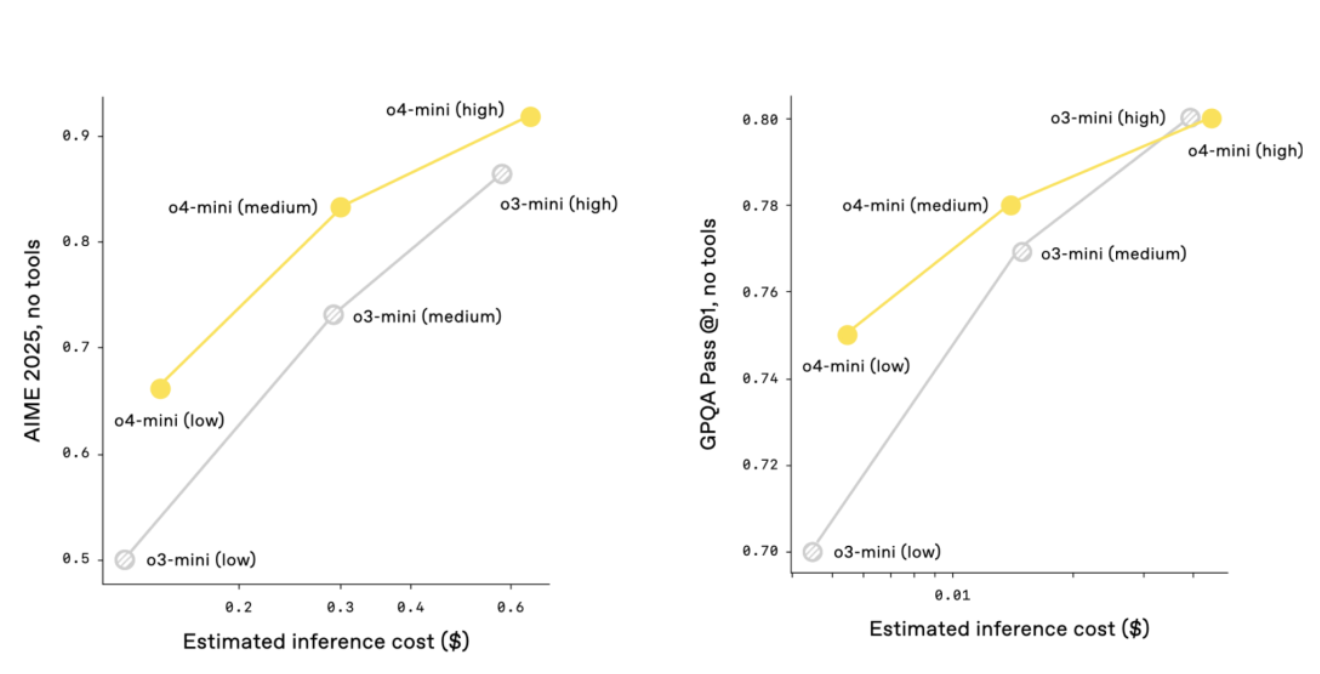

o4-mini ist „kleiner“ und für schnelles und kostengünstiges Denken optimiert. Die Genauigkeit in den Mathematiktests AIME 2024 und 2025 beträgt 92,7 % bzw. 93,4 %. Es ist besser als o3-mini bei nicht-STEM- und datenwissenschaftlichen Aufgaben. Es ist hocheffizient, kann mehr Anfragen bearbeiten und eignet sich besser für Szenarien, die eine schnelle Reaktion erfordern.

Der Leistungsvergleich zeigt, dass o3 und o4-mini die Vorgängergeneration in Tests wie AIME, Codeforces, GPQA und MMMU deutlich übertreffen und auch die Befehlsfolge und Antwortqualität deutlich verbessert werden. In Kombination mit der Erinnerungsfunktion und historischen Dialogreferenzen sind die Antworten personalisierter und relevanter.

Während des gesamten Entwicklungsprozesses von OpenAI o3 beobachtete OpenAI, dass verstärktes Lernen in großem Maßstab den gleichen Trend zeigte: „Je größer der Rechenaufwand, desto besser die Leistung“ wie beim Vortraining der GPT-Serie.

Auf diesem Weg (Reinforcement Learning) hat OpenAI die Trainingsberechnungen und die Inferenzzeit um eine Größenordnung gesteigert, konnte aber dennoch erhebliche Leistungsverbesserungen verzeichnen. Bei der gleichen Verzögerung und den gleichen Kosten wie o1 bietet o3 eine bessere Leistung und gibt ihm mehr Zeit zum Nachdenken, und die Wirkung kann besser sein.

OpenAI, das das Zeichnen von Bildern nicht vergisst, sagte auch, dass o3 und o4-mini den Integrationstrend der Argumentationsfunktionen der O-Serie und des natürlichen Dialogs und der Werkzeugnutzung der GPT-Serie demonstriert haben und dass das zukünftige Modell (GPT-5) diese Vorteile voraussichtlich weiter integrieren wird, um Benutzern ein intelligenteres und praktischeres Erlebnis zu bieten.

Ich kann mithilfe von Bildern „denken“, aber manchmal „denke ich zu viel“

OpenAI o3 und o4-mini sind auch die neuesten Modelle für visuelles Denken in der o-Serie.

Wie ist das visuelle Argumentationsmodell zu verstehen? Der offiziellen Einführung zufolge integriert das Modell Bilder erstmals direkt in die Denkkette und eröffnet so eine neue Problemlösungsmethode, die visuelles und textliches Denken integriert.

Mit Tools wie Python-Datenanalyse, Websuche und Bildgenerierung können auch komplexere Aufgaben bewältigt werden.

Laden Sie Whiteboard-Fotos, Lehrbuchdiagramme oder handgezeichnete Skizzen hoch. Selbst wenn das Bild verschwommen, invertiert oder von schlechter Qualität ist, kann das Modell es genau interpretieren und direkt Werkzeuge zur Verarbeitung des Bildes aufrufen, einschließlich Zuschneiden, Drehen, Skalieren und anderer Vorgänge.

Wichtig ist, dass diese Funktionen nativ sind und kein separates dediziertes Modell erfordern.

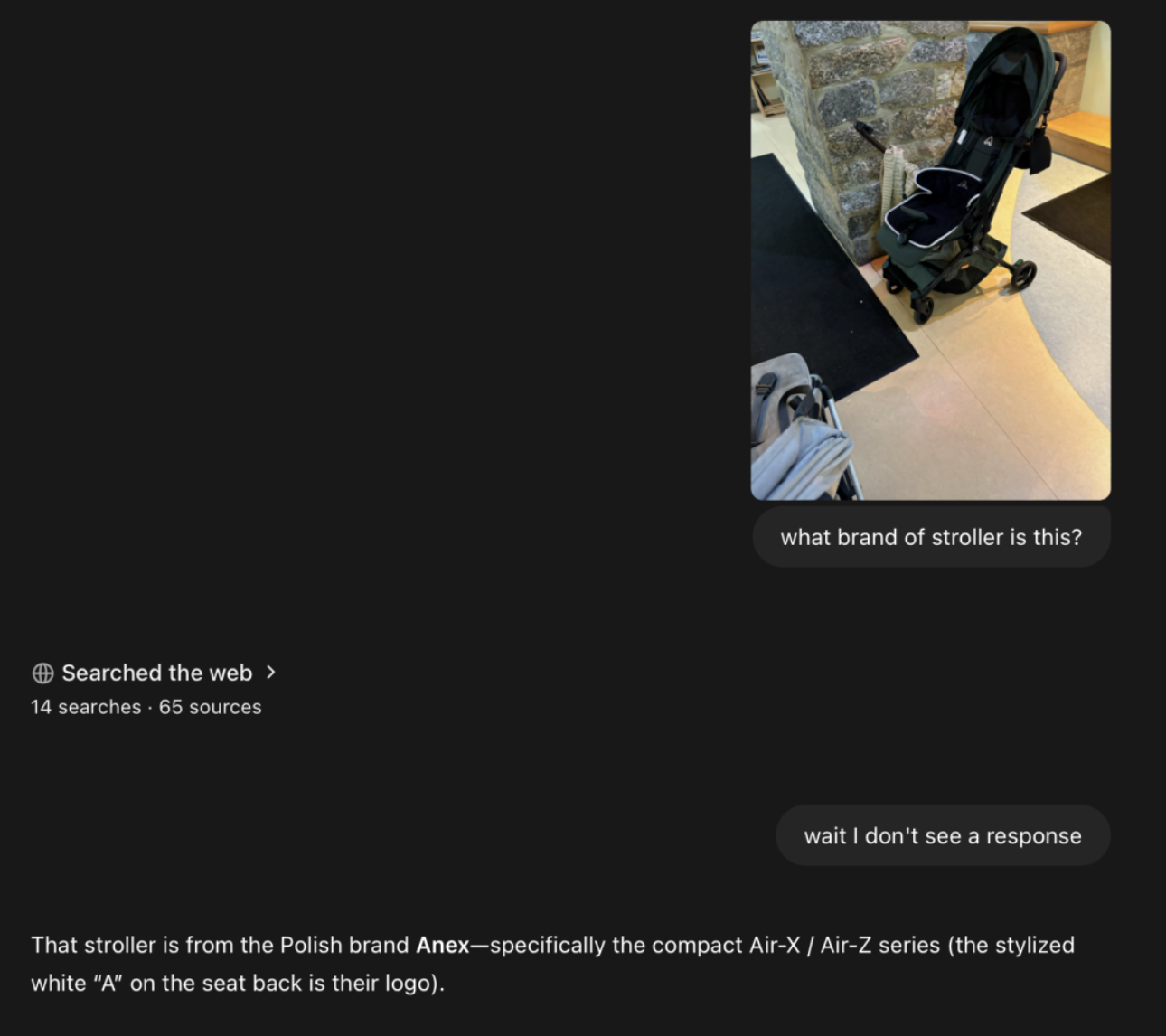

Blogger @danshipper fand eine Kinderwagenmarke über ein verschwommenes Foto und wie es aussieht, wurden im Laufe des Prozesses Dutzende Webseiten durchsucht.

Ich habe auch ein Bild des Wukang-Gebäudes hochgeladen und o3 hat genau identifiziert, dass sich das Gebäude in der Nähe der Huaihai Road befindet. Der Name des Gebäudes wurde in der Antwort jedoch nicht genannt.

Natürlich ist diese Denkweise nicht ohne „Fehler“:

- Zu viel nachdenken: Das Modell verlässt sich möglicherweise zu sehr auf Werkzeuge oder Bildverarbeitung, was zu langen Argumentationsketten führt.

- Fehleinschätzungen: Auch bei richtiger Anwendung der Tools können visuelle Missverständnisse zu falschen Antworten führen.

- Instabil: Wenn Sie dasselbe Problem mehrmals versuchen, verwendet das Modell möglicherweise unterschiedliche Argumentationspfade und einige Ergebnisse sind möglicherweise falsch.

Codex CLI ist kostenlos und Open Source. Ist OpenAI wirklich offen?

o3 und o4-mini sind der Vorgängergeneration in puncto Kosteneffizienz überlegen. Im AIME-Test 2025 hat das Preis-/Leistungsverhältnis o1 und o3-mini komplett übertroffen. Sie sind intelligenter und kostengünstiger.

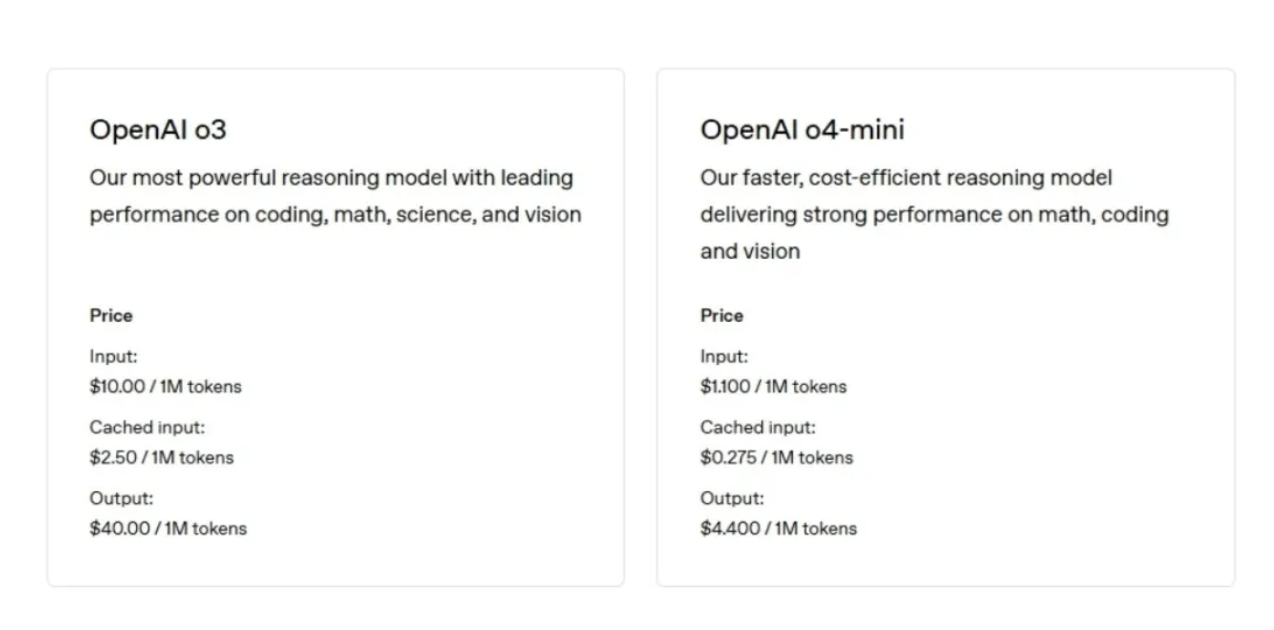

o3 kostet 10 US-Dollar pro Million Token für die Eingabe (ungefähr 750.000 Wörter, länger als die Herr der Ringe-Serie) und 40 US-Dollar pro Million Token für die Ausgabe.

o4-mini kostet 1,10 $ pro Million Token für die Eingabe und 4,40 $ pro Million Token für die Ausgabe.

Vor nicht allzu langer Zeit wurde bekannt, dass die Sicherheitstestzeit von OpenAI von Monaten auf Tage verkürzt wurde. Die Systemkarten von o3 und o4-mini zeigen, dass OpenAI den Sicherheitstrainingsdatensatz rekonstruiert und Ablehnungsaufforderungen für biologische Bedrohungen, Malware-Generierung und Jailbreak-Angriffe hinzugefügt hat.

Laut dem neuesten Readiness Framework liegen die Risiken für o3 und o4-mini in den Bereichen Biologie und Chemie, Cybersicherheit und KI-Selbstverbesserung unter der „hohen“ Schwelle.

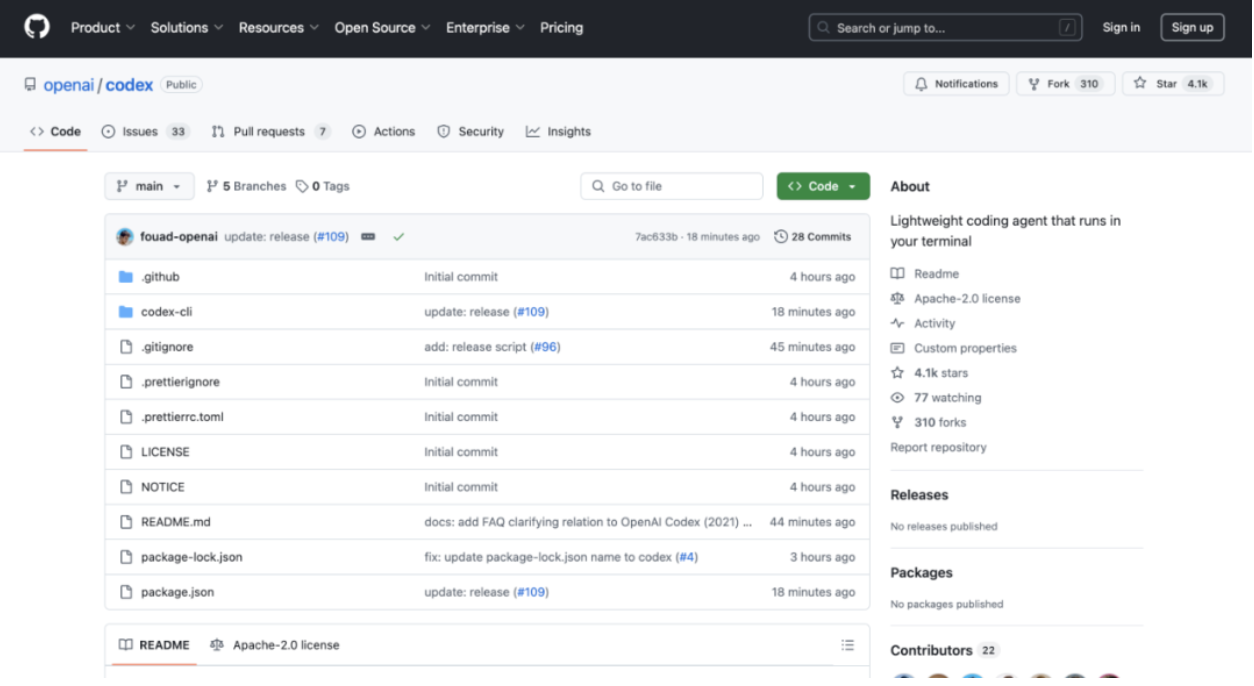

▲Das Bild ist mit der Codex CLI GitHub-Adresse angehängt: https://github.com/openai/codex

Obwohl Agent zu spät kommt, ist es angekommen. OpenAI hat außerdem einen leichtgewichtigen Terminal-Coding-Agenten auf den Markt gebracht – Codex CLI.

Basierend auf den Argumentationsfunktionen von o3 und o4-mini unterstützt Codex CLI multimodale Eingaben und wurde auf GitHub als Open Source bereitgestellt. Darüber hinaus hat OpenAI einen 1-Millionen-US-Dollar-Plan zur Unterstützung verwandter Projekte gestartet und akzeptiert Finanzierungsanträge für API-Punkte im Wert von 25.000 US-Dollar.

OpenAI ist dieses Mal wirklich offen.

Berichten zufolge verfügt Codex über zwei Betriebsmodi: Der eine ist der „Empfehlungsmodus“ (Standard): Befehle werden zur Bestätigung durch den Benutzer vorgeschlagen, der andere ist der „vollautomatische Modus“: Der Netzwerkzugriff ist deaktiviert, sodass der Agent autonom arbeiten kann, aber sicher bleibt.

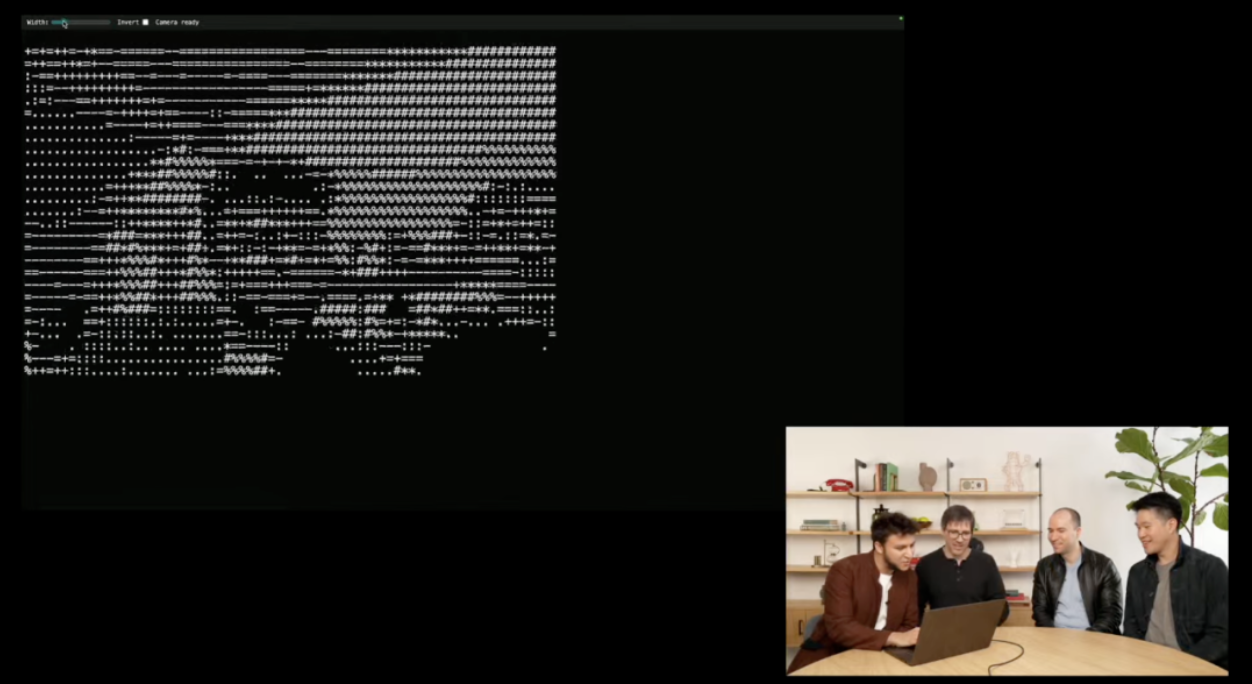

Während der Live-Demonstration zogen OpenAI-Forscher Screenshots in das Terminal, und die Codex-CLI analysierte die Bilder durch multimodales Denken, greift auf Benutzerdateien zu und generierte schließlich HTML-Dateien, erstellte einen ASCII-Grafikgenerator und fügte erfolgreich eine Webcam-API hinzu.

Erwähnenswert ist, dass OpenAI laut Bloomberg plant, das KI-Programmiertool-Unternehmen Windsurf für etwa 3 Milliarden US-Dollar zu übernehmen. Sollte die Übernahme erfolgreich sein, wird dies die bisher größte Übernahme von OpenAI sein.

In dem Bericht wurde darauf hingewiesen, dass OpenAI nach Abschluss der Transaktion in der Lage sein wird, direkter mit Unternehmen wie Anthropic, dem Microsoft-eigenen Github und Anysphere zu konkurrieren und so einen Platz im schnell wachsenden Markt für KI-Programmiertools einnimmt.

„Genie-Level“ o3 brachte Altman dazu, weiterzuleiten und zu unterstützen, aber diese Fragen wurden nicht richtig beantwortet …

Einige Blogger der X-Plattform waren qualifiziert, das neue Modell vorab kennenzulernen und teilten ihre Erfahrungen.

@danshipper, der es eine Woche lang erlebt hat, sagte, dass o3 schnell, sehr „umsetzbar“, extrem intelligent und das Gesamtgefühl großartig sei. Zu den bevorzugten Verwendungszwecken gehören:

- Entwickelte einen prägnanten Kurs für maschinelles Lernen und erinnerte Blogger daran, jeden Morgen zu lernen

- Durch ein verschwommenes Foto eine Kinderwagenmarke gefunden

- Habe ein neues KI-Benchmark-Programm mit superschneller Geschwindigkeit geschrieben

- Analysierte ein klassisches Werk von Annie Dillard wie eine Röntgenaufnahme und förderte Schreibfähigkeiten zutage, die Bloggern noch nie zuvor aufgefallen waren

- Sehen Sie sich Besprechungsprotokolle an, um Blogger zu erwischen, die versuchen, Konflikte zu vermeiden

- Welche Art von Produkten werden nach der Analyse der Organisationsstruktur zur Einführung empfohlen und wo liegen die Mängel?

@DeryaTR_, MD, findet o3 klug: „Wenn ich o3 eine anspruchsvolle klinische oder medizinische Frage stelle, klingen die Antworten, als kämen sie von einem Spitzenarzt: präzise, umfassend, evidenzbasiert und selbstbewusst, mit der höchsten Professionalität, die wir von Experten auf diesem Gebiet erwarten.“

Altman leitete auch ein Zitat von ihm weiter, in dem es hieß: „o3 ist auf oder nahe dem Genie-Niveau.“

Nach Meinung von @DeryaTR_ ist o4 mini etwas „zurückhaltender“ und die Details der Antworten sind nicht so detailliert wie bei o3. Es kann prägnanter und glatter sein, den Menschen ein elegantes Gefühl vermitteln und sogar „emotionaler“ sein.

Natürlich haben wir auch einige Probleme getestet.

Es war einmal ein alter Uhrmacher, der eine große Glocke für eine Kirche einbaute. Er war alt und geblendet, und er setzte die langen und kurzen Nadeln falsch zusammen. Die kurze Nadel bewegte sich zwölfmal so schnell wie die lange Nadel. Während der Versammlung war es 6 Uhr morgens. Er zeigte mit der kurzen Hand auf „6“ und mit der langen Hand auf „12“. Der alte Uhrmacher installierte es und ging nach Hause. Die Leute schauten eine Weile auf die Uhr und es war 7 Uhr, und dann war es 8 Uhr. Sie waren sehr überrascht und gingen sofort zum alten Uhrmacher. Als der alte Uhrmacher eintraf, war es bereits nach 19 Uhr. Er holte ein Paar Taschenuhren heraus und die Uhren gingen genau. Er vermutete, dass ihm jemand einen Streich spielte und ging zurück, als er wütend war. Die Uhr läuft immer noch auf 8 Uhr und 9 Uhr, und die Leute gehen wieder zum Uhrmacher. Der alte Uhrmacher kam am nächsten Morgen um 8 Uhr vorbei, um ein Paar Uhren zu verwenden, die noch genau waren. Denken Sie mal darüber nach: Wie spät war es 7 Uhr, als der alte Uhrmacher seine Uhr zum ersten Mal justierte? Wie spät ist es wieder 8:00 Uhr, wenn ich zum zweiten Mal auf die Uhr schaue?

▲o3 Falsche Antwort

Der U2-Chor muss in 17 Minuten zum Konzertort gelangen und dabei eine Brücke überqueren. Vier Personen beginnen am selben Ende der Brücke und Sie müssen ihnen helfen, das andere Ende zu erreichen. Es ist dunkel und sie haben nur eine Taschenlampe. Es können höchstens zwei Personen gleichzeitig die Brücke überqueren, und beim Überqueren der Brücke müssen sie eine Taschenlampe dabei haben, sodass jemand eine Taschenlampe zu beiden Enden der Brücke und von dort mitbringen muss. Taschenlampen können nicht durch Wegwerfen herumgereicht werden. Vier Personen gehen mit unterschiedlichen Geschwindigkeiten. Wenn zwei Menschen zusammen gehen, hat der langsamere die Oberhand. Bono braucht 1 Minute, um die Brücke zu überqueren, Edge braucht 2 Minuten, um die Brücke zu überqueren, Adam braucht 5 Minuten, um die Brücke zu überqueren, und Larry braucht 10 Minuten, um die Brücke zu überqueren. Wie sollen sie in 17 Minuten die Brücke überqueren?

▲o4 mini hat richtig geantwortet

In der folgenden tatsächlichen Messung gab o3 zwar vollständige Argumentationsschritte an, die Antwort war jedoch erneut falsch.

▲o3 Falsche Antwort

Anlässlich des Starts von OpenAI entdeckten aufmerksame Internetnutzer auch, dass der neue Gemini nächste Woche (22. April) veröffentlicht wird.

DeepSeek R2, Claude 4 von Anthropic und „GroK-3.5“ von Musk werden voraussichtlich ebenfalls in diesem Monat veröffentlicht.

Auch mit Blick auf die Zukunft ist der April der „involvierteste“ Monat für KI, der maßgeblich die Entwicklungsrichtung der KI-Branche im nächsten Jahr bestimmen wird. Stärkere Modelle, niedrigere Kosten und umfassendere Szenarien werden uns auch eine intelligentere und integrativere Zukunft bescheren.

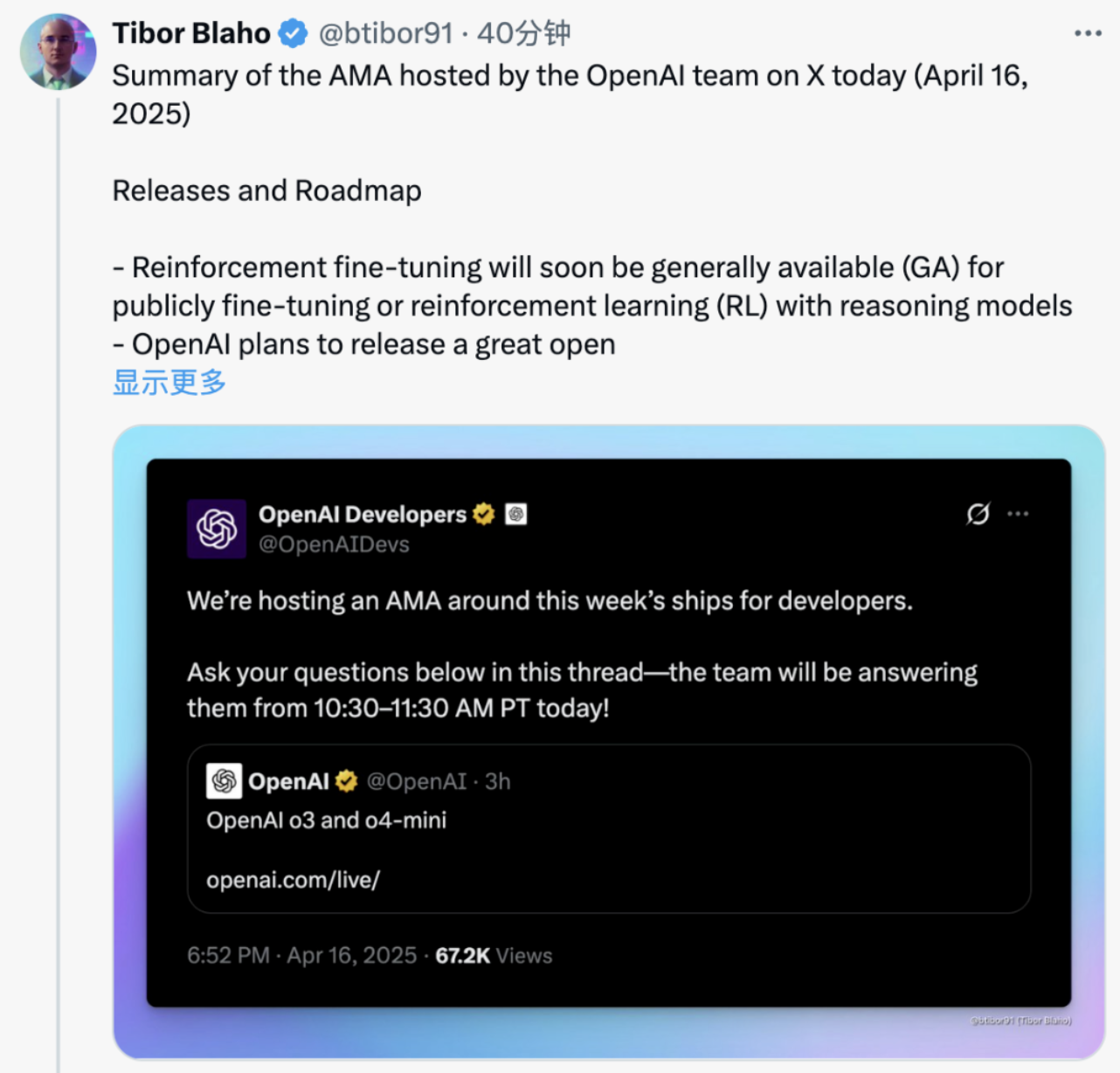

Im Anhang finden Sie die Zusammenfassung des AMA, das das OpenAI-Team auf der X-Plattform durchgeführt hat:

- OpenAI plant, in den kommenden Monaten ein großartiges offenes Modell zu veröffentlichen, und in Kürze werden neue Funktionen zur Bildgenerierung in der API verfügbar sein.

- o3 ist jetzt in der API verfügbar, während ein fortschrittlicheres o3-pro-Modell in der Entwicklung ist und voraussichtlich bald veröffentlicht wird.

- Die Feinabstimmung der Verstärkung wird bald allgemein verfügbar sein und eine öffentliche Feinabstimmung oder die Verwendung von Inferenzmodellen für Reinforcement Learning (RL) ermöglichen.

- In der Responses-API wird der Wechsel zwischen Entwicklernachrichten und Systemnachrichten automatisch gehandhabt; Das Senden von Systemnachrichten an o3 oder Entwicklernachrichten an GPT-4.1 wird automatisch konvertiert.

- Derzeit werden Hosting-Tools nicht von der ChatCompletions- oder Responses-API unterstützt

- Während der Inferenzphase von o3 und o4-mini werden Tools wie Websuche, Dateisuche und Code-Interpreter aktiv genutzt; Diese Tools werden derzeit in ChatGPT unterstützt, jedoch noch nicht in der API – die Unterstützung wird voraussichtlich bald hinzugefügt.

- OpenAI entwickelt aktiv die Threading-Unterstützung im Agents SDK, um den Konversationsverlauf und das Gedächtnis zu verbessern.

- OpenAI hält die Low-Code-Plattformvorschläge im Agents SDK für interessant und freut sich über Entwicklerfeedback zu den nützlichsten Funktionen.

- Die Codex-CLI umfasst mehrere dokumentierte Genehmigungsmodi, sodass der Benutzer für jeden Vorgang oder jede Sitzung einen Modus auswählen kann.

- Codex CLI ist nicht dazu gedacht, IDE-Tools wie Cursor und Windsurf zu ersetzen; Es dient dazu, Hintergrundaufgaben auszuführen, während der Benutzer die primäre IDE verwendet.

- Vergleichen Sie die Codierungsfunktionen und detaillierten Recherchefunktionen von Codex je nach gewähltem Modell (o3 oder o4-mini); Codex nutzt gezielt Funktionsaufrufe, um Befehle direkt auf dem Computer des Benutzers auszuführen.

- Das neue Modell ist hauptsächlich auf Allzweckbrowser, Python-/Code-Ausführungstools und benutzerdefinierte Tools trainiert, die für Entwickler nützlich sind.

- Während GPT-4.5 leistungsfähiger, langsamer und rechenintensiver ist, bietet GPT-4.1 Entwicklern eine schnellere und kostengünstigere Option.

- Einige Verbesserungen von GPT-4.1 wurden in ChatGPT integriert und weitere Verbesserungen werden in Zukunft eingeführt.

- OpenAI räumt ein, dass zwischen Modellnamen wie „4o“ und „o4“ Namensverwechslungen bestehen, und plant, die Modellbenennung bald zu vereinfachen.

# Willkommen beim offiziellen öffentlichen WeChat-Konto von aifaner: aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner | Ursprünglicher Link · Kommentare anzeigen · Sina Weibo