Was ist die Stärke des leistungsstärksten KI-Chips der Geschichte, wenn man 10 Milliarden US-Dollar für den Bau ausgibt?

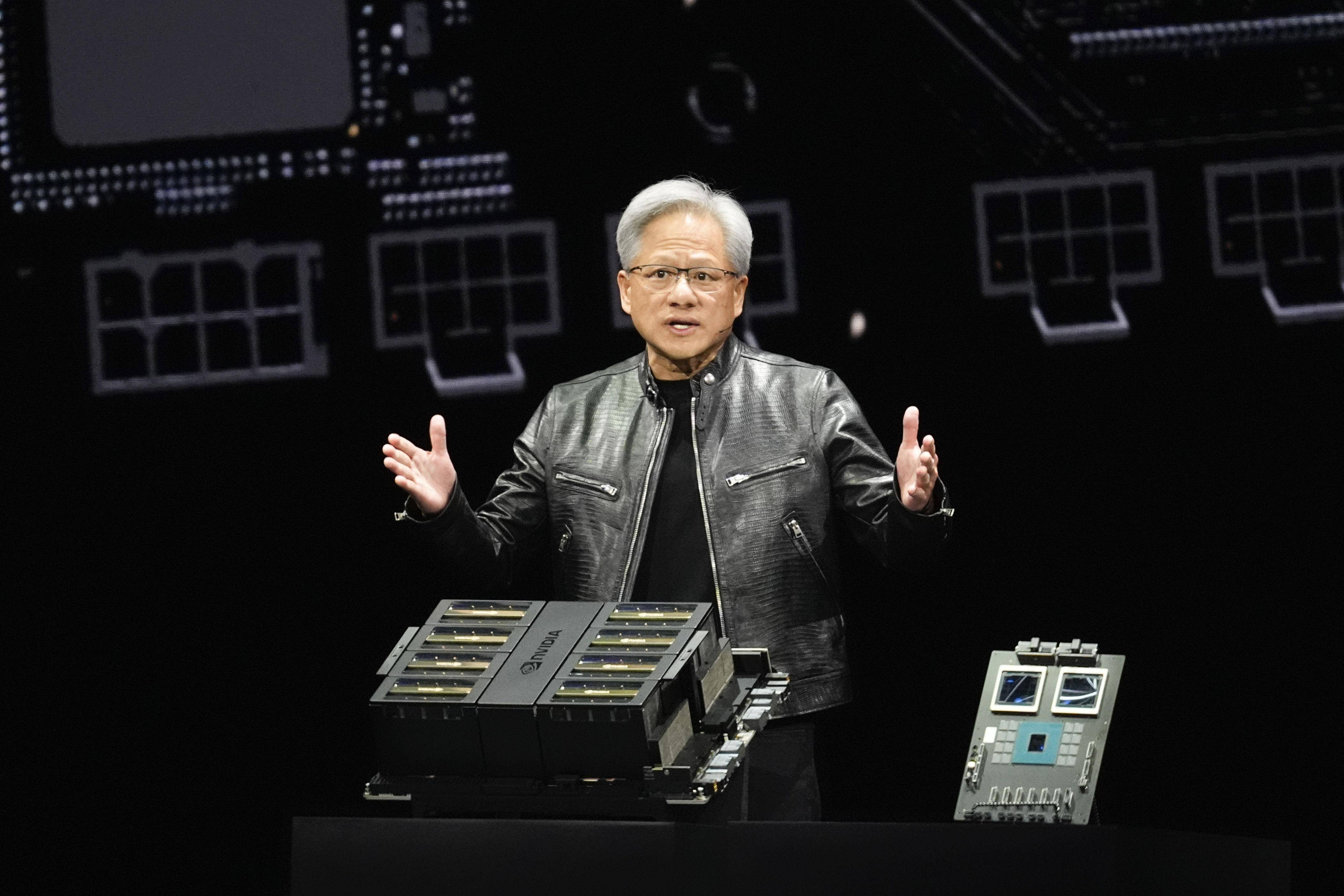

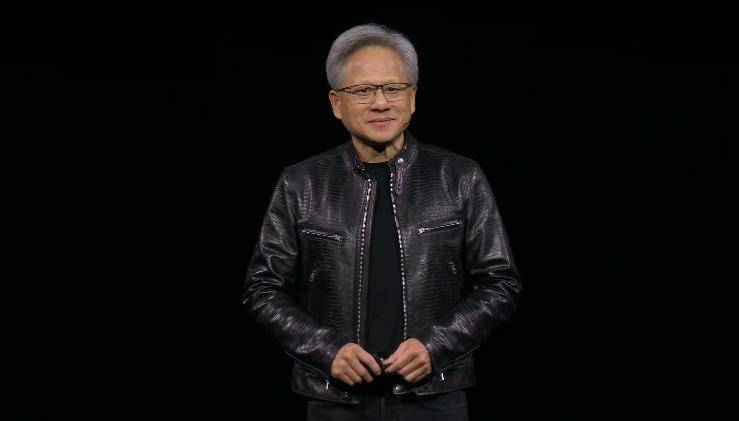

In den vergangenen zwei Tagen haben wir Huang Renxuns Rede auf der GTC 2024 noch einmal Revue passieren lassen. Als wir eine tiefergehende Analyse und Interpretation des Produkts durchführten, entdeckten wir einige Highlights, die wir damals beim langen Aufbleiben übersehen hatten.

Erstens ist Huangs Redestil humorvoll, natürlich und sehr kommunikativ. Kein Wunder, dass er eine Konferenz zur Markteinführung von Technologieprodukten in ein Konzert verwandeln kann.

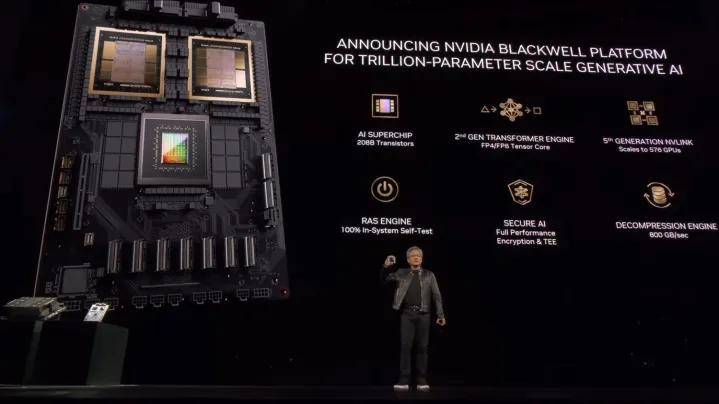

Die zweite besteht darin, die neu veröffentlichte Blackwell-Architektur und die GPU-Serie in Kombination mit früheren Produktgenerationen zu überprüfen. Ich kann nur sagen, dass die Rechenleistung, die Kosten und die zukünftige Leistung meine Vorstellungskraft bei weitem übersteigen.

Genau wie der Name NVIDIA stehen die ersten beiden Buchstaben N und V von NVIDIA für Next Version „nächste Generation“.

Wie GTC in den vergangenen Jahren veröffentlichte Nvidia planmäßig die nächste Produktgeneration mit höherer Leistung und besserer Leistung; aber es ist völlig anders als zuvor, denn Blackwell repräsentiert nicht nur die nächste Produktgeneration, sondern auch die nächste Ära.

Entdecken Sie die leistungsstärkste GPU der Welt neu

Die Selbstvorstellung beginnt normalerweise mit Ihrem Namen, also beginnen wir hier mit dem neuesten und leistungsstärksten KI-Chip.

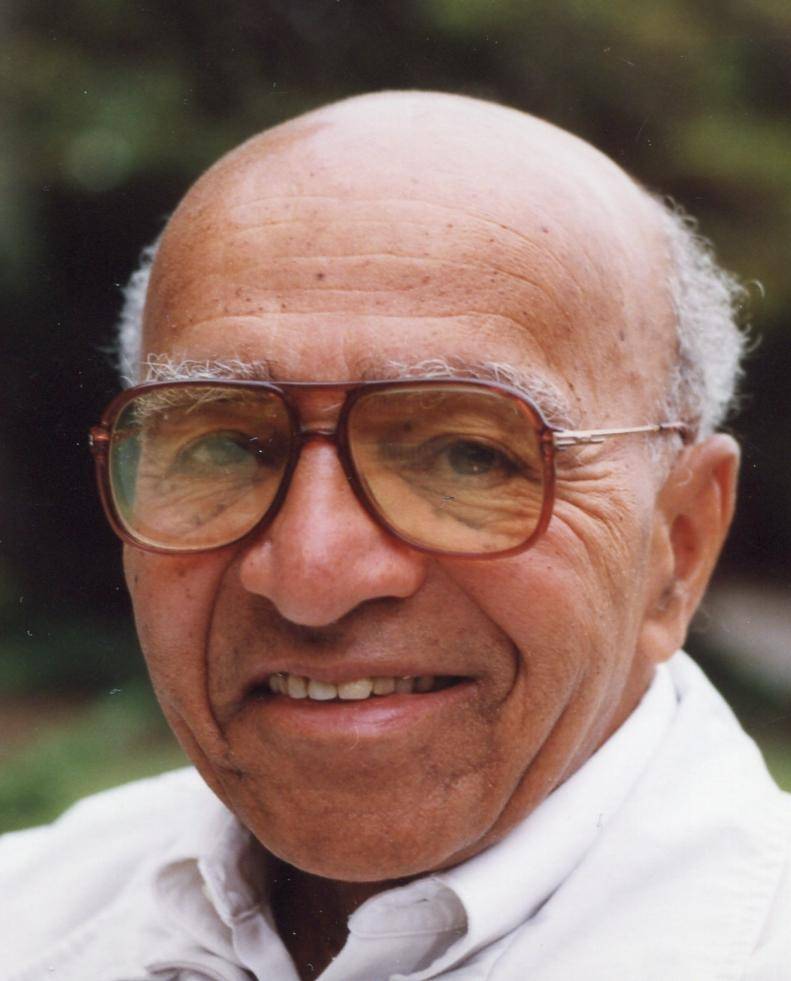

Blackwells vollständiger Name ist David Harold Blackwell. Er ist ein amerikanischer Statistiker und einer der Begründer des Rao-Blackwell-Theorems. Noch wichtiger ist, dass er das erste schwarze Mitglied der National Academy of Sciences und das erste schwarze ordentliche Fakultätsmitglied der University of California in Berkeley war.

Daraus ergibt sich das auf der GTC 2024 veröffentlichte „Blackwell“. Es ist nicht so, dass Blackwell selbst herausragende Beiträge für NVIDIA geleistet hat, sondern dass im Namenssystem von NVIDIA die Namen einiger berühmter Wissenschaftler (oder Mathematiker) der Geschichte verwendet werden. Das hat es Es ist zu einer Konvention geworden, GPU-Mikroarchitekturen nach ihrem Namen zu benennen.

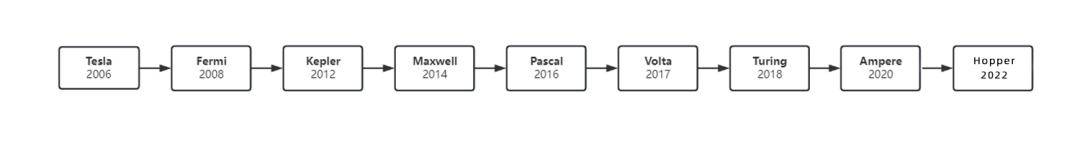

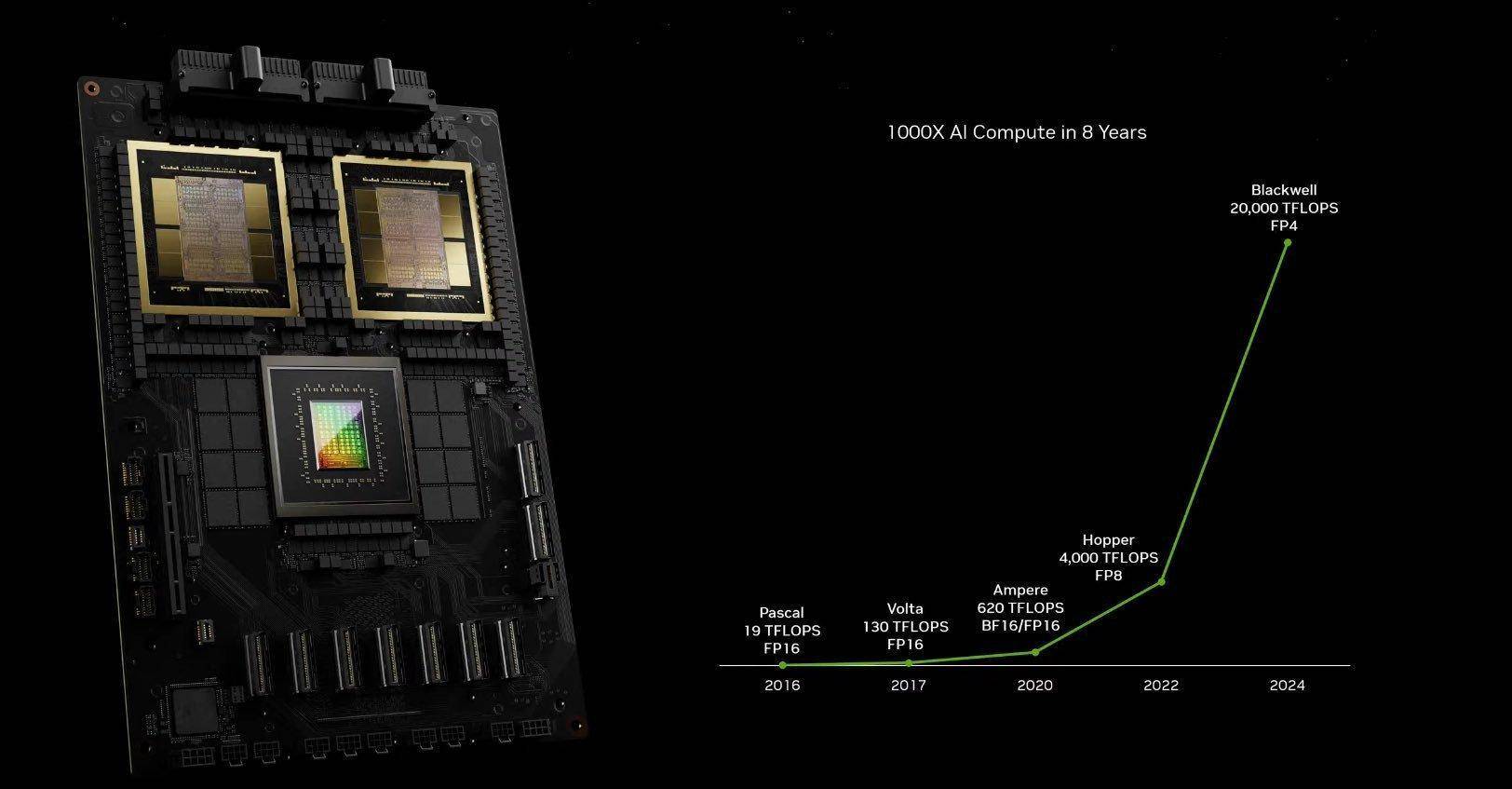

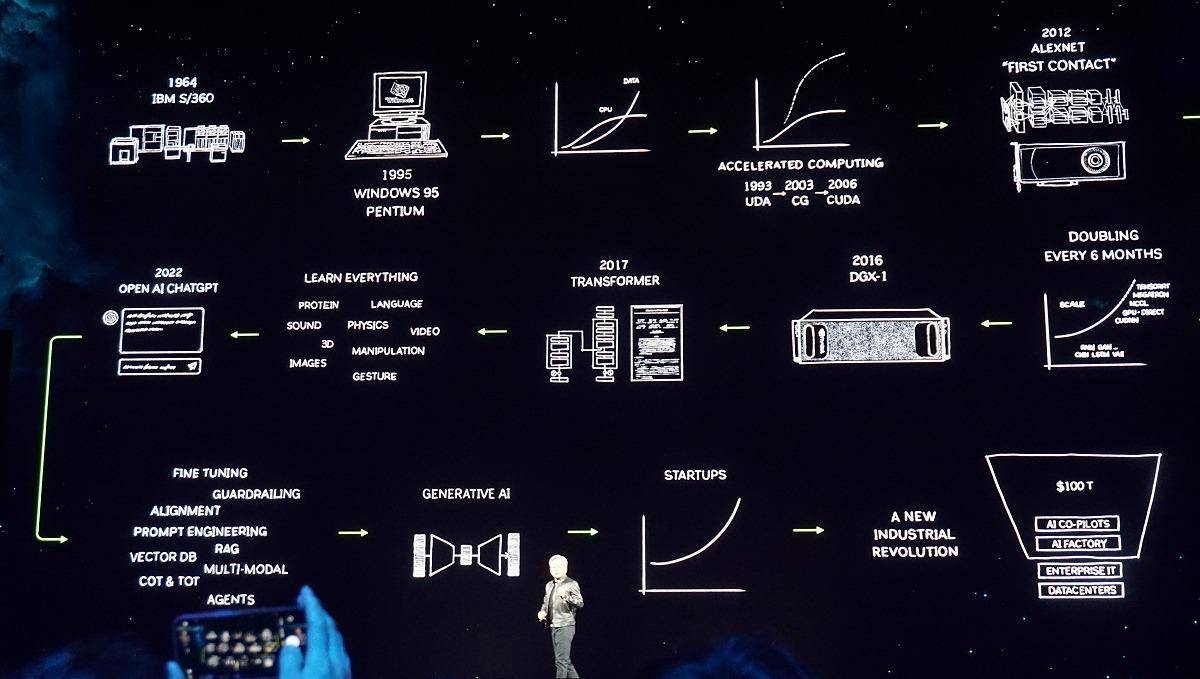

Seit 2006 hat NVIDIA nacheinander die Architekturen Tesla, Fermi, Kepler, Maxwel, Pascal, Volta, Turing und Ampere auf den Markt gebracht, die Tesla, Fermi, Kepler, Maxwell, Pascal, Volta, Turing, Ampere und diesen akademischen Spitzenreitern entsprechen.

Das eine ist, dass es berühmt ist, und das andere, dass es Materialien hat. Ob es eins zu eins mit dem bezeichneten Produkt übereinstimmt, ist eigentlich keine so starke Korrelation.

An dieser Stelle muss betont werden, dass es sich bei den oben genannten Objekten nicht um einzelne Chips handelt, sondern um die gesamte GPU-Architektur (Huang Renxun spricht von einer Plattform).

Chip-Architektur bezieht sich auf das grundlegende Design und die Organisationsstruktur des Chips. Unterschiedliche Architekturen bestimmen die Leistung, Energieeffizienz, Verarbeitungsleistung und Kompatibilität des Chips und wirken sich auch auf die Ausführungsmethode und Effizienz von Anwendungen aus.

Um es einfach auszudrücken: Sie besitzen jetzt ein Stadion (den Rohstoff für die Herstellung von Chips) und planen, es komplett umzugestalten. Ob das Gelände für Konzerte oder Sportspiele (der Zweck des Chips) genutzt wird, bestimmt die Anordnung des Veranstaltungsortes. Personaleinstellung und Dekoration. Und die Art der Ankündigung (Chip-Architektur).

Daher hängen Chiparchitektur und Chipdesign zusammen und bestimmen gemeinsam die Chipleistung.

Beispielsweise sind x86 und ARM, die oft erwähnt werden, zwei Mainstream-Architekturen, die für CPUs entwickelt wurden. Erstere bietet eine starke Leistung und letztere eine hervorragende Kontrolle des Energieverbrauchs. Jede hat ihre eigenen Stärken.

Die auf mehreren Generationen der NVIDIA-Technologie basierenden Chips B200 und B100 der Blackwell-Architektur zeichnen sich durch herausragende Leistung, Effizienz und Skalierbarkeit aus und schlagen auch ein neues Kapitel für AIGC auf.

Aber warum wird sie als „KI-Atombombe“ bezeichnet? Wie leistungsstark ist die neue GPU? Im Vergleich zum Produkt der vorherigen Generation werden wir ein intuitiveres Gefühl haben.

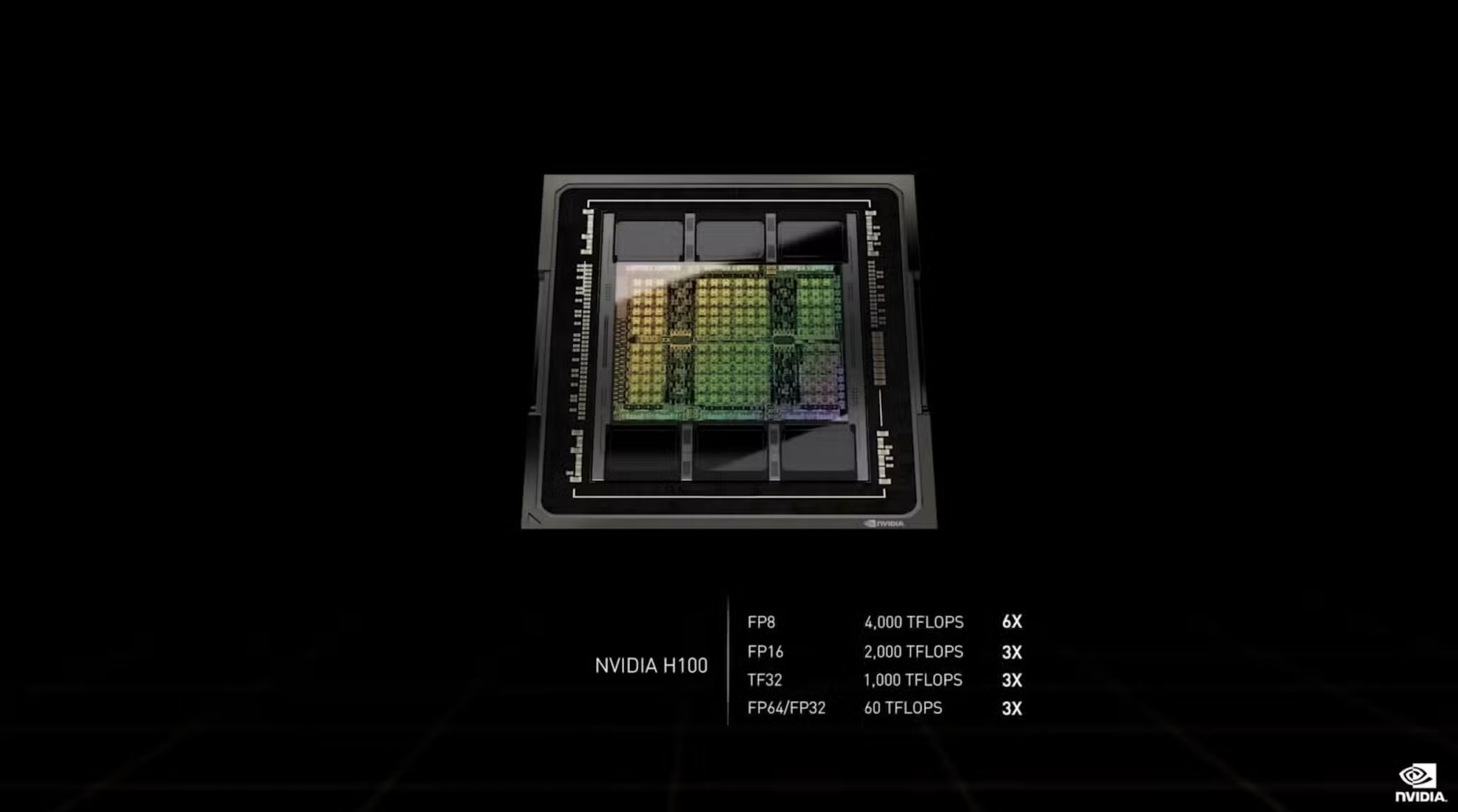

Auf der GTC 2022 veröffentlichte Huang Renxun eine neue Hopper-Architektur und einen neuen H100-Chip:

1. Es wird im 4-nm-Prozess von TSMC hergestellt und integriert 80 Milliarden Transistoren, das sind ganze 26 Milliarden mehr als die Vorgängergeneration A100.

2. Die FP16-, TF32- und FP64-Leistung von H100 ist dreimal so hoch wie die von A100, nämlich 2000 TFLOPS, 1000 TFLOPS bzw. 60 TFLOPS. Das Trainieren eines großen Modells mit 395 Milliarden Parametern dauert nur 1 Tag. In den ursprünglichen Worten von Lao Huang: „20 Bilder können die weltweiten Daten „Internetverkehr“ übertragen.

3. Die Veröffentlichung von H100 hat den Marktwert von NVIDIA auf über 2 Billionen US-Dollar gesteigert und es zum drittgrößten Technologieunternehmen nach Microsoft und Apple gemacht.

Laut einer statistischen Analyse des Marktverfolgungsunternehmens Omdia verkaufte Nvidia im dritten Quartal des vergangenen Jahres etwa 500.000 H100- und A100-GPUs, und das Gesamtgewicht dieser Grafikkarten betrug fast 1.000 Tonnen.

Bisher ist der Hopper H100 mit großem Abstand immer noch die leistungsstärkste GPU auf dem Markt.

Der Blackwell B200 hat erneut einen neuen Rekord in der Kategorie „Stärkster“ aufgestellt, mit Leistungsverbesserungen, die weit über herkömmliche Produktiterationen hinausgehen.

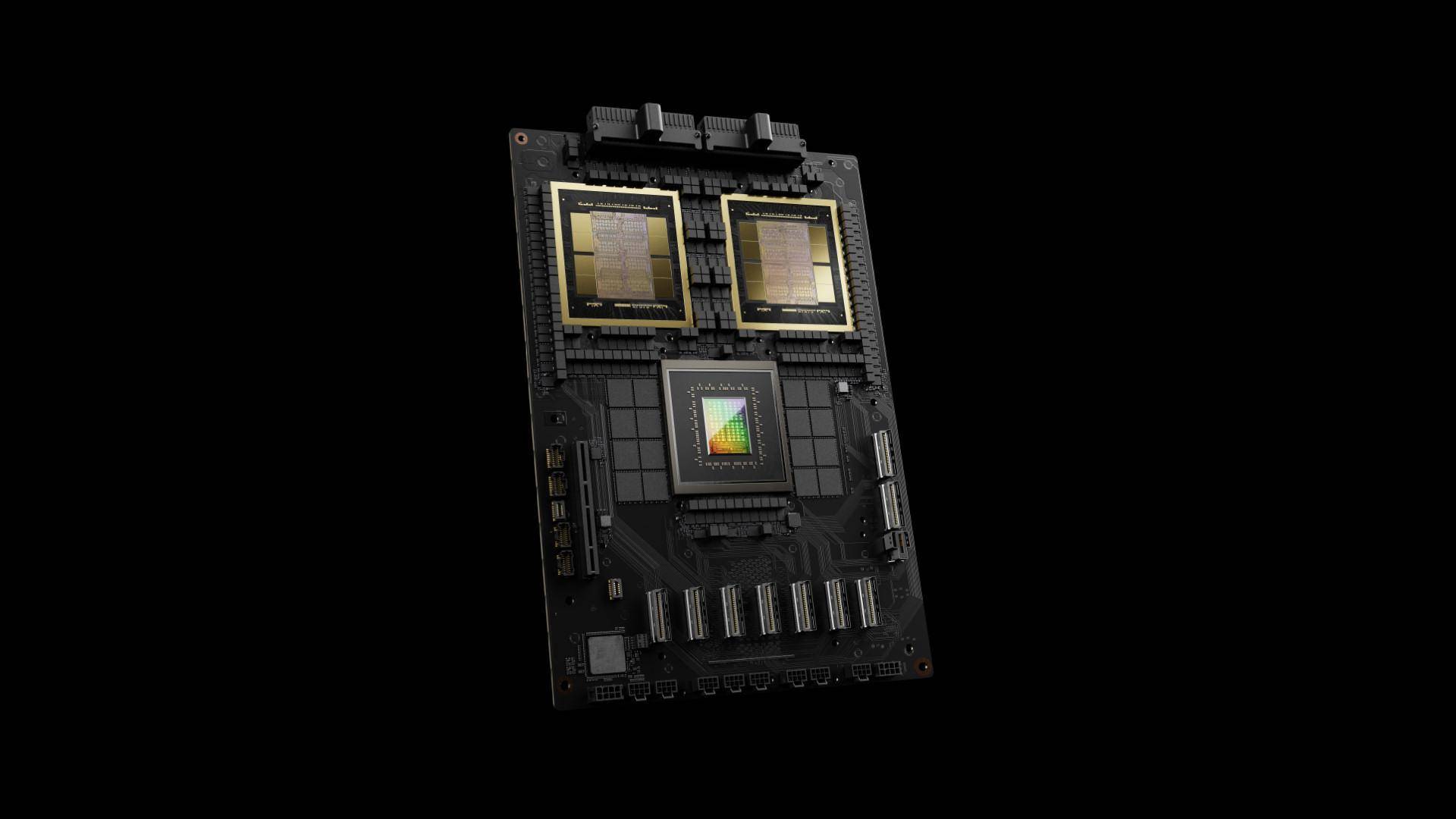

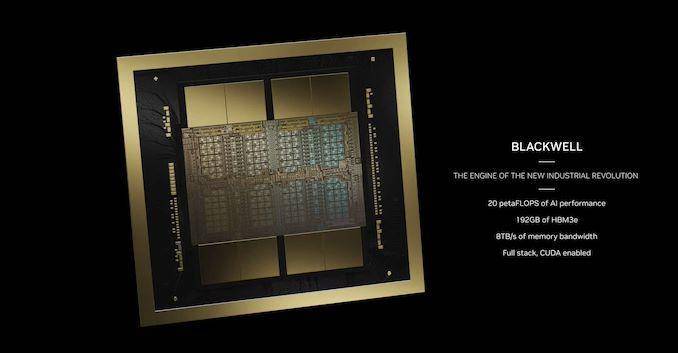

Aus prozesstechnischer Sicht nutzt die B200-GPU den TSMC 4-nm-Prozess der zweiten Generation, bei dem nackte Wafer mit der doppelten Photolithographie-Grenzgröße verwendet werden, und ist über eine Inter-Chip-Verbindungstechnologie mit 10 TB/s verbunden, um eine einheitliche GPU zu bilden Insgesamt 208 Milliarden Transistoren (ein einzelner Chip sind 104 Milliarden), verglichen mit der N4-Technologie, die zur Herstellung des Hopper H100 verwendet wurde, ist die Leistung um 6 % verbessert. , die Gesamtleistung wird um etwa 250 % verbessert.

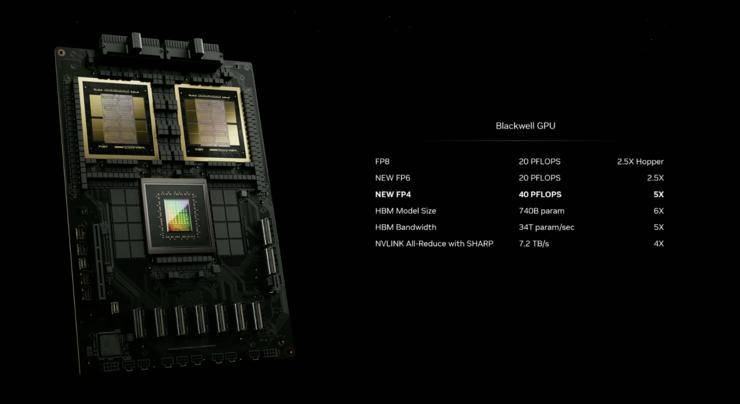

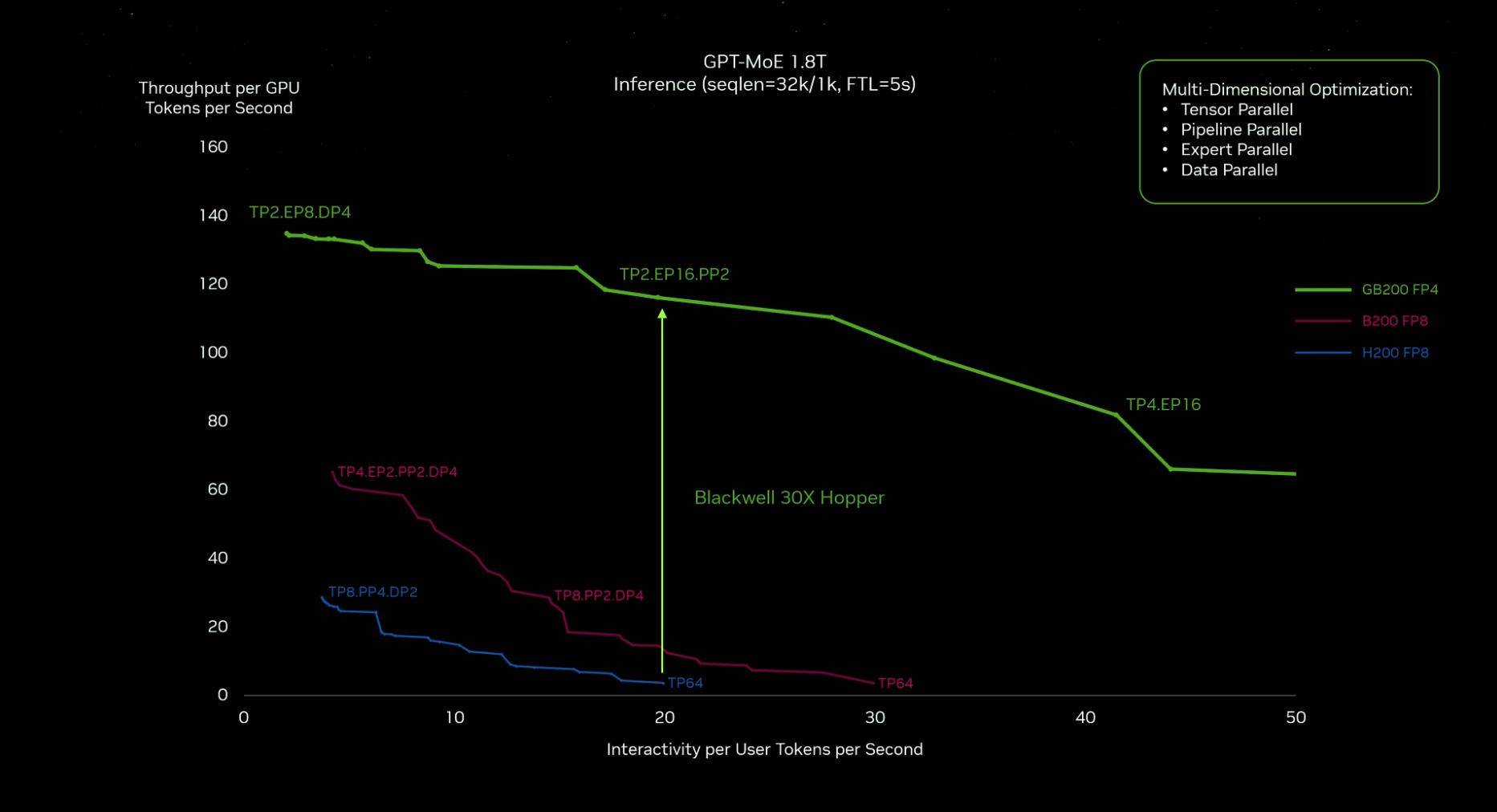

In Bezug auf die Leistung ermöglicht die Transformer-Engine der zweiten Generation Blackwell, durch die neue 4-Bit-Gleitkomma-KI die doppelte Berechnungs- und Modellgrößenberechnungsfähigkeit zu unterstützen. Die Single-Chip-KI-Leistung beträgt bis zu 20 PetaFLOPS (kann 20x leisten). 10 ^ 15 Floats pro Sekunde. Punktbetrieb), was viermal höher ist als beim Hopper H100 der vorherigen Generation, und die KI-Inferenzleistung ist 30-mal höher als bei der vorherigen Generation.

Aus Sicht der Energieverbrauchskontrolle erforderte das Training eines Modells mit 1,8 Billionen Parametern in der Vergangenheit 8.000 Hopper-GPUs und 15 Megawatt Leistung. Jetzt können dies 2.000 Blackwell-GPUs leisten, und der Stromverbrauch beträgt nur 4 Megawatt, was eine direkte Reduzierung um 96 % bedeutet.

Daher ist Huang Renxuns Aussage, dass „Blackwell der leistungsstärkste Chip der Welt werden wird“, nicht nur eine Lüge, sondern eine Tatsache.

Nicht billig, nicht einfach zu bedienen

Analysten des Finanzdienstleistungsunternehmens Raymond James hatten die Kosten des B200 geschätzt.

Nvidias Herstellungskosten für jeden H100 betragen etwa 3.320 US-Dollar, und der Preis liegt zwischen 25.000 und 30.000 US-Dollar. Basierend auf dem Leistungsunterschied zwischen den beiden wird geschätzt, dass die Kosten für B200 50 bis 60 % höher sein werden als die von H100, was etwa 6.000 US-Dollar entspricht.

In einem exklusiven Interview mit CNBC nach der Pressekonferenz verriet Huang Renxun, dass der Preis der Blackwell-GPU etwa 30.000 bis 40.000 US-Dollar beträgt und die Forschung und Entwicklung der gesamten neuen Architektur etwa 10 Milliarden US-Dollar kostet.

Wir mussten eine neue Technologie erfinden, um dies (die neue Architektur) zu ermöglichen.

Nach dem bisherigen Rhythmus wird Nvidia etwa alle zwei Jahre eine neue Generation von KI-Chips herausbringen. Im Vergleich zu früheren Produktgenerationen hat der neueste Blackwell die Rechenleistung und die Steuerung des Energieverbrauchs deutlich verbessert. Intuitiver kombiniert er den Zwei-GPU-Blackwell ist fast doppelt so groß wie der Hooper.

Die hohen Kosten hängen nicht nur mit Chips zusammen, sondern auch mit der Gestaltung von Rechenzentren und der Integration in Rechenzentren anderer Unternehmen, denn nach Ansicht von Huang Renxun stellt Nvidia keine Chips her, sondern baut Rechenzentren.

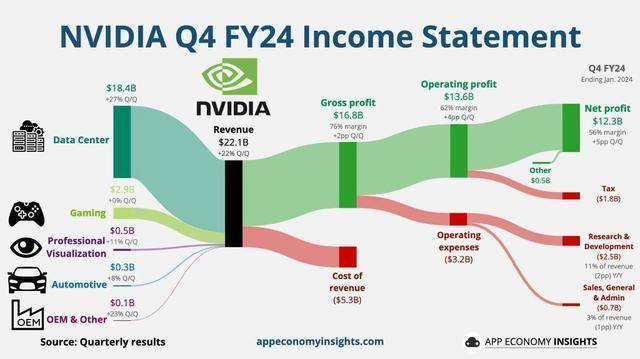

Laut Nvidias jüngstem Finanzbericht erreichte der Umsatz im vierten Quartal einen Rekordwert von 22,1 Milliarden US-Dollar, was einer Steigerung von 265 % gegenüber dem Vorjahr entspricht. Der Nettogewinn belief sich im vierten Quartal auf 12,3 Milliarden US-Dollar, was einer Steigerung von 765 % gegenüber dem Vorjahr entspricht.

Das Rechenzentrumssegment, die größte Einnahmequelle, erreichte einen Rekordwert von 18,4 Milliarden US-Dollar, ein Anstieg von 27 % gegenüber dem dritten Quartal und ein Anstieg von 409 % gegenüber dem gleichen Zeitraum des Vorjahres.

Die F&E-Kosten sind hoch, aber die positiven Erträge sind höher.

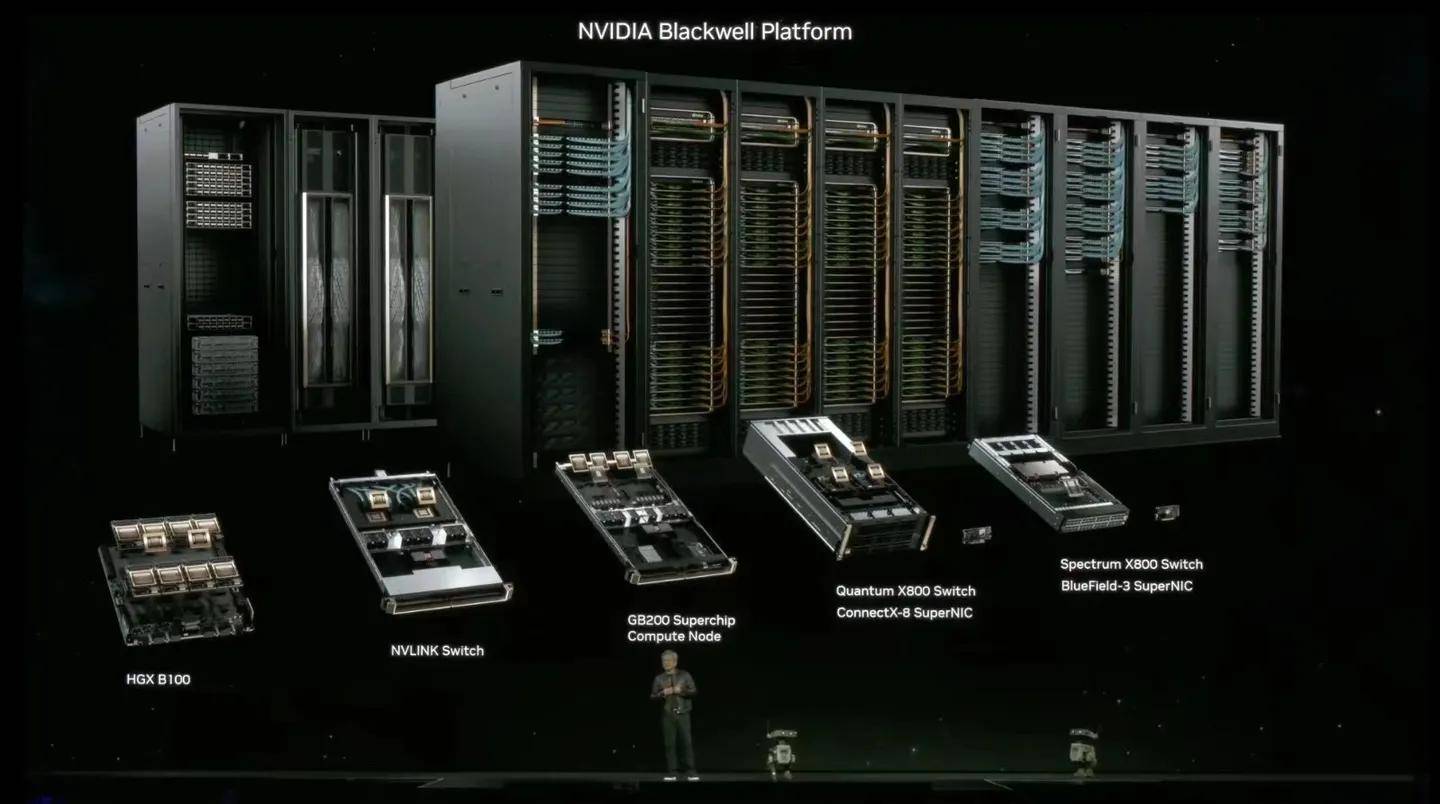

Das Rechenzentrum, das NVIDIA derzeit baut, umfasst ein Full-Stack-System und die gesamte Software. Es ist ein komplettes System. Blackwell oder GPU ist nur ein Teil davon.

Das Rechenzentrum ist in mehrere Module unterteilt. Benutzer können die entsprechenden Software- und Hardwaredienste entsprechend ihren eigenen Anforderungen frei wählen. NVIDIA passt Netzwerk, Speicher, Steuerungsplattform, Sicherheit und Verwaltung an unterschiedliche Anforderungen an und verfügt über ein dediziertes Team Technologieunterstützung bereitzustellen.

Ob eine solche globale Vision und maßgeschneiderte Dienste gut sind oder nicht, Daten können alles sagen: Seit dem 5. März hat Nvidias Marktwert Giganten wie Alphabet und Amazon überholt und Saudi Aramco überholt und ist zum drittgrößten Unternehmen der Welt geworden. an zweiter Stelle nach Die beiden großen Technologiegiganten Microsoft und Apple haben zusammen einen Marktwert von 2,4 Billionen US-Dollar.

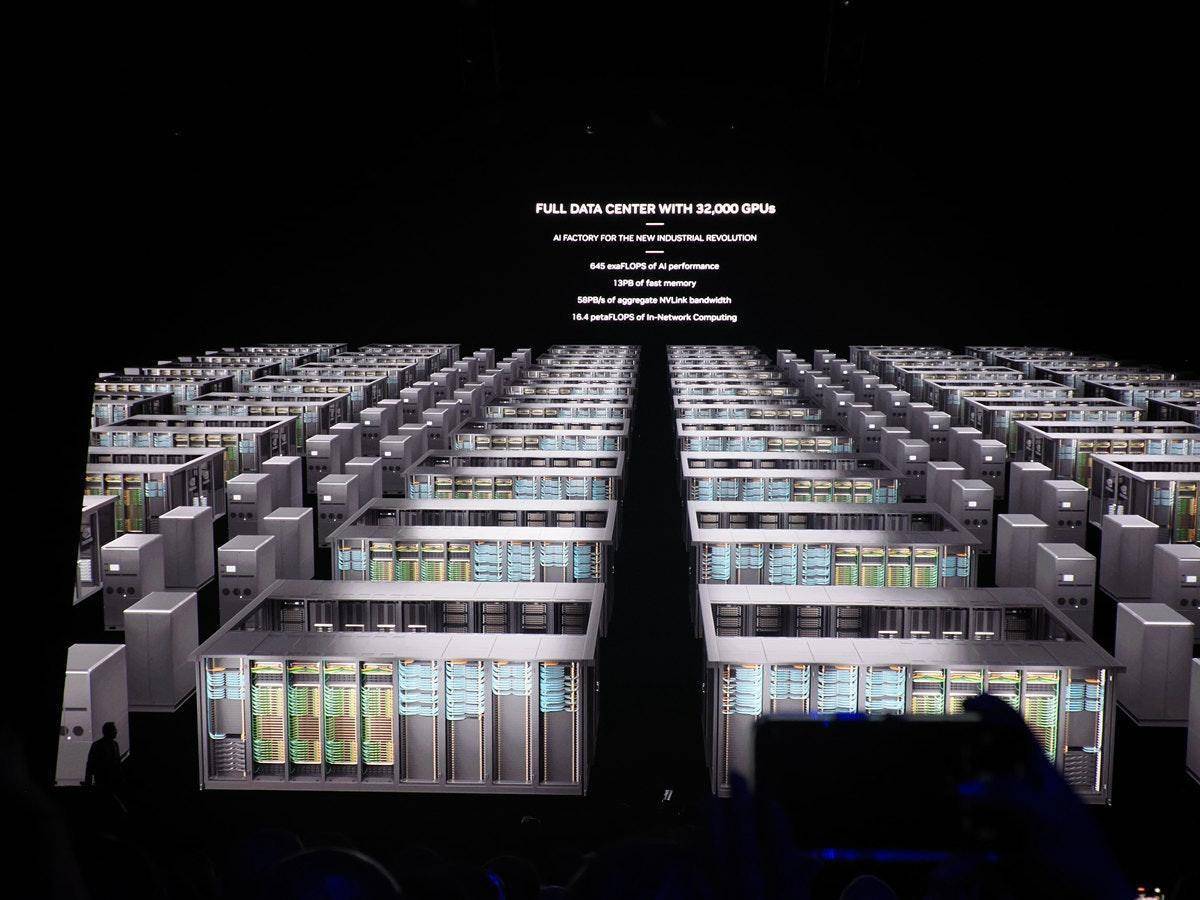

Derzeit beträgt der weltweite Markt für Rechenzentren etwa 200 Milliarden Euro (ca. 787,3 Milliarden RMB), und NVIDIA ist ein Teil davon. Huang Renxun prognostiziert, dass dieser Markt in Zukunft wahrscheinlich auf 1 bis 2 Billionen US-Dollar wachsen wird.

Analyse von Nvidia-CFO Kress:

Der Umsatz im Rechenzentrum wurde im vierten Geschäftsquartal hauptsächlich durch generative KI und die damit verbundene Schulung angetrieben. Wir schätzen, dass etwa 40 % des Rechenzentrumsumsatzes im vergangenen Jahr mit KI erzielt wurden.

Vor weniger als einem Monat erklärte Huang Renxun ebenfalls im Finanzbericht

Beschleunigtes Computing und generative KI haben einen Wendepunkt erreicht, und die Nachfrage steigt in Unternehmen, Branchen und Ländern auf der ganzen Welt.

Tatsächlich ist die Anpassung nicht nur NVIDIA vorbehalten, aber im Zeitalter der KI gibt es nur noch wenige Unternehmen, die „von Kopf bis Fuß“-Dienste anbieten können, und NVIDIA ist eines davon.

Damit Schweine abheben können, müssen sie zunächst im Wind sein

An der Schnittstelle von virtueller Realität, Hochleistungsrechnen und künstlicher Intelligenz ersetzen GPUs sogar CPUs als Gehirne von KI-Computern.

Der Hauptgrund, warum generative KI in verschiedenen Branchen hitzige Diskussionen ausgelöst hat, ist, dass sie anfängt, wie ein „Mensch“ zu arbeiten und zu lernen, vom Chatten, Texten schreiben, Bilder zeichnen, Videos erstellen, Bedingungen analysieren, recherchieren und zusammenfassen … alles Davon sind aufregende, erstaunliche Ergebnisse, die astronomische Mengen an Probendaten erfordern, um sie zu untermauern.

Wenn Sie sich zum Beispiel an den Namen „Ai Fan'er“ erinnern können, kann das daran liegen, dass die Informationen, die der öffentliche Account jeden Tag verbreitet, Ihr Gedächtnis durch die Wiederholung gestärkt haben; es kann auch daran liegen, dass Sie die Kombination aus „Ai Fan'er“ noch nie gesehen haben. Ai“ und „Fan'er“ davor, was neu ist. Der Sinn hinterlässt einen tiefen Eindruck bei Ihnen; vielleicht hinterlässt das orangefarbene Logo ein einzigartiges visuelles Symbol in Ihrem Kopf.

Jedes einfache kleine Detail festigt das Bild von „Faner“ in Ihrem Kopf, aber wenn die Informationen der nationalen Technologiemedien miteinander vermischt werden, sind mehr Symbole erforderlich, um den Eindruck zu vertiefen und Verwirrung zu vermeiden.

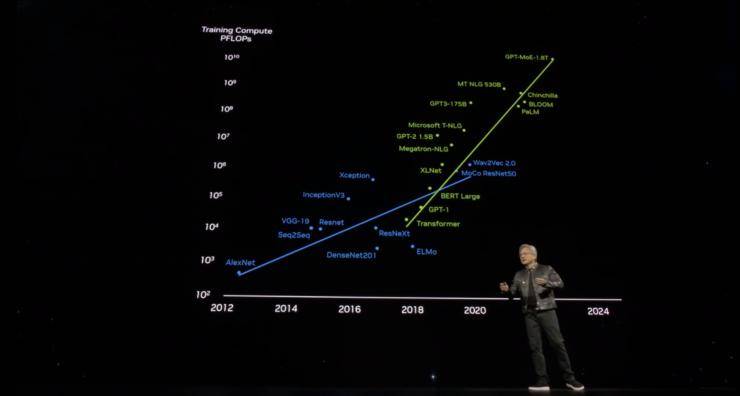

Das Deep Learning der KI folgt wahrscheinlich dieser Logik, und die GPU ist die beste Wahl für die Verarbeitung riesiger Informationsmengen.

Seitdem OpenAI AIGC ins Leben gerufen hat, haben die meisten namhaften Unternehmen begonnen, schnell ihre eigenen großen und kleinen Modelle in die Regale zu stellen. Intelligente Autos, Übersetzungssoftware, elektronische Dokumente, mobile Assistenten und sogar Kehrroboter verfügen alle über KI.

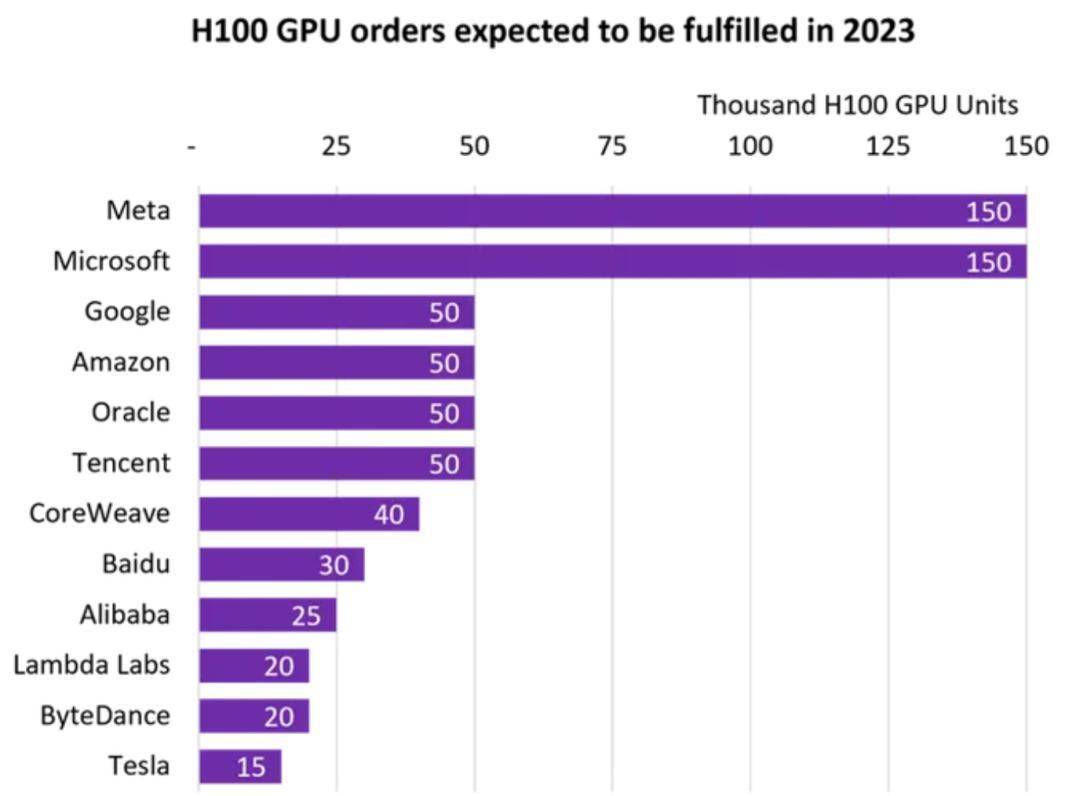

GPUs sind scheinbar über Nacht zum Gegenstand globaler Konkurrenz geworden. Laut Statistiken des Marktverfolgungsunternehmens Omdia haben Tencent, Alibaba, Baidu, ByteDance, Tesla, Meta und Microsoft jeweils 150.000 H100-GPUs (der leistungsstärkste Chip des letzten Jahres) gekauft.

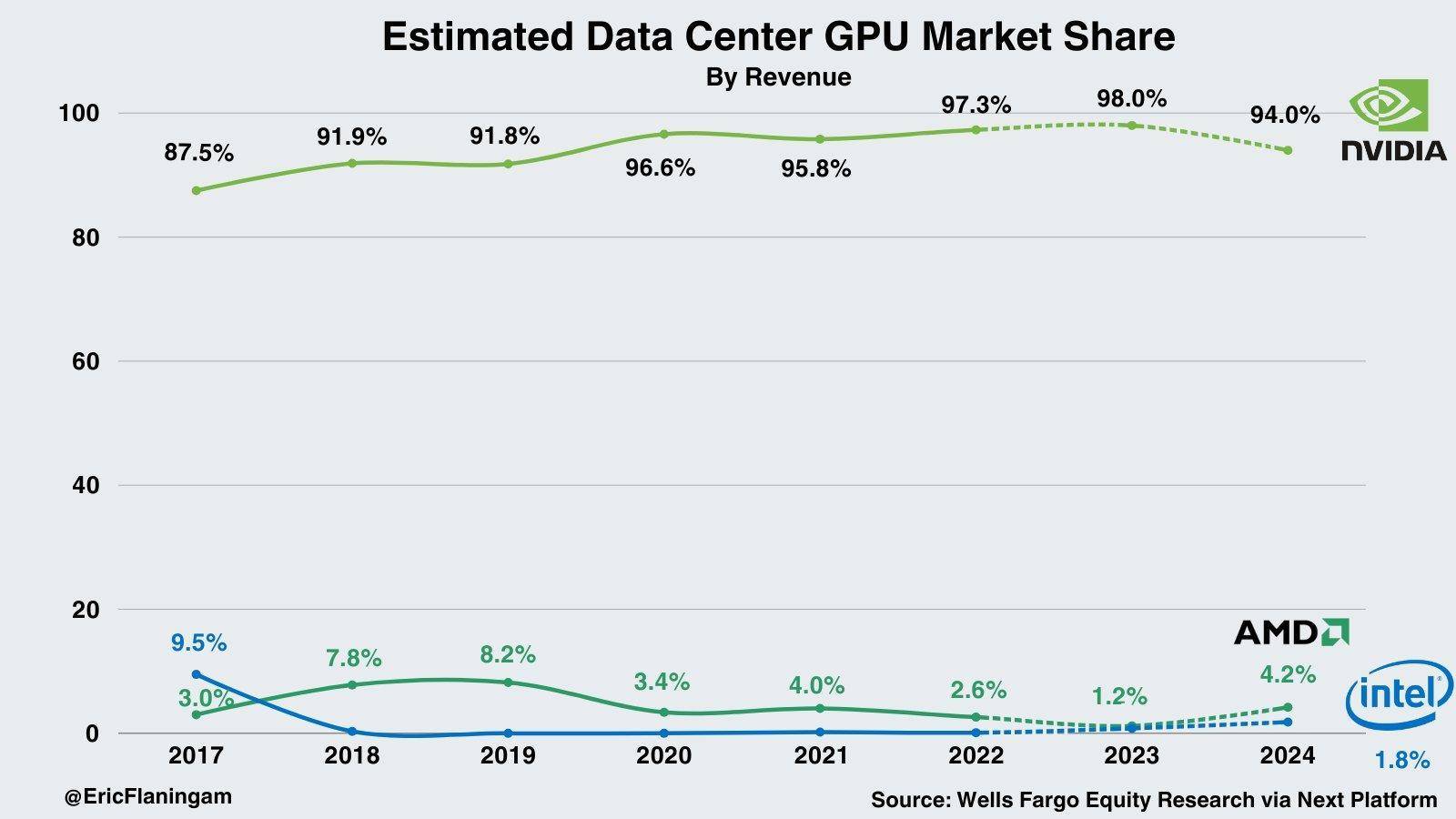

Technische Prinzipien und der Hintergrund der Zeit haben gemeinsam die Explosion der GPUs vorangetrieben und das „Grafikkartenimperium“ von Nvidia geschaffen. Laut Statistiken von Wells Fargo hat Nvidia derzeit einen Marktanteil von 98 % im KI-Markt für Rechenzentren.

Auf dem Windauslass stehend, kann sogar ein Schwein fliegen.

Aber wenn der Anteil eines Unternehmens an einer Branche nahezu 100 % beträgt, muss es einen Grund dafür geben, der ebenso wichtig ist wie die Tatsache, an der Spitze zu stehen.

Im Jahr 1999 übernahm NVIDIA die Führung bei der Einführung des GPU-Konzepts und brachte 2006 CUDA auf den Markt. Dies war ein wichtiger technologischer Wendepunkt in der Geschichte der Entwicklung von NVIDIA. Es senkte die Anwendungsschwelle der GPU. Entwickler können C/C++ und andere verwenden Sprachen, die auf der GPU aufbauen. Beim Schreiben von Programmen hat sich die GPU vom alleinigen Zweck der Bildverarbeitung gelöst und Hochleistungsrechnen hat Einzug in die Welt der Grafikkarten gehalten.

Der Sieg von AlphaGo im Jahr 2016, der Anstieg von Bitcoin im Jahr 2017 und der Mining-Boom – in dieser Zeit setzen wir auf den Markt für autonomes Fahren. Bis zum Aufkommen großer KI-Modelle wie ChatGPT im Jahr 2023 läutete NVIDIA einen Erntemoment ein die Samen, die es vor vielen Jahren gepflanzt hat.

Der Absatzmarkt ist wichtig, aber ein zukunftsorientiertes Marktlayout, diversifizierte Anwendungsbereiche, massive Investitionen und Innovationen, jede Verbindung, die fehl am Platz ist, wird nicht den aktuellen Marktmythos von nahezu perfekten Ergebnissen hervorbringen.

Für Nvidia ist es jedoch die wichtigste Frage, wie es seine führende Position am Scheideweg der Zeit behaupten kann.

Blackwell ist ein wichtiger Schritt zur Konsolidierung der Ergebnisse. Bevor viele Hersteller den bestellten H100 erhalten haben, haben die Montagelinien von B200 und B100 bereits begonnen.

In seiner Rede wiederholte Huang Renxun den Punkt, den er in früheren Finanzberichten dargelegt hatte, dass „die allgemeine Datenverarbeitung einen Engpass erreicht hat“.

Jetzt brauchen wir also größere Modelle, wir brauchen größere GPUs und wir müssen GPUs stapeln.

Dabei geht es nicht darum, Kosten zu senken, sondern darum, den Umfang zu vergrößern.

Darin liegt eine gewisse Bescheidenheit, aber natürlich gibt es auch eine große Nachfrage auf dem Markt.

Derzeit verfügt das größte Modell von OpenAI bereits über 1,8T (Billionen) Parameter und muss Milliarden von Token (Strings) verarbeiten. Selbst mit einer GPU auf PetaFLOP-Niveau (Petaflops) dauert das Training eines so großen Modells 1.000 Jahre.

Hopper ist großartig, aber wir brauchen eine leistungsstärkere GPU.

Die erste Diskussionswelle, die GTC 2024 ausgelöst hat, ist in den letzten Tagen langsam abgeklungen. Es ist absehbar, dass die Blackwell-GPU-Serie, der NVLink der fünften Generation und die RAS-Engines auf der Konferenz mehr bringen werden, wenn sie auf den Markt kommen. Schockierend ; Es ist schwer vorherzusagen, wie viele Überraschungen und Veränderungen „der Wendepunkt, den die generative KI erreicht hat“ für die Welt mit sich bringen wird?

In dem Moment, in dem AIGC ausbricht und am Vorabend der Ankunft von AGI, explodiert die von Nvidia gezündete Reihe von KI-Böllern zum ersten Mal.

# Willkommen beim offiziellen öffentlichen WeChat-Konto von aifaner: aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner | Ursprünglicher Link · Kommentare anzeigen · Sina Weibo