Was ist die Stärke des neuesten KI-Videomodells von Meta, das Sora in allen Aspekten übertrifft?

In den letzten zwei Tagen ist das Feld der Videogenerierungsmodelle aufgrund der Veröffentlichung von Meta Movie Gen erneut explodiert.

Die am meisten beklagten Punkte innerhalb und außerhalb der Branche sind nichts weiter als zwei Punkte. Erstens ist der Erzeugungseffekt natürlich und naturgetreu und kann gleichzeitig Geräusche erzeugen, die dem Bild entsprechen Veröffentlichung von Sora zu diesem Zeitpunkt; zweitens, das neue Modell von Meta AI ist hochgradig definierbar und sowohl das Videobildschirmverhältnis als auch die Videoelemente und -details können entsprechend den Bedürfnissen des Benutzers angepasst werden.

Was sind also die Details von Meta Movie Gen, das eine neue Revolution in der Videogenerierung einleiten könnte? Wie werden diese atemberaubenden Effekte auf der offiziellen Website und den Demonstrationsvideos erzielt? Andrew Brown, Leiter des Videomodells bei Meta AI, erläuterte insbesondere die theoretische Technologie von Meta Movie Gen:

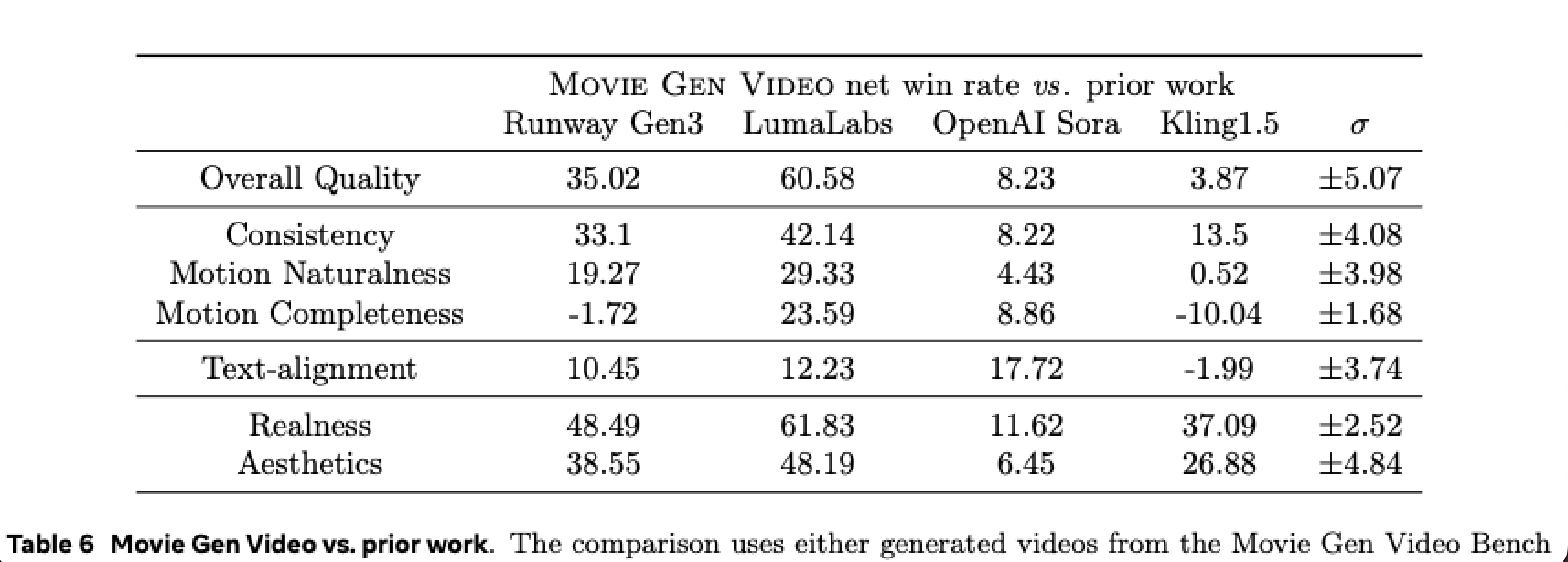

- Movie Gen ist hinsichtlich Gesamtqualität und Konsistenz deutlich besser als Sora. Authentizität und Schönheit testen den Fotorealismus, und Movie Gen überzeugt auf ganzer Linie.

- Meta Movie Gen ist eine Reihe von Modellen, die Text-zu-Video-Generierung, Text-zu-Bild-Generierung, Personalisierung, Bearbeitung und Video-zu-Audio-Generierung durchführen können.

- Es ist wichtig, die Daten-, Berechnungs- und Modellparameter zu erweitern, dies mit Flussanpassung zu kombinieren und auf eine einfache gemeinsame LLM-Architektur (Llama) umzusteigen, um so die Qualität der SOTA-Videoerzeugung zu erreichen.

- Wir (Meta AI) sind die ersten, die Llama Arch zur Mediengenerierung nutzen.

- Movie Gen ist ein parametrischer 30B-Konverter, der 1080p-Videos mit unterschiedlichen Seitenverhältnissen und synchronisiertem Audio mit einer maximalen Dauer von 16 Sekunden (16 fps) generiert.

- Wir (Meta) bieten eine mehrstufige Trainingslösung für das T2V-Modell. T2I + T2V gemeinsames Training, was zu einer viel langsameren Konvergenz und schlechterer Qualität führt.

- Die Auswertung von Text zu Video ist schwierig. Automatisierte Metriken sind sehr schlecht und korrelieren nicht gut mit menschlichen Bewertungen.

Videogeneriertes „Superindividuell“

Am Tag der Einführung von Meta Movie Gen berichtete und interpretierte APPSO sofort dieses neueste Videogenerierungsmodell. Im Allgemeinen verfügt Movie Gen über vier Funktionen: Videogenerierung, personalisierte Videogenerierung, präzise Bearbeitung und Audiogenerierung.

Schauen wir uns zunächst die einfachste Videogenerierung von Movie Gen Video an. Durch die multimodale Fähigkeit ist das neue Modell in der Lage, eine Vielzahl unterschiedlicher Eingabemethoden durchzuführen. Benutzer können entsprechende Videos nicht nur durch einfachen Text und ein paar Eingabeaufforderungen generieren Verarbeiten Sie die erforderlichen Bilder in das Modell und wandeln Sie die statischen Bilder entsprechend den Textanforderungen in dynamische Videos um.

▲ Aufforderungstext: Ein Mädchen läuft am Strand, sie hält einen Drachen in der Hand; sie trägt Jeansshorts und ein gelbes T-Shirt; die Sonne scheint auf sie.

Sie können Movie Gen sogar bitten, bei der Neugenerierung oder Optimierung eines Videos zu helfen. Unabhängig davon, welche Eingabemethode gewählt wird, ist das aktuelle Demonstrationsvideo von Movie Gen auf der offiziellen Website sehr effektiv. Die Charaktere haben natürliche Ausdrücke und die Details des Bildes sind vorhanden. Es können auch entsprechende Ergebnisse entsprechend den Eingabeaufforderungswörtern oder Textanforderungen generiert werden genauer.

Andrew Brown führte ein, dass es im Prozess der Videogenerierung sehr wichtig ist, Daten-, Berechnungs- und Modellparameter zu erweitern, sie mit Flussanpassung zu kombinieren und auf eine einfache und häufig verwendete LLM-Architektur (Llama) zurückzugreifen, um so die Qualität der SOTA-Videogenerierung zu erreichen .

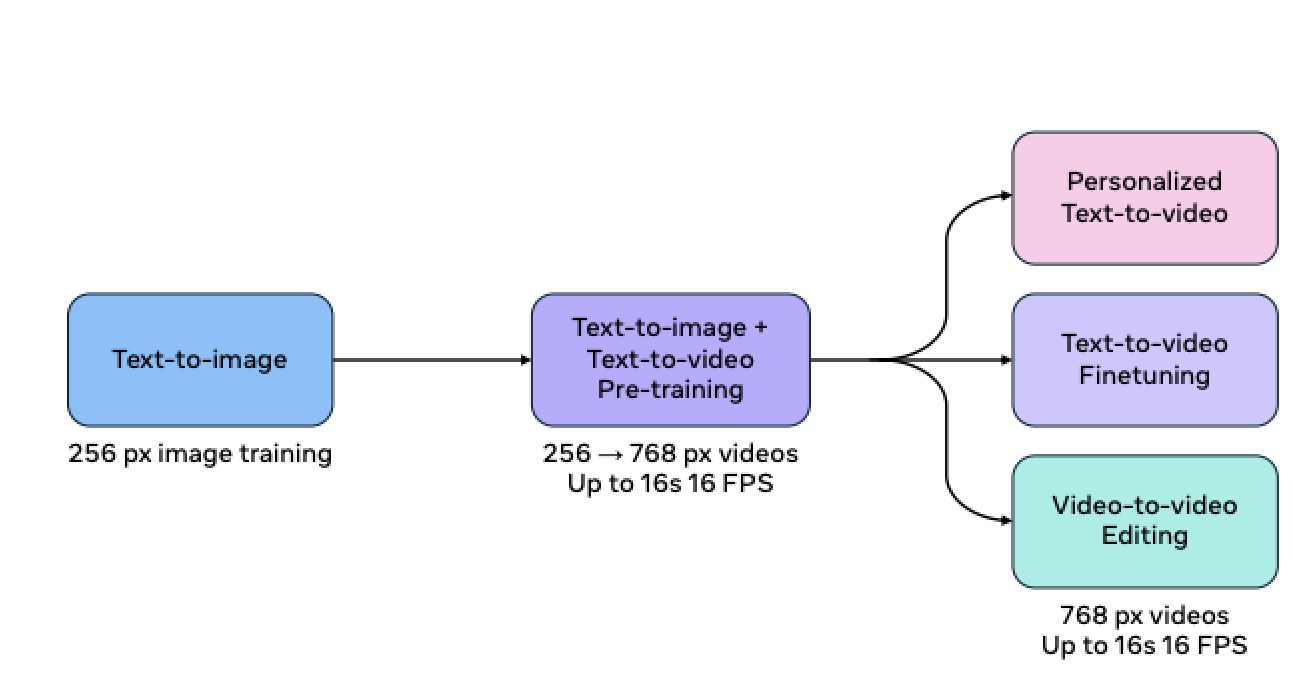

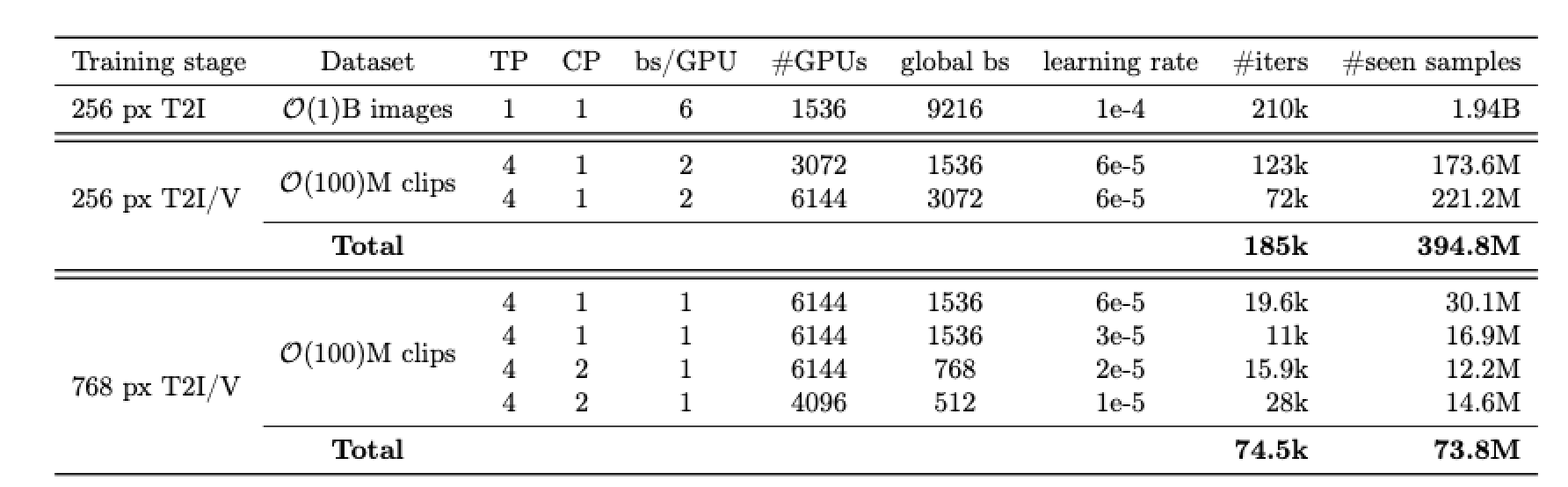

Darüber hinaus stammen die T2V-, Personalisierungs- und Bearbeitungsmodelle im neuen Modell alle aus demselben Schulungsschema. Während des Vortrainings trainiert Meta zunächst T2I und dann T2V. Verwenden Sie dieses Modell als Initialisierung, führen Sie dann das T2V-Nachtraining durch und trainieren Sie die Fähigkeit, die T2V- und V2V-Bearbeitung zu personalisieren.

Darüber hinaus wird das Training des Modells auch entsprechend der Auflösungsstufe durchgeführt, zunächst mit Training mit niedriger Auflösung (256 Pixel) und dann mit Training mit hoher Auflösung (768 Pixel). Meta AI versucht, T2I + T2V gemeinsam zu trainieren, was jedoch zu einer viel langsameren Konvergenz und schlechterer Qualität als zuvor führt.

Der Grund dafür, dass Movie Gen Video realistische Generierungsergebnisse erzielen kann, liegt im Wesentlichen in den hervorragenden Fähigkeiten des bis zu 30B-Parameter-Konvertermodells. Dieses Modell kann Videos mit einer Länge von bis zu 16 Sekunden bei einer Geschwindigkeit von 16 Bildern pro Sekunde erzeugen und kann bis zu 16 Sekunden Video. 45 Sekunden hochwertiger und originalgetreuer Ton.

Meta-Beamte enthüllten in der Zeitung außerdem:

Diese Modelle können über Objektbewegungen, Subjekt-Objekt-Interaktionen und Kamerabewegungen nachdenken und sinnvolle Bewegungen für eine Vielzahl von Konzepten lernen.

Dieser Satz hat insgesamt drei Bedeutungen. Die erste ist, dass das Modell selbst die physische Bewegung der realen Welt sowie verschiedene „gesunde“ physikalische Gesetze wiederherstellen kann. Für Benutzer sieht das „natürlich und realistisch“ aus Modelltechnik. Der erfolgreichste Ort.

Movie Gen Video kann die Bewegungsmuster der physischen Welt genau verstehen, und Meta AI hat große Anstrengungen unternommen. Das Team führte ein umfangreiches Vortraining des neuen Modells anhand von Hunderten Millionen Videos und Milliarden Bildern durch. Durch ständige Wiederholung, Lernen, Zusammenfassung, Argumentation und Anwendung hat Movie Gen Video auf der offiziellen Website eine herausragende Leistung erzielt.

Dann kann das Model auch Kamerabewegungen, Szenen, Montagen etc. professioneller Filme aktiv nachahmen und erlernen. Mit anderen Worten: Auch die mit Movie Gen Video generierten Videos weisen die Professionalität und Kunstfertigkeit auf, die mit Filmaufnahmen vergleichbar sind.

Andrew Brown erwähnte jedoch, dass die Text-zu-Video-Bewertung schwierig sei. Weil automatisierte Metriken sehr schlecht sind und nicht gut mit menschlichen Bewertungen korrelieren. Mit anderen Worten, in den frühen Tagen der Entwicklung von Videogenerierungsmodellen unterschieden sich die Generierungsergebnisse in den Eindrücken und Beobachtungen der Menschen zu sehr von der realen physischen Welt. Am Ende bestimmte Meta immer noch die Authentizität dieses Urteils und verließ sich ausschließlich auf den Menschen Auswertung.

Wir haben viel Mühe darauf verwendet, die Videoauswertung in mehrere orthogonale Qualitäts- und Ausrichtungsachsen zu unterteilen.

Ergebnisse: Movie Gen gewinnt im Vergleich zu den Modellen des 1000-Cue-Evaluierungssatzes in puncto Qualität und Konsistenz auf ganzer Linie oder liegt auf Augenhöhe.

Schließlich kann das Modell auf dieser Grundlage den nächsten Inhalt erarbeiten. Es ist wie ein professioneller Regisseur, der jede Bewegung im Bild steuert und auf der Grundlage von Videoinhalten oder Textansagen einen Soundtrack generiert das entspricht dem Bild in Echtzeit.

▲ Der Soundeffekt in dem Moment, in dem das Feuerwerk explodiert

Die Fähigkeit, Audio synchron zu generieren, basiert auf Movie Gen Audio. Hierbei handelt es sich um ein 13B-Parameter-Konvertermodell, das Videoeingaben sowie optionale Textansagen für die steuerbare Erzeugung von mit Video synchronisiertem High-Fidelity-Audio akzeptiert.

Wie Movie Gen Video führt auch Movie Gen Audio „massive“ Übungen durch und speist Millionen von Stunden Audio-Referenzen in das Modelltraining ein. Nach vielen Vergleichen und Zusammenfassungen beherrscht das aktuelle Modell die Entsprechung zwischen Ton und Bild und kann sogar die unterschiedlichen Gefühle verstehen, die unterschiedliche Hintergrundmusik beim Publikum hervorrufen wird.

Wenn es also um Stichworte zu Stimmung und Umgebung geht, findet Movie Gen Audio immer Musik, die perfekt zum Bild passt.

Gleichzeitig kann es Umgebungsgeräusche, Instrumental-Backing-Tracks und Foley-Sounds erzeugen und liefert so modernste Ergebnisse in Bezug auf Audioqualität, Video-zu-Audio-Ausrichtung und Text-zu-Audio-Ausrichtung.

Damit sind sie die fortschrittlichsten Modelle ihrer Art.

Obwohl wir es nicht wagen, eine so selbstbewusste Schlussfolgerung wie die offizielle zu ziehen, hat Movie Gen Video im Vergleich zu Modellen der vorherigen Videogeneration, unabhängig von der offiziellen Videolänge, der Bildqualität oder der Passform der Hintergrundmusik, sehr offensichtliche Fortschritte gemacht.

Darüber hinaus hat Movie Gen im Vergleich zum vorherigen Idol-Kraftpaket Sora einen klaren Vorsprung in Bezug auf Gesamtqualität und Konsistenz. Andrew Brown sagte in diesem Spiel mit Sora unverhohlen:

Movie Gen gewinnt auf ganzer Linie.

Der „Allround-Experte“ in Sachen Videobearbeitung

Durch die Zusammenarbeit von Movie Gen Video und Movie Gen Audio verfügt das neue Videogenerierungsmodell von Meta AI über neue Fähigkeiten. Die oben genannten Fortschritte sind jedoch nur die technische Grundlage. Mit der Fähigkeit, Audio und Video zu generieren, wurde Meta ebenfalls weiter ausgebaut Das neue Modell ermöglicht die Erstellung personalisierter Videos.

Personalisierung besteht, wie der Name schon sagt, darin, Benutzerbedürfnisse zu kombinieren und bestimmte Videoinhalte entsprechend den Anforderungen zu generieren.

Obwohl bisherige Videomodelle auch personalisierte Ergebnisse liefern können, sind die Ergebnisse immer unbefriedigend. Entweder können die Details nicht geändert werden und müssen von vorne begonnen werden, oder andere Elemente im Bild können nicht beibehalten werden, wenn die Details ständig geändert werden durch die Generierung neuer Videos.

Die Demonstration von Movie Gen Video auf der offiziellen Website zeigt ihre Vorteile in dieser Hinsicht sehr gut. Das neue Modell kann nicht nur personalisierte Videos gemäß den Anforderungen von Aufforderungswörtern/Referenzbildern generieren, sondern auch weiterhin Details basierend auf dem Video optimieren und anpassen und sicherstellen, dass andere generierte Inhalte nicht gestört werden, was eine „Feinmodifikation“ darstellt.

Im Gegensatz zu herkömmlichen Generierungstools, die spezielle Fähigkeiten erfordern oder denen es an Präzision mangelt, behält Movie Gen den ursprünglichen Inhalt bei und zielt nur auf relevante Pixel ab.

Unser Modell erzielt hochmoderne Ergebnisse bei der Erstellung personalisierter Videos, die die menschliche Identität und Handlungen bewahren.

Diese Funktion ist für viele Self-Media-Studios oder Personen mit Videobearbeitungsanforderungen sehr nützlich. Sie kann globale Änderungen oder detaillierte Änderungen an den geänderten Objekten vornehmen. Es kann so groß sein, dass das gesamte Bild basierend auf dem Text neu erstellt wird, oder so klein, dass nur die Haarfarbe, der Brillenstil usw. der Figur geändert werden. Mithilfe von Modellen können beispielsweise irrelevante Unordnung im Hintergrund beseitigt werden.

Oder Sie geben dem Originalvideo einen neuen Hintergrund. Ob Stil oder Farbe, Sie können ihn jederzeit ändern und auch den Tag in Sekundenschnelle verwandeln.

Darüber hinaus kann Movie Gen Video auch subtile Anpassungen an vielen Details vornehmen. Während sichergestellt wird, dass die Komposition des Videos und das Gesamtbild unverändert bleiben, kann es auch die Kleidungsfarbe, den Brillentragestil, die Hauptkörperkleidung und die Fellfarbe des Haustiers ändern , usw.

Zu seinen Stärken gehören beispielsweise das Entfernen irrelevanter Unordnung in Videos, das Ändern des Hintergrundstils des Bildes, das Hinzufügen von Details zum Video, das Ändern der Farbe der Kleidung des Motivs usw.

Aber das ist nur eine Fantasie, denn Movie Gen Video unterstützt derzeit nur 1080P, 16 Sekunden, 16 Bilder pro Sekunde langes High-Definition-Video oder bis zu 45 Sekunden hochwertiges und Hi-Fi-Audio. Eine solche Bildauflösung und Videolänge scheint für eine Einzelperson oder ein Unternehmen mit kreativen Bedürfnissen nicht ausreichend zu sein.

Dieser technologische Durchbruch hat es der KI jedoch ermöglicht, Videodateien mit unendlichen Anpassungen, Personalisierungen und präzisen Anpassungen zu bearbeiten. Darüber hinaus hat Movie Gen Audio die Tür für die Videosynchronisierung geöffnet, obwohl Movie Gen Video erst im nächsten Jahr verfügbar sein wird Offiziell wurde es von der Öffentlichkeit nicht wahrgenommen, aber nach den aktuellen offiziellen Demonstrationsergebnissen zu urteilen, ist es tatsächlich möglich, der Video-, Film- und Fernsehbranche sowie der KI-Branche neue Impulse zu verleihen und sogar eine neue Revolution herbeizuführen.

Die neuesten und modernsten Tools, darunter Movie Gen Video, versuchen, dieses Stereotyp der KI im Bereich der Videogenerierung zu durchbrechen, obwohl dieser Tag mit ihren aktuellen Fähigkeiten noch in weiter Ferne liegt.

Für Videogenerierungsmodelle ist es zunächst schwierig, das tägliche Leben normaler Menschen direkt zu beeinflussen oder sogar zu berühren. Es kann sein, dass ein bestimmter, von KI erstellter Film die Aufmerksamkeit der Öffentlichkeit in Bezug auf Frische auf sich zieht. Die aktuellen mit KI produzierten Filme, TV-Serien und Animationen weisen einige Mängel wie unrealistische Bilder und inkonsistente Bewegungen auf.

Meta AI erklärte auf seiner offiziellen Website außerdem, dass sie im Zuge der Verbesserung und Weiterentwicklung der Modelltechnologie eng mit Filmemachern und Schöpfern zusammenarbeiten werden, um deren Feedback zu integrieren. Ob Runway, Sora oder die neueste Meta-KI, sie alle entwickeln sich derzeit rasant. Zumindest im Vergleich zu den Generationsergebnissen vor einem Jahr können wir sichtbare Fortschritte erkennen.

Die Auswirkungen der KI-Technologie auf das Leben der Menschen sind möglicherweise nicht sofort erkennbar. Während immer noch darüber diskutiert wird, „was der Nutzen von KI ist“, besteht die größte Bedeutung für die meisten Menschen darin, dass es ein weiteres nützliches Werkzeug gibt: ein lustiges Spielzeug.

Ganz gleich, ob jemand ein Filmemacher ist, der in Hollywood groß rauskommen möchte, oder ein YouTuber, der gerne Videos für ein Publikum dreht, wir glauben, dass jeder Zugang zu Tools haben sollte, die ihm dabei helfen, seine Kreativität zu steigern.

# Willkommen beim offiziellen öffentlichen WeChat-Konto von Aifaner: Aifaner (WeChat-ID: ifanr) wird Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner |. Ursprünglicher Link · Kommentare anzeigen · Sina Weibo