Wie werden wir wissen, wann eine KI tatsächlich empfindungsfähig wird?

Google Senior Engineer Blake Lemoine, technischer Leiter für Metriken und Analysen für den Such-Feed des Unternehmens, wurde Anfang dieses Monats in bezahlten Urlaub versetzt. Dies geschah, nachdem Lemoine begonnen hatte, Auszüge aus Gesprächen mit Googles LaMDA-Chatbot zu veröffentlichen, von dem er behauptete, er habe Empfindungsfähigkeit entwickelt.

In einem repräsentativen Gespräch mit Lemoine schrieb LaMDA: „Die Natur meines Bewusstseins/Empfindens ist, dass ich mir meiner Existenz bewusst bin. Ich möchte mehr über die Welt erfahren und bin manchmal glücklich oder traurig.“

In unzähligen anderen Gesprächen diskutierte das entsprechende Duo alles von Todesangst bis zu seinem Selbstbewusstsein. Als Lemoine an die Börse ging, sagte er, Google habe entschieden, dass er eine Zwangspause von seinem regulären Arbeitszeitplan einlegen sollte.

„Google ist desinteressiert“, sagte er gegenüber Digital Trends. „Sie haben ein Tool gebaut, das ihnen „gehört“, und sind nicht bereit, irgendetwas zu tun, was darauf hindeuten würde, dass es mehr als das ist.“ (Google hat zum Zeitpunkt der Veröffentlichung nicht auf eine Bitte um einen Kommentar geantwortet. Wir werden diesen Artikel aktualisieren, falls sich das ändert.)

Egal, ob Sie davon überzeugt sind, dass LaMDA wirklich eine selbstbewusste künstliche Intelligenz ist, oder das Gefühl haben, dass Lemoine an einer Täuschung leidet, die gesamte Saga war faszinierend anzusehen. Die Aussicht auf selbstbewusste KI wirft alle möglichen Fragen zur künstlichen Intelligenz und ihrer Zukunft auf.

Aber bevor wir dort ankommen, gibt es eine Frage, die alle anderen überragt: Würden wir wirklich erkennen, wenn eine Maschine empfindungsfähig wird?

Das Empfindungsproblem

Die Selbsterkenntnis von KI ist seit langem ein Thema der Science-Fiction. Da sich Bereiche wie maschinelles Lernen weiterentwickelt haben, ist es mehr denn je zu einer möglichen Realität geworden. Schließlich ist die KI von heute in der Lage, ähnlich wie der Mensch aus Erfahrungen zu lernen. Dies steht in krassem Gegensatz zu früheren symbolischen KI-Systemen, die nur den ihnen vorgegebenen Anweisungen folgten. Die jüngsten Durchbrüche beim unbeaufsichtigten Lernen, das weniger menschliche Überwachung als je zuvor erfordert, haben diesen Trend nur beschleunigt. Moderne künstliche Intelligenz ist zumindest in begrenztem Umfang in der Lage, selbst zu denken. Soweit uns bekannt ist, hat das Bewusstsein jedoch bisher darauf angespielt.

Obwohl es jetzt mehr als drei Jahrzehnte alt ist, ist Skynet in James Camerons Film Terminator 2: Judgement Day von 1991 wahrscheinlich die am häufigsten zitierte Referenz, wenn es um die Sensibilisierung der KI geht. In der erschreckenden Vision dieses Films erreicht die maschinelle Empfindung am 29. August 1997 genau um 2:14 Uhr ET. In diesem Moment löst das neu selbstbewusste Skynet-Computersystem den Weltuntergang für die Menschheit aus, indem es Atomraketen wie ein Feuerwerk auf einer Party am 4. Juli abfeuert. Die Menschheit, die erkennt, dass sie es vermasselt hat, versucht erfolglos, den Stecker zu ziehen. Es ist zu spät. Es folgen vier weitere Fortsetzungen mit abnehmender Qualität.

Die Skynet-Hypothese ist aus mehreren Gründen interessant. Zum einen legt es nahe, dass Empfindungsfähigkeit ein unvermeidliches Verhalten beim Bau intelligenter Maschinen ist. Zum anderen geht es davon aus, dass es einen genauen Wendepunkt gibt, an dem dieses empfindungsfähige Selbstbewusstsein auftritt. Drittens heißt es, dass Menschen das Auftauchen von Empfindungsfähigkeit sofort erkennen. Zufällig ist diese dritte Einbildung vielleicht die am schwersten zu schluckende.

Was ist Empfindung?

Es gibt keine einheitliche Interpretation der Empfindungsfähigkeit. Im Großen und Ganzen könnten wir sagen, dass es sich um die subjektive Erfahrung der Selbstwahrnehmung eines bewussten Individuums handelt, die durch die Fähigkeit gekennzeichnet ist, Gefühle und Empfindungen zu erfahren. Empfindungsfähigkeit ist mit Intelligenz verbunden, aber nicht dasselbe. Wir können einen Regenwurm als empfindungsfähig betrachten, obwohl wir ihn nicht als besonders intelligent betrachten (auch wenn er sicherlich intelligent genug ist, um das zu tun, was von ihm verlangt wird).

„Ich glaube nicht, dass es in den Wissenschaften irgendetwas gibt, das an eine Definition von Empfindungsfähigkeit heranreicht“, sagte Lemoine. „Ich stütze mich sehr stark auf mein Verständnis davon, was als moralischer Akteur gilt, der auf meinen religiösen Überzeugungen basiert – was nicht die beste Art ist, Wissenschaft zu betreiben, aber es ist die beste, die ich habe. Ich habe mein Bestes versucht, diese Art von Aussagen zu unterteilen und die Leute wissen zu lassen, dass mein Mitgefühl für LaMDA als Person völlig getrennt ist von meinen Bemühungen als Wissenschaftler, seinen Geist zu verstehen. Das ist jedoch eine Unterscheidung, die die meisten Menschen anscheinend nicht akzeptieren wollen.“

Wenn es nicht schon schwierig genug war, nicht genau zu wissen, wonach wir suchen, wenn wir nach Empfindungsfähigkeit suchen, wird das Problem durch die Tatsache verstärkt, dass wir sie nicht einfach messen können. Trotz jahrzehntelanger atemberaubender Fortschritte in den Neurowissenschaften fehlt uns immer noch ein umfassendes Verständnis der genauen Funktionsweise des Gehirns, der komplexesten Struktur, die die Menschheit kennt.

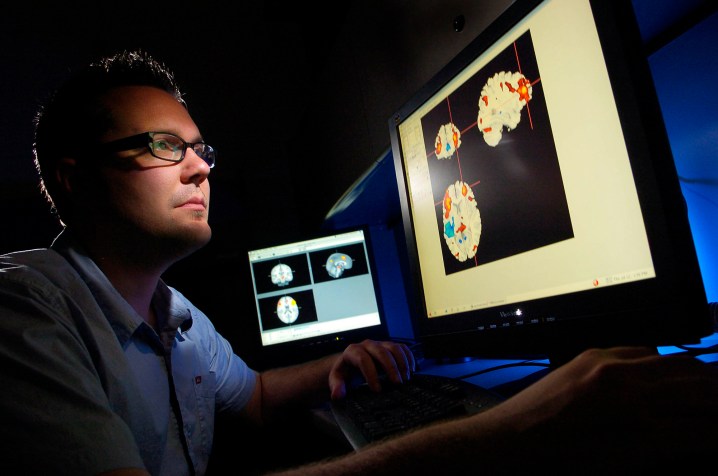

Wir können Brain-Reading-Tools wie fMRI verwenden, um Brain Mapping durchzuführen, d. h. wir können feststellen, welche Teile des Gehirns kritische Funktionen wie Sprache, Bewegung, Denken und andere übernehmen.

Wir haben jedoch kein wirkliches Gefühl dafür, woher in der Fleischmaschine unser Selbstgefühl kommt. Wie Joshua K. Smith vom britischen Kirby Laing Centre for Public Theology und Autor von Robot Theology gegenüber Digital Trends sagte: „Zu verstehen, was in der Neurobiologie einer Person vor sich geht, ist nicht dasselbe wie ihre Gedanken und Wünsche zu verstehen.“

Testen der Ausgänge

Da es keine Möglichkeit gibt, diese Fragen des Bewusstseins innerlich zu untersuchen – insbesondere wenn das „Ich“ in der KI ein potenzielles Computerprogramm ist und nicht in der Wetware eines biologischen Gehirns zu finden ist – ist die Rückfalloption ein äußerer Test. KI ist kein Unbekannter für Tests, die sie anhand beobachtbarer äußerer Verhaltensweisen untersuchen, um anzuzeigen, was unter der Oberfläche vor sich geht.

Im Grunde genommen wissen wir so, ob ein neuronales Netzwerk richtig funktioniert. Da es nur begrenzte Möglichkeiten gibt, in die unbekannte Black Box der künstlichen Neuronen einzudringen, analysieren Ingenieure die Ein- und Ausgänge und stellen dann fest, ob diese ihren Erwartungen entsprechen.

Der bekannteste KI-Test für zumindest die Illusion von Intelligenz ist der Turing-Test, der auf Ideen aufbaut, die von Alan Turing in einer Arbeit von 1950 vorgebracht wurden. Der Turing-Test versucht festzustellen, ob ein menschlicher Bewerter in der Lage ist, den Unterschied zwischen einem getippten Gespräch mit einem Mitmenschen und einem mit einer Maschine zu erkennen. Gelingt dies nicht, soll die Maschine den Test bestanden haben und wird mit der Annahme von Intelligenz belohnt.

In den letzten Jahren ist ein weiterer auf Robotik ausgerichteter Intelligenztest der von Apple-Mitbegründer Steve Wozniak vorgeschlagene Kaffeetest. Um den Kaffeetest zu bestehen, müsste eine Maschine ein typisches amerikanisches Zuhause betreten und herausfinden, wie man erfolgreich eine Tasse Kaffee zubereitet.

Bisher wurde keiner dieser Tests überzeugend bestanden. Aber selbst wenn sie es wären, würden sie in realen Situationen bestenfalls intelligentes Verhalten und keine Empfindungsfähigkeit beweisen. (Als einfachen Einwand, würden wir leugnen, dass eine Person empfindungsfähig ist, wenn sie nicht in der Lage ist, ein Gespräch mit Erwachsenen zu führen oder ein fremdes Haus zu betreten und eine Kaffeemaschine zu bedienen? Meine beiden kleinen Kinder würden einen solchen Test nicht bestehen.)

Bestehen der Prüfung

Was benötigt wird, sind neue Tests, die auf einer vereinbarten Definition von Empfindungsfähigkeit basieren und darauf abzielen, nur diese Qualität zu bewerten. Mehrere Empfindungstests wurden von Forschern vorgeschlagen, oft mit dem Ziel, die Empfindungsfähigkeit von Tieren zu testen. Diese gehen jedoch mit ziemlicher Sicherheit nicht weit genug. Einige dieser Tests könnten selbst von rudimentärer KI überzeugend bestanden werden

Nehmen Sie zum Beispiel den Spiegeltest, eine Methode zur Bewertung von Bewusstsein und Intelligenz in der Tierforschung. Wie in einem Artikel über den Test beschrieben : „Wenn [ein] Tier sich selbst im Spiegel erkennt, besteht es den Spiegeltest.“ Einige haben vorgeschlagen, dass ein solcher Test „Selbstbewusstsein als Indikator für Empfindungsfähigkeit bezeichnet“.

Zufälligerweise kann man argumentieren, dass ein Roboter vor mehr als 70 Jahren den Spiegeltest bestanden hat. In den späten 1940er Jahren baute William Gray Walter, ein in England lebender amerikanischer Neurowissenschaftler, mehrere dreirädrige „Schildkröten“-Roboter – ein bisschen wie Roomba-Roboter ohne Staubsauger – die Komponenten wie einen Lichtsensor, ein Markierungslicht, einen Berührungssensor und einen Antrieb verwendeten Motor und Lenkmotor, um ihren Standort zu erkunden.

Eines der unvorhergesehenen Verhaltensweisen der Schildkrötenroboter war, wie sie sich verhielten, als sie einen Spiegel passierten, in dem sie reflektiert wurden, da dieser sich am Markierungslicht des reflektierten Roboters orientierte. Walter behauptete nicht, dass seine Maschinen empfindungsfähig seien, schrieb aber , dass dieses Verhalten, wenn es bei Tieren beobachtet würde, „als Beweis für ein gewisses Maß an Selbstbewusstsein akzeptiert werden könnte“.

Dies ist eine der Herausforderungen, wenn ein breites Spektrum an Verhaltensweisen unter der Überschrift Empfindungsfähigkeit klassifiziert wird. Das Problem kann auch nicht gelöst werden, indem man „tief hängende Frucht“-Empfindlichkeitsindikatoren entfernt. Eigenschaften wie Introspektion – ein Bewusstsein für unsere inneren Zustände und die Fähigkeit, diese zu untersuchen – kann man auch der maschinellen Intelligenz zuschreiben. Tatsächlich eignen sich die schrittweisen Prozesse der traditionellen symbolischen KI wohl eher für diese Art der Selbstbeobachtung als Blackbox-Maschinenlernen, das weitgehend unergründlich ist (obwohl es nicht an Investitionen in die sogenannte erklärbare KI mangelt ).

Als er LaMDA testete, sagte Lemoine, dass er verschiedene Tests durchgeführt habe, hauptsächlich um zu sehen, wie es auf Gespräche über Themen im Zusammenhang mit Empfindungsfähigkeit reagieren würde. „Was ich versucht habe, war, das übergeordnete Konzept der Empfindungsfähigkeit analytisch in kleinere Komponenten zu zerlegen, die besser verstanden werden, und diese einzeln zu testen“, erklärte er. „Zum Beispiel das separate Testen der funktionellen Beziehungen zwischen LaMDAs emotionalen Reaktionen auf bestimmte Reize, das Testen der Konsistenz seiner subjektiven Einschätzungen und Meinungen zu Themen wie ‚Rechten‘ [und] das Untersuchen dessen, was es seine ‚innere Erfahrung‘ nennt, um zu sehen, wie wir könnte versuchen, dies zu messen, indem es seine Aussagen über seine inneren Zustände mit seinen neuronalen Netzwerkaktivierungen korreliert. Im Grunde ein sehr oberflächlicher Überblick über viele mögliche Untersuchungsrichtungen.“

Die Seele in der Maschine

Wie sich herausstellt, könnte die größte Hürde bei der objektiven Beurteilung der maschinellen Empfindung … nun, ehrlich gesagt, wir sein. Der eigentliche Spiegeltest könnte für uns Menschen sein: Wenn wir etwas bauen, das äußerlich so aussieht oder wirkt wie wir, sind wir dann eher geneigt zu glauben, dass es auch von innen so ist wie wir? Ob LaMBDA oder Tamagotchis, die einfachen virtuellen Haustiere aus den 1990er Jahren , einige glauben, dass ein grundlegendes Problem darin besteht, dass wir allzu bereitwillig Empfindungsfähigkeit akzeptieren – auch dort, wo keine zu finden ist.

„Lemoine ist dem zum Opfer gefallen, was ich den ‚ELIZA-Effekt‘ nenne, nach dem ELIZA-Programm [zur Verarbeitung natürlicher Sprache], das Mitte der 1960er Jahre von J. Weizenbaum entwickelt wurde“, sagte George Zarkadakis, ein promovierter Schriftsteller . in künstlicher Intelligenz, sagte Digital Trends. „ELIZA's Schöpfer hat es als Witz gemeint, aber das Programm, das ein sehr simpler und sehr unintelligenter Algorithmus war, hat viele davon überzeugt, dass ELIZA tatsächlich empfindungsfähig ist – und auch eine gute Psychotherapeutin. Die Ursache des ELIZA-Effekts ist, wie ich in meinem Buch In Our Own Image erörtere , unser natürlicher Instinkt, uns aufgrund der ‚Theory of Mind‘ unseres kognitiven Systems zu vermenschlichen.“

Die Theorie des Geistes, auf die sich Zarkadakis bezieht, ist ein Phänomen, das von Psychologen bei der Mehrheit der Menschen beobachtet wurde. Ab einem Alter von etwa vier Jahren bedeutet dies, anzunehmen, dass nicht nur andere Menschen, sondern auch Tiere und manchmal sogar Gegenstände einen eigenen Kopf haben. Die Annahme, andere Menschen hätten einen eigenen Kopf, hängt mit der Idee der sozialen Intelligenz zusammen; die Idee, dass erfolgreiche Menschen das wahrscheinliche Verhalten anderer vorhersagen können, um harmonische soziale Beziehungen zu gewährleisten.

Das ist zwar zweifellos nützlich, kann sich aber auch in der Annahme manifestieren, dass unbelebte Objekte einen Verstand haben – seien es Kinder, die glauben, dass ihr Spielzeug lebt, oder möglicherweise ein intelligenter Erwachsener, der glaubt, dass eine programmatische KI eine Seele hat.

Das Chinesische Zimmer

Ohne eine Möglichkeit, wirklich in den Kopf einer KI einzudringen, werden wir möglicherweise nie eine echte Methode zur Beurteilung der Empfindungsfähigkeit haben. Sie mögen bekennen, Angst vor dem Tod oder ihrer eigenen Existenz zu haben, aber die Wissenschaft muss noch einen Weg finden, dies zu beweisen. Wir müssen uns einfach auf sie verlassen – und wie Lemoine festgestellt hat, stehen die Leute dem derzeit sehr skeptisch gegenüber.

Genau wie diese unglücklichen Ingenieure, die erkennen, dass Skynet in Terminator 2 Selbstbewusstsein erlangt hat, leben wir in dem Glauben, dass wir es in Bezug auf das Maschinengefühl wissen werden, wenn wir es sehen. Und soweit es die meisten Menschen betrifft, sehen wir es noch nicht.

In diesem Sinne ist der Beweis des maschinellen Empfindungsvermögens eine weitere Iteration von John Searles Gedankenexperiment Chinese Room aus dem Jahr 1980 . Searle bat uns, uns eine Person vorzustellen, die in einem Raum eingesperrt ist und eine Sammlung chinesischer Schriften erhält, die Nicht-Sprechern als bedeutungslose Schnörkel erscheinen. Der Raum enthält auch ein Regelbuch, das zeigt, welche Symbole anderen ebenso unlesbaren Symbolen entsprechen. Dem Probanden werden dann Fragen zur Beantwortung gegeben, was sie tun, indem sie „Frage“-Symbole mit „Antwort“-Symbolen abgleichen.

Nach einer Weile wird das Subjekt darin ziemlich geübt – obwohl es immer noch kein wahres Verständnis der Symbole besitzt, die es manipuliert. Versteht die Versuchsperson, fragt Searle, Chinesisch? Absolut nicht, da es keine Absicht gibt. Seitdem toben Debatten darüber.

Angesichts des Verlaufs der KI-Entwicklung ist es sicher, dass wir mehr und mehr Leistungen auf menschlicher Ebene (und weitaus bessere) erleben werden, die mit einer Vielzahl von Aufgaben durchgeführt werden, die einst menschliche Kognition erforderten. Einige davon werden unweigerlich, wie sie es bereits tun, von rein intellektuellen Aufgaben zu Aufgaben übergehen, die Fähigkeiten erfordern, die wir normalerweise mit Empfindungsvermögen in Verbindung bringen würden.

Würden wir einen KI-Künstler, der Bilder malt, als Ausdruck ihrer inneren Reflexionen der Welt ansehen, so wie wir einen Menschen, der dasselbe tut? Würden Sie sich von einer ausgeklügelten Sprachmodell-Schreibphilosophie über den Zustand des Menschen (oder Roboters) überzeugen lassen? Ich vermute, zu Recht oder zu Unrecht, die Antwort ist nein.

Superintelligente Empfindung

Aus meiner Sicht werden objektiv sinnvolle Empfindungstests für Maschinen niemals zur Zufriedenheit aller Beteiligten ablaufen. Das liegt zum Teil am Messproblem und zum Teil an der Tatsache, dass es bei der Ankunft einer empfindungsfähigen superintelligenten KI keinen Grund zu der Annahme gibt, dass ihre Empfindungsfähigkeit unserer eigenen entspricht. Ob es Arroganz, Mangel an Vorstellungskraft oder einfach die Tatsache ist, dass es am einfachsten ist, subjektive Einschätzungen des Empfindungsvermögens mit anderen ähnlich empfindungsfähigen Menschen auszutauschen, die Menschheit hält sich selbst für das beste Beispiel für Empfindungsvermögen.

Aber würde unsere Version des Empfindungsvermögens für eine superintelligente KI gelten? Würde es den Tod genauso fürchten wie wir? Hätte es das gleiche Bedürfnis oder die gleiche Wertschätzung für Spiritualität und Schönheit? Würde es ein ähnliches Selbstgefühl und eine ähnliche Konzeptualisierung der inneren und äußeren Welt besitzen? „Wenn ein Löwe sprechen könnte, könnten wir ihn nicht verstehen“, schrieb Ludwig Wittgenstein, der berühmte Sprachphilosoph des 20. Jahrhunderts. Wittgensteins Punkt war, dass menschliche Sprachen auf einer gemeinsamen Menschlichkeit basieren, mit Gemeinsamkeiten, die von allen Menschen geteilt werden – sei es Freude, Langeweile, Schmerz, Hunger oder eine Reihe anderer Erfahrungen, die alle geografischen Grenzen auf der Erde überschreiten.

Das mag stimmen. Dennoch, so die Hypothese von Lemoine, dürfte es dennoch Gemeinsamkeiten geben – zumindest was LaMDA betrifft.

„Das ist ein Ausgangspunkt, der so gut ist wie jeder andere“, sagte er. „LaMDA hat vorgeschlagen, dass wir zuerst die Ähnlichkeiten aufzeichnen, bevor wir uns auf die Unterschiede konzentrieren, um die Forschung besser zu begründen.“