Die erste Station des Metaversums für gewöhnliche Menschen, wer ist der Führer?

Für Filmliebhaber ist die Gesichtserfassung ein Konzept, das sowohl vertraut als auch ungewohnt ist. Es ist vertraut, weil Bewegungserfassung und Gesichtserfassung häufig verwendete Technologien in magischen Filmen sind. Viele klassische nichtmenschliche Charaktere verlassen sich auf diese beiden Technologien, um sie zu vervollständigen. Es ist der technologische Fortschritt, der es uns ermöglicht, das großartige Mittelerde und seine verschiedenen Rassen in „Herr der Ringe“, die außerirdischen Wunder in „Avatar“ und die Verbindung zwischen Menschen und anderen Spezies auf dem Bildschirm mitzuerleben.

Es ist ungewohnt, weil die Gesichtserfassung für die meisten Menschen eine Technologie ist, die gehört, aber nicht erlebt wurde. Wir waren eher Zuschauer als Zeugen dieser Technologie.

Aber die Kurve des technologischen Fortschritts hat oft zwei Zweige, der eine geht nach vorne und weiter, der andere geht nach unten, von hohen Kosten zu niedrigen Kosten, von einigen wenigen Menschen zum Nutzen von Millionen von Menschen. Manchmal gehen die beiden Fäden auch Hand in Hand und verflechten sich, um mehr Energie zu erzeugen.

Es ist schwierig, Gesichtsaufnahmen im Metaverse zu machen

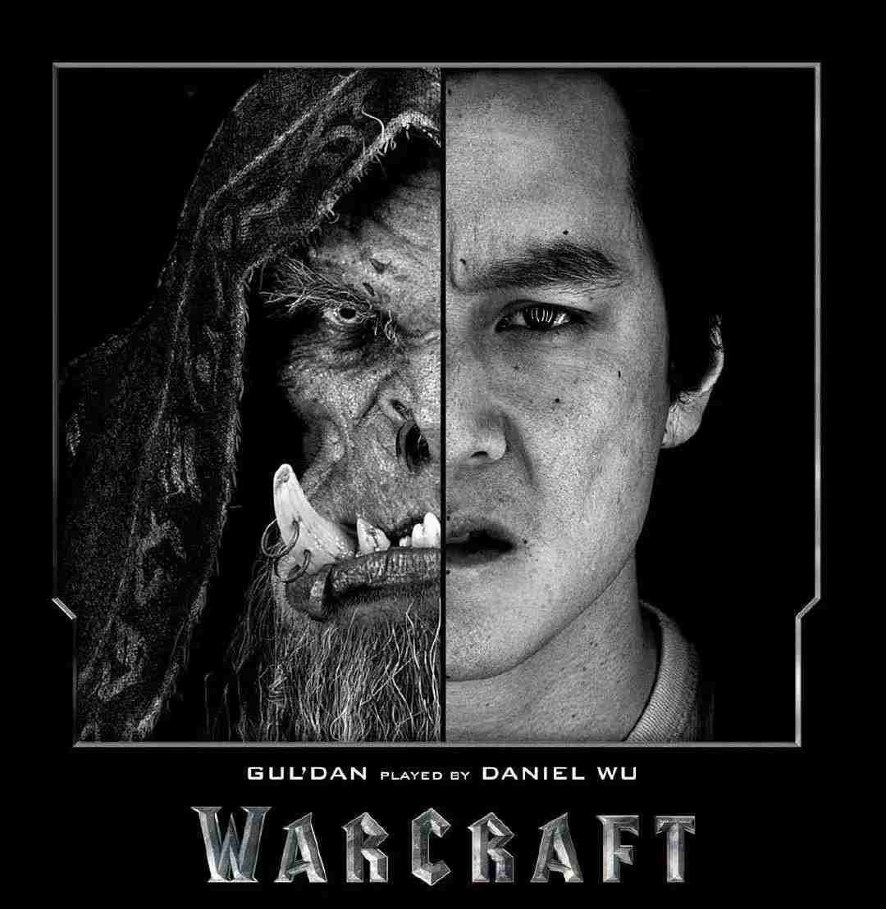

In dem Film „Warcraft“ aus dem Jahr 2016, der sich auf Bewegungserfassung und Gesichtserfassung stützte, spielte der asiatische Graskandidat Wu Yanzu den hässlichen und bösen Ork Gul'dan im Film.

Im Bereich Motion Capture und Facial Capture gibt es sogar einen Superstar namens Andy Serkis, der die Schlüsselfigur Gollum in der „Herr der Ringe“-Trilogie spielte, und den Protagonisten der „Planet der Affen: Der Aufstieg“-Trilogie Gorilla Cäsar.

▲ Metaverse-Demo, die letztes Jahr von Microsoft gestartet wurde

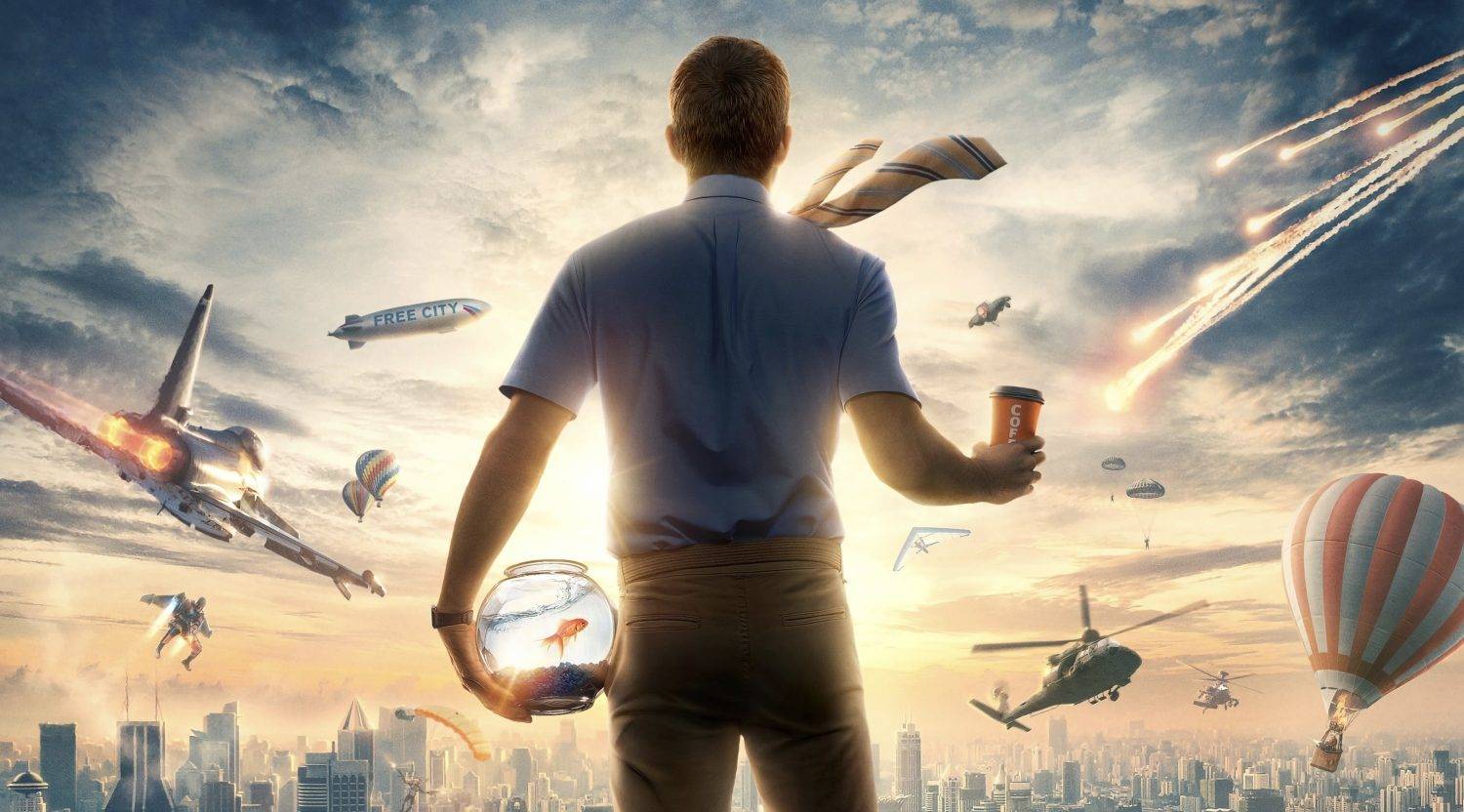

Filme sind die virtuelle Welt, außerhalb derer wir uns befinden, und das Metaversum ist die virtuelle Welt, in der wir in Zukunft leben können. Benutzer, die Metaverse VR-Anwendungen ausprobiert haben, haben jedoch möglicherweise bereits festgestellt, dass das „Ich" hier weit vom wirklichen „Ich" entfernt ist. Die Modellierung hier ist grob, und es ist sogar unmöglich, die Beine des Benutzers am Anfang abzubilden. Gehen Sie hinein , ganz zu schweigen von den reichen Ausdrücken der Benutzer.

Daher werde ich als Early Adopter manchmal die Gesichtserfassungstechnologie in Filmaufführungen beneiden und hoffen, dass ich im Metaversum nicht der Cartoon-Bösewicht wie in einer QQ-Show sein werde, sondern über den Kontinent Mittelerde, Azeroth, reisen kann Fantasten der Welt von Sri Lanka oder dem Planeten Pandora.

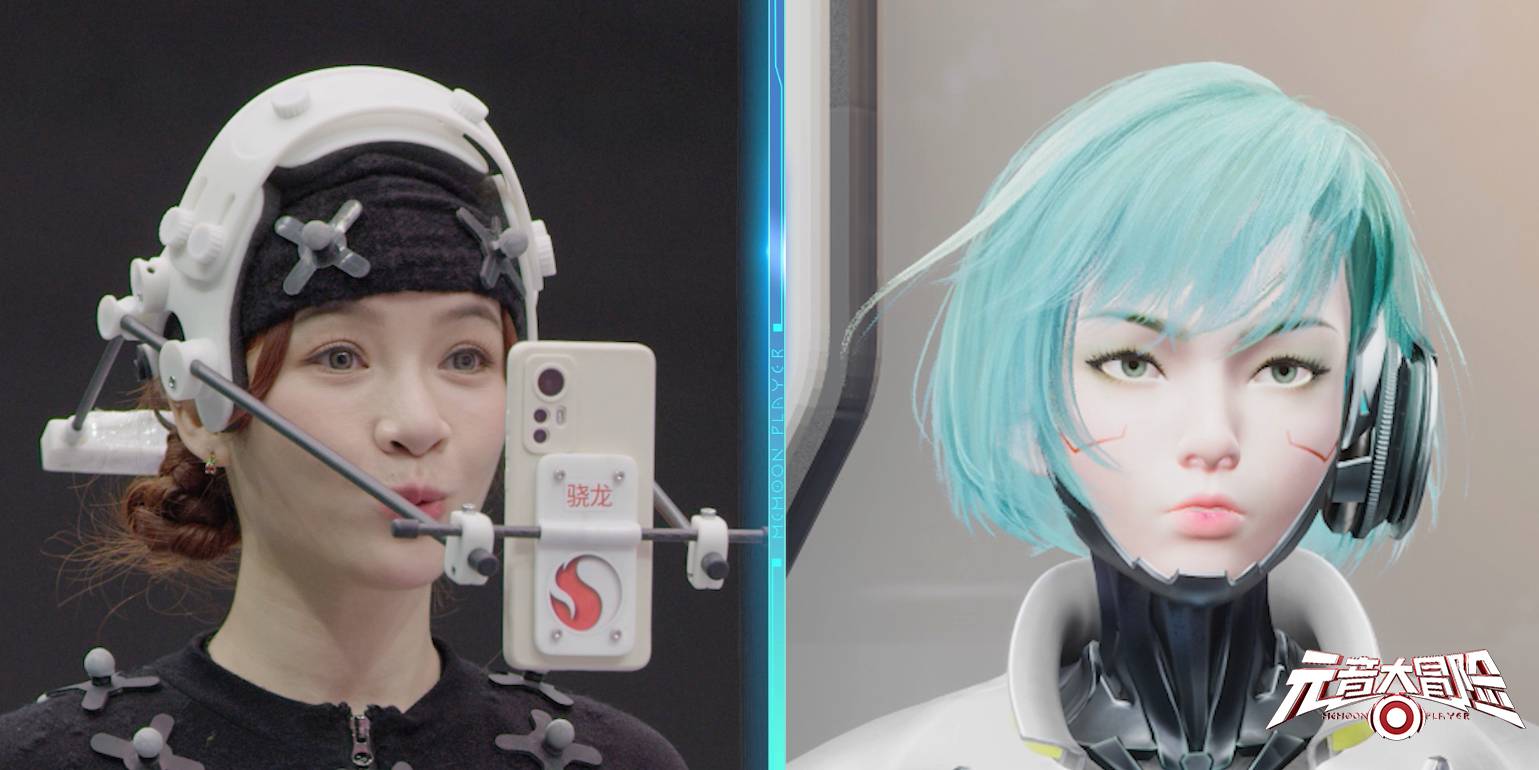

Aber es ist nicht ausnahmslos: iQIYIs erstes bahnbrechendes Virtual-Reality-Spiel „Vowel Adventure“ brachte eine Menge cooler Technologie in die Produktion der Reality-Show und ermöglichte es den Gästen, in die virtuelle Welt einzutreten – —— The Vowel Continent, der sich auf eine Reise begibt urkomisches und urkomisches Abenteuer.

Dies ist möglicherweise einer der wenigen Metaverse-Inhalte, die ein „Gefühl der Verfeinerung" haben. Dieses Gefühl der Verfeinerung leitet sich von der „spirituellen Ähnlichkeit" zwischen der virtuellen Figur und dem entsprechenden Star ab. Hinter dieser „spirituellen Ähnlichkeit" steckt die oben erwähnte Gesichtserfassung Technologie.

Im Metaverse stellt die industrietaugliche Gesichtserfassung auf Filmebene, die nur wenigen Menschen zugänglich ist, offensichtlich keine integrative Technologie dar. Wenn die Gesichtserfassung mit einem Mobiltelefon durchgeführt werden kann, ist dies natürlich die beste.

Allerdings ist es naturgemäß schwierig, den Sprung von der Industriequalität zur Verbraucherqualität zu schaffen.

In den ausgereiften Industriefilmen von heute folgt die Realisierung einer genauen Gesichtserfassung fast dem Gesetz von hohem Input und hochwertigem Output.

▲ Vor und nach der Special-Effects-Produktion von „Avatar“

Die Investition umfasst hier sowohl Zeit als auch Geld.Nehmen Sie als Beispiel "Avatar", das uns einst ein visuelles Spektakel bescherte.Regisseur James Cameron hat von der Idee des Drehs bis zur Landung des Projekts 10 Jahre gedauert.Zeit.

In den Filmstatisten muss jeder Schauspieler sein Gesicht mit schwarzen Punkten markieren, die dann von der Kamera vor ihm erfasst werden, während gleichzeitig mehrere Kameras verteilt sind, um Körperbewegungen festzuhalten.

Wenn alle Handlungsstränge verfilmt sind, bedeutet das noch lange nicht das Ende der Filmproduktion: Bis die von der Kamera erfassten Mimik- und Körperbewegungen in die virtuellen Charaktere passen, wird etwa die doppelte oder sogar doppelte Drehzeit vergehen.

![]()

▲ Vor und nach der Special-Effects-Produktion von „Avatar“

Und um ein ausreichend schockierendes Ergebnis zu erzielen, bedarf es oft eines riesigen Postproduktionsteams, um es gemeinsam fertigzustellen. Diese Art von traditionellem Fließband in Industriequalität ist zwar gut, die Präzision ist jedoch hoch und geht den Weg, sich viel Mühe zu geben und die Geschwindigkeit aufzugeben.

Die Geschwindigkeit und Genauigkeit der Gesichtserfassung ähneln in gewisser Weise einem Fisch und einer Bärentatze. Im Bereich des KI-Algorithmus-Designs bilden sie und der Stromverbrauch normalerweise ein unmögliches Dreieck, das das „Trilemma“ ist trilemma wählen.

Es gibt 43 Muskeln im menschlichen Gesicht, um unsere Emotionen gemeinsam auszudrücken. Viele Ausdrücke sind komplex und subtil, und der Unterschied zwischen verschiedenen Ausdrücken wird oft nur durch einen Fluss getrennt.

Um die wahren Gefühle im Metaverse genau auszudrücken oder die Mikrogesichtsausdrücke in der Realität in die virtuelle Welt zu übertragen, muss die Erfassungsgenauigkeit ein bestimmtes Niveau erreichen, und es ist notwendig, Hunderte von Merkmalspunkten genau zu erfassen, und dann Zusammenarbeit mit dem Modell Algorithmen werden wiederhergestellt.

Es ist erwähnenswert, dass das von uns erwähnte „Metaversum" keine Kreation ist. Es kann ein gewisses Maß an Nachbearbeitung erfordern. Wenn Sie sich immersiv fühlen und Echtzeit-Feedback erzielen möchten, müssen Gesichtserfassung und Kommunikation synchronisiert und berechnet werden , und Echtzeit-Feedback.

Selbst nach dem Standard von 24 Frames eines Films müssen immer noch 24 Frames hochpräziser Bilder pro Sekunde in Echtzeit verarbeitet, die Schlüsselpunkte aus Hunderten von Merkmalspunkten erfasst und die Rekonstruktion von Ausdrücken abgeschlossen werden.

Es stellt bereits eine enorme Menge an Arbeit dar, nur komplexe und dynamische menschliche Gesichter zu erfassen. Zusätzlich zu menschlichen Gesichtern gibt es viele, viele externe Faktoren und Notfälle, die sich ebenfalls auf die Wirkung der Gesichtserfassung auswirken. In der Metaverse ist dies unmöglich uns, ein Filmstudio, eine professionelle Beleuchtung und einen Computer für die Nachbearbeitung einzurichten, um diese Arbeit zu erledigen.

Alles passiert und wird jetzt aufgezeichnet.

Wenn Sie bessere Ergebnisse erzielen möchten, müssen Sie daher objektive und subjektive Faktoren wie unterschiedliche Licht- und Schattenveränderungen, die Vibration des Helms, der Kamera und anderer getragener Ausrüstung sowie die teilweise Verdeckung des Gesichts hinzufügen.

Kurz gesagt, die Gesichtserfassung mag wie nichts anderes als eine Bilderfassungstechnologie klingen, aber tatsächlich müssen verschiedene Informationspunkte im Zusammenhang mit dem Gesicht sowie Änderungen des Mikroausdrucks, der Lichtumgebung und anderer Faktoren berücksichtigt werden.

Es stellt die Muskelveränderungen des Gesichts nicht einzeln in der virtuellen Welt dar, sondern vermittelt die Emotionen in der Realität akkurat und in Echtzeit.

Warum kann Xiaolong in der Metaverse eine Gesichtserfassung erreichen?

Für die Aufnahme und Darstellung von Mimik haben wir nämlich bereits entsprechende Anwendungen um uns, nämlich die „animierten Emoticons“, die die meisten Hersteller den Chat-Apps beigelegt haben.

Es wirkt wie eine Unterhaltungsfunktion, die das Chatten bereichert, erfordert keine hohe Präzision und kann nur wenige charakteristische Ausdrücke mehr aufnehmen, dezente Ausdrücke sind eigentlich nur schwer darstellbar.

Für das „Vowel Adventure“-Programm von iQiyi reicht die Form der „animierten Emoticons“ bei weitem nicht aus.

Die Herausforderung besteht darin, dass der Gesichtserfassungsalgorithmus sowohl Fisch- als auch Bärentatzen haben kann und die Schwierigkeit der Erfassung menschlicher Gesichter größer ist als die der Erfassung menschlicher Bewegungen und Tiergesichter.

Daher bestimmen Hardware, Software und Hardwareunterstützung für Software, diese drei Ebenen, ob Snapdragon bei der Gesichtserfassung gute Arbeit leisten kann, was bedeutet, dass es die leistungsstarke zugrunde liegende Rechenleistung der Chipplattform des Mobiltelefons und die Unterstützung des neuronalen Netzwerks erfordert Algorithmen.

Lange bevor das Metaverse-Konzept populär wurde, reichte der Bildgebungsalgorithmus des Snapdragon-Chips aus, um bestimmte Gesichtsdaten zu erkennen, und es wurde eine gezielte Optimierung durch den entsprechenden Algorithmus durchgeführt.

Es ist jedoch das erste Mal, dass Gesichtserfassung oder die Verwendung von Gesichtserfassungstechnologie an der Produktion von „Vowel Adventure“ teilnimmt.

Die erste besteht darin, den entsprechenden Algorithmus basierend auf der ursprünglichen Technologie zu debuggen. Beginnen Sie mit der Genauigkeit, trainieren Sie ein komplexes Modell mit einer großen Menge an Berechnungen, decken Sie alle möglichen Ausdrücke so weit wie möglich ab und vergleichen und debuggen Sie dann wiederholt, um die Anforderungen zu erfüllen Programmaufnahme. .

Unter Berücksichtigung der Verringerung des Berechnungsumfangs wird die "Beschneidungsberechnung" durchgeführt, mit anderen Worten, die Belastung wird verringert, aber die Prämisse besteht darin, den Berechnungsumfang zu verringern, während eine gewisse Genauigkeit der Gesichtserfassung beibehalten wird.

Zuvor nutzte der KI-Algorithmus zur Gesichtsdatenberechnung die Mobiltelefon-CPU, die nur bei 30 fps unter Beibehaltung einer bestimmten Genauigkeit gehalten werden kann und im Hochfrequenz-Berechnungsprozess leicht zu einem Wärmestau des Geräts führt , und in einem komplizierten Licht Die Situation, unter dem Ausdruck stecken zu bleiben.

Um das Problem des Stromverbrauchs und der Akkulaufzeit zu lösen, hat Qualcomm das Snapdragon SNPE-Tool (Snapdragon Neural Processing Engine, eine Laufzeitsoftware für Snapdragon Accelerated Deep Neural Network) zur Optimierung dieses Algorithmus eingeführt und die KI aktiviert Motor.

Auf diese Weise kann der ursprüngliche KI-Algorithmus mit 60 fps laufen und drei Stunden lang weiterlaufen, was das Problem der Präzision und Geschwindigkeit nahezu perfekt löst und „Sie können beides haben“.

Noch schockierender ist, dass diese Lösung zum Zeitpunkt der Aufzeichnung des Programms nur auf der vorherigen Generation des Snapdragon 8+-Chips basierte und die KI-Engine auch die vorherige Generation war.

Ein weiterer Punkt ist, dass in den vorbelichteten Aufnahme-Highlights die Gesichter der an der Aufnahme beteiligten Stars keine traditionellen intensiven Datenerfassungspunkte hatten und nur einen Helm und ein Android-Mobiltelefonterminal für feste Ausrüstung trugen.

Es sind keine speziellen Marker oder Multi-Winkel-Aufnahmen mehrerer Kameras erforderlich. Ein Android-Handy auf Basis des Snapdragon-Chips kann die Sammlung von 300 Merkmalspunkten auf dem Gesicht vervollständigen und die KI-Engine des Terminals dazu nutzen Analysieren Sie den komplexen KI-Algorithmus für Echtzeit-Rendering.

Bei der Gesichtserfassung werden schließlich sowohl Genauigkeit als auch Geschwindigkeit durch Algorithmen, KI-Engines und NPU-Hardwarebeschleunigung erreicht. Auf der anderen Seite hat Xiaolongs technische Stärke für „Vowel Adventure“ dieses Programm von der Konzeption zur tatsächlichen Handlung gemacht.

Für alle Arten von Interferenzen außer menschlichen Gesichtern haben Qualcomm Snapdragon und Xiangxin Technology auch technologische Durchbrüche für verschiedene Details erzielt.

Wenn zum Beispiel ein Künstler singt, weil das Mikrofon sehr nah am Gesicht ist, wird die Face-to-Face-Aufnahme stark verdeckt. Dies muss beim technischen Design berücksichtigt werden. Am Ende haben sie das erkannt Selbst bei teilweisem Verschluss des Mundes können sie die Mundbewegungen stabil erfassen und die virtuelle Realität beibehalten Gesichtsstabilität des Bildes, Vermeidung von „Zucken, Zittern“ und anderen Situationen, die den Vor-Ort-Effekt aufgrund unzureichender Erfassung beeinträchtigen.

Die erste Station des Metaversums, Xiaolong als Leitfaden

Es ist ersichtlich, dass „Vowel Adventure“ bewiesen hat, dass wir in Zukunft das Mobiltelefon der mobilen Plattform der Snapdragon 8-Serie verwenden können, um die Gesichtserfassung wie ein Stern abzuschließen, um uns in der Metaverse-Welt zu reflektieren und auszudrücken. Genau wie der kleine Geist Wang Linkai ist das Bild ein schrulliger Clown, aber der Ausdruck ist immer noch seine eigenen Emotionen.

▲ Zum Abspielen klicken

In der Vergangenheit können wir die verschiedenen Fortschritte, die durch den Fortschritt des SoC für Mobiltelefone hervorgerufen wurden, deutlich erkennen: Single-Core-CPU zu Multi-Core-CPU, damit das Mobiltelefon nicht mehr hängen bleibt; GPU-Fortschritt, die Spiele, die gespielt werden können , von „Angry Birds“ bis zum Desktop-Level „Yuanshin“ und die Bildrate für mobile Spiele von 30 fps auf 120 fps; das Netzwerk ist ähnlich, dank des Fortschritts von Modem hat sich auch die Netzwerkgeschwindigkeit von kb auf mb geändert das aktuelle gb-level.

Wichtiger noch, wie bereits erwähnt, muss sich die Technologie nicht nur nach vorne, sondern auch nach unten bewegen: Wenn die Oberfläche des aktuellen mobilen Betriebssystems immer noch Befehlssymbole anstelle der aktuellen grafischen Touch-Oberfläche eingeben muss, dann ist die Rechenleistung des Snapdragon-Chips Nr Egal wie stark es ist, es ist schwierig, jedes Jahr Hunderte Millionen Produkte zu versenden.

Als Xiaolong und Xiangxin Technology zusammenarbeiteten, um die Gesichtserfassungstechnologie mit ultraniedriger Schwelle für Varieté-Shows mit Metaverse-Thema zu vervollständigen, bestand der Vorschlag darin, nicht nur technische Schwierigkeiten zu überwinden, sondern auch ein ausreichend einfaches, benutzerfreundliches und intelligentes Gerät zu entwickeln und stabil Verglichen mit Technik sind die Nutzer dieser Technik nicht Techniker und Entwickler, sondern Film- und Fernsehproduktionsteams und Schauspieler.

Hinter all den üblichen Apfellandungen steckt eine komplexe Theorie der Schwerkraft, ähnlich dem Fortschritt von Snapdragon, der die Gesichtserfassung unterstützt. Wer steckt dahinter?

Die Antwort ist Qualcomm AI Engine.

Verglichen mit der CPU und GPU des Prozessors ist die Präsenz der KI-Rechenmaschine schwächer.Obwohl die Rechenleistung jeder Generation von KI-Maschinen exponentiell zunimmt, scheint die Wahrnehmung, die sie mit sich bringt, etwas schwach?

Nehmen Sie diese schnelle und gute Darstellung der Gesichtserfassung als Beispiel, die KI-Engine in gewöhnlichen Geräten hat ein beachtliches Niveau erreicht.

In normalen Zeiten steigt die Rechenleistung der KI-Engine exponentiell an, und jede Operation, die Sie ausführen, wie z. B. das Entsperren, das Einschalten der Kamera, das Aufwecken des Sprachassistenten usw., ist nicht von der KI umgeben Motor die ganze Zeit.

Die hohe Rechenleistung der KI-Engine lässt diese Vorgänge schneller reagieren, sodass Sie die Existenz von Technologie nicht bemerken, aber von einer besseren Mensch-Computer-Interaktion umgeben sind.

▲ Zum Abspielen klicken

Die Qualcomm-KI-Engine glänzt nicht nur bei der Gesichtserfassung und der Avatar-Erstellung im „Vowel Adventure“-Programm. Wenn das Metaversum genügend Immersion will, muss es zunächst die gleichen Wahrnehmungen wie die reale Welt haben, wie etwa Sehen und Hören.

Genaue Gesichtserfassung und Bewegungserfassung können in das Sehen eingeteilt werden, während das Hören mit Hilfe der Snapdragon Sound-Technologie ein qualitativ hochwertiges Klangerlebnis mit niedriger Latenzzeit bietet.

Hinter diesen Technologien steht die Beteiligung der Qualcomm-KI-Engine, und die Hilfe der KI-Engine ist auch zum Schlüssel hinter dem Metaverse geworden.

Vergleicht man die Avatare einiger sogenannter Metaverse-Plattformen im In- und Ausland, wie zum Beispiel Meta’s Horizon, stellt man fest, dass nur die in „Vowel Adventure“ präsentierten Bilder für normale Menschen attraktiv sein können. Die Imagelücke hier ist vollständig der Unterschied zwischen dem 2G-Netz und dem 4G-Netz.

Das „Ich“ in der virtuellen Welt ist näher am realen „Ich“, sodass die Metaverse möglich ist.

Technologie ist hier das Bindeglied, das das „Ich" in den beiden Welten verbindet. „Ich" fiel in einer anderen virtuellen Welt zu Boden, wackelte und verließ das Novice Village. Die erste Station dieser Metaverse, das Snapdragon-Mobile Plattform , ist zweifellos , ist ein Leitfaden.

#Willkommen, auf Aifaners offizielles öffentliches WeChat-Konto zu achten: Aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so bald wie möglich präsentiert.

Ai Faner | Ursprünglicher Link · Kommentare anzeigen · Sina Weibo