Die Popularität von ChatGPT könnte Nvidia einen unerwarteten Schub geben

Die ständige Aufregung um ChatGPT von OpenAI lässt nicht nach. Da Microsoft jetzt dieselbe Technologie für seinen brandneuen Bing Chat verwendet, kann man mit Sicherheit sagen, dass ChatGPT diesen Aufwärtstrend noch einige Zeit fortsetzen wird. Das sind gute Nachrichten für OpenAI und Microsoft, aber sie sind nicht die einzigen beiden Unternehmen, die davon profitieren.

Einem neuen Bericht zufolge könnten die Verkäufe von Nvidias Grafikkarten für Rechenzentren in die Höhe schnellen. Mit der Kommerzialisierung von ChatGPT benötigt OpenAI möglicherweise bis zu 10.000 neue GPUs, um das wachsende Modell zu unterstützen – und Nvidia scheint der wahrscheinlichste Lieferant zu sein.

Das Forschungsunternehmen TrendForce hat heute einige interessante Schätzungen veröffentlicht, und das Interessanteste betrifft die Zukunft von ChatGPT. Laut TrendForce wird das GPT-Modell, das ChatGPT antreibt, bald eine beträchtliche Erhöhung der Hardware benötigen, um die Entwicklung zu skalieren.

„Die Anzahl der Trainingsparameter, die bei der Entwicklung dieses autoregressiven Sprachmodells verwendet wurden, stieg von rund 120 Millionen im Jahr 2018 auf fast 180 Milliarden im Jahr 2020“, so TrendForce in seinem Bericht. Obwohl es keine Schätzungen für 2023 gab, kann man davon ausgehen, dass diese Zahlen nur so weit steigen werden, wie es die Technologie und das Budget zulassen.

Das Unternehmen behauptet, dass das GPT-Modell im Jahr 2020 satte 20.000 Grafikkarten benötigte, um Trainingsdaten zu verarbeiten. Mit der weiteren Expansion wird diese Zahl voraussichtlich auf über 30.000 steigen. Das könnten großartige Neuigkeiten für Nvidia sein.

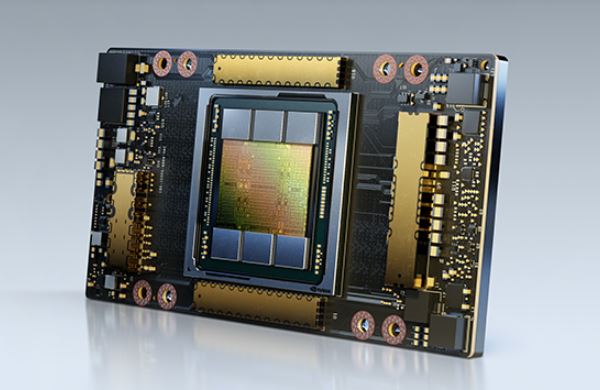

Diese Berechnungen basieren auf der Annahme, dass OpenAI die A100-GPUs von Nvidia verwenden würde, um das Sprachmodell zu betreiben. Diese ultraleistungsstarken Grafikkarten sind wirklich teuer – in der Größenordnung von 10.000 bis 15.000 US-Dollar pro Stück. Sie sind derzeit auch nicht die Top-Rechenzentrumskarten von Nvidia, daher ist es möglich, dass OpenAI stattdessen auf die neueren H100-Karten setzt, die eine bis zu dreifache Leistung von A100 liefern sollen. Diese GPUs sind mit einem starken Preisanstieg verbunden, wobei eine Karte etwa 30.000 US-Dollar oder mehr kostet.

Der GPU-Markt für Rechenzentren besteht nicht nur aus Nvidia – Intel und AMD verkaufen auch KI-Beschleuniger. Nvidia wird jedoch oft als die erste Wahl für KI-bezogene Aufgaben angesehen , daher ist es möglich, dass es einen lukrativen Deal erzielen kann, falls und wenn OpenAI beschließt, zu skalieren.

Sollten sich Spieler Sorgen machen, wenn Nvidia tatsächlich satte 10.000 GPUs liefert, um ChatGPT zu starten? Es hängt davon ab, ob. Die von OpenAI geforderten Grafikkarten haben nichts mit Nvidias besten GPUs für Gamer zu tun, da sind wir also auf der sicheren Seite. Wenn Nvidia jedoch einen Teil der Produktion auf Rechenzentrums-GPUs verlagert, könnten wir auf lange Sicht ein begrenztes Angebot an Consumer-Grafikkarten sehen. Realistisch gesehen sind die Auswirkungen möglicherweise nicht so schlimm – selbst wenn die 10.000-GPU-Vorhersage zutrifft, muss Nvidia nicht alle sofort liefern.