Aus diesem Grund tanzten Musk und die Terrakotta-Armee „Subject Three“

Ein einziges Foto kann Musk, Messi und andere Berühmtheiten magisch tanzen lassen, und sogar das im gesamten Internet beliebte Motiv drei lässt sich arrangieren.

Dies ist keine fortschrittliche KI-Technologie. Alibaba Tongyi Qianwens neu hinzugefügte „National Dance King“-Funktion auf dem mobilen Endgerät kann dies realisieren. Es gibt außerdem 12 beliebte Tanzvorlagen wie Thema drei, DJ Slow Rocking, Ghost Step Dance und Bliss Dance . Sie treffen Ihre Wahl.

Geben Sie Passwörter wie „National Dance King“ und „Tongyi Dance King“ in Tongyi Qianwen ein, wählen Sie dann Ihren Lieblingstanz in der Sprungoberfläche aus und laden Sie ein Ganzkörperfoto hoch. Es dauert nur zehn Minuten, einen Tanz zu erstellen, der sowohl physisch ist und spirituell. Der König war so herrlich „schnell vollendet“.

Unerwarteterweise könnte sich Einstein mit dicken Augenbrauen und großen Augen im Handumdrehen in einen trendigen Mann verwandeln, und der Rhythmus seiner Bewegungen ist nicht zu stark.

▲ Bild von: Simon_Awen

Es gibt nur ein Foto zwischen den Terrakotta-Kriegern und dem König des Tanzes, und diese Haltung kann nicht in den Schatten gestellt werden.

Der König des Tanzes in der Figurenwelt dominiert, wie können sie mich, Nicholas Zhao Si, den „asiatischen Tanzkönig“ ignorieren?

▲ Bild von: Gongfu Finance

Die kleinen Figuren, die ich gezeichnet habe, tanzten alle fröhlicher als ich. Es scheint, dass ich mich für einen Tanzkurs anmelden muss.

▲ Bild von: Bruder Dao Hu Kan

Crayon Shin-chan „kratzt sich am Kopf und macht Posen“, und seine Kindheit ist augenblicklich zurück.

▲ Bild von: Panhua-Hund

KI-Magie, die Fotos „lebendig“ macht

Wie hat das KI-Forschungsteam von Alibaba Fotos bewegt?

Die Veröffentlichung der Tongyi Dance King-Funktion ist eigentlich eine spezifische Anwendung und Implementierung der AnimateAnyone-Technologie.

Laut einem vom Alibaba AI-Forschungsteam veröffentlichten Artikel stellen Diffusionsmodelle derzeit den Mainstream im Bereich der visuellen Generierungsforschung dar. Im Bereich der Bild-zu-Video-Generierung gibt es jedoch immer noch Probleme wie lokale Verzerrungen und unscharfe Details und Framerate-Jitter.

In diesem Zusammenhang schlug das KI-Forschungsteam von Alibaba einen neuen KI-Algorithmus „Animate Everyone“ vor, der auf dem Diffusionsmodell basiert. Die Funktion dieses Algorithmus besteht darin, ein statisches Charakterbild in ein animiertes Video umzuwandeln, und gleichzeitig können die Charakterbewegungen im Video durch Eingabe der Haltungsfolge präzise gesteuert werden.

▲Darstellung des Prinzips des Daumenkinos. Bild von: @flipping book Andymation

Es ist zu beachten, dass bei der Videoproduktion, insbesondere bei der Animationsproduktion, die Bewegungen der Charaktere durch Bild-für-Bild-Übergänge vervollständigt werden. Das Prinzip ähnelt dem Daumenkino, mit dem ich als Kind oft gespielt habe. Jede Seite ist ein statischer handgezeichneter Entwurf, der schnell umgedreht werden kann. Bewegen Sie den Bildschirm durch die „Persistenz des Sehens“-Bug des menschlichen Auges.

Die größte Schwierigkeit beim Bewegen eines Bildes besteht darin, sich die nächsten Aktionen und Szenen „vorzustellen“, und es gibt keinen Bezug davor oder danach. Daher können Sie in der offiziellen Vergleichsanzeige sehen, dass die traditionelle Technologie „DisCO“ immer wieder als negatives Lehrmaterial verwendet wurde. Ihr starker Verzerrungseffekt kann das Motiv nur bewegen, die verdrehte Körperform und die seltsamen Bewegungseffekte jedoch nicht würdig, überhaupt genannt zu werden. Arbeit.

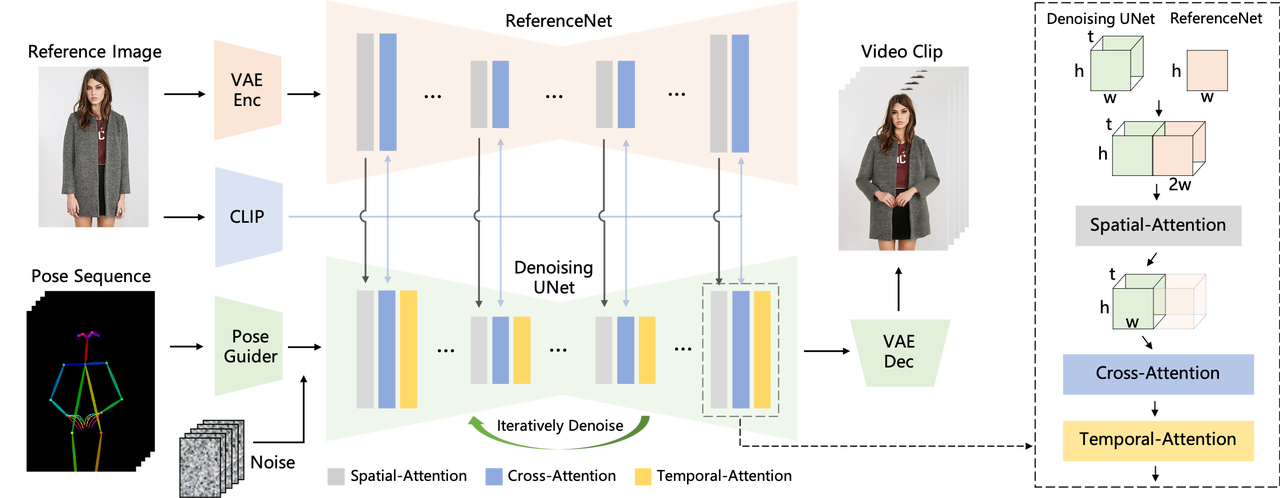

Um das Problem der Bildkonsistenz von Videozeichen zu lösen, führten sie daher das Referenzbildnetzwerk ReferenceNet ein, das die räumlichen Detailinformationen im Referenzbild erfassen kann.

Anschließend kombinierten sie ReferenceNet mit UNet, sodass UNet verstehen konnte, wo und welche Details beim Generieren des Zielbilds generiert werden sollten, sodass das generierte Bild das Rauschen insgesamt entfernen und gleichzeitig wichtige Details im Referenzbild beibehalten kann. Erzielen Sie eine Konsistenz des Zeichenbilds .

Neben der Erfassung von Details muss auch die Kontrollierbarkeit der Körperhaltung gewährleistet sein. Zu diesem Zweck hat das Alibaba AI-Team außerdem einen leichten Pose-Guider, Pose Guider, entwickelt, der Pose-Steuersignale während des Entrauschungsprozesses integriert, um sicherzustellen, dass die generierte Animationssequenz der angegebenen Pose entspricht.

Im Hinblick auf die Stabilität des Videos führten sie außerdem ein Timing-Generierungsmodul ein, das es dem Modell ermöglicht, die Verbindung zwischen Bildern zu lernen, sodass das generierte Video glatt und kohärent statt fragmentiert ist, während gleichzeitig eine hohe Auflösung beibehalten wird und die Bildqualität verbessert wird und stabiler.

Im Vergleich zu früheren Methoden kann diese Methode die Konsistenz des Erscheinungsbilds der Videozeichen effektiv aufrechterhalten, ohne dass Probleme wie die Änderung der Kleidungsfarbe auftreten. Gleichzeitig ist das Video glatt und klar, ohne Flackern und Zittern, und das auch Unterstützt die dynamische Animation jedes Charakters. Änderung.

Messi spielt zum Beispiel mit dem Top-Stil, der bei Menschen mittleren und älteren Alters beliebt ist, und hebt seine Hand, um Sie zu begrüßen.

Die zweidimensionalen Charaktere bewegen sich in einem stillen Zustand, und wenn sie House-Tänze tanzen, sind sie nicht weniger beeindruckend als echte Menschen.

Sogar Iron Man machte mit, hielt sich fit und dehnte seine Muskeln, und daran war nichts auszusetzen.

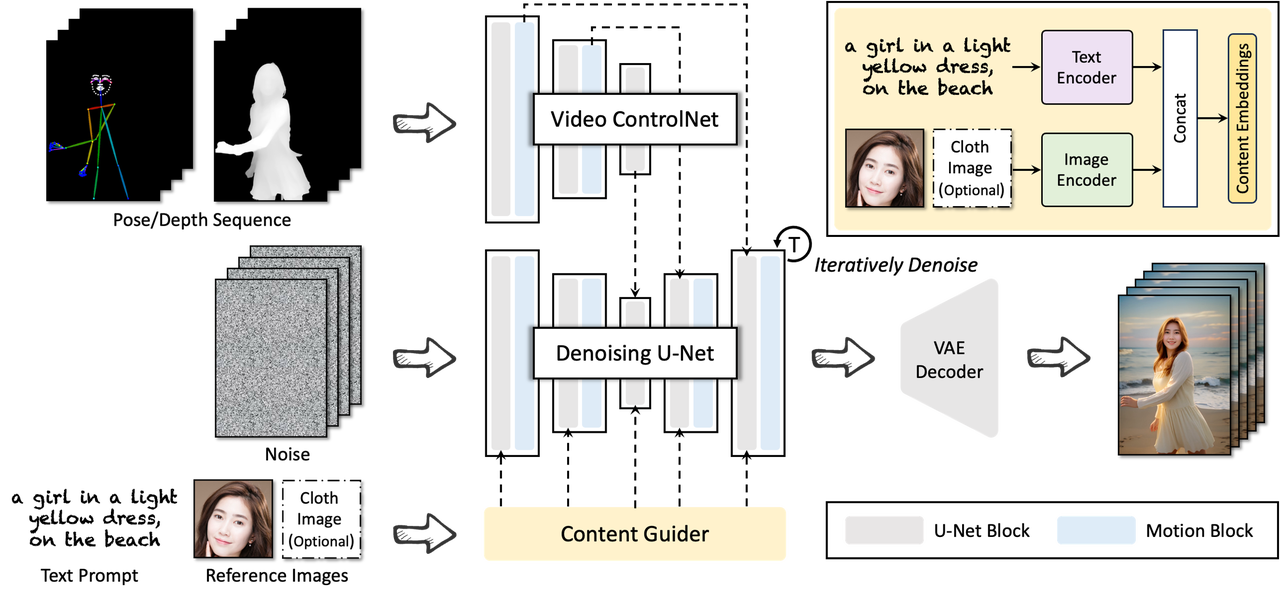

Im Bereich der KI-Videogenerierung geht die Technologieakkumulation hinter Alibaba darüber hinaus. Beispielsweise hat Alibaba letzten Monat auch eine weitere Videogenerierungstechnologie veröffentlicht, DreaMoving. Dabei handelt es sich um ein diffusionsbasiertes, steuerbares Videogenerierungs-Framework zur Generierung hochwertiger, maßgeschneiderter Porträtvideos.

Der Vorteil dieser Technologie besteht darin, dass keine tiefgreifenden Kenntnisse komplexer Videoproduktionstechniken erforderlich sind. Den Benutzern muss lediglich eine Anleitung gegeben werden, beispielsweise ein Text oder ein Referenzbild, und schon kann DreaMoving äußerst realistische Videos erstellen.

Mit anderen Worten: Solange die Zielidentität und die Posensequenz angegeben sind, kann DreaMoving basierend auf der Posensequenz ein Video von jeder Person/jedem Objekt erstellen, das irgendwo tanzt.

Einfach ausgedrückt kann DreaMoving durch einfache Eingaben wie Gesichtsbilder, Aktionssequenzen und Text automatisch verschiedene benutzerdefinierte Charaktervideos generieren und so eine präzise Kontrolle über die Videogenerierung erreichen.

Spezifische Demontageschritte: Geben Sie zuerst das Gesichtsbild einer Person ein, um das Bild des gesamten Körpers der Person im Video zu erzeugen, geben Sie dann die Haltungsfolge ein, um die Bewegungen der Figur im Video genau zu steuern, und geben Sie schließlich Text ein, um die Videogenerierung umfassender zu steuern Auswirkungen.

Zum Beispiel ein lächelndes Mädchen, das am Strand am Meer steht und ein hellgelbes, langärmliges Kleid trägt.

Ein Mann tanzt vor der Pyramide von Ägypten, trägt Anzug und blaue Krawatte.

Ein Mädchen in einem hellblauen Kleid lächelt und tanzt in einer französischen Stadt

Die Branche der KI-Videogenerierung spielt verrückt

Tatsächlich ist der Startschuss für den Bereich der KI-Videogenerierung im Bereich der generativen KI noch nicht zu spät. Vor der Geburt von ChatGPT hatten viele Hersteller, wie Microsoft und Google, bereits auf diesen Weg gesetzt. Ähnliche KI-Videogenerierung Es wurden Werkzeuge verwendet, aber der Effekt ist minimal.

Basierend auf der langfristigen Technologieakkumulation der gesamten Branche ermöglicht das Aufkommen des Diffusionsmodells den Herstellern, die potenziellen Perspektiven der KI-Videoerzeugung zu erkennen. Es hat offensichtliche Vorteile gegenüber frühen Modellen wie RNN. Es kann kohärentere und klarere Bilder oder Videosequenzen erzeugen und so den iterativen Prozess der Videogenerierung beschleunigen.

Auch die Mainstream-Tools auf dem Markt haben auf dieser Basis großartige Ergänzungen vorgenommen, wodurch der Bereich der KI-Videogenerierung erneut für Aufsehen gesorgt hat und wirklich einen erstaunlich explosiven Trend zeigt.

Ende letzten Jahres erhielt Runway Gen-2 ein umfangreiches Update, bei dem die Auflösung auf 4K erhöht wurde und ein großer Durchbruch in der Wiedergabetreue und Konsistenz der Videogenerierungseffekte erzielt wurde. Eine Woche später wurde die Bewegungspinselfunktion erneut eingeführt. Mit einem Mit einem einzigen Pinsel können Sie statische Dinge bewegen.

Unmittelbar danach veröffentlichte Stability AI, das „Rückgrat“ von Wenshengtu, auch Stable Video Diffusion und sorgte damit für einen weiteren Boom im Bereich der KI-Videogenerierung.

Pika 1.0 hingegen hat seit seinem Debüt die Gunst vieler Silicon-Valley-Chefs gewonnen, da es einfachere Videogenerierung, leicht verständliche Teilvideobearbeitung und qualitativ hochwertigere Videogenerierung bietet. Von der Generierung bis zur Postproduktion können Sie alles aus einer Hand erledigen.

Das von Li Feifeis Team in Zusammenarbeit mit Google eingeführte WALT-Modell kann auch realistische 2D/3D-Videos oder Animationen basierend auf natürlichen Sprach-/Bildaufforderungen generieren, und der Generierungseffekt ist mit dem von Runway, Pika und anderen Experten vergleichbar.

Diese KI-Tools zur Videogenerierung haben vor allem in zwei Dimensionen große Fortschritte gemacht – Qualität und Quantität. In Bezug auf die Qualität führen diese KI-Produkte weiterhin leistungsfähigere Modellarchitekturen ein und nutzen umfangreichere und qualitativ hochwertigere Daten für das Training, sodass sich die Bildqualität, Sprachverständlichkeit und Wiedergabetreue von KI-generierten Videos weiter verbessern.

Auch mengenmäßig entwickelt sich die Länge der generierten Videos stetig weiter und erreicht zweistellige Sekundenlängen, und die Kombination von Szenen und Ereignissen wird immer reichhaltiger. Mit weiteren Verbesserungen der Rechenleistung wird es in Zukunft möglich sein, qualitativ hochwertige Videos zu erstellen, die mehrere Stunden dauern.

Die in der Cloud schwebende Technologie wird schließlich auch auf der Erde angewendet, und der Aufstieg der KI-Videoerzeugung wird einen riesigen Blue-Ocean-Markt schaffen. Tongyi Qianwens „National Dance King“ basiert auf der tiefgreifenden Anhäufung von Technologie und ist ein weiteres Produkt, das auf dieser Geschäftslogik basiert.

Dies wird nicht nur den Wettbewerb mit Alibaba und anderen Unternehmen eröffnen und den Fortschritt der gesamten Branche beschleunigen, sondern uns auch die Möglichkeit geben, mehr von den Möglichkeiten zu erleben, die die KI-Videogenerierungstechnologie bietet.

# Willkommen beim offiziellen öffentlichen WeChat-Konto von aifaner: aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner | Ursprünglicher Link · Kommentare anzeigen · Sina Weibo