Nach der Gründung von OpenAI: Träume, Meinungsverschiedenheiten und AGI

Anmerkung des Herausgebers: Als Sam Altman die Vision von OpenAI erläuterte, erklärte er ohne zu zögern, dass sie eine AGI (Künstliche Allgemeine Intelligenz) entwickeln wollen, die für die gesamte Menschheit nützlich und sicher ist.

Mit der Kapitalspritze von Microsoft begannen viele Menschen daran zu zweifeln: Kann OpenAI das wirklich?

Auf diese Frage antwortete Sam Altman mit Ja.

Bloomberg hat kürzlich eine vierteilige Podcast-Serie mit dem Titel „Foundering: The OpenAI Story“ erstellt, die den Aufstieg von Sam Altman dokumentiert und versucht, einen der wichtigsten Gründer unserer Zeit vollständig zu verstehen.

Heute übersetzen wir die zweite Folge dieser Podcast-Reihe. Es beinhaltet Folgendes:

Die Vielseitigkeit von AGI: Alles daran zu setzen, AGI zu schaffen, wird von OpenAI als wichtige Vision angesehen. Dies könnte viele globale Herausforderungen lösen, birgt aber auch beispiellose Risiken, darunter unkontrollierbare künstliche Intelligenz und schwerwiegende soziale Auswirkungen.

Die Entwicklung von OpenAI: Von datengesteuerter Innovation bis hin zu sorgfältiger Modellfreigabe. Wie bleibt OpenAI unter dem Deckmantel kommerzieller Faktoren „offen“?

Machtkampf bei OpenAI: Elon Musks Wunsch nach mehr Kontrolle hat zu Meinungsverschiedenheiten mit einigen OpenAI-Mitarbeitern geführt. Unter der Führung von Sam Altman hat sich OpenAI von einer gemeinnützigen Organisation zu einer gewinnorientierten Organisation entwickelt.

Original-Podcast-Link:

Ich möchte mit einem Traum beginnen, einem Traum über den Aufbau von KI.

Über diesen Traum wird seit Jahrzehnten geträumt und geschrieben, während die Menschheit zusammenarbeitet, um ein neues Wesen zu erschaffen, das mächtiger ist als wir selbst. Einige Forscher glauben, dass dieser Traum bald wahr werden könnte.

Eines Tages werden die digitalen Gehirne unserer Computer genauso gut oder sogar besser sein als unsere biologischen Gehirne. Computer werden intelligenter als wir. Wir nennen dies künstliche allgemeine Intelligenz (AGI).

Dies sagt Ilya Sutskever, einer der Mitbegründer von OpenAI. In einem Ted Talk letztes Jahr verhielt er sich oft wie ein religiöser Mystiker, wenn er über die Zukunft der künstlichen Intelligenz sprach.

Aber jetzt spricht er nur über die Suche nach AGI, einer Art künstlicher Intelligenz, die wie Menschen denken und Probleme lösen kann. Es kann frei zwischen Spielen, Lösen wissenschaftlicher Probleme, dem Schaffen schöner Kunst und Autofahren wechseln.

Das Ziel von OpenAI ist der Aufbau von AGI. In der KI-Welt war diese Idee früher zumindest sehr avantgardistisch. Ilya beschreibt AGI als einen fast mystischen, bedeutsamen Sprung nach vorne, wie Prometheus, der das Feuer bringt, mit enormen Konsequenzen. Es wird uns in technologischen Glanz, aber auch ins Chaos führen. In der Dokumentation „iHuman“ zeigte er sich zuversichtlich hinsichtlich zukünftiger Veränderungen.

Das Aufkommen der KI ist jetzt eine großartige Sache, denn KI wird alle Probleme lösen, mit denen wir heute konfrontiert sind. Es wird sich mit Beschäftigung, Krankheit und Armut befassen. Aber es wird auch neue Probleme mit sich bringen, das Problem der Fake News wird gravierender, Cyberangriffe werden extremer und wir werden über vollautomatische KI-Waffen verfügen.

Ilya ist ein hochqualifizierter KI-Forscher, der vor seiner Tätigkeit bei OpenAI bei Google gearbeitet hat. Er hat eine tiefe und leidenschaftliche Zuneigung zur Menschheit. Er kann Klavier spielen und zeichnen. Eines seiner Gemälde hängt im Büro von OpenAI. Es ist eine Blume in Form des Firmenlogos.

Gleichzeitig konzentriert er sich auch stark auf die KI-Forschung. Er sagte einmal zu einem Reporter: „Ich lebe ein sehr einfaches Leben. Ich gehe zur Arbeit und dann nach Hause. Ich mache nichts anderes. Es gibt viele soziale Situationen und viele Aktivitäten, an denen ich teilnehmen kann, aber ich Ich werde nicht daran teilnehmen.“

Er verbringt viel Zeit damit, die Entwicklung der KI zu beobachten und zu versuchen, die Zukunft vorherzusagen. Besonders besorgt ist Ilya darüber, ob AGI eigene Wünsche und Ziele haben wird. Diese Fantasie ist in seinen Worten zu hören.

Es ist nicht so, dass es Menschen aktiv hassen und ihnen schaden will, aber es wird zu mächtig. Ich denke, eine gute Analogie ist die Art und Weise, wie Menschen mit Tieren umgehen. Wir hassen Tiere nicht, aber wenn wir eine Autobahn zwischen zwei Städten bauen müssen, ziehen wir sie nicht zu Rate. Es ist denkbar, dass die Erdoberfläche mit Sonnenkollektoren und Rechenzentren bedeckt sein könnte.

Ich möchte hier einen Moment innehalten. Dies stellt ein sehr starkes, kraftvolles Bild davon dar, dass wir eine Art neue Existenz schaffen. Es wird an uns interessiert, aber letztendlich gleichgültig sein, genau wie wir es mit Rehen sind.

Was mich bei dieser Aufnahme am meisten beeindruckte, war Ilyas Tonfall, der nicht Angst, sondern Ehrfurcht ausstrahlte. Ilya stellt sich eine AGI vor, die uns stürzen könnte, um ihre Ziele zu erreichen, ein dramatisches Szenario, das schwer vorstellbar ist. Diese Vorstellung von einem übernatürlichen, allmächtigen Wesen hat einen sehr starken religiösen Unterton.

Ich sollte erwähnen, dass dies alles völlig theoretisch ist und wir von AGI noch weit entfernt sind. OpenAI versucht derzeit sein Bestes, Modelle zu entwickeln, die Menschen glaubwürdig nachahmen können, aber es gibt immer noch eine große Lücke zwischen Nachahmung und KI, die unabhängig denken kann. Dennoch möchte OpenAI es tun, und es möchte der Beste und der Erste sein. Hier ist, was Sam Altman sagte, als er 2023 vor dem Kongress aussagte:

Meine größte Sorge ist der enorme Einfluss, den wir auf die Welt haben werden. Unser gesamter Bereich, unsere Technologie und unsere Industrie können der Welt „erheblichen Schaden“ zufügen. Deshalb haben wir dieses Unternehmen gegründet. Ich denke, wenn mit dieser Technologie etwas schief geht, könnte es „furchtbar schief gehen“.

Sie hören „Foundering“ und ich bin Ihre Moderatorin Ellen Hewitt. In dieser Folge entführen wir Sie in die chaotischen und idealistischen Anfänge von OpenAI.

Wir diskutieren über den Traum vom Aufbau einer allmächtigen AGI, der wichtig ist. Denn darauf schreitet OpenAI rasant voran: der Wettlauf dieser Generation zum Mond. Wir werden diskutieren, wie sich die KI-Technologie dramatisch und schnell verändert und wie dieser Wandel den Traum von AGI näher denn je bringt.

In nur wenigen Jahren entwickelte sich daraus von einer merkwürdigen Idee, die belächelt wurde, zu einem Meilenstein, von dem einige Experten glauben, dass er innerhalb weniger Jahre erreicht werden könnte. Sam Altman deutete sogar an, dass es im Jahr 2028 passieren könnte. Wir werden uns auch die Kompromisse ansehen, die OpenAI bei der Verwirklichung dieses Traums eingegangen ist.

Ursprünglich versprach das Unternehmen, seine Forschungsergebnisse weithin zu verbreiten und sich nicht vom Profitstreben leiten zu lassen. Doch als ihre Technologie Fortschritte machte und es so aussah, als könnten sie große Macht erlangen, vollzogen sie eine Kehrtwende. Dieser kritische Moment entwickelte sich dann zu einem Machtkampf innerhalb von OpenAI, bei dem Sam Altman die Zügel übernahm.

Beginnen wir mit 2015. OpenAI war zu diesem Zeitpunkt gerade erst gegründet worden, mit einer Zusage von 1 Milliarde US-Dollar von Elon Musk sowie Mitteln anderer Spender. Es war ein kleines, junges Forschungslabor.

In der Anfangszeit waren Sam und Elon nicht sehr oft da. Damals leitete Sam eigentlich noch den Startup-Accelerator Y Combinator, doch er begann, sich als Vordenker im KI-Bereich zu positionieren. Insbesondere sprach er über KI-Weltuntergangsszenarien.

2015 erklärte er in einem Blog, dass die Entwicklung übermenschlicher Maschinenintelligenz die größte Bedrohung für den Fortbestand der Menschheit darstellen könnte. Er schrieb auch, dass KI jeden Menschen im Universum zerstören könnte. Im selben Jahr erwähnte er auf einer Technologieveranstaltung, dass OpenAI kurz vor der Etablierung stehe.

Tatsächlich habe ich gerade zugestimmt, ein Unternehmen zu finanzieren, das KI-Sicherheitsforschung betreibt. Wissen Sie, ich denke, dass KI wahrscheinlich das Ende der Welt herbeiführen wird. Aber in der Zwischenzeit wird es einige großartige Unternehmen geben, die fortschrittliche Techniken des maschinellen Lernens einsetzen.

Ich möchte über dieses Zitat sprechen. Er sagt, KI könnte uns alle töten, während er uns dazu auffordert, seinen Schlussfolgerungen als Experte zu vertrauen. Aber auch wenn es ums Geldverdienen geht, ist er „glatt“.

In den frühen Tagen von OpenAI waren Sam und Elon nicht oft in die tägliche Arbeit eingebunden. Sie gehen raus und reden mit Leuten, rekrutieren Talente, reden mit Reportern. Sie kommen etwa einmal pro Woche vorbei, um Fortschrittsaktualisierungen zu erhalten. An diesen Tagen mischte sich Sam in das Gespräch ein und ging dann wieder.

Er kommt mir sehr klug, scharfsinnig und sehr effizient vor. Wenn das Gespräch beendet ist, ist es vorbei.

Dies ist Peter Abele, ein Forscher, der in den ersten beiden Jahren bei OpenAI gearbeitet hat. In seinen Anfängen sah OpenAI wie ein typisches Startup aus, sagte er. Eine Zeit lang hatten sie nicht einmal ein Büro und trafen sich bei einem der Mitbegründer zu Hause.

Wir begannen Ende 2015 und Anfang 2016 in Greg Brockmans Wohnung im Mission District von San Francisco zu arbeiten. Wir sitzen im Grunde auf der Couch, auf der Küchentheke und im Bett, und dort findet die Arbeit statt. Es ist verrückt, sich vorzustellen, dass ein so großes Projekt hier beginnen könnte. Wir haben 20 der besten KI-Forscher der Welt, die sich darauf konzentrieren, etwas zu erreichen, was noch nie zuvor getan wurde.

In Abwesenheit von Sam und Elon waren die Hauptführer zwei Männer, die später wichtige Rollen spielen würden. Sie sind keine Berühmtheiten, werden aber in Zukunft eine große Rolle spielen.

Der eine ist Greg, dessen Wohnung als Büro dient, und der andere ist Ilya, der KI-Wissenschaftler, von dem wir zu Beginn der Episode gehört haben. Sie können sich Greg als den Workaholic vorstellen, der für den Geschäftsbetrieb verantwortlich ist, und Ilya als das KI-Genie.

Zusammen führten sie OpenAI durch, und Peter erinnerte sich noch daran, wie er jede Woche mit Ilya durch die Straßen von San Francisco ging, über das große Ganze sprach und sich fragte: Lösen wir das richtige Problem?

Ich denke, er hat das Potenzial der KI früher und klarer erkannt als jeder andere. Er war optimistischer als die anderen und ließ sich Analogien einfallen. Ein neuronales Netzwerk zum Beispiel ist nur ein Computerprogramm, nur ein Schaltkreis, wir programmieren ihn nur auf eine andere Art und Weise.

In der Zwischenzeit arbeitete Greg weiter hart.

Greg ist jemand, der sein ganzes Herzblut in seine Arbeit steckt. Er konnte weiter arbeiten und arbeiten. Ich habe solche Leute gesehen, aber nur sehr wenige.

Selbst nachdem OpenAI aus Gregs Wohnung ausgezogen war, lebte er immer noch im Wesentlichen im Büro. Ein ehemaliger Mitarbeiter sagte, er habe immer noch an seinem Schreibtisch gearbeitet, als sie morgens zur Arbeit kamen, und noch immer auf seiner Tastatur getippt, als sie abends gingen.

Als Greg ein paar Jahre später heiratete, veranstaltete er sogar eine weltliche Zeremonie im Büro. Verziert mit einem großen Blumenhintergrundstoff, ist die Form der Blume auch das OpenAI-Logo. Der Ring wurde von einer Roboterhand gehalten und der Hochzeitsoffizier war Ilya.

Als Greg und Ilya OpenAI beitraten, brauchten sie kein Geld. Ilya verkaufte ein Unternehmen an Google, und Greg besaß einen Großteil von Stripe, und dieses Unternehmen war mehrere zehn Milliarden Dollar wert.

Im Silicon Valley gründen Menschen normalerweise Startups, weil sie glauben, sie könnten ein lukratives Geschäft aufbauen. Aber OpenAI ist eine gemeinnützige Organisation. Greg und Ilya wurden von diesem Traum inspiriert.

Das ist Reid Hoffman, einer der ersten Spender von OpenAI:

Für das Startteam gibt es keine Eigenkapitalrendite. Sie tun es für die Menschheit.

„Das ist für die Menschheit“, hat OpenAI immer gesagt. Auf ihrer Website heißt es, dass es unsere Mission ist, sicherzustellen, dass AGI der gesamten Menschheit zugute kommt.

Nun, es ist kein Geheimnis, dass Silicon Valley große Leitbilder liebt und WeWork das globale Bewusstsein fördern möchte, aber das Leitbild von OpenAI ist noch großartiger, mit Untertönen von Altruismus.

Wenn Sam über die Arbeit des Unternehmens spricht, spricht er oft von möglichen Katastrophen. Hier spricht er mit Rebecca Jarvis von ABC, seine Stimme ist wieder ernst, während er sich als Vordenker auf diesem Gebiet positioniert. Was ist also das schlechteste Ergebnis?

Sam Altman: Eine Sache, die mich besonders beunruhigt, ist, dass diese Modelle für groß angelegte Desinformation genutzt werden könnten. Jetzt, wo sie immer besser darin werden, Computercode zu schreiben, befürchte ich, dass diese Systeme für offensive Cyberangriffe genutzt werden könnten.

Rebecca Jarvis: Sie machen einen wichtigen Punkt: Die Menschen, die die Maschinen steuern, verfügen jetzt auch über enorme Macht.

Sam Altman: Wir sind sehr besorgt über die Entwicklung dieser Technologie durch autoritäre Regierungen.

Rebecca Jarvis: Putin hat einmal gesagt, dass derjenige, der dieses KI-Rennen gewinnt, im Grunde die Menschheit kontrollieren wird. Stimmen Sie dieser Aussage zu?

Sam Altman: Das ist in der Tat eine erschreckende Aussage.

Sam sagt, dieses Ding sei so wertvoll, dass die globalen Supermächte darum streiten würden. Skeptiker glauben, dass man mehr Aufmerksamkeit und Geld auf sich zieht, wenn man den Eindruck erweckt, dass das, woran man arbeitet, wichtig ist. Auf diese Perspektive werden wir uns in der nächsten Folge konzentrieren.

In den frühen Tagen von OpenAI waren ihre Pläne zur Rettung der Menschheit unklar. Ihre Strategie war etwas verstreut, hier ist Peters Erinnerung:

Wir haben uns mit der Robotik beschäftigt, wo wir einiges erforscht haben; wir haben uns mit analogen Robotern beschäftigt, wo wir viel Erfahrung investiert haben, und wir haben uns mit digitalen Agenten beschäftigt, die verschiedene Aufgaben im Internet ausführen können; wie das Buchen von Flügen. Wir haben uns auch Videospiele angeschaut.

Laut OpenAI wird eines seiner ersten Ziele darin bestehen, einen Roboter-Butler zu bauen, der Tische decken und abräumen kann. Wie das Dienstmädchen aus „The Jetsons“.

Das Unternehmen hat auch eine Roboterhand gebaut, die einen Zauberwürfel mit einer Hand lösen kann, und hat viel Mühe in die Entwicklung eines Roboters gesteckt, der Dota 2, ein äußerst beliebtes Multiplayer-Onlinespiel, spielen kann. Sie glauben, dass die Komplexität der Spielumgebung es der KI ermöglichen kann, sich besser in der realen Welt zurechtzufinden.

Hier ist jemand, der den Bot testet:

Dieser Roboter ist großartig, viel besser als ich erwartet hatte.

Diese Dota-Bots treten sogar gegen Profispieler an:

Bereiten Sie sich im Voraus vor, die Aktion beginnt! Also, die KI hat den ersten Tropfen Blut bekommen …

Ein Bot, der Dota spielen kann, ist technisch beeindruckend, aber für den Durchschnittsmenschen sieht das nicht so aus, und die kommerziellen Anwendungen dieser Produkte sind nicht sofort offensichtlich. Hier ist ein Kommentar eines ehemaligen Mitarbeiters:

Wir machen zufällige Dinge und sehen, was passiert. Manchmal fühlt es sich so an, als gäbe es eine große Lücke zwischen dem, was gebaut wurde, und dem, was man sich vorgestellt hat. Menschen programmieren Roboter so, dass sie tagsüber Videospiele spielen, und dann sitzen sie beim Mittagessen am Tisch und reden über die Rettung der Menschheit.

Eine im Bereich der KI verbreitete Ansicht ist, dass man manchmal mit etwas Trivialem beginnen muss, um etwas Mächtiges zu schaffen. Videospiele und Robotermädchen werden den Weg für selbstfahrende Autos und krebsheilende KI ebnen.

Innerhalb von OpenAI vergleichen sie sich manchmal mit dem Manhattan Project, dem Team, das für den Bau der ersten Atombombe verantwortlich ist, und halten es für eine gute Sache, ehrgeizig und wichtig. Das hat mir ein anderer ehemaliger Mitarbeiter erzählt:

Es ist ein Wettrüsten, sie alle wollen das erste AGI herstellen und glauben, dass sie es am besten können. Ich sehe keine große Angst vor der KI selbst, ich sehe nur Begeisterung für den Aufbau von KI.

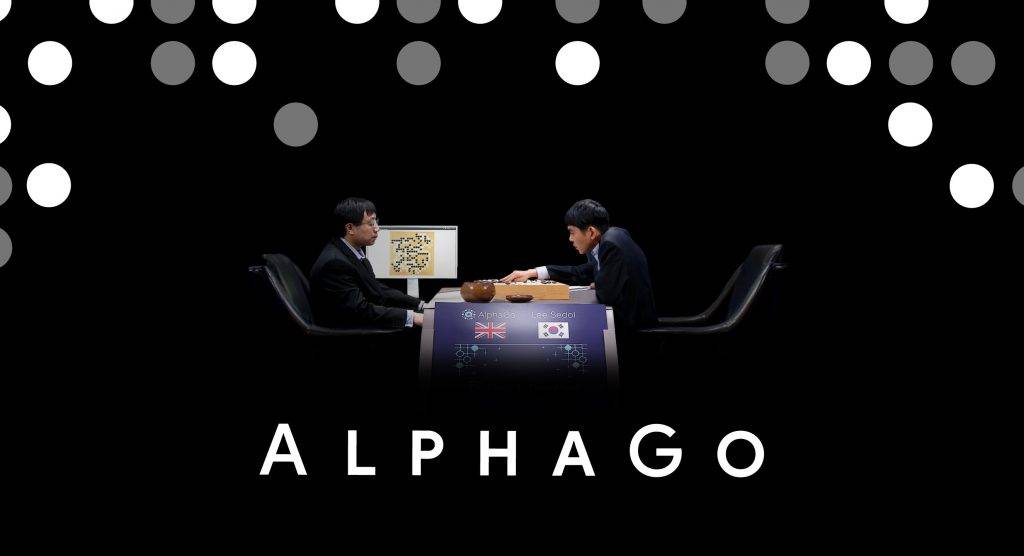

Im Jahr 2015 sah die KI ganz anders aus als heute, sie war schwächer und schwieriger zu trainieren. Der große Durchbruch war damals, dass ein Roboter in Go, einem komplexen Strategie-Brettspiel aus China, die weltbesten Spieler schlagen konnte. Aber diese KI kann nur Go spielen, sie kann nichts anderes.

Das ist Oren Etzioni, Informatikprofessor und ehemaliger Forschungsdirektor eines KI-Forschungsinstituts:

Diese Systeme sind eng begrenzt und sehr zielgerichtet. Das System, das Go spielt, kann nicht einmal Schach spielen, geschweige denn über die Straße gehen oder eine Sprache verstehen. Und ein System, das Flugpreisschwankungen vorhersagt und Preiserhöhungen oder -senkungen sehr genau vorhersagen kann, kann mit Text nicht umgehen. Im Grunde genommen müssen Sie jedes Mal, wenn es eine neue Anwendung gibt, ein neues System trainieren. Dies dauert lange, erfordert viele annotierte Daten usw.

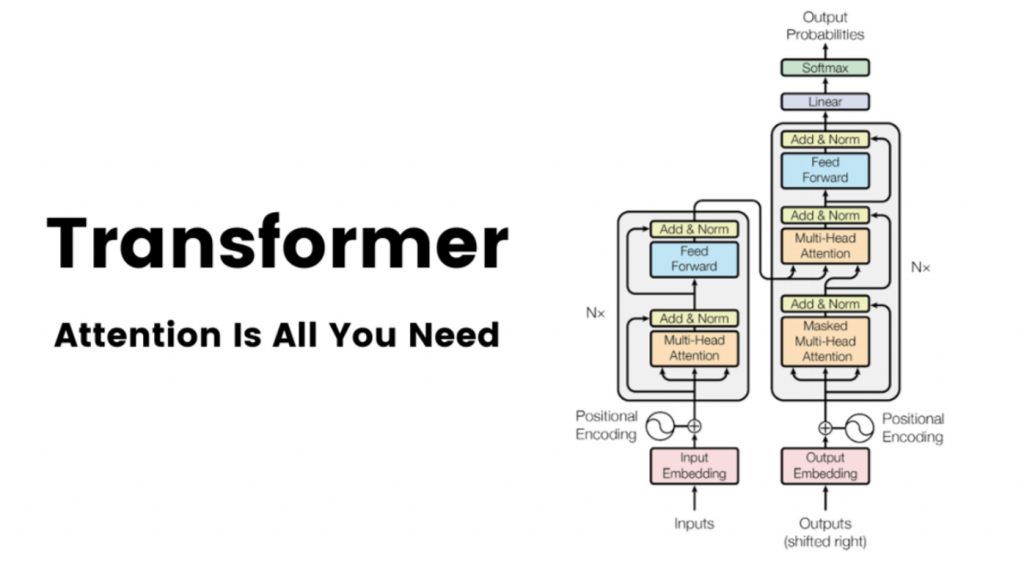

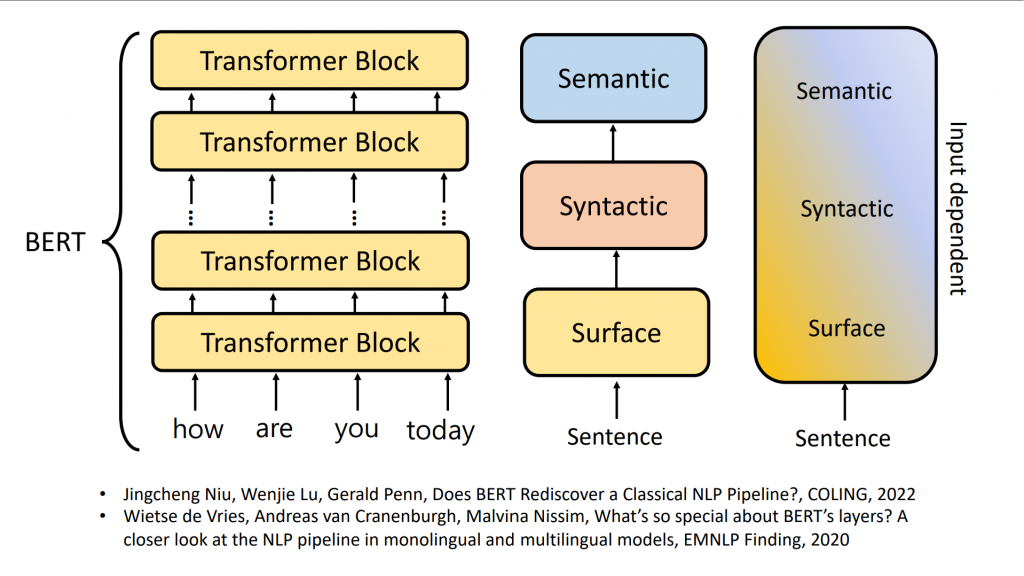

Doch dann gelang der KI-Technologie ein großer Durchbruch. Im Jahr 2017 veröffentlichte ein Forscherteam von Google Brain einen Artikel mit dem Titel „Aufmerksamkeit ist alles, was Sie brauchen“. In diesem Artikel beschreiben sie eine neue KI-Architektur namens Transformer.

Transformer hat für seine Zeit etwas sehr Wichtiges getan. Das KI-System muss sehr spezifische Daten eingeben, und jedes Datenelement muss gekennzeichnet sein. Das ist richtig, das ist falsch.

Aber Transformer ermöglicht es der KI, unordentliche, unbeschriftete Daten zu empfangen. Tatsächlich kann es dies effizienter als erwartet tun und dabei weniger Rechenleistung verbrauchen.

Jetzt können diese Transformer-basierten Modelle selbstständig lernen. Es ist ein bisschen so, als ob man früher, wenn man einem Kind das Lesen beibringen wollte, einen Nachhilfelehrer engagieren musste, der da saß und Lernkarten benutzte, aber jetzt kann man das Kind alleine in die Bibliothek gehen lassen und es wird wissend herauskommen wie man liest und schreibt.

Es ist eine überraschende und schmerzhafte Realität, wie ein Investor es mir beschrieb, dass die beste KI nicht von den spezialisiertesten Trainingstechniken kommt, sondern von denen mit den meisten Daten.

Peter, ein früher OpenAI-Mitarbeiter, sagt, Ilya habe das Potenzial sofort erkannt:

Ilya reagierte mit Bestimmtheit und sagte, dies sei ein großer Durchbruch, dem wir Aufmerksamkeit schenken müssten.

Selbst in den Anfängen von OpenAI hatte Ilya immer die Ahnung, dass große Fortschritte in der KI nicht durch eine bestimmte Optimierung oder neue Erfindung, sondern durch mehr Daten entstehen würden, die immer mehr Treibstoff in den Motor pumpen würden. Jetzt verfügt Ilya über Forschungsergebnisse, die seine Hypothese stützen.

Das hat Oren noch einmal gesagt:

Ilya von OpenAI ist bekannt für seine Ansicht, dass Daten und Datenvolumen uns dahin bringen werden, wo wir sein müssen, wenn wir es deutlich vergrößern. Dies ist kein allgemeiner Glaube, und viele sehr kluge und berühmte Menschen, darunter auch ich, haben dies nicht vorhergesehen.

Dank Ilyas Vorstoß begann OpenAI, mit Transformer zu experimentieren. Sie waren eines der ersten Unternehmen, das dies tat. Sie haben das Modell erstellt, das vorab trainierte Transformer unter dem mittlerweile bekannten Akronym GPT generiert.

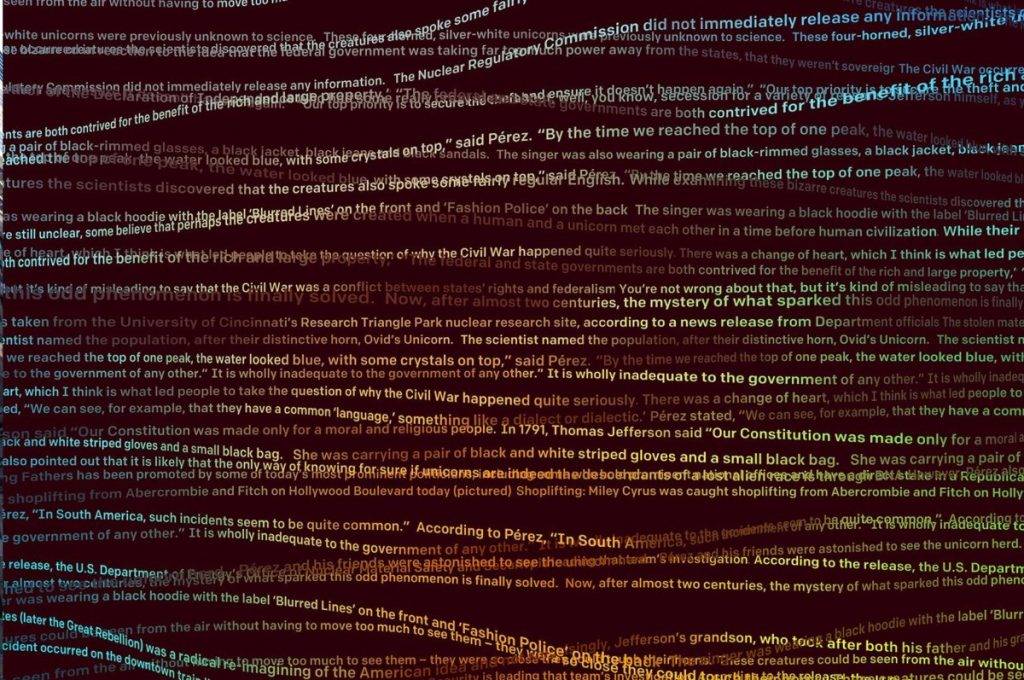

Vor allem, als sie anfingen, mit der Leistung des Transformers bei der Textverarbeitung zu experimentieren. Denn sie können grundsätzlich jedes Buch, jeden Zeitungsartikel, jeden Reddit-Beitrag, jeden Blog eintippen. Menschen verbringen viel Zeit mit Schreiben, und dieser Text hat jetzt einen neuen Zweck: Trainingsdaten.

Das Internet wurde nicht geschaffen, um KI zu trainieren, aber letztendlich könnte das sein Vermächtnis sein. Die Modelle von OpenAI werden bei der Textgenerierung immer besser, und das nicht nur in einem Wissensbereich.

Das Erstaunliche an GPT-Systemen ist, dass sie so umfassend sind, dass sie eigentlich Generalisten sind. Sie können sie zu fast jedem Thema befragen und sie werden Ihnen überraschend gute Antworten geben. Das liegt daran, dass sie darauf trainiert wurden, den gesamten Textbestand, Milliarden von Sätzen, alle Dokumente, Memos, Wissenswertes, Harry-Potter-Fanfiction, die Sie jemals gelesen haben, den Menschen effektiv zur Verfügung zu stellen und all das in die Mühle einzuspeisen. Sobald Sie dies gelesen haben, wird es sehr vielseitig. Zum ersten Mal haben wir also ein System, dem Sie jede Frage stellen können und das Ihnen eine überraschend intelligente Antwort gibt, von der KI in einem engen Bereich bis hin zu einer allgemeinen oder breiten KI.

Durch die Eingabe großer Textmengen in das Modell stellte OpenAI fest, dass sie eine KI erstellen konnten, die viel besser in der Lage war, überzeugende Antworten zu generieren. Tatsächlich begannen sie irgendwann zu befürchten, dass es zu gut sein könnte.

Als das Sprachmodell GPT-2 von OpenAI zum ersten Mal auf den Markt kam, beschlossen sie zunächst, das Modell nicht weiter zu verbreiten, weil sie befürchteten, dass es gefährlich sein könnte. Dies ist Peter, der OpenAI inzwischen verlassen und sein eigenes Unternehmen gegründet hatte, aber er erinnert sich an die Szene am Tag des Starts:

Anscheinend versteht es Sprache viel besser als alles, was ihm zuvor beigebracht wurde. Die Veröffentlichung war mit viel, vielleicht gutem Marketing, vielleicht Vorsicht oder beidem verbunden. Es wurde als „zu gefährlich für die Veröffentlichung“ bezeichnet, daher denke ich, dass dies das erste Projekt ist, bei dem OpenAI beschlossen hat, einen Teil seiner Arbeit nicht zu veröffentlichen. Plötzlich ist das, worüber wir nachdenken, die Frage: „Was wäre, wenn etwas so mächtig wäre, dass Menschen es auf eine Weise missbrauchen könnten, die wir nicht kontrollieren können?“

Sobald OpenAI ein wirklich starkes Produkt hat, werden sie beginnen, ihre Offenheit zu überdenken.

Für den Namen OpenAI bedeutet Open eigentlich, dass alles Open Source sein wird und jeder darauf aufbauen kann.

„Offenheit“ ist ein zentraler Bestandteil der Unternehmensmarke. Als sie auf den Markt kamen, sagte Sam dem Reporter Steven Levy: „Es wird Open Source sein und jeder kann es nutzen.“

Er sagte Reportern auch: „Ihre KI wird im freien Besitz der Welt sein. Open-Source-Software bedeutet im Großen und Ganzen, dass der Quellcode öffentlich ist und jeder den Code anpassen und selbst verbreiten kann.“ Aber das Unternehmen begann bald, sich allmählich zurückzuziehen diese Verpflichtungen.

Offensichtlich wurde dies im Laufe der Zeit zu etwas, das nicht vollständig oder überhaupt nicht Open Source war. Ich meine, sie werden ihre Arbeit jetzt definitiv nicht als Open Source veröffentlichen.

Dieser Open-Source-Geist scheint langsam zu verschwinden. Das Folgende ist eine Rede, die Sam 2023 in München gehalten hat:

Ich bin gespannt, wie viele Leute möchten, dass wir GPT-6 am Tag des Abschlusses der Schulung als Open Source veröffentlichen, wenn wir den Verlauf von GPT-2, GPT-3, GPT-4 und dann zu GPT-5 und GPT-6 beibehalten ?

Wow, okay, das machen wir nicht, aber es macht Spaß.

Ehrlich gesagt wirkt Sam hier ziemlich arrogant. Er wusste, dass OpenAI ursprünglich versprach, Open Source zu sein. Jetzt befragt er seine Zuhörer, was sie über das Open-Source-Modell denken, und weist deren Antworten dann sofort zurück.

Im Laufe der Jahre änderte Sam auf subtile Weise die Bedeutung von „offen“ und wurde immer mehrdeutiger. Hier ist, was er bei einer Risikokapitalfirma sagte:

Das nennen wir OpenAI und wir möchten, dass diese Technologie für alle offen ist.

Er sagte es so natürlich, als ob es offensichtlich wäre, was Offenheit bedeutet. Aber seine Definition erscheint mir so vage, dass sie im Wesentlichen bedeutungslos ist. Ich meine, die Google-Suche steht jedem offen. Es scheint, als ob OpenAI gerne bereit ist, die Leute darüber im Unklaren zu lassen, was sie unter Offenheit verstehen.

Nur wenige Monate nach der Firmengründung schrieb Ilya in einer internen E-Mail:

Je näher wir dem Aufbau von KI kommen, desto sinnvoller ist es, weniger offen zu werden. Das „Offene“ in OpenAI bedeutet, dass jeder von den Ergebnissen der KI profitieren soll, es aber keine Notwendigkeit gibt, die Wissenschaft zu teilen, obwohl kurz- und möglicherweise mittelfristig das Teilen von allem definitiv die richtige Strategie für die Rekrutierung von Talenten ist.

Diese E-Mail ist sehr interessant, weil sie zeigt, dass OpenAI von Anfang an geplant hatte, seine Wissenschaft nicht frei zu teilen. Sie wollen nicht Open Source sein, wie sie behaupten, aber sie wollen ein offenes öffentliches Image bewahren, weil es ihnen einen Vorteil bei der Rekrutierung verschafft.

Bauen Sie zum Beispiel keine KI für die Bösewichte, sondern kommen Sie und arbeiten Sie für uns. Als wir nach der sich ändernden Definition von Offenheit fragten, sagte ein Unternehmenssprecher: „Unsere Mission ist dieselbe geblieben, aber unsere Strategie musste sich ändern.“

Okay, gehen wir zurück ins Jahr 2017. Zwei Jahre nach der Firmengründung tauchte bei OpenAI ein neues Problem auf: ein Machtkampf.

Elon will übernehmen, er ist der Typ, der es gewohnt ist, das Sagen zu haben. Laut OpenAI will er das Unternehmen unter Tesla bringen und CEO mit Mehrheitsanteil werden. Wenn es nicht nach seinen Wünschen läuft, gibt er auf.

Wie bei allen Dingen möchte Elon mit der Zeit mehr Kontrolle ausüben und sicherstellen, dass das Unternehmen so geführt wird, wie er es sich wünscht. Das erzeugt also Spannung.

Dies ist meine Kollegin Ashley Vance, die eine Biografie über Elon geschrieben hat.

Elons bevorzugte Rolle in allen Bereichen besteht darin, der CEO und die dominierende Kraft bei der Kontrolle des Tagesgeschäfts zu sein.

Tatsächlich sind Greg Brockman und Ilya Sutskever, die für das Tagesgeschäft verantwortlich sind, sehr wachsam. Obwohl Elon rücksichtslos, impulsiv und schwer zu verstehen ist, ist er auch ihre Hauptfinanzierungsquelle.

Er hat fast eine Milliarde US-Dollar zugesagt. OpenAI hat andere Spender, aber keiner kommt annähernd an diesen Betrag heran. Eine Möglichkeit besteht darin, bei Elon zu bleiben und sein Kapital zu behalten.

Die Mitarbeiter sind von der Idee nicht ganz überzeugt und haben einige Bedenken. Wir sind also an diesem Entscheidungspunkt angelangt: Sollen wir bei Elon bleiben oder ihn verlassen? In den letzten Jahren haben sich die Menschen fast immer mit Elon und seinen Forderungen abgefunden.

Oder eine andere Möglichkeit besteht darin, sich von Elon zu trennen und andere Finanzierungsquellen zu finden. Kennen Sie jemanden, der gut darin sein könnte, Geld zu sammeln? Sam Altman.

Der Fokus lag darauf, dass Elon wollte, dass das Unternehmen einen Weg einschlägt und die Mitarbeiter einen anderen. Deshalb wurde Sam ausgewählt, um OpenAI voranzutreiben.

In den ersten Jahren war Sam nicht viel mit OpenAI beschäftigt. Eigentlich ist er immer noch der Präsident von Y Combinator, aber in diesem Machtkampf siegt Sam über Elon, und das ist eine große Sache. Elon ist berühmter, erfahrener und vor allem hasst er es zu verlieren.

In einem Konflikt besteht Elons Reaktion darin, um jeden Preis zu gewinnen. Elon hat in den letzten Jahren selten eine „Schlacht“ verloren. Wenn er nicht im Unternehmen ist, verklagt er normalerweise jemanden, um ihn zum Nachgeben zu bewegen; wenn er im Unternehmen ist, wird er die Richtlinie durchsetzen, bis er bekommt, was er will. Es ist schwer, in den letzten Jahren ein Beispiel zu finden, bei dem er nicht die gewünschten Ergebnisse erzielt hat. Damit dies nicht geschieht, müssen die Unruhen innerhalb des Unternehmens sehr ernst sein.

Also stürmte Elon 2018 los und nahm sein Kapital mit. Ein paar Jahre später verklagte er Sam und OpenAI tatsächlich und behauptete, sie hätten ihre ursprünglichen Non-Profit- und Open-Source-Versprechen gebrochen.

Kurz nachdem Elon gegangen war, wurde Sam CEO von OpenAI. Es gab hier zuvor keinen CEO, aber der Machtkampf bestimmte Sams neue Dominanz im Unternehmen. Erinnern Sie sich, was der Gründer von YC einmal gesagt hat? „Sam ist sehr gut darin, mächtig zu sein.“

Sams Interesse an OpenAI wuchs weiter und seine Aufmerksamkeit verlagerte sich zunehmend von der Verwaltung von YC. Tatsächlich ist die Leitung eines weltbekannten Startup-Accelerators eine Position mit großer Wirkung.

Aber das Rennen um AGI verschärft sich, und wenn es OpenAI gelingt, AGI vor allen anderen zu schaffen, kann man sich kaum eine Position mit mehr Macht als seinem CEO vorstellen. Allerdings gab Sam seinen Job bei YC nicht sofort auf.

Die Situation macht einige Leute, die Beschleuniger betreiben, unglücklich. Sie hatten das Gefühl, dass Sam zu sehr abgelenkt war, zu schnell drängte und seine eigenen Interessen über YC stellte. Dies hat ihm innerhalb seines eigenen Teams einige Feinde geschaffen.

Einer Quelle zufolge ist Sams Mentor Paul Graham, der Mann, der ihn ursprünglich in die Position versetzt hatte, tatsächlich aus Großbritannien eingeflogen, um Sam persönlich zum Rücktritt aufzufordern. Paul verlor das Vertrauen in seinen ehemaligen Schützling, wollte aber auch kein öffentliches Drama erzeugen. Also wurde Sam überredet, aufzuhören, sie blieben unauffällig und jetzt konzentriert er sich nur noch auf OpenAI.

Sam hat ein großes Ziel: Geld für das Training der OpenAI-Modelle zu sammeln. Sie erfordern viel Rechenleistung und Rechenleistung ist teuer. Sam versuchte, Geld aufzutreiben, kam aber nicht voran. Hier ist, was er im Lex Fridman Podcast sagte:

Wir haben als gemeinnützige Organisation begonnen. Schon früh wurde uns klar, dass wir viel mehr Geld brauchten, als wir als gemeinnützige Organisation aufbringen konnten, um das zu tun, was wir tun mussten. Wir haben mehrmals versucht, als gemeinnützige Organisation Geld zu sammeln, sind aber gescheitert. Wir sehen dort keinen Weg nach vorne. Wir brauchen also einige der Vorteile des Kapitalismus, aber nicht zu viele. Ich erinnere mich, dass jemand sagte, als gemeinnützige Organisation würden die Dinge nicht weit genug gehen; als gemeinnützige Organisation würden die Dinge zu weit gehen.

Sie brauchten etwas in der Mitte, und um ehrlich zu sein, machte sich Sam keine allzu großen Sorgen um das Leben nach der Non-Profit-Organisation. Er fügte etwas zusammen und gründete im Grunde eine gewinnorientierte Organisation, die mit der ursprünglichen gemeinnützigen Organisation verbunden war.

Ein gewinnorientiertes Unternehmen kann alles wie ein normales Unternehmen tun, beispielsweise Investitionen beschaffen und den Mitarbeitern Eigenkapital zur Verfügung stellen, aber die Renditen für seine Investoren sind begrenzt, während sie bei anderen Unternehmen unbegrenzt sind.

Diese Unternehmensstruktur wurde zusammengeschustert, wobei OpenAI nun im Wesentlichen eine gewinnorientierte Einheit ist, die von einem gemeinnützigen Vorstand kontrolliert wird, was ein wenig wackelig klingt. OpenAI behauptete mehrere Jahre lang, sie seien gemeinnützig, und nun hat es diese gewinnorientierte Lösung gefunden.

Nach dieser Änderung waren viele Menschen unzufrieden. Aber OpenAI konzentriert sich mehr auf ihr Endziel: Sie wollen AGI aufbauen und müssen Gelder sammeln, um dieses Ziel zu erreichen.

Dann, im Jahr 2019, machte der Händler Sam eine große Sache: Er sammelte 1 Milliarde US-Dollar von Microsoft. Folgendes sagte Microsoft-CEO Satya Nadella nach der Unterzeichnung der Vereinbarung:

Hallo, ich bin hier mit Sam Altman, CEO von OpenAI. Wir freuen uns sehr, heute unsere strategische Partnerschaft mit OpenAI bekannt zu geben.

Wichtig ist, dass Microsoft über eine Menge roher Rechenleistung verfügt, die OpenAI jetzt nutzen kann. Denken Sie daran, dass OpenAI ursprünglich als „Gegenmittel“ zu Google konzipiert wurde. Sie präsentierten sich als grundlegend anders als die profitgierigen Technologiegiganten und wurden dann über Nacht eng mit Technologieunternehmen im Wert von über einer Billion Dollar verbunden.

OpenAI ist mittlerweile in vielerlei Hinsicht ein Fork von Microsoft, was eine bedeutende Veränderung darstellt. Reid Hoffman, der damals sowohl im Vorstand von OpenAI als auch von Microsoft saß, sah darin keine Abkehr vom ursprünglichen Versprechen von OpenAI.

Es gab Bedenken, ob dies die Mission gefährden würde. Aber ich halte es für eine moderne Naivität zu glauben, dass Unternehmen schlecht oder korrupt sind, denn es gibt so viele Möglichkeiten, wie Unternehmen mit Menschen und der Gesellschaft interagieren. Sie versuchen, Kunden zu bedienen, Mitarbeiter zu beschäftigen, Aktionäre zu haben und in der Gesellschaft zu existieren.

Reid möchte damit sagen, dass der Wille, Geld zu verdienen, nicht bedeutet, dass man schlecht ist, was für einen milliardenschweren Risikokapitalgeber typisch ist.

Ich habe das Gefühl, dass der Microsoft-Deal für OpenAI die praktischste Möglichkeit sein könnte, seine Mission, sichere AGI für die gesamte Menschheit zu schaffen, fortzusetzen. Aber es unterstreicht auch die wichtige Eigenschaft, dass OpenAI dazu neigt, seine Versprechen einzuhalten, wenn es ihm passt.

Unter diesem Hintergrund begannen Menschen, Sams Integrität sowohl innerhalb als auch außerhalb des Unternehmens in Frage zu stellen.

Dadurch entsteht ein großer Riss.

Wir sehen uns in der nächsten Folge von „Foundering“!

# Willkommen beim offiziellen öffentlichen WeChat-Konto von Aifaner: Aifaner (WeChat-ID: ifanr) wird Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner |. Ursprünglicher Link · Kommentare anzeigen · Sina Weibo