Unter der Welle von DeepSeek, dem Innovationskatalysator der End-Side-KI

Es gibt eine metaphorische Geschichte über die Höhle in Platons „Die Republik“. Eine Gruppe von Gefangenen war von Kindheit an in einer Höhle eingesperrt, mit dem Gesicht zur Wand, hinter ihnen sahen die Gefangenen ihr ganzes Leben lang nur Schatten, die sich auf der Wand spiegelten, und sie dachten, diese Schatten seien die reale Welt.

Auch große Models wurden von ähnlichen „Schatten“ in die Irre geführt und betrachteten einst ein Vortraining, das Wunder bewirken kann, als die Norm. Bis DeepSeek R1 Anfang 2025 seine Denkfähigkeiten demonstrierte, hat sich die KI von der bloßen Beobachtung von Schatten zur Erforschung wahren Wissens auf introspektive und dialektische Weise gewandelt.

DeepSeek ermöglicht es Modellen, aus der „Höhle“ herauszukommen, und verändert auch das Paradigma intelligenter Terminals.

Das DeepSeek-Destillationsmodell wurde in weniger als zwei Wochen nach seiner Veröffentlichung auf kommerziellen Terminals implementiert, die mit der Snapdragon-Plattform ausgestattet waren. KI-Hardware wird nicht mehr nur eine „sexy Story“ zur Steigerung der Bewertung sein, sondern hat bereits tatsächlichen Anwendungswert und kommerzielles Potenzial.

Das neueste Whitepaper von Qualcomm „AI Transformation is Promoting Terminal-Side Inference Innovation“ weist darauf hin, dass die Einführung von DeepSeek den Eintritt der KI in das Zeitalter der Inferenzinnovation markiert. Reduzierte Schulungskosten, schneller Inferenzeinsatz und Innovation für Edge-Umgebungen treiben die Verbreitung hochwertiger kleiner Modelle voran und beschleunigen den Einsatz von KI über Edge-Terminals hinweg.

Liu Zhiyuan, außerordentlicher Professor an der Tsinghua-Universität und Mitbegründer und leitender Wissenschaftler von Wall-Facing Intelligence, schlug außerdem vor, dass dieser Wechsel von „Skalierung zuerst“ zu „Effizienz zuerst“ wichtige Inspirationen für KI auf Geräten liefert: Durch Modellkomprimierung, Parameteroptimierung und Algorithmusinnovation ist es möglich, den Bedarf an Rechenressourcen erheblich zu reduzieren und gleichzeitig die Modellleistung beizubehalten, sodass sie für die Ausführung auf Endgeräten geeignet ist.

Das mit DeepSeek destillierte Qwen-7B-Modell konnte mit dem fortschrittlichsten GPT-4o-Cloud-Modell mithalten, das letztes Jahr eingeführt wurde.

Dies bedeutet auch, dass viele Modelle, die in der Vergangenheit nur große Parameter in der Cloud ausführen konnten, auf tragbaren Endgeräten bereitgestellt werden können, um komplexe Argumentationsprozesse lokal abzuschließen, und möglicherweise sogar mit voller Kapazität laufen. Gleichzeitig erleben wir im Rahmen der neuen Welle der geräteinternen KI einen weiteren wichtigen Wandel bei intelligenten Endgeräten – von rein funktionalen Geräten hin zu Agenten mit autonomen Verständnis- und Handlungsfähigkeiten.

Der technologische Wendepunkt der On-Device-KI: von „Scale First“ zur „Ära der Inferenzinnovation“

Vor zwei Jahren veröffentlichte Bill Gates einen Blog, in dem er sagte, er habe in seinem Leben zwei revolutionäre Demos erlebt. Die erste war 1980, als er die grafische Benutzeroberfläche (GUI), den Vorgänger moderner Betriebssysteme, sah, und die andere, als er einige Monate vor GPT-3.5 die Art und Weise sah, wie KI antwortete.

Als normale Benutzer ist die Wahrnehmung dieser Änderung jedoch offensichtlich nicht so stark, da der Träger interaktiver Änderungen nicht von intelligenten Endgeräten getrennt werden kann, genau wie das iPhone Tastenbetätigungen im Feature-Phone-Zeitalter in Touch-Interaktion verwandelte und so das gesamte Smartphone-Ökosystem neu gestaltete.

Was ist dieser Träger im KI-Zeitalter?

Vielleicht handelt es sich nicht unbedingt um eine neue Form von Terminals, sondern um eine neue Form der Erfahrung, die intelligente Terminals bieten – von anwendungsgesteuert zu agentengesteuert.

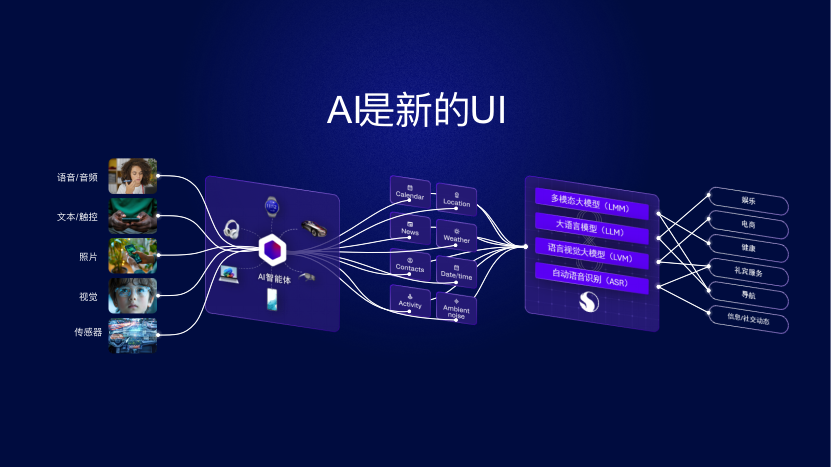

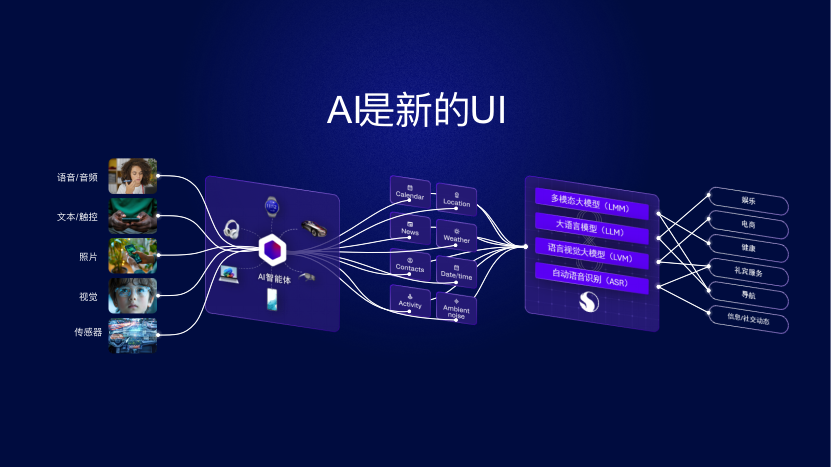

Genau wie der neue Trend, den Qualcomm-CEO Anmon Ende letzten Jahres erwähnte, ist KI die neue Benutzeroberfläche (UI). Die Implementierung endseitiger KI wird die traditionelle Interaktionslogik verändern.

Der Benutzer muss keine bestimmte Anwendung öffnen und der KI-Agent kann Aufgaben direkt über multimodale Eingaben (Sprache, Bild, Video) ausführen. Diese Funktionen sind eigentlich untrennbar mit der Edge-Side-KI-Unterstützung verbunden.

Beispielsweise erfordern viele interaktive Funktionen des YOYO-Agenten in der Honor Magic7-Serie die Unterstützung von KI-Verarbeitungsfunktionen auf der Terminalseite. Die mit der Snapdragon 8 Extreme Edition ausgestattete Qualcomm Hexagon NPU bietet ausreichend KI-Rechenleistung für die Terminalseite, um KI-Aufgaben wie Denken und Verstehen lokal auf dem Telefon zu erledigen.

In der Vergangenheit war die geräteseitige KI durch die Hardwareleistung begrenzt, aber die Rechenanforderungen für große Modelle steigen rasant. Obwohl Smartphones, die mit Snapdragon 8 Extreme Edition ausgestattet sind, Modelle im Maßstab 7B auf dem Gerät ausführen konnten, müssen einige komplexe generative KI-Anwendungsfälle und -Aufgaben wie die Generierung hochwertiger Bilder immer noch mit Cloud-Computing-Leistung kombiniert werden.

Allerdings ist nun der technische Wendepunkt der geräteseitigen KI erreicht. Das Whitepaper „AI Transformation is Promoting Terminal-Side Reasoning Innovation“ weist auf vier Haupttrends hin, die die Implementierung geräteseitiger KI beschleunigen sollen:

- Die aktuellen fortschrittlichen kleinen KI-Modelle verfügen bereits über eine hervorragende Leistung. Durch Modelldestillation und neue Netzwerkarchitektur hat die Leistung die größeren Modelle übertroffen, die vor einem Jahr nur in der Cloud ausgeführt werden konnten.

- Die Größe der Modellparameter nimmt rapide ab, und fortschrittliche Quantisierungs- und Bereinigungstechniken ermöglichen es Entwicklern, die Modellgröße zu reduzieren und gleichzeitig die Genauigkeit beizubehalten.

- Entwickler können am Edge umfangreichere Anwendungen erstellen, z. B. Textzusammenfassung, Programmierassistenten und Echtzeitübersetzung

- Lassen Sie Agent zu einem neuen Interaktionsportal werden, und personalisierte multimodale KI-Agenten vereinfachen die Interaktion

Ma Dejia, Senior Vice President und General Manager des Technologieplanungs- und Edge-Solutions-Geschäfts von Qualcomm Technologies, sagte gegenüber iFaner, dass Modelle mit einer Parameterskala von 1 bis 2 Milliarden künftig weniger Arbeitsspeicher beanspruchen und sich besser an Terminals mit Speichereinstellungen von 8 bis 12 GB anpassen werden, da die Modellskala weiter abnimmt.

Heterogene Computerarchitektur: die Hardware-Grundlage der endseitigen KI

Qualcomm Technologies verfügt über drei branchenführende Prozessoreinheiten, die für die Entwicklung endseitiger KI von großer Bedeutung sind.

Ma Dejia sagte: „Wir verfügen über branchenführende kundenspezifische Qualcomm Oryon-CPUs und haben sie auf unseren PC-, Mobil- und Automobilplattformen eingesetzt.“

Die Qualcomm Adreno GPU kann die vielen funktionalen Anforderungen erfüllen, die für den terminalseitigen KI-Betrieb erforderlich sind. Darüber hinaus ist die Qualcomm Hexagon NPU vollständig auf die Bewältigung generativer KI-Workloads ausgelegt.

Diese drei großen Prozessoreinheiten müssen über branchenführende Fähigkeiten verfügen und in der Lage sein, zusammenzuarbeiten, um heterogenes Computing zu erreichen und die Entwicklungsanforderungen der generativen KI zu erfüllen. Qualcomm hat in diesem Bereich einen großen Vorteil.

Die Implementierung terminalseitiger KI hat höhere Anforderungen an die Chiparchitektur gestellt. Der Ansatz von Qualcomm besteht darin, NPU, GPU und CPU in die heterogene Computerarchitektur im Terminal zu integrieren und so eine höhere Rechenleistung bei geringerem Stromverbrauch zu erzielen und den Anforderungen von KI-Verarbeitungsaufgaben in verschiedenen Szenarien gerecht zu werden.

Der Kern dieser Architektur ist die Zusammenarbeit zwischen den drei großen Prozessoreinheiten wie bei einem Symphonieorchester:

- Qualcomms selbst entwickelte Oryon-CPU: Die neueste Oryon-CPU der zweiten Generation nutzt den 3-nm-Prozess von TSMC mit einer maximalen Hauptfrequenz von 4,32 GHz und einem großen Cache-Design (der branchenweit größte 24 MB L2-Cache), um die KI-Inferenzlatenz deutlich zu reduzieren.

- Qualcomm Adreno GPU: Erfüllt die vielfältigen Funktionsanforderungen für terminalseitige KI-Operationen und schneidet besonders gut bei parallelem Rechnen und Bildverarbeitung ab.

- Qualcomm Hexagon NPU: Speziell für die Bewältigung generativer KI-Workloads entwickelt, wodurch die Snapdragon 8 Extreme Edition eine 45-prozentige Verbesserung der KI-Leistung und eine 45-prozentige Verbesserung der KI-Energieeffizienz erreichen kann.

Unter anderem wird die Oryon-CPU in Mobiltelefonen und Automobilchips wiederverwendet. Dies bedeutet, dass diese Endgeräte eine gemeinsame zugrunde liegende Architektur verwenden können, eine bessere Kompatibilität aufweisen und die Verbindung untereinander reibungsloser erfolgt.

Diese heterogene Computerarchitektur spiegelt sich in vielen der neuesten Flaggschiff-Telefone der Snapdragon 8 Extreme Edition wider, um eine KI-E-Sport-Signal-Engine zu erstellen. Sie optimiert das Netzwerk intelligent, um in Multitasking-Szenarien eine geringere Latenz zu erreichen.

REDMI K80 Pro wendet KI-Technologie auf das Verbindungserlebnis an und bietet Xiaomi Star AI-Multi-Netzwerk-Integration, die eine intelligente Signalvorhersage durchführen und das Netzwerk automatisch optimieren kann. In der U-Bahn-Szene wird die WeChat-Videoverzögerungsrate um 31 % und die kurze Videoverzögerungsrate um 29 % reduziert.

Wenn intelligente Terminals in die Ära der Agenten eingetreten sind, ist die heterogene Computerarchitektur das „zentrale Nervensystem“ des intelligenten Agenten. Sie verarbeitet nicht nur verschiedene sensorische Informationen, sondern koordiniert auch „Denken“ und „Handeln“, um den effizienten, reibungslosen und stabilen Betrieb der End-KI zu gewährleisten.

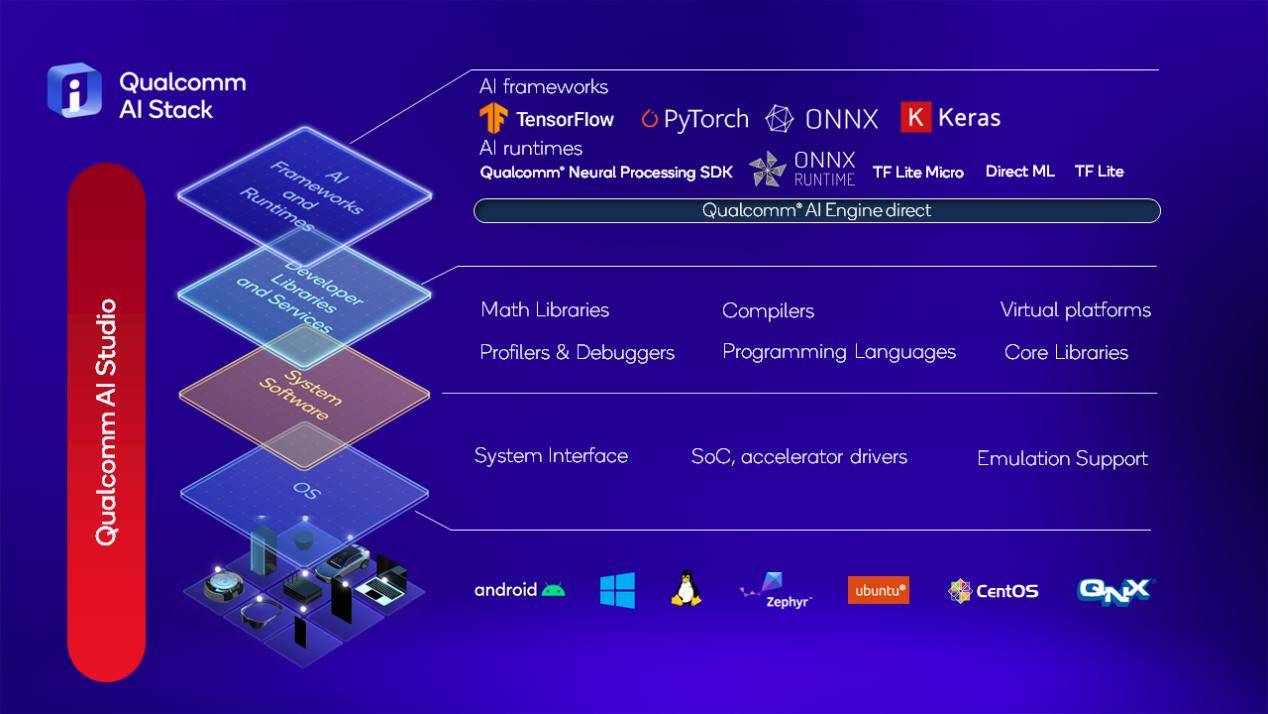

Software ist auch der Schlüssel zur Erschließung des Potenzials endseitiger KI

Genauso wie Hochleistungsrennen nicht nur einen leistungsstarken Motor, sondern auch eine präzise Abstimmung und einen hervorragenden Fahrer erfordern. Die Implementierung von On-Device-KI ist nicht nur auf leistungsstarke Hardware-Rechenleistung angewiesen, sondern erfordert auch eine effiziente und vollständige Unterstützung durch Softwaretools.

Für Entwickler besteht eigentlich keine Notwendigkeit, die spezifischen Designdetails der Hardware zu kennen. Wichtiger ist die Unterstützung der Software-Tool-Bibliothek, die es ihnen ermöglicht, das erforderliche Framework, die Laufzeit und die Tools entsprechend ihren eigenen Anforderungen frei und flexibel auszuwählen und KI-Anwendungen und Agenten für jedes Betriebssystem zu entwerfen.

Qualcomm stellt nicht nur die Hardware-Grundlage bereit, sondern baut auch einen KI-Software-Stack auf, einschließlich Bibliotheken, SDKs und Optimierungstools, der die Modellbereitstellung vereinfachen und die Leistung verbessern kann.

Entwickler können diese Ressourcen nutzen, um Modelle effizient an Qualcomm-Plattformen anzupassen und die Markteinführungszeit für KI-fähige Anwendungen zu verkürzen. Unabhängig davon, wie leistungsfähig die Rechenleistung der endseitigen KI ist, kann sie nur durch Anwendungen freigesetzt und letztendlich in ein Benutzererlebnis umgewandelt werden.

In praktischen Anwendungen können Sie zum Telefon greifen, um die Zutaten zu identifizieren, die Sie zum Kochen verwenden. Nach erfolgreicher Identifizierung kann das Telefon Ihnen bei der Erstellung der entsprechenden Rezepte helfen und Sie können das Telefon auch bitten, Ihnen einige kalorienarme Menükombinationen zu geben.

Nach dem Kochen können Sie mithilfe der Kamera Ihr Telefon nach den im Essen enthaltenen Kalorien fragen. Da Smartphones mittlerweile multimodale KI-Funktionen unterstützen, kann dieser Anwendungsfall geräteseitig vollständig umgesetzt werden.

Dieses Szenario ist eine typische Anwendung intelligenter Agenten als neue Plattform – Benutzer müssen nicht mehr mehrere Anwendungen öffnen, sondern können komplexe Aufgaben direkt durch natürliche Interaktionen erledigen.

Diese entwicklerzentrierte Strategie hat den Prozess der Integration fortschrittlicher KI-Funktionen in Verbraucher- und kommerzielle Produkte erheblich vereinfacht und beschleunigt auch die Anwendung von KI-Argumentationsinnovationen auf der Geräteseite.

AI Hub entwickelt sich zu einer Schatztruhe für Entwickler

Derzeit haben viele Smartphone-, PC- und Automobilhersteller DeepSeek in Endgeräte integriert und damit begonnen, hochwertige kleine Modelle zu verwenden, um das KI-Erlebnis auf der Endgeräteseite zu verbessern oder neue KI-Anwendungen zu erstellen. Die Innovation bei Edge-Side-KI-Anwendungen steht kurz vor dem Start.

Wenn Sie Entwickler sind, besteht auch ein dringenderer Bedarf an der Bereitstellung von KI auf Chipplattformen in verschiedenen Segmenten. Der von Qualcomm letztes Jahr veröffentlichte Qualcomm AI Hub machte einen großen Schritt nach vorne und ermöglichte es Entwicklern, die entsprechende Plattform und das entsprechende Entwicklungsmodell auszuwählen, Anwendungen zu schreiben und diese schließlich auf verschiedenen Arten von mobilen Endgeräten bereitzustellen.

Qualcomm AI Hub enthält mehr als 100 voroptimierte KI-Modelle wie Llama, Allam 3B, Tongyi Qianwen, OpenAI und Modelle anderer Hersteller und unterstützt die nahtlose Bereitstellung auf Terminals, die mit der Snapdragon-Plattform ausgestattet sind. Ein Jahr nach seiner Veröffentlichung nutzen ihn derzeit mehr als 1.500 Unternehmen und fördern so die Popularisierung geräteseitiger KI-Anwendungen.

Die Zahl der von AI Hub abgedeckten Terminals nimmt ebenfalls zu. Ma Dejia stellte uns vor, dass Qualcomm AI Hub mobile, PC-, IoT-, Automobil- und sogar Wi-Fi-vernetzte Terminalplattformen unterstützen kann, wie beispielsweise die Qualcomm Robot RB3-Plattform der zweiten Generation, eine Roboterplattform für den IoT-Bereich.

Qualcomm entwickelt sich zu einem geräteseitigen Entwickler von KI-Ökosystemen. Durch die aktive Zusammenarbeit mit globalen Herstellern von KI-Modellen bietet Qualcomm nicht nur eine leistungsstarke Computerplattform, sondern entwickelt auch einen vollständigen Software-Stack und Entwicklungstools, die es Entwicklern ermöglichen, KI-Modelle einfacher in Anwendungen zu integrieren.

Bevor die Agenten-Ära intelligenter Terminals wirklich anbricht, muss die Branche ein vollständiges geräteseitiges KI-Ökosystem aufbauen.

Qualcomm wird zum Chefarchitekten der geräteseitigen KI

In der Sui-Dynastie in China wurde Yu Wenkai geboren, ein Experte für Bautechnik mit langjährigem Ruf. Er plante nicht nur ein Netzwerk von Wasserstraßen, die von Norden nach Süden verlaufen, sondern entwarf auch innovativ ein Schiffsschleusensystem, um das technische Problem der Schiffe zu lösen, die zwischen verschiedenen Wasserständen fahren. Nutzen Sie den systematischen Gedanken „Das Allgemeine wird gedeihen, die Blockade wird abnehmen“, um die verstreuten Flüsse in ein miteinander verbundenes Transportnetz zu integrieren.

Dies ähnelt stark der einheitlichen und effizienten Computergrundlage, die Qualcomm für geräteseitige KI bereitstellt. So wie der Bau des Canal Grande die Bewältigung vieler Herausforderungen wie Gelände und Hydrologie erforderte, sieht sich die On-Device-KI vielfältigeren und komplexeren Anforderungen durch unterschiedliche Endgeräte und unterschiedliche Anwendungsszenarien gegenüber. Dazu gehören nicht nur Einschränkungen der Hardwareleistung, sondern auch mehrere Einschränkungen wie Modellgröße, Stromverbrauch und Latenz.

Um KI wirklich in diese verschiedenen Terminals zu integrieren, ist, genau wie Yu Wenkai den Canal Grande geplant hat, ein „Chefarchitekt“ erforderlich, der das Design auf höchster Ebene ausführt und eine leistungsstarke zugrunde liegende Architektur erstellt, um den effizienten Betrieb zu unterstützen. Diese Architektur muss nicht nur große Datenmengen verarbeiten können, sondern sich auch flexibel an verschiedene Anwendungsszenarien anpassen lassen.

Dieser Übergang vom Konkreten zum Abstrakten, vom Ingenieurwesen zur Technologie spiegelt tatsächlich den grundlegenden Kontext der Entwicklung der menschlichen Zivilisation wider.

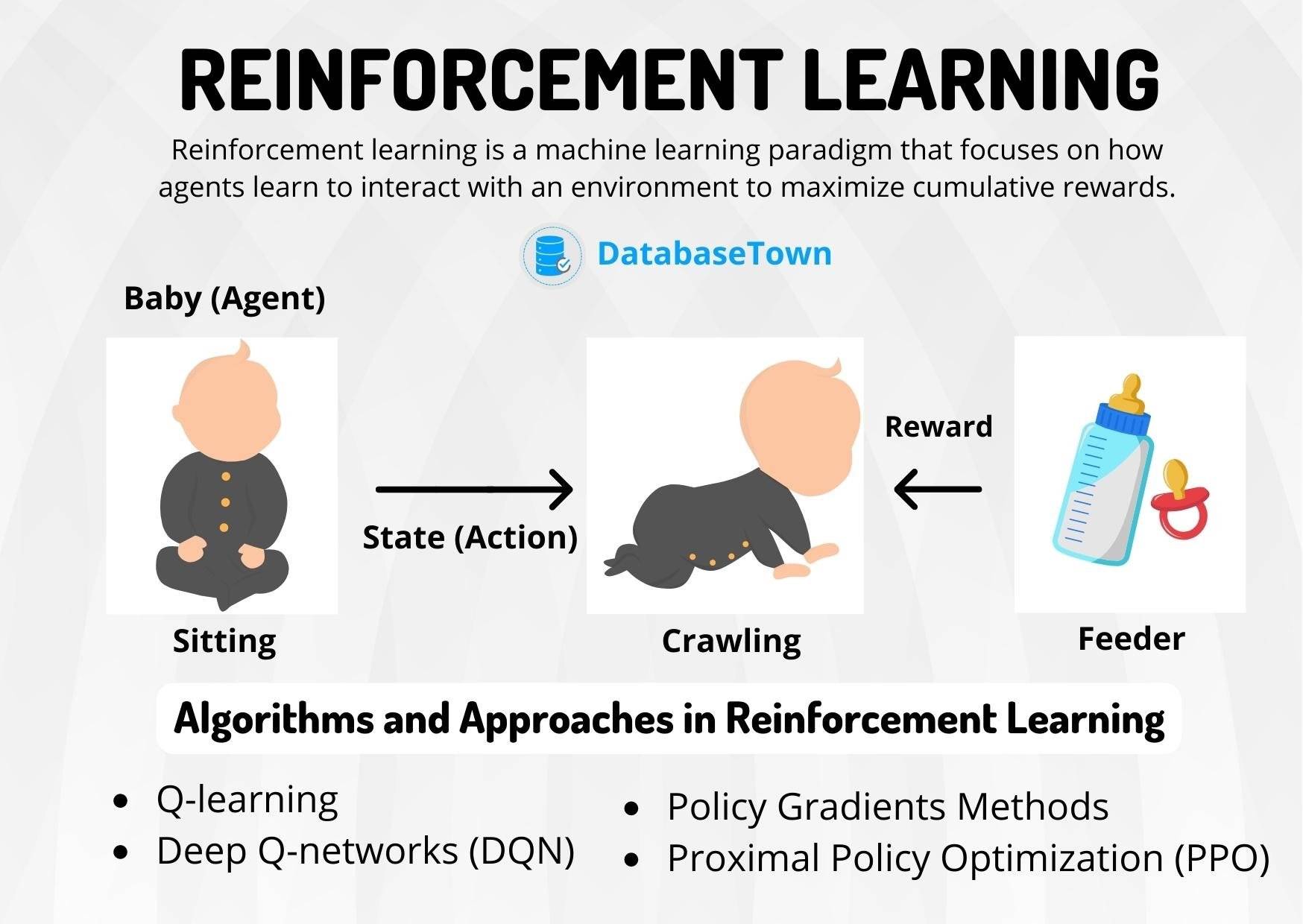

Die ererbte Essenz der menschlichen Zivilisation ist der Prozess der Informationsdestillation. Vom Wort-für-Wort-Kopieren im Mittelalter und der systematischen Struktur des Informationszeitalters bis hin zur Ära des KI-Denkens hat die Verfeinerung von Informationen eine neue Form angenommen – Modelle entwickeln Denkfähigkeiten durch verstärkendes Lernen, so wie Babys die Welt durch kontinuierliche Selbsterkundung verstehen.

Wie der zuvor erwähnte Qualcomm AI Hub ermöglicht die von ihm erstellte voroptimierte Modellbibliothek Entwicklern, an Endgeräte angepasste Modelle auf die technische Basis von Qualcomm-Mobiltelefonen, PCs, Autos und anderen Endgeräten anzuwenden.

Die Modellreduzierung ist der Schlüssel zur Popularisierung der End-Side-KI. DeepSeek-Destillationsmodelle können bereits direkt auf Smartphones und PCs der Snapdragon-Plattform ausgeführt werden. Dieser technologische Durchbruch ähnelt dem wassersparenden Tordesign im Grand Canal-Projekt, das maximale Verkehrseffizienz bei minimalem Ressourcenverbrauch erreicht.

Gleichzeitig explodiert die Innovationskraft im KI-Denken.

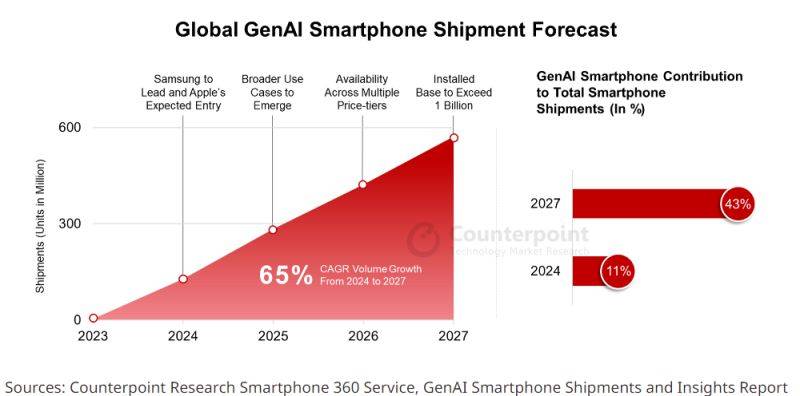

Das Forschungsunternehmen Counterpoint Research prognostiziert, dass das Jahr 2025 ein entscheidender Wendepunkt für generative KI-Telefone sein wird.

Die generative KI-Technologie wird zu einem Standardmerkmal von Mobiltelefonen der mittleren bis oberen Preisklasse. Es wird erwartet, dass die weltweite Verbreitung von Mobiltelefonen mit generativer KI von 19 % im Jahr 2024 auf 29 % im Jahr 2025 steigen wird, wobei die Auslieferungen von Mobiltelefonen mit generativer KI bis 2027 voraussichtlich 550 Millionen Einheiten erreichen werden (was 43 % des Gesamtmarkts ausmacht).

Darüber hinaus wird erwartet, dass der Umfang globaler Edge-KI-Chips von 7,6 Milliarden US-Dollar im Jahr 2023 auf 25,2 Milliarden US-Dollar im Jahr 2027 ansteigt (CAGR 27,1 %), wobei Automobile, industrielles IoT und medizinische Versorgung die Kernwachstumsbereiche sind.

Qualcomm entwickelt sich zum Chefarchitekten der End-Side-KI.

Die Fähigkeiten der endseitigen KI werden in jede Ecke des Terminals eingebracht, von Smartphones bis zu Autos, von XR-Headsets bis zu PCs. Es entsteht ein technologischer „Großer Kanal“, der verschiedene Terminals verbindet und den freien Fluss von Informationen fördert.

# Willkommen beim offiziellen öffentlichen WeChat-Konto von Aifaner: Aifaner (WeChat-ID: ifanr) wird Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner |. Ursprünglicher Link · Kommentare anzeigen · Sina Weibo