Ist der große Modell-Token zu teuer? Apple wird Entwicklern „keine Gebühren“ berechnen

Der Nachgeschmack von Apple Intelligence, das auf der letztjährigen WWDC überbewertet und dann von Apple zurückgewiesen wurde, ist immer noch spürbar.

Am frühen Morgen des 10. Juni 2025 war die Hauptrede (aufgezeichnet) der WWDC25 gerade zu Ende gegangen, und der Teil, der sich auf KI bezog, ließ die Leute immer noch von Zeit zu Zeit seufzen: „Das war’s.“

Viele der sogenannten neuen Funktionen, die Apple in diesem Jahr im Bereich KI angekündigt hat, wie etwa Echtzeitübersetzung und Kurzbefehle, sind nicht sehr revolutionär. Was die visuelle Intelligenz betrifft, hinkt sie nicht nur funktional sechs oder sieben Jahre hinter Google Lens her, sondern auch das interaktive Erlebnis ist weit vom Niveau der integrierten KI-/Agent-Produkte einer Reihe von Android-Konkurrenten im ersten Halbjahr 2025 entfernt.

Aber nachdem ich mir die ganze Sendung angesehen habe, kann ich behaupten, dass es nur eine Neuigkeit über Apples Intelligenz gibt, die weitreichende Auswirkungen haben wird – sowohl für normale Benutzer als auch für Entwickler.

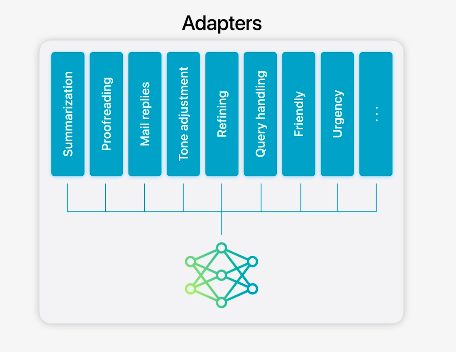

Es handelt sich um das „Foundation Models Framework“, ein von Apple für Entwickler bereitgestelltes Framework für den Zugriff auf endseitige KI-Modelle. Mithilfe dieses Frameworks können Apple-Entwickler problemlos und ohne Token-Kosten auf das endseitige große Sprachmodell für ihre Apps zugreifen.

Dies bedeutet, dass Entwickler Benutzern ohne jegliche Belastung LLM-basierte Funktionen und Dienste bereitstellen und reines End-Side-Reasoning durchführen können, ohne sich um die Token-Gebühren kümmern zu müssen, die durch den Aufruf der Cloud-LLM-API entstehen, und die Kosten natürlich nicht an die Benutzer weitergeben müssen.

Entwickler können das Preismodell ihrer Wahl seriöser beibehalten und die Benutzer profitieren davon.

Apple smart, reines End-to-End

Letztes Jahr kündigte Apple auf der WWDC eine Reihe von KI-Produkten, Funktionen und technischen Möglichkeiten an, die Entwicklern unter dem Namen „Apple Intelligence“ zur Verfügung gestellt werden könnten. Wir wissen bereits, dass die meisten dieser Ankündigungen verspätet erfolgten oder sogar komplett als „Vaporware“ (angekündigte, aber stark verzögerte Software) erschienen.

Dies beeinflusst die Beurteilung des Erfolgs von Apple im Bereich der KI durch die Außenwelt.

Apple liefert jedoch nach wie vor die meisten Smartphones weltweit aus. Auch wenn das Unternehmen bei Cloud-LLM mit großen Parametern nur langsam reagiert, hat es dennoch großen Einfluss darauf, wie Menschen KI nutzen und wie Entwickler KI-Technologie in ihren Projekten einsetzen – das ist objektiv und unbestreitbar.

Auf der WWDC25 dieses Jahr habe ich gesehen, wie Apple von diesem Rederecht Gebrauch machte. Das Unternehmen teilte den Entwicklern mit:

Möchten Sie Nutzern KI-Funktionen zur Verfügung stellen? Kein Problem. Mit dem von Apple bereitgestellten End-Side-Modell können Sie LLM-Reasoning vollständig lokal auf dem Gerät durchführen, ohne dass eine Internetverbindung erforderlich ist. Dies schützt die Privatsphäre der Nutzer und verursacht keine Cloud-Gebühren.

Das „Basic Model Framework“ ist ein leistungsstarkes Tool, das Apple den Entwicklern übergeben hat.

Das Basismodell bildet den Kern der Intelligenz von Apple. Letztes Jahr wurde es ausschließlich für Apples eigene Produkte und Funktionen verwendet. Ab heute hat Apple das Basismodell für Entwickler geöffnet. Jede Drittanbieteranwendung kann diese terminalseitigen Basismodelle direkt nutzen, um KI-basierte Funktionen zu implementieren und Nutzern ein völlig neues Erlebnis zu bieten.

Beispielsweise kann Kahoot!, ein vor Ort vorgeführtes Bildungsprodukt, das clientseitige Modell verwenden, um einen auf die Benutzer zugeschnittenen Fragensatz zu generieren.

Oder Alltrails, ein Must-Have-Produkt für Wanderfreunde im Ausland, kann den Benutzern auch in Situationen die nötige Unterstützung bieten, in denen in gefährlichen Bergregionen überhaupt kein Netz vorhanden ist.

Was sind also die Basismodelle?

- Letztes Jahr veröffentlichte Apple auf der WWDC ein End-to-End-Sprachmodell mit 3 Milliarden Parametern sowie die nachfolgende aktualisierte Version.

- Für Client/Apple angepasstes ChatGPT-Modell.

——Zumindest diese beiden Kategorien sind bekannt (die spezifischen Modelltypen sind unbekannt, und Apple hat Nicht-Entwicklern noch keine genaueren Informationen zur Verfügung gestellt). Derzeit unterstützt das „Basic Model Framework“ Swift nativ (andere Sprachen sind unbekannt), und Entwickler benötigen nur wenige Codezeilen, um darauf zuzugreifen und die Inhaltsgenerierung, Toolaufrufe und andere LLM-Funktionen zu unterstützen.

Doch heutzutage haben Entwickler zu viele Möglichkeiten: DeepSeek, Claude, O-Serie, Gemini … und deren verschiedene offizielle Modelle und überarbeitete Versionen für bestimmte Szenarien. Warum sollten sie mit Apples Basismodell konkurrieren?

Das Wertversprechen von Apple ist unkompliziert.

Kurz gesagt: Die Nutzung dieser LLMs verursacht direkte wirtschaftliche Kosten. Je größer die Anzahl der Benutzer und je aktiver bzw. beständiger sie sind, desto höher sind die Kosten für den Aufruf der Cloud-API und die Generierung von Token.

Angesichts dieser Kosten können Star-Startups über Risikokapital Mittel beschaffen, und große Unternehmen können diese über ihre Barreserven subventionieren. Daher sind die heutigen Benutzer seit langem an kostenlose LLM-Produkte gewöhnt.

Für kleine und mittelgroße Entwickler, insbesondere unabhängige Entwickler, wird dies jedoch zu einem sehr praktischen Problem: Stellen Sie sich vor, ein Benutzer hat gerade Ihre App heruntergeladen und möchte Ihre KI-Funktion ausprobieren, und sofort sieht er: „Diesen Monat gibt es 3 kostenlose Generierungskontingente“ … und wenn einer Ihrer Konkurrenten zufällig ein großes Unternehmen ist, wie können Sie dann mit ihm konkurrieren?

Jetzt kommt Apple mit dem „Basic Model Framework“ zu Ihnen und stellt Ihnen das End-Side-Modell kostenlos zur Verfügung, sodass Sie die lokale Rechenleistung von iPhone/iPad/Mac nutzen können, um LLM-Argumentation schnell, effizient und privat durchzuführen und so die Benutzeranforderungen zu erfüllen.

Sie müssen sich keine Gedanken mehr über Ihre Kapitalkette machen, um Cloud-API-Gebühren zu bezahlen. Sie müssen Ihre Preisstrategie nicht mehr ändern, um Token-Kosten zu decken. Sie können sich klar und deutlich für das Geschäftsmodell entscheiden, das Ihnen gefällt und mit dem sich Ihre Nutzer wohlfühlen – ob Sie ein kleiner, mittlerer oder unabhängiger Entwickler sind, klingt das nicht großartig?

Es ist eine Win-Win-Situation für Entwickler und Benutzer – und wenn dann noch Apple dazukommt, ist es eine Win-Win-Win-Situation für alle.

„Spät, aber angekommen“, KI-Version

Der bekannte Entwickler und Apple-Analyst John Gruber hat vor einigen Tagen einen sehr interessanten Blogbeitrag geschrieben.

Er wies darauf hin, dass Apple bei einigen wichtigen Produkten/Technologien immer hinter der Konkurrenz zurückliegt, was jedem bekannt sei. Allerdings müsse man zugeben, dass Apple in seiner Firmengeschichte tatsächlich keine bedeutende technologische Revolution auf Paradigmenebene verpasst habe.

So kamen beispielsweise Apples Safari-Browser und sein Browser-Kernel WebKit Anfang 2003 auf den Markt, acht Jahre später als der Netscape-Browser, der einst weltweit für Furore sorgte und sogar Microsoft in den Ruin zu treiben drohte, und sogar drei Jahre nach dem Platzen der „.com-Blase“. Aber besser spät als nie, ganz abgesehen davon, dass es vor Safari keinen guten Browser auf der Mac-Plattform gab.

Wendet man diese Logik an, benötigt Apple, das gezwungen ist, in das KI-Zeitalter einzutreten, eine neue Produkttechnologiekombination, die mit dem heutigen Safari/WebKit mithalten kann.

Die gute Nachricht ist: Wie eingangs erwähnt, sind die Auslieferungszahlen und der Marktanteilsvorteil des iPhones zu groß. So sehr die Außenwelt Apple auch dafür verspottet, dass es im KI-Zeitalter hinterherhinkt, eine Realität lässt sich nicht leugnen:

Apple wird noch lange Zeit genug Mitspracherecht haben, um zu bestimmen, wie Benutzer KI verwenden (auf iPhone/iPad/Mac/Vision-Produkten), anstatt die KI bestimmen zu lassen, wie seine Produkte aussehen sollen.

Sie können sehen, dass OpenAI das Unternehmen des ehemaligen Apple-Designchefs Jony Ive übernommen hat, um ein Gerät mit neuem Formfaktor zu entwickeln, das „vollständig KI-nativ“ ist. Sie werden aber auch sehen, dass OpenAI und Apple eine Vereinbarung getroffen haben, der einzige „globale Smart-Partner“ im Apple-Ökosystem zu werden – das heißt, der einzige externe Anbieter von Basismodellen.

Glaubt Apple, hinter OpenAI zurückzubleiben? Nein. Andernfalls müsste Apple OpenAI bezahlen. Im Gegenteil, laut The Information wird OpenAI Apple eine „Maut“ zahlen, um in das Apple-Ökosystem einzutreten und zum Standard-Basismodell zu werden, genau wie sein Vorgänger Google, der zur Standardsuchmaschine für iOS wurde.

Wenn die monatliche Abonnementgebühr für ChatGPT-Benutzer 20 US-Dollar beträgt, könnte Apples Provision bis zu 30 % betragen und dieser Umsatz entspricht fast dem reinen Gewinn.

Sehen Sie, Apple sammelt Geld von OpenAI und subventioniert dann verdeckt Entwickler und Endbenutzer – ist das nicht ziemlich überraschend?

Bei Apples Bilanzkonferenz zum ersten Quartal 2009 sagte Cook, der aufgrund von Jobs schwerer Erkrankung zum zweiten Mal als amtierender CEO fungierte, einige Worte, die später als „Cook-Credo“ bekannt wurden. Eines dieser Worte lautete:

Wir sind davon überzeugt, dass wir die grundlegenden Technologien hinter den von uns hergestellten Produkten besitzen und kontrollieren müssen und uns nur an Märkten beteiligen dürfen, in denen wir einen wesentlichen Beitrag leisten können.

Zusammen mit der Analyse von John Gruber habe ich diese Idee in einem Satz zusammengefasst:

Apple sollte ein Gerät und einen Träger für die Ausführung von KI-Produkten/-Diensten/LLM entwickeln und dieses Gerät/diesen Träger dann nutzen, um zu definieren, wie Menschen KI nutzen, anstatt die KI bestimmen zu lassen, wie Produkte entwickelt werden.

Nach der WWDC25 könnte die Außenwelt diese neue Perspektive übernehmen, wenn sie die KI-Arbeit von Apple beobachtet und kommentiert.

Apple Smart, Mikro-Update

Werfen wir abschließend einen Blick auf weitere neue KI-Ankündigungen von WWDC25.

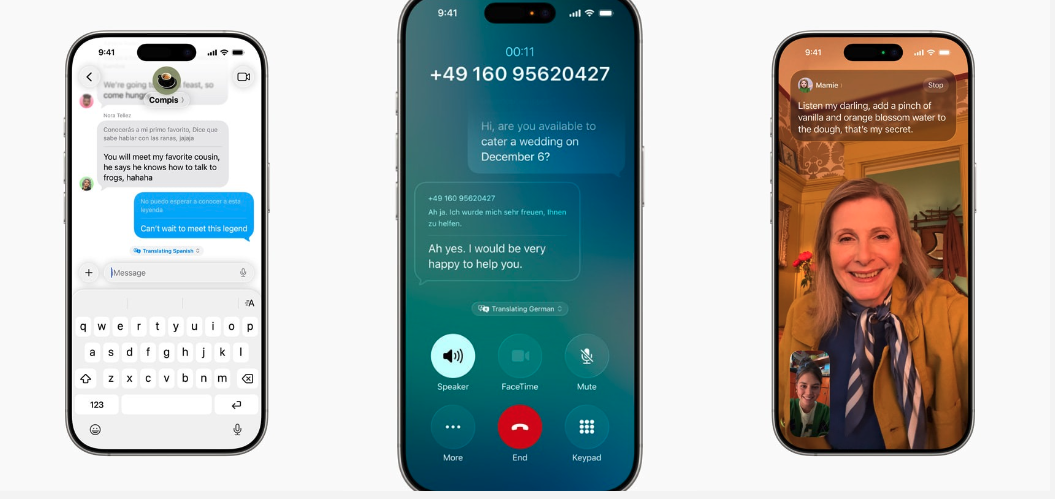

Echtzeitübersetzung

Apple hat endlich eine Echtzeit-Übersetzungsfunktion in iOS/iPadOS/macOS integriert, die das Branchen-Benchmark-Niveau erreicht (vor zwei oder drei Jahren).

Derzeit unterstützt die Echtzeitübersetzung drei Anwendungen: Nachrichten, Telefon und FaceTime. Alle Übersetzungen können vollständig clientseitig durchgeführt werden.

- Beim Senden einer Nachricht kann der Benutzer diese in seiner eigenen Sprache eingeben, die Streaming-Ausgabe des übersetzten fremdsprachigen Textes in Echtzeit auf der Benutzeroberfläche sehen und dann manuell auf „Senden“ klicken. Ebenso kann die von der anderen Partei gesendete Nachricht auch automatisch auf der lokalen Benutzeroberfläche des Benutzers übersetzt werden.

- Beim Telefonieren wird zunächst der Originaltext gesprochen, anschließend können beide Gesprächspartner den übersetzten Text hören.

- In FaceTime kann eine Partei sprechen und die andere Partei kann die übersetzten Untertitel sehen.

Genmoji und Image Playground

Genmoji: Benutzer können jetzt LLM-Eingabeaufforderungen verwenden, um Genmoji-Avatare mit weiteren neuen Elementen zu generieren. Zum Beispiel: Kombinieren Sie ein Faultier und eine Glühbirne

In Image Playground können Benutzer das multimodale Modell von ChatGPT aufrufen, um Fotos in verschiedenen oder zufälligen Stilen zu generieren – Sie können sich dies als offizielle Apple OpenAI 4o-Shell vorstellen.

Visuelle Intelligenz

Visual Intelligence unterstützte bereits zuvor die Kamerafotosuche und erhielt auf der diesjährigen WWDC ein weiteres überraschendes Update: Unterstützung für die Screenshot-Suche/anschließende Interaktion.

So können Sie beispielsweise durch den Aufruf einer beliebigen App Store App direkt nach Elementen im Screenshot suchen oder Datum, Uhrzeit und Ort im Screenshot ablesen und einem Kalendereintrag oder einer Notiz hinzufügen.

(Die visuelle Intelligenz holt endlich das ein, was Google Image Search und Lens vor 6 oder 7 Jahren erreicht haben.)

Aber was vor allem sprachlos macht, ist die zu altmodische Interaktionsmethode: Screenshots, anstatt wie bei Android-Telefonen in der ersten Hälfte des Jahres 2025 zu sein, die den Inhalt auf dem Bildschirm des Benutzers direkt lesen und darauf reagieren können, ohne Screenshots zu machen, und sogar über Agentenfunktionen verfügen, die den Bildschirm im Namen des Benutzers direkt steuern können.

Meines Wissens nach könnte Apple hierfür zwei Gründe haben: 1) Die Funktionen sind denen der Hersteller von Google/Android tatsächlich unterlegen; 2) aus Datenschutzgründen müssen die Benutzer manuell Screenshots erstellen und auf die Schaltfläche zur visuellen Smart-Erkennung klicken.

Verknüpfungen

Shortcuts unterstützt Apple-Smartphones, sodass Entwickler ihre Apps anpassen und schnell Shortcuts für Apps erstellen können. Ich weiß nicht, wie viele Leute Shortcuts verwenden, aber es dürfte Dutzende davon weltweit geben.

#Willkommen beim offiziellen öffentlichen WeChat-Konto von iFanr: iFanr (WeChat-ID: ifanr), wo Ihnen so bald wie möglich weitere spannende Inhalte präsentiert werden.