Dieser KI-Bildgenerator hat sein erstes Videomodell veröffentlicht: keine Auflösung, aber Internetnutzer sagten, das Bild sei erstaunlich und habe die Erwartungen übertroffen mit prompten Worten

Angesichts der Urheberrechtsklagen von Disney und Universal Pictures hat das erfahrene Grafikdesign-„Einhorn“ Midjourney sein Tempo nicht gedrosselt. Stattdessen brachte es am frühen Morgen unter Druck sein erstes Videomodell heraus.

Die Farbabstimmung ist präzise, die Komposition exquisit, die Emotionen sind voll und der Stil ist immer noch online.

Midjourney bietet keine hohe Auflösung oder lange Brennweiten, sondern eine einzigartige Atmosphäre und ästhetische Wiedererkennung. Midjourney ist ehrgeizig und zielt auf das „Weltmodell“ ab, aber ob das derzeit etwas „grobe“ funktionale Design es noch weiter bringen kann, ist noch ungewiss.

Die strömungssparende Variante sieht wie folgt aus:

- Klicken Sie nach dem Hochladen oder Generieren eines Bildes einfach auf „Animieren“. Standardmäßig gibt eine einzelne Aufgabe vier 5-Sekunden-Videos aus, die auf maximal 21 Sekunden verlängert werden können.

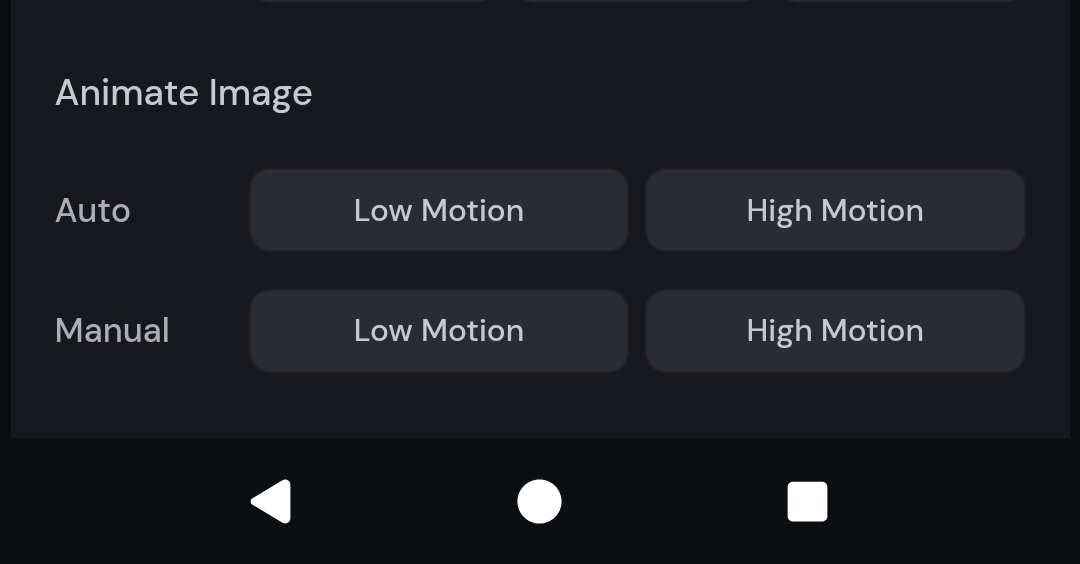

- Unterstützt manuelle und automatische Modi, und Benutzer können den Bilderzeugungseffekt durch Eingabeaufforderungen einstellen; bietet Optionen für geringe und hohe Bewegung, geeignet für statische Atmosphäre bzw. stark dynamische Szenen

- Video ist in bestehenden Abonnements enthalten (10 $/Monat) und nutzt 8-mal mehr GPU-Ressourcen als Grafikaufgaben

- Das Hinzufügen von Soundeffekten, die Bearbeitung der Timeline, Clip-Übergänge und API-Zugriff werden nicht unterstützt. Die Auflösung beträgt lediglich 480p, und das Seitenverhältnis passt sich automatisch an das Bild an. Es handelt sich noch um eine frühe Version.

- Das Videomodell ist ein schrittweises Ergebnis. Zukünftig werden wir weiterhin 3D-Modelle und Echtzeitsysteme einführen und letztendlich das Weltmodell anstreben.

Midjourney-Videomodell jetzt verfügbar

Sie rollen Ihren Vorsatz, ich gehe mit meiner Hyperrealität.

Midjourney war schon immer für seinen fantastischen und surrealen visuellen Stil bekannt. Den Testergebnissen aktueller Nutzer zufolge setzt auch die Videoversion diese ästhetische Linie mit einem stabilen Stil und hohem Wiedererkennungswert fort.

In dem vom Blogger @EccentrismArt geteilten Video fällt ein kleiner Junge senkrecht aus großer Höhe. Die Figur ist einfach und dynamisch gestaltet, als würde sie springen, fallen oder sich im freien Fall befinden. Die Bewegungsbahn ist fließend und der Schwerpunkt der Figur relativ natürlich.

Die Häuserblöcke sind dicht mit Lichtern gefüllt und die Gebäude scheinen sich im Raum zu neigen und zu drehen, wodurch die optische Illusion einer räumlichen Verzerrung entsteht. Die allgemeine Gebäudedynamik weist jedoch keine offensichtlichen Jitter- oder KI-generierten Verbindungsfehler auf.

In diesem Video einer japanischen Straßenbahnszene verlässt die Straßenbahn die Station, und die Sonne geht gerade unter. Die Farbtemperatur ist präzise eingestellt, und die Lichtquelle ist natürlich. Dadurch entsteht ein Rhythmus aus Bewegung in Stille und Stille in Bewegung.

▲Prompt: Der Zug fährt durch den Bahnhof. | @PAccetturo

Die Silhouette einer Frau im Hemd hält ein Dokument oder Buch in der Hand. Dahinter ist die riesige Silhouette eines menschlichen Kopfes zu sehen. Man erkennt, dass die Mehrfachbelichtung/Überlagerung sehr sauber umgesetzt ist, mit natürlichem Lichthof und ohne Überbelichtung. Kein Wunder, dass Perplexity AI-Designer Phi Hoang sagte, es habe die Erwartungen übertroffen.

Der bekannte X-Blogger @nickfloats teilte ein Video von einem Mädchen, das auf einem hell erleuchteten Bahnsteig läuft, während im Hintergrund ein Hochgeschwindigkeitszug vorbeifährt. Die Licht- und Schattenunterschiede waren deutlich zu erkennen, und der dreidimensionale Effekt war stark.

Das gleichzeitige Auftreten von Nacht, Polarlicht, Schnee, Autolichtern, Bewegungsunschärfe und anderen Elementen stellt eine große Herausforderung für das Videogenerierungsmodell dar. Das Modell bewältigt jedoch erfolgreich die Interferenzen mehrerer Lichtquellen; Schneepartikel, Geschwindigkeitsunschärfe und Lichteffekte der Flugbahn sind äußerst konsistent.

▲Prompt: Blauer Subaru der World Rally 2022, rast nachts durch das verschneite Finnland, dramatische Action-Aufnahme, dynamische Bewegungsunschärfe, fliegender Schnee, Nordlichter am Himmel, Scheinwerfer erhellen den Schnee, hoher Kontrast, filmische Beleuchtung | @JamianGerard

In klassischen Raumanzügen tragen die Astronauten eine große Anzahl bunter Lichtspuren, die hinter ihnen verlaufen und die Illusion einer „Reise“ oder „Hochgeschwindigkeitsbewegung“ mit einem starken Gefühl für visuellen Rhythmus erzeugen.

▲Prompt: „Lebe ein bisschen, nimm LSD und fliege davon. Ich fühle mich wie ein Astronaut im Weltraum. Ich glaube nicht, dass es den Schaden anrichtet, den sie sagen. Ich fühle mich wie ein Astronaut im Weltraum.“ | @JamianGerard

Elemente wie Glanzlichter, Materialien und Flüssigkeitsbewegungen bieten Möglichkeiten, die Fähigkeit des KI-Modells zu testen, Stilllebenobjekte darzustellen. In diesem Video wirken Eiswürfel, Sahne und Karamell dynamisch und natürlich, und das Etikett zeigt beim Drehen des Bechers keine offensichtlichen Verzerrungen.

▲Vorgabe: Ein Starbucks-Getränk, klassischer großer Becher, eisgekühlter Karamell-Macchiato, Karamell-Sprudel, Schlagsahne obendrauf, Kondenswasser auf dem Becher, lebendig und appetitlich, hochwertige Getränkefotografie, Seitenverhältnis 1:1. | @JamianGerard

Der Eindruck perspektivischer Tiefe ist klar, Distanz und Nähe sind gut aufeinander abgestimmt und auch der realistische Stil ist stark.

▲Aufforderung: Mitten im Dschungel sitzen, wo sich viele wilde Tiere bewegen S | @JamianGerard

In den apokalyptischen Straßen New Yorks gibt es jede Menge Details wie brennende Autos und Ruinen; das generierte Video muss gemäß den Vorgaben der Prompt-Wörter eine 35mm-Filmtextur aufweisen und ist zudem insgesamt leicht körnig.

▲ Stichwort: Eine Stadtstraße am frühen Morgen, mit brennenden Autos und überall verstreuten Trümmern. Die Szene erinnert an das New York der 1990er Jahre, eingefangen im Stil des Fotografen Jeff Wall mit der körnigen Textur eines 35-mm-Films. | @JamianGerard

Die Kristallkugel schwebt und dreht sich langsam, was die Stabilität der Szene testet, und auch die Kamerabewegung ist ziemlich flüssig.

▲Eingabeaufforderung: Kristalline Kugel schwebt und dreht sich langsam über einem ruhigen, farbenfrohen Feld, Steady-Cam-Aufnahme | @JamianGerard

Es ist erwähnenswert, dass die oben gezeigten Ergebnisse der Fallgenerierung möglicherweise mehrere Runden des „Kartenziehens“ durchlaufen haben, aber gemessen am Endeffekt ist die visuelle Vollendung bereits ziemlich beeindruckend.

Ambitious Midjourney baut den zweiten Baustein des „Weltmodells“

Ab heute können Midjourney-Benutzer Bilder auf der offiziellen Website (Midjourney.com) hochladen oder direkt von der Plattform generierte Bilder verwenden und auf die Schaltfläche „Animieren“ klicken, um Bilder in Videos umzuwandeln.

Jede Aufgabe generiert vier 5-Sekunden-Videos. Nutzer können jedes Segment bis zu viermal verlängern, indem sie jedes Mal vier Sekunden hinzufügen. Die Gesamtlänge beträgt dann bis zu 21 Sekunden. Aller Anfang ist natürlich schwer, und der Beamte sagte, dass Länge und Funktionen in Zukunft weiter ausgebaut werden.

Die Anforderungen an die Bedienlogik sind tatsächlich nicht hoch. Bilder lassen sich wie gewohnt in Midjourney erstellen, allerdings gibt es nun einen zusätzlichen Schritt zur Bildanimation. Darüber hinaus können externe Bilder als „Startbild“ hochgeladen und anschließend mit Eingabeaufforderungen der gewünschte dynamische Effekt beschrieben werden.

V1 bietet einige anpassbare benutzerdefinierte Einstellungen, die es Benutzern ermöglichen, den Bildinhalt detaillierter zu steuern.

Im manuellen Modus können Sie bestimmte Hinweise eingeben, um automatisch festzulegen, wie sich Elemente im Video bewegen und wie sich die Szene entwickelt. Wenn Sie jedoch noch keine Vorstellung von den Hinweisen haben, können Sie eine automatische Einstellung wählen, die automatisch Bewegungshinweise für Sie generiert und die Bilder bewegt.

In puncto Kreativstil können Sie zudem zwischen zwei Bewegungseinstellungen wählen:

- Low-Motion-Modus: Geeignet für atmosphärische Szenen. Die Kamera bleibt meist still und das Motiv bewegt sich langsam oder rhythmisch. Der Nachteil besteht darin, dass manchmal überhaupt keine Bewegung stattfindet (z. B. blinzelnde Personen, eine Brise, die durch die Landschaft weht usw.).

- Bewegungsmodus: Geeignet für Szenen, die viel Bewegung des Objektivs und des Motivs erfordern. Der Nachteil ist, dass starke Bewegungen manchmal zu Bildfehlern oder Instabilitäten führen können.

Preislich ist die Videofunktion direkt in das Abo-System von Midjourney eingebunden und der Einstiegspreis liegt weiterhin bei 10 US-Dollar monatlich.

Laut dem offiziellen Blog benötigt Midjourney pro Video etwa achtmal so viel GPU-Zeit wie Bildbearbeitung. Unter der Voraussetzung, dass Videos mit einer Länge von bis zu 20 Sekunden erstellt werden können, sind die durchschnittlichen Kosten pro Sekunde jedoch fast gleich hoch wie bei der Bildbearbeitung. Im Vergleich zu Konkurrenzprodukten ist die Kosteneffizienz am höchsten.

Wir haben außerdem mithilfe der KI-Suchmaschine die Abonnementgebühren einiger Mainstream-Videomodelle zu Ihrer Information kurz sortiert.

Darüber hinaus testet Midjourney den „Relax Mode“ für Pro- und höhere Abonnenten. Dieser ermöglicht eine langsamere Ausführung der Generierungsaufgabe und reduziert so den Verbrauch von Rechenressourcen. Für andere Nutzerstufen gelten weiterhin Gebühren nach GPU-Zeit und Mitgliedschaftsstufe.

Derzeit gibt es viele Kritikpunkte am Midjourney-Videomodell. Am häufigsten fehlt es an wichtigen Funktionen für professionelle Produktionen.

Zunächst einmal unterstützt das Midjourney-Videomodell im Gegensatz zu Googles Veo 3 oder Lumas Dream Machine derzeit keine automatische Hinzufügung von Hintergrundmusik oder Umgebungsgeräuschen. Falls Audio benötigt wird, muss es weiterhin manuell mit Tools von Drittanbietern hinzugefügt werden.

Zweitens unterstützt das Midjourney-Videomodell keine Bearbeitung der Zeitleiste und die generierten Videoclips sind „Jump Cuts“, wodurch es unmöglich wird, eine Kontinuität der Geschichte und eine natürliche Verbindung zwischen den Bildern zu erreichen, was es schwierig macht, den Handlungsrhythmus oder die emotionale Vorahnung zu kontrollieren.

Darüber hinaus bietet das Midjourney-Videomodell derzeit keinen API-Zugriff.

Wichtiger noch: Die Standardauflösung der von Midjourney generierten Videos beträgt 480p (Standardauflösung) und das Seitenverhältnis wird automatisch an die Originalgröße des Bildes angepasst. Auch beim Hochladen auf andere Plattformen wird die Auflösung als 480p gekennzeichnet.

▲Hinweis: Während der Reise kann das Seitenverhältnis leicht angepasst werden und die Proportionen des endgültigen Ausgabevideos können leicht vom Ausgangsbild abweichen.

Vertreter von Midjourney gaben außerdem zu, dass sich die aktuelle Version noch in der frühen Erkundungsphase befindet und der Schwerpunkt auf Zugänglichkeit, Benutzerfreundlichkeit und Skalierbarkeit liegt.

Das Videomodell ist nur ein Ausschnitt. Midjourney möchte ein umfassenderes System zur Inhaltsproduktion.

Laut dem offiziellen Plan besteht das ultimative Ziel darin, ein „Weltmodell“ zu erstellen, das Bildgenerierung, Animationssteuerung, dreidimensionale Raumnavigation und Echtzeit-Rendering zu integrieren.

Sie können es sich so vorstellen: In einem KI-System, das Bilder in Echtzeit generieren kann, können Sie einen Satz eingeben, um dem KI-Protagonisten zu befehlen, sich im 3D-Raum zu bewegen. Die Umgebungsszene ändert sich entsprechend und Sie können mit allem interagieren.

Um dieses Ziel zu erreichen, benötigen wir wie bei Bausteinen ein Bildmodell (um statische Bilder zu erzeugen) → ein Videomodell (um die Bilder zu bewegen) → ein 3D-Modell (um räumliche Navigation und Linsenbewegung zu erreichen) → ein Echtzeitmodell (um sicherzustellen, dass jedes Bild synchron reagieren kann).

Gemäß dem Produktplan von Midjourney werden diese vier technischen Bausteine in den nächsten zwölf Monaten ausgeliefert und schließlich in ein einheitliches System integriert. Das V1-Videomodell ist als schrittweises Ergebnis der zweite Schritt auf dem Weg zu diesem Endziel.

#Willkommen beim offiziellen öffentlichen WeChat-Konto von iFanr: iFanr (WeChat-ID: ifanr), wo Ihnen so bald wie möglich weitere spannende Inhalte präsentiert werden.