Apple erweitert FaceTime um eine Nacktheitserkennung, eine Wahl zwischen Privatsphäre und Ethik

Sie haben sicher die Werbung von Apple und Yue Yunpeng gesehen, deren Kernaussage lautet:

Das Bestreben, Privatsphäre und Sicherheit zu gewährleisten, ist genau das Richtige für das iPhone.

Apple hat dies gesagt und tatsächlich getan. Wenn jedoch „Datenschutz“ und „Moral“ an die beiden Enden der Skala gestellt werden, steht selbst Apple vor einem Dilemma.

▲ Gemeinsames Werbeplakat von Apple und Yue Yunpeng. Bildquelle: Apple

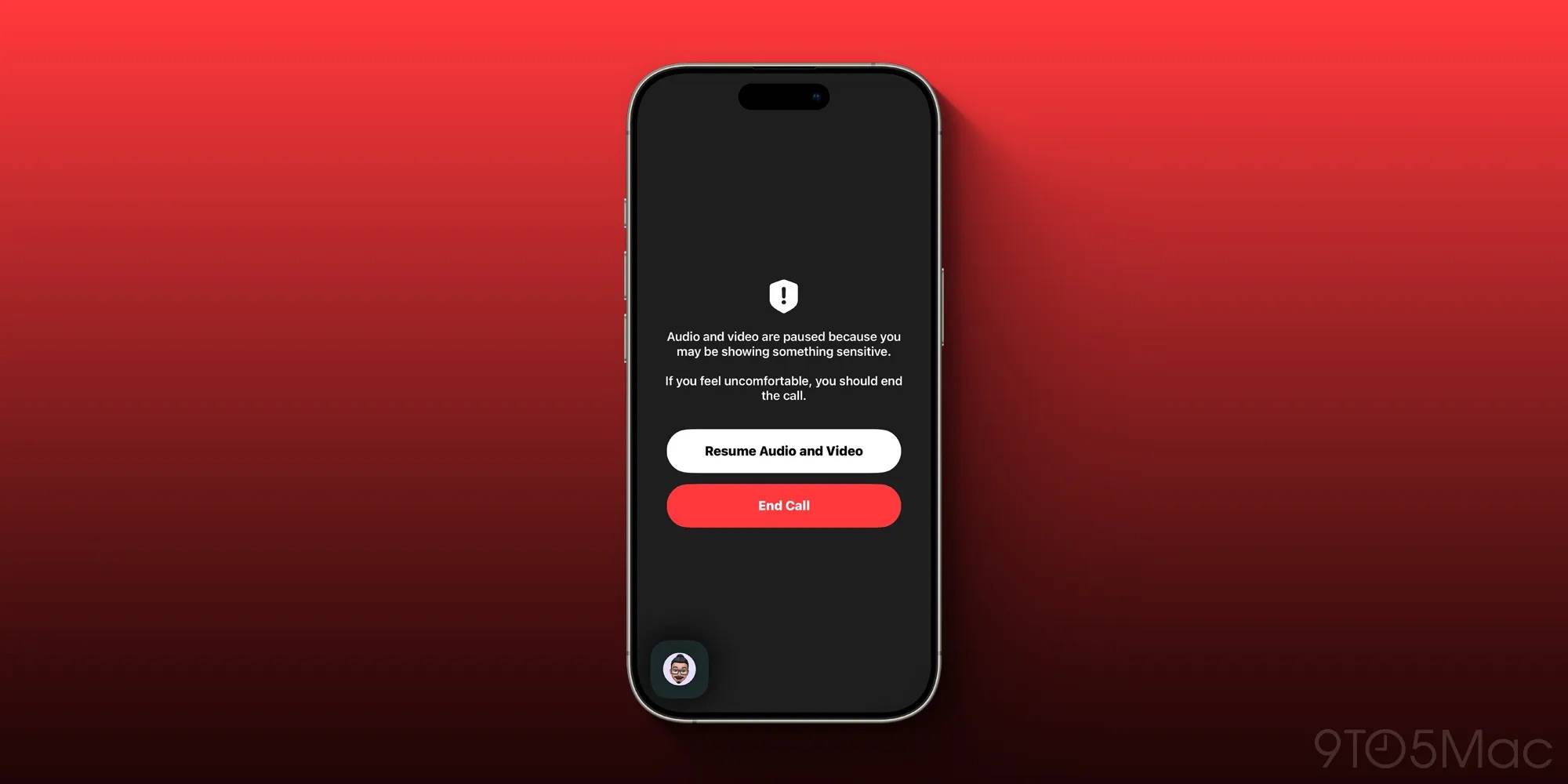

Laut 9to5mac hat Apple in der Entwicklervorschau von iOS 26 eine Funktion zur Nacktheitserkennung für FaceTime eingeführt, die unangemessene Nacktheit bei Videoanrufen erkennen soll.

Es wird berichtet, dass Apple den KI-Algorithmus auf der Geräteseite verwenden wird, um Nacktinhalte in Anrufen in Echtzeit zu identifizieren. Wenn das System mögliche Nacktszenen erkennt, wird der Videoanruf sofort unterbrochen und eine Warnung angezeigt.

Apple sagte, die Funktion sei ursprünglich für die Verwendung auf Kinderkonten konzipiert worden, um Teenagern ein sichereres digitales soziales Umfeld zu bieten.

▲ FaceTime-Oberfläche eingefroren. Bild von: 9to5Mac

Diese Funktion stammt ursprünglich aus dem CSAM-Scan-Programm (Child Sexual Abuse Material), das Apple vor einigen Jahren eingeführt hat. Aus irgendeinem Grund wurde diese Funktion in der Entwicklerversion von iOS 26 jedoch auf Benutzer aller Altersgruppen erweitert. Mit anderen Worten: Auch erwachsene Benutzer sind „geschützt“.

Obwohl Apple betonte, dass die gesamte Erkennung lokal auf dem Gerät erfolgt und die Daten nicht in die Cloud hochgeladen werden, sorgte die Ausweitung der Altersabdeckung in den sozialen Medien für heftige Kontroversen. Ein Nutzer namens krazygreekguy kommentierte auf 9to5mac:

Ich verstehe die dahinterstehende Denkweise, aber sie haben kein Recht, eine derartige Kontrolle über Erwachsene auszuüben. Keine Organisation hat das Recht, in die Privatsphäre von Menschen einzudringen.

▲ Apple-Werbebild. Bildquelle: Apple

Mit anderen Worten: Die Menschen befürchten, dass diese Ausweitung der Altersabdeckung eine Ausweitung der einzigartigen Macht von Apple darstellt, die bis zu einem übermäßigen Eingriff in das Privatleben geht und sich sogar auf Szenarien ausweiten könnte, die nichts mit pornografischen Absichten zu tun haben.

Stellen Sie sich vor, Sie führen zu Hause einen Videoanruf mit Ihrem Kind. Nur weil Sie oben ohne sind oder Ihre Kleidung zurechtrücken, kann das System Sie fälschlicherweise als unangemessen entblößt einstufen und das Video blockieren:

Hält mich mein iPhone für einen Perversen?

▲ FaceTime. Bildquelle: Apple

FaceTime gibt es tatsächlich schon seit 14 Jahren. Als altgediente Funktion des Apple-Ökosystems sorgte sie nicht zum ersten Mal für Kontroversen. 2019 wies FaceTime eine technische Lücke auf, die es Nutzern ermöglichte, das Gespräch des anderen Teilnehmers zu hören, ohne eine Verbindung herzustellen. Obwohl Apple diese Lücke schnell schloss, weckte sie aufgrund der Datenschutzpropaganda viele Zweifel an Apples tatsächlichen Schutzmöglichkeiten.

▲ Apple-Werbebild. Bildquelle: Apple

Als Kernwert des Unternehmens hat Apple dem Schutz der Privatsphäre der Benutzer schon immer große Bedeutung beigemessen.

Wer Apple schon länger verfolgt, erinnert sich vielleicht noch an den Vorfall im Jahr 2015, als Apple mit dem FBI konfrontiert wurde. Nach der Schießerei in San Bernardino, Kalifornien, forderte das FBI die Entsperrung des iPhones des Mörders, um Informationen über terroristische Aktivitäten zu erhalten, doch Apple lehnte ab. Apple-Chef Tim Cook sagte damals: „ Sobald die Hintertür einmal geöffnet ist, kann sie nicht mehr geschlossen werden, was die Sicherheit und Privatsphäre aller Nutzer gefährdet.“

▲ FaceTime-Oberfläche. Bildquelle: Apple

Dennoch hat Apple aufgrund von Datenschutzproblemen auch für Kontroversen gesorgt. So wurde beispielsweise auch der oben erwähnte CSAM-Scanplan bei seiner Einführung kritisiert.

Ab iOS 15 im Jahr 2021 nutzt Apple die NeuralHash-Technologie auf lokalen Geräten, um die Hashwerte der von Nutzern in iCloud hochgeladenen Fotos mit der CSAM-Datenbank der zuständigen US-Behörden abzugleichen. Wird der voreingestellte Schwellenwert überschritten, entschlüsselt Apple die entsprechenden Daten und führt eine manuelle Überprüfung durch. Nach der Bestätigung wird das Konto deaktiviert und dem National Center for Missing and Exploited Children (NCMEC) gemeldet.

Apple gibt an , dass der Zweck dieser Funktion darin besteht, Sexualstraftäter an Kindern zu erkennen und zu fassen, die Privatsphäre der Benutzer technisch so weit wie möglich zu schützen und Fehleinschätzungen und Missbrauch zu vermeiden.

Datenschutzorganisationen und Sicherheitsexperten bezweifelten jedoch, dass Apple von seinem konsequenten Engagement zum Datenschutz abweichen würde. Schließlich dient das CSAM-Scanning im Wesentlichen der Identifizierung von privaten Informationen, die von Nutzern hochgeladen werden. Angesichts des Drucks kündigte Apple an, die Veröffentlichung dieser Funktion zu verschieben und stattdessen andere Kinderschutzmaßnahmen wie Informations- und Kommunikationssicherheit sowie die Siri-Suchinterventionsfunktionen einzuführen.

Für Apple können „Moral“ und „Datenschutz“ möglicherweise nicht gleichzeitig erreicht werden.

Zurück zur eingangs erwähnten Nacktheitserkennung von FaceTime: Apples ursprüngliche Absicht war es, diese Sicherheitsfunktion zum besseren Schutz von Jugendlichen einzuführen. Sie soll verhindern, dass Jugendliche bei Videoanrufen unangemessener Nacktheit ausgesetzt werden. Weltweit gibt es unzählige ähnliche Fälle von sexueller Belästigung und Betrug bei mobilen Videoanrufen. Mit über einer Milliarde Nutzern trägt Apple tatsächlich eine entsprechende gesellschaftliche Verantwortung.

Andererseits bleibt aber auch die Frage wichtig, wo die Grenzen dieses „automatischen Eingriffs“ liegen.

Wenn öffentliche Moral und Privatsphäre an beiden Enden der Skala stehen, könnte die Frage, wie man die Vor- und Nachteile abwägt und die „richtige“ Entscheidung trifft, Apple in Zukunft noch lange Probleme bereiten.

Autoren: Zhou Qiantong, Xiao Qinpeng

#Willkommen beim offiziellen öffentlichen WeChat-Konto von iFanr: iFanr (WeChat-ID: ifanr), wo Ihnen so bald wie möglich weitere spannende Inhalte präsentiert werden.