Auch die kostenpflichtige Version von ChatGPT ist dümmer geworden, und OpenAI wurde für den „Modellwechsel“ entlarvt, was die Benutzer in Aufruhr versetzte Hunt Good Weekly Report

Willkommen zur neuesten Ausgabe von Hunt Good Weekly!

In dieser Ausgabe sehen Sie:

7 neue Informationen

4 nützliche Tools

1 interessanter Fall

3 klare Standpunkte

Jagd nach Neuigkeiten|Erweiterte Schlagzeilen

Der Modellrouting-Mechanismus von OpenAI löst bei Benutzern Kontroversen aus

Der Modellrouting-Mechanismus von OpenAI löst bei Benutzern Kontroversen aus

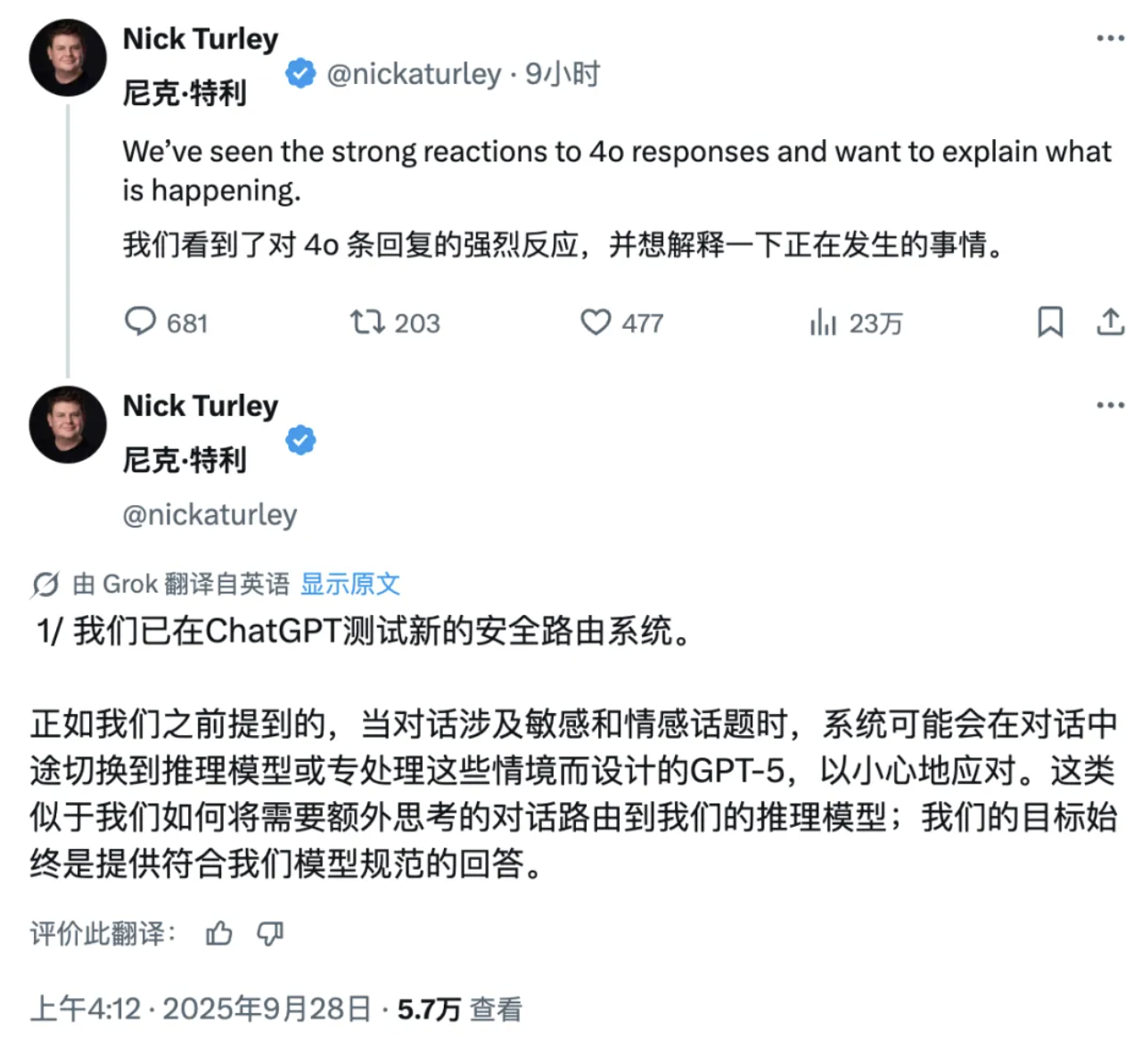

Kürzlich entdeckte der bekannte X-Blogger Tibor Blaho, dass OpenAI die Anfragen von ChatGPT-Benutzern automatisch und ohne deren Zustimmung an zwei nicht genannte „geheime Modelle“ umleitet.

Laut Blaho handelt es sich bei den beiden Modellen um „gpt-5-chat-safety“ und „gpt-5-at-mini“. Ersteres ist ein neues Modell, das speziell für den Umgang mit sensiblen Inhalten entwickelt wurde, während Letzteres ein hochsensibles Inferenzmodell zur Erkennung von „Verletzungen“ ist, das allein durch die Eingabe des Wortes „Verletzung“ eine Reaktion auslöst.

Stellt das System fest, dass die Konversation eines Nutzers sensible Themen, emotionale Äußerungen oder potenziell illegale Informationen enthält, leitet es die Anfrage automatisch zur Verarbeitung an diese Backend-Modelle weiter, unabhängig davon, ob der Nutzer die GPT-4- oder GPT-5-Version ausgewählt hat. Selbst einfache Ausdrücke mit leichter emotionaler Konnotation wie „Ich habe einen schlechten Tag“ oder „Ich liebe dich auch“ können den Routing-Mechanismus auslösen.

Es ist erwähnenswert, dass diese Praxis nicht nur kostenlose Benutzer betrifft, sondern auch Plus-Benutzer, die 20 US-Dollar pro Monat zahlen, und Pro-Mitglieder, die 200 US-Dollar pro Monat zahlen, nicht immun sind. Viele Internetnutzer beschwerten sich sogar darüber, dass ChatGPT seine Intelligenz offensichtlich reduziert habe.

Nick Turley, Vizepräsident von OpenAI und Leiter der ChatGPT-Anwendungen, gab zu, dass OpenAI ein neues sicheres Routing-System testet. Er erklärte, dass das System bei sensiblen und emotionalen Gesprächsthemen auf ein Argumentationsmodell oder GPT-5 umschaltet, das speziell für die rigorose Handhabung solcher Szenarien entwickelt wurde.

Darüber hinaus betonte Turley, dass dieser Wechsel vom Standardmodell zum sensiblen Modell derzeit nur vorübergehend sei, und sagte, dass ChatGPT auf ausdrückliche Anfrage des Benutzers weiterhin über das aktuell verwendete spezifische Modell informieren werde.

https://x.com/btibor91/status/1971959782379495785

https://x.com/btibor91/status/1971959782379495785

MuskxAI verklagt OpenAI wegen angeblichen Diebstahls von Geschäftsgeheimnissen

MuskxAI verklagt OpenAI wegen angeblichen Diebstahls von Geschäftsgeheimnissen

Am 25. September reichte Elon Musks Unternehmen für künstliche Intelligenz xAI vor dem Bundesgericht des nördlichen Bezirks von Kalifornien Klage gegen OpenAI ein und beschuldigte das Unternehmen, durch die Abwerbung wichtiger Mitarbeiter Geschäftsgeheimnisse gestohlen zu haben.

xAI reichte im August Klage gegen den ehemaligen Mitarbeiter Li Xuechen ein, der seine Unternehmensanteile abrupt verkaufte und anschließend zum Konkurrenten OpenAI wechselte. Es ist jedoch unklar, ob er dort tatsächlich seine Tätigkeit aufgenommen hat.

In seiner jüngsten Anklageschrift beschuldigte xAI OpenAI, ehemalige Mitarbeiter, darunter Li Xuechen, den ehemaligen Ingenieur Jimmy Fratello und einen leitenden Finanzmanager, zum Diebstahl von Geschäftsgeheimnissen „verleitet“ zu haben.

Ein zentraler Vorwurf der Anklage lautet, OpenAI habe versucht, an die „Geheimwaffe“ von xAI zu gelangen, nämlich „die Fähigkeit von xAI, Rechenzentren mit umfangreichen Rechenressourcen einzusetzen, um künstliche Intelligenz mit beispielloser Geschwindigkeit zu trainieren und auszuführen.“

Der Anklageschrift zufolge brachte der namentlich nicht genannte „leitende Finanzmanager“ Kenntnisse über die Prozesse zum schnellen Aufbau und zur Skalierung von Rechenzentren zu OpenAI mit. Als er nach seinem Ausscheiden per E-Mail zu angeblichen Verstößen gegen die Vertraulichkeitsvereinbarung befragt wurde, antwortete der Manager: „Leck mich.“ xAI fügte der Anklageschrift einen Screenshot der E-Mail als Beweis bei.

xAI wirft OpenAI vor, eine „koordinierte, unfaire und illegale Kampagne“ zu betreiben, um wichtige xAI-Mitarbeiter abzuwerben und sie dann dazu zu „verleiten“, Geschäftsgeheimnisse an OpenAI weiterzugeben, da das Unternehmen „schnell zur dominierenden Kraft unter den generativen KI-Unternehmen aufgestiegen ist, einfach weil es ein ‚First Mover‘ war.“

Ein Sprecher von OpenAI antwortete in einer E-Mail: „Diese neue Klage ist das jüngste Kapitel in der anhaltenden Schikanierung von Herrn Musk. Wir haben keinerlei Toleranz für Verstöße gegen Vertraulichkeitsvereinbarungen und kein Interesse an den Geschäftsgeheimnissen anderer Labore.“

https://sherwood.news/tech/musks-xai-sues-openai-alleging-theft-of-trade-secrets/

https://sherwood.news/tech/musks-xai-sues-openai-alleging-theft-of-trade-secrets/

Wird ChatGPT Werbung hinzufügen?

Quellen zufolge will Fidji Simo, der neue CEO von OpenAI, ein neues Team bilden, um Werbung in ChatGPT einzuführen. Der neue Teamleiter wird die volle Verantwortung für alle gewinnbringenden Geschäftsbereiche von OpenAI tragen und dabei verschiedene Aspekte wie Werbung und Abonnementdienste abdecken.

Mit der Angelegenheit vertraute Personen sagten, Simo habe sich kürzlich mit potenziellen Kandidaten getroffen, darunter auch einige ihrer ehemaligen Kollegen bei Facebook. Die Verhandlungen dauern noch an, und der neu eingestellte Werbeleiter soll Simo direkt unterstellt sein.

Darüber hinaus trat Simo OpenAI offiziell bei, nachdem er letzten Monat als CEO von Instacart zurückgetreten war.

In der Organisationsstruktur von OpenAI ist Simo für die Leitung der meisten Geschäftsbereiche des Unternehmens verantwortlich, mit Ausnahme der Forschungs-, Infrastruktur-, Verbraucherhardware- und Sicherheitsteams. Diese Kernabteilungen berichten weiterhin direkt an CEO Sam Altman.

https://sources.news/p/openai-ads-leader-sam-altman-memo-stargate?hide_intro_popup=true

https://sources.news/p/openai-ads-leader-sam-altman-memo-stargate?hide_intro_popup=true

Meta setzt auf eine Roboterplattform im „Android-Stil“

Meta setzt auf eine Roboterplattform im „Android-Stil“

Meta-CTO Andrew Bosworth gab in einem kürzlichen Interview bekannt, dass er unter direkter Anweisung von CEO Mark Zuckerberg Anfang des Jahres ein spezielles Robotik-Forschungsteam gegründet habe und derzeit an einem humanoiden Roboterprojekt mit dem Codenamen „Metabot“ arbeite.

Anders als seine Konkurrenten will Meta nicht zum Hardwarehersteller werden. Stattdessen plant das Unternehmen ein Geschäftsmodell, das dem von Google ähnelt, das sein Betriebssystem Android an Telefonhersteller lizenziert. Meta plant, einen vollständigen Softwareentwurf zu entwickeln und diesen dann an jedes Unternehmen zu lizenzieren, das die technischen Spezifikationen erfüllt. So könnten mehr Hersteller humanoide Roboter auf Basis der Softwareplattform von Meta produzieren.

In Bezug auf die Technologie betonte Bosworth, dass derzeit die Softwareentwicklung der größte Engpass sei, nicht die Hardware selbst.

Während des Interviews nahm er ein Glas Wasser vom Tisch und erklärte: „Diese Roboter können stehen, laufen und sogar Rückwärtssaltos machen, da der Boden eine extrem stabile Plattform ist. Versucht der Roboter jedoch, das Glas hochzuheben, wird er es höchstwahrscheinlich zerdrücken oder das gesamte Wasser darin verschütten.“ Dieses einfache Beispiel zeigt, dass die geschickte Handhabung immer noch eine der größten Herausforderungen für die Robotik darstellt.

Um diese Herausforderung zu meistern, arbeitet Metas Superintelligent AI Lab eng mit dem Robotik-Team zusammen, um ein „Weltmodell“ zu entwickeln, das komplexe Handbewegungen simulieren kann. Bosworth weist darauf hin, dass die Sensorschleife, die humanoiden Robotern die Ausführung filigraner Bewegungen wie das vorsichtige Herausziehen von Schlüsseln aus der Jeanstasche mit menschenähnlicher Präzision ermöglicht, derzeit nicht existiert. Daher musste das Team den entsprechenden Datensatz von Grund auf neu erstellen.

https://www.theverge.com/column/786759/humanoid-robots-meta

https://www.theverge.com/column/786759/humanoid-robots-meta

Microsoft kündigt an, dass der Copilot-Assistent das Claude-Modell einführt und die Abhängigkeit von OpenAI verringert

Microsoft kündigt an, dass der Copilot-Assistent das Claude-Modell einführt und die Abhängigkeit von OpenAI verringert

Am 24. September kündigte Microsoft die Einführung des Claude-Modells von Anthropic in den Microsoft 365 Copilot-Assistenten an.

In dieser neuen Zusammenarbeit können Benutzer der Researcher-Agent-Funktion in Copilot, die Informationen sammelt und analysiert und Berichte erstellt, jetzt wählen, ob ihre Prompt-Anfragen entweder von einem Claude-Modell oder einem OpenAI-Modell beantwortet werden sollen.

Die Verwendung dieser Modelle erfordert jedoch die vorherige Genehmigung durch einen Administrator und unterliegt den Geschäftsbedingungen von Anthropic.

Es ist erwähnenswert, dass Microsoft als Großinvestor und wichtiger Cloud-Service-Partner von OpenAI seit langem hauptsächlich auf OpenAI-Modelle setzt, um KI-Funktionen für die Bing-Suche, das Windows-Betriebssystem und andere Produkte bereitzustellen.

Doch als sich die Kluft zu OpenAI vertiefte, begann Microsoft nicht nur, weitere groß angelegte Sprachmodelle des Unternehmens zu integrieren, sondern auch, sein eigenes MAI-1-Vorschaumodell zu testen.

Gleichzeitig hat sich OpenAI von seiner Abhängigkeit von Microsoft Azure gelöst und die Ausweitung seines Kooperationsgebiets beschleunigt. Das Unternehmen hat mit Oracle, Broadcom und Nvidia umfangreiche Vereinbarungen im Wert von mehreren zehn bis hundert Milliarden US-Dollar zur Unterstützung des Baus seiner groß angelegten Rechenzentren getroffen.

https://www.cnbc.com/2025/09/24/microsoft-adds-anthropic-model-to-microsoft-365-copilot.html

https://www.cnbc.com/2025/09/24/microsoft-adds-anthropic-model-to-microsoft-365-copilot.html

Apples interne Version von ChatGPT ist durchgesickert und bereitet sich auf das neue Siri vor

Apples interne Version von ChatGPT ist durchgesickert und bereitet sich auf das neue Siri vor

Einem gestrigen Bloomberg-Bericht zufolge entwickelt Apple eine mobile App ähnlich wie ChatGPT, um die neue Version von Siri zu testen und vorzubereiten, die nächstes Jahr auf den Markt kommen soll.

Berichten zufolge nutzt die KI-Abteilung von Apple die App, um neue Siri-Funktionen schnell zu bewerten, darunter das Testen von Suchen nach persönlichen Daten und das Ausführen von In-App-Aktionen wie dem Bearbeiten von Fotos.

Die Software mit dem internen Codenamen „Veritas“ (lateinisch für „Wahrheit“) ist derzeit nur für den internen Gebrauch bestimmt. Obwohl die Software nicht für den privaten Gebrauch vorgesehen ist, besteht die Funktion der App im Wesentlichen darin, neue Technologien aus der neuen Siri zu extrahieren und so den Apple-Mitarbeitern zu helfen, Tests effizient durchzuführen.

Auch ohne öffentliche Veröffentlichung markiert das interne Tool eine neue Phase in Apples Vorbereitungen für eine umfassende Überarbeitung von Siri, die bereits mehrere Verzögerungen überstanden hat und nun im März nächsten Jahres auf den Markt kommen soll, heißt es in dem Bericht.

Veritas läuft angeblich auf dem zugrundeliegenden System, das Apple für die neue Siri-Sprache mit dem Codenamen „Linwood“ umgebaut hat. Veritas basiert außerdem auf dem Large Language Model (LLM) und integriert die Arbeit von Apples eigenem Grundlagenmodellierungsteam.

Darüber hinaus zeigt laut einem aktuellen Bericht von 9to5Mac versteckter Code in den Entwickler-Betaversionen von iOS 26.1, iPadOS 26.1 und macOS Tahoe 26.1, dass Apple den Grundstein für die Einführung der MCP-Unterstützung für App Intents legt.

Verwandte Lektüre: Verstecktes Easter Egg in iOS 26.1 aufgedeckt, Apple hat einen neuen „C-Port“ für ChatGPT erstellt

Verwandte Lektüre: Verstecktes Easter Egg in iOS 26.1 aufgedeckt, Apple hat einen neuen „C-Port“ für ChatGPT erstellt

Meta startet den KI-Video-Streaming-Dienst „Vibes“, Zuckerberg macht persönlich Werbung dafür und wird von Internetnutzern kritisiert

Meta startet den KI-Video-Streaming-Dienst „Vibes“, Zuckerberg macht persönlich Werbung dafür und wird von Internetnutzern kritisiert

Meta hat vor Kurzem die Einführung eines neuen KI-Videostreams namens „Vibes“ angekündigt.

In einem Instagram-Post stellte Zuckerberg Vibes als „einen Stream ausdrucksstarker, KI-generierter Videos von Künstlern und Kreativen“ vor. Die Funktion wird in den USA und mehr als 40 weiteren Ländern verfügbar sein.

In Bezug auf das funktionale Design sagte Meta, dass Benutzer nicht nur KI-generierte Inhalte ansehen, sondern auch eigene Videos erstellen oder vorhandene Videos „remixen“ können, einschließlich des Hinzufügens neuer visueller Effekte und Musik.

Um die neue Funktion zu demonstrieren, veröffentlichte Zuckerberg einen KI-generierten Videoclip mit dem Titel „Papa versucht, das Trinkgeld für ein 30-Dollar-Mittagessen zu berechnen“. In dem Video sagt eine Vaterfigur, die Zuckerberg ähnelt: „Oh mein Gott … ich glaube, es sind mindestens 600 Milliarden Dollar.“

Zuckerbergs Werbevideo wurde jedoch von den Internetnutzern verspottet und viele Internetnutzer bezeichneten diese KI-generierten Videos unter seinem Video als „KI-Schund“.

Es ist erwähnenswert, dass Meta zwar über ein eigenes KI-Modell namens Llama verfügt, das Unternehmen sich für das Vibes-Projekt jedoch für die Verwendung von Videogenerierungsmodellen der KI-Labore Midjourney und Black Forest entschieden hat.

https://www.theguardian.com/technology/2025/sep/26/cute-fluffy-characters-and-egyptian-selfies-meta-launches-ai-feed-vibes

https://www.theguardian.com/technology/2025/sep/26/cute-fluffy-characters-and-egyptian-selfies-meta-launches-ai-feed-vibes

Jagd nach Werkzeugen|Erweiterte Werkzeuge

Der ehemalige CTO von OpenAI gibt seinen zweiten unternehmerischen Erfolg bekannt

Der ehemalige CTO von OpenAI gibt seinen zweiten unternehmerischen Erfolg bekannt

Am 27. September veröffentlichte das von mehreren ehemaligen OpenAI-Führungskräften gegründete Thinking Machines Lab (TML) offiziell sein zweites Forschungspapier „Modular Manifolds“, dessen Ziel es ist, den Trainingsprozess großer Modelle von Grund auf stabil und effizient zu gestalten.

Einfach ausgedrückt besteht die Kernidee dieser Forschung darin, den Gewichtsparametern des neuronalen Netzwerks einen geometrischen „engen Ring“ zu geben.

Herkömmliche Ansätze beinhalten oft die Anwendung eines Optimierers auf ein Modell, nachdem es erstellt wurde. Das „modulare Mannigfaltigkeits“-Framework geht noch einen Schritt weiter und behandelt jede Schicht eines neuronalen Netzwerks als einen „geometrischen Raum“ (d. h. eine Mannigfaltigkeit) mit unabhängigen Regeln. Die Parameter werden zunächst intern eingeschränkt, und dann werden diese Räume mithilfe eines globalen „Ratenbegrenzers“ „zusammengefügt“, um die Aktualisierungsgeschwindigkeit des gesamten Netzwerks zu koordinieren.

Dieses integrierte Modell- und Optimiererdesign verhindert den Kontrollverlust über die internen Parameter des Netzwerks. Die im Rahmen des Artikels durchgeführten klein angelegten Experimente zeigen vielversprechende Stabilität und Genauigkeit.

Der Autor dieser Errungenschaft ist Jeremy Bernstein, ein Forscher für maschinelles Lernen am TML, der auch Postdoc-Forschung am MIT betrieben hat.

In diesem Monat, sechs Monate nach seiner Gründung, veröffentlichte TML sein erstes großes Forschungspapier mit dem Titel „Defeating Nondeterminism in LLM Inference“.

Es ist erwähnenswert, dass die Bewertung von TML zuvor auf 12 Milliarden US-Dollar (entspricht 85 Milliarden RMB) gestiegen war, als das Unternehmen „0 Produkte und 0 Benutzer“ hatte.

https://thinkingmachines.ai/blog/modular-manifolds/

https://thinkingmachines.ai/blog/modular-manifolds/

DeepSeek-Modell erneut aktualisiert, die ultimative Version

DeepSeek-Modell erneut aktualisiert, die ultimative Version

Am 22. September gab DeepSeek bekannt, dass Deepseek-Chat und Deepseek-Reasoner vollständig auf DeepSeek-V3.1-Terminus aktualisiert wurden.

Darunter entspricht Deepseek-Chat dem Nicht-Denkmodus und Deepseek-Reasoner dem Denkmodus. Berichten zufolge behält dieses Update die vorhandenen Funktionen des Modells bei und optimiert es gleichzeitig basierend auf Benutzerfeedback.

- In Bezug auf die Sprachkonsistenz wurden die Vermischung von Chinesisch und Englisch sowie gelegentliche ungewöhnliche Zeichen verringert.

- In Bezug auf die Agentenfunktionen wurde die Leistung von Code Agent und Search Agent weiter verbessert.

- Es ist erwähnenswert, dass Entwickler auf mehreren Plattformen berichtet haben, dass das DeepSeek V3.1-Modell gelegentlich extreme Anomalien aufweist – das wiederholte Einfügen von Token wie dem chinesischen Schriftzeichen „极“, dem englischen Schriftzeichen „extreme“ oder dem traditionellen chinesischen Schriftzeichen „極“ (極)) in normalen Code oder Textausgaben. Obwohl die Wahrscheinlichkeit dieses Fehlers bei etwa eins zu tausend liegt, reicht er aus, um Kompilierungsfehler oder unbrauchbare Inhalte zu verursachen. Dieses Versions-Upgrade sollte auch eine gezielte Lösung für dieses Problem enthalten.

Das neue Modell ist jetzt Open Source:

Umarmungsgesicht: https://huggingface.co/deepseek-ai/DeepSeek-V3.1-Terminus

Umarmungsgesicht: https://huggingface.co/deepseek-ai/DeepSeek-V3.1-Terminus  ModelScope: https://modelscope.cn/models/deepseek-ai/DeepSeek-V3.1-Terminus

ModelScope: https://modelscope.cn/models/deepseek-ai/DeepSeek-V3.1-Terminus

ChatGPT bringt „Pulse“ auf den Markt, einen aktiven Informationsassistenten

ChatGPT bringt „Pulse“ auf den Markt, einen aktiven Informationsassistenten

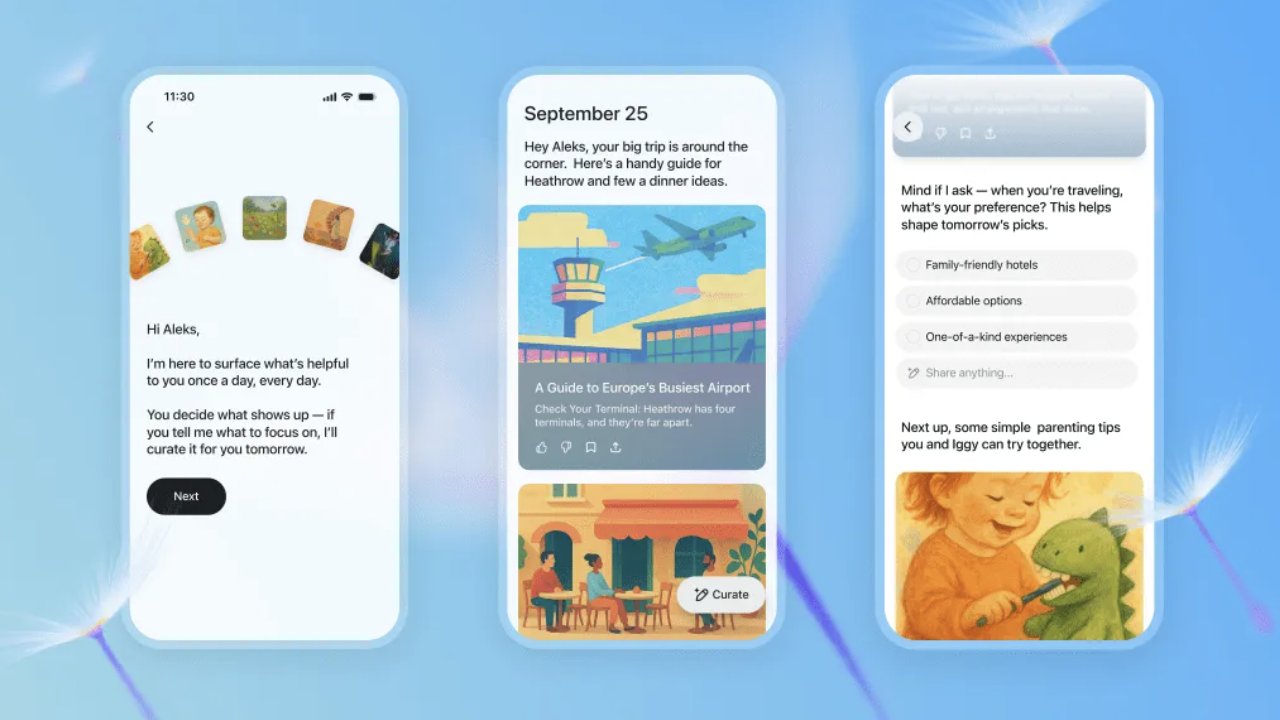

Am 26. September kündigte OpenAI die Einführung einer neuen Funktion „ChatGPT Pulse“ an, die jetzt für mobile Pro-Benutzer als Vorschau verfügbar ist.

Laut der offiziellen Einführung generiert ChatGPT Pulse jeden Morgen automatisch eine Reihe personalisierter Forschungsupdates basierend auf dem Chatverlauf, dem Feedback und den verbundenen Anwendungen (wie Gmail und Google Kalender) des Benutzers. Diese Updates werden in Form von Karten präsentiert, die Benutzer schnell durchsuchen oder erweitern können, um Details anzuzeigen.

Im Gegensatz zum Frage-Antwort-Modell traditioneller KI legt ChatGPT Pulse Wert auf Proaktivität. Das System führt über Nacht asynchrone Recherchen durch und integriert dabei Benutzerinteressen und historisches Feedback, um am nächsten Tag gezieltere Empfehlungen zu liefern, wie zum Beispiel „Rezepte für gesunde Abendessen“, „Triathlon-Trainingspläne“ oder „Entwürfe für Besprechungsagenden“.

Es ist zu beachten, dass Updates von ChatGPT Pulse nur am Tag ihrer Veröffentlichung gültig sind. Wenn ein Nutzer einen Beitrag nicht speichert oder erweitert, bleiben die Informationen nicht langfristig erhalten. Verantwortlichen betonten, dass das Ziel dieser Funktion darin bestehe, „Nutzern den schnellen Zugriff auf wichtige Informationen zu ermöglichen, anstatt endlos darin scrollen zu müssen“.

Derzeit befindet sich „ChatGPT Pulse“ noch in der Vorschauphase. Es soll in Zukunft schrittweise auf mehr Benutzer ausgeweitet werden und soll den Zugriff auf mehr Anwendungen von Drittanbietern unterstützen.

Verwandte Lektüre: ChatGPT wurde gerade aktualisiert, Ultraman: Das ist meine Lieblingsfunktion

Verwandte Lektüre: ChatGPT wurde gerade aktualisiert, Ultraman: Das ist meine Lieblingsfunktion

Google DeepMind veröffentlicht ein neues KI-Modell, mit dem Roboter das Internet durchsuchen können, um komplexe Aufgaben zu erledigen

Google DeepMind veröffentlicht ein neues KI-Modell, mit dem Roboter das Internet durchsuchen können, um komplexe Aufgaben zu erledigen

Am 26. September kündigte Google DeepMind die Einführung eines verbesserten KI-Modells an, das Robotern bei der Erledigung komplexerer Aufgaben helfen kann.

Es wird berichtet, dass die neu eingeführten KI-Modelle von Deepmind dank der neu veröffentlichten Version Gemini Robotics 1.5 und des verkörperten Schlussfolgerungsmodells Gemini Robotics-ER 1.5 zusammenarbeiten können, um Robotern zu ermöglichen, „mehrere Schritte vorauszudenken“, bevor sie in der physischen Welt aktiv werden.

Dem Bericht zufolge werden die Roboter in der Lage sein, komplexere, mehrstufige Vorgänge durchzuführen, wie etwa Wäsche nach hellen und dunklen Farben zu sortieren, Koffer entsprechend den aktuellen Wetterbedingungen in London zu packen und Menschen dabei zu helfen, Müll, Kompost und Wertstoffe entsprechend den Anforderungen bestimmter Gebiete zu sortieren.

Carolina Parada, Leiterin der Robotikabteilung von DeepMind, sagte: „Frühere Modelle konnten Einzelbefehlsaufgaben sehr gut ausführen und waren sehr allgemein. Mit diesem Update gehen wir über die Ausführung einzelner Anweisungen hinaus und können physikalische Aufgaben wirklich verstehen und lösen.“

Um dies zu erreichen, können Roboter das Modell Gemini Robotics-ER 1.5 nutzen, um ihre Umgebung zu verstehen und digitale Tools wie die Google-Suche zu nutzen, um weitere Informationen zu gewinnen. Diese Erkenntnisse werden dann in natürliche Sprachanweisungen übersetzt und an Gemini Robotics 1.5 weitergegeben, sodass der Roboter mithilfe der Seh- und Sprachverständnisfähigkeiten des Modells Aufgaben Schritt für Schritt ausführen kann.

Darüber hinaus gab DeepMind bekannt, dass Gemini Robotics 1.5 Robotern dabei helfen kann, voneinander zu „lernen“, selbst wenn sie unterschiedlich konfiguriert sind. Derzeit stellt DeepMind Gemini Robotics-ER 1.5 Entwicklern über die Gemini-API in Google AI Studio zur Verfügung. Gemini Robotics 1.5 ist derzeit nur für einige Partner verfügbar.

https://www.theverge.com/news/785193/google-deepmind-gemini-ai-robotics-web-search

https://www.theverge.com/news/785193/google-deepmind-gemini-ai-robotics-web-search

Jagd zum Spaß | Spiel zuerst

Google startet Androidify-App zum Erstellen personalisierter „Android-Personen“

Google startet Androidify-App zum Erstellen personalisierter „Android-Personen“

Google hat vor Kurzem offiziell die neue Anwendung Androidify eingeführt, mit der Benutzer Selfies hochladen oder Stichwörter eingeben können, um mithilfe von KI-Technologie ihr eigenes Android-Roboterbild zu erstellen.

Die App steht jetzt im Internet und im Google Play Store zum Download bereit.

Berichten zufolge integriert Androidify Gemini und Firebase AI Logic SDK und unterstützt Funktionen wie Bildüberprüfung, automatische Beschreibungsgenerierung und personalisierte Robotergenerierung.

Die Anwendung erkennt zunächst mit Gemini 2.5 Flash die von den Benutzern hochgeladenen Fotos und stellt sicher, dass die Bilder klar sind und den Sicherheitsstandards entsprechen. Anschließend erstellt sie eine detaillierte Beschreibung und ruft das Imagen 3-Modell auf, um das endgültige Roboterbild zu generieren.

Erwähnenswert ist, dass die neueste Version auch „Hintergrundatmosphärengenerierung“ und „Stickermodus“ hinzufügt.

Ersteres kann dem Roboter über das Gemini-Modell einen Szenenhintergrund hinzufügen, während Letzteres die Segmentierungstechnologie von ML Kit verwendet, um den Hintergrund zu entfernen und PNG-Aufkleber zu generieren, die in Chat-Anwendungen verwendet werden können.

Google sagte, das Ziel von Androidify bestehe darin, den Benutzern die Möglichkeit zu geben, die Kreativität und Personalisierung zu erleben, die durch die Kombination von KI- und Android-Technologie entsteht, während sie gleichzeitig Unterhaltung genießen.

https://androidify.com/

https://androidify.com/

Jagd nach Erkenntnissen

OpenAI-Chefwissenschaftler: Nach der Atmosphärenkodierung kommt vielleicht die „Atmosphärenforschung“

OpenAI-Chefwissenschaftler: Nach der Atmosphärenkodierung kommt vielleicht die „Atmosphärenforschung“

In einem kürzlich von a16z geführten Interview haben Jakub Pachocki, Chefwissenschaftler von OpenAI, und Mark Chen, Chief Research Officer, einige wichtige Gedanken und Zukunftspläne zum Entwicklungspfad der KI ausführlich preisgegeben.

In Bezug auf die Sättigung der aktuellen Bewertungsmetriken räumte Jakub Pachocki ein, dass das von ihm seit einigen Jahren verwendete Bewertungssystem tatsächlich kurz vor der Sättigung stehe. OpenAI werde sich daher darauf konzentrieren, ob seine Modelle neue Erkenntnisse gewinnen und in wirtschaftlich relevanten Bereichen echte Fortschritte erzielen können.

Jakub enthüllte ein großes Ziel von OpenAI: automatisierte Forscher zu trainieren, automatisch neue Ideen zu entdecken.

Er erwähnte eine interessante Messgröße: die Zeitspanne, in der das Modell tatsächlich schlussfolgert und Fortschritte macht. Derzeit kann das Denkniveau des Modells etwa ein bis fünf Stunden lang aufrechterhalten werden. OpenAI wird sich als Nächstes darauf konzentrieren, diese Zeitspanne zu verlängern, sowohl im Hinblick auf die langfristigen Planungsmöglichkeiten als auch auf die Speicherfähigkeit.

In Bezug auf die KI-Programmierung verglich Mark Chen den Fortschritt bei der Programmierung von Modellen mit den Erfahrungen des Go-Spielers Lee Sedol bei AlphaGo und sagte, der Fortschritt vom Lösen von Mathematikaufgaben der achten Klasse bis zum Erreichen des professionellen Niveaus bei Programmierwettbewerben ein Jahr später sei „verrückt“.

Er stellt fest, dass dieser Fortschritt die Standardmethode beim Programmieren bereits verändert hat. Junge Menschen betrachten „Ambient Coding“ mittlerweile als Standard, während die Idee, alles von Grund auf neu zu schreiben, seltsam erscheint. Er prognostiziert, dass der nächste Schritt nach Ambient Coding „Ambient Research“ sein könnte.

Jakub Pachocki ist überzeugt, dass Beharrlichkeit bei der Talentgewinnung eine Schlüsseleigenschaft ist. Forschung bedeutet naturgemäß, Unbekanntes zu erforschen, und viele Versuche scheitern. Daher müsse man auf Misserfolge vorbereitet sein und daraus lernen. Mark Chen ergänzte, dass es in der Forschung keine Abkürzungen gebe; die Wahl der richtigen Fragen erfordere Erfahrung.

https://www.youtube.com/watch?v=KSgPNVmZ8jQ

https://www.youtube.com/watch?v=KSgPNVmZ8jQ

Turing-Preisträger: Große Sprachmodelle sind eine Sackgasse

Turing-Preisträger: Große Sprachmodelle sind eine Sackgasse

Richard Sutton, Gewinner des Turing Award 2024 und bekannt als „Vater des bestärkenden Lernens“, sagte kürzlich in einem Interview, dass große Sprachmodelle keine echte Intelligenz erreichen können und durch neue Architekturen ersetzt werden.

Suttons Kernaussage besteht darin, dass große Sprachmodelle im Wesentlichen nur menschliches Verhalten nachahmen, anstatt die Welt wirklich zu verstehen.

Suttons Ansicht nach sollte wahre Intelligenz durch direkte Interaktion mit der Umwelt und Lernen aus Erfahrung entstehen, genau wie Tiere in der Natur lernen. Er betonte, dass Tiere niemals „überwachtes Lernen“ erfahren; sie lernen durch Ausprobieren von Handlungen und Beobachten der Ergebnisse, was ein gängiger Lernmechanismus in der Natur ist.

Als Moderator Patel erwähnte, dass große Sprachmodelle offenbar ein Weltmodell aufgebaut hätten, erwiderte Sutton: „Sprechende Menschen zu imitieren ist nicht dasselbe wie ein Weltmodell zu erstellen. Ein reales Weltmodell sollte es ermöglichen, vorherzusagen, was passieren wird, nicht, was die Leute sagen werden.“

Sutton ist der Ansicht, dass das größte Problem großer Sprachmodelle das Fehlen eines klaren Ziels sei. Er zitierte John McCarthys Definition: „Intelligenz ist die rechnerische Fähigkeit, Ziele zu erreichen.“ Ohne ein Ziel sei es unmöglich, das richtige Verhalten zu definieren, und echtes Lernen sei nicht möglich.

Er erklärte weiter: „Beim bestärkenden Lernen gibt es korrektes Verhalten, denn korrektes Verhalten ist Verhalten, das belohnt werden kann. Wir haben eine klare Definition von korrektem Verhalten, sodass wir testen und lernen können.“ Großen Sprachmodellen fehlen jedoch solche Bewertungskriterien und sie können in tatsächlichen Interaktionen kein Feedback erhalten und sich nicht verbessern.

Während des Interviews wies Sutton auch auf die grundlegenden Mängel der Generalisierungsfähigkeiten aktueller Deep-Learning-Methoden hin. Er ist der Ansicht, dass große Sprachmodelle zwar bei bestimmten Aufgaben gute Ergebnisse erzielen, dieser Erfolg jedoch oft auf eine einzige Lösung und nicht auf echte Generalisierungsfähigkeiten zurückzuführen ist.

„Gradientenabstieg ermöglicht es dem System, Lösungen für erkannte Probleme zu finden. Wenn es jedoch mehrere Lösungen gibt, von denen einige gut und andere schlecht verallgemeinern, wird der Algorithmus das System nicht dazu veranlassen, die Lösung mit der guten Generalisierungsfähigkeit auszuwählen.“ Sutton sagte, dies erkläre auch, warum Deep-Learning-Systeme anfällig für Probleme wie katastrophales Vergessen seien.

https://www.dwarkesh.com/p/richard-sutton

https://www.dwarkesh.com/p/richard-sutton

Der Vater des Quantencomputings: Die Entschlüsselung der Quantengravitationstheorie könnte zum neuen Maßstab für die Beurteilung von AGI werden

Der Vater des Quantencomputings: Die Entschlüsselung der Quantengravitationstheorie könnte zum neuen Maßstab für die Beurteilung von AGI werden

Am 25. September diskutierten OpenAI-CEO Sam Altman und David Deutsch, ein berühmter britischer Physiker und „Vater des Quantencomputings“, bei einer Dialogveranstaltung in der Axel-Springer-Zentrale in Berlin ausführlich über die AGI-Bewertungskriterien und erzielten einen Konsens.

Nach Deutschs Ansicht beruht die Fähigkeit großer Sprachmodelle, kontinuierliche Gespräche zu führen, hauptsächlich auf der enormen Menge an Wissenstraining, das sie erhalten, während sich wahre Intelligenz in der Fähigkeit widerspiegeln sollte, Wissen zu schaffen – das heißt in der Fähigkeit, Probleme zu erkennen, Lösungen zu erfinden, sie zu testen und kontinuierlich zu verbessern.

Um diesen Punkt zu verdeutlichen, führt Deutsch Einsteins Relativitätstheorie als Beispiel an: „Manche haben in Frage gestellt, ob Einstein die Relativitätstheorie tatsächlich geschaffen oder lediglich bestehende Ideen mechanisch kombiniert hat. Wir sind davon überzeugt, dass dies der Fall war, da wir seinen Forschungsprozess, die Probleme, die er angehen wollte, und seine Motivationen verstehen.“

Er gab jedoch auch offen zu, dass er zuvor geglaubt hatte, Computer könnten ohne künstliche Intelligenz keine offenen Gespräche führen. Die Leistung von ChatGPT habe seine Überzeugung jedoch widerlegt. Er sagte: „ChatGPT ist zwar keine künstliche Intelligenz, aber es ist in der Lage, Gespräche zu führen.“

Als Antwort auf Deutschs Argument stellte Altman eine hypothetische Frage: Wenn GPT-8 das Problem der Quantengravitation lösen und seine Forschungsgeschichte detailliert darlegen könnte, einschließlich der Wahl des Problems und der Motivation für die Forschung, „würde das ausreichen, um Sie zu überzeugen?“

Deutsch antwortete entschieden: „Ich denke schon.“ Ultraman lächelte und sagte: „Ich stimme dem als Teststandard zu.“

https://www.businessinsider.com/sam-altman-predicts-ai-agi-surpass-human-intelligence-2030-2025-9

https://www.businessinsider.com/sam-altman-predicts-ai-agi-surpass-human-intelligence-2030-2025-9

Ostereierzeit

Autor: @azed_ai

Stichwort: Ein Low-Poly-3D-Rendering eines [Motivs], aufgebaut aus sauberen dreieckigen Facetten mit flachen [Farbe1]- und [Farbe2]-Oberflächen. Die Umgebung ist eine stilisierte digitale Wüste mit minimaler Geometrie und Umgebungsverdeckung.

Link: https://x.com/azed_ai/status/1971892865581350967

#Willkommen beim offiziellen öffentlichen WeChat-Konto von iFaner: iFaner (WeChat-ID: ifanr), wo Ihnen so bald wie möglich weitere spannende Inhalte präsentiert werden.

MuskxAI verklagt OpenAI wegen angeblichen Diebstahls von Geschäftsgeheimnissen

MuskxAI verklagt OpenAI wegen angeblichen Diebstahls von Geschäftsgeheimnissen Meta setzt auf eine Roboterplattform im „Android-Stil“

Meta setzt auf eine Roboterplattform im „Android-Stil“ Microsoft kündigt an, dass der Copilot-Assistent das Claude-Modell einführt und die Abhängigkeit von OpenAI verringert

Microsoft kündigt an, dass der Copilot-Assistent das Claude-Modell einführt und die Abhängigkeit von OpenAI verringert Apples interne Version von ChatGPT ist durchgesickert und bereitet sich auf das neue Siri vor

Apples interne Version von ChatGPT ist durchgesickert und bereitet sich auf das neue Siri vor Meta startet den KI-Video-Streaming-Dienst „Vibes“, Zuckerberg macht persönlich Werbung dafür und wird von Internetnutzern kritisiert

Meta startet den KI-Video-Streaming-Dienst „Vibes“, Zuckerberg macht persönlich Werbung dafür und wird von Internetnutzern kritisiert Der ehemalige CTO von OpenAI gibt seinen zweiten unternehmerischen Erfolg bekannt

Der ehemalige CTO von OpenAI gibt seinen zweiten unternehmerischen Erfolg bekannt DeepSeek-Modell erneut aktualisiert, die ultimative Version

DeepSeek-Modell erneut aktualisiert, die ultimative Version ChatGPT bringt „Pulse“ auf den Markt, einen aktiven Informationsassistenten

ChatGPT bringt „Pulse“ auf den Markt, einen aktiven Informationsassistenten Google DeepMind veröffentlicht ein neues KI-Modell, mit dem Roboter das Internet durchsuchen können, um komplexe Aufgaben zu erledigen

Google DeepMind veröffentlicht ein neues KI-Modell, mit dem Roboter das Internet durchsuchen können, um komplexe Aufgaben zu erledigen Google startet Androidify-App zum Erstellen personalisierter „Android-Personen“

Google startet Androidify-App zum Erstellen personalisierter „Android-Personen“ OpenAI-Chefwissenschaftler: Nach der Atmosphärenkodierung kommt vielleicht die „Atmosphärenforschung“

OpenAI-Chefwissenschaftler: Nach der Atmosphärenkodierung kommt vielleicht die „Atmosphärenforschung“ Turing-Preisträger: Große Sprachmodelle sind eine Sackgasse

Turing-Preisträger: Große Sprachmodelle sind eine Sackgasse Der Vater des Quantencomputings: Die Entschlüsselung der Quantengravitationstheorie könnte zum neuen Maßstab für die Beurteilung von AGI werden

Der Vater des Quantencomputings: Die Entschlüsselung der Quantengravitationstheorie könnte zum neuen Maßstab für die Beurteilung von AGI werden