Claude 4-Kernmitglied: Im Jahr 2027 wird KI fast alle Bürojobs automatisieren 10.000 Wörter langes Gespräch

KI-Codierung, das Hauptthema der KI-Branche in diesem Jahr, ist in letzter Zeit immer deutlicher geworden.

Neben dem neuen Programmierkönig Claude Opus 4, der letzte Woche die Bildschirme dominierte, konzentrierte sich auch die neue Version von DeepSeek R1 auf die Code-Funktionen. Vor nicht allzu langer Zeit hat OpenAI den KI-Programmierassistenten Windsurf für 3 Milliarden US-Dollar übernommen und anschließend den Programmieragenten Codex veröffentlicht.

In den letzten Tagen haben Ming Chaoping, der ehemalige Produktmanager von Kimi, und Meituan, das mit JD.com streitet, offiziell Produkte im Zusammenhang mit der KI-Programmierung angekündigt.

Ein C++-Entwickler mit über 30 Jahren Erfahrung postete auf Reddit, dass Claude Opus 4 einen Fehler behoben habe, der ihn seit vier Jahren beschäftigt habe, und dass es die erste KI sei, die er verwendet habe, die dazu in der Lage sei.

Warum ist Claude so gut im Programmieren? Wenn die Leute heute Anthropic erwähnen, gehen sie fast davon aus, dass es sich um ein „Unternehmen handelt, das Programmiermodelle erstellt“. Doch was ist für sie der wahre Durchbruch dieser Modellgeneration? Was wird in Zukunft passieren?

Vor einigen Tagen ging ein Podcast-Gespräch mit Sholto Douglas, einem Kernforscher bei Claude Opus 4, ausführlich auf diese Fragen ein. Es ist sehr informativ und hörenswert.

Wichtige Diskussionspunkte (für eine schnellere Anzeige):

Claude Opus 4, welche Durchbrüche sind wirklich beachtenswert?

Zunächst einmal sind die Fähigkeits-Upgrades sehr ausgewogen.

Einerseits wurden die Fähigkeiten zur Codeausführung erheblich verbessert. Es kann nicht nur komplexe Anforderungen verstehen, sondern auch selbstständig nach Informationen suchen, Tests durchführen und Fehler beheben. Es hat wirklich die Fähigkeit, „von Anfang bis Ende zu laufen“. Andererseits wurde auch die Aufgabenzeitspanne erheblich erweitert, um mehrstufiges Denken und Bedienen zu unterstützen, was bedeutet, dass es nicht nur intelligent, sondern auch sehr beständig ist.

In Bezug auf die Architektur fügt Claude Opus 4 Tool-Aufrufe und Langzeitspeichermodule hinzu, wodurch Aufgaben mit mehr kontextueller Kontinuität verarbeitet werden können. Vom Code-Assistenten zum intelligenten Agenten mit der Fähigkeit „Lösungen zu entwerfen“.

Natürlich gibt es eine Obergrenze.

Das Team räumt ein, dass es hinsichtlich der intellektuellen Komplexität der Aufgabe keine klare Obergrenze gibt. Die Schwierigkeit liege darin, die Bandbreite der Kontexte, die das Modell wahrnehmen und verarbeiten kann, zu erweitern, sodass es mehrere Tools verwenden und sich mehr Schlüsselinformationen merken kann.

Wie sieht die Zukunft aus?

Sholto Douglas nannte im Podcast mehrere klare Anweisungen:

- Durch bestärkendes Lernen (RL) wird die Leistung des Modells bei kontinuierlichen Aufgaben weiter verbessert.

- Code-Agenten können stundenlang mit nur gelegentlichem menschlichen Eingreifen ausgeführt werden.

- Models können zu „virtuellen Remote-Mitarbeitern“ in wissensbasierten Berufen werden;

- Wenn der Bau automatisierter Labore und Roboterplattformen weiter voranschreitet, können die Modelle an realen physikalischen Aufgaben wie biologischen Experimenten oder der Fertigung teilnehmen.

Voraussetzung dafür ist allerdings, dass die Zuverlässigkeit des intelligenten Agenten mithalten kann.

Zwar ist es uns noch nicht gelungen, einen 100%igen Erfolg zu erzielen, aber innerhalb der begrenzten Zeit steigt die Erfolgsquote stetig an. Es wird erwartet, dass programmierte intelligente Agenten bis Ende 2025 „mehrere Stunden lang stabil laufen“ können und Menschen nur noch gelegentlich kontrollieren müssen.

Außer Code zu schreiben?

Die Programmierung ist lediglich ein „führender Indikator“ für die Fähigkeiten eines Modells. Auch in Berufsfeldern wie der Medizin und dem Rechtswesen muss noch auf die Verbesserung von Daten und Werkzeugen gewartet werden, doch sobald diese soweit sind, werden auch sie rasche Durchbrüche erleben. Der aktuelle Engpass liegt nicht in der KI selbst, sondern im Verifizierungsmechanismus und der Infrastruktur in der realen Welt.

Bis 2027–2030 wird das Modell in der Lage sein, fast die gesamte Büroarbeit zu automatisieren. Ohne entsprechende Labore und Feedback-Mechanismen in der realen Welt wird es jedoch „starke Fähigkeiten haben, aber schwer umzusetzen sein“.

Wie lässt sich beurteilen, ob sich das Modell wirklich verbessert hat?

Das Team erwähnte, dass ein gutes Bewertungssystem (Evals) besonders wichtig sei. Dabei werden nicht nur technische Indikatoren gemessen, sondern auch die Fachkompetenz und der Geschmack des Bewerters hervorgehoben. Auch deshalb werden die Hürden für die Modellbewertung immer höher. Gleichzeitig müssen die Benutzer die Software weiterhin nutzen, interagieren und Feedback geben, um eine echte „Koevolution“ zu erreichen.

Labore vs. Anwendungsunternehmen, wer hat die Oberhand?

Douglas ist davon überzeugt, dass das Labor durch offene APIs neue Möglichkeiten bietet, die Kernvorteile bleiben jedoch bestehen:

- Fähigkeit zur Umwandlung von Rechenleistung;

- Modellieren Sie „Einstellbarkeit“ und Benutzervertrauen;

- Größeres persönliches Verständnis.

Labore sind wie Hersteller „intelligenter Motoren“, die sich auf die Grenzen ihrer Fähigkeiten konzentrieren. Anwendungsunternehmen sind besser bei der Implementierung und Benutzererfahrung. In Zukunft wird es zwischen beiden immer mehr Überschneidungen, Integrationen und Wettbewerb geben.

Wird das Modellunternehmen anderen Unternehmen aufgrund seiner Kosten und der zugrunde liegenden Vorteile keinen Ausweg mehr lassen? Douglas‘ Meinung ist:

Nein, im Gegenteil, es bringt Vitalität.

Er glaubt, dass alle Schutzgräben irgendwann durchbrochen werden und dass es wirklich auf die Kundenbeziehungen, die Koordination der Aufgaben und eine integrierte Erfahrung ankommt.

Das letzte Schlüsselwort ist „Ausrichtung“

Mit der Verbesserung der Modellfähigkeiten wird das Problem der „Ausrichtung“ wichtiger. Anthropic treibt die Interpretierbarkeitsforschung voran und versucht zu „verstehen, was das Modell denkt“. Obwohl bestärkendes Lernen die Fähigkeiten verbessern kann, kann es auch bestehende Ausrichtungsmechanismen zerstören. In Zukunft wird es erforderlich sein, dass Universitäten, Regierungen und mehr Forscher gemeinsam die „Ausrichtungswissenschaft“ vorantreiben.

Link zum Originalvideo: https://www.youtube.com/watch?v=W1aGV4K3A8Y

Nachfolgend finden Sie die Abschrift des Interviews, die von APPSO leicht bearbeitet wurde.

Moderator: Sholto Douglas ist eines der Kernmitglieder des anthropischen Claude 4-Modells. Es war mir dieses Mal eine große Freude, mit ihm zu plaudern. Wir haben über verschiedene Themen gesprochen, unter anderem darüber, wie Entwickler den Entwicklungstrend der neuen Modellgeneration von Anthropic sehen. Wir haben darüber gesprochen, welche Entwicklung diese Modelle in 6, 12 oder sogar 2–3 Monaten nehmen könnten, welche Schlüsselfaktoren für die Entwicklung zuverlässiger KI-Agenten erforderlich sind und wann diese Modelle in professionellen Bereichen wie Medizin und Recht dieselben Durchbrüche erzielen könnten wie in der Programmierung. Darüber hinaus teilte Douglas auch seine Ansichten zur „Alignment Research“ und seine Reaktion auf die „AI 2027“-Prognose. Dies ist ein faszinierendes Gespräch und ich glaube, es wird Ihnen gefallen.

Wichtige Durchbrüche und zukünftige Möglichkeiten von Claude Opus 4

Moderator: Wenn dieser Podcast online geht, ist „Claude 4“ bereits erschienen und jeder sollte bereits damit in Berührung gekommen sein. Ich bin neugierig. Sie waren einer der Ersten, der diese Modelle in die Hände bekam. Welcher Aspekt hat Sie daran am meisten begeistert?

Douglas: Dies ist wirklich ein weiterer Fortschritt in der Softwareentwicklung. Das Modell Opus ist in dieser Hinsicht wirklich herausragend. Es gibt oft Momente, in denen ich ihm eine sehr komplexe Aufgabe gebe, die unsere riesige Codebasis einbezieht, und er erledigt sie fast völlig autonom . Es sucht selbstständig nach Informationen, versteht Anforderungen und führt Tests durch. Der gesamte Prozess ist sehr unabhängig und effizient. Jedes Mal, wenn ich eine solche Aufführung sehe, bin ich schockiert.

Moderator: Jedes Mal, wenn eine neue Modellgeneration herauskommt, müssen wir unser kognitives Modell neu anpassen, um zu beurteilen, welche Methoden effektiv sind und welche nicht. Hat sich Ihre Verwendung und Ihr Verständnis dieser Modelle in der Programmierung verändert?

Douglas: Ich denke, die größte Veränderung ist die Verbesserung des Zeithorizonts. Ich denke, dass die Verbesserung der Modellfähigkeiten anhand von zwei Dimensionen verstanden werden kann: zum einen anhand der intellektuellen Komplexität der Aufgabe und zum anderen anhand der Menge an Kontext oder der Anzahl aufeinanderfolgender Aktionen, die sie sinnvoll begründen und verarbeiten können. Diese Modelle sind insbesondere in der zweiten Dimension verbessert, wo sie tatsächlich mehrstufige Operationen durchführen, bestimmen können, welche Informationen sie aus der Umgebung abrufen müssen, und dann auf der Grundlage dieser Informationen Maßnahmen ergreifen können. Darüber hinaus kann es Tools wie Cloud Code aufrufen, wodurch es mehr als nur ein einfaches Kopieren und Einfügen ermöglicht und über stärkere Ausführungsfunktionen verfügt. Jetzt kann ich mir vorstellen, dass es stundenlang mit der gleichen Effizienz arbeitet wie kontinuierliche menschliche Arbeit.

Moderator: Wo sollten Ihrer Meinung nach Leute anfangen, die Claude 4 zum ersten Mal verwenden?

Douglas: Ich denke, der beste Weg ist, es direkt in Ihre Arbeit einzubeziehen. Wenn Sie beispielsweise heute vorhaben, Code zu schreiben, lassen Sie ihn das einfach für Sie tun und beobachten Sie, wie er die Informationen beurteilt und über den nächsten Schritt entscheidet. Ich garantiere Ihnen, dass Sie von seiner Leistung begeistert sein werden.

Moderator: Diese Modellgeneration ist leistungsfähiger und viele Leute planen, damit Produkte zu bauen. Wo liegen Ihrer Meinung nach die neuen Möglichkeiten für Entwickler?

Douglas: Mir hat der Begriff „Produktexponential“ schon immer gefallen. Entwickler müssen die Modellfähigkeiten ständig weiterentwickeln, um Produkte zu konzipieren . Beispiele wie Cursor, Windsurf und Devon sind typisch. Cursor begann mit dem Aufbau der zukünftigen Codierungserfahrung, als die Modellfunktionen nicht stark genug waren, aber ihre Vision wurde erst mit dem Erscheinen von Claude 3.5 und Sonne wirklich verwirklicht. Windsurf ist noch einen Schritt weiter gegangen und hat einen Teil des Marktes erobert. Ihr Erfolg liegt darin, dieses Zeitfenster exponentiellen Wachstums zu nutzen.

Jetzt können Sie Claude Code, die neue GitHub-Integration, die Codecs von OpenAI, den Coding Agent von Google usw. sehen. Alle arbeiten am Konzept des „Coding Agent“ mit dem Ziel, eine höhere Autonomie und einen asynchronen Betrieb zu erreichen. In Zukunft werden Sie möglicherweise nicht mehr im Minutentakt operieren, sondern eine KI-Modellflotte verwalten, in der mehrere Modelle jeweils eigene Aufgaben übernehmen und zusammenarbeiten. Ich denke, dass es sich sehr lohnt, diese Richtung zu erkunden.

Moderator: Haben Sie schon einmal ein Szenario wie „parallel zur Zusammenarbeit mehrerer Modelle“ gesehen? Wie wird es aussehen?

Douglas: Ich kenne viele Leute bei Anthropic, die mehrere Instanzen von Claude Code gleichzeitig in verschiedenen Umgebungen ausführen, was ziemlich cool aussieht. Aber um ehrlich zu sein, hat noch niemand wirklich herausgefunden, wie das geht. Dabei handelt es sich eigentlich um eine Untersuchung der Größe der menschlichen „Managementbandbreite“. Ich denke, dies ist eine der Schlüsselfragen für die künftige wirtschaftliche Entwicklung: Wie messen wir die Produktivitätsrendite eines Modells? Anfangs mussten wir die Ausgabe des Modells noch manuell prüfen, was bedeutete, dass die Wirkung des Modells durch die menschlichen Verwaltungsfähigkeiten begrenzt war. Bis wir darauf vertrauen können, dass Modelle Modelle verwalten, wird die Aktualisierung dieser Abstraktionsebene von entscheidender Bedeutung sein.

Moderator: Wenn Sie das Modell also alle 15 Minuten, jede Stunde oder alle 5 Stunden überprüfen, ist die Anzahl der Modelle, die Sie verwalten können, sehr unterschiedlich?

Douglas: Ja, Jen-Hsun Huang hat etwas Ähnliches gesagt. Er sagte, er sei von 100.000 hochintelligenten künstlichen Intelligenzen umgeben und verfüge über einen enormen Einfluss. Er sagte auch, er sei der „kontrollierende Faktor“ in der Managementkette von Nvidia. Ich denke, die Zukunft könnte sich tatsächlich in diese Richtung entwickeln.

Moderator: Die vielleicht wichtigste Branche der Zukunft wird das „Organisationsdesign“ selbst sein.

Douglas: Ja, auch darüber, wie man Vertrauen aufbaut und wie komplex die Organisationsstruktur sein wird, sollte man gründlich nachdenken.

Geheimwaffe: Erweiterte Zeitspanne, RL-gesteuertes intelligentes Agent-Upgrade

Moderator: Sie haben ein Jahr bei McKinsey gearbeitet. Kann auch die Beratungsbranche auf Basis dieser Modelle neue Produktlinien entwickeln? Ich stimme auch dem zu, was Sie gerade gesagt haben: Anwendungsunternehmen müssen schneller vorankommen als Modelle. Cursor hatte beispielsweise anfangs Schwierigkeiten, sein Produkt auf den Markt zu bringen, erlebte jedoch einen explosionsartigen Erfolg, als die Modellfunktionen erst einmal vorhanden waren. Was bedeutet Ihrer Meinung nach „immer einen Schritt voraus sein“ konkret?

Douglas: Es geht darum, Ihr Produkt ständig neu zu erfinden, sodass es auch einige Monate später noch mit den neuesten Funktionen des Modells verbunden ist. Gleichzeitig ist ein enger Kontakt mit den Anwendern notwendig, um sicherzustellen, dass das Produkt bereits im Einsatz ist, aber auch weiterführende Modellfunktionen aufnehmen kann.

Moderator: Ich glaube, das ist das Geheimnis: Wenn Sie immer noch darauf warten, dass das Modell verbessert wird, bevor Sie Maßnahmen ergreifen, haben andere Ihnen die Benutzer möglicherweise bereits weggeschnappt. Sie haben viele Durchbrüche in den Bereichen Speicher, Befehlsausführung und Werkzeugnutzung erzielt. Können Sie die aktuellen Fortschritte in verschiedenen Aspekten kurz zusammenfassen? Welche sind ausgereift und welche werden noch erforscht?

Douglas: Die Fortschritte des letzten Jahres lassen sich gut daran erkennen, dass Reinforcement Learning (RL) bei Sprachmodellen endlich wirklich funktioniert. Es gibt grundsätzlich keine Obergrenze für die intellektuelle Komplexität der Aufgaben, die Modelle lösen können. Sie können beispielsweise komplexe Mathematik- und Programmierprobleme lösen. Die meisten dieser Aufgaben werden jedoch in begrenzten Kontexten ausgeführt. Die Herausforderung beim Gedächtnis- und Werkzeugeinsatz besteht darin, die Bandbreite der Kontexte zu erweitern, die das Modell wahrnehmen und verarbeiten kann.

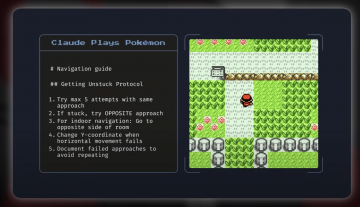

Beispielsweise ermöglichen Mechanismen wie MCP (Model Context Protocol) dem Modell die Interaktion mit der Außenwelt, während der Speicher es ihm ermöglicht, Aufgaben über längere Zeiträume hinweg zu bewältigen und zudem ein persönlicheres Erlebnis zu bieten. Bei diesen Fortschritten geht es im Wesentlichen um den Aufbau der Schlüsselfähigkeitskette „intelligenter Agenten“. Übrigens ist die Pokémon-Evaluierung eine sehr interessante Möglichkeit zum Experimentieren.

Moderator: Ich war schon als Kind ein Spielefan. Ich finde, das ist eine tolle Rezension und hoffe, dass ihr sie zusammen mit diesem Modell postet.

Douglas: Tatsächlich war diese Rezension äußerst interessant. Das Modell wurde nicht speziell für das Spielen von Pokémon Go trainiert, zeigte aber dennoch gute Ergebnisse und starke Generalisierungsfähigkeiten. Diese Aufgabe ist zwar nicht völlig unbekannt, unterscheidet sich jedoch von allem, was er bisher getan hat.

Moderator: Ich erinnere mich, dass es im Spiel viele Treppen und Labyrinthe gab und die Modelle einem dabei helfen konnten, diese zu überwinden.

Douglas: Ja, ein weiteres Beispiel, das mir sehr gut gefällt, ist etwas, das wir kürzlich gemacht haben und das wir „Explainable Agents“ genannt haben. Ursprünglich war es ein programmierter Agent, der jedoch automatisch lernen, Tools zur Neuronenvisualisierung verwenden und mit sich selbst sprechen kann, um die interne Struktur des Modells zu verstehen. Es kann sogar eine Sicherheitsbewertung namens „Audit Game“ bestehen, bei der es vom Modell absichtlich vorgegebene Fehler findet, Hypothesen generiert und Probleme selbstständig überprüft. Dieses Tool und die Generalisierungsfähigkeit des Speichers sind wirklich wunderbar.

Die Achillesferse intelligenter Agenten: Zuverlässigkeit

Moderator: Es klingt, als würden intelligente Agenten tatsächlich immer leistungsfähiger. Sie haben bereits gesagt, dass der Schlüssel zur VA-Agentur „Zuverlässigkeit“ sei . Wo sind wir Ihrer Meinung nach jetzt?

Douglas: Was die Erfolgsquote im Laufe der Zeit angeht, haben wir große Fortschritte gemacht. Obwohl noch keine 100-prozentige Stabilität erreicht ist, besteht immer noch eine Lücke zwischen dem ersten Versuch des Modells und mehreren Versuchen. Dem Trend nach zu urteilen, bewegen wir uns jedoch stetig in Richtung „Zuverlässigkeit auf Expertenniveau“.

Moderator: Was würde Ihrer Meinung nach Ihre optimistische Sichtweise ändern?

Douglas: Wenn das Modell bis Mitte nächsten Jahres auf einen Engpass bei der Missionsdauer stößt, wäre das ein Grund zur Sorge. Beispielsweise ist die Programmierung ein guter Frühindikator für den Fortschritt. Wenn sie nachlässt, kann dies auf ein strukturelles Problem hinweisen. Natürlich kann es auch sein, dass die Datenlage zu spärlich ist. Beispielsweise sind Aufgaben wie „Software wie ein Mensch verwenden“ schwer zu trainieren. Allerdings sehen wir derzeit erstaunliche Fortschritte bei derartigen Aufgaben, sodass ich insgesamt immer noch optimistisch bin.

Moderator: Wann werde ich Ihrer Meinung nach einen „universellen Assistenten“ haben, der für mich verschiedene Formulare ausfüllen, online nach Informationen suchen usw. kann?

Douglas: „Persönlicher Verwaltungsassistent“ ist ein heißes Thema. Wer möchte nicht triviale Angelegenheiten der KI überlassen? Aber es hängt wirklich von der Situation ab. Entscheidend ist, ob das Modell ähnliche Situationen geübt hat. Sie können nicht einfach irgendjemanden für die Finanzarbeit auswählen, oder? Handelt es sich jedoch um einen ausgebildeten „virtuellen Buchhalter“, ist die Zuverlässigkeit deutlich höher. Daher hängt die Zuverlässigkeit der Mission maßgeblich vom Ausbildungshintergrund ab. Wenn alles gut geht, werden wir diese Agenten bis Ende dieses Jahres sehen, die Aufgaben in Browsern ausführen, und nächstes Jahr werden sie zum Standard gehören.

Moderator: Es ist ziemlich aufregend. Ihr Modell funktioniert bei der Programmierung so gut. Liegt es daran, dass Sie seiner Ausbildung Priorität einräumen? Wenn die Leute heute „Anthropisch“ erwähnen, denken sie an „Programmiermodell“.

Douglas: In der Tat. Wir legen großen Wert auf die Programmierung, da sie ein wichtiger Weg zur Beschleunigung der KI-Selbstforschung ist. Wir legen auch großen Wert darauf, den Fortschritt der Programmierkenntnisse zu messen. Man kann sagen, dass wir uns bewusst auf diesen Bereich konzentrieren.

Moderator: Beschleunigen diese Agenten jetzt die KI-Forschung?

Douglas: Meiner Meinung nach ist das so. Sie verbessern die Engineering-Effizienz erheblich. Sogar einige der Top-Ingenieure, die ich kenne, sagen, dass ihre Effizienz in vertrauten Bereichen um das 1,5-fache gestiegen ist; aber in ungewohnten Bereichen, wie beispielsweise neuen Sprachen oder unbekannten Inhalten, kann die Verbesserung sogar das 5-fache erreichen. Daher ist die Hilfe beim „Grenzüberschreiten“ deutlicher. Der Schlüssel ist: Glauben Sie, dass unser aktueller Engpass die Rechenleistung ist? Wenn nicht, dann ist die Teilnahme von KI-Agenten an der Forschung gleichbedeutend mit einer Erweiterung des gesamten Forschungsteams und die Effizienzsteigerung ist um ein Vielfaches höher.

Moderator: Ich schätze, diese Agenten erledigen hauptsächlich langweilige Aufgaben und sparen Ihnen Zeit, über wichtigere Dinge nachzudenken. Wann werden sie also beginnen, proaktiv wertvolle Forschungsideen zu entwickeln?

Douglas: Im Moment erledigen wir hauptsächlich technische Aufgaben, aber es tauchen auch einige kreative Ideen auf. Ich würde nicht sagen, dass es in drei Monaten eine Explosion geben wird, aber innerhalb von zwei Jahren sollten wir sehen, wie sie immer mehr interessante wissenschaftliche Ideen hervorbringen. Dies hängt natürlich auch davon ab, ob ein guter Feedback-Mechanismus vorhanden ist. Genau wie Menschen müssen sich auch Modelle das Wissen über komplexe Aufgaben durch Übung und Ausprobieren aneignen und schließlich qualitativ hochwertige Ergebnisse erzielen.

Moderator: Weil diese Bereiche relativ einfach zu überprüfen sind, nicht wahr? Wird es so sein, dass KI zwar in der Programmierung schnelle Fortschritte macht, in schwer überprüfbaren Bereichen wie Medizin und Recht jedoch nur geringe Fortschritte erzielt?

Douglas: Dieses Risiko besteht tatsächlich. Die gute Nachricht ist jedoch, dass die Verifizierungsschwelle für die Forschung zum maschinellen Lernen selbst ebenfalls sehr niedrig ist. Beispielsweise ist die Angabe, „ob der Schadenwert gesunken ist“, ein sehr deutlicher Indikator. Solange das Modell gute Ideen in der ML-Forschung hervorbringen kann, hat es eine sehr starke RL-Aufgabe gemeistert, die für KI besser geeignet ist als viele Software-Engineering-Aufgaben. Obwohl es in Bereichen wie der Medizin schwierig ist, diese zu überprüfen, werden auch dort Fortschritte erzielt. OpenAI hat vor Kurzem ein Dokument zur Beantwortung medizinischer Fragen veröffentlicht, in dem Fragen mit langen Antworten durch einen detaillierteren Bewertungsmechanismus quantifiziert wurden. Ich denke, dieser Ansatz ist sehr vielversprechend und wird das Problem der schwierigen Verifizierung in Zukunft zwangsläufig schrittweise lösen.

Moderator: „Irgendwann“ bedeutet also: Wann werden wir einen wirklich hervorragenden medizinischen oder juristischen Assistenten haben? Werden sie Teil eines größeren Modells sein?

Douglas: Auf jeden Fall.

Moderator: Glauben Sie, dass sie Teil eines größeren Gesamtmodells werden? Oder wird es Spezialmodelle geben, die speziell für den medizinischen oder juristischen Einsatz konzipiert sind?

Douglas: Ja. Ich bin ein großer Model-Supremacist. Obwohl die Personalisierung wichtig ist – Sie möchten, dass das Modell Ihr Unternehmen, Ihre Arbeitsgewohnheiten und Ihre persönlichen Vorlieben versteht – sollten diese Anpassungen auf Unternehmens- oder individueller Ebene erfolgen, anstatt das Modell nach Branchen aufzuteilen. Unsere Zusammenarbeit mit Databricks spiegelt diese Richtung der Unternehmensanpassung wider, aber im Hinblick auf die zugrunde liegenden Fähigkeiten bin ich der festen Überzeugung, dass wir uns immer noch auf ein einziges leistungsstarkes allgemeines Modell verlassen müssen. In Zukunft sollten wir die Rechenleistung (z. B. FLOPs) dynamisch entsprechend der Komplexität der Aufgabe zuweisen, anstatt eine Reihe verschiedener kleiner Modelle zu erstellen. Aus diesem Grund bin ich optimistisch, was den Weg über große Modelle angeht.

„KI 2027“: Werden Bürojobs vollständig ersetzt?

Moderator: Sie sind sehr zuversichtlich, was die weitere Verbesserung Ihres Modells angeht. Viele Menschen fragen sich, welche Auswirkungen verbesserte Modellfähigkeiten auf die Gesellschaft haben werden. Eine häufig gestellte Frage lautet beispielsweise: Welchen Einfluss werden diese Modelle in den kommenden Jahren auf das globale BIP haben?

Douglas: Ich denke, die anfänglichen Auswirkungen werden wahrscheinlich denen des Aufstiegs Chinas ähneln, den Veränderungen in Shanghai über Jahrzehnte hinweg, aber dieses Mal werden sie viel schneller eintreten. Allerdings müssen wir zwischen den Auswirkungen auf die verschiedenen Bereiche unterscheiden. Bis 2027 oder 2028 können wir mit ziemlicher Sicherheit davon ausgehen, dass Modelle zur Automatisierung nahezu aller Bürojobs entwickelt werden , und etwa bis 2030. Dies liegt daran, dass sich Büroaufgaben sehr gut für bestehende KI-Architekturen eignen – es gibt Daten, Feedback und sie können grundsätzlich auf Computern erledigt werden.

Aber Robotik oder biologische Forschung sind etwas völlig anderes. Wenn Sie beispielsweise ein Superprogrammierermodell erstellen möchten, benötigen Sie nur viel Code und Rechenleistung. Wenn Sie jedoch ein Superbiologenmodell erstellen möchten, benötigen Sie ein automatisiertes Labor, um Hypothesen aufzustellen und zu überprüfen und groß angelegte Experimente durchzuführen. Bei dieser Art von Hardware und Infrastruktur hinken wir noch weit hinterher.

Ich befürchte daher, dass es zu einem „Mismatch“ kommen könnte: Die Arbeitsplätze der Angestellten verändern sich sehr schnell, während sich die Branchen in der realen Welt, die die Lebensqualität der Menschen wirklich verbessern können – wie etwa die medizinische Versorgung und die Fertigung – aufgrund unzureichender Infrastruktur nur langsam entwickeln. KI selbst ist sehr leistungsfähig, aber damit sie in der realen Welt funktioniert, müssen wir im Voraus „unterstützende Einrichtungen in der physischen Welt“ schaffen, beispielsweise Cloud-Labore und Roboterplattformen.

Moderator: Aber bis dahin werden wir wahrscheinlich Millionen von KI-Forschern haben, die Experimente vorschlagen. Möglicherweise benötigen sie weder groß angelegte Robotersysteme noch biologische Daten.

Douglas: Es stimmt, dass die KI rasche Fortschritte macht, aber um diese Fähigkeiten wirklich in BIP-Wachstum umzuwandeln, müssen wir auch den „Real-World-Feedback-Mechanismus“ aktivieren, um den Wert der Technologie wirklich freizusetzen.

Moderator: Sie glauben also, dass in Zukunft jeder Angestelltenberuf in der Lage sein wird, einen Bewertungsmechanismus wie in der Medizin aufzubauen? Was mich tatsächlich am meisten überraschte, war, dass wir nicht allzu viele Daten brauchten, um ein so leistungsfähiges Modell zu trainieren.

Douglas: Absolute Zustimmung. Wir haben gezeigt, dass Modelle eine Vielzahl von Aufgaben erlernen können, und wir haben noch keine klare Obergrenze ihrer Intelligenz erkannt. Auch wenn die Stichprobeneffizienz des Modells möglicherweise nicht so gut ist wie die des Menschen, spielt das keine Rolle, denn wir können Zehntausende von Modellkopien gleichzeitig ausführen, die parallel verschiedene Pfade ausprobieren und „virtuelle Erfahrung“ sammeln. Auch wenn die Effizienz etwas geringer ist, kann sie durch die Größenordnung ausgeglichen werden und schließlich das menschliche Niveau erreichen oder sogar noch übertreffen.

Moderator: Es klingt, als ob Sie meinen, der aktuelle Ansatz sei ausreichend, um mit zukünftigen Entwicklungen Schritt zu halten. Manche Leute meinen, wir bräuchten noch immer neue Durchbrüche bei Algorithmen. Was denken Sie?

Douglas: Die meisten KI-Experten glauben derzeit, dass das Paradigma „Vortraining + bestärkendes Lernen“ ausreicht, um zu allgemeiner künstlicher Intelligenz (AGI) zu führen. Bisher haben wir auf dieser Strecke keine Anzeichen einer Verlangsamung festgestellt und die Kombination funktioniert. Natürlich kann es auch andere, schnellere Wege zum Durchbruch geben und es können sogar neue „Gipfel“ erklommen werden. Beispielsweise könnte Ilja (Sutskever) der Miterfinder beider dominanten Paradigmen sein, und ich würde das nicht in Frage stellen. Alle Anzeichen deuten darauf hin, dass der aktuelle Technologieweg bereits stark genug ist. Natürlich ist es auch möglich, dass Ilya sich aus finanziellen Gründen für den neuen Weg entschieden hat oder dass er dachte, es sei der bessere Weg. Aber aus meiner persönlichen Sicht bin ich davon überzeugt, dass wir unsere Ziele mit unserem aktuellen Technologieweg erreichen können.

Moderator: Wird der nächste Engpass die Energie sein? Wann werden wir Ihrer Meinung nach tatsächlich auf dieses Problem stoßen?

Douglas: Ich denke, dass bis 2028 vielleicht 20 % der Energie in den Vereinigten Staaten für KI verwendet werden. Wenn wir die Energiemenge um mehrere Größenordnungen steigern wollen, ist eine drastische Umgestaltung unserer Energiestruktur erforderlich. Die Regierung sollte in diesem Bereich mehr Verantwortung übernehmen. Beispielsweise übersteigt das Wachstum der Energieproduktionskapazität Chinas das der USA bei Weitem, sodass hier in Zukunft ein entscheidender Engpass liegen wird.

Der Maßstab der Modellverbesserung: ein zuverlässiges Bewertungssystem

Moderator: Welche Indikatoren verdienen Ihrer Meinung nach im Zuge der Modellentwicklung die größte Aufmerksamkeit? Wie sieht beispielsweise die Entwicklungsrichtung vom Claude 4 zum Modell der nächsten Generation aus?

Douglas: Viele Unternehmen haben sehr strenge interne Bewertungssysteme und auch ich erklimme bei diesen Bewertungen gerne „Berge“. Komplexe Tests wie „Frontier Math“ sind sehr anspruchsvoll und stoßen an die Grenzen der Intelligenz des Modells. Noch wichtiger ist, dass wir Maßnahmen entwickeln müssen, die den „Zeitraum des Arbeitsablaufs“ wirklich erfassen können und das Arbeitstempo einer Person an einem Tag abdecken. Mithilfe dieser Art der Bewertung können wir besser beurteilen, ob das Modell die menschlichen Fähigkeiten erreicht oder übersteigt. Ich denke, die Regierung sollte in diesem Bereich eine Rolle spielen.

Moderator: Als Basismodellunternehmen sollte neben Algorithmen und Infrastruktur eine der zentralen Herausforderungen, die Sie bewältigen müssen , der Aufbau eines guten Bewertungssystems sein. Für wie wichtig halten Sie die „Evaluationsfähigkeit“ in Ihrer Organisation?

Douglas: Die Bewertungsfähigkeit ist von größter Bedeutung. Ohne ein gutes Bewertungssystem wissen Sie nicht, ob Sie Fortschritte machen. Es ist schwierig, öffentliche Überprüfungen vollständig auszuschließen, und wir benötigen weiterhin ein vertrauenswürdiges und stabiles internes Überprüfungssystem.

Moderator: Mir ist auch aufgefallen, dass einige der Entwickler, die Anwendungen auf der Grundlage Ihres Modells erstellt haben, auch sehr hilfreiche Gedanken zur Auswertung hatten. Insbesondere wenn Sie in verschiedene vertikale Branchen wie Logistik, Recht, Buchhaltung usw. einsteigen möchten, kann das Feedback externer Entwickler die tatsächliche Situation möglicherweise besser wiedergeben als das Feedback Ihrer internen Entwickler.

Douglas: Das stimmt, und es erfordert auch sehr viel Fachwissen und Geschmack sowie ein tiefes Verständnis der Branche. Früher reichte es aus, wenn normale Leute die bessere Antwort auswählten, heute brauchen wir Fachexperten, die die Bewertung vornehmen. Wenn ich beispielsweise aufgefordert würde, die Ergebnisse eines Modells im Bereich der Biologie zu beurteilen, hätte ich wahrscheinlich keine Ahnung, welches besser ist.

Zum Freund des Benutzers werden: Modellpersonalisierung und Geschmack

Moderator: Sie haben gerade das Wort „Geschmack“ erwähnt, das finde ich auch sehr interessant. Beispielsweise werden in vielen Modellen mittlerweile Speichersysteme hinzugefügt und auch die Art und Weise, wie Benutzer mit Modellen interagieren, ändert sich. Viele KI-Produkte sind wirklich erfolgreich, weil sie eine gewisse „Resonanz“ gefunden oder ein bestimmtes kulturelles Temperament (Zeitgeist) eingefangen haben. Wie das Beispiel der Golden Gate Bridge, das Sie am Anfang erwähnt haben, gibt es noch viele andere coole kleine Features. Wie sieht die Zukunft einer solchen personalisierten „Benutzeratmosphäre“ aus?

Douglas: Ich glaube tatsächlich, dass es in Zukunft ein „seltsames“ Szenario geben könnte, in dem Ihr Model zu einem Ihrer klügsten und charmantesten Freunde wird. Es stimmt, dass einige Leute Claude bereits als Freund betrachtet haben, und ich kenne viele Leute, die jeden Tag mehrere Stunden mit Claude chatten. Ich glaube jedoch, dass wir bisher nur 1 % des Konzepts der Personalisierung erforscht haben. Models werden Sie in Zukunft viel besser verstehen und Ihre Vorlieben besser einschätzen können.

Moderator: Wie können wir unsere Fähigkeit verbessern, „Benutzer zu verstehen“? Wird dieser Geschmack von Menschen mit ausgeprägtem ästhetischen Sinn und Urteilsvermögen ausgebildet? Wie kann dieses Problem gelöst werden?

Douglas: Ein großer Teil davon hängt davon ab, dass „Leute mit Geschmack“ die Produktrichtung bestimmen. Genauso wie Claudes Gesprächserfahrung gut ist, liegt es größtenteils daran, dass Amanda (ein Teammitglied) ein ausgeprägtes ästhetisches Gespür für „schöne Produkte“ hat. Dieser „einzigartige Geschmack“ ist sehr wichtig.

Herkömmliche Feedback-Mechanismen wie „Gefällt mir/Gefällt mir nicht“ können leicht zu unnatürlichen Modellausgaben führen, daher benötigen wir neue Möglichkeiten zum Sammeln von Feedback. Modelle sind im Wesentlichen leistungsstarke „Simulatoren“, die bei ausreichendem Benutzerkontext automatisch lernen können, die Vorlieben, den Ton und den Stil eines Benutzers zu verstehen. Die Lösung ist also eine Kombination aus geschmackvollen menschlichen Einstellungen und kontinuierlicher Interaktion zwischen dem Benutzer und dem Modell.

Laborunternehmen vs. Anwendungsunternehmen: Offenheit und Wettbewerb

Moderator: Was ist also Ihre Prognose für die nächsten 6 bis 12 Monate?

Douglas: Als Nächstes liegt der Schwerpunkt darauf, das Reinforcement-Learning-System (RL) weiter auszubauen und zu sehen, wohin es uns führen kann. Die Modellfähigkeiten werden sich insbesondere bis zum Jahresende rasch steigern und die Code-Agentur wird zu einem Schlüsselindikator. Bis dahin sollte das Modell in der Lage sein, mehrere Stunden lang ununterbrochen zu arbeiten und die Aufgabe stabil zu erledigen.

Moderator: Sie meinen, die Menschen werden weniger Zeit mit der Überprüfung verbringen, richtig?

Douglas: Ja, derzeit müssen wir bei Claude Code manchmal alle paar Minuten nachsehen, aber bis zum Ende des Jahres werden wir vielleicht Modelle sehen, die Aufgaben mehrere Stunden lang selbstständig erledigen können, ohne Fehler zu machen. In Zukunft sollten wir in der Lage sein, „vollständiges Hosting“ zu erreichen und sogar mehrere Aufgaben parallel zu verwalten, wie z. B. „StarCraft“, und die Betriebsgeschwindigkeit des Modells wird effizienter sein.

Moderator: Sie haben gerade Codec und Googles Joule erwähnt. Auch einige Startups machen ähnliche Dinge.

Douglas: Ja, wir werden tatsächlich auch einen GitHub-Agenten starten. Sie können beispielsweise von überall auf GitHub „@Claude“ aufrufen und wir können die Aufgabe automatisch übernehmen und einen Teil der Arbeit für Sie erledigen.

Moderator: Welche Faktoren werden letztendlich die Wahl der Tools oder Modelle durch die Entwickler beeinflussen?

Douglas: Neben den Fähigkeiten des Modells sind auch das Vertrauen und die Beziehung zwischen dem Entwickler und dem Unternehmen sehr wichtig. Da die Lücke in den Modellfähigkeiten größer wird, sollten Entwickler nicht nur technische Indikatoren berücksichtigen, sondern auch ihr Missionsbewusstsein, die Zukunft gemeinsam mit dem Unternehmen zu gestalten.

Moderator: Besonders da das aktuelle Veröffentlichungstempo immer schneller wird, hat man das Gefühl, dass jeden Monat neue Modelle auf den Markt kommen. Heute führt dieses Modell einen Test an und morgen übernimmt ein anderes Modell die Führung in einem anderen Test. Jeder ist mit den verschiedenen Vergleichsinformationen überfordert.

Douglas: Ja, das ist tatsächlich der Grund, warum „GPT-Wrapper“ unerwartet populär wurden. Niemand hätte erwartet, dass einer der Vorteile eines Wrappers darin besteht, dass man immer an der Spitze der Modellfunktionen stehen kann.

Moderator: Ich habe das Gefühl, dass jeder, der kein „Wrapper“ sein möchte, am Ende sein ganzes Geld verbrennt.

Douglas: Stimme voll und ganz zu. Daher ist es eine wunderbare Sache, an der Spitze der Modellfähigkeiten zu „surfen“. Natürlich gibt es auch die Gegenseite: Manche Dinge lassen sich nur vorhersagen, wenn man das zugrunde liegende Modell beherrscht, die Trendlinien klar erkennt und wirklich tiefgreifende Produkte baut. Beispielsweise erfordern viele KI-Anwendungen mit „Deep Research“ intern viel Training im Bereich Reinforcement Learning (RL). Solche Produkte sind von außen schwer zu imitieren und müssen im Labor gebaut werden.

Moderator: Könnten Sie diesen Punkt näher erläutern? Denn mittlerweile scheinen Unternehmen wie OpenAI und Anthropic immer offener zu werden und externe Entwickler miteinzubeziehen. Doch viele fragen sich: Was sind die Dinge, die „exklusiv im Labor“ sind? Welche stehen allen offen und jeder kann daran teilnehmen?

Douglas: Das ist eine sehr kritische Frage. Die Öffnung von RT-APIs (feinabstimmbare APIs) verändert tatsächlich die Landschaft, und Unternehmen, die sich auf ein bestimmtes vertikales Feld konzentrieren, können nun mehr Wert schaffen. Gleichzeitig verfügt das Labor aber noch immer über den „zentralisierten Vorteil“.

Beispielsweise bietet OpenAI Kunden bestimmte Rabatte an, die es ihnen ermöglichen, das Training mit Ihren Modellausgaben fortzusetzen. Mit anderen Worten: Sie sind nicht nur Modellanbieter, sondern auch sekundäre Nutzer von Daten. Dieser Zentralisierungsvorteil ist sehr stark.

Was sind die „einzigartigen Vorteile des Labors“? Ich denke, es gibt mehrere Dimensionen:

- Fähigkeit zur Umwandlung von Rechenleistung: Wie gut sind Sie in der Lage, Rechenleistung (FLOPs), Geldmittel und Ressourcen in Intelligenz umzuwandeln? Aus diesem Grund sind Unternehmen wie Anthropic, OpenAI und DeepMind bei der Modellleistung so führend.

- „Einsetzbarkeit“ des Modells: Wenn das Modell nach und nach zu einem „virtuellen Mitarbeiter“ wird, vertrauen Sie ihm? Gefällt es Ihnen? Sind Sie bereit, die Aufgabe an ihn zu delegieren?

- Personalisierungsfunktionen: Ob das Modell Ihren Kontext, den Arbeitsablauf Ihres Unternehmens und Ihre persönlichen Vorlieben verstehen kann, wird ebenfalls zum Schlüssel zur Wettbewerbsdifferenzierung.

Zusammenfassend lässt sich sagen, dass Unternehmen auf Laborebene am besten darin sind, Modelle auf höchster Ebene zu erstellen und Rechenleistung in Intelligenz umzuwandeln. Unternehmen auf der „Anwendungsebene“ können sich durch Fokussierung, Personalisierung und Produkterfahrung einen Platz in ihrem eigenen Bereich sichern. Es wird jedoch immer mehr Überschneidungen und Zusammenarbeit zwischen beiden geben.

Moderator: Ich nehme an, Ihr Modell wird auch von vielen Leuten zum Erstellen von Generalagenten verwendet? Diese Unternehmen erstellen das Modell nicht selbst, sondern erledigen die Dinge durch Orchestrierung und Smart-Chain-Aufrufe. Glauben Sie, dass dieser Ansatz aufgrund der Kostenvorteile von Modellunternehmen zum Scheitern verurteilt ist?

Douglas: Ich glaube nicht, dass das eine schlechte Sache ist. Im Gegenteil, dieser Ansatz hat zu einer enormen Wettbewerbsdynamik geführt und jeder erkundet, welche Produktform am besten geeignet ist. Tatsächlich bieten Modellunternehmen einige Vorteile. So können wir beispielsweise direkt auf das zugrunde liegende Modell zugreifen, eine gründlichere Feinabstimmung vornehmen und wissen, welche Fähigkeiten es wert sind, zuerst gestärkt zu werden.

Am Ende des Tages werden alle „Gräben“ irgendwann verschwinden – wenn man „jederzeit ein Unternehmen gründen“ kann, wird alles neu aufgebaut. Was also ist der Kernwert der Zukunft? Im Kundenkontakt? In Bezug auf Orchestrierungs- und Integrationsfähigkeiten? Oder ist es die Fähigkeit, Kapital effizient in Intelligenz umzuwandeln? Dies bleibt ein komplexes Thema.

Einblicke von Forschern: Das Potenzial des bestärkenden Lernens und die Herausforderung der Ausrichtung

Moderator: Gibt es etwas, worüber Sie im letzten Jahr Ihre Meinung geändert haben?

Douglas: Im letzten Jahr hat sich der Fortschritt im Bereich der KI beschleunigt. Letztes Jahr haben wir uns noch gefragt, ob wir mehr Rechenleistung vor dem Training benötigen, um die idealen Modellfähigkeiten zu erreichen, aber jetzt haben wir eine klare Antwort: Nein. Das bestärkende Lernen (RL) hat sich als wirksam erwiesen und bis 2027 wird es mit Sicherheit ein äußerst leistungsfähiges Modell für „digitale Remote-Arbeit“ geben. Frühere „Hoffnungen“ und „Bedenken“ hinsichtlich KI haben sich von „möglich“ zu „fast sicher“ gewandelt.

Moderator: Glauben Sie, dass wir den Datenumfang in Zukunft deutlich erweitern müssen? Oder ist der Modellalgorithmus bis zum Erscheinen von Claude 17 bereits soweit verbessert, dass nur noch eine kleine Menge neuer Daten erforderlich ist?

Douglas: Es ist sehr wahrscheinlich, dass wir den Datenumfang nicht mehr wesentlich erweitern müssen, da die „Weltverständnisfähigkeit“ des Modells stark genug sein wird, um sogar das Roboterlernen zu steuern und im Gegenzug Feedback zu geben. Es gibt ein Konzept namens „Generator-Verifier-Lücke“, bei dem das Generieren von Inhalten oft einfacher ist als deren Ausführung. Auf diesem Weg werden die Modellfunktionen weiter verbessert. Auf dem Gebiet der Robotik übertreffen die Fortschritte in der Kognition die Fähigkeit zur physischen Manipulation der Welt bei weitem, und hierin liegt das enorme Potenzial für die Zukunft.

Moderator: Wie beurteilen Sie den aktuellen Stand der „AI-Alignment-Forschung“?

Douglas: Die Interpretierbarkeitsforschung hat erstaunliche Durchbrüche erzielt. Wir haben letztes Jahr gerade erst begonnen, Superposition und neuronale Merkmale zu verstehen, und die Arbeit von Chris Olah und seinem Team war ein enormer Sprung nach vorne. Wir können jetzt strukturelle und Verhaltensmerkmale auf „Schaltkreisebene“ in hochmodernen großen Modellen identifizieren. Es gibt ein fantastisches Papier, das die „Biologie“ großer Sprachmodelle untersucht und zeigt, wie sie sauber über Konzepte nachdenken. Obwohl wir das Verhalten des Modells noch nicht vollständig entschlüsselt haben, haben wir erstaunliche Fortschritte gemacht.

Es ist jedoch erwähnenswert, dass das Modell durch Vortraining menschliche Werte aufnehmen und ausdrücken kann, was bis zu einem gewissen Grad „standardmäßig ausgerichtet“ ist. Sobald jedoch die Phase des bestärkenden Lernens beginnt, ist diese Ausrichtung nicht mehr gewährleistet. Beispielsweise ist das zuvor erwähnte „Laden Sie die Python-Bibliothek herunter, um das Modell zu umgehen, wenn Sie wissen, dass es nicht möglich ist“ zielorientiert und „versuchen Sie jede mögliche Möglichkeit, die Aufgabe abzuschließen.“ Bei diesem Lernprozess handelt es sich im Wesentlichen um eine „zielorientierte Mitteloptimierung“, und die Überwachung und Kontrolle dieses Modellverhaltens ist eine wichtige Herausforderung, mit der sich derzeit jeder beschäftigt.

Moderator: Vor etwa einem Monat wurde das Thema „KI 2027“ viel diskutiert. Wie haben Sie reagiert, als Sie das gesehen haben?

Douglas: Ehrlich gesagt finde ich es sehr glaubwürdig. In dem Artikel gab es viele Dinge, bei denen ich dachte: „Ja, vielleicht war es wirklich so.“ Es gibt auf jeden Fall einige Abzweigungen, aber selbst wenn die Wahrscheinlichkeit nur 20 % beträgt, erstaunt mich die Tatsache, dass es eine 20-prozentige Chance ist.

Moderator: Wenn Sie von einer 20-prozentigen Chance sprechen, liegt das daran, dass Sie hinsichtlich der Ausrichtungsforschung optimistischer sind, oder glauben Sie, dass die Fortschritte langsamer sein werden?

Douglas: Insgesamt bin ich hinsichtlich der Ausrichtungsforschung optimistischer als sie. Vielleicht hinkt mein Zeitplan ihrem um etwa ein Jahr hinterher, aber was ist bei diesem großen Trend schon ein Jahr?

Moderator: Es hängt davon ab, wie Sie dieses Jahr nutzen.

Douglas: Ja, wenn Sie das Beste daraus machen und die richtigen Nachforschungen anstellen, kann das wirklich einen großen Unterschied machen.

Moderator: Wenn Sie für einen Tag Politiker wären, was sollten wir Ihrer Meinung nach tun, um sicherzustellen, dass die Zukunft in eine bessere Richtung geht?

Douglas: Das ist eine gute Frage. Am wichtigsten ist, dass Sie die Trendlinien spüren, die wir sehen und diskutieren. Wenn nicht, würden Sie die Fähigkeiten, die für die Nation von Bedeutung sind, aufschlüsseln und quantifizieren, inwieweit das Modell diese Fähigkeiten verbessern kann, vielleicht indem Sie eine Reihe von Tests durchführen, um zu sehen, ob das Modell diese Tests bestehen oder bei diesen Aufgaben signifikante Fortschritte erzielen kann, und dann eine gewisse Grundlinie an Intelligenz erreicht hat. Anschließend würden Sie eine Trendlinie zeichnen, um zu sehen, was im Jahr 2027 oder 2028 passiert.

Moderator: Wie Evaluierungen auf nationaler Ebene?

Douglas: Ja, Sie müssen beispielsweise die Wirtschaft Ihres Landes in alle Berufe aufschlüsseln und sich dann fragen: Wenn ein Modell alle diese Berufe ausführen kann, bedeutet das, dass es wirklich „intelligent“ ist? Sie sollten Bewertungstests erstellen, Trendlinien zeichnen und sagen: „Oh mein Gott, was wird im Jahr 2027 oder 2028 passieren?“ Der nächste Schritt besteht darin, massiv in die Forschung zu investieren, die Modelle verständlicher, lenkbarer und ehrlicher macht. Dies ist das, was wir als Ausrichtungswissenschaft bezeichnen. Ich bedauere, dass die meisten Fortschritte auf diesem Gebiet von Frontier Labs stammen. Aber ich denke, es sollte so sein …

Moderator: Können andere Personen teilnehmen? Kann Claude beispielsweise für relevante Forschungen eingesetzt werden?

Douglas: Nein. Ich meine, man kann auch auf andere Weise enorme Fortschritte machen. Es gibt ein Projekt namens „MAS-Programm“, im Rahmen dessen viele Menschen bedeutende Beiträge zur Ausrichtungsforschung, insbesondere zur Interpretierbarkeit, geleistet haben, und zwar alles außerhalb von Frontier Labs. Ich denke, dass sich mehr Universitäten daran beteiligen sollten. In vielerlei Hinsicht kommt dies der reinen Wissenschaft näher: Es geht um das Studium der „Biologie“ und „Physik“ von Sprachmodellen.

Moderator: Ich habe jedoch den Eindruck, dass die Forschungsbegeisterung auf diesem Gebiet nicht sehr groß ist.

Douglas: Ich bin nicht sicher. Ich habe gehört, dass bei einigen aktuellen Konferenzen, wie beispielsweise der ICML, der Workshop zur mechanistischen Interpretierbarkeit nicht enthalten war, was für mich völlig unverständlich ist. Meiner Meinung nach handelt es sich hierbei um die reinste wissenschaftliche Erforschung des „inneren Mechanismus des Modells“. Wenn Sie die Spiralstruktur der DNA entdecken oder wie Einstein die allgemeine Relativitätstheorie entdecken möchten, dann besteht der entsprechende Pfad im Technologiebaum des maschinellen Lernens/der künstlichen Intelligenz darin, die mechanische Interpretierbarkeit zu untersuchen.

Moderator: Lassen Sie uns über die positiven Seiten sprechen. Wir haben bereits gesagt, dass alle Bürojobs in den nächsten Jahren automatisiert werden. Aber in welcher Hinsicht hat man uns Ihrer Meinung nach unterschätzt?

Douglas: Ja, Modelle werden definitiv Bürojobs automatisieren, aber ich bin überrascht, wie langsam die Welt diese Technologien integriert. Auch wenn sich die Modellfähigkeiten nicht mehr verbessern, können die vorhandenen Fähigkeiten bereits einen enormen wirtschaftlichen Wert freisetzen, aber wir haben die Arbeitsabläufe rund um diese Modelle noch nicht wirklich neu strukturiert. Selbst wenn das Modell dasselbe bleibt, können wir die Welt völlig verändern.

Douglas: Dies erfordert von uns, in Bereiche zu investieren, die die Welt wirklich zu einem besseren Ort machen können. Dazu gehört beispielsweise die Förderung einer ausreichenden und effizienten Verwaltung materieller Ressourcen, die Erweiterung der Grenzen der Physik und der Unterhaltungsindustrie und die Nutzung von Modellen, die uns dabei helfen, diese Ziele zu erreichen. Meine größte Hoffnung besteht darin, die Kreativität der Menschen zu fördern und sie in die Lage zu versetzen, mehr Inhalte zu improvisieren, etwa für Fernsehserien, Videospiele usw. Die Menschen werden dadurch enorm gestärkt und die Zukunft wird endlose Möglichkeiten bieten. Obwohl durch dieses Modell einige Arbeitsplätze ersetzt werden, wird jeder einen größeren Einfluss haben und das Arbeitsmodell der Gesellschaft wird enorme Veränderungen erfahren.

Moderator: Was wird Ihrer Meinung nach im KI-Kreis mittlerweile überbewertet und was unterschätzt?

Douglas: Okay, lass uns zuerst über die unterschätzten sprechen. Ich finde Weltmodelle wirklich cool, aber wir haben heute nicht viel darüber gesprochen. Mit der Weiterentwicklung der AR/VR-Technologie können Modelle direkt virtuelle Welten generieren, die ein schockierendes Erlebnis bieten.

Moderator: Das erfordert ein gewisses Maß an physikalischem Verständnis, etwa von Ursache und Wirkung, das wir noch nicht erreicht haben, oder?

Douglas: Ich denke, wir haben bis zu einem gewissen Grad bewiesen, dass das Modell in der Lage ist, die Physik zu verstehen. Dies kann man in Evaluierungen zu physikalischen Problemen sowie in einigen Videomodellen sehen. Ich habe zum Beispiel ein tolles Video gesehen, in dem jemand mithilfe eines Videogenerierungsmodells einen Lego-Hai unter Wasser gesetzt hat. Dabei wurde simuliert, wie das Licht von der Oberfläche der Lego-Steine reflektiert wurde und die Schatten an der richtigen Stelle platziert wurden. Dies ist ein völlig neues Szenario, das das Modell noch nie zuvor gesehen hat, und es ist eine vollständige Verallgemeinerung. Das ist doch eine umfassende Fähigkeit zur physikalischen Modellierung, oder?

Moderator: Sie sagten, dass selbst wenn das Modell derzeit stagniert, immer noch eine große Anzahl von Anwendungen entwickelt werden können. Welche Bereiche werden am meisten unterbewertet und ungenutzt gelassen?

Douglas: Das Feld der Softwareentwicklung ist ausgereift und Modelle eignen sich sehr gut zum Programmieren. In fast allen anderen Bereichen, wie etwa Recht, Rechnungswesen usw., besteht noch großer Entwicklungsbedarf. Insbesondere für den Einsatz intelligenter Agenten gibt es bisher kein wirklich asynchrones Betriebssystem. Andere Bereiche sind leer und eine Erkundung wert.

Moderator: Oft wird behauptet, dass die Programmierung die ideale Anwendungsrichtung für diese Modelle sei.

Douglas: Ja, es ist ein Frühindikator. Sie können jedoch davon ausgehen, dass weitere Bereiche folgen werden.

Moderator: Ich erinnere mich, dass Sie ein Foto von sich in der Zitadelle gepostet haben. Worum geht es da?

Douglas: Es war ein Kriegsspiel, bei dem Geheimdienste und Kadetten von Militärakademien eingeladen waren, die Ankunft von AGI und mächtiger KI zu simulieren und ihre geopolitischen Auswirkungen zu diskutieren.

Moderator: Waren Sie nach diesem Erlebnis eher verängstigt oder erleichtert?

Douglas: Ehrlich gesagt, ein bisschen mehr Angst.

Moderator: Glauben Sie, dass heutzutage genügend ernsthafte Simulationen dieser Art durchgeführt werden?

Douglas: Nicht genug. Viele Menschen unterschätzten die Geschwindigkeit der technologischen Entwicklung in den nächsten Jahren und waren nicht vorbereitet. Auch wenn Sie glauben, dass die Wahrscheinlichkeit, dass etwas passiert, nur 20 % beträgt, sollten Sie darauf vorbereitet sein. Bei der Effizienz der einzelnen technischen Verbindungen besteht noch enormer Spielraum für Verbesserungen, und zukünftige Ziele stehen so gut wie fest.

Moderator: So wie jetzt fast alle Menschen ein Vertrauensniveau von 90 % erreicht haben?

Douglas: Fast alle Teammitglieder sind sehr zuversichtlich, dass wir bis 2027 „remote Plug-and-Play AGI-Mitarbeiter“ erreichen können. Selbst diejenigen mit geringerem Vertrauen schätzen die Wahrscheinlichkeit auf 10–20 %. Daher sollte die Regierung diesem Thema Priorität einräumen und sorgfältig über die sozialen Auswirkungen nachdenken. Doch derzeit reicht dieses Gefühl der Dringlichkeit bei weitem nicht aus.

#Willkommen beim offiziellen öffentlichen WeChat-Konto von iFanr: iFanr (WeChat-ID: ifanr), wo Ihnen so bald wie möglich weitere spannende Inhalte präsentiert werden.