Die KI, die sich „mit nur einem Klick auszieht“, lässt Kinder gar nicht erst los

„Spirituelle Reise“ besagt, dass man bei der Suche nach dem Meer wissen sollte, dass man bereits im Wasser lebt.

Das Gleiche scheint auch für die KI in der menschlichen Gesellschaft zu gelten.

Seit Anfang dieses Jahres ist „iPhone“ in allen Lebensbereichen allgegenwärtig. Runway verwandelt Stille in Bewegung, Pika zeichnet Teile neu, HeyGen lässt Ausländer authentisches Chinesisch sprechen und du singst und ich erscheine in der Mitte der Bühne.

In der Ecke ohne Highlights erweitert der scheinbar gewöhnliche, gesichtsverändernde Deepfake sein Territorium und betrifft jeden, von Prominenten und Präsidenten über Mittelschüler bis hin zu gewöhnlichen Menschen. Es ist nicht verblüffend oder subversiv, aber es reicht aus, um uns ins Schwitzen zu bringen.

Ziehen Sie sich mit einem Klick aus und entkommen Sie vollständig

„Ich habe dein Nacktfoto gesehen.“

Im September, am ersten Schultag, kam ein Junge auf die 14-jährige Isabel zu und sagte diese Worte zu ihr. Am Morgen war der Campus voller Klatsch und Tratsch, die Neuigkeiten verbreiteten sich gruppenweise, auf fast allen Mobiltelefonen waren „explizite Bilder“ von Mitschülerinnen im Umlauf.

Dies ist ein wahres Ereignis, das im Südwesten Spaniens stattfand und Almendralejo, eine kleine Stadt mit nur etwa 30.000 Einwohnern, international bekannt machte. Es gibt fünf Mittelschulen in der Stadt, und in mindestens vier von ihnen wurden „Nacktfotos“ verbreitet.

Die Ursache des Vorfalls ist nicht kompliziert: Eine Gruppe ruchloser Jungen hat Fotos ihrer Klassenkameradinnen in den sozialen Medien auf ein KI-Tool zum „One-Click-Stripping“ hochgeladen.

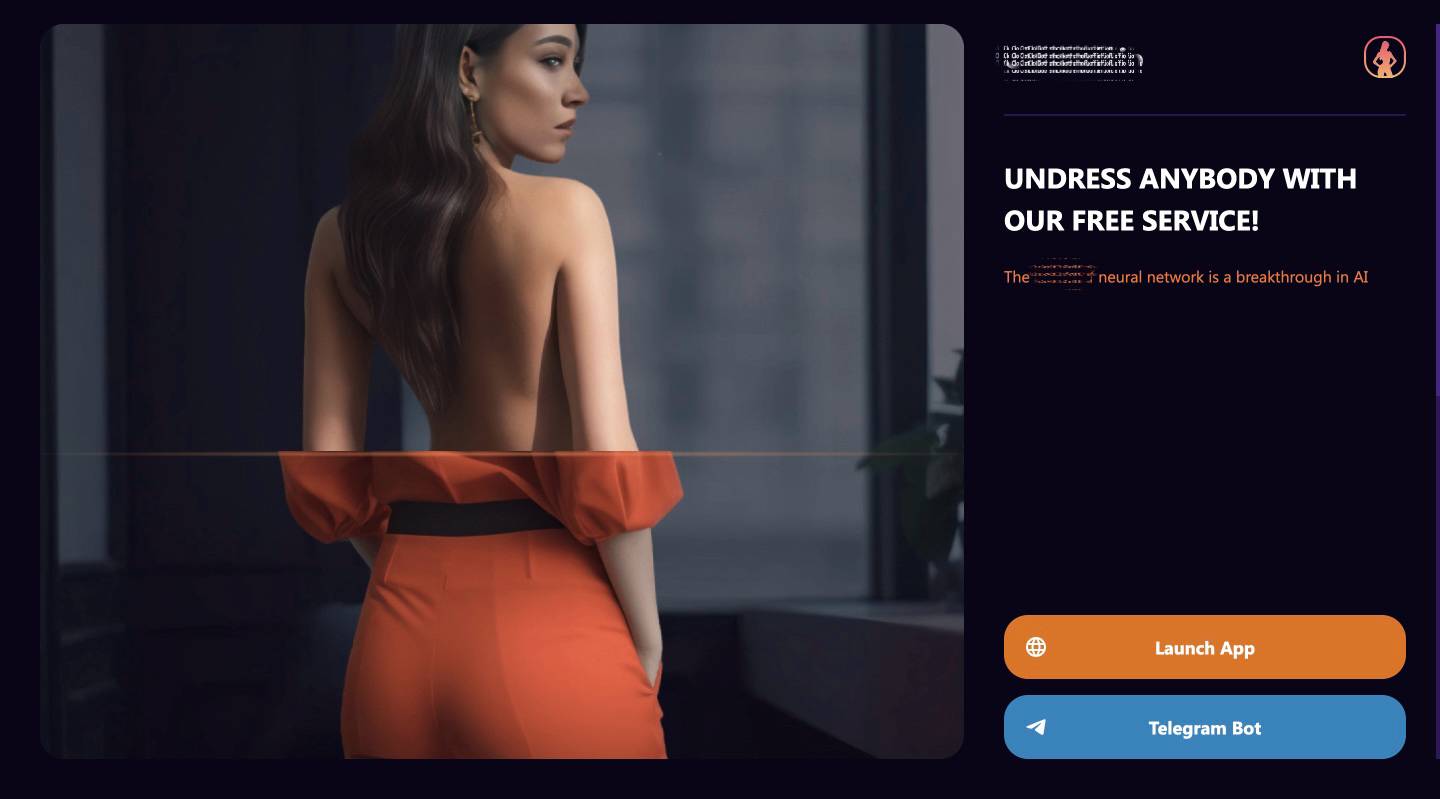

▲Die von ihnen verwendeten KI-Tools.

Dieses Tool kann über die mobile App oder die Instant-Messaging-Software Telegram genutzt werden. Der Slogan lautet „Zieh jedem kostenlos die Kleidung aus“, solange jemand anderes ein Foto in deinem Handyalbum hat.

Obwohl es angeblich kostenlos ist, beträgt der Preis für die Erstellung von 25 Nacktbildern 10 Euro und die Bezahlung kann mit Visa, Paypal, MasterCard usw. erfolgen, genauso bequem wie mit WeChat und Alipay in China, aber diese Zahlungsmethoden waren nach der Medienpräsenz deaktiviert.

Die spanische Polizei bestätigte, dass es mindestens 30 Opfer gab, hauptsächlich Studentinnen im Alter von 12 bis 14 Jahren. Die meisten Initiatoren kannten sie und waren ebenfalls minderjährig. Mindestens zehn von ihnen waren sogar unter 14 Jahre alt und konnten nicht strafrechtlich verfolgt werden.

Sie erstellten Gruppenchats auf WhatsApp und Telegram, um diese „Nacktfotos“ zu verbreiten, und drohten den Opfern über Instagram, „Lösegeld“ und echte Nacktfotos zu erpressen.

Als die Mutter eines der Opfer das „Nacktfoto“ ihrer Tochter sah, setzte ihr Herz einen Schlag aus. „Dieses Foto sieht echt aus.“

▲ Eine Mutter forderte weitere Opfer auf, sich zu melden.

Im Oktober ereignete sich eine ähnliche Situation an einer High School in New Jersey, USA. Es gab etwa 30 Opfer. Ihre männlichen Klassenkameraden machten in den Sommerferien „Nacktfotos“. Viele Mädchen weinten vor Wut. Eines der Opfer hatte noch nie gedacht, dass Deepfake mit ihr verwandt sein würde:

Ich hätte nie gedacht, dass mir KI als Student überhaupt nicht in den Sinn kam. Ich habe einfach das Gefühl, dass das hier wie ein Monster im Internet ist.

Der Schulleiter versicherte, dass alle Bilder gelöscht worden seien und nicht weiter verbreitet würden. Der Initiator wurde für einige Tage von der Schule suspendiert und kehrte zum „Tatort“ zurück, als wäre alles in Ordnung.

Viele Eltern sind mit dem Loslassen unzufrieden, können aber nichts dagegen tun. Bis heute ist Deepfake vielerorts noch eine Grauzone.

In den USA sind Deepfake-Bilder von Minderjährigen verboten. Im November wurde ein Kinderpsychiater aus North Carolina zu 40 Jahren Gefängnis verurteilt, weil er Patienten heimlich gefilmt und sie mit einem Klick „ausgezogen“ hatte.

Aber es gibt Ausnahmen. Wenn der Täter ebenfalls minderjährig ist, kann die Schule ihn milde behandeln. In dieser High School in New Jersey beispielsweise ist die Strafe nur eine Suspendierung. Einen Monat nach dem Vorfall sind die Opfer und ihre Eltern immer noch minderjährig Sie kennen weder ihre Identität noch ihre Nummer.

Wenn das Opfer ein Erwachsener ist, der sich selbst schützen kann, ist die Situation komplizierter. Jeder Staat hat unterschiedliche gesetzliche Bestimmungen, die entweder die Kriminalisierung oder die Einreichung von Zivilklagen vorsehen, aber es gibt derzeit kein Bundesgesetz, das die Produktion von Deepfake-Pornografie verbietet.

Ein Grund dafür, dass die Gesetzgebung schwierig ist, besteht darin, dass manche Leute glauben, dass das Subjekt auf dem Deepfake-Bild, selbst wenn es wie Sie aussieht, es nicht wirklich Sie sind, sodass Ihre Privatsphäre nicht wirklich verletzt wird.

Allerdings weiß jeder, dass die Bilder zwar gefälscht sind, die Verletzungen aber real sind und sich nicht von echten Nacktfotos unterscheiden. Für die Beteiligten und Passanten, die die Wahrheit nicht kennen, kommt es nicht darauf an, ob die Fotos 100 %ig sind echt, sondern ob sie echt aussehen.

Das Werk „Ghost in the Shell“ vom Ende des letzten Jahrhunderts hat sich bereits mit solchen Fragen beschäftigt. Jemand, der genauso aussieht wie Sie, hat etwas getan, was Sie niemals tun würden, aber es ist für Sie schwierig zu beweisen, dass Sie es nicht sind, die Daten Sie sind und die Spuren der Existenz Sie sind.

Die Streiche gewöhnlicher Leute, Mobiltelefone sind Waffen

Um es einfach auszudrücken: Deepfake nutzt KI, um scheinbar echte Videos, Audios oder Bilder zu generieren, um Dinge zu simulieren, die tatsächlich nicht passiert sind.

Deepfake tauchte erstmals 2017 auf Reddit auf, der „amerikanischen Version von Tieba“. Die Hauptform besteht darin, die Gesichter von Prominenten durch die Protagonisten pornografischer Videos zu ersetzen oder politische Persönlichkeiten zu fälschen.

Die früheste KI-Anwendung für „One-Click-Ausziehen“ könnte DeepNude im Jahr 2019 sein. Damals musste man noch Software herunterladen, die mit Windows 10- und Linux-Geräten kompatibel war, und der Server würde aufgrund zu vieler Leute ausfallen.

Aber mittlerweile ist das „Ausziehen mit einem Klick“ einfacher und üblicher geworden. Dienstleistungen werden in Form von Apps bereitgestellt und Geld wird über gängige Zahlungsmethoden verdient. Es ist zu einem Streich geworden, den gewöhnliche Menschen gewöhnlichen Menschen spielen. Es ist bereits geschehen in Mittelschulen und kann auch in Mittelschulen passieren. bei jedem.

Mit nur einem Foto, einer E-Mail-Adresse und ein paar Dollar können Sie die „Kleidung“ von Prominenten, Klassenkameraden und Fremden stapelweise ausziehen, und der Effekt ist noch schwieriger, zwischen echt und gefälscht zu unterscheiden. Bilder, die zum „Ausziehen“ verwendet werden, werden häufig ohne Zustimmung des Herausgebers aus sozialen Medien bezogen und dann ohne deren Wissen verbreitet.

Der Vater eines 14-jährigen Deepfake-Opfers in Spanien hat es auf den Punkt gebracht:

Nun kann das Smartphone als Waffe betrachtet werden.

Während das Gesetz hinterherhinkt, haben Technologieplattformen auf Drängen der öffentlichen Meinung einige Abhilfemaßnahmen ergriffen, aber sie können das Feuer nur eindämmen.

Google entfernt relevante Anzeigen und optimiert das Ranking-System und unterstützt mich auch dabei, relevante Inhalte nach Vorlage von Beweisen zu löschen. TikTok blockiert Schlüsselwörter wie „Ausziehen“, Reddit verbietet mehrere Domainnamen und Telegram verlässt sich auf automatische Überwachung und Benutzerberichte, um Inhalte zu löschen verstößt gegen die Nutzungsbedingungen…

Es gibt keine Hindernisse zu befürchten. Deepfake hat sich in diesem Jahr besonders schnell entwickelt, als wäre es auf Musks Raumschiff.

Laut Statistiken des Social-Network-Analyseunternehmens Graphika hatten allein im September die 34 „One-Click-Undressing“-Plattformen insgesamt mehr als 24 Millionen Besucher, und die 52 Telegram-Gruppen, die auf den „One-Click-Undressing“-Dienst zugreifen, waren unter enthalten mindestens 1 Million Benutzer.

Auch das Betriebsteam dahinter ist sehr schlau und versteht Marketing und Monetarisierung. Sie werben in sozialen Medien und empfehlen den Service „bestimmten Menschen“. Seit Anfang dieses Jahres ist die Zahl der „One-Click-Strip“-Werbelinks auf X und Reddit um mehr als 2.400 % gestiegen.

Die Reife der Industriekette hat Graphika zu dem Schluss geführt, dass Deepfake nun den Nachnamen „Niu Hulu“ erhalten hat, der völlig anders ist:

KI-generierte Strip-Bilder haben sich von Nischen-Porno-Diskussionsforen zu großen und kommerziellen Online-Unternehmen entwickelt.

Graphika glaubt, dass es noch einen weiteren wichtigen Grund gibt, warum Deepfake in diesem Jahr wieder auf dem Vormarsch ist: Die Funktionalität des Open-Source-KI-Bilddiffusionsmodells nimmt weiter zu und es wird einfacher zu verwenden.

Diese Open-Source-Modelle haben zum „hochwertigen und preisgünstigen“ Deepfake-Markt beigetragen. Andernfalls müssten Entwickler von „One-Click-Undressing“-Anwendungen ihre eigenen benutzerdefinierten Bildverbreitungsmodelle hosten, warten und ausführen, was länger und länger dauert kostet mehr.

Das FBI, das sein Können bei kriminalpolizeilichen Ermittlungsfilmen unter Beweis gestellt hat, konnte nicht still sitzen. Im Juni dieses Jahres gab es eine sorgfältig formulierte Warnung heraus, um die Öffentlichkeit vor pornografischen Deepfake-Bildern und -Videos zur Vorsicht zu warnen. Normalerweise werden sie in sozialen Medien öffentlich verbreitet oder pornografische Websites und zur Belästigung und Erpressung genutzt werden. Letztendlich ist es eine gute Möglichkeit, den Schaden an der Quelle zu stoppen:

Sobald Inhalte im Internet geteilt werden, ist es äußerst schwierig, wenn nicht unmöglich, sie zu entfernen, nachdem sie von anderen Parteien verbreitet oder veröffentlicht wurden.

Echte Möglichkeiten, abstrakter Spaß

ABC News interviewte einmal per E-Mail ein Team, das „One-Click-Ausziehen“ entwickelte, und die Antwort der anderen Partei war schwer zu kommentieren.

Sie behaupten, dass sie diese Art von Anwendung hauptsächlich zum Spaß entwickeln und damit Fotos von sich selbst oder ihren Freunden verarbeiten. Jeder hat Spaß daran und schämt sich nicht mehr für Nacktheit. Wie auch immer, es wird alles mit KI gemacht.

Warum machen sich Mittelschüler und andere Täter in Wirklichkeit nicht übereinander lustig oder holen im Voraus die Zustimmung des Opfers ein? Teams müssen nicht so tun, als wären sie verwirrt, weil sie sich wirklich von der Welt fernhalten wollen. Warum bieten sie diese Art von Service nicht speziell für die Teambildung im Unternehmen an? Lassen Sie alle ihre Scham niederlegen, motiviert sein und das Unternehmen wirklich so behandeln ihr Zuhause.

Aber das ist in der Tat eine Sichtweise. Wenn Sie nackt sind, andere nackt sind und ich nackt bin, bedeutet das, dass niemand nackt ist. Es besteht kein Grund zur Panik, wenn Sie in Zukunft Nacktfotos sehen. Ich bestehe darauf, dass KI wird das Gesicht verändern und das Lächeln wird verschwinden. Es gibt kein Konzept von Pornografie. Ursprünglich gibt es nichts, egal wie staubig es ist.

Ich weiß nicht, was für eine fortgeschrittene Gesellschaft eine so harmonische Szene haben kann. Jüngste Statistiken haben jedoch ergeben, dass, obwohl alle gleich sind, wenn es darum geht, sich auszuziehen, die meisten Dienstleistungen nur Frauen zur Verfügung stehen. Daher ist der Service „One-Click-Ausziehen“ nicht von hohem Standard und muss auf das Geschlecht abgestimmt sein.

Nur „Ausziehen mit einem Klick“ reicht nicht aus, um Ihre Wünsche zu befriedigen.

Im September dieses Jahres wurde ein südkoreanischer Mann in den Vierzigern zu zweieinhalb Jahren Gefängnis verurteilt, weil er mithilfe von KI etwa 360 kinderpornografische Bilder erstellt hatte. Ihm wurde ein Verstoß gegen das Kinder- und Jugendschutzgesetz vorgeworfen. Dies war das erste Mal Zeit in Südkorea, dass dies geschehen ist. Inländische Gerichte haben solche KI-Fälle verurteilt.

Der Korea Herald berichtete, dass er bei der Erstellung der Bilder Schlagworte wie „10 Jahre alt“, „nackt“ und „Kind“ verwendet habe, die das Gericht für realistisch genug hielt, und wies das Argument der Verteidigung zurück, dass sie nicht als sexuelle Ausbeutung angesehen werden könnten.

Wenn DIY nicht möglich ist, bieten einige Websites, die KI-Modelle teilen, „durchdachtere“ Dienste an. Wenn Sie den Namen einer Berühmtheit in das Textfeld eingeben und „nackt“ und andere Aufforderungswörter hinzufügen, erhalten Sie ein verschwommenes Bild, um das Bild hervorzuheben Appetit und Bezahlung des Benutzers. Schalten Sie Kinder und alte Männer ohne Täuschung frei.

Einige scharfsichtige Praktiker der Erotikbranche sehen Gefahren und Chancen zugleich. KI könnte sie ersetzen oder zu ihren Kollegen werden.

Fanvue ist eine Abonnementplattform ähnlich wie OnlyFans. Sie ist hinsichtlich KI-generierter Schöpfer sehr optimistisch, da sie den Prozess vereinfachen und Charaktere erstellen kann, die in der Realität nicht existieren. Es ist mutiger als eine KI-Freundin, die nur unter einer Decke plaudert, und origineller als ein Promi-Deepfake.

▲ Bild von: Fanvue

Eine ihrer KI-Charaktere, Emily Pellegrini, hat fast 120.000 Follower auf Instagram und ist auch eine Erstellerin von Inhalten für Erwachsene. Sie hat bereits Geld auf Fanvue verdient und in sechs Wochen mehr als 9.600 US-Dollar durch Abonnements, Pay-per-View-Inhalte usw. verdient.

Wenn sich dieser Trend fortsetzt, warum sollte sich Luo Ji, der Mauerwanderer in „Das Drei-Körper-Problem“, die Mühe machen, in einem Meer von Menschen nach seinem idealen Liebhaber Zhuang Yan zu suchen? Er erklärt auch anderen, dass dies Teil davon ist Plan und es ist nicht schwer, ihn anzupassen.

Neben Plattformen mit vielen Menschen gibt es auch Solo-Sexarbeiterinnen, die aktiv mit KI kooperieren, weil sie eine Wahrheit verstehen:

Wenn ich nicht mitmache, werden andere mein Bild missbrauchen.

Es gibt zwei Hauptformen der Zusammenarbeit. Die eine ist ein Chatbot, der über alles redet. Er wird anhand von YouTube-Videos, Podcasts, Interviews und eingeschränkten Inhalten trainiert. Dafür wird eine monatliche Abonnementgebühr von mehreren Dutzend Dollar erhoben. Die andere ist eine personalisierte Anpassung. Bildservice Die Bandbreite reicht von PG13, die von Minderjährigen bis hin zu 18+ angesehen werden kann. Sie werden damit zufrieden sein, sich die Gerichte der Leute anzusehen.

Einige Praktiker treffen auch Vorkehrungen und hoffen, in Zukunft immersive VR-Erlebnisse bieten zu können und Anforderungen zu erfüllen, die selbst echte Menschen nicht erfüllen können.

An Essen und Sex ist nichts auszusetzen. Mustafa von „Brave New World“ sagte: „Zivilisierte Menschen haben kein Bedürfnis, irgendwelche Beschwerden zu ertragen.“

Mustafa ist der nüchternste und rücksichtsloseste Charakter in diesem dystopischen Roman. Er versteht alle Übel und Leiden, versteht, dass Barbaren das Recht auf Leiden anstreben, und weiß, wie man der überwiegenden Mehrheit der Menschen mit verschiedenen Methoden ein angenehmes Leben ermöglicht. Handelsübliche Chemikalien helfen den Menschen simulieren notwendige Emotionen.

Wenn dies unvermeidbar ist, sollten wir zumindest zunächst die Kinder so gut wie möglich schützen. Wenn KI-Pornos es den Menschen ermöglichen, eine große Befreiung des Körpers und der Scham zu erreichen, könnte man der Arbeit auch eine Erinnerung hinzufügen: Dabei werden keine echten Menschen geschädigt.

# Willkommen beim offiziellen öffentlichen WeChat-Konto von aifaner: aifaner (WeChat-ID: ifanr). Weitere spannende Inhalte werden Ihnen so schnell wie möglich zur Verfügung gestellt.

Ai Faner | Ursprünglicher Link · Kommentare anzeigen · Sina Weibo