Die neuen flüssigkeitsgekühlten GPUs von Nvidia gehen in die Rechenzentren

Nvidia macht sich einige Notizen von der PC-Enthusiasten, um den CO2-Fußabdruck von Rechenzentren zu reduzieren. Das Unternehmen kündigte während seiner Keynote zur Computex 2022 zwei neue flüssigkeitsgekühlte GPUs an, aber sie werden nicht ihren Weg in Ihren nächsten Gaming-PC finden.

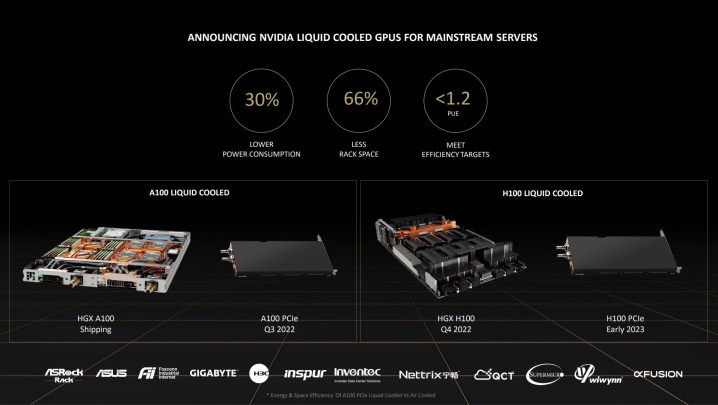

Stattdessen werden die GPUs H100 (angekündigt auf der GTC Anfang dieses Jahres ) und A100 gegen Ende des Jahres als Teil von HGX-Server-Racks ausgeliefert. Flüssigkeitskühlung ist nichts Neues für die Welt der Supercomputer, aber Mainstream-Rechenzentrumsserver waren traditionell nicht in der Lage, auf diese effiziente Kühlmethode zuzugreifen (nicht ohne zu versuchen, eine Gaming-GPU in einen Server zu stecken).

Neben HGX-Server-Racks wird Nvidia die flüssigkeitsgekühlten Versionen der H100 und A100 als Slot-in-PCIe-Karten anbieten. Der A100 kommt in der zweiten Hälfte des Jahres 2022 und der H100 Anfang 2023. Nvidia sagt, dass „mindestens ein Dutzend“ Systemhersteller diese GPUs bis Ende des Jahres verfügbar haben werden, einschließlich Optionen von Asus, ASRock und Gigabyte.

Rechenzentren machen etwa 1 % des gesamten Stromverbrauchs weltweit aus, und fast die Hälfte dieses Stroms wird ausschließlich für die Kühlung des gesamten Rechenzentrums aufgewendet. Im Gegensatz zur herkömmlichen Luftkühlung sagt Nvidia, dass seine neuen flüssigkeitsgekühlten Karten den Stromverbrauch um etwa 30 % senken und gleichzeitig den Rack-Platz um 66 % reduzieren können.

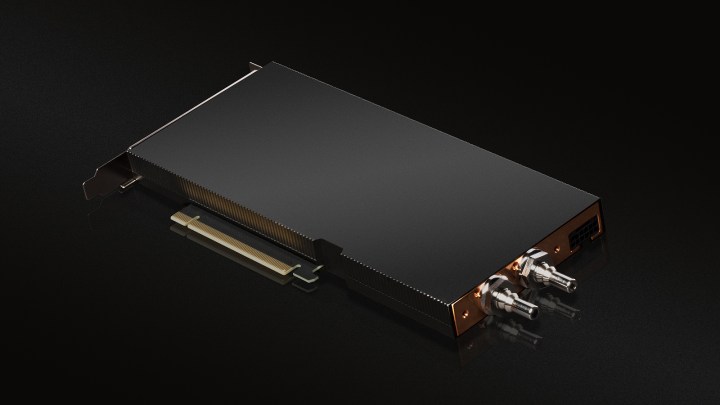

Anstelle eines All-in-One-Systems, wie Sie es bei einer flüssigkeitsgekühlten Gaming-GPU finden würden, verwenden der A100 und der H100 eine direkte Flüssigkeitsverbindung zur Verarbeitungseinheit selbst. Bis auf die Zuleitungen ist alles im GPU-Gehäuse versteckt, das selbst nur einen PCIe-Steckplatz belegt (im Gegensatz zu zwei bei den luftgekühlten Versionen).

Rechenzentren betrachten die Power Usage Effectiveness (PUE), um den Energieverbrauch zu messen – im Wesentlichen ein Verhältnis zwischen dem Stromverbrauch eines Rechenzentrums und dem Stromverbrauch des Computers. Bei einem luftgekühlten Rechenzentrum hatte Equinix einen PUE-Wert von etwa 1,6. Die Flüssigkeitskühlung mit den neuen GPUs von Nvidia senkte diesen Wert auf 1,15, was bemerkenswert nahe an den 1,0 PUE-Werten liegt, die Rechenzentren anstreben.

Neben einer besseren Energieeffizienz bietet die Flüssigkeitskühlung laut Nvidia Vorteile beim Wassersparen. Das Unternehmen sagt, dass jedes Jahr Millionen Liter Wasser in Rechenzentren verdunstet werden, um luftgekühlte Systeme in Betrieb zu halten. Durch die Flüssigkeitskühlung kann dieses Wasser zirkulieren und „einen Abfall in einen Vermögenswert verwandeln“, so Zac Smith, Head of Edge Infrastructure bei Equinix.

Obwohl diese Karten nicht in den riesigen Rechenzentren von Google, Microsoft und Amazon auftauchen werden – die wahrscheinlich bereits Flüssigkeitskühlung verwenden – bedeutet das nicht, dass sie keine Auswirkungen haben werden. Banken, medizinische Einrichtungen und Rechenzentrumsanbieter wie Equinix gefährden einen großen Teil der heutigen Rechenzentren, und sie alle könnten von flüssigkeitsgekühlten GPUs profitieren.

Laut Nvidia ist dies ebenfalls nur der Anfang einer Reise zu klimaneutralen Rechenzentren. In einer Pressemitteilung schrieb Joe Delaere, Senior Product Marketing Manager bei Nvidia, dass das Unternehmen plant, „auf absehbare Zeit Flüssigkeitskühlung in unseren leistungsstarken Rechenzentrums-GPUs und unseren Nvidia HGX-Plattformen zu unterstützen“.